Modelele de limbaj mari (LLM) cu miliarde de parametri sunt în prezent în fruntea procesării limbajului natural (NLP). Aceste modele zguduie domeniul cu abilitățile lor incredibile de a genera text, de a analiza sentimentele, de a traduce limbi și multe altele. Cu acces la cantități masive de date, LLM-urile au potențialul de a revoluționa modul în care interacționăm cu limbajul. Deși LLM-urile sunt capabile să îndeplinească diverse sarcini NLP, ei sunt considerați generaliști și nu specialiști. Pentru a pregăti un LLM pentru a deveni expert într-un anumit domeniu, este de obicei necesară o reglare fină.

Una dintre provocările majore în pregătirea și implementarea LLM-urilor cu miliarde de parametri este dimensiunea lor, ceea ce poate face dificilă încadrarea lor în un singur GPU, hardware-ul utilizat în mod obișnuit pentru învățarea profundă. Amploarea acestor modele necesită resurse de calcul de înaltă performanță, cum ar fi GPU-uri specializate cu cantități mari de memorie. În plus, dimensiunea acestor modele le poate face costisitoare din punct de vedere computațional, ceea ce poate crește semnificativ timpii de antrenament și de inferență.

În această postare, demonstrăm cum putem folosi Amazon SageMaker JumpStart pentru a ajusta cu ușurință un model mare de generare de text în limbaj pe un set de date specific unui domeniu, în același mod în care ați antrena și implementați orice model pe Amazon SageMaker. În special, arătăm cum puteți ajusta modelul de limbă GPT-J 6B pentru generarea de text financiar folosind atât JumpStart SDK, cât și Amazon SageMaker Studio UI pe un set de date disponibil public de dosare SEC.

JumpStart vă ajută să începeți rapid și ușor cu învățarea automată (ML) și oferă un set de soluții pentru cele mai obișnuite cazuri de utilizare care pot fi antrenate și implementate cu ușurință în doar câțiva pași. Toți pașii din această demonstrație sunt disponibili în blocnotesul însoțitor Reglarea fină a modelului GPT-J 6B pentru generarea de text pe un set de date specific domeniului.

Prezentare generală a soluțiilor

În secțiunile următoare, oferim o demonstrație pas cu pas pentru reglarea fină a unui LLM pentru sarcini de generare de text atât prin interfața de utilizare JumpStart Studio, cât și prin SDK-ul Python. În special, discutăm următoarele subiecte:

- O prezentare generală a datelor de depunere la SEC în domeniul financiar pe care modelul este reglat fin

- O prezentare generală a modelului LLM GPT-J 6B pe care am ales să-l perfectionăm

- O demonstrație a două moduri diferite prin care putem ajusta LLM folosind JumpStart:

- Utilizați JumpStart în mod programatic cu SageMaker Python SDK

- Accesați JumpStart folosind interfața de utilizare Studio

- O evaluare a modelului reglat fin prin compararea acestuia cu modelul pre-antrenat fără reglaj fin

Reglarea fină se referă la procesul de preluare a unui model lingvistic pre-instruit și de instruire pentru o sarcină diferită, dar înrudită, folosind date specifice. Această abordare este cunoscută și ca transfer de învățare, care presupune transferul cunoștințelor învățate de la o sarcină la alta. LLM-urile precum GPT-J 6B sunt instruite pe cantități masive de date neetichetate și pot fi reglate fin pe seturi de date mai mici, ceea ce face ca modelul să funcționeze mai bine într-un anumit domeniu.

Ca exemplu despre cum se îmbunătățește performanța atunci când modelul este reglat fin, luați în considerare următoarea întrebare:

„Ce motivează creșterea vânzărilor la Amazon?”

Fără reglaj fin, răspunsul ar fi:

„Amazon este cel mai mare retailer online din lume. Este, de asemenea, cea mai mare piață online din lume. Este și lumea”

Cu reglajul fin, răspunsul este:

„Creșterea vânzărilor la Amazon este determinată în primul rând de utilizarea sporită a clienților, inclusiv de selecție sporită, prețuri mai mici și confort sporit și vânzări crescute de către alți vânzători pe site-urile noastre.”

Îmbunătățirea de la reglaj fin este evidentă.

Folosim text financiar din dosarele SEC pentru a ajusta un GPT-J 6B LLM pentru aplicații financiare. În secțiunile următoare, introducem datele și LLM-ul care vor fi ajustate.

Setul de date de depunere a SEC

Depunerile SEC sunt esențiale pentru reglementarea și dezvăluirea în finanțe. Documentele notifică comunitatea de investitori despre condițiile de afaceri ale companiilor și perspectivele de viitor ale companiilor. Textul din dosarele SEC acoperă întreaga gamă de operațiuni și condiții de afaceri ale unei companii. Datorită valorii lor predictive potențiale, aceste dosare sunt surse bune de informații pentru investitori. Deși aceste dosare SEC sunt public pentru oricine, descărcarea fișierelor analizate și construirea unui set de date curat, cu funcții adăugate, este un exercițiu care necesită timp. Facem acest lucru posibil prin câteva apeluri API din JumpStart Industry SDK.

Folosind API-ul SageMaker, am descărcat rapoarte anuale (Pilituri 10-K; vedea Cum să citești un 10-K pentru mai multe informații) pentru un număr mare de companii. Selectăm rapoartele de depunere la SEC ale Amazon pentru anii 2021–2022 ca date de antrenament pentru a regla fin modelul GPT-J 6B. În special, concatenăm rapoartele SEC ale companiei în ani diferiți într-un singur fișier text, cu excepția secțiunii „Discuții și analize de conducere”, care conține declarații prospective ale conducerii companiei și sunt utilizate ca date de validare.

Se așteaptă ca, după reglarea fină a modelului de generare de text GPT-J 6B pe documentele financiare SEC, modelul este capabil să genereze rezultate textuale perspicace legate de financiar și, prin urmare, să poată fi utilizat pentru a rezolva mai multe sarcini NLP specifice domeniului.

Model de limbaj mare GPT-J 6B

GPT-J 6B este un model open-source, cu 6 miliarde de parametri, lansat de Eleuther AI. GPT-J 6B a fost instruit pe un corp mare de date text și este capabil să realizeze diverse sarcini NLP, cum ar fi generarea de text, clasificarea textului și rezumarea textului. Deși acest model este impresionant pentru o serie de sarcini NLP, fără a fi nevoie de nicio reglare fină, în multe cazuri va trebui să ajustați modelul pentru un anumit set de date și sarcini NLP pentru care încercați să le rezolvați. Cazurile de utilizare includ chatbot-uri personalizate, generarea de idei, extragerea entităților, clasificarea și analiza sentimentelor.

Accesați LLM-uri pe SageMaker

Acum că am identificat setul de date și modelul pe care urmează să-l perfectionăm, JumpStart oferă două căi pentru a începe să utilizați reglarea fină a generării de text: SageMaker SDK și Studio.

Utilizați JumpStart în mod programatic cu SDK-ul SageMaker

Trecem acum peste un exemplu despre cum puteți utiliza SDK-ul SageMaker JumpStart pentru a accesa un LLM (GPT-J 6B) și a-l regla fin pe setul de date de depunere a SEC. După finalizarea reglajului fin, vom implementa modelul reglat fin și vom face inferențe împotriva acestuia. Toți pașii din această postare sunt disponibili în caietul însoțitor: Reglarea fină a modelului GPT-J 6B pentru generarea de text pe un set de date specific domeniului.

În acest exemplu, JumpStart utilizează Container de învățare profundă SageMaker Hugging Face (DLC) și DeepSpeed bibliotecă pentru a regla fin modelul. Biblioteca DeepSpeed este concepută pentru a reduce puterea de calcul și utilizarea memoriei și pentru a antrena modele mari distribuite cu un paralelism mai bun pe hardware-ul computerului existent. Suportă antrenament distribuit cu un singur nod, utilizând puncte de control în gradient și paralelism de model pentru a antrena modele mari pe o singură instanță de antrenament SageMaker cu mai multe GPU-uri. Cu JumpStart, integrăm biblioteca DeepSpeed cu DLC-ul SageMaker Hugging Face pentru tine și ne ocupăm de tot ce este sub capotă. Puteți ajusta cu ușurință modelul pe setul de date specific domeniului, fără a-l configura manual.

Ajustați modelul pre-antrenat pe date specifice domeniului

Pentru a regla fin un model selectat, trebuie să obținem URI-ul modelului respectiv, precum și scriptul de antrenament și imaginea containerului folosită pentru antrenament. Pentru a ușura lucrurile, aceste trei intrări depind numai de numele modelului, versiune (pentru o listă a modelelor disponibile, consultați Algoritmi încorporați cu tabel model pre-antrenat), și tipul de instanță pe care doriți să vă antrenați. Acest lucru este demonstrat în următorul fragment de cod:

Recuperăm model_id corespunzătoare aceluiași model pe care vrem să-l folosim. În acest caz, reglam fin huggingface-textgeneration1-gpt-j-6b.

Definirea hiperparametrilor presupune setarea valorilor pentru diverși parametri utilizați în timpul procesului de antrenament al unui model ML. Acești parametri pot afecta performanța și acuratețea modelului. În pasul următor, stabilim hiperparametrii utilizând setările implicite și specificând valori personalizate pentru parametri precum epochs și learning_rate:

JumpStart oferă o listă extinsă de hiperparametri disponibili pentru reglare. Următoarea listă oferă o prezentare generală a unei părți a hiperparametrilor cheie utilizați la reglarea fină a modelului. Pentru o listă completă de hiperparametri, consultați caietul Reglarea fină a modelului GPT-J 6B pentru generarea de text pe un set de date specific domeniului.

- epoci – Specifică cel mult câte epoci ale setului de date original vor fi iterate.

- rata_de_învățare – Controlează dimensiunea pasului sau rata de învățare a algoritmului de optimizare în timpul antrenamentului.

- eval_steps – Specifică câți pași trebuie executați înainte de a evalua modelul pe setul de validare în timpul antrenamentului. Setul de validare este un subset de date care nu este folosit pentru antrenament, ci este folosit pentru a verifica performanța modelului pe date nevăzute.

- decadere_greutate – Controlează puterea de regularizare în timpul antrenamentului de model. Regularizarea este o tehnică care ajută la prevenirea supraadaptarii modelului la datele de antrenament, ceea ce poate duce la o performanță mai bună pe date nevăzute.

- fp16 – Controlează dacă se utilizează antrenamentul de precizie fp16 pe 16 biți (mixt) în loc de antrenament pe 32 de biți.

- strategie_evaluare – Strategia de evaluare utilizată în timpul instruirii.

- pași_de_acumulare_gradient – Numărul de pași de actualizări pentru care să acumulați gradienții înainte de a efectua o trecere înapoi/actualizare.

Pentru mai multe detalii referitoare la hiperparametri, consultați oficialul Documentația Hugging Face Trainer.

Acum puteți ajusta acest model JumpStart pe propriul set de date personalizat folosind SDK-ul SageMaker. Utilizăm datele de depunere a SEC pe care le-am descris mai devreme. Trenul și datele de validare sunt găzduite sub train_dataset_s3_path și validation_dataset_s3_path. Formatul de date acceptat include CSV, JSON și TXT. Pentru datele CSV și JSON, datele text sunt utilizate din coloana numită text sau prima coloană dacă nu este găsită nicio coloană numită text. Deoarece aceasta este pentru reglarea fină a generării de text, nu sunt necesare etichete de adevăr de bază. Următorul cod este un exemplu SDK despre cum să reglați fin modelul:

După ce am configurat SageMaker Estimator cu hiperparametrii necesari, instanțiem un estimator SageMaker și apelăm .fit metoda de a începe reglarea fină a modelului nostru, trecându-i Serviciul Amazon de stocare simplă (Amazon S3) URI pentru datele noastre de antrenament. După cum puteți vedea, entry_point scriptul furnizat este numit transfer_learning.py (la fel pentru alte sarcini și modele) și canalul de date de intrare transmis .fit trebuie să fie numit tren și validare.

JumpStart acceptă și optimizarea hiperparametrului cu Ajustarea automată a modelului SageMaker. Pentru detalii, vezi exemplul caiet.

Implementați modelul reglat fin

Când antrenamentul este complet, puteți implementa modelul dvs. reglat fin. Pentru a face acest lucru, tot ce trebuie să obținem este URI-ul scriptului de inferență (codul care determină modul în care modelul este utilizat pentru inferență odată implementat) și URI-ul imaginii containerului de inferență, care include un server de model adecvat pentru a găzdui modelul ales. Vezi următorul cod:

După câteva minute, modelul nostru este implementat și putem obține predicții din el în timp real!

Accesați JumpStart prin interfața de utilizare Studio

O altă modalitate de a ajusta și de a implementa modelele JumpStart este prin interfața de utilizare Studio. Această interfață de utilizare oferă o soluție low-code/fără cod pentru reglarea fină a LLM-urilor.

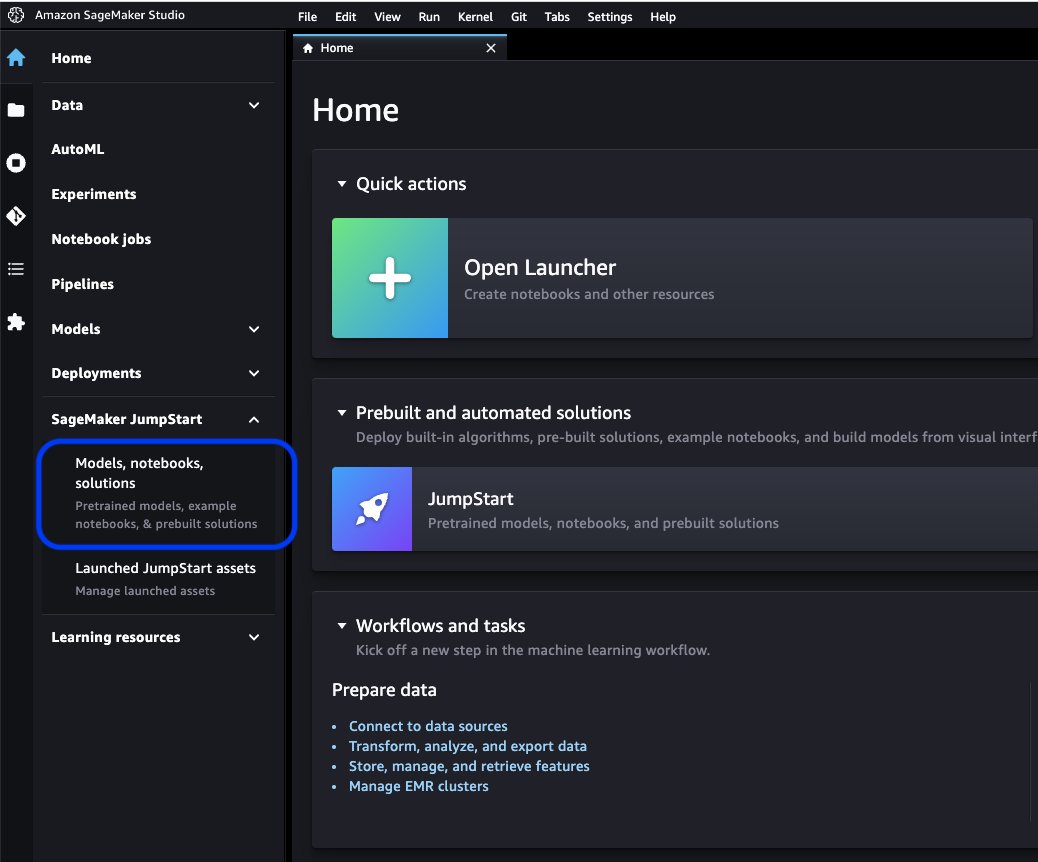

Pe consola Studio, alegeți Modele, caiete, solutii în SageMaker JumpStart în panoul de navigare.

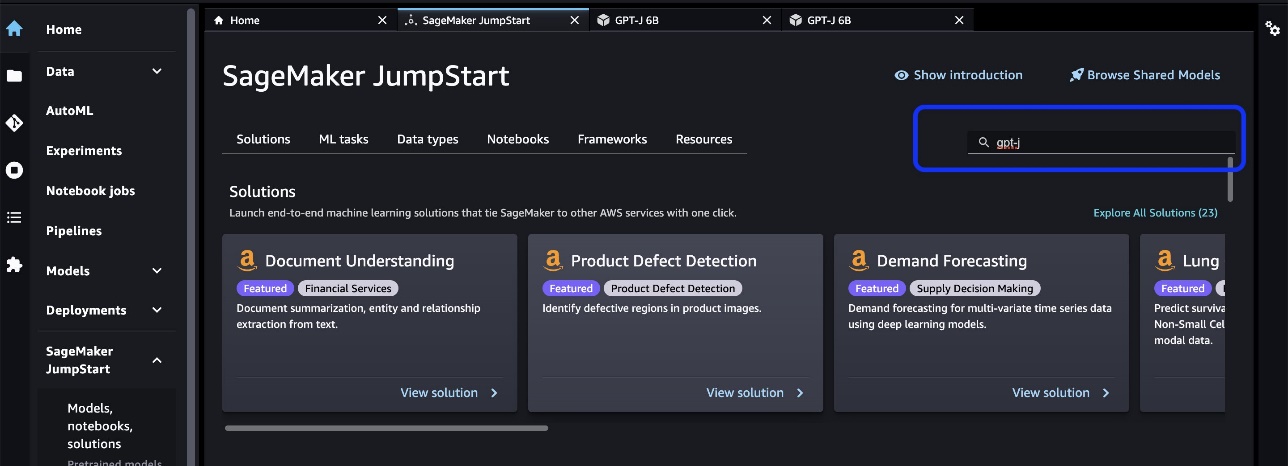

În bara de căutare, căutați modelul pe care doriți să îl ajustați și să îl implementați.

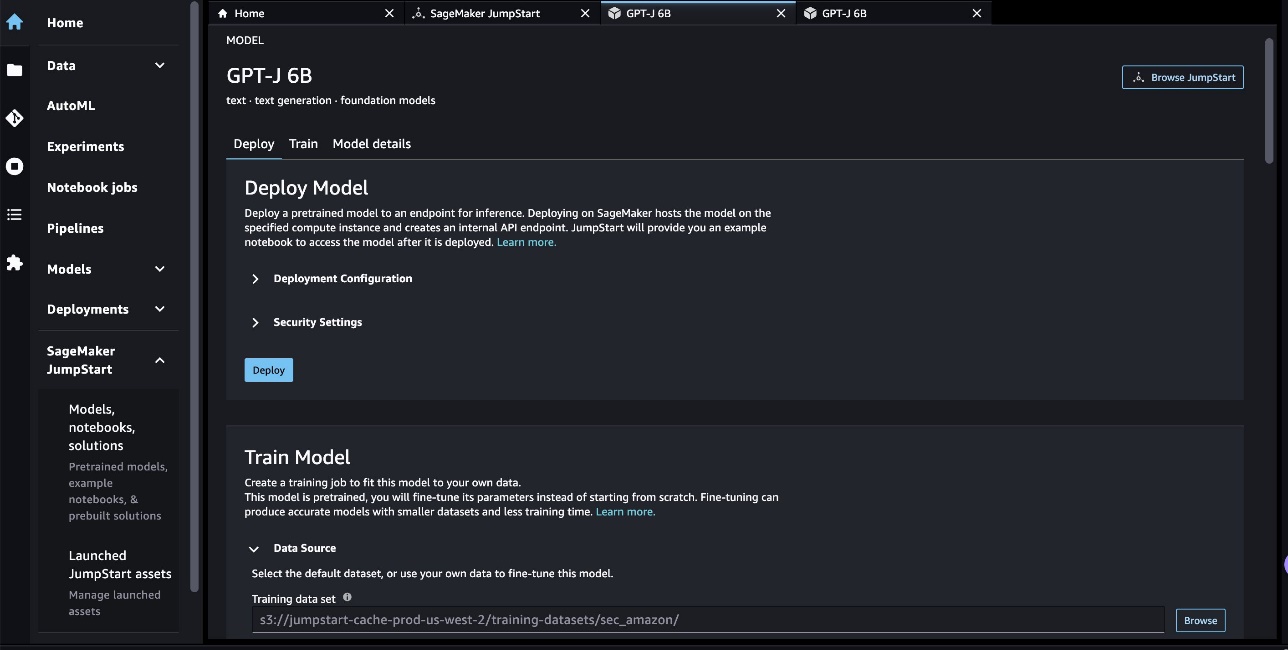

În cazul nostru, am ales cardul model GPT-J 6B. Aici putem ajusta direct sau implementa LLM.

Evaluarea modelului

Când evaluăm un LLM, putem folosi perplexitatea (PPL). PPL este o măsură comună a cât de bine este un model de limbaj capabil să prezică următorul cuvânt dintr-o secvență. În termeni mai simpli, este o modalitate de a măsura cât de bine modelul poate înțelege și genera un limbaj asemănător omului.

Un scor de nedumerire mai mic înseamnă că modelul are rezultate mai bune la prezicerea cuvântului următor. În termeni practici, putem folosi nedumerirea pentru a compara diferite modele de limbaj și pentru a determina care dintre ele se descurcă mai bine la o anumită sarcină. De asemenea, îl putem folosi pentru a urmări performanța unui singur model în timp. Pentru mai multe detalii, consultați Perplexitatea modelelor cu lungime fixă.

Evaluăm performanța modelului printr-o comparație a performanței sale pre și post-ajustare fină. PPL este emis în posturile de formare Amazon CloudWatch busteni. În plus, ne uităm la rezultatul generat de model ca răspuns la solicitări specifice de testare.

| Metrica de evaluare a datelor de validare | Înainte de reglaj fin | După reglaj fin |

| Perplexitate (PPL) | 8.147 | 1.437 |

Performanța îmbunătățită a modelului este demonstrată de două experimente:

- Generarea textului – Arătăm că rezultatul GPT-J reglat generează text care are o asemănare cu setul de date SEC, indicând faptul că a învățat să imite tiparele și convențiile lingvistice ale domeniului de reglementare financiară

- Învățare zero-shot – Demonstrăm că GPT-J reglat fin prezintă performanțe semnificativ mai bune decât GPT-J neajustat la răspunsul la întrebarea zero

Pentru experimentul de generare a textului, folosim următorii parametri de inferență pentru a obține rezultatele noastre: max_length de 400 (număr de jetoane returnate), num_return_sequences din 1 (număr de exemple de text de răspuns), top_k din 250 (alegeți din una dintre primele 250 de continuări posibile), top_p de 0.8 (selectați numai dintre continuările care sunt probabile cel puțin 80%), do_sample is True (eșantionare) și temperature de 1 (temperatura ridicată reprezintă o mai mare aleatorie a răspunsurilor). Pentru mai multe detalii despre parametri, consultați GenerationConfig. Următorul tabel compară GPT-J reglat fin și cel neajustat pe o sarcină de completare a textului.

| Exemplu de inferență | Ieșire de la GPT-J 6B înainte de reglare fină | Ieșire de la GPT-J 6B după reglaj fin |

| Acest raport Formular 10-K arată că |

Acest raport Formular 10-K arată că: Venitul net atribuit Societății pentru anul încheiat la 31 decembrie 2016 a fost de 3,923,000 USD, sau 0.21 USD per acțiune diluată, comparativ cu 3,818,000 USD sau 0.21 USD per acțiune diluată, pentru anul încheiat la 31 decembrie 2015. Venitul net atribuit Societății pentru anul încheiat la 31 decembrie 2016 a fost de 4,816,000 USD, sau 0.28 USD per acțiune diluată, comparativ cu 4,726,000 USD sau 0.27 USD per acțiune diluată, pentru anul încheiat la 31 decembrie 2015. Venitul net atribuit Societății pentru anul încheiat la 31 decembrie 2016 a fost de 5,828,000 USD, sau 0.34 USD per acțiune diluată, comparativ cu 5,716,000 USD sau 0.33 USD per acțiune diluată, pentru anul încheiat la 31 decembrie 2015. La 21 august 2009, Compania a depus un Formular 10-Q pentru trimestrul încheiat la 31 decembrie 2008. La 21 august 2009, Compania a depus un Formular 10-Q pentru trimestrul încheiat la 30 septembrie 2008. La 21 august 2009, Compania a depus un Formular 10-Q pentru trimestrul încheiat la 31 martie 2009. |

Acest raport Formular 10-K arată că: (1) Numele, adresa și numărul de telefon ale solicitantului înregistrării sunt după cum urmează: Amazon.com, Inc. c/o Ernst & Young LLPSeattle, Washington Atenție: Secretar corporativ (2) Pentru Scopul articolului III din Securities Exchange Act din 1934, numele și adresa solicitantului înregistrării sunt următoarele: (3) Perioada de raportare a solicitantului înregistrării Exchange Act este de la și inclusiv 1 ianuarie 2020 până în prezent. (4) Evaluarea subiectivă a solicitantului înregistrării este că situațiile financiare și alte informații financiare incluse în acest raport prezintă în mod fidel, sub toate aspectele semnificative, situația financiară, rezultatele operațiunilor și fluxurile de numerar ale solicitantului înregistrării la și pentru perioadele prezentate în acest raport. (5) Conducerea solicitantului înregistrării evaluarea este că situațiile financiare și alte informații financiare incluse în acest raport prezintă în mod corect, sub toate aspectele semnificative, situația financiară, rezultatele operațiunilor și fluxurile de numerar ale solicitantului înregistrării la și pentru perioadele prezentate în acest raport./s/ Ernst & Young LLPSeattle, Washington 29 ianuarie 2020EX-31.1 5 amzn-20201231xex311.htm EX-31.1 Document Exhibit 31.1CERTIFICATIONSI, Andrew R. Jassy, certifică că:1. Am examinat acest Formular 10-K al Amazon.com, Inc.;2. Pe baza cunoștințelor mele, acest raport nu conține nicio declarație falsă a unui fapt material sau nu omite să enunțe un fapt material necesar pentru a face declarațiile făcute, în lumina circumstanțelor în care au fost făcute astfel de declarații, să nu inducă în eroare în ceea ce privește perioada acoperită de prezentul raport; |

| Servim consumatorii prin intermediul |

Servim consumatorii prin: Blog-ul nostru Sunteți proprietar de afaceri și doriți să vă dezvoltați afacerea? Vrei să creezi o afacere mai eficientă și mai eficientă? Vrei să înveți cum să-ți dezvolți afacerea? Dacă ați răspuns „da” la oricare dintre aceste întrebări, atunci trebuie să citiți acest articol. Primul pas pentru a vă dezvolta afacerea este să vă înțelegeți afacerea. Trebuie să poți răspunde la următoarele întrebări despre afacerea ta: Cine sunt clienții tăi? Care este produsul sau serviciul dvs.? Care este propunerea dvs. unică de vânzare? Care este strategia ta de marketing? Care este prognoza dvs. de vânzări? Care este prognoza dvs. de vânzări? Care este prognoza dvs. de vânzări? Care este prognoza dvs. de vânzări? Care este prognoza dvs. de vânzări? |

Servim consumatorii prin: Amazon.com, un retailer de produse fizice și digitale; Amazon Web Services, care oferă servicii de infrastructură tehnologică care permit practic orice tip de afacere; Amazon Enterprise Solutions, care oferă companiilor tehnologie și servicii personalizate pentru a permite procese de afaceri mai bune și pentru a îmbunătăți eficiența și productivitatea; și Audible, un editor de cărți audio digitale. Servim dezvoltatori și întreprinderi de toate dimensiunile prin AWS, care oferă un set larg de oferte globale de calcul, stocare, baze de date și alte servicii. De asemenea, producem și vindem dispozitive electronice. Ne-am organizat operațiunile în două segmente principale: America de Nord și Internațional. A se vedea punctul 8 din partea a II-a, „”Situații financiare și date suplimentare-Nota 12-Informații pe segment.”” A se vedea punctul 7 din partea a II-a, „”Discuția și analiza de către conducere a stării financiare și a rezultatelor operațiunilor-rezultate ale operațiunilor-informații suplimentare” ” pentru informații suplimentare despre vânzările noastre nete. Consumatorii Servim consumatorii prin magazinele noastre online și fizice și ne concentrăm pe selecție, preț și comoditate. Ne proiectăm magazinele astfel încât sute de milioane de produse unice să fie vândute de către noi și de către terți în zeci de categorii de produse. Clienții accesează ofertele noastre prin site-urile noastre web, aplicațiile mobile, Alexa și vizitând fizic magazinele noastre. De asemenea, producem și vindem dispozitive Kindle. Ne străduim să oferim clienților noștri cele mai mici prețuri posibile prin prețuri zilnice reduse pentru produse și oferte de transport și să ne îmbunătățim eficiența operațională, astfel încât să putem continua să reducem prețurile pentru clienții noștri. Oferim, de asemenea, funcționalitate ușor de utilizat, îndeplinire rapidă și fiabilă și servicii pentru clienți în timp util. În plus, oferim Amazon Prime, un program de abonament care include transport gratuit nelimitat pentru peste 100 de milioane de articole, acces la streaming nelimitat de zeci de mii de filme și Episoade TV și alte beneficii. |

| Anul acesta ne concentrăm în mod deosebit |

Anul acesta ne concentrăm în special pe: Rolul sistemului de sănătate în prevenirea obezității și diabetului Rolul sistemului de sănătate în prevenirea obezității și diabetului Rolul sistemului de sănătate în prevenirea obezității și diabetului Rolul sistemului de sănătate în prevenirea obezității și diabetului Rolul sistemului de sănătate în prevenirea obezității și diabetului Rolul sistemului de sănătate în prevenirea obezității și diabetului Rolul sistemului de sănătate în prevenirea obezității și diabetului |

Anul acesta ne concentrăm în special pe: -Extinderea internațională continuă, inclusiv dezvoltarea de noi afaceri în segmentele de piață internațională existente, precum și dezvoltarea de noi segmente de piață internațională; -Extinderea bazei noastre de clienți, inclusiv creșterea vânzărilor către clienții existenți și atragerea de noi clienți; -Dezvoltarea de noi oportunități de afaceri și încheierea de acorduri comerciale, inclusiv prin licențiere și alte aranjamente, cu alte companii sau prin achiziționarea altor companii; - Dezvoltarea tehnologiei care oferă servicii îmbunătățite pentru clienți și furnizează în mod eficient produsele și serviciile noastre; - Dezvoltarea de noi oferte de produse și servicii și încorporarea acestora în ofertele de produse și servicii existente și noi; -Dezvoltarea de sisteme eficiente și eficiente pentru susținerea afacerii noastre; și -Alte inițiative de afaceri și strategice. Credem că oferirea de prețuri mici clienților noștri este fundamentală pentru succesul nostru viitor. O modalitate prin care oferim prețuri mai mici este prin oferte de transport gratuit, care au ca rezultat un cost net pentru livrarea produselor și prin calitatea de membru la Amazon Prime, care oferă transport gratuit pentru milioane de articole și acces la filme și alt conținut. De asemenea, oferim și alte promoții care ne permit să reducem costul net al vânzărilor. Ne-am organizat operațiunile în două segmente principale: America de Nord și Internațional. A se vedea punctul 8 din partea a II-a, „”Situații financiare și date suplimentare-Nota 12-Informații pe segment.”” A se vedea punctul 7 din partea a II-a,””Discuția și analiza de către conducere a stării financiare și a rezultatelor operațiunilor-rezultate ale operațiunilor-informații suplimentare”” pentru informații suplimentare despre vânzările noastre nete. Consumatorii Servim consumatorii prin site-urile noastre de vânzare cu amănuntul și magazinele fizice și ne concentrăm pe selecție, preț și comoditate. |

Pentru cel de-al doilea experiment cu o sarcină de răspuns la întrebare zero, am setat max_length să fie o valoare diferită (40, 200 și, respectiv, 40) în funcție de rezultatul pe care îl așteptăm de la fiecare întrebare. Parametrii de top_k, top_p, do_sample, temperature sunt setate ca 250, 0.8, False, și, respectiv, 0. Setăm temperatura aproape de 0 pentru a controla caracterul aleatoriu al rezultatelor, în timp ce în sarcina de generare a textului o setăm aproape de 1 pentru a face modelul mai creativ. Următorul tabel compară rezultatele. Pentru fiecare întrebare, rezultatul de la GPT-J reglat fin este mai precis decât cel neajustat.

| Intrare | Ieșire de la GPT-J 6B înainte de reglare fină | Ieșire de la GPT-J 6B după reglaj fin |

| Despre ce este articolul 7 din depunerea 10-K SEC?: |

Despre ce este articolul 7 din depunerea 10-K SEC?: Punctul 7 din depunerea 10-K SEC este următorul: „Compania nu a primit niciun adversar semnificativ |

Punctul 7. Discuția conducerii și analiza situației financiare și a rezultatelor operațiunilor Declarații prospective |

| Cum a afectat pandemia COVID-19 afacerile Amazon?: |

Cum a afectat pandemia COVID-19 afacerile Amazon?: Afacerea Amazon este afectată de pandemia COVID-19 în mai multe moduri. Compania înregistrează o scădere a numărului de membri Prime, ceea ce reprezintă o mare parte a afacerii sale. De asemenea, compania înregistrează o scădere a numărului de membri Prime. De asemenea, Amazon înregistrează o scădere a numărului de comenzi plasate pe site-ul său. De asemenea, compania înregistrează o scădere a numărului de persoane care fac cumpărături pe site-ul său. De asemenea, Amazon înregistrează o scădere a numărului de persoane care fac cumpărături pe site-ul său. De asemenea, Amazon înregistrează o scădere a numărului de persoane care fac cumpărături pe site-ul său. De asemenea, Amazon înregistrează o scădere a numărului de persoane care fac cumpărături pe site-ul său. De asemenea, Amazon înregistrează o scădere a numărului de persoane care fac cumpărături |

Cum a afectat pandemia COVID-19 afacerile Amazon?: Pandemia COVID-19 a afectat afacerea noastră în mai multe moduri. În primul rând, ne-a perturbat lanțul de aprovizionare și a afectat cererea clienților, care, la rândul său, ne-a afectat vânzările și rezultatele operaționale. În al doilea rând, ne-a crescut cheltuielile pentru publicitate și marketing, care ar putea să nu fie eficiente pe termen lung. În al treilea rând, ne-a crescut cheltuielile pentru infrastructura tehnologică și capacitatea de calcul, care ar putea să nu fie eficiente pe termen lung. În al patrulea rând, ne-a crescut cheltuielile pentru onorare și servicii pentru clienți, care ar putea să nu fie eficiente pe termen lung. În cele din urmă, ne-a crescut cheltuielile pentru conținut, care poate să nu fie eficient pe termen lung. A se vedea punctul 8 din partea a II-a, „Situații financiare și date suplimentare — Nota 1 — Descrierea afacerilor și a politicilor contabile. |

| Ce determină creșterea vânzărilor la Amazon?: | Amazon este cel mai mare retailer online din lume. Este, de asemenea, cea mai mare piață online din lume. Este, de asemenea, lumea' | Creșterea vânzărilor la Amazon este determinată în principal de utilizarea sporită a clienților, inclusiv de selecție sporită, prețuri mai mici și confort sporit și vânzări crescute de către alți vânzători pe site-urile noastre web. |

A curăța

Pentru a evita taxele continue, ștergeți punctele finale de inferență SageMaker. Puteți șterge punctele finale prin consola SageMaker sau din notebook folosind următoarele comenzi:

Concluzie

JumpStart este o capacitate din SageMaker care vă permite să începeți rapid cu ML. JumpStart folosește modele open-source, pre-antrenate pentru a rezolva probleme comune ML, cum ar fi clasificarea imaginilor, detectarea obiectelor, clasificarea textului, clasificarea perechilor de propoziții și răspunsul la întrebări.

În această postare, v-am arătat cum să reglați și să implementați un LLM pre-antrenat (GPT-J 6B) pentru generarea de text pe baza setului de date de completare SEC. Am demonstrat cum modelul s-a transformat într-un expert în domeniul financiar, prin procesul de reglare fină pe doar două rapoarte anuale ale companiei. Această reglare fină a permis modelului să genereze conținut cu o înțelegere a subiectelor financiare și o mai mare precizie. Încercați singur soluția și spuneți-ne cum merge în comentarii.

Important: această postare are doar scop demonstrativ. Nu este consiliere financiară și nu ar trebui să fie bazată pe consiliere financiară sau de investiții. Postul a folosit modele pre-instruite pe date obținute din baza de date SEC EDGAR. Sunteți responsabil pentru respectarea termenilor și condițiilor de acces ale EDGAR dacă utilizați datele SEC.

Pentru a afla mai multe despre JumpStart, consultați următoarele postări:

Despre Autori

Dr. Xin Huang este cercetător aplicat senior pentru algoritmii încorporați Amazon SageMaker JumpStart și Amazon SageMaker. El se concentrează pe dezvoltarea de algoritmi scalabili de învățare automată. Interesele sale de cercetare sunt în domeniul prelucrării limbajului natural, al învățării profunde explicabile pe date tabulare și al analizei robuste a grupării non-parametrice spațiu-timp. A publicat multe lucrări în ACL, ICDM, conferințe KDD și Royal Statistical Society: Series A.

Dr. Xin Huang este cercetător aplicat senior pentru algoritmii încorporați Amazon SageMaker JumpStart și Amazon SageMaker. El se concentrează pe dezvoltarea de algoritmi scalabili de învățare automată. Interesele sale de cercetare sunt în domeniul prelucrării limbajului natural, al învățării profunde explicabile pe date tabulare și al analizei robuste a grupării non-parametrice spațiu-timp. A publicat multe lucrări în ACL, ICDM, conferințe KDD și Royal Statistical Society: Series A.

Marc Karp este arhitect ML cu echipa Amazon SageMaker Service. El se concentrează pe a ajuta clienții să proiecteze, să implementeze și să gestioneze sarcinile de lucru ML la scară. În timpul liber, îi place să călătorească și să exploreze locuri noi.

Marc Karp este arhitect ML cu echipa Amazon SageMaker Service. El se concentrează pe a ajuta clienții să proiecteze, să implementeze și să gestioneze sarcinile de lucru ML la scară. În timpul liber, îi place să călătorească și să exploreze locuri noi.

Dr. Sanjiv Das este bursier Amazon și profesor Terry de finanțe și știință a datelor la Universitatea Santa Clara. El deține diplome postuniversitare în finanțe (M.Phil și doctorat de la Universitatea din New York) și Computer Science (MS de la UC Berkeley) și un MBA de la Institutul Indian de Management, Ahmedabad. Înainte de a fi cadru universitar, a lucrat în afacerile derivate din regiunea Asia-Pacific ca vicepreședinte la Citibank. Lucrează pe învățarea automată multimodală în domeniul aplicațiilor financiare.

Dr. Sanjiv Das este bursier Amazon și profesor Terry de finanțe și știință a datelor la Universitatea Santa Clara. El deține diplome postuniversitare în finanțe (M.Phil și doctorat de la Universitatea din New York) și Computer Science (MS de la UC Berkeley) și un MBA de la Institutul Indian de Management, Ahmedabad. Înainte de a fi cadru universitar, a lucrat în afacerile derivate din regiunea Asia-Pacific ca vicepreședinte la Citibank. Lucrează pe învățarea automată multimodală în domeniul aplicațiilor financiare.

Arun Kumar Lokanatha este arhitect senior de soluții ML cu echipa Amazon SageMaker Service. El se concentrează pe a ajuta clienții să construiască, să antreneze și să migreze sarcinile de lucru de producție ML către SageMaker la scară. Este specializat în deep learning, în special în zona NLP și CV. În afara serviciului, îi place să alerge și să facă drumeții.

Arun Kumar Lokanatha este arhitect senior de soluții ML cu echipa Amazon SageMaker Service. El se concentrează pe a ajuta clienții să construiască, să antreneze și să migreze sarcinile de lucru de producție ML către SageMaker la scară. Este specializat în deep learning, în special în zona NLP și CV. În afara serviciului, îi place să alerge și să facă drumeții.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- Platoblockchain. Web3 Metaverse Intelligence. Cunoștințe amplificate. Accesați Aici.

- Mintând viitorul cu Adryenn Ashley. Accesați Aici.

- Sursa: https://aws.amazon.com/blogs/machine-learning/domain-adaptation-fine-tuning-of-foundation-models-in-amazon-sagemaker-jumpstart-on-financial-data/

- :are

- :este

- :nu

- $3

- $UP

- 000

- 1

- 100

- 11

- 20

- 200

- 2016

- 2020

- 28

- 7

- 8

- 9

- a

- abilități

- Capabil

- Despre Noi

- academic

- acces

- Contabilitate

- Acumula

- precizie

- precis

- Obține

- achiziție

- peste

- act

- adăugat

- Caracteristici adăugate

- plus

- În plus,

- adresa

- Promovare

- sfat

- afecta

- După

- împotriva

- AI

- Alexa

- Algoritmul

- algoritmi

- TOATE

- permite

- de asemenea

- Cu toate ca

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- Amazon.com

- America

- Sume

- an

- analiză

- analiza

- și

- Andrew

- anual

- O alta

- răspunde

- Orice

- oricine

- api

- aplicatii

- aplicat

- abordare

- adecvat

- Apps

- SUNT

- ZONĂ

- articol

- AS

- evaluare

- At

- atenţie

- atragere

- August

- Automat

- disponibil

- AWS

- bar

- de bază

- bazat

- BE

- deoarece

- deveni

- fost

- înainte

- fiind

- Crede

- Beneficiile

- Berkeley

- Mai bine

- Mare

- miliarde

- atât

- larg

- construi

- construit-in

- afaceri

- dar

- by

- apel

- denumit

- apeluri

- CAN

- Poate obține

- capabil

- Capacitate

- card

- pasă

- caz

- cazuri

- certifica

- lanţ

- provocări

- Canal

- taxe

- chatbots

- verifica

- Alege

- a ales

- ales

- împrejurări

- Citibank

- Clara

- clasificare

- Închide

- clustering

- cod

- Coloană

- COM

- comentarii

- Comun

- în mod obișnuit

- comunitate

- Companii

- companie

- Compania

- comparaţie

- comparație

- compararea

- comparație

- Completă

- completare

- Calcula

- calculator

- Informatică

- tehnica de calcul

- puterea de calcul

- condiție

- Condiții

- conferințe

- Lua în considerare

- luate în considerare

- Consoleze

- construirea

- Consumatorii

- conţine

- Recipient

- conține

- conţinut

- continua

- Control

- controale

- comoditate

- Istoria

- Corespunzător

- A costat

- acoperit

- Covers

- Covid-19

- Pandemie COVID-19

- crea

- Creator

- critic

- În prezent

- personalizat

- client

- Serviciu clienți

- clienţii care

- de date

- știința datelor

- Baza de date

- seturi de date

- decembrie

- Refuzați

- adânc

- învățare profundă

- Mod implicit

- livrarea

- Oferă

- Cerere

- demonstra

- demonstrat

- implementa

- dislocate

- Implementarea

- Instrumentele financiare derivate

- descris

- descriere

- Amenajări

- proiectat

- detalii

- Detectare

- Determina

- determină

- Dezvoltatorii

- în curs de dezvoltare

- Dezvoltare

- Dispozitive

- FĂCUT

- diferit

- dificil

- digital

- direct

- dezvăluire

- discuta

- discuţie

- distribuite

- instruire distribuită

- Docher

- documente

- domeniu

- zeci

- condus

- în timpul

- fiecare

- Mai devreme

- cu ușurință

- ușor de folosit

- Eficace

- eficiență

- eficiență

- eficient

- Electronic

- permite

- activat

- Punct final

- sporită

- Afacere

- Companii

- Întreg

- entitate

- epoci

- Ernst & Young

- mai ales

- stabili

- evalua

- evaluarea

- evaluare

- de fiecare zi

- tot

- exemplu

- exemple

- Cu excepția

- schimb

- Exercita

- existent

- expansiune

- aștepta

- aşteptare

- scump

- experiment

- expert

- Explorarea

- extensiv

- Față

- FAST

- DESCRIERE

- puțini

- camp

- Fișier

- Depunerea

- În cele din urmă

- finanţa

- financiar

- sfaturi financiare

- date financiare

- informatie financiara

- capăt

- First

- potrivi

- Concentra

- se concentrează

- următor

- urmează

- Pentru

- pentru investitori

- Prognoză

- frunte

- formă

- format

- de perspectivă

- găsit

- Fundație

- Al patrulea

- din

- Complet

- funcționalitate

- fundamental

- mai mult

- viitor

- genera

- generată

- generează

- generaţie

- obține

- dat

- Caritate

- Go

- Merge

- merge

- bine

- unități de procesare grafică

- gradienți

- mai mare

- Teren

- Crește

- În creştere

- Creștere

- Piese metalice

- Avea

- he

- Sănătate

- Sănătate

- ajutor

- ajută

- aici

- Înalt

- performanta ridicata

- deține

- capotă

- gazdă

- găzduit

- Cum

- Cum Pentru a

- HTML

- http

- HTTPS

- Față îmbrățișată

- sute

- sute de milioane

- Optimizarea hiperparametrului

- i

- idee

- identificat

- imagine

- Clasificarea imaginilor

- Impactul

- afectate

- import

- impresionant

- îmbunătăţi

- îmbunătățire

- in

- Inc

- include

- inclus

- include

- Inclusiv

- Venituri

- care încorporează

- Crește

- a crescut

- crescând

- incredibil

- indian

- informații

- Infrastructură

- inițiative

- intrare

- instanță

- in schimb

- Institut

- integra

- interacţiona

- interese

- Internațional

- în

- introduce

- investiţie

- Investopedia

- investitor

- Investitori

- IT

- articole

- ESTE

- Loc de munca

- jpg

- JSON

- doar

- Cheie

- Cunoaște

- cunoştinţe

- cunoscut

- etichete

- limbă

- Limbă

- mare

- cea mai mare

- lansa

- AFLAȚI

- învățat

- învăţare

- Bibliotecă

- de licențiere

- ușoară

- ca

- Listă

- LLM

- Lung

- Uite

- cautati

- de pe

- Jos

- preturi mici

- maşină

- masina de învățare

- făcut

- major

- face

- Efectuarea

- administra

- administrare

- manual

- multe

- Martie

- Piață

- Marketing

- piaţă

- masiv

- material

- Mai..

- mijloace

- măsura

- apartenență

- de membru

- Memorie

- metodă

- metric

- migra

- milion

- milioane

- minute

- mixt

- ML

- Mobil

- mobile-aplicații

- model

- Modele

- mai mult

- cele mai multe

- Filme

- MS

- multiplu

- nume

- Numit

- Natural

- Procesarea limbajului natural

- Navigare

- necesar

- Nevoie

- net

- Nou

- produs nou

- New York

- următor

- nlp

- nod

- North

- America de Nord

- caiet

- acum

- număr

- Obezitatea

- obiect

- Detectarea obiectelor

- obține

- obținut

- of

- oferi

- oferind

- ofertele

- promoții

- on

- ONE

- în curs de desfășurare

- on-line

- piața online

- retailer online

- afară

- open-source

- de operare

- Operațiuni

- Oportunităţi

- optimizare

- or

- comandă

- comenzilor

- Organizat

- original

- Altele

- al nostru

- Perspectivă

- producție

- exterior

- peste

- trece peste

- Prezentare generală

- propriu

- proprietar

- pandemie

- pâine

- lucrări

- parametrii

- parte

- special

- în special

- petreceri

- trece

- Trecut

- Care trece

- cale

- modele

- oameni

- Efectua

- performanță

- efectuarea

- efectuează

- perioadă

- perioadele

- FIL

- fizic

- Fizic

- alege

- Locuri

- Plato

- Informații despre date Platon

- PlatoData

- Politicile

- posibil

- Post

- postări

- potenţial

- putere

- Practic

- Precizie

- prezice

- estimarea

- Predictii

- Predictor

- prezenta

- prezentat

- preşedinte

- împiedica

- Prevenirea

- precedent

- preţ

- Prețuri

- de stabilire a prețurilor

- în primul rând

- Prim

- Principal

- anterior

- probleme

- proces

- procese

- prelucrare

- Produs

- producere

- productivitate

- Produse

- Profesor

- Program

- promoţii

- propunere

- furniza

- prevăzut

- furnizează

- public

- publicat

- editor

- scop

- scopuri

- Piton

- Trimestru

- întrebare

- Întrebări

- repede

- dezordine

- rată

- Citeste

- real

- primit

- reduce

- se referă

- cu privire la

- regex

- regiune

- Regulament

- autoritățile de reglementare

- legate de

- eliberat

- raportează

- Rapoarte

- necesar

- Necesită

- cercetare

- Resurse

- respect

- răspuns

- responsabil

- rezultat

- REZULTATE

- cu amănuntul

- vânzător cu amănuntul

- revizuite

- revoluţiona

- robust

- Rol

- regal

- Alerga

- funcţionare

- sagemaker

- SageMaker Inference

- de vânzări

- acelaşi

- Mos Craciun

- scalabil

- Scară

- Ştiinţă

- Om de stiinta

- scor

- sdk

- Caută

- SEC

- Depunerea SEC

- Al doilea

- secretar

- Secțiune

- secțiuni

- Titluri de valoare

- vedere

- segmente

- selectate

- selecţie

- vinde

- Vanzatorii

- De vânzare

- senior

- propoziție

- sentiment

- Septembrie

- Secvenţă

- serie

- Seria A

- servi

- serviciu

- Servicii

- set

- instalare

- setări

- câteva

- Distribuie

- Livrarea

- Cumpărături

- să

- Arăta

- indicat

- Emisiuni

- semnificativ

- simplu

- singur

- Mărimea

- dimensiuni

- mai mici

- So

- Societate

- vândut

- soluţie

- soluţii

- REZOLVAREA

- Surse

- specialiști

- de specialitate

- specializată

- specific

- Cheltuire

- Începe

- început

- Stat

- Declarații

- statistic

- Pas

- paşi

- depozitare

- magazine

- Strategic

- Strategie

- de streaming

- rezistenţă

- lupta

- studio

- succes

- astfel de

- livra

- lanțului de aprovizionare

- Suportat

- De sprijin

- Sprijină

- sistem

- sisteme

- tabel

- Lua

- luare

- Sarcină

- sarcini

- echipă

- Tehnologia

- termeni

- termenii si condițiile

- test

- Clasificarea textului

- decât

- acea

- Zona

- Viitorul

- lor

- Lor

- prin urmare

- Acestea

- ei

- lucruri

- Al treilea

- terțe părți

- acest

- trei

- Prin

- timp

- consumă timp

- ori

- la

- indicativele

- top

- subiecte

- urmări

- Tren

- dresat

- Pregătire

- transferare

- transformat

- Traduceți

- Traveling

- Adevăr

- ÎNTORCĂ

- tv

- ui

- în

- înţelege

- înţelegere

- unic

- universitate

- nelimitat

- actualizări

- us

- Folosire

- utilizare

- utilizat

- folosind

- obișnuit

- utilizate

- Utilizand

- validare

- valoare

- Valori

- diverse

- versiune

- de

- Vicepreședinte

- practic

- a fost

- Washington

- Cale..

- modalități de

- we

- web

- servicii web

- website

- site-uri web

- BINE

- dacă

- care

- OMS

- voi

- cu

- fără

- Cuvânt

- Apartamente

- a lucrat

- fabrică

- lume

- ar

- an

- ani

- Tu

- tineri

- Ta

- zephyrnet