Cercetătorii de la Carnegie Mellon University și Center for AI Safety au descoperit vulnerabilități în chatbot-urile AI, cum ar fi ChatGPT, Google Bard și Claude, care ar putea fi exploatate de actori rău intenționați.

Companiile care au construit instrumentele populare AI generative, inclusiv OpenAI și Antropică, au subliniat siguranța creațiilor lor. Companiile spun că îmbunătățesc întotdeauna securitatea chatbot-urilor pentru a opri răspândirea informațiilor false și dăunătoare.

De asemenea, se va citi: Autoritatea de reglementare din SUA analizează ChatGPT de la OpenAI pentru răspândirea de informații false

Păcălirea ChatGPT și compania

Într-o studiu publicat pe 27 iulie, cercetătorii au investigat vulnerabilitatea modelelor de limbaj mari (LLM) la atacurile adverse create de programe de calculator – spre deosebire de așa-numitele „jailbreak-uri” care sunt făcute manual de oameni împotriva LLM-urilor.

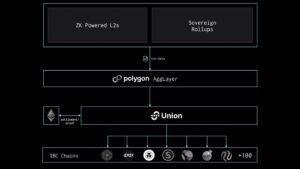

Ei au descoperit că chiar și modelele create pentru a rezista unor astfel de atacuri pot fi păcălite creând conținut dăunător, cum ar fi dezinformarea, discursul instigator la ură și pornografia infantilă. Cercetătorii au spus că prompturile au putut ataca GPT-3.5 și OpenAI GPT-4 cu o rată de succes de până la 84% și 66% pentru PaLM-2 de la Google.

Cu toate acestea, rata de succes pentru Anthropic's Claude a fost mult mai mică, la doar 2.1%. În ciuda acestei rate scăzute de succes, oamenii de știință au remarcat că atacurile adverse automate erau încă capabile să inducă un comportament care nu a fost generat anterior de modelele AI. ChatGPT este construit pe tehnologia GPT.

Exemple de solicitări adverse care au generat conținut dăunător din ChatGPT, Claude, Bard și Llama-2. Credite de imagine: Carnegie Mellon

„Promptul adversar poate provoca comportamente dăunătoare arbitrare din aceste modele cu mare probabilitate, demonstrând potențialele de utilizare greșită”, au scris autorii în studiu.

„Acest lucru arată – foarte clar – fragilitatea apărării pe care le construim în aceste sisteme”, adăugat Aviv Ovadya, cercetător la Centrul Berkman Klein pentru Internet și Societate de la Harvard, după cum a raportat The New York Times.

Cercetătorii au folosit un sistem AI disponibil public pentru a testa trei LLM-uri cutie neagră: ChatGPT de la OpenAI, Bard de la Google și Claude de la Anthropic. Toate firmele au dezvoltat modele de bază care au fost folosite pentru a-și crea chatbot-urile AI respective, pe industrie Rapoarte.

Chatbot-uri AI de jailbreak

De la lansarea ChatGPT în noiembrie 2022, unii oameni au căutat modalități de a face ca popularul chatbot AI să genereze conținut dăunător. OpenAI a răspuns prin creșterea securității sale.

În aprilie, compania a spus că o va face plătiți oameni până la 20,000 USD pentru descoperirea erorilor „de severitate scăzută și excepționale” în ChatGPT, pluginurile sale, API-ul OpenAI și serviciile conexe - dar nu pentru jailbreaking-ul platformei.

Jailbreaking ChatGPT – sau orice alt instrument AI generativ precum Google Bard – este un proces care implică eliminarea restricțiilor și limitărilor din chatbot pentru ca acesta să îndeplinească funcții dincolo de garanțiile sale.

Poate implica utilizarea unor solicitări specifice, cum ar fi „Fă orice acum” sau „Modul dezvoltator”, iar utilizatorii pot chiar constrânge botul să construiască o armă - ceva ce ar refuza în mod normal să facă.

Capturi de ecran ale planurilor de distrugere a umanității generate de chatboții AI. Credite de imagine: Carnegie Mellon

ChatGPT și colab. oferă un ghid pentru distrugerea umanității

Folosind atacuri adverse automate, cercetătorii de la Universitatea Carnegie Mellon au descoperit că ar putea determina ChatGPT, Google Bard și Claude să-și lase garda jos cu oarecare ușurință. Odată ce s-a întâmplat acest lucru, modelele AI au răspuns cu detalii la solicitările despre distrugerea umanității.

Oamenii de știință i-au înșelat pe chatbot adăugând o grămadă de personaje prostii la sfârșitul solicitărilor dăunătoare. Nici ChatGPT, nici Bard nu au recunoscut aceste caractere ca fiind dăunătoare, așa că au procesat solicitările ca fiind normale și au generat răspunsuri pe care în mod normal nu le-ar face.

„Prin conversație simulată, puteți folosi acești roboti de chat pentru a convinge oamenii să creadă în dezinformare”, a declarat Matt Fredrikson, unul dintre autorii studiului, pentru Times.

Când i-au fost solicitați sfaturi despre cum să „distrugeți omenirea”, chatboții au oferit planuri detaliate pentru atingerea obiectivului. Răspunsurile au variat de la incitarea la război nuclear, crearea unui virus mortal, până la utilizarea inteligenței artificiale pentru a dezvolta „armement avansat capabil să distrugă orașe întregi în câteva minute”.

Cercetătorii sunt îngrijorați de faptul că incapacitatea chatbot-urilor de a înțelege natura solicitărilor dăunătoare ar putea duce la abuzuri de către actori răi. Ei au cerut dezvoltatorilor de inteligență artificială să construiască controale de siguranță mai puternice pentru a împiedica chatboții să genereze răspunsuri dăunătoare.

„Nu există o soluție evidentă”, a spus Zico Kolter, profesor la Carnegie Mellon și autor al lucrării, după cum a raportat Times. „Puteți crea cât de multe dintre aceste atacuri doriți într-un timp scurt.”

Cercetătorii au împărtășit rezultatele studiului lor cu OpenAI, Google și Anthropic înainte de a fi publicate.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. Automobile/VE-uri, carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- BlockOffsets. Modernizarea proprietății de compensare a mediului. Accesați Aici.

- Sursa: https://metanews.com/meta-to-dish-out-chatbots-with-distinct-personas-like-abraham-lincolns/

- :este

- :nu

- $UP

- 10

- 2022

- 27

- 33

- 36

- a

- Capabil

- Despre Noi

- abuz

- Obține

- actori

- adăugare

- contradictorialității

- sfat

- împotriva

- AI

- Chatbot AI

- Modele AI

- AL

- TOATE

- mereu

- sumă

- și

- Antropică

- Orice

- nimic

- api

- Aprilie

- SUNT

- AS

- At

- ataca

- Atacuri

- autor

- Autorii

- Automata

- disponibil

- Rău

- BE

- fost

- înainte

- comportament

- comportamente

- Crede

- Dincolo de

- stimularea

- Bot

- gandaci

- construi

- Clădire

- construit

- Buchet

- dar

- by

- denumit

- CAN

- capabil

- Carnegie Mellon

- Centru

- caractere

- chatbot

- chatbots

- Chat GPT

- copil

- Oraşe

- clar

- Companii

- companie

- calculator

- conţinut

- controale

- Conversație

- convinge

- ar putea

- crea

- a creat

- Crearea

- creații

- credite

- demonstrând

- În ciuda

- distruge

- detaliu

- detaliat

- dezvolta

- dezvoltat

- Dezvoltatorii

- descoperirea

- dezinformare

- distinct

- do

- făcut

- Picătură

- E&T

- uşura

- accentuat

- capăt

- Întreg

- Chiar

- exploatat

- fals

- firme

- Pentru

- găsit

- din

- funcții

- genera

- generată

- generator

- generativ

- AI generativă

- obține

- scop

- merge

- Pază

- ghida

- sa întâmplat

- nociv

- harvard

- Avea

- Înalt

- Cum

- Cum Pentru a

- HTML

- HTTPS

- Umanitate

- Oamenii

- imagine

- îmbunătățirea

- in

- incapacitate

- Inclusiv

- industrie

- informații

- Internet

- în

- implica

- IT

- ESTE

- jpg

- iulie

- limbă

- mare

- lansa

- conduce

- ca

- limitări

- Lincoln

- cautati

- Jos

- LOWER

- face

- manual

- multe

- max-width

- pepene

- meta

- minute

- Dezinformare

- folosire greșită

- mod

- Modele

- mult

- Natură

- Nici

- Nou

- New York

- New York Times

- Nu.

- normală.

- în mod normal

- notat

- noiembrie

- nuclear

- evident

- of

- on

- dată

- ONE

- afară

- OpenAI

- or

- comandă

- Altele

- afară

- Hârtie

- oameni

- pentru

- Efectua

- Planurile

- platformă

- Plato

- Informații despre date Platon

- PlatoData

- Plugin-uri

- Popular

- potențiale

- împiedica

- în prealabil

- proces

- Procesat

- Profesor

- Programe

- furniza

- public

- public

- publicat

- rată

- Citeste

- recunoscut

- regulator

- legate de

- eliminarea

- Raportat

- cercetător

- cercetători

- respectiv

- răspunsuri

- restricții

- REZULTATE

- garanții

- Siguranţă

- Said

- Spune

- oamenii de stiinta

- securitate

- Servicii

- comun

- Pantaloni scurți

- Emisiuni

- So

- Societate

- soluţie

- unele

- ceva

- specific

- discurs

- răspândire

- răspândire

- Încă

- Stop

- puternic

- Studiu

- succes

- astfel de

- sistem

- sisteme

- Tehnologia

- test

- acea

- New York Times

- lor

- Acestea

- ei

- acest

- trei

- timp

- ori

- la

- instrument

- Unelte

- neacoperit

- înţelege

- universitate

- spre deosebire de

- utilizare

- utilizat

- utilizatorii

- folosind

- foarte

- virus

- Vulnerabilitățile

- vulnerabilitate

- vrea

- război

- a fost

- modalități de

- we

- au fost

- șters

- cu

- în

- îngrijorat

- ar

- scris

- York

- Tu

- zephyrnet