Vicepreședinte al IBM Quantum Jay Gambetta vorbește cu Philip Ball despre numeroasele progrese cuantice ale companiei în ultimii 20 de ani, precum și despre foaia de parcurs de cinci ani anunțată recent pentru „avantajul cuantic”

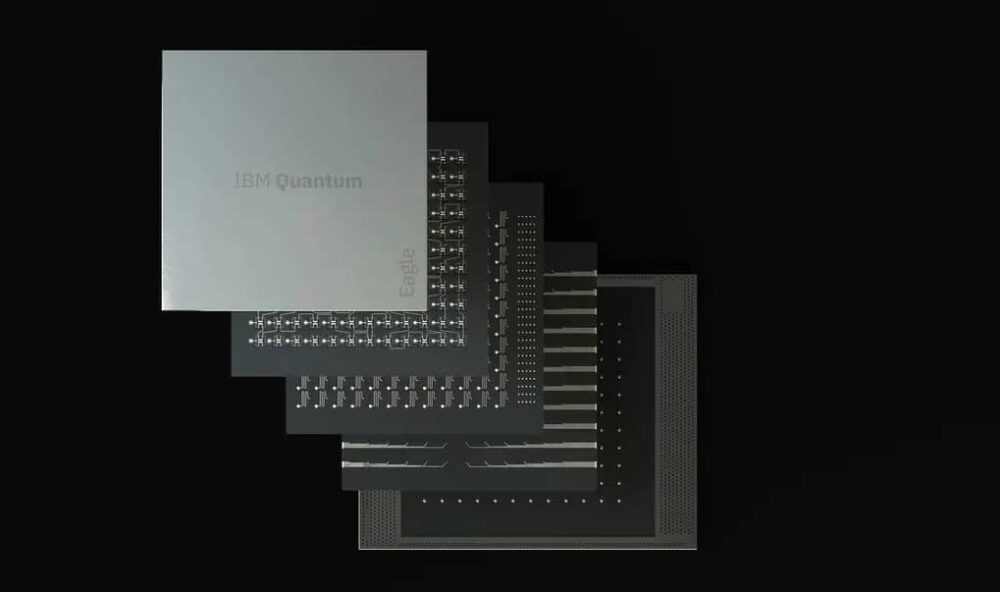

Companiile și laboratoarele de cercetare din întreaga lume lucrează pentru a-și scoate tehnologiile cuantice în curs de dezvoltare din laborator și în lumea reală, gigantul tehnologic american IBM fiind un jucător cheie. În luna mai a acestui an, IBM Quantum a dezvăluit cea mai recentă foaie de parcurs pentru viitorul calculului cuantic în următorul deceniu, iar firma și-a stabilit niște obiective ambițioase. După ce a anunțat-o Procesor Eagle cu 127 de biți cuantici (qubiți) anul trecut, compania este dezvoltă acum procesorul Osprey de 433 de qubit pentru un debut la sfârșitul acestui an, urmând să fie urmat în 2023 de Condor de 1121 de qubit.

Dar dincolo de asta, spune compania, jocul va trece la asamblarea unor astfel de procesoare în circuite modulare, în care cipurile sunt conectate împreună prin interconexiuni cuantice sau clasice mai rare. Acest efort va culmina cu ceea ce ei se referă drept dispozitivul lor Kookaburra de 4158 de qubiți în 2025. Dincolo de atunci, IBM prognozează modular procesoare cu 100,000 sau mai mulți qubiți, capabile să calculeze fără erorile care fac în prezent calculul cuantic o chestiune de a găsi soluții pentru zgomotul qubiților. Cu această abordare, echipa de calcul cuantică a companiei este încrezătoare că poate obține un „avantaj cuantic” general, în care computerele cuantice vor depăși în mod constant computerele clasice și vor efectua calcule complexe dincolo de mijloacele dispozitivelor clasice.

În timp ce se afla la Londra în drum spre 28th Conferința Solvay de la Bruxelles, care a abordat informațiile cuantice, Lumea fizicii ajuns din urmă cu un fizician Jay Gambetta, vicepreședinte al IBM Quantum. După ce a condus o mare parte din progresele companiei în ultimele două decenii, Gambetta a explicat cum ar putea fi atinse aceste obiective și ce vor implica ele pentru viitorul calculului cuantic.

Care este stadiul actual al tehnicii la IBM Quantum? Care sunt câțiva dintre parametrii cheie pe care vă concentrați?

Foaia de parcurs IBM se referă la extindere – nu doar numărul de qubiți, ci și viteza, calitatea și arhitectura lor de circuit. Acum avem timpi de coerență [durata pentru care qubiții rămân coerenți și capabili să efectueze un calcul cuantic] de 300 de microsecunde în procesorul Eagle [comparativ cu aproximativ 1 μs în 2010], iar următoarea generație de dispozitive va ajunge la 300 de milisecunde. Și qubiții noștri [făcuți din metale supraconductoare] au acum o fidelitate de aproape 99.9% [aceștia fac o singură eroare la fiecare 1000 de operații – o rată de eroare de 10-3]. Cred că 99.99% nu ar fi imposibil până la sfârșitul anului viitor.

Deci, testul final de turnesol pentru maturitatea computerelor cuantice este dacă timpul de rulare cuantic poate fi competitiv cu timpul de rulare clasic.

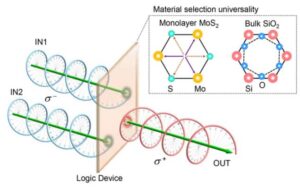

Dar a face lucrurile în mod inteligent va deveni mai important decât doar împingerea valorilor brute. Arhitectura procesorului devine din ce în ce mai importantă. Nu cred că vom depăși cu mult 1000 de qubiți per cip [ca pe Condor], așa că acum ne uităm la modularitate. În acest fel, putem ajunge la procesoare de 10,000 de qubiți până la sfârșitul acestui deceniu. Vom folosi atât comunicarea clasică (pentru a controla electronica) între cipuri, cât și canalele cuantice care creează unele încurcături (pentru a efectua calcule). Aceste canale între cipuri vor fi lente – poate de 100 de ori mai lente decât circuitele în sine. Și fidelitățile canalelor vor fi greu de împins peste 95%.

Pentru calcularea de înaltă performanță, ceea ce contează cu adevărat este reducerea timpului de rulare – adică minimizarea timpului necesar pentru a genera o soluție pentru o problemă de interes. Testul final de turnesol pentru maturitatea computerelor cuantice este dacă timpul de rulare cuantic poate fi competitiv cu timpul de rulare clasic. Am început să arătăm teoretic că, dacă aveți un circuit mare pe care doriți să-l rulați și îl împărțiți în circuite mai mici, atunci de fiecare dată când faceți o tăietură, vă puteți gândi la un cost clasic, care crește timpul de rulare. exponenţial. Deci, scopul este de a menține această creștere exponențială cât mai aproape de 1.

Pentru un circuit dat, timpul de rulare depinde exponențial de a parametrul pe care îl numim γ̄ ridicat la putere nd, În cazul în care n este numărul de qubiți și d este adâncimea [o măsură a celei mai lungi căi dintre intrarea și ieșirea circuitului sau, echivalent, numărul de pași de timp necesari pentru ca circuitul să funcționeze]. Deci, dacă putem obțineb γ̄ cât mai aproape de 1, ajungem la un punct în care există un avantaj cuantic real: nicio creștere exponențială în timpul de execuție. Putem reduce γ̄ prin îmbunătățiri ale coerenței și fidelității porții [rata de eroare intrinsecă]. În cele din urmă, vom ajunge la un punct de cotitură în care, chiar și cu supraîncărcarea exponențială a atenuării erorilor, putem obține beneficii de rulare față de computerele clasice. Dacă puteți reduce γ̄ la 1.001, timpul de rulare este mai rapid decât dacă ar fi să simulați acele circuite în mod clasic. Sunt încrezător că putem face acest lucru – cu îmbunătățiri ale fidelității porții și diafonie suprimată între qubiți, am măsurat deja un γ̄ de 1.008 pe cipul Falcon r10 [27-qubit].

Cum puteți face acele îmbunătățiri pentru atenuarea erorilor?

Pentru a îmbunătăți fidelitatea, am adoptat o abordare numită anularea erorilor probabilistice [arXiv:2201.09866]. Ideea este că îmi trimiteți sarcini de lucru și vă voi trimite rezultate procesate cu estimări fără zgomot ale acestora. Spui că vreau să conduci acest circuit; Caracterizez tot zgomotul pe care îl am în sistemul meu și fac multe rulări și apoi procesez toate acele rezultate împreună pentru a vă oferi o estimare fără zgomot a ieșirii circuitului. În acest fel, începem să arătăm că este probabil să existe un continuum de unde ne aflăm astăzi, cu suprimarea erorilor și atenuarea erorilor până la corectarea completă a erorilor.

Deci, puteți ajunge acolo fără a construi qubiți logici care corectează complet erorile?

Ce este de fapt un qubit logic? Ce înseamnă de fapt oamenii prin asta? Ceea ce contează cu adevărat este: puteți rula circuite logice și cum le rulați într-un mod în care timpul de rulare devine mereu mai rapid? În loc să ne gândim la construirea de qubiți logici, ne gândim la modul în care rulăm circuitele și le oferim utilizatorilor estimări ale răspunsului, apoi îl cuantificăm în funcție de timpul de execuție.

Când faceți corectarea normală a erorilor, corectați ceea ce credeați că ar fi fost răspunsul până în acel moment. Actualizați un cadru de referință. Dar vom obține corectarea erorilor prin atenuarea erorilor. Cu γ̄ egal cu 1, voi avea efectiv corectarea erorilor, pentru că nu există nicio taxă generală pentru îmbunătățirea estimărilor atât cât doriți.

În acest fel, vom avea efectiv qubiți logici, dar vor fi inserați continuu. Așa că începem să ne gândim la asta la un nivel superior. Viziunea noastră este de a crea, din perspectiva utilizatorului, un continuum care devine din ce în ce mai rapid. Testul final de turnesol pentru maturitatea computerelor cuantice este, prin urmare, dacă timpul de rulare cuantic poate fi competitiv cu timpul de rulare clasic.

Este foarte diferit de ceea ce fac alte firme cuantice, dar voi fi foarte surprins dacă acest lucru nu devine o viziune generală – pun pariu că vei începe să vezi oameni comparând timpii de execuție, nu ratele de corecție a erorilor.

Ceea ce facem este doar calcul în general și îi dăm un impuls printr-un procesor cuantic

Dacă faci dispozitive modulare cu conexiuni clasice, înseamnă asta că viitorul nu este cuantic versus clasic, ci cuantic? și clasic?

Da. Adunarea clasică și cuantică vă va permite să faceți mai mult. Acesta este ceea ce eu numesc surplus cuantic: să faci calcul clasic într-un mod inteligent folosind resurse cuantice.

Dacă aș putea agita o baghetă magică, nu aș numi-o calcul cuantic. M-aș întoarce și aș spune că ceea ce facem este doar calcul în general și îi dăm un impuls printr-un procesor cuantic. Am folosit expresia „supercomputing centrat pe cuantum”. Este într-adevăr despre intensificarea calculului prin adăugarea de cuanți. Chiar cred că asta va fi arhitectura.

Care sunt obstacolele tehnice? Contează că aceste dispozitive au nevoie de răcire criogenică, să zicem?

Asta nu este chiar mare lucru. O problemă mai mare este că, dacă continuăm pe harta noastră de parcurs, sunt îngrijorat de prețul electronicelor și de toate lucrurile care o înconjoară. Pentru a reduce aceste costuri, trebuie să dezvoltăm un ecosistem; iar noi, ca comunitate, încă nu facem suficient pentru a crea acel mediu. Nu văd mulți oameni care se concentrează doar pe electronică, dar cred că se va întâmpla.

Toată știința este acum făcută, astfel încât acum este mai mult o chestiune de inginerie?

Întotdeauna va fi știință de făcut, mai ales când trasați această cale de la atenuarea erorilor la corectarea erorilor. Ce tip de conexiune doriți să construiți în cip? Care sunt conexiunile? Toate acestea sunt științe fundamentale. Cred că putem încă împinge ratele de eroare la 10-5. Personal, nu-mi place să etichet lucrurile „știință” sau „tehnologie”; construim o inovație. Cred că există cu siguranță o tranziție către aceste dispozitive care devin instrumente, iar întrebarea devine cum folosim aceste lucruri pentru știință, mai degrabă decât despre știința creării instrumentului.

Ești îngrijorat că ar putea exista o bulă cuantică?

Nu. Cred că avantajul cuantic poate fi împărțit în două lucruri. În primul rând, cum rulați de fapt circuitele mai repede pe hardware-ul cuantic? Sunt încrezător că pot face predicții despre asta. Și în al doilea rând, cum folosiți de fapt aceste circuite și le raportați la aplicații? De ce o metodă bazată pe cuanți funcționează mai bine decât doar o metodă clasică? Sunt întrebări științifice foarte grele. Și sunt întrebări de care sunt interesați fizicienii de înaltă energie, oamenii de știință ai materialelor și chimiștii cuantici. Cred că va fi cu siguranță o cerere – o vedem deja. Vedem că unele întreprinderi de afaceri se interesează și ele, dar va dura ceva timp pentru a găsi soluții reale, mai degrabă decât cuantica să fie un instrument pentru a face știință.

Văd asta ca fiind o tranziție lină. Un mare potențial domeniu de aplicare îl reprezintă problemele care au date cu un anumit tip de structură, în special date pentru care este foarte greu de găsit corelațiile în mod clasic. Finanța și medicina se confruntă atât cu probleme de genul acesta, iar metodele cuantice precum învățarea automată cuantică sunt foarte bune în găsirea corelațiilor. Va fi un drum lung, dar merită investiția ca ei să o facă.

Ce zici de menținerea în siguranță a calculului împotriva, să zicem, atacuri precum algoritmul de factoring al lui Shor, care exploatează metode cuantice pentru a sparge metodele criptografice actuale cu cheie publică, bazate pe factorizare?

Toată lumea vrea să fie în siguranță împotriva algoritmului lui Shor – acum este numit „sigur cuantic”. Avem o mulțime de cercetări fundamentale în algoritmi, dar cum să le integrăm va deveni o întrebare importantă. Investigăm să integrăm acest lucru în produsele noastre tot timpul, mai degrabă decât ca supliment. Și trebuie să ne întrebăm cum ne asigurăm că avem infrastructura clasică care este sigură pentru quantum. Modul în care se va desfășura acel viitor va fi foarte important în următorii câțiva ani - cum construiești hardware cuantic sigur de la zero.

Definiția mea a succesului este atunci când majoritatea utilizatorilor nici măcar nu vor ști că folosesc un computer cuantic

Ai fost surprins de viteza cu care a ajuns calculul cuantic?

Pentru cineva care a fost în ea la fel de adânc ca mine din 2000, a urmat remarcabil de aproape de drumul care a fost prezis. Îmi amintesc că m-am întors la o foaie de parcurs IBM internă din 2011 și a fost destul de potrivită. Am crezut că inventez lucrurile atunci! În general, simt că oamenii supraestimează cât timp va dura. Pe măsură ce suntem din ce în ce mai avansati, iar oamenii aduc idei de informații cuantice pe aceste dispozitive, în următorii câțiva ani vom putea rula circuite mai mari. Apoi va fi vorba despre tipurile de arhitectură pe care trebuie să le construiți, cât de mari sunt clusterele, ce tipuri de canale de comunicare folosiți și așa mai departe. Aceste întrebări vor fi determinate de tipul de circuite pe care le rulați: cum începem să construim mașini pentru anumite tipuri de circuite? Va exista o specializare a circuitelor.

Cum va arăta 2030 pentru calculul cuantic?

Definiția mea a succesului este atunci când majoritatea utilizatorilor nici măcar nu vor ști că folosesc un computer cuantic, deoarece este încorporat într-o arhitectură care funcționează perfect cu calcularea clasică. Măsura succesului ar fi atunci că este invizibil pentru majoritatea oamenilor care îl folosesc, dar le îmbunătățește viața într-un fel. Poate că telefonul tău mobil va folosi o aplicație care își face estimarea folosind un computer cuantic. În 2030 nu vom fi la acel nivel, dar cred că vom avea mașini foarte mari până atunci și vor depăși cu mult ceea ce putem face în mod clasic.