În lumea dinamică a streamingului Amazon Muzica, fiecare căutare a unui cântec, podcast sau playlist conține o poveste, o dispoziție sau un val de emoții care așteaptă să fie dezvăluite. Aceste căutări servesc ca o poartă către noi descoperiri, experiențe prețuite și amintiri durabile. Bara de căutare nu este doar despre găsirea unui cântec; este vorba despre milioanele de utilizatori activi care își încep călătoria personală în lumea bogată și diversă pe care Amazon Music o are de oferit.

Oferirea unei experiențe superioare pentru clienți pentru a găsi instantaneu muzica pe care o caută utilizatorii necesită o platformă inteligentă și receptivă. Amazon Music folosește puterea AI pentru a realiza acest lucru. Cu toate acestea, optimizarea experienței clienților în timp ce gestionați costurile de instruire și deducerea modelelor AI care alimentează capacitățile barei de căutare, cum ar fi verificarea ortografică în timp real și căutarea vectorială, este dificilă în perioadele de vârf de trafic.

Amazon SageMaker oferă un set de servicii end-to-end care permit Amazon Music să creeze, să antreneze și să implementeze pe AWS Cloud cu efort minim. Având grijă de ridicarea greutății nediferențiate, SageMaker vă permite să vă concentrați pe lucrul la modelele de învățare automată (ML) și să nu vă faceți griji cu privire la lucruri precum infrastructura. Ca parte a modelului de responsabilitate partajată, SageMaker se asigură că serviciile pe care le furnizează sunt fiabile, performante și scalabile, în timp ce vă asigurați că aplicarea modelelor ML folosește cel mai bine capacitățile pe care le oferă SageMaker.

În această postare, parcurgem călătoria pe care a făcut-o Amazon Music pentru a optimiza performanța și costurile folosind SageMaker și NVIDIA Triton Inference Server și TensorRT. Ne aprofundăm în a arăta cum funcționează acea bară de căutare aparent simplă, dar complicată, asigurând o călătorie neîntreruptă în universul Amazon Music, cu întârzieri frustrante de tipar de la puțin până la zero și rezultate relevante de căutare în timp real.

Amazon SageMaker și NVIDIA: Oferă capabilități rapide și precise de căutare vectorială și verificare ortografică

Amazon Music oferă o bibliotecă vastă de peste 100 de milioane de melodii și milioane de episoade de podcast. Cu toate acestea, găsirea melodiei sau a podcastului potrivit poate fi o provocare, mai ales dacă nu cunoașteți titlul exact, artistul sau numele albumului sau dacă interogarea căutată este foarte largă, cum ar fi „podcasturi de știri”.

Amazon Music a adoptat o abordare în două direcții pentru a îmbunătăți procesul de căutare și recuperare. Primul pas este introducerea căutării vectoriale (cunoscută și sub numele de regăsire bazată pe încorporare), o tehnică ML care poate ajuta utilizatorii să găsească conținutul cel mai relevant pe care îl caută folosind semantica conținutului. Al doilea pas implică introducerea unui model de corectare a vrăjii bazat pe Transformer în stiva de căutare. Acest lucru poate fi util în special atunci când căutați muzică, deoarece este posibil ca utilizatorii să nu cunoască întotdeauna ortografia exactă a titlului unei melodii sau a numelui artistului. Corectarea ortografică poate ajuta utilizatorii să găsească muzica pe care o caută, chiar dacă greșesc de ortografie în interogarea lor de căutare.

Introducerea modelelor Transformer într-o conductă de căutare și recuperare (în generarea de încorporare a interogărilor necesară pentru căutarea vectorială și modelul generativ Seq2Seq Transformer în Spell Correction) poate duce la o creștere semnificativă a latenței generale, afectând negativ experiența clienților. Prin urmare, a devenit o prioritate pentru noi să optimizăm latența de inferență în timp real pentru modelele de căutare vectorială și de corectare a ortografiei.

Amazon Music și NVIDIA s-au unit pentru a aduce cea mai bună experiență posibilă pentru clienți în bara de căutare, folosind SageMaker pentru a implementa atât capabilități de verificare ortografică rapide și precise, cât și sugestii de căutare semantică în timp real, folosind tehnici bazate pe căutare vectorială. Soluția include utilizarea de găzduire SageMaker alimentată de instanțe G5 care utilizează GPU-uri NVIDIA A10G Tensor Core, containerul pentru serverul de inferință NVIDIA Triton acceptat de SageMaker și NVIDIA TensorRT formatul modelului. Prin reducerea latenței de inferență a modelului de verificare ortografică la 25 de milisecunde la traficul de vârf și prin reducerea latenței de generare a interogărilor de căutare cu 63% în medie și a costului cu 73% în comparație cu inferența bazată pe CPU, Amazon Music a crescut performanța barei de căutare.

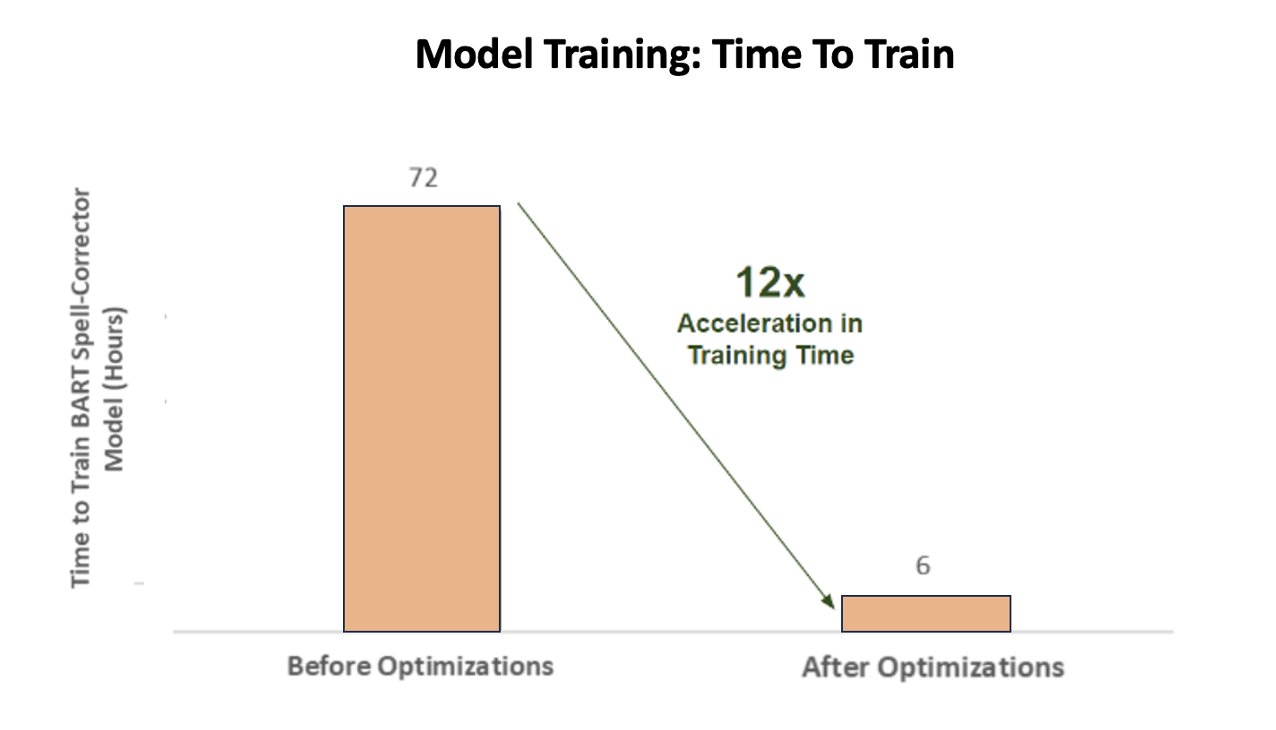

În plus, atunci când antrenează modelul AI pentru a oferi rezultate precise, Amazon Music a obținut o accelerare uriașă de 12 ori în timpul de antrenament pentru modelul lor de transformator de corectare a vrăjii secvență-la-secvență BART, economisindu-le atât timp, cât și bani, prin optimizarea utilizării GPU-ului.

Amazon Music a colaborat cu NVIDIA pentru a prioritiza experiența de căutare a clienților și pentru a crea o bară de căutare cu funcționalități de verificare ortografică și de căutare vectorială bine optimizate. În secțiunile următoare, împărtășim mai multe despre cum au fost orchestrate aceste optimizări.

Optimizarea antrenamentului cu GPU-urile NVIDIA Tensor Core

Obținerea accesului la un GPU NVIDIA Tensor Core pentru formarea modelelor de limbi mari nu este suficient pentru a-și surprinde adevăratul potențial. Există pași cheie de optimizare care trebuie să aibă loc în timpul antrenamentului pentru a maximiza pe deplin utilizarea GPU-ului. Cu toate acestea, un GPU subutilizat va duce, fără îndoială, la utilizarea ineficientă a resurselor, durate prelungite de antrenament și costuri operaționale crescute.

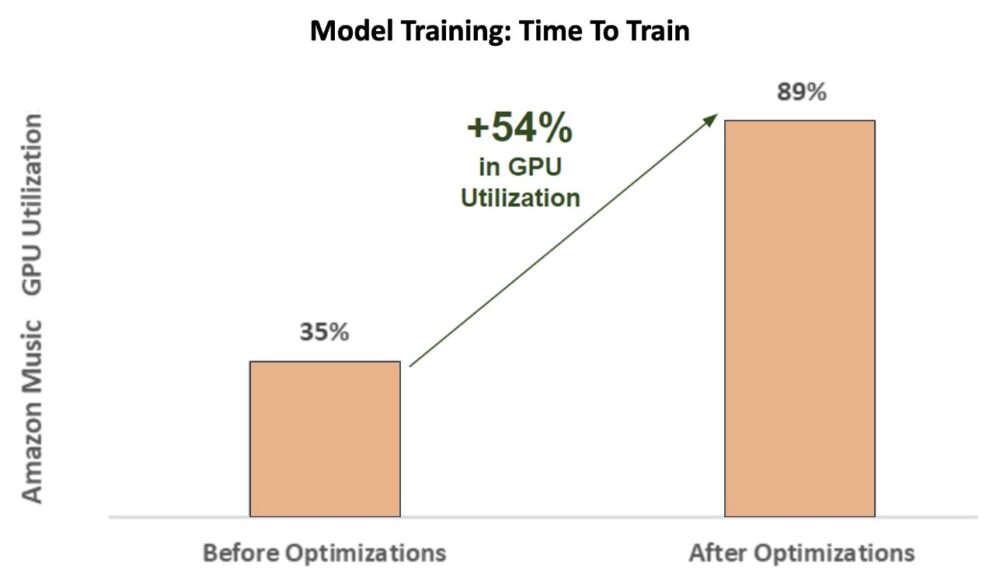

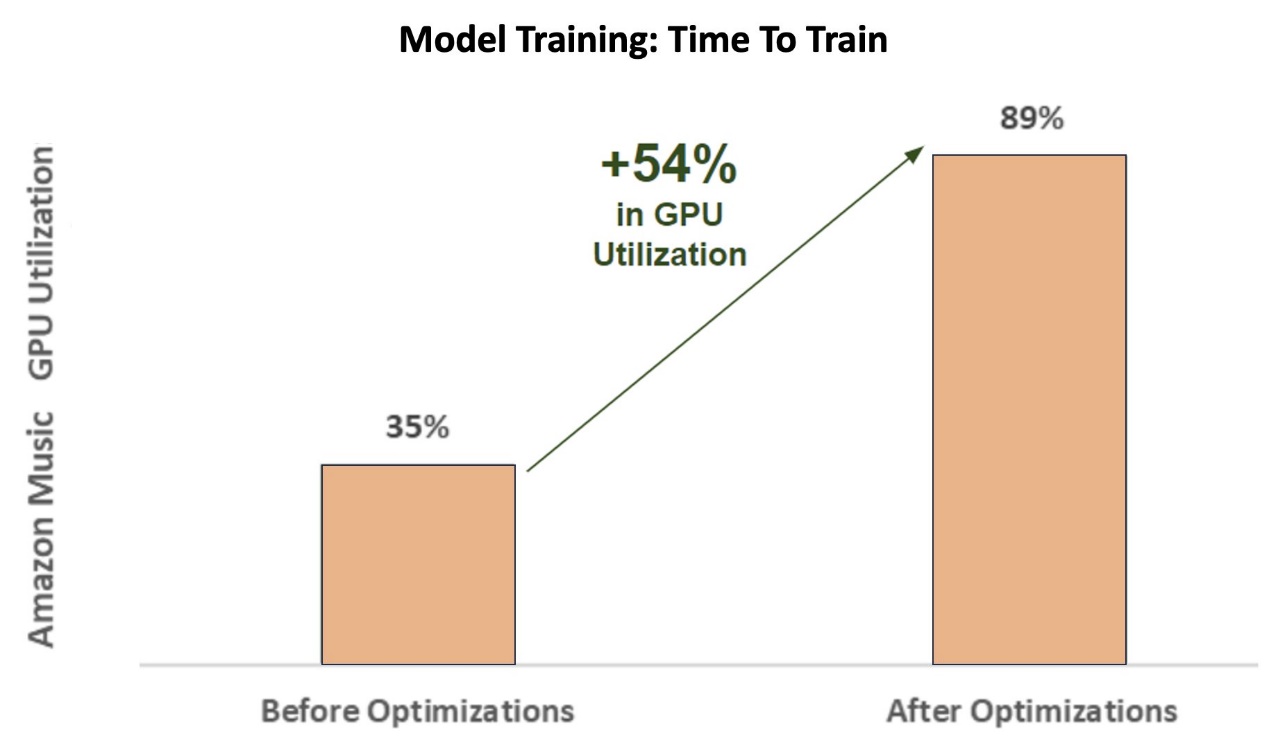

În fazele inițiale de antrenament corectorul ortografic BART (bart-bază) model de transformator pe o instanță SageMaker ml.p3.24xlarge (8 GPU-uri NVIDIA V100 Tensor Core), utilizarea GPU-ului Amazon Music a fost de aproximativ 35%. Pentru a maximiza beneficiile instruirii accelerate de GPU NVIDIA, arhitecții de soluții AWS și NVIDIA au sprijinit Amazon Music în identificarea zonelor de optimizare, în special în ceea ce privește dimensiunea lotului și parametrii de precizie. Acești doi parametri cruciali influențează eficiența, viteza și acuratețea modelelor de deep learning de formare.

Optimizările rezultate au produs o utilizare nouă și îmbunătățită a GPU-ului V100, constantă la aproximativ 89%, reducând drastic timpul de antrenament al Amazon Music de la 3 zile la 5-6 ore. Prin comutarea dimensiunii lotului de la 32 la 256 și folosind tehnici de optimizare, cum ar fi rularea antrenament automat de precizie mixtă în loc să folosească doar precizia FP32, Amazon Music a reușit să economisească atât timp, cât și bani.

Următorul grafic ilustrează creșterea cu 54% procentuală a utilizării GPU-ului după optimizări.

Figura următoare ilustrează accelerația timpului de antrenament.

Această creștere a dimensiunii lotului a permis GPU-ului NVIDIA să proceseze în mod semnificativ mai multe date simultan pe mai multe nuclee Tensor, rezultând un timp de antrenament accelerat. Cu toate acestea, este important să mențineți un echilibru delicat cu memoria, deoarece loturile mai mari necesită mai multă memorie. Atât creșterea dimensiunii lotului, cât și utilizarea unei precizii mixte pot fi esențiale în deblocarea puterii GPU-urilor NVIDIA Tensor Core.

După ce modelul a fost antrenat pentru convergență, era timpul să se optimizeze pentru implementarea inferenței pe bara de căutare a Amazon Music.

Corectare ortografică: deducerea modelului BART

Cu ajutorul instanțelor SageMaker G5 și NVIDIA Triton Inference Server (un software de servire a inferențelor cu sursă deschisă), precum și NVIDIA TensorRT, un SDK pentru inferențe de învățare profundă de înaltă performanță, care include un optimizator de inferență și un timp de execuție, Amazon Music își limitează verificarea ortografică BART (bart-bază) modelează latența de inferență a serverului la doar 25 de milisecunde la traficul de vârf. Acestea includ cheltuieli generale precum echilibrarea încărcăturii, preprocesarea, deducerea modelului și timpii de postprocesare.

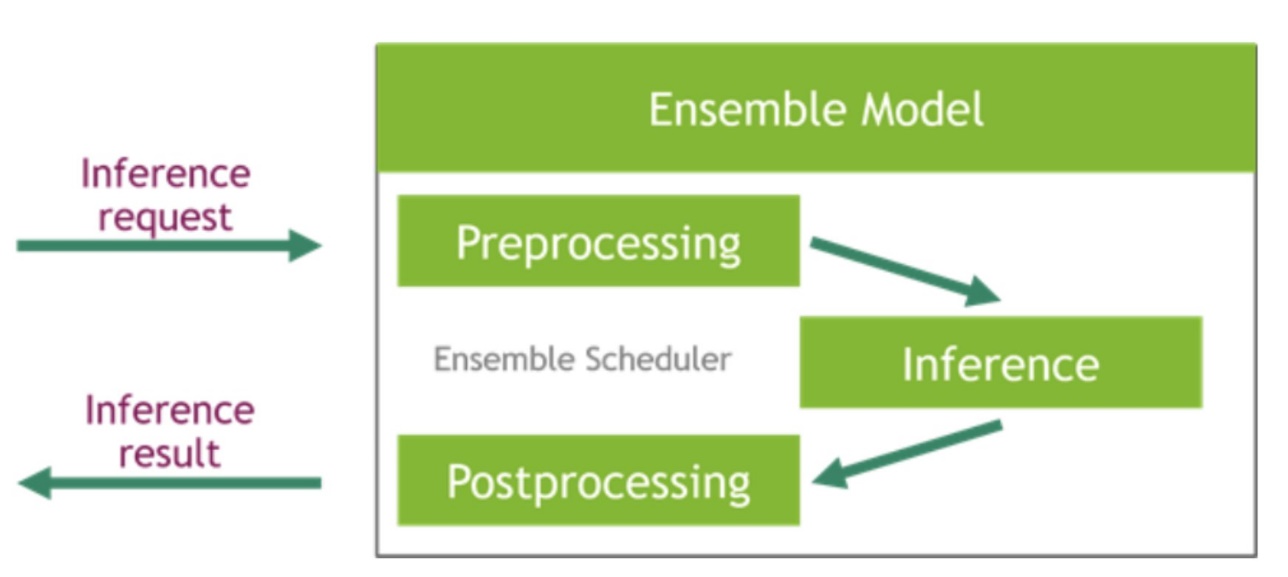

NVIDIA Triton Inference Server oferă două tipuri diferite de backend: unul pentru găzduirea modelelor pe GPU și un backend Python unde vă puteți aduce propriul cod personalizat pentru a fi utilizat în pașii de preprocesare și postprocesare. Figura următoare ilustrează schema de ansamblu model.

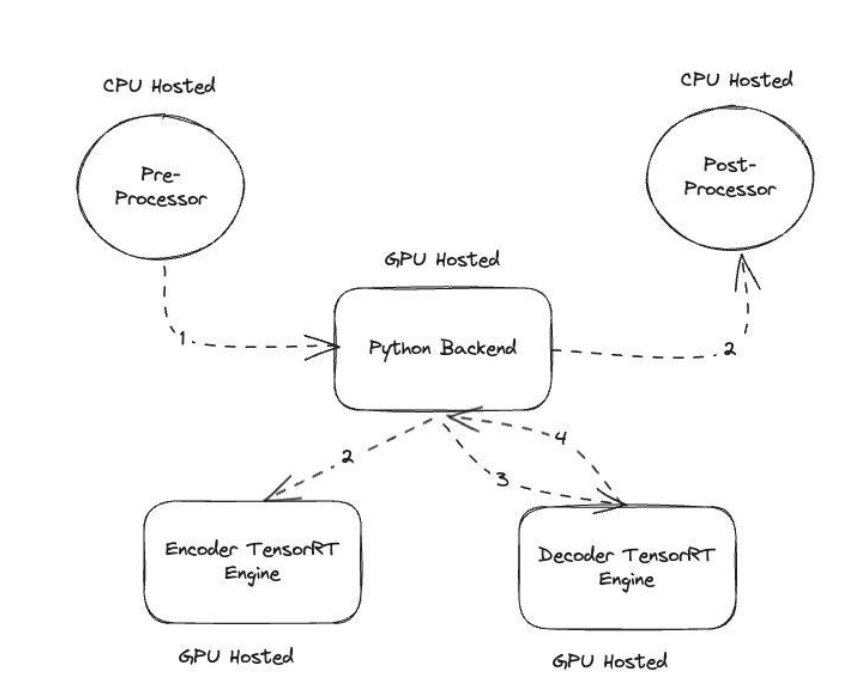

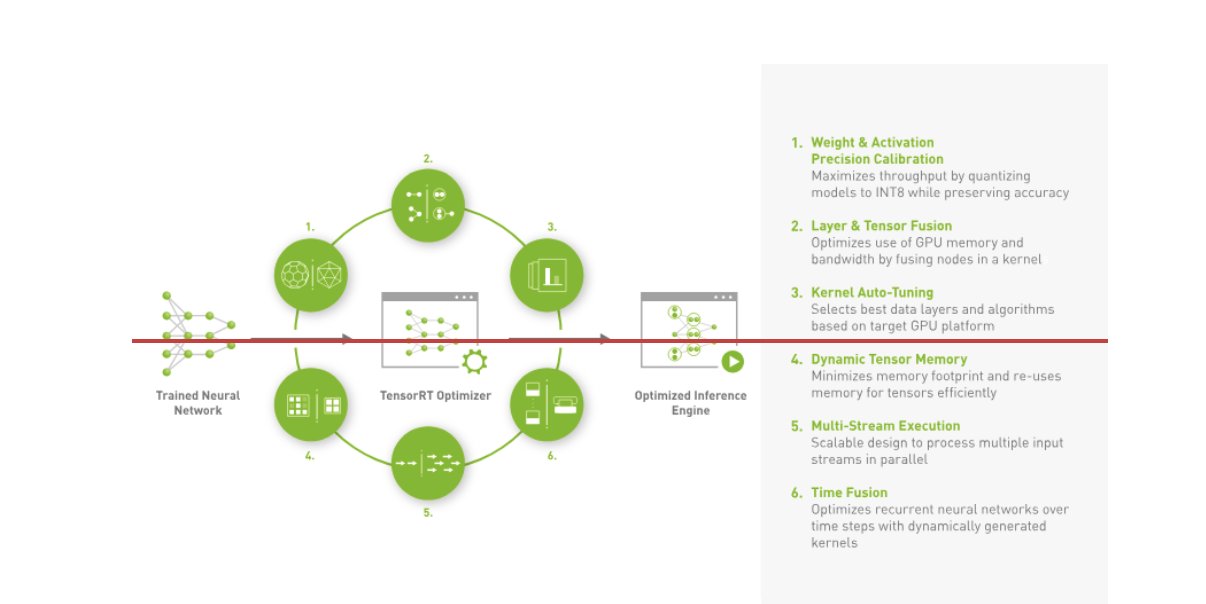

Amazon Music și-a construit BART conductă de inferență rulând atât pașii de preprocesare (tokenizare text) cât și postprocesare (jetoane în text) pe CPU, în timp ce pasul de execuție a modelului rulează pe GPU-uri NVIDIA A10G Tensor Core. Un backend Python se află la mijlocul etapelor de preprocesare și postprocesare și este responsabil pentru comunicarea cu modelele BART convertite prin TensorRT, precum și cu rețelele de codificator/decodor. TensorRT sporește performanța de inferență cu calibrarea de precizie, fuziunea straturilor și tensorilor, reglarea automată a nucleului, memoria dinamică a tensorilor, execuția multi-stream și fuziunea în timp.

Următoarea figură ilustrează designul la nivel înalt al modulelor cheie care alcătuiesc conducta de inferență a modelului BART corector de vrăji.

Căutare vectorială: interogare încorporarea propoziției de generare a modelului BERT

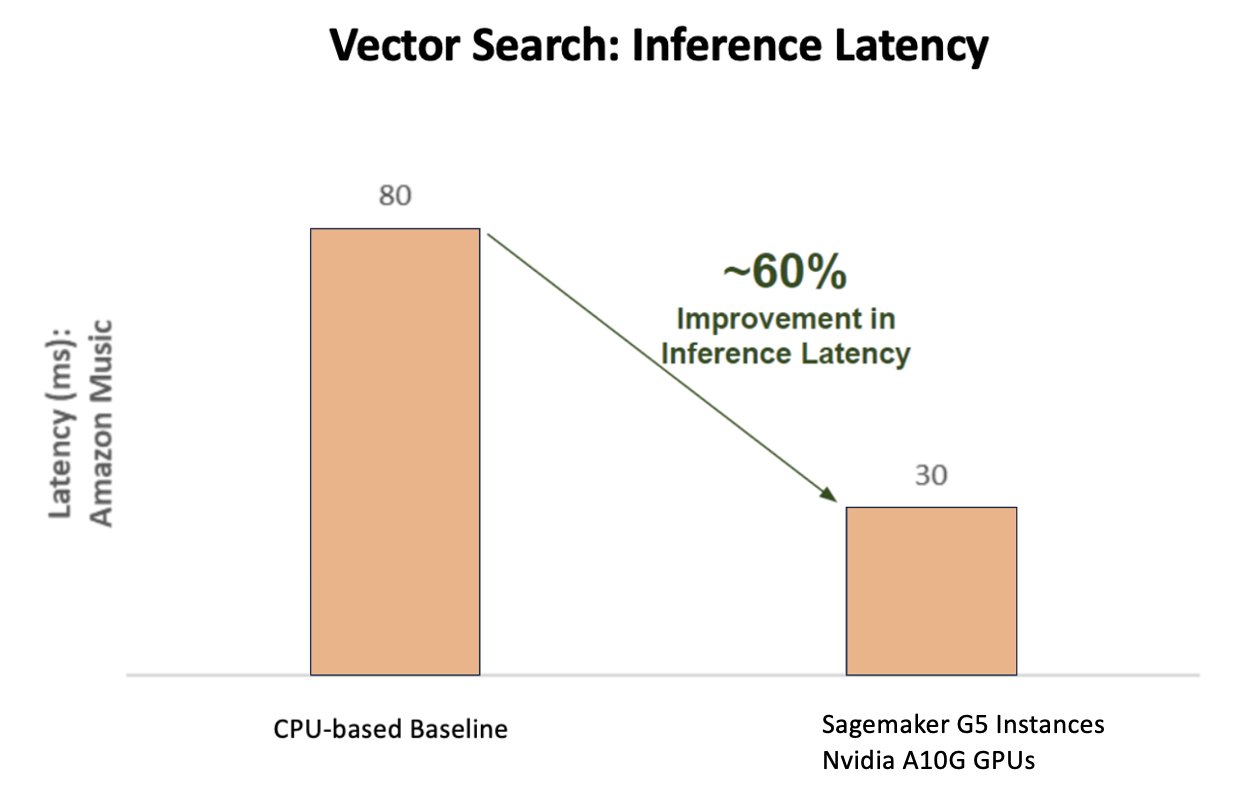

Următorul diagramă ilustrează îmbunătățirea cu 60% a latenței (care deservește p90 800–900 TPS) atunci când se utilizează platforma NVIDIA AI Inference Platform comparativ cu o linie de bază bazată pe CPU.

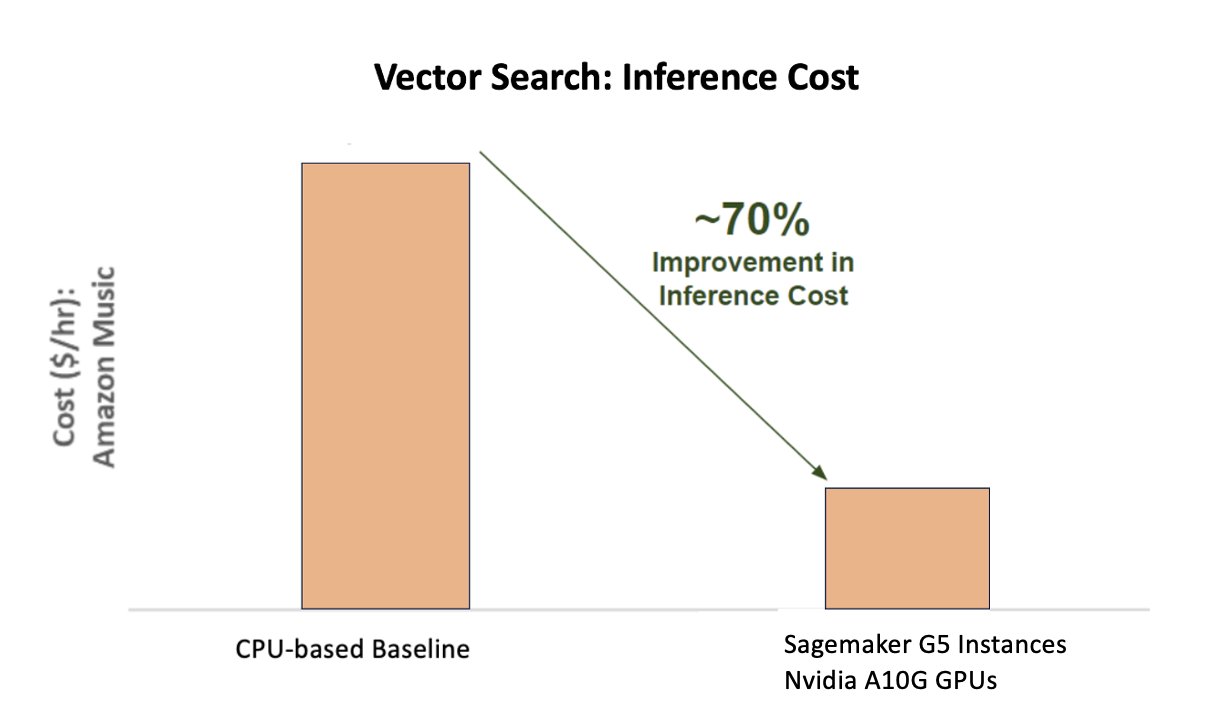

Următorul grafic arată o îmbunătățire cu 70% a costului atunci când se utilizează platforma de inferință AI NVIDIA, comparativ cu o linie de bază bazată pe CPU.

Următoarea figură ilustrează un SDK pentru inferența de învățare profundă de înaltă performanță. Include un optimizator de inferență de învățare profundă și un timp de rulare care oferă o latență scăzută și un randament ridicat pentru aplicațiile de inferență.

Pentru a obține aceste rezultate, Amazon Music a experimentat cu mai mulți parametri diferiți de implementare Triton folosind Analizor de modele Triton, un instrument care ajută la găsirea celei mai bune configurații de model NVIDIA Triton pentru a implementa o inferență eficientă. Pentru a optimiza inferența modelului, Triton oferă caracteristici precum loturi dinamice și execuție simultană a modelului și are suport pentru alte capacități de flexibilitate. Gruparea dinamică adună cereri de inferență, grupându-le perfect în cohorte pentru a maximiza debitul, toate asigurând răspunsuri în timp real pentru utilizatorii Amazon Music. Capacitatea de execuție simultană a modelului îmbunătățește și mai mult performanța de inferență găzduind mai multe copii ale modelului pe același GPU. În cele din urmă, prin utilizarea Analizor de modele Triton, Amazon Music a reușit să ajusteze cu atenție parametrii de găzduire a inferenței de concurență dinamice și a modelului pentru a găsi setări optime care maximizează performanța de inferență folosind traficul simulat.

Concluzie

Optimizarea configurațiilor cu Triton Inference Server și TensorRT pe SageMaker a permis Amazon Music să obțină rezultate remarcabile atât pentru instruire, cât și pentru conductele de inferență. Platforma SageMaker este platforma deschisă end-to-end pentru AI de producție, oferind timp rapid de valorificare și versatilitate pentru a susține toate cazurile de utilizare majore a AI atât în hardware, cât și în software. Prin optimizarea utilizării GPU-ului V100 pentru antrenament și trecerea de la procesoare la instanțele G5 utilizând GPU-uri NVIDIA A10G Tensor Core, precum și prin utilizarea software-ului NVIDIA optimizat, cum ar fi Triton Inference Server și TensorRT, companii precum Amazon Music pot economisi timp și bani, sporind în același timp performanța în ambele instruire și inferență, traducându-se direct într-o experiență mai bună pentru clienți și costuri de operare mai mici.

SageMaker se ocupă de sarcinile grele nediferențiate pentru instruirea și găzduirea ML, permițând Amazon Music să livreze operațiuni ML fiabile și scalabile atât în hardware, cât și în software.

Vă încurajăm să verificați dacă sarcinile dvs. de lucru sunt optimizate utilizând SageMaker, evaluând întotdeauna opțiunile de hardware și software pentru a vedea dacă există modalități prin care puteți obține performanțe mai bune cu costuri reduse.

Pentru a afla mai multe despre NVIDIA AI în AWS, consultați următoarele:

Despre autori

Siddharth Sharma este lider tehnic de învățare automată la echipa de știință și modelare la Amazon Music. El este specializat în probleme de modelare legate de căutare, regăsire, clasare și NLP. Siddharth are o experiență bogată în probleme de învățare automată la scară largă, care sunt sensibile la latență, de exemplu, direcționarea anunțurilor, regăsirea multimodală, înțelegerea interogărilor de căutare etc. Înainte de a lucra la Amazon Music, Siddharth lucra la companii precum Meta, Walmart Labs, Rakuten privind problemele ML centrate pe comerțul electronic. Siddharth și-a petrecut o parte de început a carierei lucrând cu startup-uri din zona golfului.

Siddharth Sharma este lider tehnic de învățare automată la echipa de știință și modelare la Amazon Music. El este specializat în probleme de modelare legate de căutare, regăsire, clasare și NLP. Siddharth are o experiență bogată în probleme de învățare automată la scară largă, care sunt sensibile la latență, de exemplu, direcționarea anunțurilor, regăsirea multimodală, înțelegerea interogărilor de căutare etc. Înainte de a lucra la Amazon Music, Siddharth lucra la companii precum Meta, Walmart Labs, Rakuten privind problemele ML centrate pe comerțul electronic. Siddharth și-a petrecut o parte de început a carierei lucrând cu startup-uri din zona golfului.

Tarun Sharma este un manager de dezvoltare software care conduce Relevanța pentru căutarea muzicală în Amazon. Echipa sa de oameni de știință și ingineri ML este responsabilă pentru furnizarea de rezultate de căutare relevante și personalizate din punct de vedere contextual clienților Amazon Music.

Tarun Sharma este un manager de dezvoltare software care conduce Relevanța pentru căutarea muzicală în Amazon. Echipa sa de oameni de știință și ingineri ML este responsabilă pentru furnizarea de rezultate de căutare relevante și personalizate din punct de vedere contextual clienților Amazon Music.

James Park este arhitect de soluții la Amazon Web Services. El lucrează cu Amazon.com pentru a proiecta, construi și implementa soluții tehnologice pe AWS și are un interes deosebit pentru AI și învățarea automată. În timpul liber, îi place să caute noi culturi, experiențe noi și să fie la curent cu cele mai recente tendințe tehnologice. Îl puteți găsi pe LinkedIn.

James Park este arhitect de soluții la Amazon Web Services. El lucrează cu Amazon.com pentru a proiecta, construi și implementa soluții tehnologice pe AWS și are un interes deosebit pentru AI și învățarea automată. În timpul liber, îi place să caute noi culturi, experiențe noi și să fie la curent cu cele mai recente tendințe tehnologice. Îl puteți găsi pe LinkedIn.

Kshitiz Gupta este arhitect de soluții la NVIDIA. Îi face plăcere să educe clienții din cloud despre tehnologiile GPU AI pe care le oferă NVIDIA și să-i ajute să-și accelereze învățarea automată și aplicațiile de deep learning. În afara serviciului, îi place să alerge, să facă drumeții și să urmărească fauna sălbatică.

Kshitiz Gupta este arhitect de soluții la NVIDIA. Îi face plăcere să educe clienții din cloud despre tehnologiile GPU AI pe care le oferă NVIDIA și să-i ajute să-și accelereze învățarea automată și aplicațiile de deep learning. În afara serviciului, îi place să alerge, să facă drumeții și să urmărească fauna sălbatică.

Jiahong Liu este arhitect de soluții în echipa de furnizori de servicii cloud de la NVIDIA. El ajută clienții să adopte soluții de învățare automată și inteligență artificială care folosesc calcularea accelerată NVIDIA pentru a-și aborda provocările de formare și inferență. În timpul liber, îi place origami, proiecte de bricolaj și joacă baschet.

Jiahong Liu este arhitect de soluții în echipa de furnizori de servicii cloud de la NVIDIA. El ajută clienții să adopte soluții de învățare automată și inteligență artificială care folosesc calcularea accelerată NVIDIA pentru a-și aborda provocările de formare și inferență. În timpul liber, îi place origami, proiecte de bricolaj și joacă baschet.

Tugrul Konuk este arhitect senior de soluții la NVIDIA, specializat în formare pe scară largă, învățare profundă multimodală și calcul științific de înaltă performanță. Înainte de NVIDIA, a lucrat în industria energetică, concentrându-se pe dezvoltarea de algoritmi pentru imagistica computațională. Ca parte a doctoratului său, a lucrat la deep learning bazat pe fizică pentru simulări numerice la scară. În timpul liber, îi place să citească, să cânte la chitară și la pian.

Tugrul Konuk este arhitect senior de soluții la NVIDIA, specializat în formare pe scară largă, învățare profundă multimodală și calcul științific de înaltă performanță. Înainte de NVIDIA, a lucrat în industria energetică, concentrându-se pe dezvoltarea de algoritmi pentru imagistica computațională. Ca parte a doctoratului său, a lucrat la deep learning bazat pe fizică pentru simulări numerice la scară. În timpul liber, îi place să citească, să cânte la chitară și la pian.

Rohil Bhargava este Product Marketing Manager la NVIDIA, concentrat pe implementarea cadrelor de aplicații NVIDIA și a SDK-urilor pe anumite platforme CSP.

Rohil Bhargava este Product Marketing Manager la NVIDIA, concentrat pe implementarea cadrelor de aplicații NVIDIA și a SDK-urilor pe anumite platforme CSP.

Eliuth Triana Isaza este manager de relații cu dezvoltatori la NVIDIA, împuternicește AI MLOps, DevOps, oamenii de știință și experții tehnici AWS de la Amazon să stăpânească stiva de calcul NVIDIA pentru accelerarea și optimizarea modelelor Generative AI Foundation, de la curatarea datelor, instruirea GPU, inferența modelului și implementarea producției pe instanțele GPU AWS . În plus, Eliuth este un pasionat de ciclism montan, schior, tenis și poker.

Eliuth Triana Isaza este manager de relații cu dezvoltatori la NVIDIA, împuternicește AI MLOps, DevOps, oamenii de știință și experții tehnici AWS de la Amazon să stăpânească stiva de calcul NVIDIA pentru accelerarea și optimizarea modelelor Generative AI Foundation, de la curatarea datelor, instruirea GPU, inferența modelului și implementarea producției pe instanțele GPU AWS . În plus, Eliuth este un pasionat de ciclism montan, schior, tenis și poker.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :are

- :este

- :nu

- :Unde

- $UP

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- Capabil

- Despre Noi

- accelerat

- accelerarea

- accelerare

- acces

- realiza

- precizie

- precis

- Obține

- realizat

- peste

- activ

- plus

- adresa

- Adoptarea

- Anunţuri

- care afectează

- După

- AI

- Modele AI

- ai cazuri de utilizare

- Album

- algoritmi

- TOATE

- permite

- permis

- Permiterea

- permite

- de asemenea

- mereu

- Amazon

- Amazon Web Services

- Amazon.com

- an

- și

- aplicație

- aplicatii

- abordare

- arhitecți

- SUNT

- ZONĂ

- domenii

- în jurul

- artist

- AS

- asistarea

- asistă

- At

- in medie

- AWS

- Backend

- Sold

- de echilibrare

- bar

- bazat

- De bază

- Baschet

- Golf

- BE

- a devenit

- deoarece

- Beneficiile

- CEL MAI BUN

- Mai bine

- stimularea

- rapeluri

- atât

- aduce

- larg

- construi

- construit

- by

- CAN

- capacități

- capacitate

- captura

- pasă

- Carieră

- cu grijă

- cazuri

- provocări

- provocare

- Diagramă

- verifica

- prețuite

- alegeri

- clientii

- Cloud

- cod

- COM

- cum

- comunicarea

- Companii

- comparație

- de calcul

- tehnica de calcul

- concurent

- Configuraţie

- Recipient

- conţinut

- Convergenţă

- Nucleu

- A costat

- Cheltuieli

- ambarcaţiunilor

- critic

- crucial

- CSP

- custozi

- personalizat

- client

- experienta clientului

- clienţii care

- de date

- Data

- Zi

- scăzut

- adânc

- învățare profundă

- întârzieri

- livra

- livrarea

- Oferă

- Cerere

- implementa

- Implementarea

- desfășurarea

- Amenajări

- Dezvoltator

- în curs de dezvoltare

- Dezvoltare

- diferit

- dificil

- direct

- scufunda

- diferit

- diy

- Dont

- drastic

- în timpul

- dinamic

- e

- e-commerce

- Devreme

- educarea

- eficiență

- eficient

- efort

- elevat

- Încorporarea

- emotii

- angajarea

- împuternicirea

- activat

- încuraja

- un capăt la altul

- energie

- inginerii

- Îmbunătăţeşte

- suficient de

- asigurare

- mai ales

- etc

- evaluarea

- Chiar

- Fiecare

- execuție

- experienţă

- Experiențe

- experți

- FAST

- DESCRIERE

- Figura

- În cele din urmă

- Găsi

- descoperire

- First

- Flexibilitate

- inundaţie

- Concentra

- concentrat

- concentrându-se

- următor

- Pentru

- format

- Fundație

- Cadru

- cadre

- din

- frustrant

- complet

- funcționalități

- mai mult

- fuziune

- poartă

- generaţie

- generativ

- AI generativă

- GPU

- unități de procesare grafică

- Mânere

- întâmpla

- Piese metalice

- Avea

- he

- greu

- ridicare de greutati

- ajutor

- util

- ajută

- Înalt

- la nivel înalt

- performanta ridicata

- -l

- lui

- deține

- găzduire

- ORE

- Cum

- Totuși

- HTML

- HTTPS

- identificarea

- if

- ilustrează

- Imaging

- punerea în aplicare a

- important

- îmbunătăţi

- îmbunătățit

- îmbunătățire

- in

- include

- Crește

- a crescut

- crescând

- industrie

- ineficace

- influență

- Infrastructură

- inițială

- instanță

- imediat

- in schimb

- interes

- în

- introduce

- introducerea

- IT

- ESTE

- călătorie

- jpg

- doar

- Cheie

- Copil

- Cunoaște

- cunoscut

- Labs

- limbă

- mare

- pe scară largă

- mai mare

- durată

- Latență

- Ultimele

- strat

- conduce

- conducere

- AFLAȚI

- învăţare

- Pârghie

- Bibliotecă

- ridicare

- ca

- Limitele

- încărca

- cautati

- Jos

- LOWER

- maşină

- masina de învățare

- menține

- major

- face

- FACE

- manager

- de conducere

- Marketing

- maestru

- Maximaliza

- Mai..

- Amintiri

- Memorie

- meta

- De mijloc

- milion

- milioane

- milisecunde

- minim

- greşeală

- mixt

- ML

- MLOps

- model

- modelare

- Modele

- Module

- bani

- mai mult

- cele mai multe

- Munte

- Multicolor

- multiplu

- Muzică

- trebuie sa

- nume

- necesar

- negativ

- rețele

- Nou

- nlp

- Nvidia

- of

- oferi

- promoții

- on

- ONE

- afară

- deschide

- open-source

- de operare

- operațional

- Operațiuni

- optimă

- optimizare

- Optimizați

- optimizate

- optimizarea

- or

- orchestrat

- comandă

- Altele

- afară

- exterior

- remarcabil

- peste

- global

- propriu

- parametrii

- parte

- special

- în special

- parteneriat

- pasionat

- Vârf

- procent

- performanță

- personal

- Personalizat

- PhD

- conducte

- platformă

- Platforme

- Plato

- Informații despre date Platon

- PlatoData

- player

- joc

- Podcast

- Podcast-uri

- Punct

- poker

- posibil

- Post

- potenţial

- putere

- alimentat

- Precizie

- anterior

- Prioritizarea

- prioritate

- probleme

- proces

- Produs

- producere

- Proiecte

- furniza

- furnizorul

- furnizează

- furnizarea

- Piton

- Rapid

- Clasat

- Citind

- în timp real

- reducerea

- trimite

- legate de

- relaţii

- relevanţa

- de încredere

- cereri de

- Necesită

- Resurse

- răspunsuri

- responsabilitate

- responsabil

- sensibil

- rezultând

- REZULTATE

- Bogat

- dreapta

- funcţionare

- ruleaza

- Runtime

- sagemaker

- acelaşi

- Economisiți

- economisire

- scalabil

- Scară

- Ştiinţă

- ştiinţific

- oamenii de stiinta

- sdk

- sdks

- perfect

- Caută

- Cautari

- căutare

- Al doilea

- secțiuni

- vedea

- caută

- aparent

- semantică

- senior

- sensibil

- propoziție

- servi

- serverul

- serviciu

- Furnizor de servicii

- Servicii

- servire

- set

- setări

- câteva

- Distribuie

- comun

- Emisiuni

- semnificativ

- semnificativ

- simplu

- sta

- Mărimea

- dimensiuni

- inteligent

- Software

- de dezvoltare de software

- soluţie

- soluţii

- cântec

- Sursă

- tensiune

- specializată

- specializata

- specific

- viteză

- VRAJA

- ortografie

- uzat

- stivui

- Pornire

- Startup-urile

- ședere

- constant

- Pas

- paşi

- Poveste

- de streaming

- astfel de

- superior

- a sustine

- Suportat

- sigur

- luate

- luare

- direcționare

- echipă

- tech

- Tehnic

- tehnică

- tehnici de

- Tehnologii

- Tehnologia

- a) Sport and Nutrition Awareness Day in Manasia Around XNUMX people from the rural commune Manasia have participated in a sports and healthy nutrition oriented activity in one of the community’s sports ready yards. This activity was meant to gather, mainly, middle-aged people from a Romanian rural community and teach them about the benefits that sports have on both their mental and physical health and on how sporting activities can be used to bring people from a community closer together. Three trainers were made available for this event, so that the participants would get the best possible experience physically and so that they could have the best access possible to correct information and good sports/nutrition practices. b) Sports Awareness Day in Poiana Țapului A group of young participants have taken part in sporting activities meant to teach them about sporting conduct, fairplay, and safe physical activities. The day culminated with a football match.

- acea

- lor

- Lor

- Acolo.

- prin urmare

- Acestea

- ei

- lucruri

- acest

- Prin

- debit

- timp

- ori

- Titlu

- la

- împreună

- tokenizarea

- indicativele

- a luat

- instrument

- top

- tps

- trafic

- Tren

- dresat

- Pregătire

- transformator

- Tendinţe

- Triton

- adevărat

- Două

- înţelegere

- fara indoiala

- Univers

- deblocare

- dezvaluit

- us

- utilizare

- utilizat

- utilizatorii

- utilizări

- folosind

- Utilizand

- valoare

- Fixă

- versatilitate

- foarte

- Aşteptare

- umbla

- Walmart

- a fost

- vizionarea

- modalități de

- we

- web

- servicii web

- BINE

- au fost

- cand

- întrucât

- în timp ce

- voi

- cu

- Apartamente

- a lucrat

- de lucru

- fabrică

- lume

- face griji

- încă

- a cedat

- Tu

- Ta

- zephyrnet