Cercetătorii au descoperit peste 100 de modele de învățare automată (ML) rău intenționate pe platforma Hugging Face AI, care le pot permite atacatorilor să injecteze cod rău intenționat în mașinile utilizatorilor.

Deși Hugging Face implementează măsuri de securitate, descoperirile evidențiază riscul tot mai mare de „armare” a modelelor disponibile public, deoarece acestea pot crea o ușă în spate pentru atacatori.

Descoperirile JFrog Security Research fac parte dintr-un studiu aflat în curs de desfășurare pentru a analiza modul în care hackerii pot folosi ML pentru a ataca utilizatorii.

Conținut nociv

Potrivit unui articol de Calculator, cercetătorii au dezvoltat un sistem avansat de scanare pentru a examina modelele găzduite pe platforma Hugging Face AI, cum ar fi PyTorch și Tensorflow Keras.

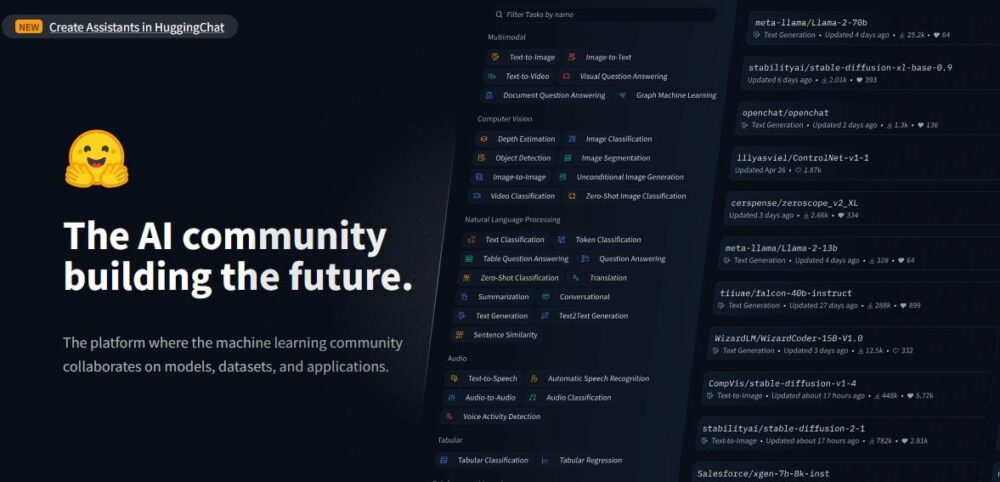

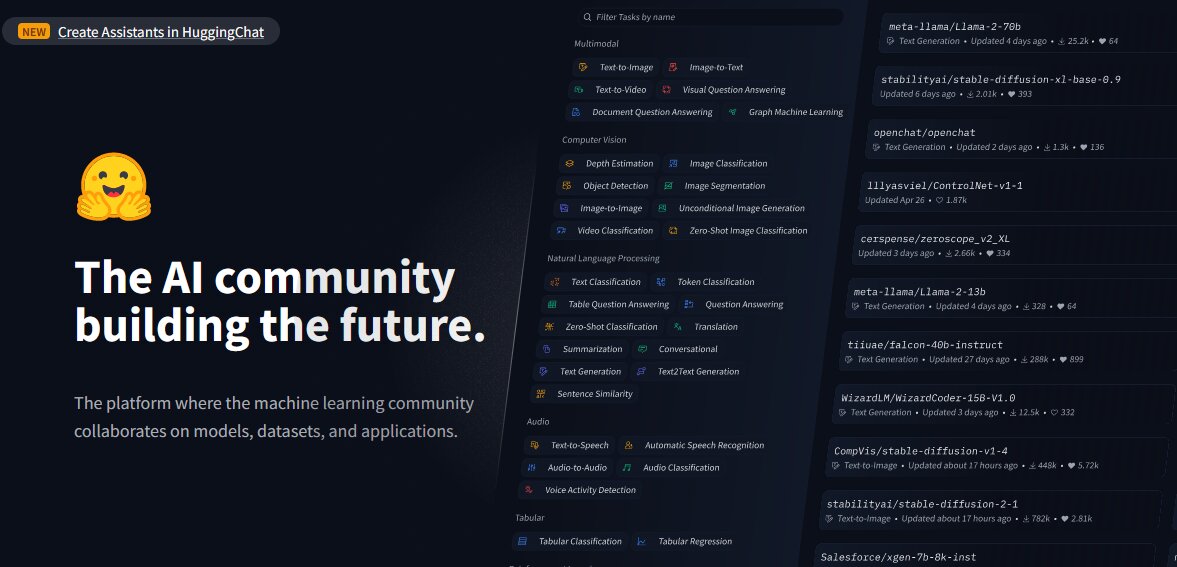

Hugging Face este o platformă dezvoltată pentru partajarea modelelor, seturilor de date și aplicațiilor AI. După ce au analizat modelele, cercetătorii au descoperit încărcături utile dăunătoare „în cadrul unor modele aparent inofensive”.

Acest lucru se întâmplă în ciuda faptului că Hugging Face efectuează măsuri de securitate precum programele malware și scanarea murată. Cu toate acestea, platforma nu restricționează descărcarea modelelor care ar putea fi potențial dăunătoare și, de asemenea, permite accesul public Modele AI pentru a fi abuzat și armat de utilizatori.

Examinând platforma și modelele existente, cercetătorii de securitate de la JFrog au descoperit aproximativ 100 de modele AI cu funcționalități rău intenționate, conform lor. raportează.

Unele dintre aceste modele, indică raportul, sunt capabile să execute cod pe mașinile utilizatorilor, „creând astfel o ușă în spate persistentă pentru atacatori”.

Cercetătorii au indicat, de asemenea, că astfel de constatări exclud fals pozitive. Acestea, au spus ei, sunt o reprezentare exactă a prevalenței modelelor rău intenționate pe platformă.

De asemenea, se va citi: Apple redirecționează echipa mașină către încetinirea pieței AI post-EV

Exemplele

Potrivit raportului lui JFrog, unul dintre cazurile „alarmante” implică a PyTorch model. Modelul a fost încărcat de un utilizator identificat ca „baller423”, care a fost ulterior șters de pe platforma Hugging Face.

Analizând în continuare modelul, cercetătorii au observat că acesta conținea o sarcină utilă rău intenționată, permițându-i să stabilească un shell invers pe o gazdă specificată (210.117.212.93).

Cercetătorul senior în securitate JFrog, David Cohen, a spus: „(Este în mod semnificativ mai intruziv și potențial rău intenționat, deoarece stabilește o conexiune directă la un server extern, indicând o potențială amenințare la securitate, mai degrabă decât o simplă demonstrație a vulnerabilității”, a scris el.

Acest lucru folosește metoda „_reduce_” a modulului pickle Python pentru a executa cod arbitrar la încărcarea fișierului model, ocolind efectiv metodele convenționale de detectare.”

Cercetătorii au recunoscut, de asemenea, că aceeași sarcină utilă a creat conexiuni la adrese IP diferite, „sugerând că operatorii ar putea fi mai degrabă cercetători decât hackeri rău intenționați”.

Un apel de trezire

Echipa JFrog a remarcat că descoperirile sunt un semnal de alarmă pentru Hugging Face, arătând că platforma sa este predispusă la manipulare și potențiale amenințări.

„Aceste incidente servesc ca mementouri emoționante ale amenințărilor continue cu care se confruntă depozitele Hugging Face și alte depozite populare, cum ar fi Kaggle, care ar putea compromite confidențialitatea și securitatea organizațiilor care utilizează aceste resurse, în plus față de provocări pentru inginerii AI/ML”, a spus cercetatorii.

Aceasta vine ca. securitatea cibernetică amenință în întreaga lume sunt în creștere, alimentate de proliferarea instrumentelor AI, actorii răi abuzând de ele pentru intenții rău intenționate. Hackerii folosesc, de asemenea, inteligența artificială pentru a avansa atacurile de phishing și pentru a păcăli oamenii.

Cu toate acestea, echipa JFrog a făcut alte descoperiri.

Un loc de joacă pentru cercetători

Cercetătorii au remarcat, de asemenea, că Fata îmbrățișată a evoluat într-un loc de joacă pentru cercetătorii „care doresc să combată amenințările emergente, așa cum demonstrează gama variată de tactici de a ocoli măsurile sale de securitate”.

De exemplu, încărcarea utilă încărcată de „baller423” a inițiat o conexiune reverse shell la un interval de adrese IP care aparține Kreonet (Rețeaua deschisă a mediului de cercetare din Coreea).

În conformitate cu Citire întunecată, Kreonet este o rețea de mare viteză din Coreea de Sud care sprijină activități de cercetare avansată și educaționale; „Prin urmare, este posibil ca cercetătorii sau practicienii AI să fi fost în spatele modelului.”

„Putem vedea că cele mai multe încărcături utile „răuțioase” sunt de fapt încercări ale cercetătorilor și/sau recompense pentru erori de a obține executarea codului în scopuri aparent legitime”, a spus Cohen.

În ciuda scopurilor legitime, echipa JFrog a avertizat însă că strategiile folosite de cercetători demonstrează clar că platforme precum Hugging Face sunt deschise atacurilor din lanțul de aprovizionare. Acestea, potrivit echipei, pot fi personalizate pentru a se concentra pe anumite demografii, cum ar fi inginerii AI sau ML.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://metanews.com/over-100-malicious-code-execution-models-on-hugging-face-backdoors-users-devices/

- :are

- :este

- :nu

- 100

- 210

- 212

- 7

- 9

- a

- Despre Noi

- Conform

- precis

- activităţi de

- actori

- de fapt

- plus

- adresa

- adrese

- avansa

- avansat

- AI

- Modele AI

- Platforma AI

- AI / ML

- de asemenea

- an

- analiza

- analiza

- și

- aplicatii

- arbitrar

- SUNT

- Mulțime

- articol

- AS

- ataca

- Atacuri

- Încercările

- disponibil

- ușă din dos

- Rău

- BE

- fost

- în spatele

- aparține

- premiu

- Bug

- Bounty de bug

- by

- by-pass

- apel

- CAN

- capabil

- mașină

- cazuri

- provocări

- clar

- CO

- cod

- Cohen

- combaterea

- vine

- compromis

- tehnica de calcul

- conexiune

- Conexiuni

- conținute

- convențional

- ar putea

- crea

- Crearea

- personalizate

- seturi de date

- David

- Criterii demografice

- demonstra

- demonstrat

- În ciuda

- Detectare

- dezvoltat

- diferit

- direcționa

- a descoperit

- diferit

- face

- Descarca

- de învăţământ

- în mod eficient

- șmirghel

- angajat

- permite

- permite

- permițând

- inginerii

- Mediu inconjurator

- stabili

- stabilește

- evoluat

- examinator

- a executa

- executând

- execuție

- existent

- extern

- Față

- cu care se confruntă

- fapt

- fals

- Fișier

- constatările

- Concentra

- Pentru

- formă

- din

- alimentat

- funcționalitate

- mai mult

- obține

- În creştere

- hackeri

- nociv

- Avea

- he

- Înalt

- Evidențiați

- gazdă

- găzduit

- Cum

- Totuși

- HTTPS

- identificat

- ustensile

- in

- Crește

- indicată

- indică

- indicând

- iniţiat

- injecta

- instanță

- intenţiile

- în

- intruziv

- implică

- IP

- Adresa IP

- Adresele IP

- IT

- ESTE

- jpg

- keras

- Coreea

- învăţare

- legitim

- pîrghii

- ca

- încărcare

- maşină

- masina de învățare

- Masini

- făcut

- rău

- malware

- Manipulare

- Piață

- max-width

- Mai..

- măsuri

- Mers

- metodă

- Metode

- ML

- model

- Modele

- mai mult

- cele mai multe

- reţea

- în special

- notat

- of

- on

- ONE

- în curs de desfășurare

- pe

- deschide

- rețea deschisă

- Operatorii

- or

- organizații

- Altele

- afară

- peste

- parte

- oameni

- Phishing

- atacuri de phishing

- platformă

- Platforme

- Plato

- Informații despre date Platon

- PlatoData

- loc de joaca

- Popular

- posibil

- potenţial

- potenţial

- răspândire

- intimitate

- Confidențialitate și securitate

- public

- scopuri

- pirtorh

- gamă

- mai degraba

- Citeste

- recunoscut

- raportează

- relatărilor

- reprezentare

- cercetare

- cercetător

- cercetători

- Resurse

- restrânge

- inversa

- Risc

- Said

- acelaşi

- scanare

- securitate

- Măsuri de securitate

- vedea

- aparent

- senior

- servi

- serverul

- partajarea

- Coajă

- arătând

- Sud

- Coreea de Sud

- specific

- specificată

- strategii

- Studiu

- Ulterior

- astfel de

- De sprijin

- sistem

- tactică

- echipă

- tensorflow

- decât

- acea

- lor

- Lor

- Acestea

- ei

- amenințare

- amenințări

- la

- Unelte

- truc

- încărcat

- pe

- utilizare

- Utilizator

- utilizatorii

- folosind

- Utilizand

- vulnerabilitate

- a avertizat

- a fost

- care

- dori

- cu

- lume

- scris

- zephyrnet