Amazon SageMaker Data Wrangler vă ajută să înțelegeți, să agregați, să transformați și să pregătiți datele pentru învățarea automată (ML) dintr-o singură interfață vizuală. Conține peste 300 de transformări de date încorporate, astfel încât să puteți normaliza, transforma și combina rapid funcții fără a fi nevoie să scrieți niciun cod.

Practicienii în știința datelor generează, observă și procesează date pentru a rezolva problemele de afaceri acolo unde trebuie să transforme și să extragă caracteristici din seturile de date. Transformările, cum ar fi codificarea ordinală sau codificarea one-hot, învață codificări din setul dvs. de date. Aceste ieșiri codificate sunt denumite parametri antrenați. Pe măsură ce seturile de date se modifică de-a lungul timpului, poate fi necesar să reajustați codificări pe date nevăzute anterior pentru a menține fluxul de transformare relevant pentru datele dvs.

Suntem încântați să anunțăm funcția de reinstalare a parametrilor antrenați, care vă permite să utilizați parametrii antrenați anterior și să-i remontați după cum doriți. În această postare, demonstrăm cum să folosiți această funcție.

Prezentare generală a funcției de reinstalare a Data Wrangler

Ilustram modul în care funcționează această caracteristică cu următorul exemplu, înainte de a ne aprofunda în specificul caracteristicii parametrului antrenat de refit.

Să presupunem că setul de date despre clienți are o caracteristică categorică pentru country reprezentate ca şiruri ca Australia și Singapore. Algoritmii ML necesită intrări numerice; prin urmare, aceste valori categoriale trebuie să fie codificate în valori numerice. Codificarea datelor categorice este procesul de creare a unei reprezentări numerice pentru categorii. De exemplu, dacă țara din categoria dvs. are valori Australia și Singapore, puteți codifica aceste informații în doi vectori: [1, 0] pentru a reprezenta Australia și [0, 1] pentru a reprezenta Singapore. Transformarea folosită aici este o codificare one-hot, iar noua ieșire codificată reflectă parametrii antrenați.

După antrenamentul modelului, cu timpul clienții dvs. pot crește și aveți valori mai distincte în lista de țări. Noul set de date ar putea conține o altă categorie, India, care nu făcea parte din setul de date original, ceea ce poate afecta acuratețea modelului. Prin urmare, este necesar să vă reantrenați modelul cu noile date care au fost colectate de-a lungul timpului.

Pentru a depăși această problemă, trebuie să reîmprospătați codificarea pentru a include noua categorie și să actualizați reprezentarea vectorială conform celui mai recent set de date. În exemplul nostru, codificarea ar trebui să reflecte noua categorie pentru country, Care este India. Ne referim în mod obișnuit la acest proces de reîmprospătare a unei codări ca la o operație de reajustare. După ce efectuați operația de reinstalare, obțineți noua codificare: Australia: [1, 0, 0], Singapore: [0, 1, 0] și India: [0, 0, 1]. Reajustarea codificării one-hot și apoi reantrenarea modelului pe noul set de date are ca rezultat predicții de mai bună calitate.

Caracteristica parametrului antrenat de reajustare a lui Data Wrangler este utilă în următoarele cazuri:

- Date noi sunt adăugate la setul de date – Reantrenarea modelului ML este necesară atunci când setul de date este îmbogățit cu date noi. Pentru a obține rezultate optime, trebuie să reajustăm parametrii antrenați pe noul set de date.

- Antrenament pe un set de date complet după efectuarea ingineriei caracteristicilor pe date eșantion – Pentru un set de date mare, se ia în considerare un eșantion al setului de date pentru a învăța parametrii instruiți, care este posibil să nu reprezinte întregul set de date. Trebuie să reînvățăm parametrii antrenați pe setul de date complet.

Următoarele sunt unele dintre cele mai comune transformări Data Wrangler efectuate pe setul de date care beneficiază de opțiunea de parametru antrenat de refit:

Pentru mai multe informații despre transformări în Data Wrangler, consultați Transformarea datelor.

În această postare, arătăm cum să procesăm acești parametri antrenați pe seturi de date folosind Data Wrangler. Puteți utiliza fluxurile Data Wrangler în joburile de producție pentru a vă reprocesa datele pe măsură ce acestea cresc și se modifică.

Prezentare generală a soluțiilor

Pentru această postare, demonstrăm cum să folosiți funcția de parametri antrenați de refit a Data Wrangler cu setul de date disponibil public pe Kaggle: Date despre locuințe din SUA de la Zillow, Proprietăți de vânzare în Statele Unite. Are prețurile de vânzare a caselor în diverse geo-distribuții de case.

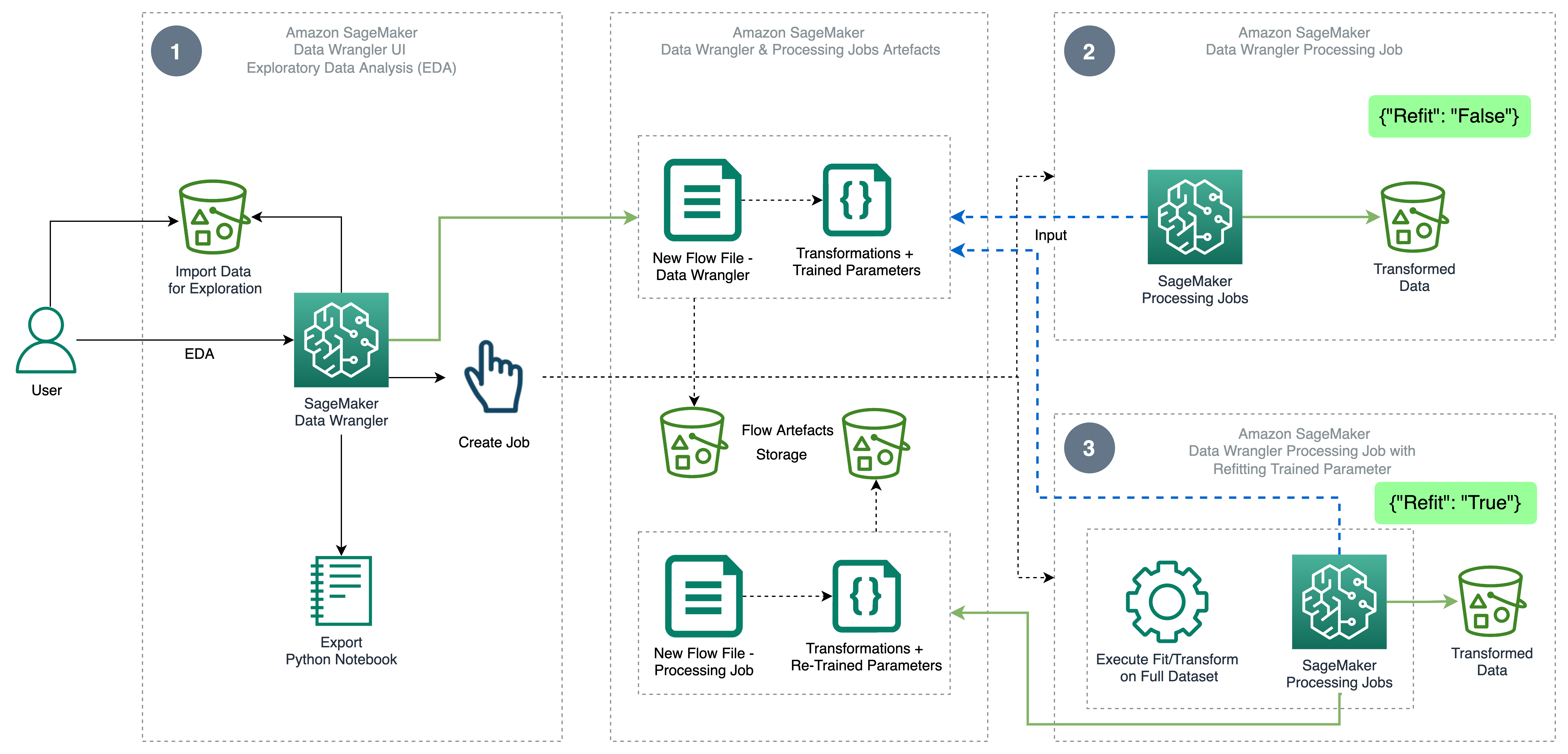

Următoarea diagramă ilustrează arhitectura de nivel înalt a Data Wrangler folosind caracteristica parametrilor antrenați de refit. De asemenea, arătăm efectul asupra calității datelor fără parametrul antrenat de refit și contrastăm rezultatele la sfârșit.

Fluxul de lucru include următorii pași:

- Efectuați o analiză exploratorie a datelor – Creați un nou flux pe Data Wrangler pentru a începe analiza exploratorie a datelor (EDA). Importați date de afaceri pentru a înțelege, curăța, agrega, transforma și pregăti datele pentru instruire. A se referi la Explorați capabilitățile Amazon SageMaker Data Wrangler cu mostre de seturi de date pentru mai multe detalii despre efectuarea EDA cu Data Wrangler.

- Creați un job de procesare a datelor – Acest pas exportă toate transformările pe care le-ați făcut pe setul de date ca fișier flux stocat în configurat Serviciul Amazon de stocare simplă (Amazon S3) locație. Lucrarea de procesare a datelor cu fișierul flux generat de Data Wrangler aplică transformările și parametrii antrenați învățați pe setul dvs. de date. Când lucrarea de procesare a datelor este finalizată, fișierele de ieșire sunt încărcate în locația Amazon S3 configurată în nodul de destinație. Rețineți că opțiunea de reinstalare este dezactivată în mod implicit. Ca alternativă la executarea instantanee a sarcinii de procesare, puteți, de asemenea programați o lucrare de procesare în câteva clicuri folosind Data Wrangler – Create Job pentru a rula la anumite momente.

- Creați o lucrare de procesare a datelor cu caracteristica parametrului antrenat de refit – Selectați noua caracteristică a parametrilor antrenați de reajustare în timp ce creați jobul pentru a impune reînvățarea parametrilor antrenați pe setul de date complet sau consolidat. Conform configurației locației Amazon S3 pentru stocarea fișierului de flux, jobul de procesare a datelor creează sau actualizează noul fișier de flux. Dacă configurați aceeași locație Amazon S3 ca la Pasul 2, sarcina de procesare a datelor actualizează fișierul flux generat la Pasul 2, care poate fi folosit pentru a menține fluxul relevant pentru datele dvs. La finalizarea lucrării de procesare, fișierele de ieșire sunt încărcate în compartimentul S3 configurat pentru nodul de destinație. Puteți utiliza fluxul actualizat pe întregul set de date pentru un flux de lucru de producție.

Cerințe preliminare

Înainte de a începe, încărcați setul de date într-un bucket S3, apoi importați-l în Data Wrangler. Pentru instrucțiuni, consultați Importați date de pe Amazon S3.

Să parcurgem acum pașii menționați în diagrama arhitecturii.

Efectuați EDA în Data Wrangler

Pentru a încerca caracteristica parametrilor instruiți pentru reajustare, configurați următoarea analiză și transformare în Data Wrangler. La sfârșitul configurării EDA, Data Wrangler creează un fișier de flux capturat cu parametri antrenați din setul de date.

- Creați un nou flux în Amazon SageMaker Data Wrangler pentru analiza exploratorie a datelor.

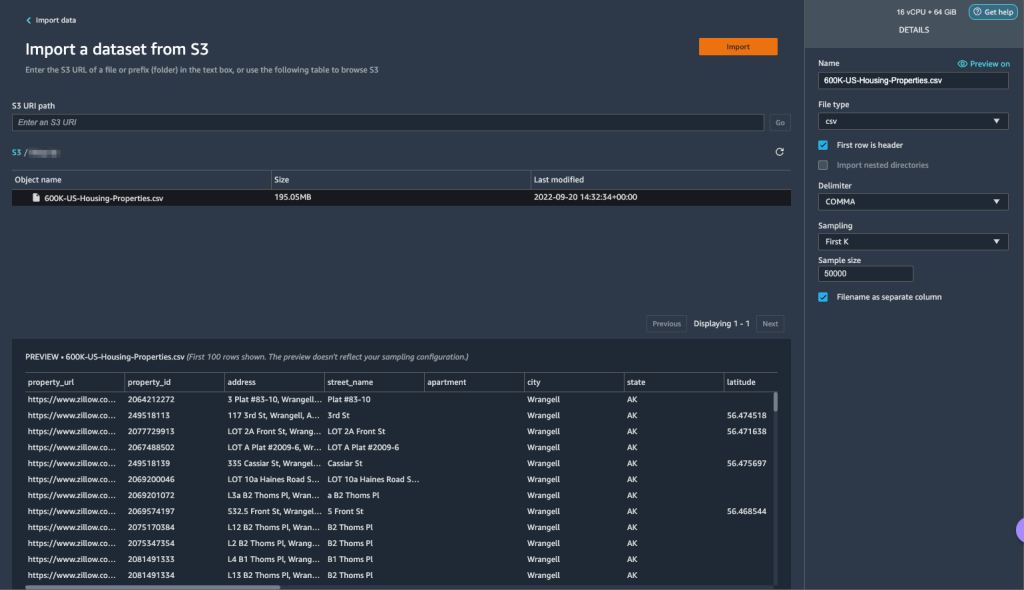

- Importați datele comerciale pe care le-ați încărcat pe Amazon S3.

- Puteți previzualiza datele și opțiunile pentru alegerea tipului de fișier, a delimitatorului, a eșantionării și așa mai departe. Pentru acest exemplu, folosim În primul rând K opțiunea de eșantionare oferită de Data Wrangler pentru a importa primele 50,000 de înregistrări din setul de date.

- Alege Import.

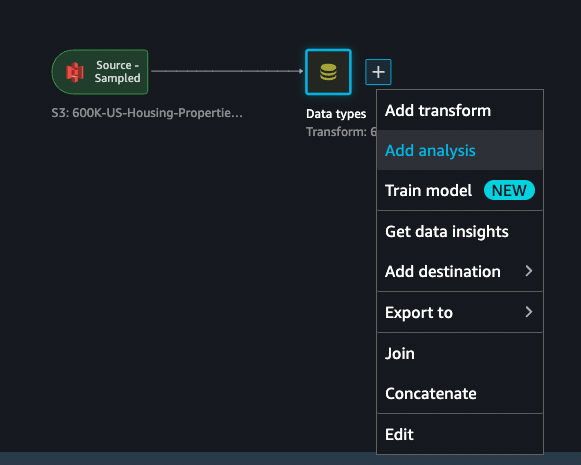

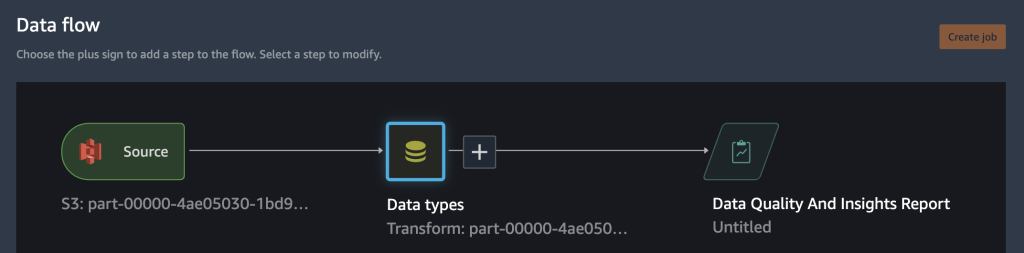

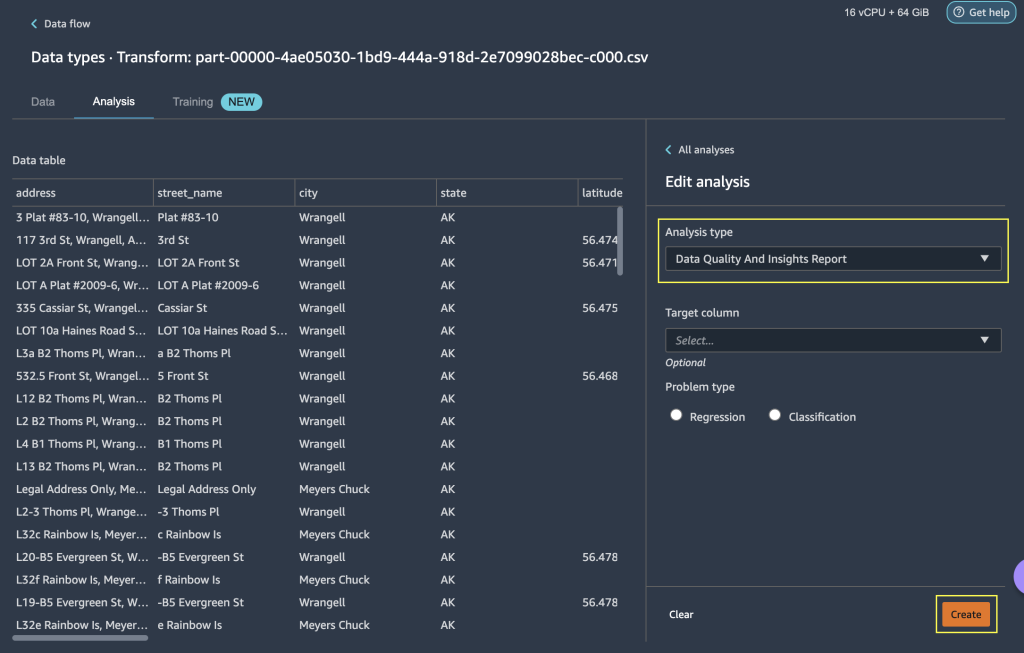

- După ce verificați potrivirea tipului de date aplicată de Data Wrangler, adăugați o nouă analiză.

- Pentru Tipul analizei, alege Raport privind calitatea datelor și perspective.

- Alege Crea.

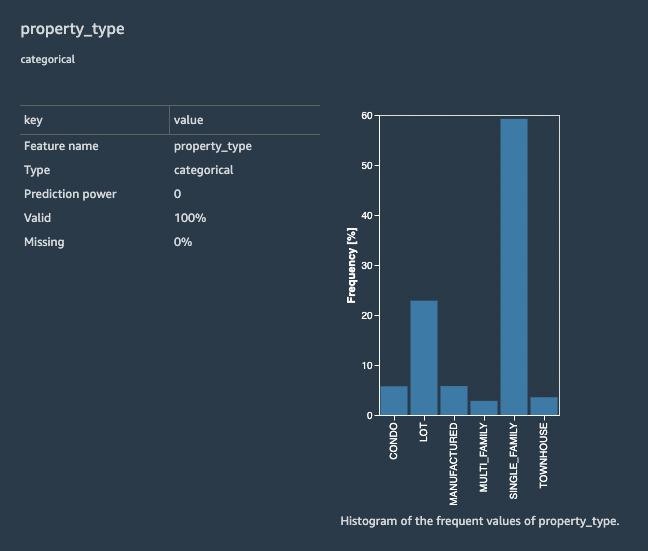

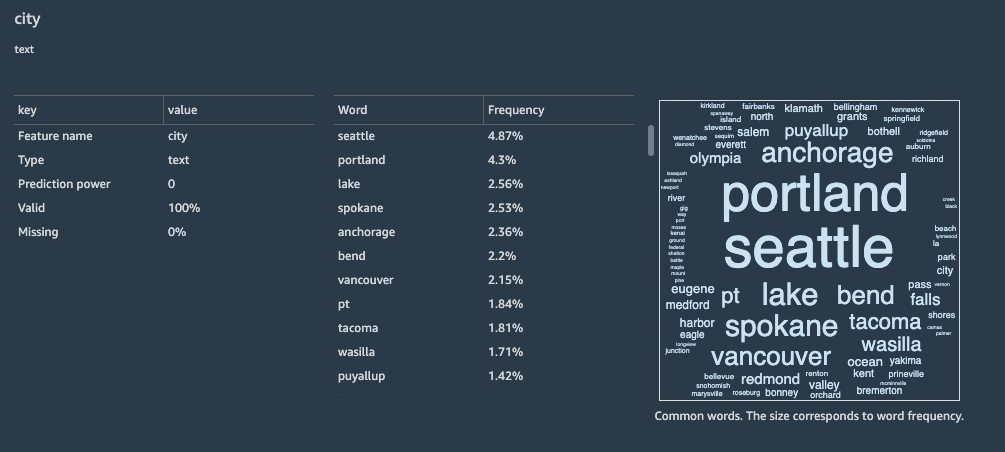

Cu Raportul privind calitatea datelor și statistici, obțineți un scurt rezumat al setului de date cu informații generale, cum ar fi valori lipsă, valori nevalide, tipuri de caracteristici, valori aberante și multe altele. Puteți alege caracteristici property_type și city pentru aplicarea transformărilor pe setul de date pentru a înțelege caracteristica parametrului antrenat de refit.

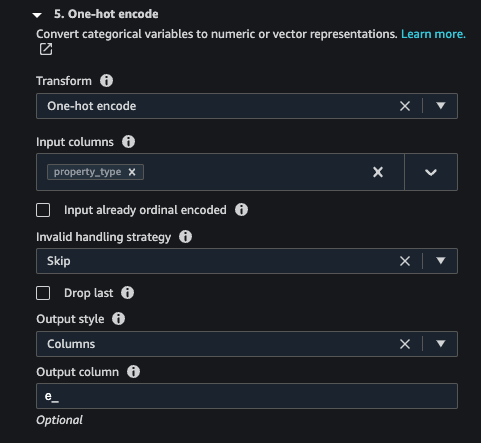

Să ne concentrăm pe caracteristică property_type din setul de date. În raportul Detalii despre caracteristică secțiunea, puteți vedea property_type, care este o caracteristică categorică și șase valori unice derivate din setul de date eșantionat de 50,000 de Data Wrangler. Setul de date complet poate avea mai multe categorii pentru caracteristică property_type. Pentru o caracteristică cu multe valori unice, este posibil să preferați codificarea ordinală. Dacă caracteristica are câteva valori unice, poate fi utilizată o abordare de codificare one-hot. Pentru acest exemplu, optăm pentru codificare one-hot activată property_type.

În mod similar, pentru city caracteristică, care este un tip de date text cu un număr mare de valori unice, să aplicăm codificarea ordinală acestei caracteristici.

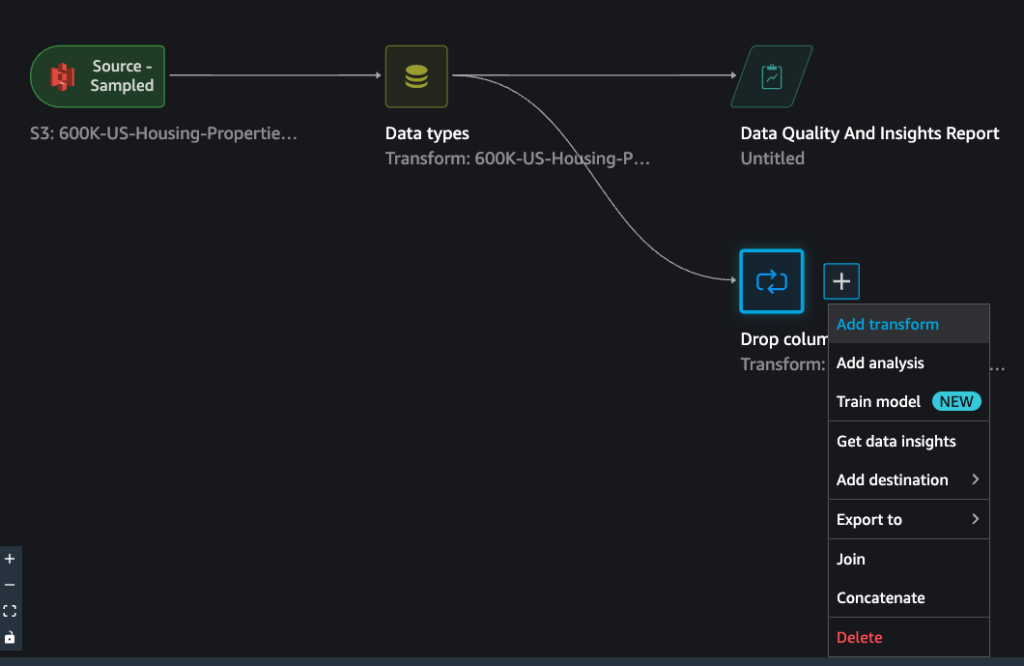

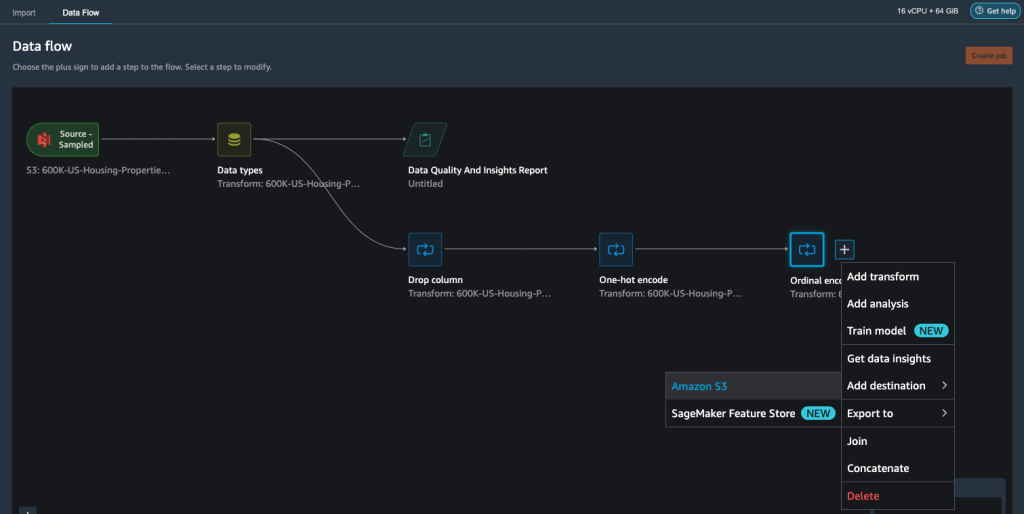

- Navigați la fluxul Data Wrangler, alegeți semnul plus și alegeți Adăugați transformare.

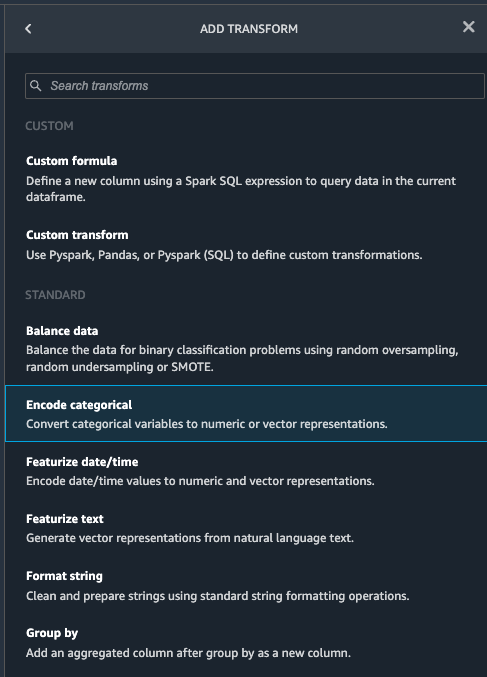

- Alege Codificați categoric opțiune pentru transformarea caracteristicilor categoriale.

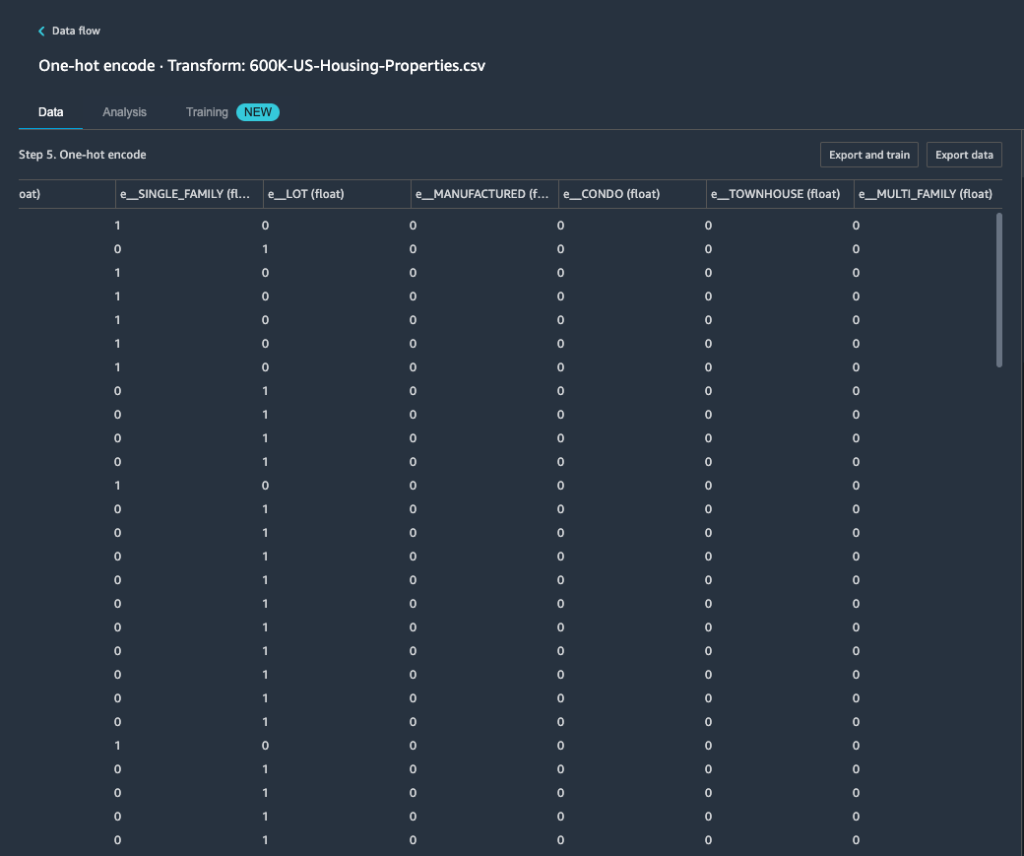

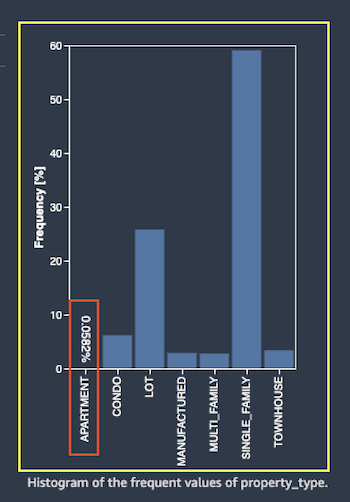

Din raportul privind calitatea datelor și statistici, funcția property_type prezintă șase categorii unice: CONDO, LOT, MANUFACTURED, SINGLE_FAMILY, MULTI_FAMILY, și TOWNHOUSE.

- Pentru Transforma, alege One-hot codificare.

După aplicarea codării one-hot pe caracteristică property_type, puteți previzualiza toate cele șase categorii ca caracteristici separate adăugate ca coloane noi. Rețineți că 50,000 de înregistrări au fost eșantionate din setul dvs. de date pentru a genera această previzualizare. În timp ce rulați o lucrare de procesare Data Wrangler cu acest flux, aceste transformări sunt aplicate întregului set de date.

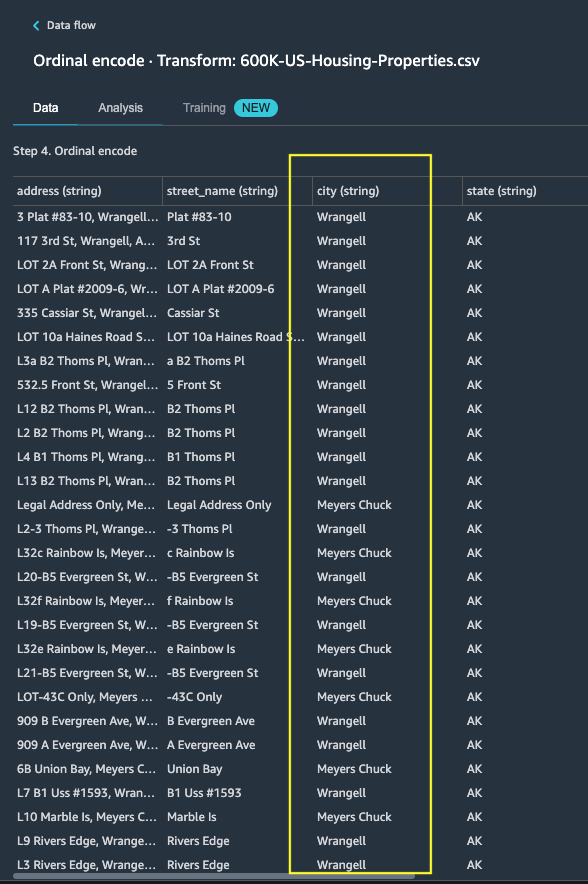

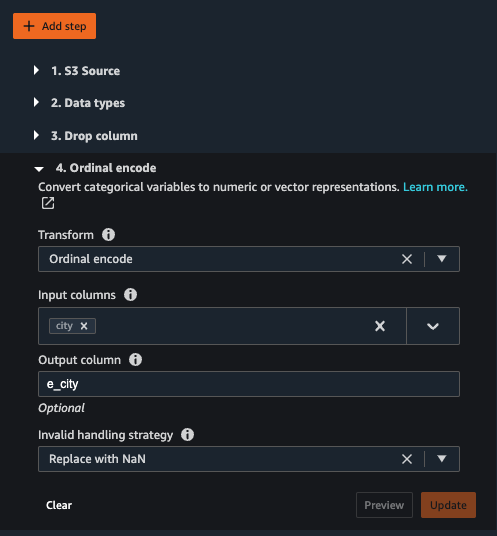

- Adăugați o nouă transformare și alegeți Codificați categoric pentru a aplica o transformare asupra caracteristicii

city, care are un număr mai mare de valori unice de text categoric. - Pentru a codifica această caracteristică într-o reprezentare numerică, alegeți Codul ordinal pentru Transforma.

- Alegeți Previzualizare pe această transformare.

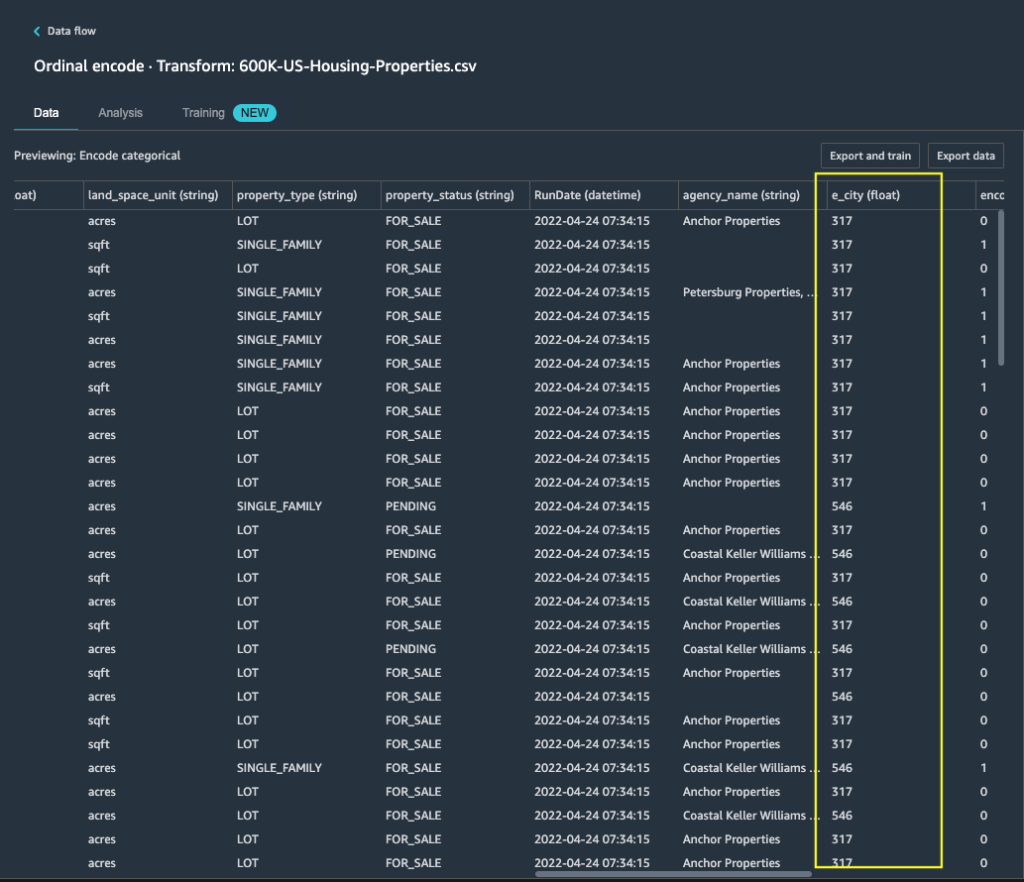

Puteți vedea că caracteristica categorială city este mapat la valorile ordinale din coloana de ieșire e_city.

- Adăugați acest pas alegând Actualizează.

- Puteți seta destinația la Amazon S3 pentru a stoca transformările aplicate pe setul de date pentru a genera rezultatul ca fișier CSV.

Data Wrangler stochează fluxul de lucru pe care l-ați definit în interfața cu utilizatorul ca fișier flux și îl încarcă în locația Amazon S3 a jobului de procesare a datelor configurat. Acest fișier de flux este utilizat atunci când creați joburi de procesare Data Wrangler pentru a aplica transformările pe seturi de date mai mari sau pentru a transforma date noi de armare pentru a reinstrui modelul.

Lansați o lucrare de procesare a datelor Data Wrangler fără reinstalare activată

Acum puteți vedea cum opțiunea de reajustare folosește parametri antrenați pe noile seturi de date. Pentru această demonstrație, definim două joburi de procesare Data Wrangler care operează pe aceleași date. Prima lucrare de procesare nu va permite reinstalarea; pentru a doua lucrare de prelucrare, folosim refit. Comparam efectele la final.

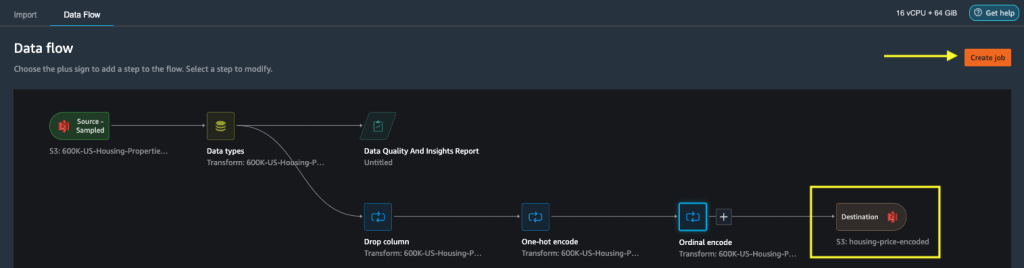

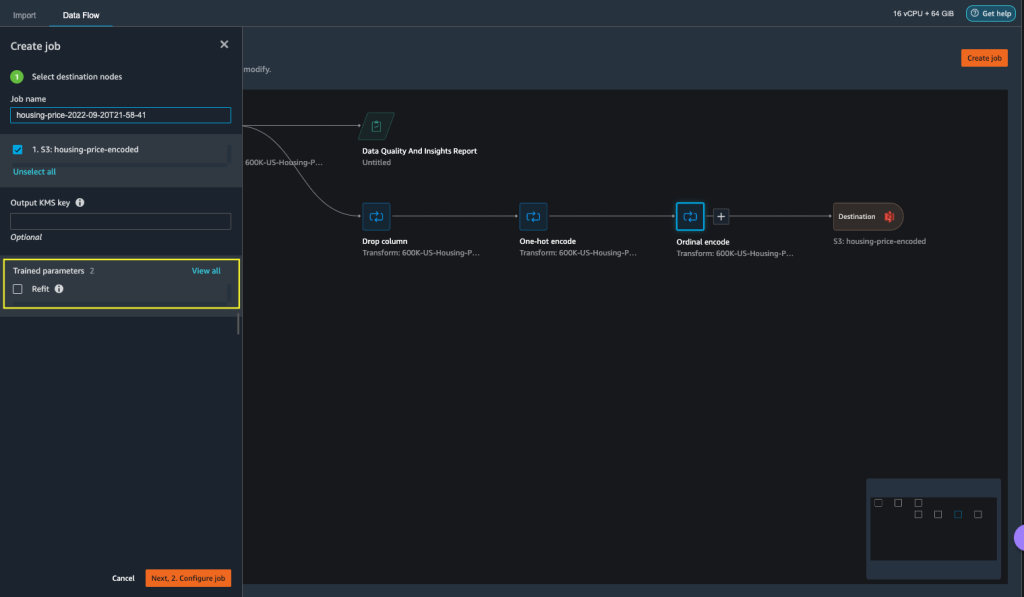

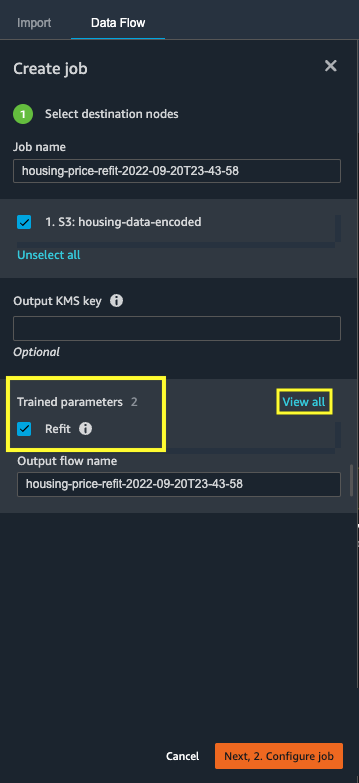

- Alege Creați loc de muncă pentru a iniția o lucrare de procesare a datelor cu Data Wrangler.

- Pentru Numele locului de munca, introduceți un nume.

- În Parametri antrenați, nu selectați regarnisi.

- Alege Configurați job.

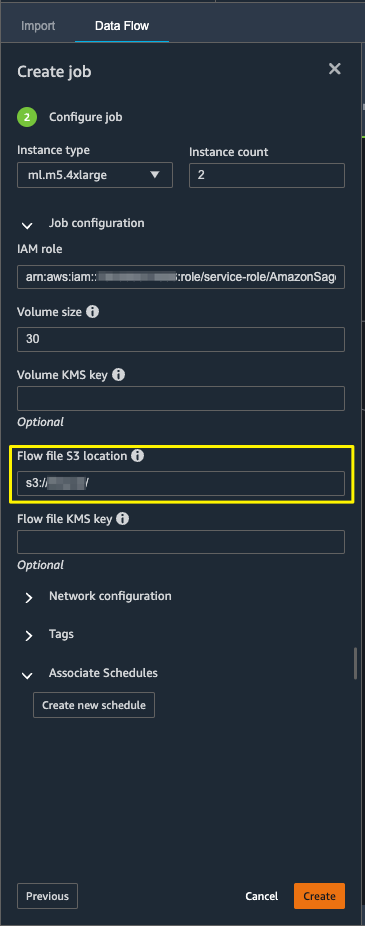

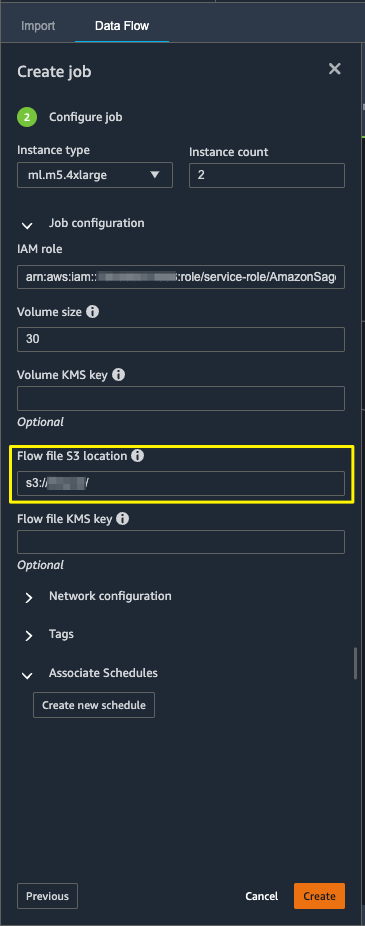

- Configurați parametrii jobului, cum ar fi tipurile de instanță, dimensiunea volumului și locația Amazon S3 pentru stocarea fișierului flux de ieșire.

- Data Wrangler creează un fișier de flux în locația fișierului de flux S3. Fluxul folosește transformări pentru a antrena parametrii, iar mai târziu folosim opțiunea de reajustare pentru a reantrena acești parametri.

- Alege Crea.

Așteptați finalizarea lucrării de procesare a datelor pentru a vedea datele transformate în compartimentul S3 configurat în nodul destinație.

Lansați o lucrare de procesare a datelor Data Wrangler cu refit activat

Să creăm o altă lucrare de procesare activată cu funcția de parametru antrenat de reajustare activată. Această opțiune impune parametrii antrenați reînvățați pe întregul set de date. Când această lucrare de procesare a datelor este finalizată, un fișier flux este creat sau actualizat în locația Amazon S3 configurată.

- Alege Creați loc de muncă.

- Pentru Numele locului de munca, introduceți un nume.

- Pentru Parametri antrenați, Selectați regarnisi.

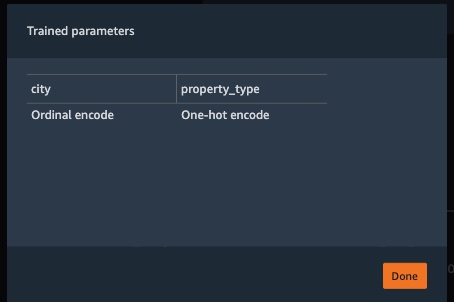

- Dacă alegeți Vezi tot, puteți revizui toți parametrii antrenați.

- Alege Configurați job.

- Introduceți locația fișierului flux Amazon S3.

- Alege Crea.

Așteptați finalizarea procesului de prelucrare a datelor.

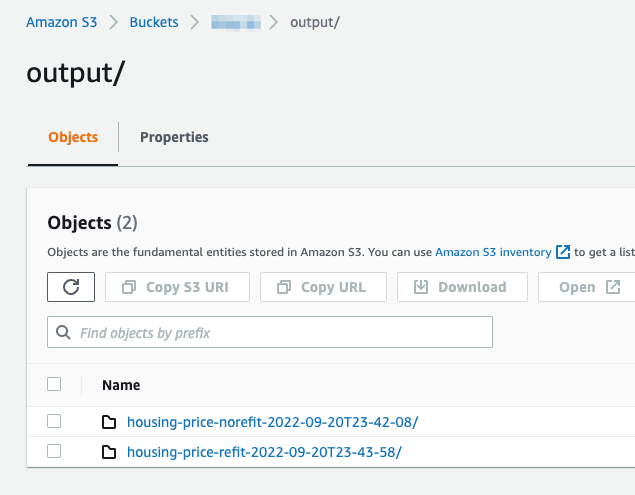

Consultați compartimentul S3 configurat în nodul destinație pentru a vedea datele generate de jobul de procesare a datelor care rulează transformările definite.

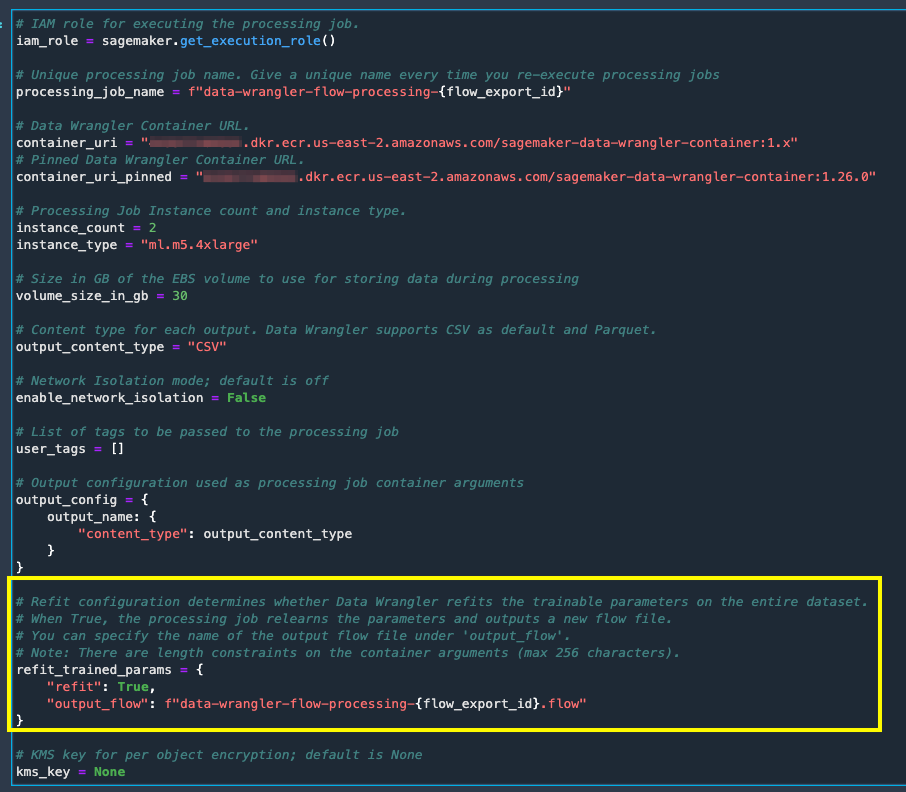

Exportați în codul Python pentru rularea joburilor de procesare Data Wrangler

Ca alternativă la pornirea lucrărilor de procesare folosind opțiunea Creare job din Data Wrangler, puteți declanșa lucrările de procesare a datelor exportând fluxul Data Wrangler într-un notebook Jupyter. Data Wrangler generează un notebook Jupyter cu intrări, ieșiri, configurații de procesare a lucrărilor și cod pentru verificarea stării lucrărilor. Puteți modifica sau actualiza parametrii conform cerințelor dvs. de transformare a datelor.

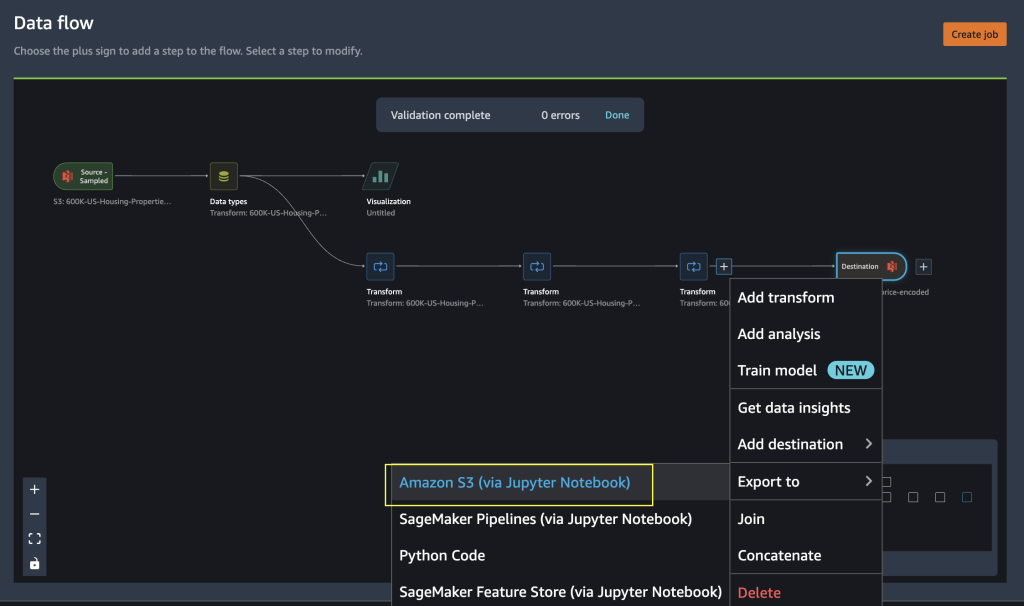

- Alegeți semnul plus de lângă finală Transforma nodul.

- Alege Export la și Amazon S3 (prin Jupyter Notebook).

Puteți vedea un blocnotes Jupyter deschis cu intrări, ieșiri, configurații de procesare a lucrărilor și cod pentru verificările stării lucrărilor.

- Pentru a aplica opțiunea parametrilor antrenați de reinstalare prin cod, setați

refitparametru pentru aTrue.

Comparați rezultatele lucrărilor de prelucrare a datelor

Comparați rezultatele lucrărilor de prelucrare a datelor

După ce joburile de procesare Data Wrangler sunt finalizate, trebuie să creați două noi fluxuri Data Wrangler cu rezultatul generat de joburile de procesare a datelor stocate în destinația Amazon S3 configurată.

Vă puteți referi la locația configurată în folderul de destinație Amazon S3 pentru a examina rezultatele joburilor de procesare a datelor.

Pentru a inspecta rezultatele lucrării de procesare, creați două noi fluxuri Data Wrangler utilizând Raportul Calitatea datelor și Informații pentru a compara rezultatele transformării.

- Creați un flux nou în Amazon SageMaker Data Wrangler.

- Importați lucrarea de procesare a datelor fără fișierul de ieșire activat refit din Amazon S3.

- Adăugați o nouă analiză.

- Pentru Tipul analizei, alege Raport privind calitatea datelor și perspective.

- Alege Crea.

Repetați pașii de mai sus și creați un nou flux de date wrangler pentru a analiza rezultatul lucrării de procesare a datelor cu refit activat.

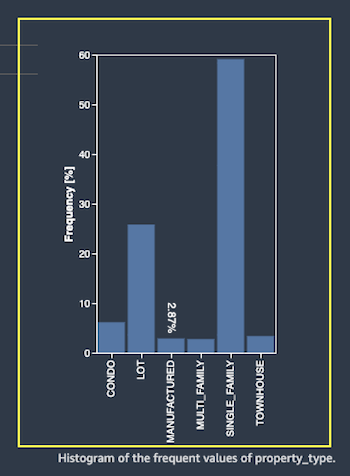

Acum să ne uităm la rezultatele procesării joburilor pentru caracteristică property_type folosind rapoartele privind calitatea datelor și statistici. Derulați la detaliile caracteristicii din lista Rapoarte de date și statistici feature_type.

Lucrarea de procesare a parametrilor instruiți a reinstalat parametrii antrenați pe întregul set de date și a codificat noua valoare APARTMENT cu șapte valori distincte pe întregul set de date.

Lucrarea normală de procesare a aplicat parametrii antrenați pentru setul de date eșantion, care au doar șase valori distincte pentru property_type caracteristică. Pentru date cu feature_type APARTMENT, strategie de manipulare nevalidă Skip este aplicat și jobul de prelucrare a datelor nu învață această nouă categorie. Codificarea one-hot a omis această nouă categorie prezentă în noile date, iar codificarea omite categoria APARTMENT.

Să ne concentrăm acum pe o altă caracteristică, city. Lucrarea de procesare a parametrilor instruit la reajustare a reînvățat toate valorile disponibile pentru city caracteristică, având în vedere noile date.

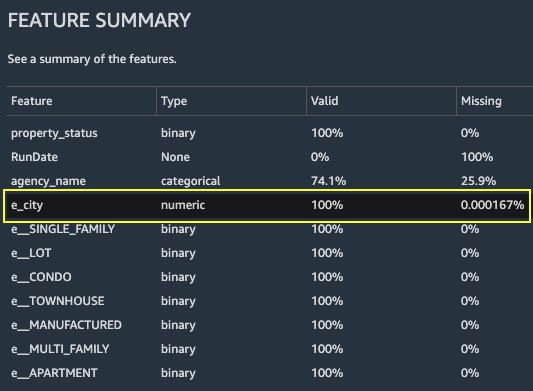

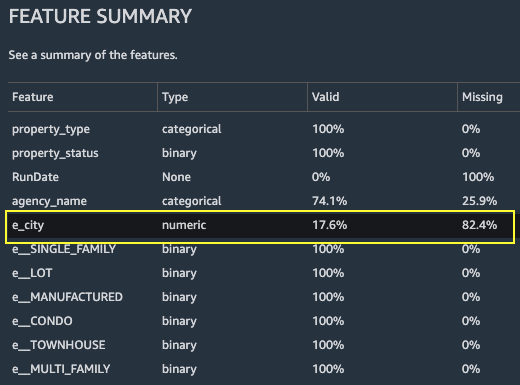

Așa cum se arată în Rezumatul caracteristicilor secțiunea raportului, noua coloană de caracteristici codificate e_city are parametri validi 100% prin utilizarea caracteristicii parametrilor antrenați de refit.

În schimb, lucrarea normală de procesare are 82.4% din valorile lipsă în noua coloană de caracteristici codificate e_city. Acest fenomen se datorează faptului că numai setul eșantion de parametri instruiți învățați sunt aplicați pe setul complet de date și nicio reajustare nu este aplicată de jobul de procesare a datelor.

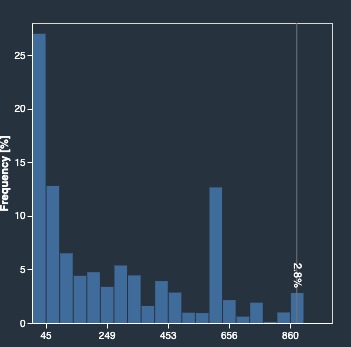

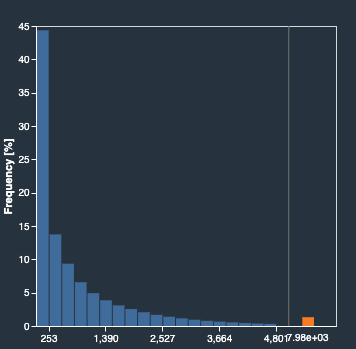

Următoarele histograme descriu caracteristica codificată ordinală e_city. Prima histogramă este a caracteristicii transformate cu opțiunea de refit.

Următoarea histogramă este a caracteristicii transformate fără opțiunea de reinstalare. Coloana portocalie arată valorile lipsă (NaN) în Raportul privind calitatea datelor și statistici. Noile valori care nu sunt învățate din setul de date eșantion sunt înlocuite ca Not a Number (NaN), așa cum este configurat în interfața de utilizare a Data Wrangler. strategie de manipulare nevalidă.

Lucrarea de prelucrare a datelor cu parametrul antrenat de refit a reînvățat property_type și city caracteristici luând în considerare noile valori din întregul set de date. Fără parametrul antrenat de refit, jobul de procesare a datelor utilizează numai parametrii antrenați preînvățați ai setului de date eșantionat. Apoi le aplică noilor date, dar noile valori nu sunt luate în considerare pentru codificare. Acest lucru va avea implicații asupra acurateței modelului.

A curăța

Când nu utilizați Data Wrangler, este important să închideți instanța pe care rulează pentru a evita costurile suplimentare.

Pentru a evita pierderea muncii, salvați fluxul de date înainte de a închide Data Wrangler.

- Pentru a vă salva fluxul de date Amazon SageMaker Studio, alege Fișier, Apoi alegeți Salvați fluxul de date Wrangler. Data Wrangler salvează automat fluxul de date la fiecare 60 de secunde.

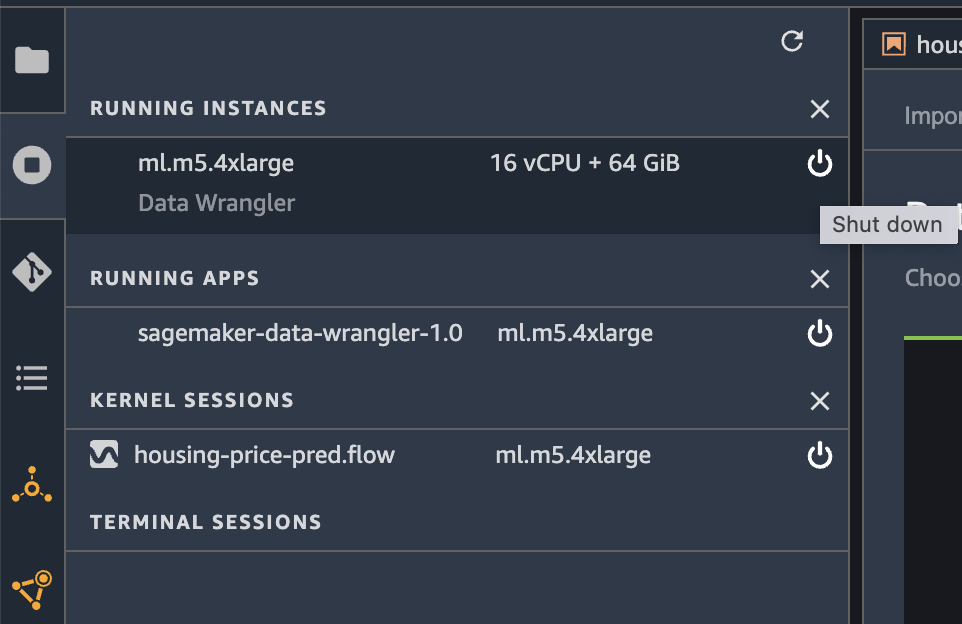

- Pentru a închide instanța Data Wrangler, în Studio, alegeți Rularea instanțelor și a nucleelor.

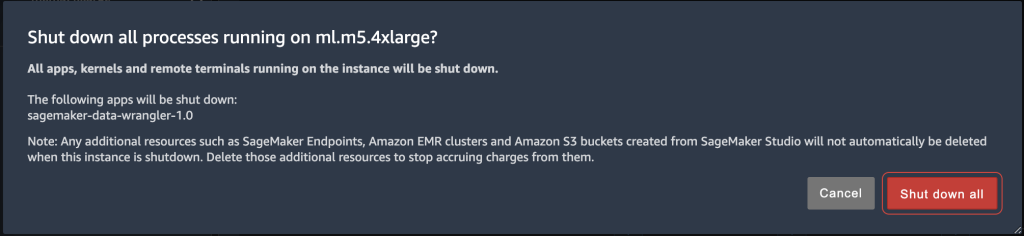

- În RULEAȚI APLICAȚII, alegeți pictograma de închidere de lângă aplicația sagemaker-data-wrangler-1.0.

- Alege Închideți totul a confirma.

Data Wrangler rulează pe o instanță ml.m5.4xlarge. Această instanță dispare din INSTANȚE DE RELARE când închideți aplicația Data Wrangler.

După ce închideți aplicația Data Wrangler, aceasta trebuie să repornească data viitoare când deschideți un fișier de flux Data Wrangler. Acest lucru poate dura câteva minute.

Concluzie

În această postare, am oferit o prezentare generală a caracteristicii parametrilor antrenați de refit în Data Wrangler. Cu această nouă caracteristică, puteți stoca parametrii antrenați în fluxul Data Wrangler, iar joburile de procesare a datelor folosesc parametrii antrenați pentru a aplica transformările învățate pe seturi mari de date sau seturi de date de consolidare. Puteți aplica această opțiune la vectorizarea caracteristicilor de text, a datelor numerice și la gestionarea valorii aberante.

Păstrarea parametrilor instruiți pe parcursul procesării datelor ciclului de viață ML simplifică și reduce pașii de procesare a datelor, acceptă o inginerie robustă a caracteristicilor și susține formarea modelului și formarea de consolidare pe date noi.

Vă încurajăm să încercați această nouă funcție pentru cerințele dvs. de prelucrare a datelor.

Despre autori

Hariharan Suresh este arhitect senior de soluții la AWS. Este pasionat de baze de date, de învățare automată și de proiectarea de soluții inovatoare. Înainte de a se alătura AWS, Hariharan a fost arhitect de produs, specialist principal în implementare bancară și dezvoltator și a lucrat cu organizații BFSI timp de peste 11 ani. În afara tehnologiei, îi plac parapanta și ciclismul.

Hariharan Suresh este arhitect senior de soluții la AWS. Este pasionat de baze de date, de învățare automată și de proiectarea de soluții inovatoare. Înainte de a se alătura AWS, Hariharan a fost arhitect de produs, specialist principal în implementare bancară și dezvoltator și a lucrat cu organizații BFSI timp de peste 11 ani. În afara tehnologiei, îi plac parapanta și ciclismul.

Santosh Kulkarni este arhitect de soluții pentru întreprinderi la Amazon Web Services care lucrează cu clienți de sport din Australia. Este pasionat de construirea de aplicații distribuite la scară largă pentru a rezolva problemele de afaceri folosind cunoștințele sale în AI/ML, big data și dezvoltarea de software.

Santosh Kulkarni este arhitect de soluții pentru întreprinderi la Amazon Web Services care lucrează cu clienți de sport din Australia. Este pasionat de construirea de aplicații distribuite la scară largă pentru a rezolva problemele de afaceri folosind cunoștințele sale în AI/ML, big data și dezvoltarea de software.

Vishaal Kapoor este un om de știință senior aplicat cu AWS AI. Este pasionat de a ajuta clienții să-și înțeleagă datele în Data Wrangler. În timpul liber, face biciclete montane, face snowboard și își petrece timpul cu familia.

Vishaal Kapoor este un om de știință senior aplicat cu AWS AI. Este pasionat de a ajuta clienții să-și înțeleagă datele în Data Wrangler. În timpul liber, face biciclete montane, face snowboard și își petrece timpul cu familia.

Aniketh Manjunath este inginer de dezvoltare software la Amazon SageMaker. El ajută la sprijinirea Amazon SageMaker Data Wrangler și este pasionat de sistemele de învățare automată distribuite. În afara serviciului, îi place să facă drumeții, să se uite la filme și să joace cricket.

Aniketh Manjunath este inginer de dezvoltare software la Amazon SageMaker. El ajută la sprijinirea Amazon SageMaker Data Wrangler și este pasionat de sistemele de învățare automată distribuite. În afara serviciului, îi place să facă drumeții, să se uite la filme și să joace cricket.

- AI

- ai art

- ai art generator

- ai robot

- Amazon SageMaker

- Amazon SageMaker Data Wrangler

- inteligență artificială

- certificare de inteligență artificială

- inteligența artificială în domeniul bancar

- robot cu inteligență artificială

- roboți cu inteligență artificială

- software de inteligență artificială

- Învățare automată AWS

- blockchain

- conferință blockchain ai

- coingenius

- inteligența artificială conversațională

- criptoconferință ai

- dall-e

- învățare profundă

- google ai

- Intermediar (200)

- masina de învățare

- Plato

- platoul ai

- Informații despre date Platon

- Jocul lui Platon

- PlatoData

- platogaming

- scara ai

- sintaxă

- zephyrnet