Această postare vă prezintă cele mai frecvente provocări cu care se confruntă clienții atunci când caută documente interne și vă oferă îndrumări concrete cu privire la modul în care serviciile AWS pot fi utilizate pentru a crea un bot conversațional AI generativ care face informațiile interne mai utile.

Datele nestructurate reprezintă 80% din toate datele găsite în cadrul organizațiilor, constând din depozite de manuale, PDF-uri, întrebări frecvente, e-mailuri și alte documente care cresc zilnic. Companiile de astăzi se bazează pe depozite de informații interne în continuă creștere, iar problemele apar atunci când cantitatea de date nestructurate devine imposibil de gestionat. Adesea, utilizatorii se trezesc citind și verificând multe surse interne diferite pentru a găsi răspunsurile de care au nevoie.

Forumurile interne de întrebări și răspunsuri pot ajuta utilizatorii să obțină răspunsuri foarte specifice, dar necesită și timpi de așteptare mai mari. În cazul întrebărilor frecvente interne specifice companiei, timpii lungi de așteptare au ca rezultat o productivitate mai scăzută a angajaților. Forumurile de întrebări și răspunsuri sunt greu de scalat, deoarece se bazează pe răspunsuri scrise manual. Cu IA generativă, există în prezent o schimbare de paradigmă în modul în care utilizatorii caută și găsesc informații. Următorul pas logic este utilizarea AI generativă pentru a condensa documente mari în informații de dimensiuni mai mici, pentru un consum mai ușor de către utilizator. În loc să petreacă mult timp citind text sau așteptând răspunsuri, utilizatorii pot genera rezumate în timp real pe baza mai multor depozite existente de informații interne.

Prezentare generală a soluțiilor

Soluția permite clienților să obțină răspunsuri la întrebările adresate despre documentele interne, folosind un model de transformator pentru a genera răspunsuri la întrebări despre date pe care nu au fost instruiți, o tehnică cunoscută sub numele de promptare zero-shot. Prin adoptarea acestei soluții, clienții pot obține următoarele beneficii:

- Găsiți răspunsuri corecte la întrebări pe baza surselor existente de documente interne

- Reduceți timpul petrecut de utilizatori căutând răspunsuri utilizând modele lingvistice mari (LLM) pentru a oferi răspunsuri aproape imediate la întrebări complexe, folosind documente cu cele mai actualizate informații

- Căutați întrebări la care s-a răspuns anterior printr-un tablou de bord centralizat

- Reduceți stresul cauzat de petrecerea timpului citind manual informații pentru a căuta răspunsuri

Recuperare Augmented Generation (RAG)

Retrieval Augmented Generation (RAG) reduce unele dintre deficiențele interogărilor bazate pe LLM prin găsirea răspunsurilor din baza de cunoștințe și folosind LLM pentru a rezuma documentele în răspunsuri concise. Te rog citește asta post pentru a învăța cum să implementați abordarea RAG cu Amazon Kendra. Următoarele riscuri și limitări sunt asociate cu interogările bazate pe LLM pe care o abordare RAG cu Amazon Kendra le abordează:

- Halucinații și trasabilitate – LLMS sunt antrenate pe seturi mari de date și generează răspunsuri pe probabilități. Acest lucru poate duce la răspunsuri inexacte, care sunt cunoscute sub numele de halucinații.

- Silozuri de date multiple – Pentru a face referire la date din mai multe surse în cadrul răspunsului dvs., trebuie să configurați un ecosistem de conectori pentru a agrega datele. Accesarea mai multor depozite este manuală și necesită timp.

- Securitate – Securitatea și confidențialitatea sunt considerații critice atunci când implementați roboți conversaționali alimentați de RAG și LLM. În ciuda folosirii Amazon Comprehend pentru a filtra datele cu caracter personal care pot fi furnizate prin interogări ale utilizatorilor, rămâne posibilitatea de a afișa neintenționat informații personale sau sensibile, în funcție de datele ingerate. Aceasta înseamnă că controlul accesului la chatbot este crucial pentru a preveni accesul neintenționat la informații sensibile.

- Relevanța datelor – LLMS sunt instruiți pe date până la o anumită dată, ceea ce înseamnă că informațiile nu sunt adesea actuale. Costul asociat modelelor de instruire pe date recente este ridicat. Pentru a asigura răspunsuri exacte și actualizate, organizațiile poartă responsabilitatea actualizării și îmbogățirii periodice a conținutului documentelor indexate.

- Cost – Costul asociat cu implementarea acestei soluții ar trebui să fie luat în considerare pentru companii. Companiile trebuie să își evalueze cu atenție bugetul și cerințele de performanță atunci când implementează această soluție. Rularea LLM-urilor poate necesita resurse de calcul substanțiale, ceea ce poate crește costurile operaționale. Aceste costuri pot deveni o limitare pentru aplicațiile care trebuie să funcționeze la scară largă. Cu toate acestea, unul dintre beneficiile AWS Cloud este flexibilitatea de a plăti doar pentru ceea ce folosești. AWS oferă un model de preț simplu, consecvent, cu plata în funcție de utilizare, astfel încât sunteți taxat doar pentru resursele pe care le consumați.

Utilizarea Amazon SageMaker JumpStart

Pentru modelele de limbaj bazate pe transformator, organizațiile pot beneficia de pe urma utilizării Amazon SageMaker JumpStart, care oferă o colecție de modele de învățare automată prefabricate. Amazon SageMaker JumpStart oferă o gamă largă de modele fundamentale de generare de text și răspunsuri la întrebări (Întrebări și răspunsuri) care pot fi implementate și utilizate cu ușurință. Această soluție integrează un model Amazon SageMaker JumpStart FLAN T5-XL, dar există diferite aspecte de reținut atunci când alegerea unui model de fundație.

Integrarea securității în fluxul nostru de lucru

Urmând cele mai bune practici ale Pilonului de securitate al Cadru bine arhitecturat, Amazon Cognito este folosit pentru autentificare. Pool-urile de utilizatori Amazon Cognito pot fi integrate cu furnizori de identitate terți care acceptă mai multe cadre utilizate pentru controlul accesului, inclusiv Open Authorization (OAuth), OpenID Connect (OIDC) sau Security Assertion Markup Language (SAML). Identificarea utilizatorilor și a acțiunilor acestora permite soluției să mențină trasabilitatea. Soluția folosește și Detectarea informațiilor de identificare personală (PII) Amazon Comprehend funcția de identificare și redactare automată a PII. PII eliminate includ adrese, numere de securitate socială, adrese de e-mail și alte informații sensibile. Acest design asigură că orice PII furnizat de utilizator prin interogarea de intrare este redactat. PII nu este stocat, utilizat de Amazon Kendra sau alimentat LLM.

Soluție pasională

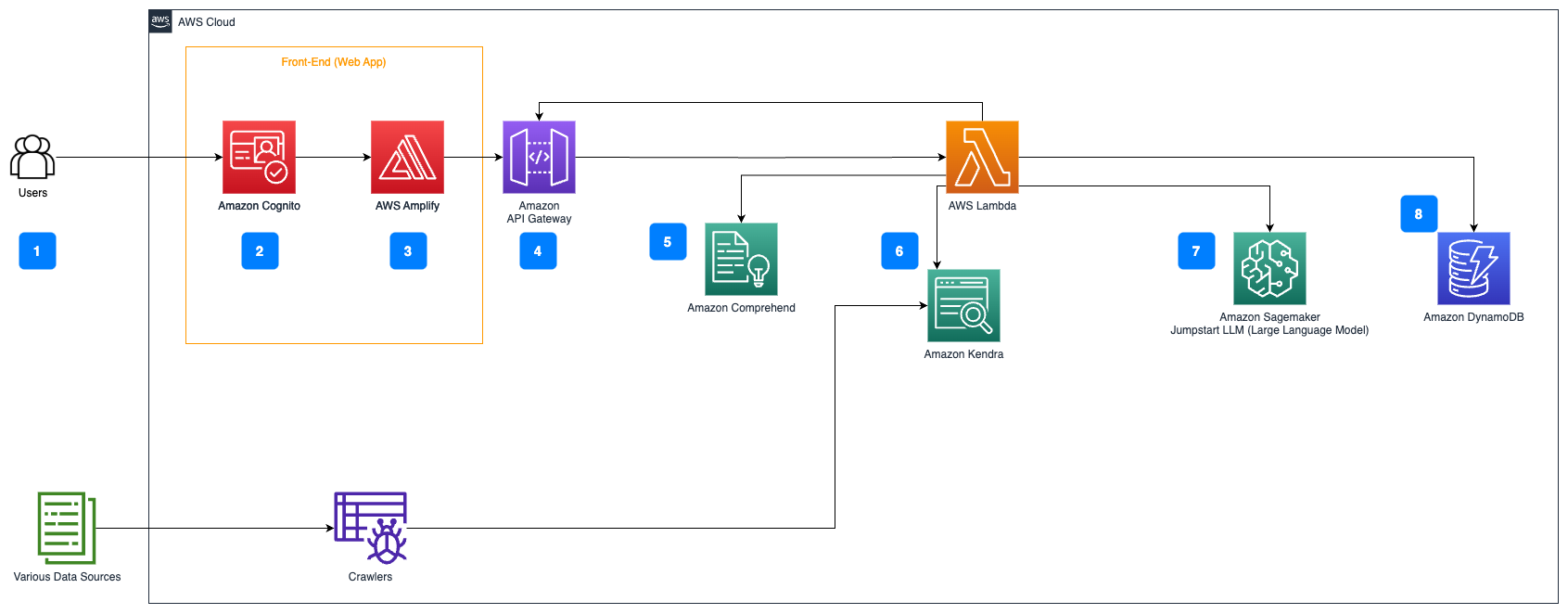

Următorii pași descriu fluxul de lucru al fluxului de răspunsuri la întrebări peste documente:

- Utilizatorii trimit o interogare printr-o interfață web.

- Amazon Cognito este utilizat pentru autentificare, asigurând accesul securizat la aplicația web.

- Aplicația web front-end este găzduită Amplificare AWS.

- Gateway API Amazon găzduiește un API REST cu diferite puncte finale pentru a gestiona solicitările utilizatorilor care sunt autentificate folosind Amazon Cognito.

- Redactarea PII cu Amazon Comprehend:

- Procesarea interogărilor utilizatorului: atunci când un utilizator trimite o interogare sau o intrare, aceasta este mai întâi transmisă prin Amazon Comprehend. Serviciul analizează textul și identifică orice entități PII prezente în interogare.

- Extragerea PII: Amazon Comprehend extrage entitățile PII detectate din interogarea utilizatorului.

- Recuperarea informațiilor relevante cu Amazon Kendra:

- Amazon Kendra este folosit pentru a gestiona un index de documente care conține informațiile folosite pentru a genera răspunsuri la întrebările utilizatorului.

- Preluare LangChain QA modulul este utilizat pentru a construi un lanț de conversații care conține informații relevante despre interogările utilizatorului.

- Integrarea cu Amazon SageMaker JumpStart:

- Funcția AWS Lambda utilizează biblioteca LangChain și se conectează la punctul final Amazon SageMaker JumpStart cu o interogare plină de context. Punctul final Amazon SageMaker JumpStart servește ca interfață a LLM utilizat pentru inferență.

- Stocarea răspunsurilor și returnarea acestora către utilizator:

- Răspunsul de la LLM este stocat în Amazon DynamoDB împreună cu interogarea utilizatorului, marcajul de timp, un identificator unic și alți identificatori arbitrari pentru articol, cum ar fi categoria de întrebare. Stocarea întrebării și a răspunsului ca elemente discrete permite funcției AWS Lambda să recreeze cu ușurință istoricul conversațiilor unui utilizator în funcție de momentul în care au fost puse întrebările.

- În cele din urmă, răspunsul este trimis înapoi utilizatorului printr-o solicitare HTTP prin răspunsul de integrare API REST Amazon API Gateway.

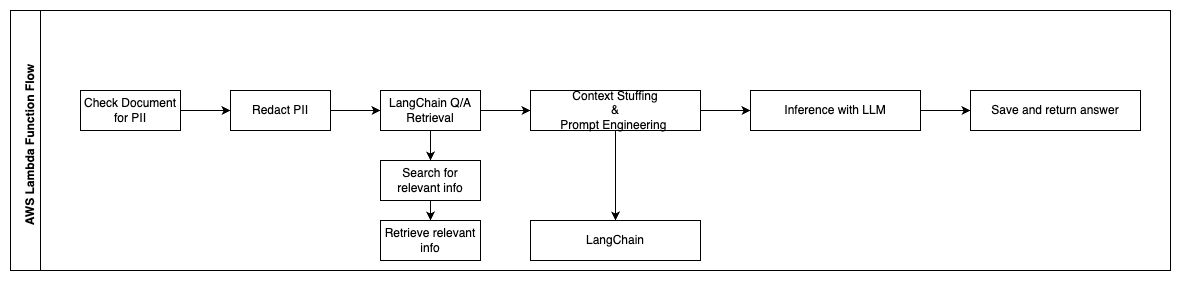

Următorii pași descriu funcțiile AWS Lambda și fluxul lor prin proces:

- Verificați și redactați orice PII/informații sensibile

- Lanțul de recuperare LangChain QA

- Căutați și preluați informații relevante

- Umplutura de context și inginerie promptă

- Inferență cu LLM

- Returnați răspunsul și salvați-l

Cazuri de utilizare

Există multe cazuri de utilizare în afaceri în care clienții pot folosi acest flux de lucru. Următoarea secțiune explică modul în care fluxul de lucru poate fi utilizat în diferite industrii și verticale.

Asistență pentru angajați

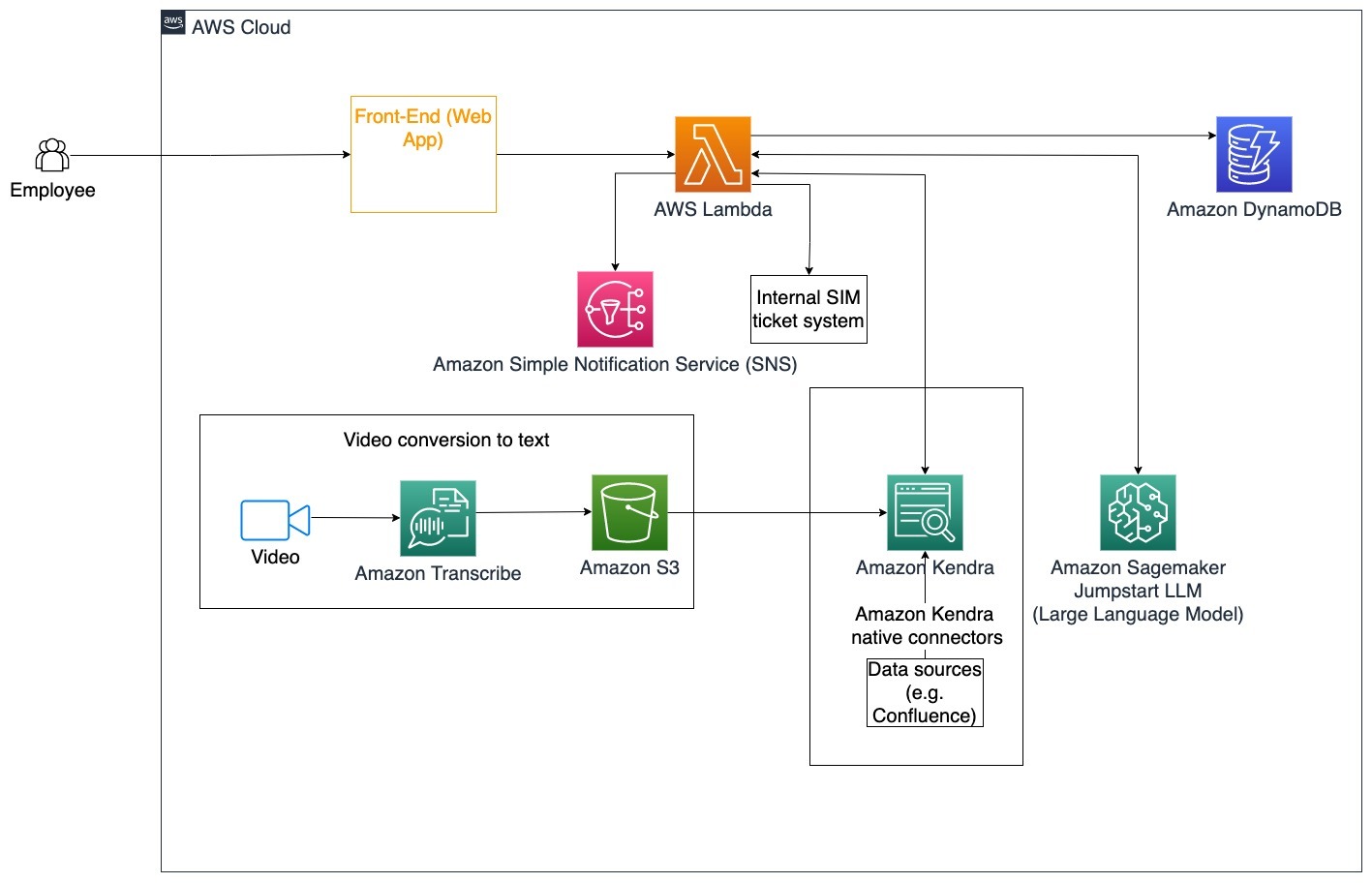

Instruirea corporativă bine concepută poate îmbunătăți satisfacția angajaților și poate reduce timpul necesar pentru integrarea noilor angajați. Pe măsură ce organizațiile cresc și complexitatea crește, angajaților le este greu să înțeleagă numeroasele surse ale documentelor interne. Documentele interne în acest context includ liniile directoare ale companiei, politicile și procedurile standard de operare. Pentru acest scenariu, un angajat are o întrebare despre cum să procedeze și să editeze un bilet intern de ticketing. Angajatul poate accesa și utiliza botul conversațional de inteligență artificială generativă (AI) pentru a cere și a executa următorii pași pentru un anumit bilet.

Caz de utilizare specific: Automatizați rezolvarea problemelor pentru angajați pe baza ghidurilor corporative.

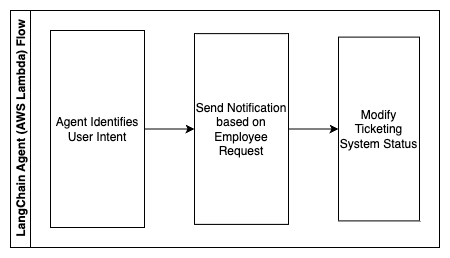

Următorii pași descriu funcțiile AWS Lambda și fluxul lor prin proces:

- Agent LangChain pentru a identifica intentia

- Trimiteți o notificare pe baza solicitării angajatului

- Modificați starea biletului

În această diagramă de arhitectură, videoclipurile de formare corporativă pot fi ingerate Transcriere Amazon pentru a colecta un jurnal al acestor scripturi video. În plus, conținutul de formare corporativă stocat în diverse surse (de exemplu, Confluence, Microsoft SharePoint, Google Drive, Jira etc.) poate fi folosit pentru a crea indici prin conectorii Amazon Kendra. Citiți acest articol pentru a afla mai multe despre colecția de nativi conectori puteți utiliza în Amazon Kendra ca punct sursă. Crawler-ul Amazon Kendra poate folosi atât scripturile video de instruire corporativă, cât și documentația stocată în aceste alte surse pentru a ajuta botul conversațional să răspundă la întrebări specifice ghidurilor de instruire corporative ale companiei. Agentul LangChain verifică permisiunile, modifică starea biletului și notifică persoanele corecte utilizând Amazon Simple Notification Service (Amazon SNS).

Echipe de asistență clienți

Rezolvarea rapidă a întrebărilor clienților îmbunătățește experiența clienților și încurajează loialitatea mărcii. O bază de clienți loiali ajută la creșterea vânzărilor, ceea ce contribuie la rezultatul final și crește implicarea clienților. Echipele de asistență pentru clienți cheltuiesc multă energie referindu-se la multe documente interne și software de management al relațiilor cu clienții pentru a răspunde întrebărilor clienților despre produse și servicii. Documentele interne în acest context pot include scripturi de apeluri generice de asistență pentru clienți, manuale, linii directoare de escaladare și informații despre afaceri. Botul conversațional AI generativ ajută la optimizarea costurilor, deoarece gestionează interogările în numele echipei de asistență pentru clienți.

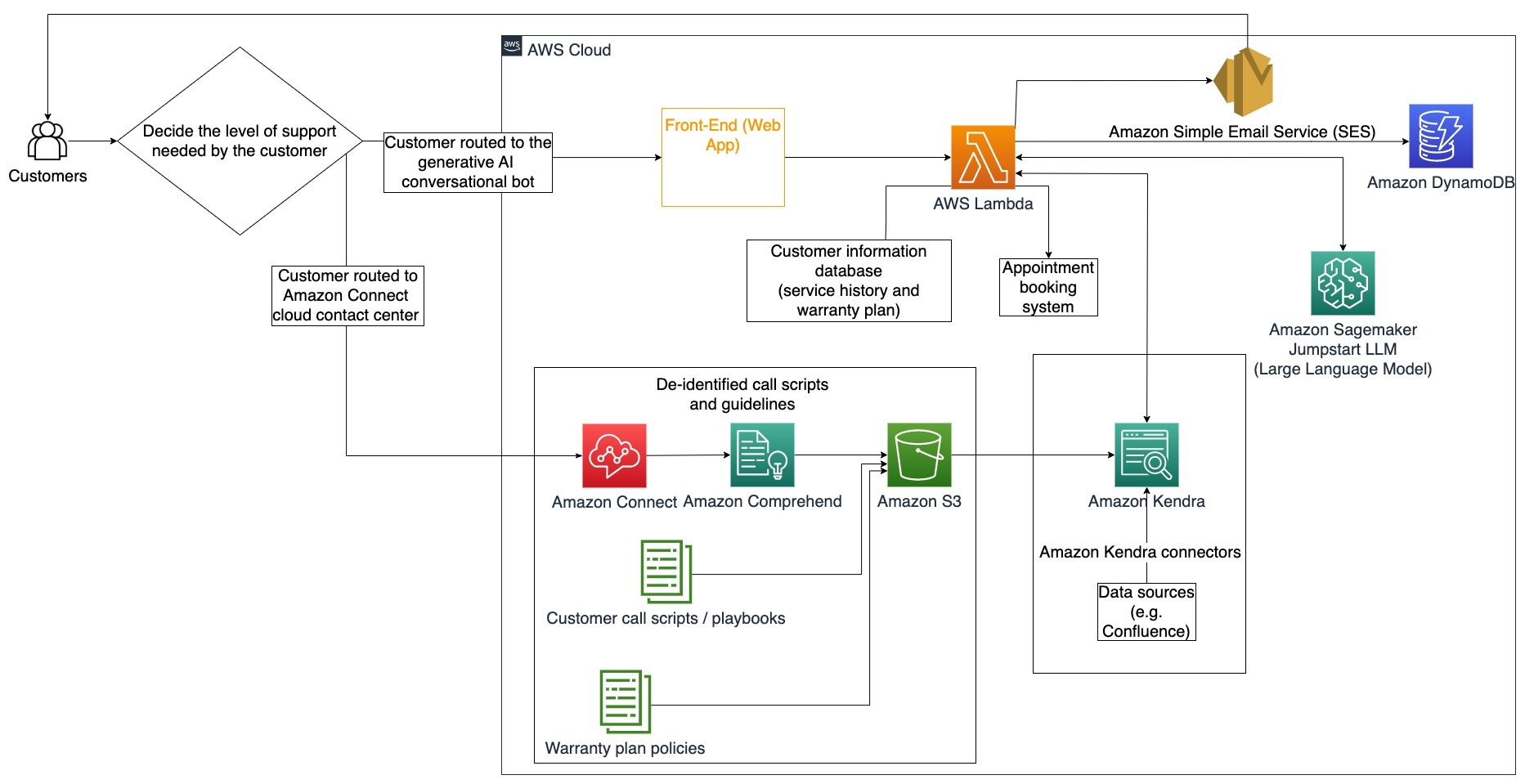

Caz de utilizare specific: Gestionarea unei cereri de schimbare a uleiului pe baza istoricului de service și a planului de service pentru clienți achiziționat.

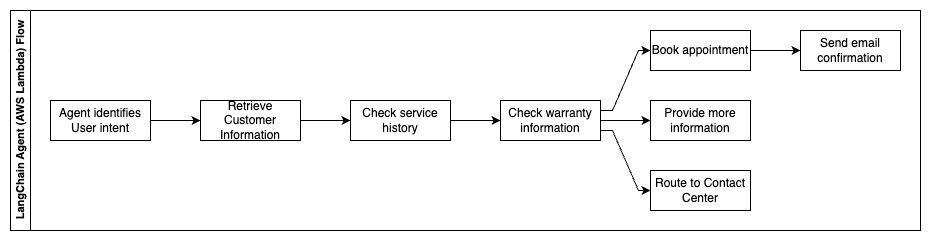

În această diagramă de arhitectură, clientul este direcționat fie către botul conversațional AI generativ, fie către Amazon Connect centru de contact. Această decizie se poate baza pe nivelul de asistență necesar sau pe disponibilitatea agenților de asistență pentru clienți. Agentul LangChain identifică intenția clientului și verifică identitatea. Agentul LangChain verifică, de asemenea, istoricul serviciilor și planul de asistență achiziționat.

Următorii pași descriu funcțiile AWS Lambda și fluxul lor prin proces:

- Agentul LangChain identifică intenția

- Preluați informații despre client

- Verificați istoricul serviciului pentru clienți și informațiile despre garanție

- Rezervați o întâlnire, furnizați mai multe informații sau rutați către centrul de contact

- Trimiteți confirmarea prin e-mail

Amazon Connect este utilizat pentru a colecta jurnalele de voce și chat, iar Amazon Comprehend este utilizat pentru a elimina informațiile de identificare personală (PII) din aceste jurnale. Crawler-ul Amazon Kendra poate folosi apoi jurnalele de voce și chat redactate, scripturile de apel pentru clienți și politicile planului de asistență pentru clienți pentru a crea indexul. Odată luată o decizie, botul conversațional generativ AI decide dacă rezervă o întâlnire, oferă mai multe informații sau direcționează clientul către centrul de contact pentru asistență suplimentară. Pentru optimizarea costurilor, agentul LangChain poate genera, de asemenea, răspunsuri folosind mai puține jetoane și un model de limbaj mai puțin costisitor pentru interogările clienților cu prioritate mai mică.

Servicii financiare

Companiile de servicii financiare se bazează pe utilizarea în timp util a informațiilor pentru a rămâne competitive și pentru a respecta reglementările financiare. Folosind un bot conversațional generativ AI, analiștii financiari și consilierii pot interacționa cu informațiile textuale într-o manieră conversațională și pot reduce timpul și efortul necesar pentru a lua decizii mai bine informate. În afara investițiilor și a cercetării de piață, un bot conversațional generativ AI poate crește și capabilitățile umane prin gestionarea sarcinilor care ar necesita în mod tradițional mai mult efort și timp uman. De exemplu, o instituție financiară specializată în împrumuturi personale poate crește rata la care sunt procesate împrumuturile, oferind în același timp o mai bună transparență clienților.

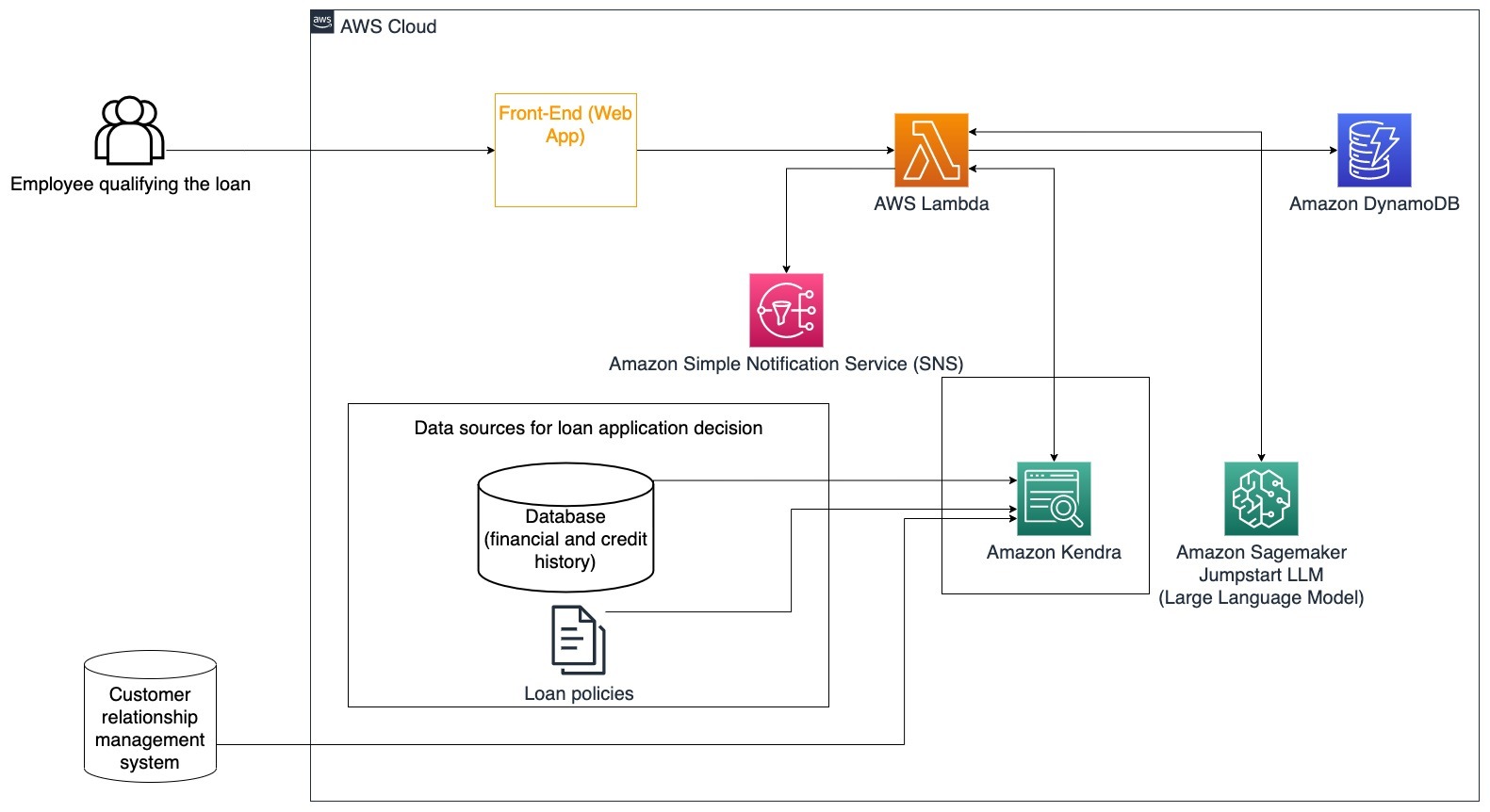

Caz de utilizare specific: Utilizați istoricul financiar al clienților și cererile anterioare de împrumut pentru a decide și explica decizia de împrumut.

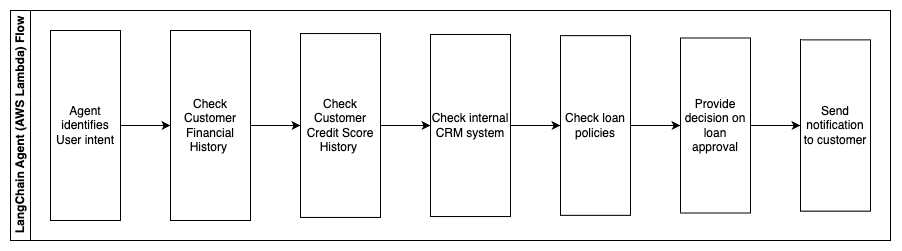

Următorii pași descriu funcțiile AWS Lambda și fluxul lor prin proces:

- Agent LangChain pentru a identifica intentia

- Verificați istoricul financiar și al scorului de credit al clienților

- Verificați sistemul intern de management al relațiilor cu clienții

- Verificați politicile standard de împrumut și sugerați decizia angajatului care se califică pentru împrumut

- Trimiteți o notificare către client

Această arhitectură încorporează date financiare ale clienților stocate într-o bază de date și date stocate într-un instrument de management al relațiilor cu clienții (CRM). Aceste puncte de date sunt folosite pentru a informa o decizie bazată pe politicile interne de împrumut ale companiei. Clientul poate pune întrebări clarificatoare pentru a înțelege pentru ce împrumuturi se califică și condițiile împrumuturilor pe care le poate accepta. Dacă botul conversațional AI generativ nu poate aproba o cerere de împrumut, utilizatorul poate pune întrebări despre îmbunătățirea scorurilor de credit sau despre opțiunile alternative de finanțare.

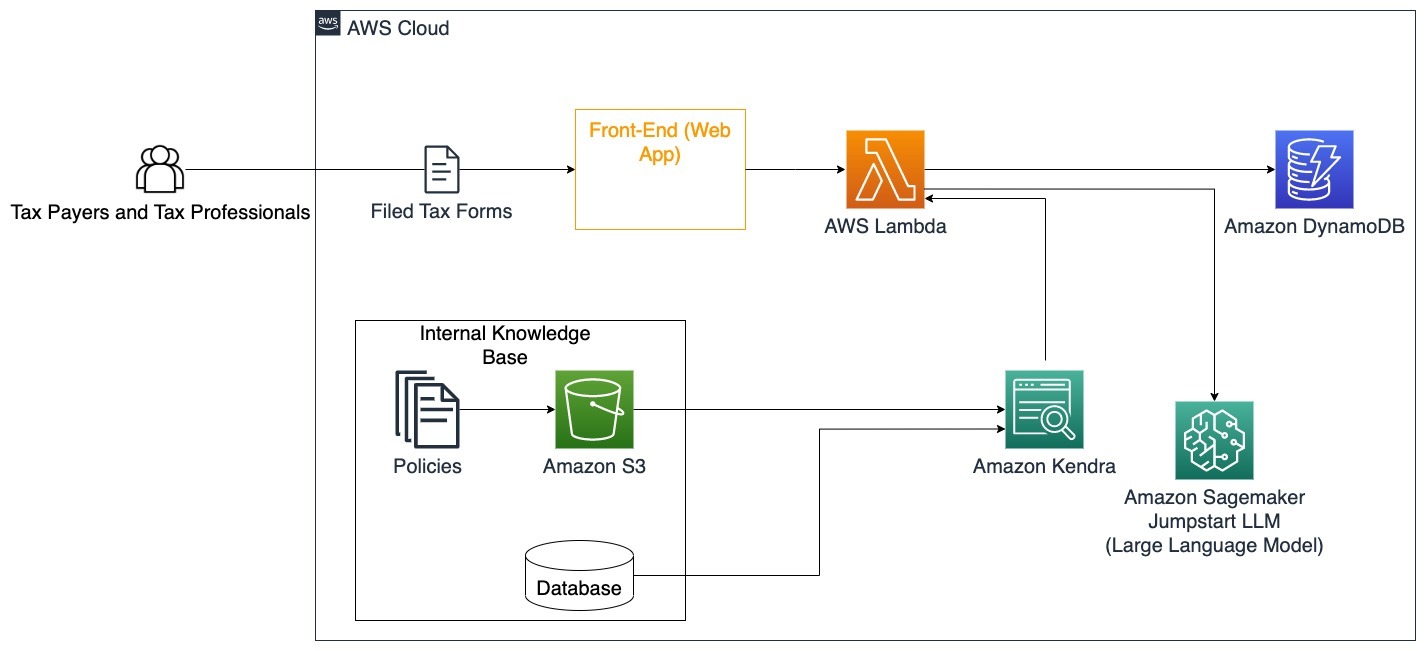

Guvern

Boții conversaționali generativi AI pot beneficia foarte mult instituțiilor guvernamentale prin accelerarea proceselor de comunicare, eficiență și luare a deciziilor. Boții conversaționali generativi de inteligență artificială pot oferi, de asemenea, acces instantaneu la bazele de cunoștințe interne pentru a ajuta angajații guvernamentali să recupereze rapid informații, politici și proceduri (adică, criteriile de eligibilitate, procesele de aplicare și serviciile și asistența cetățenilor). O soluție este un sistem interactiv, care permite contribuabililor și profesioniștilor fiscali să găsească cu ușurință detalii și beneficii legate de impozite. Poate fi folosit pentru a înțelege întrebările utilizatorilor, pentru a rezuma documentele fiscale și pentru a oferi răspunsuri clare prin conversații interactive.

Utilizatorii pot pune întrebări precum:

- Cum funcționează impozitul pe moștenire și care sunt pragurile fiscale?

- Puteți explica conceptul de impozit pe venit?

- Care sunt implicațiile fiscale atunci când vindeți o a doua proprietate?

În plus, utilizatorii pot avea comoditatea de a trimite formulare fiscale la un sistem, care poate ajuta la verificarea corectitudinii informațiilor furnizate.

Această arhitectură ilustrează modul în care utilizatorii pot încărca formulare fiscale completate în soluție și le pot utiliza pentru verificarea interactivă și îndrumări despre cum să completeze cu exactitate informațiile necesare.

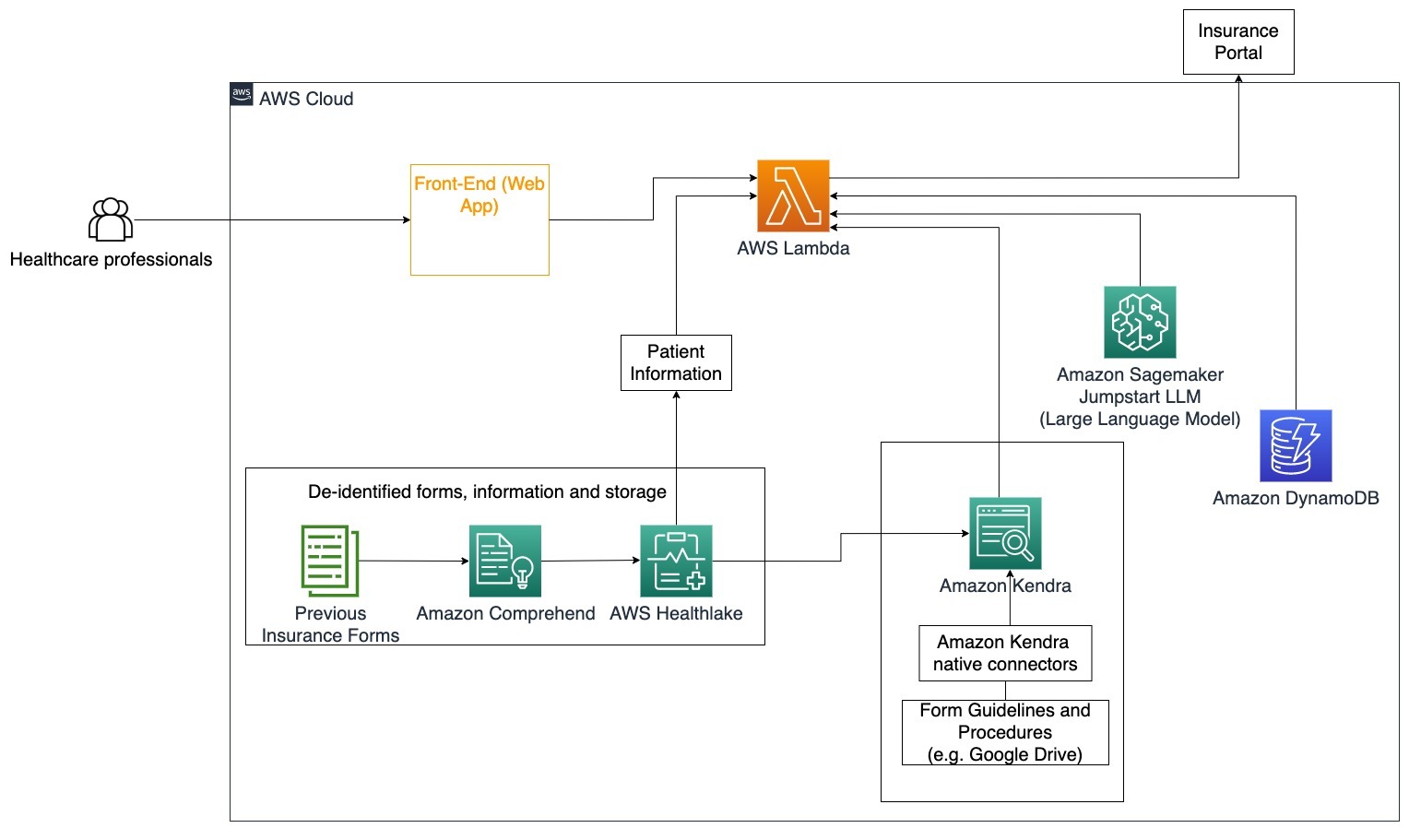

Farmaceutice

Întreprinderile din domeniul sănătății au posibilitatea de a automatiza utilizarea unor cantități mari de informații interne ale pacienților, abordând în același timp întrebări frecvente referitoare la cazurile de utilizare, cum ar fi opțiunile de tratament, cererile de asigurare, studiile clinice și cercetarea farmaceutică. Utilizarea unui bot conversațional generativ AI permite generarea rapidă și precisă de răspunsuri despre informațiile de sănătate din baza de cunoștințe furnizată. De exemplu, unii profesioniști din domeniul sănătății petrec mult timp completând formulare pentru a depune cereri de asigurare.

În situații similare, administratorii studiilor clinice și cercetătorii trebuie să găsească informații despre opțiunile de tratament. Un bot conversațional generativ de inteligență artificială poate folosi conectorii pre-construiți în Amazon Kendra pentru a prelua cele mai relevante informații din milioanele de documente publicate prin cercetările în desfășurare efectuate de companii farmaceutice și universități.

Caz de utilizare specific: Reduceți erorile și timpul necesar pentru completarea și trimiterea formularelor de asigurare.

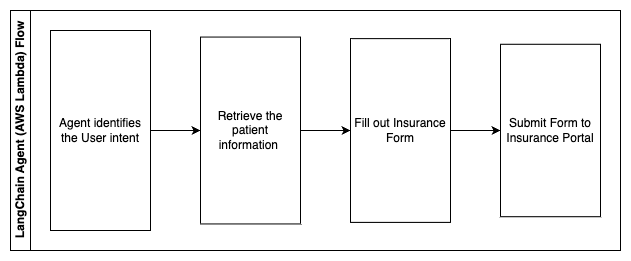

În această diagramă de arhitectură, un profesionist din domeniul sănătății poate folosi botul conversațional AI generativ pentru a afla ce formulare trebuie să fie completate pentru asigurare. Agentul LangChain este apoi capabil să recupereze formularele potrivite și să adauge informațiile necesare pentru un pacient, precum și să ofere răspunsuri pentru părțile descriptive ale formularelor pe baza polițelor de asigurare și a formularelor anterioare. Profesionistul din domeniul sănătății poate edita răspunsurile date de LLM înainte de a aprobă și de a primi formularul pe portalul de asigurări.

Următorii pași descriu funcțiile AWS Lambda și fluxul lor prin proces:

- Agent LangChain pentru a identifica intentia

- Preluați informațiile necesare despre pacient

- Completați formularul de asigurare pe baza informațiilor despre pacient și a ghidului de formular

- Trimiteți formularul pe portalul de asigurări după aprobarea utilizatorului

AWS HealthLake este utilizat pentru a stoca în siguranță datele de sănătate, inclusiv formularele de asigurare anterioare și informațiile despre pacient, iar Amazon Comprehend este utilizat pentru a elimina informațiile de identificare personală (PII) din formularele de asigurare anterioare. Crawler-ul Amazon Kendra este apoi capabil să utilizeze setul de formulare și linii directoare de asigurare pentru a crea indexul. Odată ce formularele sunt completate de către AI generativ, atunci formularele revizuite de medicul specialist pot fi trimise către portalul de asigurări.

Cost estimat

Costul implementării soluției de bază ca dovadă de concept este prezentat în tabelul următor. Deoarece soluția de bază este considerată o dovadă de concept, Amazon Kendra Developer Edition a fost folosită ca opțiune cu costuri reduse, deoarece volumul de lucru nu ar fi în producție. Presupunerea noastră pentru Amazon Kendra Developer Edition a fost de 730 de ore active pe lună.

Pentru Amazon SageMaker, am presupus că clientul va folosi instanța ml.g4dn.2xlarge pentru inferență în timp real, cu un singur punct final de inferență per instanță. Puteți găsi mai multe informații despre prețurile Amazon SageMaker și tipurile de instanțe de inferență disponibile aici.

| serviciu | Resurse consumate | Cost estimat pe lună în USD |

| Amplificare AWS | 150 de minute de construcție 1 GB de date difuzate 500,000 cereri |

15.71 |

| Gateway API Amazon | 1 milion de apeluri API REST | 3.5 |

| AWS Lambdas | 1 milion de cereri Durată de 5 secunde per cerere 2 GB memorie alocată |

160.23 |

| Amazon DynamoDB | 1 de milioane de citiri 1 milion de scrieri stocare 100 GB |

26.38 |

| Amazon Sagemaker | Inferență în timp real cu ml.g4dn.2xlarge | 676.8 |

| Amazon Kendra | Developer Edition cu 730 de ore/lună 10,000 de documente scanate 5,000 de interogări/zi |

821.25 |

| . | . | Cost total: 1703.87 |

* Amazon Cognito are un nivel gratuit de 50,000 de utilizatori activi lunari care folosesc grupuri de utilizatori Cognito sau 50 de utilizatori activi lunari care folosesc furnizori de identitate SAML 2.0

Clean Up

Pentru a economisi costuri, ștergeți toate resursele pe care le-ați implementat ca parte a tutorialului. Puteți șterge toate punctele finale SageMaker pe care le-ați creat prin consola SageMaker. Rețineți că ștergerea unui index Amazon Kendra nu elimină documentele originale din spațiul de stocare.

Concluzie

În această postare, v-am arătat cum să simplificați accesul la informațiile interne prin rezumatul din mai multe depozite în timp real. După recentele dezvoltări ale LLM-urilor disponibile comercial, posibilitățile AI generative au devenit mai evidente. În această postare, am prezentat modalități de a folosi serviciile AWS pentru a crea un chatbot fără server care utilizează AI generativă pentru a răspunde la întrebări. Această abordare încorporează un strat de autentificare și detectarea PII de la Amazon Comprehend pentru a filtra orice informații sensibile furnizate în interogarea utilizatorului. Fie că este vorba de persoane din domeniul sănătății care înțeleg nuanțele pentru depunerea cererilor de asigurare sau HR care înțeleg reglementările specifice la nivel de companie, există mai multe industrii și sectoare verticale care pot beneficia de această abordare. Un model de bază Amazon SageMaker JumpStart este motorul din spatele chatbot-ului, în timp ce o abordare de umplere a contextului folosind tehnica RAG este utilizată pentru a se asigura că răspunsurile fac referire mai precisă la documentele interne.

Pentru a afla mai multe despre lucrul cu IA generativă pe AWS, consultați Anunțăm noi instrumente pentru construirea cu IA generativă pe AWS. Pentru îndrumări mai aprofundate despre utilizarea tehnicii RAG cu serviciile AWS, consultați Creați rapid aplicații AI generative de înaltă precizie pe datele întreprinderii folosind Amazon Kendra, LangChain și modele de limbaj mari. Deoarece abordarea din acest blog este agnostică LLM, orice LLM poate fi folosit pentru deducere. În următoarea noastră postare, vom schița modalități de implementare a acestei soluții folosind Amazon Bedrock și Amazon Titan LLM.

Despre Autori

Abhishek Maligehalli Shivalingaiah este arhitect senior de soluții de servicii AI la AWS. Este pasionat de construirea de aplicații folosind Generative AI, Amazon Kendra și NLP. Are aproximativ 10 ani de experiență în construirea de soluții de date și inteligență artificială pentru a crea valoare pentru clienți și întreprinderi. El a construit chiar și un chatbot (personal) pentru distracție, pentru a răspunde la întrebări despre cariera și călătoria sa profesională. În afara muncii, îi place să facă portrete ale familiei și prietenilor și îi place să creeze opere de artă.

Abhishek Maligehalli Shivalingaiah este arhitect senior de soluții de servicii AI la AWS. Este pasionat de construirea de aplicații folosind Generative AI, Amazon Kendra și NLP. Are aproximativ 10 ani de experiență în construirea de soluții de date și inteligență artificială pentru a crea valoare pentru clienți și întreprinderi. El a construit chiar și un chatbot (personal) pentru distracție, pentru a răspunde la întrebări despre cariera și călătoria sa profesională. În afara muncii, îi place să facă portrete ale familiei și prietenilor și îi place să creeze opere de artă.

Medha Aiyah este arhitect asociat de soluții la AWS, cu sediul în Austin, Texas. Ea a absolvit recent Universitatea din Texas din Dallas, în decembrie 2022, cu Masterul în Științe în Informatică, cu o specializare în Sisteme Inteligente, concentrându-se pe AI/ML. Este interesată să afle mai multe despre AI/ML și despre utilizarea serviciilor AWS pentru a descoperi soluții de care pot beneficia clienții.

Medha Aiyah este arhitect asociat de soluții la AWS, cu sediul în Austin, Texas. Ea a absolvit recent Universitatea din Texas din Dallas, în decembrie 2022, cu Masterul în Științe în Informatică, cu o specializare în Sisteme Inteligente, concentrându-se pe AI/ML. Este interesată să afle mai multe despre AI/ML și despre utilizarea serviciilor AWS pentru a descoperi soluții de care pot beneficia clienții.

Hugo Tse este arhitect asociat de soluții la AWS cu sediul în Seattle, Washington. El deține o diplomă de master în Tehnologia Informației de la Arizona State University și o diplomă de licență în economie de la Universitatea din Chicago. Este membru al Asociației de Audit și Control al Sistemelor Informaționale (ISACA) și al Consorțiului Internațional de Certificare a Securității Sistemelor Informaționale (ISC)2. Îi face plăcere să ajute clienții să beneficieze de tehnologie.

Hugo Tse este arhitect asociat de soluții la AWS cu sediul în Seattle, Washington. El deține o diplomă de master în Tehnologia Informației de la Arizona State University și o diplomă de licență în economie de la Universitatea din Chicago. Este membru al Asociației de Audit și Control al Sistemelor Informaționale (ISACA) și al Consorțiului Internațional de Certificare a Securității Sistemelor Informaționale (ISC)2. Îi face plăcere să ajute clienții să beneficieze de tehnologie.

Ayman Ishimwe este arhitect asociat de soluții la AWS cu sediul în Seattle, Washington. El deține o diplomă de master în Inginerie software și IT de la Universitatea Oakland. Are o experiență anterioară în dezvoltarea de software, în special în construirea de microservicii pentru aplicații web distribuite. Este pasionat de a ajuta clienții să construiască soluții robuste și scalabile pe serviciile cloud AWS, urmând cele mai bune practici.

Ayman Ishimwe este arhitect asociat de soluții la AWS cu sediul în Seattle, Washington. El deține o diplomă de master în Inginerie software și IT de la Universitatea Oakland. Are o experiență anterioară în dezvoltarea de software, în special în construirea de microservicii pentru aplicații web distribuite. Este pasionat de a ajuta clienții să construiască soluții robuste și scalabile pe serviciile cloud AWS, urmând cele mai bune practici.

Shervin Suresh este arhitect asociat de soluții la AWS cu sediul în Austin, Texas. A absolvit un master în inginerie software cu o concentrare în cloud computing și virtualizare și o licență în inginerie informatică de la San Jose State University. Este pasionat de utilizarea tehnologiei pentru a ajuta la îmbunătățirea vieții oamenilor din toate mediile.

Shervin Suresh este arhitect asociat de soluții la AWS cu sediul în Austin, Texas. A absolvit un master în inginerie software cu o concentrare în cloud computing și virtualizare și o licență în inginerie informatică de la San Jose State University. Este pasionat de utilizarea tehnologiei pentru a ajuta la îmbunătățirea vieții oamenilor din toate mediile.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. Automobile/VE-uri, carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- ChartPrime. Crește-ți jocul de tranzacționare cu ChartPrime. Accesați Aici.

- BlockOffsets. Modernizarea proprietății de compensare a mediului. Accesați Aici.

- Sursa: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :are

- :este

- :nu

- :Unde

- $UP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- Capabil

- Despre Noi

- Accept

- acces

- accesarea

- Conturi

- precis

- precis

- acțiuni

- activ

- adăuga

- În plus,

- adrese

- adresare

- administratori

- Adoptarea

- consilieri

- După

- Agent

- agenţi

- agregat

- AI

- Servicii AI

- AI / ML

- TOATE

- permite

- de-a lungul

- de asemenea

- alternativă

- Amazon

- Gateway API Amazon

- Amazon Cognito

- Amazon Comprehend

- Amazon Kendra

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- sumă

- Sume

- an

- analiști

- analize

- și

- răspunde

- răspunsuri

- Orice

- api

- aparent

- aplicație

- aplicatii

- programare

- abordare

- aproba

- arhitectură

- SUNT

- apărea

- Arizona

- în jurul

- articol

- artificial

- inteligență artificială

- Inteligența artificială (AI)

- opere de arta

- AS

- cere

- aspecte

- evalua

- ajuta

- Asistență

- Avocat Colaborator

- asociate

- Asociație

- presupunere

- At

- de audit

- augmented

- Austin

- autentificata

- Autentificare

- autorizare

- automatizarea

- în mod automat

- disponibilitate

- disponibil

- AWS

- AWS Lambdas

- înapoi

- fundaluri

- de bază

- bazat

- BE

- Urs

- deoarece

- deveni

- devine

- fost

- înainte

- folosul

- în spatele

- beneficia

- Beneficiile

- CEL MAI BUN

- Cele mai bune practici

- Mai bine

- Blog

- carte

- Bot

- atât

- roboţii

- De jos

- marca

- buget

- construi

- Clădire

- construit

- afaceri

- întreprinderi

- dar

- by

- apel

- CAN

- capacități

- Carieră

- cu grijă

- caz

- cazuri

- Categorii

- cauzată

- Centru

- centralizat

- sigur

- Certificare

- lanţ

- provocări

- Schimbare

- încărcat

- chatbot

- control

- Verificări

- Chicago

- creanțe

- clar

- clinic

- studii clinice

- Cloud

- cloud computing

- servicii de tip cloud

- colecta

- colectare

- comercial

- Comun

- Comunicare

- Companii

- companie

- Compania

- competitiv

- Terminat

- completarea

- complex

- complexitate

- se conforma

- înţelege

- calculator

- Inginerie calculator

- Informatică

- tehnica de calcul

- concentrare

- concept

- concis

- efectuat

- confluenţă

- Conectați

- Connects

- considerare

- Considerații

- luate în considerare

- consistent

- Constând

- Consoleze

- consorţiu

- consuma

- consum

- contactați-ne

- centru de contact

- conține

- conţinut

- context

- continuu

- contribuie

- Control

- controlul

- comoditate

- Conversație

- de conversaţie

- conversații

- Istoria

- corecta

- A costat

- Cheltuieli

- tractor pe şenile

- crea

- A crea valoare

- a creat

- Crearea

- credit

- Criteriile de

- critic

- CRM

- crucial

- curator

- Curent

- În prezent

- client

- Angajarea cu clienții

- experienta clientului

- Serviciu clienți

- Relații Clienți

- clienţii care

- zilnic

- Dallas

- de date

- puncte de date

- seturi de date

- Baza de date

- Data

- decembrie

- decide

- decizie

- Luarea deciziilor

- Deciziile

- Grad

- livrate

- În funcție

- dislocate

- Implementarea

- descrie

- Amenajări

- În ciuda

- detalii

- detectat

- Detectare

- Dezvoltator

- Dezvoltare

- evoluții

- diferit

- dificil

- descoperi

- distribuite

- documentaţie

- documente

- face

- Nu

- conduce

- durată

- e

- mai ușor

- cu ușurință

- Economie

- ecosistem

- ediţie

- eficiență

- efort

- oricare

- eligibilitate

- e-mailuri

- Angajat

- de angajați

- permite

- încurajează

- Punct final

- energie

- angajament

- Motor

- Inginerie

- îmbogățitor

- asigura

- asigură

- asigurare

- Afacere

- Companii

- entități

- Erori

- Escaladarea

- estima

- etc

- Chiar

- exemplu

- a executa

- existent

- scump

- experienţă

- Explica

- explică

- extracţie

- extracte

- Față

- familie

- Caracteristică

- fed-

- mai puține

- Figura

- Fișier

- umple

- umplut

- umplere

- filtru

- financiar

- date financiare

- istoric financiar

- institutie financiara

- finanțare

- Găsi

- descoperire

- First

- Flexibilitate

- debit

- concentrându-se

- următor

- Pentru

- formă

- formulare

- forumuri

- găsit

- Fundație

- cadre

- Gratuit

- Prietenii lui

- din

- distracţie

- funcţie

- funcții

- mai mult

- Câştig

- poartă

- genera

- generaţie

- generativ

- AI generativă

- obține

- dat

- oferă

- Oferirea

- Guvern

- foarte mult

- Crește

- În creştere

- creste

- îndrumare

- orientări

- manipula

- Mânere

- Manipularea

- Avea

- având în

- he

- Sănătate

- informație despre sănătate

- de asistență medicală

- ajutor

- ajutor

- ajută

- ei

- Înalt

- extrem de

- lui

- istorie

- deține

- găzduit

- Gazdele

- ORE

- Cum

- Cum Pentru a

- Totuși

- hr

- HTML

- HTTPS

- uman

- i

- identificator

- identificatorii

- identifică

- identifica

- identificarea

- Identitate

- if

- ilustrează

- punerea în aplicare a

- Punere în aplicare a

- implicații

- îmbunătăţi

- îmbunătăţeşte

- îmbunătățirea

- in

- în profunzime

- inexact

- include

- include

- Inclusiv

- Venituri

- impozit pe venit

- Crește

- Creșteri

- index

- indexate

- indexurile

- persoane fizice

- industrii

- Informa

- informații

- Sisteme de informare

- tehnologia informației

- informat

- moștenire

- intrare

- instanță

- clipă

- in schimb

- Instituţie

- instituții

- asigurare

- integrate

- integreaza

- integrare

- Inteligență

- Inteligent

- scop

- interacţiona

- interactiv

- interesat

- interfaţă

- intern

- Internațional

- în

- investiţie

- problema

- IT

- articole

- călătorie

- jpg

- A pastra

- cunoştinţe

- cunoscut

- limbă

- mare

- strat

- conduce

- AFLAȚI

- învăţare

- mai puțin

- Nivel

- efectului de pârghie

- Bibliotecă

- limitare

- limitări

- Linie

- Locuiește

- LLM

- împrumut

- Credite

- log

- logic

- Lung

- perioadă lungă de timp

- mai lung

- Uite

- Lot

- iubeste

- low-cost

- LOWER

- loial

- Loialitate

- maşină

- masina de învățare

- făcut

- menține

- face

- FACE

- Efectuarea

- administra

- administrare

- manieră

- manual

- manual

- multe

- Piață

- de cercetare de piață

- studii de masterat

- Mai..

- mijloace

- medical

- membru

- Memorie

- microservices

- Microsoft

- milion

- milioane

- minte

- ML

- model

- Modele

- Module

- Lună

- lunar

- mai mult

- cele mai multe

- multiplu

- nativ

- necesar

- Nevoie

- necesar

- nevoilor

- Nou

- următor

- nlp

- notificare

- numere

- Oakland

- oauth

- of

- promoții

- de multe ori

- Ulei

- on

- La imbarcare

- dată

- ONE

- în curs de desfășurare

- afară

- deschide

- funcionar

- de operare

- operațional

- Oportunitate

- optimizare

- Opțiune

- Opţiuni

- or

- comandă

- organizații

- original

- Altele

- al nostru

- afară

- schiță

- exterior

- peste

- paradigmă

- parte

- piese

- Trecut

- pasionat

- pacient

- Plătește

- oameni

- pentru

- performanță

- permisiuni

- personal

- date personale

- Personal

- Farmaceutic

- Stâlp

- plan

- Plato

- Informații despre date Platon

- PlatoData

- "vă rog"

- Punct

- puncte

- Politicile

- piscine

- Portal

- portrete

- posibilităţile de

- posibilitate

- Post

- alimentat

- practicile

- prezenta

- împiedica

- precedent

- în prealabil

- de stabilire a prețurilor

- model de stabilire a prețurilor

- anterior

- prioritate

- intimitate

- probleme

- Proceduri

- continua

- proces

- Procesat

- procese

- prelucrare

- producere

- productivitate

- Produse

- profesional

- profesioniști

- proprietate

- furniza

- prevăzut

- furnizori

- furnizarea

- publicat

- cumparate

- Q & A

- califica

- de calificare

- interogări

- întrebare

- Întrebări

- Rapid

- repede

- gamă

- rată

- Citeste

- Citind

- în timp real

- recent

- recent

- reduce

- reduce

- trimite

- corelarea

- cu privire la

- regulat

- regulament

- relaţie

- relevanţa

- se bazează

- rămășițe

- minte

- scoate

- solicita

- cereri de

- necesita

- necesar

- Cerinţe

- cercetare

- cercetători

- Rezoluţie

- rezolvarea

- Resurse

- răspuns

- răspunsuri

- responsabilitate

- REST

- rezultat

- revenind

- revizuite

- dreapta

- Riscurile

- robust

- Traseul

- funcţionare

- s

- sagemaker

- de vânzări

- San

- San Jose

- satisfacție

- Economisiți

- scalabil

- Scară

- scenariu

- Ştiinţă

- scor

- script-uri

- Caută

- căutare

- Seattle

- Al doilea

- secunde

- Secțiune

- sigur

- în siguranță,

- securitate

- De vânzare

- trimite

- senior

- sensibil

- trimis

- serverless

- servește

- serviciu

- Servicii

- set

- Seturi

- setări

- câteva

- ea

- schimbare

- deficiențe

- să

- a prezentat

- a arătat

- indicat

- silozuri

- asemănător

- simplu

- simplifica

- întrucât

- singur

- dimensionat

- mai mici

- So

- Social

- Software

- de dezvoltare de software

- Inginerie software

- soluţie

- soluţii

- unele

- Sursă

- Surse

- specializata

- specific

- specific

- petrece

- Cheltuire

- standard

- Stat

- Stare

- şedere

- Pas

- paşi

- Încă

- depozitare

- stoca

- stocate

- stocarea

- stres

- umplutură

- substanțial

- astfel de

- sugera

- rezuma

- a sustine

- sistem

- sisteme

- tabel

- ia

- sarcini

- impozit

- echipă

- echipe

- Tehnologia

- termeni

- Texas

- a) Sport and Nutrition Awareness Day in Manasia Around XNUMX people from the rural commune Manasia have participated in a sports and healthy nutrition oriented activity in one of the community’s sports ready yards. This activity was meant to gather, mainly, middle-aged people from a Romanian rural community and teach them about the benefits that sports have on both their mental and physical health and on how sporting activities can be used to bring people from a community closer together. Three trainers were made available for this event, so that the participants would get the best possible experience physically and so that they could have the best access possible to correct information and good sports/nutrition practices. b) Sports Awareness Day in Poiana Țapului A group of young participants have taken part in sporting activities meant to teach them about sporting conduct, fairplay, and safe physical activities. The day culminated with a football match.

- textual

- acea

- informațiile

- lor

- se

- apoi

- Acolo.

- Acestea

- ei

- terț

- acest

- Prin

- bilet

- Bilete de avion

- Nivelul

- timp

- consumă timp

- oportun

- ori

- timestamp-ul

- gigant

- la

- astăzi

- indicativele

- instrument

- Unelte

- Trasabilitatea

- tradiţional

- dresat

- Pregătire

- transformator

- Transparență

- tratament

- proces

- studii

- tutorial

- Tipuri

- incapabil

- înţelege

- înţelegere

- unic

- Universități

- universitate

- Universitatea din Chicago

- up-to-data

- actualizat

- actualizarea

- utilizare

- carcasa de utilizare

- utilizat

- Utilizator

- utilizatorii

- utilizări

- folosind

- folosi

- utilizate

- Utilizand

- valoare

- diverse

- Verificare

- verifica

- verticalele

- de

- Video

- Video

- Voce

- aștepta

- Aşteptare

- a fost

- Washington

- modalități de

- we

- web

- aplicatie web

- aplicații web

- servicii web

- BINE

- au fost

- Ce

- cand

- dacă

- care

- în timp ce

- OMS

- larg

- Gamă largă

- cu

- în

- Apartamente

- flux de lucru

- de lucru

- ar

- scris

- ani

- Tu

- Ta

- zephyrnet