Большие языковые модели (LLM) с миллиардами параметров в настоящее время находятся на переднем крае обработки естественного языка (NLP). Эти модели потрясают мир своими невероятными способностями генерировать текст, анализировать настроения, переводить языки и многое другое. Имея доступ к огромным объемам данных, LLM могут революционизировать то, как мы взаимодействуем с языком. Хотя LLM способны выполнять различные задачи НЛП, они считаются универсалами, а не специалистами. Чтобы обучить LLM, чтобы он стал экспертом в определенной области, обычно требуется тонкая настройка.

Одной из основных проблем при обучении и развертывании LLM с миллиардами параметров является их размер, который может затруднить их размещение в отдельных графических процессорах, которые обычно используются для глубокого обучения. Огромный масштаб этих моделей требует высокопроизводительных вычислительных ресурсов, таких как специализированные графические процессоры с большим объемом памяти. Кроме того, размер этих моделей может сделать их вычислительно затратными, что может значительно увеличить время обучения и вывода.

В этом посте мы покажем, как мы можем использовать Amazon SageMaker JumpStart чтобы легко настроить модель генерации текста на большом языке в наборе данных, специфичном для предметной области, так же, как вы обучаете и развертываете любую модель на Создатель мудреца Амазонки. В частности, мы покажем, как можно точно настроить языковую модель GPT-J 6B для создания финансовых текстов, используя как JumpStart SDK, так и Студия Amazon SageMaker Пользовательский интерфейс в общедоступном наборе данных документов SEC.

JumpStart помогает быстро и легко начать работу с машинным обучением (ML) и предоставляет набор решений для наиболее распространенных вариантов использования, которые можно легко обучить и развернуть всего за несколько шагов. Все шаги в этой демонстрации доступны в прилагаемой записной книжке. Точная настройка модели генерации текста GPT-J 6B для набора данных, специфичного для предметной области..

Обзор решения

В следующих разделах мы представляем пошаговую демонстрацию тонкой настройки LLM для задач генерации текста с помощью пользовательского интерфейса JumpStart Studio и Python SDK. В частности, мы обсуждаем следующие темы:

- Обзор данных подачи SEC в финансовой области, на которых модель точно настроена.

- Обзор модели LLM GPT-J 6B, которую мы выбрали для тонкой настройки

- Демонстрация двух разных способов точной настройки LLM с помощью JumpStart:

- Программное использование JumpStart с SageMaker Python SDK

- Доступ к JumpStart с помощью пользовательского интерфейса Studio

- Оценка настроенной модели путем сравнения ее с предварительно обученной моделью без тонкой настройки.

Тонкая настройка относится к процессу использования предварительно обученной языковой модели и ее обучения другой, но связанной задаче с использованием конкретных данных. Этот подход также известен как трансферное обучение, который включает в себя перенос знаний, полученных от одной задачи, к другой. LLM, такие как GPT-J 6B, обучаются на больших объемах немаркированных данных и могут быть настроены на меньших наборах данных, что позволяет модели работать лучше в конкретной области.

В качестве примера того, как улучшается производительность при точной настройке модели, задайте ей следующий вопрос:

«Что способствует росту продаж в Amazon?»

Без тонкой настройки ответ будет таким:

«Amazon — крупнейший в мире интернет-магазин. Это также крупнейший в мире онлайн-рынок. Это тоже мир»

При точной настройке ответ будет таким:

«Рост продаж в Amazon обусловлен, прежде всего, увеличением числа клиентов, в том числе расширением выбора, снижением цен и повышением удобства, а также увеличением продаж других продавцов на наших веб-сайтах».

Улучшение от тонкой настройки очевидно.

Мы используем финансовый текст из документов SEC, чтобы настроить GPT-J 6B LLM для финансовых приложений. В следующих разделах мы представим данные и LLM, которые будут тонко настроены.

Набор данных для подачи в SEC

Заявки SEC имеют решающее значение для регулирования и раскрытия информации в финансовой сфере. Заявки уведомляют сообщество инвесторов об условиях бизнеса компаний и перспективах компаний на будущее. Текст в документах SEC охватывает всю гамму операций компании и условий ведения бизнеса. Из-за их потенциальной прогностической ценности эти документы являются хорошими источниками информации для инвесторов. Хотя эти документы SEC общедоступной для всех загрузка проанализированных файлов и создание чистого набора данных с добавленными функциями отнимает много времени. Мы делаем это возможным с помощью нескольких вызовов API в JumpStart. Отраслевой SDK.

С помощью SageMaker API мы скачивали годовые отчеты (10-К заявок; увидеть Как читать 10-К для получения дополнительной информации) для большого количества компаний. Мы выбрали отчеты Amazon по SEC за 2021–2022 годы в качестве обучающих данных для точной настройки модели GPT-J 6B. В частности, мы объединяем отчеты компании, подаваемые в SEC за разные годы, в один текстовый файл, за исключением раздела «Обсуждение и анализ руководства», который содержит прогнозные заявления руководства компании и используется в качестве данных проверки.

Ожидается, что после точной настройки модели генерации текста GPT-J 6B для финансовых документов SEC модель сможет генерировать проницательный текстовый вывод, связанный с финансами, и, следовательно, может использоваться для решения нескольких задач НЛП, специфичных для предметной области.

Модель GPT-J 6B с большим числом языков

ГПТ-ДЖ 6Б — это модель с 6 миллиардами параметров с открытым исходным кодом, выпущенная Eleuther AI. GPT-J 6B был обучен на большом массиве текстовых данных и способен выполнять различные задачи НЛП, такие как генерация текста, классификация текста и суммирование текста. Хотя эта модель впечатляет для ряда задач NLP без необходимости какой-либо тонкой настройки, во многих случаях вам потребуется настроить модель для определенного набора данных и задач NLP, которые вы пытаетесь решить. Варианты использования включают настраиваемых чат-ботов, генерацию идей, извлечение сущностей, классификацию и анализ настроений.

Доступ к LLM на SageMaker

Теперь, когда мы определили набор данных и модель, которую собираемся настроить, JumpStart предлагает два способа начать работу с тонкой настройкой генерации текста: SageMaker SDK и Studio.

Программное использование JumpStart с SageMaker SDK

Теперь мы рассмотрим пример того, как вы можете использовать SageMaker JumpStart SDK для доступа к LLM (GPT-J 6B) и его точной настройки в наборе данных SEC. По завершении тонкой настройки мы развернем настроенную модель и сделаем на ее основе вывод. Все шаги в этом посте доступны в прилагаемой записной книжке: Точная настройка модели генерации текста GPT-J 6B для набора данных, специфичного для предметной области..

В этом примере JumpStart использует Контейнер глубокого обучения SageMaker Hugging Face (DLC) и Глубокая скорость библиотека для тонкой настройки модели. Библиотека DeepSpeed предназначена для снижения вычислительной мощности и использования памяти, а также для обучения больших распределенных моделей с лучшим параллелизмом на существующем компьютерном оборудовании. Он поддерживает распределенное обучение с одним узлом, используя контрольные точки градиента и параллелизм моделей для обучения больших моделей на одном учебном экземпляре SageMaker с несколькими графическими процессорами. В JumpStart мы интегрируем для вас библиотеку DeepSpeed с DLC SageMaker Hugging Face и позаботимся обо всем, что находится под капотом. Вы можете легко настроить модель в наборе данных для конкретной предметной области, не настраивая ее вручную.

Точная настройка предварительно обученной модели на предметно-ориентированных данных

Чтобы настроить выбранную модель, нам нужно получить URI этой модели, а также сценарий обучения и образ контейнера, используемый для обучения. Для простоты эти три входа зависят исключительно от названия модели, версии (список доступных моделей см. Встроенные алгоритмы с предварительно обученной таблицей моделей) и тип экземпляра, на котором вы хотите тренироваться. Это демонстрируется в следующем фрагменте кода:

Мы извлекаем model_id соответствующие той же модели, которую мы хотим использовать. В этом случае мы корректируем huggingface-textgeneration1-gpt-j-6b.

Определение гиперпараметров включает в себя установку значений различных параметров, используемых в процессе обучения модели машинного обучения. Эти параметры могут повлиять на производительность и точность модели. На следующем шаге мы устанавливаем гиперпараметры, используя настройки по умолчанию и указав пользовательские значения для таких параметров, как epochs и learning_rate:

JumpStart предоставляет обширный список гиперпараметров, доступных для настройки. В следующем списке представлен обзор части ключевых гиперпараметров, используемых при тонкой настройке модели. Полный список гиперпараметров смотрите в блокноте Точная настройка модели генерации текста GPT-J 6B для набора данных, специфичного для предметной области..

- эпохи – Указывает не более, сколько эпох исходного набора данных будет повторяться.

- Learning_rate – Управляет размером шага или скоростью обучения алгоритма оптимизации во время обучения.

- eval_steps – Указывает, сколько шагов нужно выполнить перед оценкой модели на проверочном наборе во время обучения. Набор проверки — это подмножество данных, которое не используется для обучения, а вместо этого используется для проверки производительности модели на невидимых данных.

- вес_распад – Контролирует силу регуляризации во время обучения модели. Регуляризация — это метод, который помогает предотвратить чрезмерную подгонку модели к обучающим данным, что может привести к повышению производительности на невидимых данных.

- fp16 – Управляет использованием 16-битного (смешанного) точного обучения fp16 вместо 32-битного обучения.

- оценка_стратегия – Стратегия оценки, используемая во время обучения.

- градиент_накопление_шаги – Количество шагов обновления для накопления градиентов перед выполнением прохода назад/обновления.

Для получения дополнительной информации о гиперпараметрах обратитесь к официальному Документация Hugging Face Trainer.

Теперь вы можете точно настроить эту модель JumpStart для своего собственного пользовательского набора данных с помощью SageMaker SDK. Мы используем данные регистрации SEC, которые мы описали ранее. Данные обучения и проверки размещены в train_dataset_s3_path и validation_dataset_s3_path. Поддерживаемый формат данных включает CSV, JSON и TXT. Для данных CSV и JSON используются текстовые данные из столбца с именем text или первый столбец, если столбец с именем text не найден. Поскольку это делается для точной настройки генерации текста, метки истинности не требуются. Следующий код является примером SDK для точной настройки модели:

После настройки SageMaker Estimator с необходимыми гиперпараметрами мы создаем экземпляр SageMaker Estimator и вызываем метод .fit метод, чтобы начать тонкую настройку нашей модели, передав ей Простой сервис хранения Amazon (Amazon S3) URI для наших обучающих данных. Как видите, entry_point предоставленный сценарий называется transfer_learning.py (то же самое для других задач и моделей), а канал входных данных перешел к .fit должны быть названы train и validation.

JumpStart также поддерживает оптимизацию гиперпараметров с помощью SageMaker автоматическая настройка модели. Подробности смотрите в примере ноутбук.

Разверните доработанную модель

Когда обучение завершено, вы можете развернуть свою точно настроенную модель. Для этого все, что нам нужно получить, — это URI сценария вывода (код, который определяет, как модель используется для вывода после развертывания) и URI образа контейнера вывода, который включает соответствующий сервер модели для размещения выбранной нами модели. См. следующий код:

Через несколько минут наша модель развернута, и мы можем получать от нее прогнозы в режиме реального времени!

Доступ к JumpStart через пользовательский интерфейс Studio

Еще один способ тонкой настройки и развертывания моделей JumpStart — через пользовательский интерфейс Studio. Этот пользовательский интерфейс предоставляет решение с минимальным кодом или без кода для точной настройки LLM.

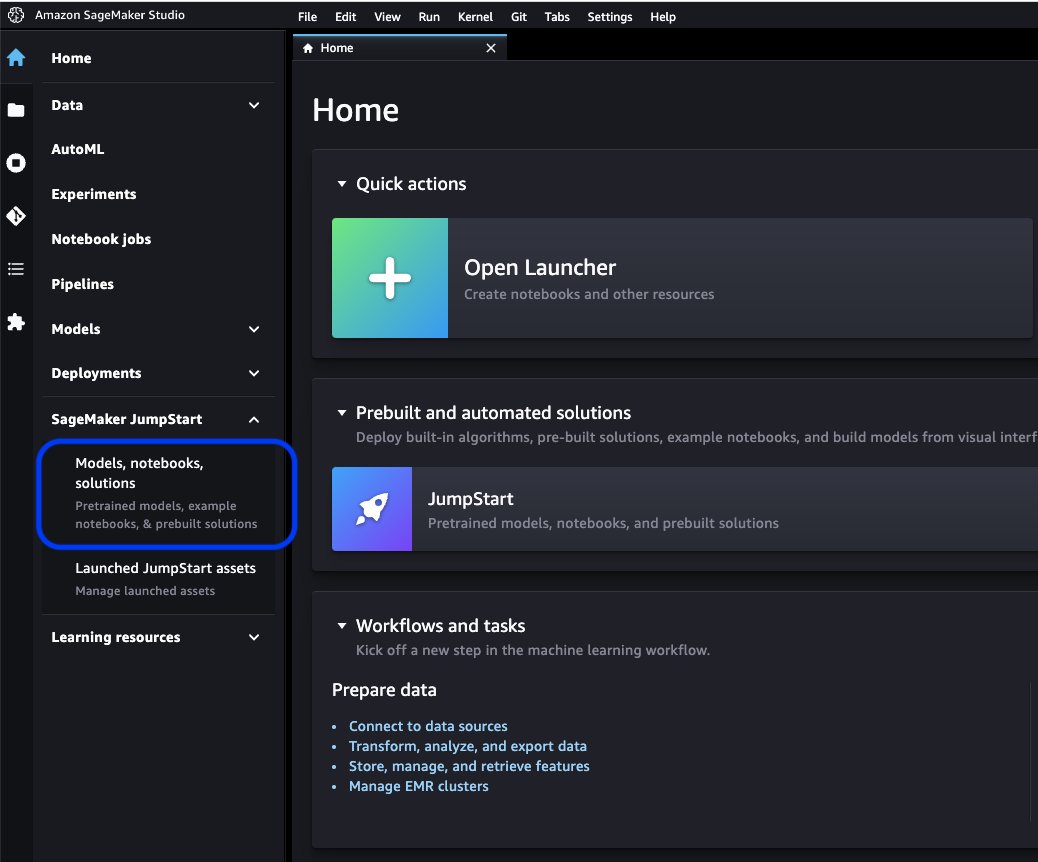

На консоли Studio выберите Модели, ноутбуки, решения под SageMaker JumpStart в навигационной панели.

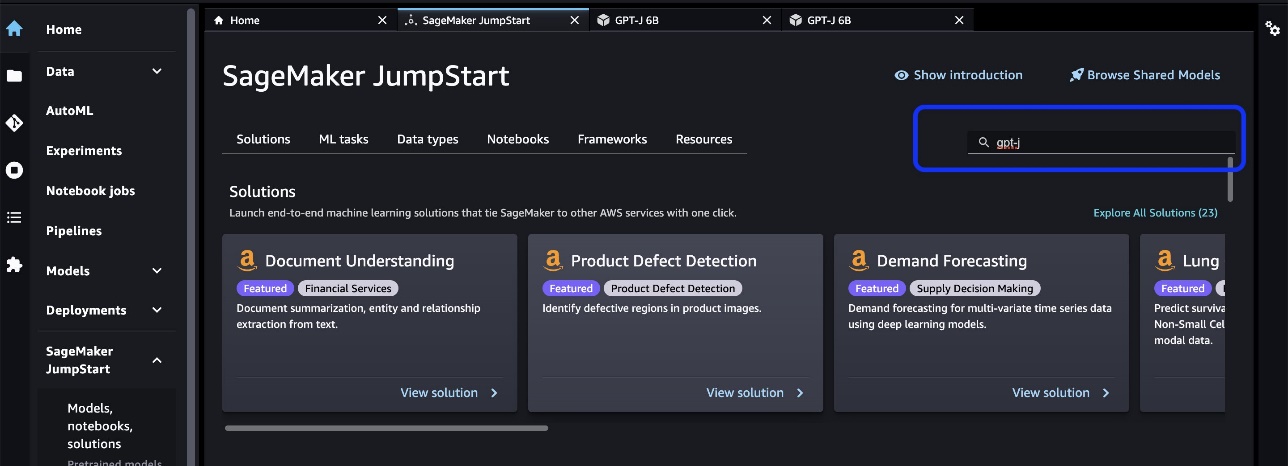

В строке поиска найдите модель, которую хотите настроить и развернуть.

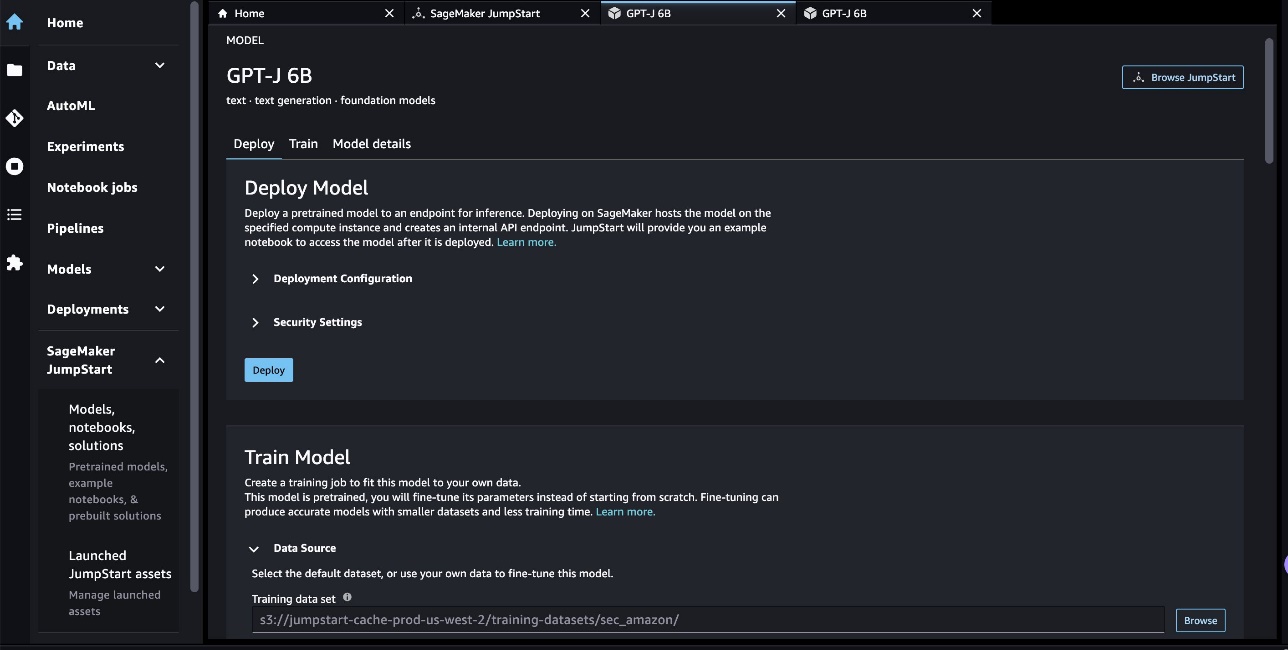

В нашем случае мы выбрали карту модели GPT-J 6B. Здесь мы можем напрямую настроить или развернуть LLM.

Оценка модели

При оценке LLM мы можем использовать недоумение (PPL). PPL — это обычная мера того, насколько хорошо языковая модель способна предсказать следующее слово в последовательности. Проще говоря, это способ измерить, насколько хорошо модель может понимать и генерировать человекоподобный язык.

Более низкий показатель недоумения означает, что модель лучше предсказывает следующее слово. С практической точки зрения, мы можем использовать недоумение для сравнения различных языковых моделей и определения того, какая из них лучше справляется с данной задачей. Мы также можем использовать его для отслеживания производительности одной модели с течением времени. Для получения более подробной информации см. Недоумение моделей фиксированной длины.

Мы оцениваем производительность модели путем сравнения ее производительности до и после тонкой настройки. PPL выдается в учебном задании Amazon CloudWatch журналы. Кроме того, мы смотрим на выходные данные, сгенерированные моделью в ответ на определенные тестовые запросы.

| Метрика оценки данных проверки | Перед тонкой настройкой | После тонкой настройки |

| Недоумение (PPL) | 8.147 | 1.437 |

Повышение производительности модели демонстрируют два эксперимента:

- Генерация текста - Мы показываем, что на выходе точно настроенный GPT-J генерирует текст, который имеет сходство с набором данных SEC, что указывает на то, что он научился эмулировать языковые шаблоны и соглашения области финансового регулирования.

- Безупречное обучение – Мы демонстрируем, что точно настроенный GPT-J показывает значительно лучшую производительность, чем не настроенный GPT-J, при ответах на вопросы с нулевым шансом.

Для эксперимента по генерации текста мы используем следующие параметры вывода для достижения наших результатов: max_length из 400 (количество возвращенных токенов), num_return_sequences из 1 (количество примеров текста ответа), top_k из 250 (выберите одно из 250 возможных продолжений), top_p 0.8 (выбирать только из продолжений с вероятностью не менее 80%), do_sample is True (выборка) и temperature 1 (высокая температура – большая хаотичность в ответах). Для получения более подробной информации о параметрах см. Конфигурация поколения. В следующей таблице сравнивается GPT-J с тонкой настройкой и GPT-J без тонкой настройки в задаче завершения текста.

| Пример вывода | Выход GPT-J 6B перед тонкой настройкой | Выход GPT-J 6B после тонкой настройки |

| Этот отчет формы 10-K показывает, что |

Этот отчет формы 10-K показывает, что: Чистая прибыль Компании за год, закончившийся 31 декабря 2016 г., составила 3,923,000 0.21 3,818,000 долл. США, или 0.21 долл. США на разводненную акцию, по сравнению с 31 2015 XNUMX долл. США, или XNUMX долл. США на разводненную акцию, за год, закончившийся XNUMX декабря XNUMX г. Чистая прибыль Компании за год, закончившийся 31 декабря 2016 г., составила 4,816,000 0.28 4,726,000 долл. США, или 0.27 долл. США на разводненную акцию, по сравнению с 31 2015 XNUMX долл. США, или XNUMX долл. США на разводненную акцию, за год, закончившийся XNUMX декабря XNUMX г. Чистая прибыль Компании за год, закончившийся 31 декабря 2016 г., составила 5,828,000 0.34 5,716,000 долл. США, или 0.33 долл. США на разводненную акцию, по сравнению с 31 2015 XNUMX долл. США, или XNUMX долл. США на разводненную акцию, за год, закончившийся XNUMX декабря XNUMX г. 21 августа 2009 г. Компания подала форму 10-Q за квартал, закончившийся 31 декабря 2008 г. 21 августа 2009 г. Компания подала форму 10-Q за квартал, закончившийся 30 сентября 2008 г. 21 августа 2009 г. Компания подала форму 10-Q за квартал, закончившийся 31 марта 2009 г. |

В этом отчете по форме 10-K показано, что: (1) Имя, адрес и номер телефона лица, подавшего регистрацию, следующие: Amazon.com, Inc. c/o Ernst & Young LLPСиэтл, Вашингтон Внимание: Корпоративный секретарь (2) Для Для целей статьи III Закона о ценных бумагах и биржах от 1934 г. имя и адрес лица, осуществляющего регистрацию, являются следующими: (3) Отчетный период для владельца регистрации в соответствии с Законом о биржах — с 1 января 2020 г. включительно по настоящее время. (4) Субъективная оценка владельца регистрации: что финансовая отчетность и другая финансовая информация, включенная в этот отчет, достоверно отражает во всех существенных аспектах финансовое положение, результаты операций и движение денежных средств владельца регистрации на периоды, представленные в этом отчете, и за периоды, представленные в этом отчете. (5) Руководство владельца регистрации оценка состоит в том, что финансовая отчетность и другая финансовая информация, включенная в этот отчет, достоверно отражает во всех существенных аспектах финансовое положение, результаты операций и движение денежных средств владельца регистрации на периоды, представленные в этом отчете, и за периоды, представленные в этом отчете./s/ Ernst & Young LLPСиэтл, Вашингтон, 29 января 2020 г. EX-31.1 5 amzn-20201231xex311.htm EX-31.1 ДокументПриложение 31.1СЕРТИФИКАЦИЯSI, Эндрю Р. Джасси, удостоверяю, что:1. Я просмотрел эту форму 10-K Amazon.com, Inc.;2. Насколько мне известно, этот отчет не содержит ложных заявлений о существенных фактах или не содержит существенных фактов, необходимых для того, чтобы сделать сделанные заявления, в свете обстоятельств, при которых такие заявления были сделаны, не вводящие в заблуждение в отношении периода, охватываемого настоящим отчет; |

| Мы обслуживаем потребителей через |

Мы обслуживаем потребителей через: Наш блог Вы владелец бизнеса и хотите развивать свой бизнес? Хотите создать более эффективный и результативный бизнес? Хотите узнать, как развивать свой бизнес? Если вы ответили «да» хотя бы на один из этих вопросов, то вам необходимо прочитать эту статью. Первый шаг к развитию вашего бизнеса — это понимание вашего бизнеса. Вы должны быть в состоянии ответить на следующие вопросы о вашем бизнесе: Кто ваши клиенты? Каков ваш продукт или услуга? В чем ваше уникальное торговое предложение? Какая у вас маркетинговая стратегия? Каков ваш прогноз продаж? Каков ваш прогноз продаж? Каков ваш прогноз продаж? Каков ваш прогноз продаж? Каков ваш прогноз продаж? |

Мы обслуживаем потребителей через: Amazon.com, розничного продавца физических и цифровых товаров; Amazon Web Services, предоставляющая услуги технологической инфраструктуры, позволяющие вести практически любой бизнес; Amazon Enterprise Solutions, который предоставляет компаниям индивидуальные технологии и услуги для улучшения бизнес-процессов и повышения эффективности и производительности; и Audible, издатель цифровых аудиокниг. Мы обслуживаем разработчиков и предприятия любого размера через AWS, который предлагает широкий набор глобальных предложений по вычислительным ресурсам, хранилищам, базам данных и другим услугам. Мы также производим и продаем электронные устройства. Мы разделили нашу деятельность на два основных сегмента: Североамериканский и Международный. См. пункт 8 Части II, «Финансовая отчетность и дополнительные данные — Примечание 12 — Сегментная информация». См. Пункт 7 Части II, «Обсуждение и анализ руководством финансового состояния и результатов операций — Результаты операций — Дополнительная информация». » для получения дополнительной информации о наших чистых продажах. Потребители Мы обслуживаем потребителей через наши интернет-магазины и обычные магазины и уделяем особое внимание выбору, цене и удобству. Мы разрабатываем наши магазины таким образом, чтобы мы и третьи лица могли продавать сотни миллионов уникальных товаров в десятках товарных категорий. Клиенты получают доступ к нашим предложениям через наши веб-сайты, мобильные приложения, Alexa и физически посещают наши магазины. Мы также производим и продаем Kindledevices. Мы стремимся предлагать нашим клиентам самые низкие цены за счет ежедневных предложений по ценам и доставке, а также повышать эффективность нашей работы, чтобы мы могли продолжать снижать цены для наших клиентов. Мы также предоставляем простые в использовании функции, быстрое и надежное выполнение и своевременное обслуживание клиентов. Кроме того, мы предлагаем Amazon Prime, программу членства, которая включает неограниченную бесплатную доставку более 100 миллионов товаров, доступ к неограниченному потоковому вещанию десятков тысяч фильмов и телесериалы и другие преимущества. |

| В этом году мы уделяем особое внимание |

В этом году мы уделяем особое внимание: Роль системы здравоохранения в профилактике ожирения и диабета Роль системы здравоохранения в профилактике ожирения и диабета Роль системы здравоохранения в профилактике ожирения и диабета Роль системы здравоохранения в профилактике ожирения и диабета Роль системы здравоохранения в профилактике ожирения и диабета Роль системы здравоохранения в профилактике ожирения и диабета Роль системы здравоохранения в профилактике ожирения и диабета |

В этом году мы уделяем особое внимание: -продолжению международной экспансии, включая развитие новых направлений бизнеса в существующих сегментах международного рынка, а также развитие новых сегментов международного рынка; - Расширение клиентской базы, в том числе увеличение продаж существующим клиентам и привлечение новых клиентов; - Развитие новых деловых возможностей и заключение коммерческих соглашений, в том числе посредством лицензирования и других соглашений, с другими компаниями или путем приобретения других компаний; -Разработка технологий, обеспечивающих улучшенное обслуживание клиентов и эффективное предоставление наших продуктов и услуг; - Разработка новых предложений продуктов и услуг и включение этих предложений в существующие и новые предложения продуктов и услуг; -Разработка эффективных и действенных систем поддержки нашего бизнеса; и -Другие деловые и стратегические инициативы. Мы считаем, что предложение низких цен для наших клиентов имеет основополагающее значение для нашего будущего успеха. Один из способов, которым мы предлагаем более низкие цены, — это предложения бесплатной доставки, которые приводят к чистой стоимости доставки продуктов, а также членство в Amazon Prime, которое обеспечивает бесплатную доставку миллионов товаров и доступ к фильмам и другому контенту. Мы также предлагаем другие рекламные акции, которые позволяют нам снизить себестоимость продаж. Мы разделили нашу деятельность на два основных сегмента: Североамериканский и Международный. См. Пункт 8 Части II, «Финансовые отчеты и дополнительные данные — Примечание 12 — Сегментная информация». См. Пункт 7 Части II, «Обсуждение и анализ руководством финансового состояния и результатов операций — Результаты операций — Дополнительная информация»». для получения дополнительной информации о наших чистых продажах. Потребители Мы обслуживаем потребителей через наши розничные веб-сайты и физические магазины, уделяя особое внимание выбору, цене и удобству. |

Для второго эксперимента с нулевым ответом на вопрос мы установили max_length быть другим значением (40, 200 и 40 соответственно) в зависимости от результатов, которые мы ожидаем от каждого вопроса. Параметры top_k, top_p, do_sample, temperature установлены как 250, 0.8, Falseи 0 соответственно. Мы установили температуру близкой к 0, чтобы контролировать случайность вывода, тогда как в задаче генерации текста мы установили ее близкой к 1, чтобы сделать модель более творческой. В следующей таблице сравниваются результаты. Для каждого вопроса вывод тонко настроенного GPT-J более точен, чем нетонко настроенный.

| вход | Выход GPT-J 6B перед тонкой настройкой | Выход GPT-J 6B после тонкой настройки |

| О чем говорится в пункте 7 документа 10-K SEC?: |

О чем говорится в пункте 7 документа 10-K SEC?: Пункт 7 заявки 10-K SEC заключается в следующем: «Компания не получала каких-либо существенных неблагоприятных |

Пункт 7. Обсуждение и анализ руководством финансового положения и результатов деятельности Прогнозные заявления |

| Как пандемия COVID-19 повлияла на бизнес Amazon?: |

Как пандемия COVID-19 повлияла на бизнес Amazon?: Пандемия COVID-19 по-разному повлияла на бизнес Amazon. Компания наблюдает снижение числа членов Prime, что составляет большую часть ее бизнеса. Компания также наблюдает снижение количества членов Prime. Amazon также наблюдает снижение количества заказов, размещенных на его веб-сайте. Компания также наблюдает снижение числа людей, совершающих покупки на ее веб-сайте. Amazon также наблюдает снижение числа людей, совершающих покупки на своем веб-сайте. Amazon также наблюдает снижение числа людей, совершающих покупки на своем веб-сайте. Amazon также наблюдает снижение числа людей, совершающих покупки на своем веб-сайте. Amazon также наблюдает снижение числа людей, совершающих покупки. |

Как пандемия COVID-19 повлияла на бизнес Amazon? Пандемия COVID-19 повлияла на наш бизнес несколькими способами. Во-первых, это нарушило нашу цепочку поставок и повлияло на потребительский спрос, что, в свою очередь, сказалось на наших продажах и операционных результатах. Во-вторых, это увеличило наши расходы на рекламу и маркетинг, что может оказаться неэффективным в долгосрочной перспективе. В-третьих, это увеличило наши расходы на технологическую инфраструктуру и вычислительные мощности, что может оказаться неэффективным в долгосрочной перспективе. В-четвертых, это увеличило наши расходы на выполнение и обслуживание клиентов, что может оказаться неэффективным в долгосрочной перспективе. Наконец, это увеличило наши расходы на контент, что может оказаться неэффективным в долгосрочной перспективе. См. пункт 8 Части II «Финансовая отчетность и дополнительные данные — Примечание 1 — Описание деловой и учетной политики». |

| Что способствует росту продаж на Amazon?: | Amazon — крупнейший в мире интернет-магазин. Это также крупнейший в мире онлайн-рынок. Это также мир' | Рост продаж на Amazon обусловлен, прежде всего, увеличением числа клиентов, в том числе расширением выбора, снижением цен и повышением удобства, а также увеличением продаж других продавцов на наших веб-сайтах. |

Убирать

Чтобы избежать текущих расходов, удалите конечные точки логического вывода SageMaker. Вы можете удалить конечные точки через консоль SageMaker или из ноутбука, используя следующие команды:

Заключение

JumpStart — это функция SageMaker, позволяющая быстро приступить к работе с машинным обучением. JumpStart использует предварительно обученные модели с открытым исходным кодом для решения распространенных проблем машинного обучения, таких как классификация изображений, обнаружение объектов, классификация текста, классификация пар предложений и ответы на вопросы.

В этом посте мы показали вам, как настроить и развернуть предварительно обученный LLM (GPT-J 6B) для генерации текста на основе набора данных заполнения SEC. Мы продемонстрировали, как модель трансформировалась в эксперта в области финансов, пройдя процесс тонкой настройки всего на двух годовых отчетах компании. Эта тонкая настройка позволила модели генерировать контент с пониманием финансовых тем и большей точностью. Попробуйте решение самостоятельно и сообщите нам, как оно работает, в комментариях.

Важно: этот пост предназначен только для демонстрационных целей. Это не финансовый совет, и на него нельзя полагаться как на финансовый или инвестиционный совет. В посте использовались модели, предварительно обученные на данных, полученных из базы данных SEC EDGAR. Вы несете ответственность за соблюдение условий доступа EDGAR, если используете данные SEC.

Чтобы узнать больше о JumpStart, ознакомьтесь со следующими сообщениями:

Об авторах

Доктор Синь Хуан — старший научный сотрудник Amazon SageMaker JumpStart и встроенных алгоритмов Amazon SageMaker. Он занимается разработкой масштабируемых алгоритмов машинного обучения. Его исследовательские интересы лежат в области обработки естественного языка, объяснимого глубокого обучения на табличных данных и надежного анализа непараметрической пространственно-временной кластеризации. Он опубликовал множество статей на конференциях ACL, ICDM, KDD и в Королевском статистическом обществе: серия A.

Доктор Синь Хуан — старший научный сотрудник Amazon SageMaker JumpStart и встроенных алгоритмов Amazon SageMaker. Он занимается разработкой масштабируемых алгоритмов машинного обучения. Его исследовательские интересы лежат в области обработки естественного языка, объяснимого глубокого обучения на табличных данных и надежного анализа непараметрической пространственно-временной кластеризации. Он опубликовал множество статей на конференциях ACL, ICDM, KDD и в Королевском статистическом обществе: серия A.

Марк Карп является архитектором машинного обучения в команде Amazon SageMaker Service. Он фокусируется на помощи клиентам в проектировании, развертывании и управлении рабочими нагрузками машинного обучения в любом масштабе. В свободное время он любит путешествовать и исследовать новые места.

Марк Карп является архитектором машинного обучения в команде Amazon SageMaker Service. Он фокусируется на помощи клиентам в проектировании, развертывании и управлении рабочими нагрузками машинного обучения в любом масштабе. В свободное время он любит путешествовать и исследовать новые места.

Доктор Санджив Дас является стипендиатом Amazon и профессором финансов и науки о данных Терри в Университете Санта-Клары. Он имеет ученую степень в области финансов (магистр философии и доктор философии Нью-Йоркского университета) и компьютерных наук (магистратура Калифорнийского университета в Беркли), а также степень магистра делового администрирования Индийского института менеджмента в Ахмадабаде. Прежде чем стать академиком, он работал в сфере деривативов в Азиатско-Тихоокеанском регионе в качестве вице-президента Citibank. Он работает над мультимодальным машинным обучением в области финансовых приложений.

Доктор Санджив Дас является стипендиатом Amazon и профессором финансов и науки о данных Терри в Университете Санта-Клары. Он имеет ученую степень в области финансов (магистр философии и доктор философии Нью-Йоркского университета) и компьютерных наук (магистратура Калифорнийского университета в Беркли), а также степень магистра делового администрирования Индийского института менеджмента в Ахмадабаде. Прежде чем стать академиком, он работал в сфере деривативов в Азиатско-Тихоокеанском регионе в качестве вице-президента Citibank. Он работает над мультимодальным машинным обучением в области финансовых приложений.

Арун Кумар Локанатха является старшим архитектором решений машинного обучения в команде Amazon SageMaker Service. Он помогает клиентам создавать, обучать и переносить производственные рабочие нагрузки машинного обучения в SageMaker в нужном масштабе. Он специализируется на глубоком обучении, особенно в области НЛП и CV. Вне работы он любит бегать и ходить в походы.

Арун Кумар Локанатха является старшим архитектором решений машинного обучения в команде Amazon SageMaker Service. Он помогает клиентам создавать, обучать и переносить производственные рабочие нагрузки машинного обучения в SageMaker в нужном масштабе. Он специализируется на глубоком обучении, особенно в области НЛП и CV. Вне работы он любит бегать и ходить в походы.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- Платоблокчейн. Интеллект метавселенной Web3. Расширение знаний. Доступ здесь.

- Чеканка будущего с Эдриенн Эшли. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/domain-adaptation-fine-tuning-of-foundation-models-in-amazon-sagemaker-jumpstart-on-financial-data/

- :имеет

- :является

- :нет

- $3

- $UP

- 000

- 1

- 100

- 11

- 20

- 200

- 2016

- 2020

- 28

- 7

- 8

- 9

- a

- способности

- в состоянии

- О нас

- академический

- доступ

- Бухгалтерский учет

- скапливаться

- точность

- точный

- Достигать

- приобретение

- через

- Действие (Act):

- добавленный

- Добавленные функции

- дополнение

- Дополнительно

- адрес

- Реклама

- совет

- влиять на

- После

- против

- AI

- Alexa

- алгоритм

- алгоритмы

- Все

- позволяет

- причислены

- Несмотря на то, что

- Amazon

- Создатель мудреца Амазонки

- Amazon SageMaker JumpStart

- Amazon Web Services

- Amazon.com

- Америка

- суммы

- an

- анализ

- анализировать

- и

- Эндрю

- годовой

- Другой

- ответ

- любой

- кто угодно

- API

- Приложения

- прикладной

- подхода

- соответствующий

- Программы

- МЫ

- ПЛОЩАДЬ

- гайд

- AS

- оценки;

- At

- внимание

- привлечения

- Август

- Автоматический

- доступен

- AWS

- бар

- Использование темпера с изогнутым основанием

- основанный

- BE

- , так как:

- становиться

- было

- до

- не являетесь

- верить

- Преимущества

- Беркли

- Лучшая

- большой

- миллиарды

- изоферменты печени

- широкий

- строить

- встроенный

- бизнес

- но

- by

- призывают

- под названием

- Объявления

- CAN

- Может получить

- способный

- Пропускная способность

- карта

- заботится

- случаев

- случаев

- удостоверять

- цепь

- проблемы

- Канал

- расходы

- chatbots

- проверка

- Выберите

- выбрал

- выбранный

- обстоятельства

- Citibank

- Очистить

- классификация

- Закрыть

- кластеризации

- код

- Column

- COM

- Комментарии

- Общий

- обычно

- сообщество

- Компании

- Компания

- Компании

- сравнить

- сравненный

- сравнив

- сравнение

- полный

- завершение

- Вычисление

- компьютер

- Информатика

- вычисление

- вычислительная мощность

- состояние

- Условия

- конференции

- Рассматривать

- считается

- Консоли

- строительство

- Потребители

- содержать

- Container

- содержит

- содержание

- продолжать

- контроль

- контрольная

- удобство

- Корпоративное

- соответствующий

- Цена

- покрытый

- Обложки

- Covid-19.

- COVID-19 пандемия

- Создайте

- творческий

- критической

- В настоящее время

- изготовленный на заказ

- клиент

- Служба поддержки игроков

- Клиенты

- данным

- наука о данных

- База данных

- Наборы данных

- Декабрь

- Отклонить

- глубоко

- глубокое обучение

- По умолчанию

- доставки

- обеспечивает

- Спрос

- демонстрировать

- убивают

- развертывание

- развернуть

- развертывание

- Производные

- описано

- описание

- Проект

- предназначенный

- подробнее

- обнаружение

- Определять

- определяет

- застройщиков

- развивающийся

- Развитие

- Устройства

- DID

- различный

- трудный

- Интернет

- непосредственно

- раскрытие

- обсуждать

- обсуждение

- распределенный

- распределенное обучение

- Docker

- Документация

- домен

- множество

- управляемый

- в течение

- каждый

- Ранее

- легко

- Простой в использовании

- Эффективный

- Эффективность

- затрат

- эффективный

- Электронный

- включить

- включен

- Конечная точка

- расширение

- Предприятие

- предприятий

- Весь

- организация

- эпохи

- Ernst & Young

- особенно

- установить

- оценивать

- оценки

- оценка

- повседневный

- многое

- пример

- Примеры

- Кроме

- обмена

- Упражнение

- существующий

- расширение

- ожидать

- ожидание

- дорогим

- эксперимент

- эксперту

- Исследование

- обширный

- Face

- БЫСТРО

- Особенности

- несколько

- поле

- Файл

- Подача

- в заключение

- финансы

- финансовый

- Финансовые консультации

- финансовые данные

- финансовая информация

- конец

- Во-первых,

- соответствовать

- Фокус

- фокусируется

- после

- следующим образом

- Что касается

- Для инвесторов

- Прогноз

- Передний край

- форма

- формат

- дальновидный

- найденный

- Год основания

- Четвертый

- от

- полный

- функциональность

- фундаментальный

- далее

- будущее

- порождать

- генерируется

- генерирует

- поколение

- получить

- данный

- Глобальный

- Go

- идет

- будет

- хорошо

- Графические процессоры

- градиенты

- большой

- земля

- Расти

- Рост

- Рост

- Аппаратные средства

- Есть

- he

- Медицина

- Товары для здоровья

- помощь

- помогает

- здесь

- High

- высокая производительность

- имеет

- капот

- кашель

- состоялся

- Как

- How To

- HTML

- HTTP

- HTTPS

- ОбниматьЛицо

- Сотни

- сотни миллионов

- Оптимизация гиперпараметра

- i

- идея

- идентифицированный

- изображение

- Классификация изображений

- Влияние

- влияние

- Импортировать

- впечатляющий

- улучшать

- улучшение

- in

- Инк

- включают

- включены

- включает в себя

- В том числе

- доход

- включения

- Увеличение

- расширились

- повышение

- невероятный

- Индийская кухня

- информация

- Инфраструктура

- инициативы

- вход

- пример

- вместо

- Институт

- интегрировать

- взаимодействовать

- интересы

- Мультиязычность

- в

- вводить

- инвестиций

- Investopedia

- инвестор

- Инвесторы

- IT

- пункты

- ЕГО

- работа

- JPG

- JSON

- всего

- Основные

- Знать

- знания

- известный

- Этикетки

- язык

- Языки

- большой

- крупнейших

- запуск

- УЧИТЬСЯ

- узнали

- изучение

- Библиотека

- Лицензирование

- легкий

- такое как

- Список

- LLM

- Длинное

- посмотреть

- искать

- от

- Низкий

- Низкие цены

- машина

- обучение с помощью машины

- сделанный

- основной

- сделать

- Создание

- управлять

- управление

- вручную

- многих

- Март

- рынок

- Маркетинг

- рынка

- массивный

- материала

- Май..

- означает

- проводить измерение

- членство

- Членство

- Память

- метод

- метрический

- мигрировать

- миллиона

- миллионы

- Минут

- смешанный

- ML

- Мобильный телефон

- мобильные приложения-

- модель

- Модели

- БОЛЕЕ

- самых

- Кино

- MS

- с разными

- имя

- Названный

- натуральный

- Обработка естественного языка

- Навигация

- необходимо

- Необходимость

- сеть

- Новые

- новый продукт

- New York

- следующий

- НЛП

- узел

- север

- Северная Америка

- ноутбук

- сейчас

- номер

- тучность

- объект

- Обнаружение объекта

- получать

- полученный

- of

- предлагают

- предлагающий

- Предложения

- Предложения

- on

- ONE

- постоянный

- онлайн

- онлайн торговая площадка

- интернет-магазин

- только

- с открытым исходным кодом

- операционный

- Операционный отдел

- Возможности

- оптимизация

- or

- заказ

- заказы

- Организованный

- оригинал

- Другое

- наши

- Outlook

- выходной

- внешнюю

- за

- переопределение

- обзор

- собственный

- владелец

- пандемия

- хлеб

- бумага

- параметры

- часть

- особый

- особенно

- Стороны

- pass

- Прошло

- Прохождение

- путь

- паттеранами

- Люди

- Выполнять

- производительность

- выполнения

- выполняет

- период

- периодов

- ФИЛ

- физический

- Физически

- выбирать

- Мест

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- сборах

- возможное

- После

- Блог

- потенциал

- мощностью

- практическое

- Точность

- предсказывать

- прогнозирования

- Predictions

- Predictor

- представить

- представлены

- президент

- предотвращать

- предотвращение

- предыдущий

- цена

- Цены

- цены

- в первую очередь

- Простое число

- Основной

- Предварительный

- проблемам

- процесс

- Процессы

- обработка

- Продукт

- Производство

- производительность

- Продукция

- Профессор

- FitPartner™

- Спецпредложения

- предложение.

- обеспечивать

- при условии

- приводит

- публично

- опубликованный

- издатель

- цель

- целей

- Питон

- Четверть

- вопрос

- Вопросы

- быстро

- хаотичность

- Обменный курс

- Читать

- реальные

- получила

- уменьшить

- понимается

- по

- регулярное выражение

- область

- "Регулирование"

- регуляторы

- Связанный

- выпустил

- отчету

- Отчеты

- обязательный

- требуется

- исследованиям

- Полезные ресурсы

- уважение

- ответ

- ответственный

- результат

- Итоги

- розничный

- розничный торговец

- отзывы

- революционизировать

- надежный

- Роли

- королевский

- Run

- Бег

- sagemaker

- Вывод SageMaker

- главная

- то же

- Санта-

- масштабируемые

- Шкала

- Наука

- Ученый

- Гол

- SDK

- Поиск

- SEC / КОМИССИЯ ПО ЦЕННЫМ БУМАГАМ И БИРЖАМ

- Регистрация SEC

- Во-вторых

- секретарь

- Раздел

- разделах

- Ценные бумаги

- видя

- сегментами

- выбранный

- выбор

- продаем

- Продавцы

- продажа

- старший

- предложение

- настроение

- сентябрь

- Последовательность

- Серии

- Серия A

- служить

- обслуживание

- Услуги

- набор

- установка

- настройки

- несколько

- Поделиться

- Доставка и оплата

- Шоппинг

- должен

- показывать

- показанный

- Шоу

- существенно

- просто

- одинарной

- Размер

- Размеры

- меньше

- So

- Общество

- проданный

- Решение

- Решения

- РЕШАТЬ

- Источники

- специалисты

- специализированный

- специализируется

- конкретный

- Расходы

- Начало

- и политические лидеры

- Область

- отчетность

- статистический

- Шаг

- Шаги

- диск

- магазины

- Стратегический

- Стратегия

- потоковый

- прочность

- стараться

- студия

- успех

- такие

- поставка

- цепочками поставок

- Поддержанный

- поддержки

- Поддержка

- система

- системы

- ТАБЛИЦЫ

- взять

- с

- Сложность задачи

- задачи

- команда

- Технологии

- terms

- условиями

- тестXNUMX

- Классификация текста

- чем

- который

- Ассоциация

- Местоположение

- Будущее

- их

- Их

- следовательно

- Эти

- они

- вещи

- В третьих

- третье лицо

- этой

- три

- Через

- время

- кропотливый

- раз

- в

- Лексемы

- топ

- Темы

- трек

- Train

- специалистов

- Обучение

- Передающий

- преобразован

- переведите

- Путешествие

- Правда

- ОЧЕРЕДЬ

- tv

- ui

- под

- понимать

- понимание

- созданного

- Университет

- Неограниченный

- Updates

- us

- Применение

- использование

- используемый

- через

- обычно

- использовать

- Использующий

- Проверка

- ценностное

- Наши ценности

- различный

- версия

- с помощью

- вице-президент

- фактически

- законопроект

- Вашингтон

- Путь..

- способы

- we

- Web

- веб-сервисы

- Вебсайт

- веб-сайты

- ЧТО Ж

- будь то

- , которые

- КТО

- будете

- без

- Word

- Работа

- работавший

- работает

- мире

- бы

- год

- лет

- Ты

- молодой

- ВАШЕ

- зефирнет