Сегодня мы рады объявить о доступности поддержки логического вывода и тонкой настройки Llama 2 на AWS Трениум и Вывод AWS экземпляры в Amazon SageMaker JumpStart. Использование экземпляров на базе AWS Trainium и Inferentia через SageMaker может помочь пользователям снизить затраты на тонкую настройку до 50 % и снизить затраты на развертывание в 4.7 раза, одновременно снижая задержку на каждый токен. Llama 2 — это авторегрессивная модель генеративного текстового языка, использующая оптимизированную архитектуру преобразователя. Являясь общедоступной моделью, Llama 2 предназначена для решения многих задач НЛП, таких как классификация текста, анализ настроений, языковой перевод, языковое моделирование, генерация текста и диалоговые системы. Точная настройка и развертывание LLM, таких как Llama 2, может стать дорогостоящим или сложным для обеспечения производительности в реальном времени и обеспечения хорошего качества обслуживания клиентов. Trainium и AWS Inferentia, реализованные благодаря АВС Нейрон комплект разработки программного обеспечения (SDK) предлагает высокопроизводительный и экономически эффективный вариант для обучения и вывода моделей Llama 2.

В этом посте мы демонстрируем, как развернуть и настроить Llama 2 на экземплярах Trainium и AWS Inferentia в SageMaker JumpStart.

Обзор решения

В этом блоге мы рассмотрим следующие сценарии:

- Разверните Llama 2 на экземплярах AWS Inferentia как в Студия Amazon SageMaker Пользовательский интерфейс с возможностью развертывания одним щелчком мыши и SDK SageMaker Python.

- Выполните точную настройку Llama 2 на экземплярах Trainium как в пользовательском интерфейсе SageMaker Studio, так и в SageMaker Python SDK.

- Сравните производительность точно настроенной модели Llama 2 с производительностью предварительно обученной модели, чтобы показать эффективность точной настройки.

Чтобы освоить, см. Пример блокнота GitHub.

Разверните Llama 2 на экземплярах AWS Inferentia с помощью пользовательского интерфейса SageMaker Studio и Python SDK.

В этом разделе мы покажем, как развернуть Llama 2 на экземплярах AWS Inferentia, используя пользовательский интерфейс SageMaker Studio для развертывания одним щелчком мыши и Python SDK.

Откройте для себя модель Llama 2 в пользовательском интерфейсе SageMaker Studio.

SageMaker JumpStart предоставляет доступ как к общедоступным, так и к проприетарным модели фундамента. Модели Foundation внедряются и поддерживаются сторонними и собственными поставщиками. Таким образом, они выпускаются под разными лицензиями, указанными в источнике модели. Обязательно ознакомьтесь с лицензией для любой модели фундамента, которую вы используете. Вы несете ответственность за проверку и соблюдение всех применимых условий лицензии, а также за проверку их приемлемости для вашего варианта использования перед загрузкой или использованием контента.

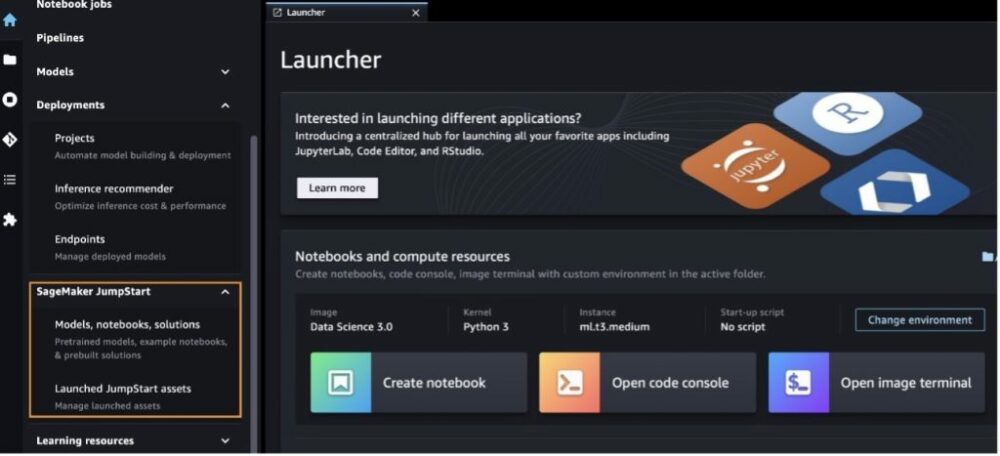

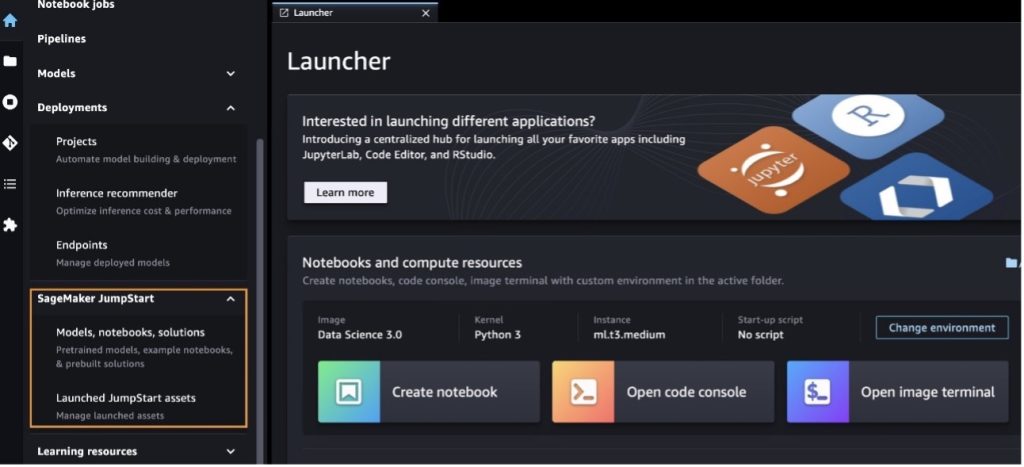

Доступ к базовым моделям Llama 2 можно получить через SageMaker JumpStart в пользовательском интерфейсе SageMaker Studio и SageMaker Python SDK. В этом разделе мы рассмотрим, как находить модели в SageMaker Studio.

SageMaker Studio — это интегрированная среда разработки (IDE), которая предоставляет единый визуальный веб-интерфейс, с помощью которого вы можете получить доступ к специально созданным инструментам для выполнения всех этапов разработки машинного обучения (ML), от подготовки данных до создания, обучения и развертывания вашего ML. модели. Более подробную информацию о том, как начать работу и настроить SageMaker Studio, см. Студия Amazon SageMaker.

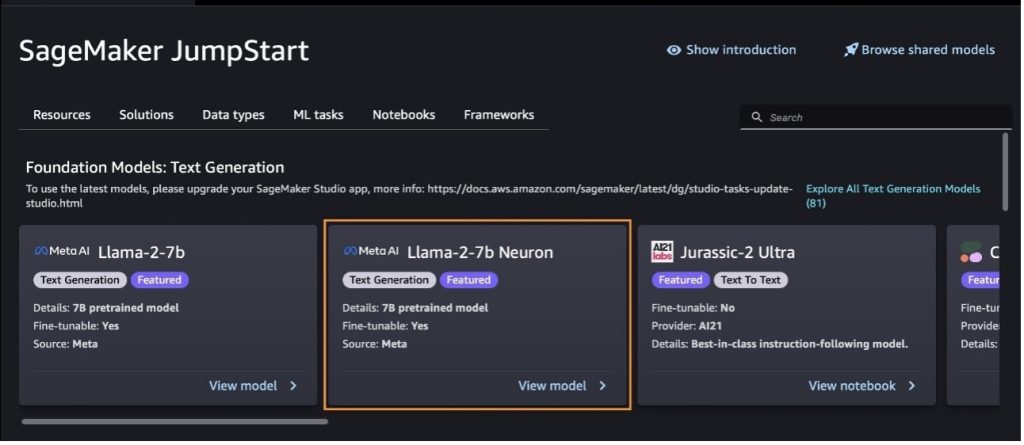

Перейдя в SageMaker Studio, вы можете получить доступ к SageMaker JumpStart, который содержит предварительно обученные модели, блокноты и готовые решения, в разделе Готовые и автоматизированные решения. Более подробную информацию о том, как получить доступ к проприетарным моделям, см. Используйте собственные модели фундамента из Amazon SageMaker JumpStart в Amazon SageMaker Studio..

На целевой странице SageMaker JumpStart вы можете искать решения, модели, ноутбуки и другие ресурсы.

Если вы не видите модели Llama 2, обновите версию SageMaker Studio, выключив и перезапустив ее. Дополнительную информацию об обновлениях версий см. Завершите работу и обновите приложения Studio Classic..

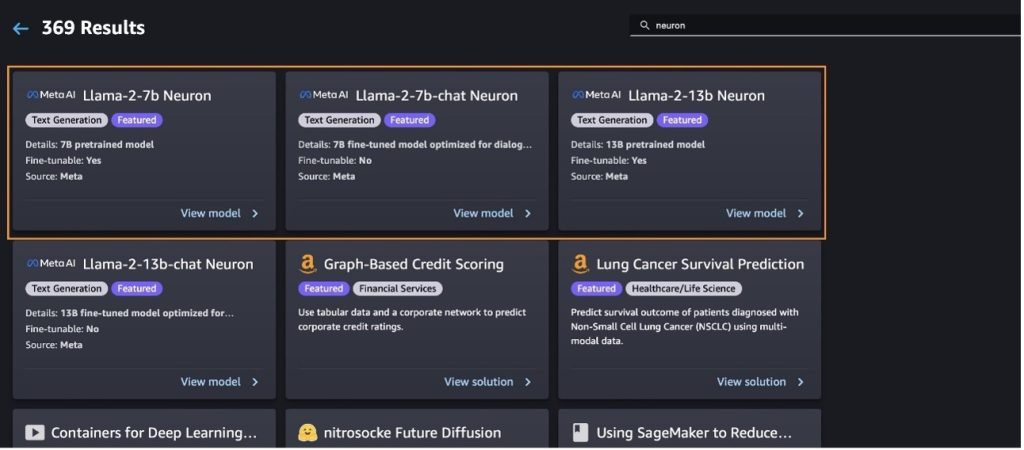

Вы также можете найти другие варианты модели, выбрав Изучите все модели генерации текста или поиск llama or neuron в поле поиска. Посмотреть модели Llama 2 Neuron вы сможете на этой странице.

Развертывание модели Llama-2-13b с помощью SageMaker Jumpstart

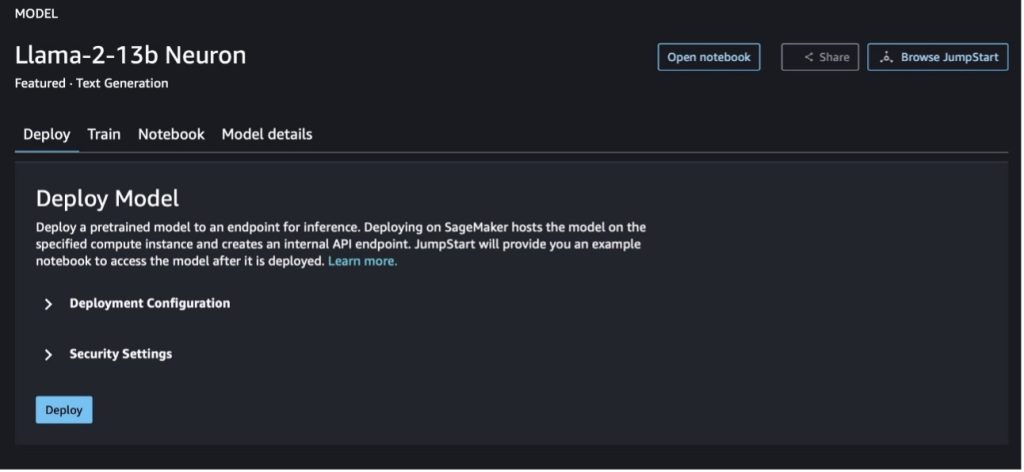

Вы можете выбрать карточку модели, чтобы просмотреть сведения о модели, такие как лицензия, данные, используемые для обучения, и способы их использования. Вы также можете найти две кнопки, Развертывание и Открыть блокнот, которые помогут вам использовать модель с использованием этого примера без кода.

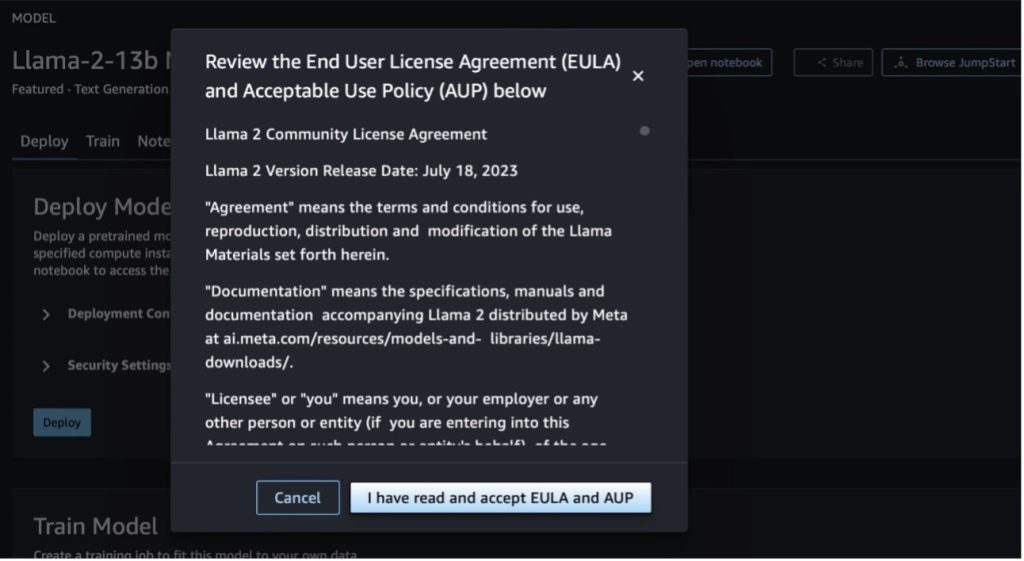

При выборе любой кнопки во всплывающем окне отобразятся Лицензионное соглашение с конечным пользователем и Политика допустимого использования (AUP), которые вам необходимо подтвердить.

После подтверждения политик вы можете развернуть конечную точку модели и использовать ее, выполнив действия, описанные в следующем разделе.

Развертывание модели Llama 2 Neuron с помощью Python SDK

Когда вы выбираете Развертывание и подтвердите условия, начнется развертывание модели. Альтернативно вы можете выполнить развертывание с помощью примера записной книжки, выбрав Открыть блокнот. Пример записной книжки содержит исчерпывающие инструкции по развертыванию модели для логического вывода и очистки ресурсов.

Чтобы развернуть или точно настроить модель на экземплярах Trainium или AWS Inferentia, сначала необходимо вызвать PyTorch Neuron (факел-нейронкс), чтобы скомпилировать модель в граф, специфичный для Neuron, который оптимизирует ее для NeuronCores Inferentia. Пользователи могут указать компилятору оптимизировать работу для достижения минимальной задержки или максимальной пропускной способности, в зависимости от целей приложения. В JumpStart мы предварительно скомпилировали графики Neuron для различных конфигураций, чтобы пользователи могли выполнять этапы компиляции, ускоряя тонкую настройку и развертывание моделей.

Обратите внимание, что предварительно скомпилированный график Neuron создается на основе конкретной версии компилятора Neuron.

Существует два способа развертывания LIama 2 на экземплярах на базе AWS Inferentia. Первый метод использует предварительно созданную конфигурацию и позволяет развернуть модель всего за две строки кода. Во втором вы имеете больший контроль над конфигурацией. Давайте начнем с первого метода, с предварительно созданной конфигурации, и в качестве примера используем предварительно обученную модель нейрона Llama 2 13B. Следующий код показывает, как развернуть Llama 13B всего двумя строками:

Чтобы выполнить вывод по этим моделям, вам необходимо указать аргумент accept_eula быть True в качестве части model.deploy() вызов. Если этот аргумент верен, вы подтверждаете, что вы прочитали и приняли лицензионное соглашение модели. Лицензионное соглашение можно найти в описании карты модели или на странице Мета-сайт.

Тип экземпляра по умолчанию для Llama 2 13B — ml.inf2.8xlarge. Вы также можете попробовать идентификаторы других поддерживаемых моделей:

meta-textgenerationneuron-llama-2-7bmeta-textgenerationneuron-llama-2-7b-f(модель чата)meta-textgenerationneuron-llama-2-13b-f(модель чата)

В качестве альтернативы, если вы хотите иметь больше контроля над конфигурациями развертывания, такими как длина контекста, степень параллелизма тензора и максимальный размер повторяющегося пакета, вы можете изменить их с помощью переменных среды, как показано в этом разделе. Базовым контейнером глубокого обучения (DLC) развертывания является Вывод больших моделей (LMI) NeuronX DLC. Переменные среды следующие:

- OPTION_N_POSITIONS – Максимальное количество входных и выходных токенов. Например, если вы скомпилируете модель с помощью

OPTION_N_POSITIONSкак 512, то вы можете использовать входной токен 128 (размер входного приглашения) с максимальным выходным токеном 384 (общее количество входных и выходных токенов должно быть 512). Для максимального выходного токена подходит любое значение ниже 384, но выходить за его пределы нельзя (например, входное значение 256 и выходное значение 512). - OPTION_TENSOR_PARALLEL_DEGREE – Количество NeuronCores для загрузки модели в экземпляры AWS Inferentia.

- OPTION_MAX_ROLLING_BATCH_SIZE – Максимальный размер пакета для одновременных запросов.

- OPTION_DTYPE – Тип даты для загрузки модели.

Компиляция графа нейрона зависит от длины контекста (OPTION_N_POSITIONS), степень тензорной параллельности (OPTION_TENSOR_PARALLEL_DEGREE), максимальный размер партии (OPTION_MAX_ROLLING_BATCH_SIZE) и тип данных (OPTION_DTYPE), чтобы загрузить модель. SageMaker JumpStart предварительно скомпилировал графики Neuron для различных конфигураций предыдущих параметров, чтобы избежать компиляции во время выполнения. Конфигурации предварительно скомпилированных графиков перечислены в следующей таблице. Если переменные среды попадают в одну из следующих категорий, компиляция графиков нейронов будет пропущена.

| ЛИама-2 7Б и ЛИама-2 7Б Чат | ||||

| Тип экземпляра | OPTION_N_POSITIONS | OPTION_MAX_ROLLING_BATCH_SIZE | OPTION_TENSOR_PARALLEL_DEGREE | OPTION_DTYPE |

| ml.inf2.xlarge | 1024 | 1 | 2 | fp16 |

| ml.inf2.8xlarge | 2048 | 1 | 2 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 4 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 4 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 24 | fp16 |

| ЛИама-2 13Б и ЛИама-2 13Б Чат | ||||

| ml.inf2.8xlarge | 1024 | 1 | 2 | fp16 |

| ml.inf2.24xlarge | 2048 | 4 | 4 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 2048 | 4 | 4 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 24 | fp16 |

Ниже приведен пример развертывания Llama 2 13B и настройки всех доступных конфигураций.

Теперь, когда мы развернули модель Llama-2-13b, мы можем выполнить с ее помощью вывод, вызвав конечную точку. В следующем фрагменте кода показано использование поддерживаемых параметров вывода для управления генерацией текста:

- максимальная длина – Модель генерирует текст до тех пор, пока длина вывода (включая длину входного контекста) не достигнет

max_length. Если указано, это должно быть положительное целое число. - max_new_tokens – Модель генерирует текст до тех пор, пока длина вывода (исключая длину входного контекста) не достигнет

max_new_tokens. Если указано, это должно быть положительное целое число. - num_beams – Это указывает количество лучей, используемых при жадном поиске. Если указано, оно должно быть целым числом, большим или равным

num_return_sequences. - no_repeat_ngram_size – Модель гарантирует, что последовательность слов

no_repeat_ngram_sizeне повторяется в выходной последовательности. Если указано, это должно быть положительное целое число больше 1. - температура – Это контролирует случайность вывода. Более высокая температура приводит к выходной последовательности со словами малой вероятности; более низкая температура приводит к выходной последовательности со словами с высокой вероятностью. Если

temperatureравен 0, это приводит к жадному декодированию. Если указано, это должно быть положительное число с плавающей запятой. - ранняя_остановка - Если

Trueгенерация текста завершается, когда все гипотезы луча достигают конца токена предложения. Если указано, оно должно быть логическим. - do_sample - Если

True, модель выбирает следующее слово в соответствии с вероятностью. Если указано, оно должно быть логическим. - топ_к – На каждом этапе генерации текста модель отбирает только

top_kскорее всего слова. Если указано, это должно быть положительное целое число. - топ_р – На каждом этапе генерации текста модель выбирает наименьший возможный набор слов с кумулятивной вероятностью

top_p. Если указано, это должно быть число с плавающей запятой от 0 до 1. - остановить – Если указано, это должен быть список строк. Генерация текста прекращается, если генерируется одна из указанных строк.

Следующий код показывает пример:

Результат:

Дополнительную информацию о параметрах полезной нагрузки см. Детальные параметры.

Вы также можете изучить реализацию параметров в ноутбук чтобы добавить дополнительную информацию о ссылке на записную книжку.

Точная настройка моделей Llama 2 на экземплярах Trainium с помощью пользовательского интерфейса SageMaker Studio и SageMaker Python SDK.

Основополагающие модели генеративного искусственного интеллекта стали основным направлением в машинном обучении и искусственном интеллекте, однако их широкое обобщение может оказаться недостаточным в конкретных областях, таких как здравоохранение или финансовые услуги, где задействованы уникальные наборы данных. Это ограничение подчеркивает необходимость точной настройки этих генеративных моделей ИИ с использованием данных, специфичных для конкретной предметной области, чтобы повысить их производительность в этих специализированных областях.

Теперь, когда мы развернули предварительно обученную версию модели Llama 2, давайте посмотрим, как мы можем точно настроить ее на данные для конкретной предметной области, чтобы повысить точность, улучшить модель с точки зрения быстрого завершения и адаптировать модель к ваш конкретный вариант использования и данные для бизнеса. Вы можете точно настроить модели с помощью пользовательского интерфейса SageMaker Studio или SageMaker Python SDK. В этом разделе мы обсудим оба метода.

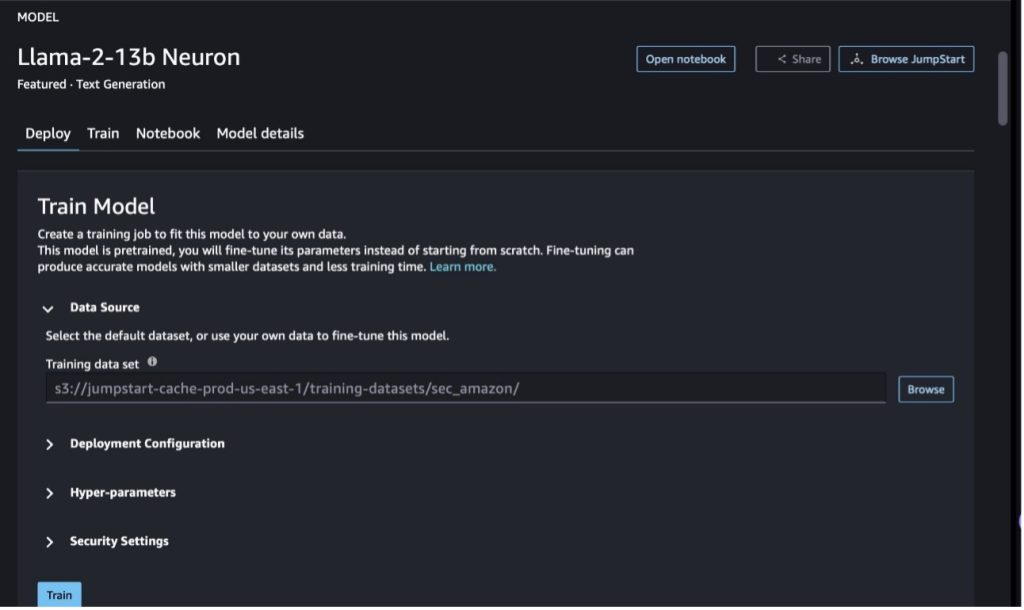

Точная настройка модели нейрона Llama-2-13b с помощью SageMaker Studio.

В SageMaker Studio перейдите к модели Llama-2-13b Neuron. На Развертывание вкладку, вы можете указать на Простой сервис хранения Amazon (Amazon S3) Корзина, содержащая наборы данных обучения и проверки для точной настройки. Кроме того, вы можете настроить конфигурацию развертывания, гиперпараметры и параметры безопасности для более точной настройки. Тогда выбирай Train чтобы начать задание обучения на экземпляре SageMaker ML.

Чтобы использовать модели Llama 2, вам необходимо принять лицензионное соглашение EULA и AUP. Он появится, когда вы, когда вы выберете Train. Выберите Я прочитал и принимаю лицензионное соглашение EULA и AUP. чтобы начать работу по тонкой настройке.

Вы можете просмотреть статус вашего задания по обучению для точно настроенной модели в консоли SageMaker, выбрав Работа по обучению в навигационной панели.

Вы можете либо точно настроить модель Llama 2 Neuron, используя этот пример без кода, либо выполнить точную настройку с помощью Python SDK, как показано в следующем разделе.

Точная настройка модели нейрона Llama-2-13b с помощью SageMaker Python SDK.

Вы можете выполнить точную настройку набора данных с помощью формата адаптации предметной области или точная настройка на основе инструкций формат. Ниже приведены инструкции по форматированию обучающих данных перед отправкой на тонкую настройку:

- вход -

trainкаталог, содержащий файл в формате строк JSON (.jsonl) или текстовый (.txt).- В файле строк JSON (.jsonl) каждая строка представляет собой отдельный объект JSON. Каждый объект JSON должен быть структурирован как пара ключ-значение, где ключ должен быть

text, а значение — это содержимое одного обучающего примера. - Количество файлов в каталоге поезда должно равняться 1.

- В файле строк JSON (.jsonl) каждая строка представляет собой отдельный объект JSON. Каждый объект JSON должен быть структурирован как пара ключ-значение, где ключ должен быть

- Результат – Обученная модель, которую можно использовать для вывода.

В этом примере мы используем подмножество Набор данных Долли в формате настройки инструкций. Набор данных Dolly содержит около 15,000 2.0 записей выполнения инструкций для различных категорий, таких как ответы на вопросы, обобщение и извлечение информации. Он доступен по лицензии Apache XNUMX. Мы используем information_extraction примеры для тонкой настройки.

- Загрузите набор данных Dolly и разделите его на

train(для тонкой настройки) иtest(для оценки):

- Используйте шаблон подсказки для предварительной обработки данных в формате инструкций для задания обучения:

- Изучите гиперпараметры и перезапишите их для своего варианта использования:

- Настройте модель и начните обучение SageMaker. Скрипты тонкой настройки основаны на нейронкс-немо-мегатрон репозиторий, который представляет собой модифицированные версии пакетов НеМо и Вершина которые были адаптированы для использования с экземплярами Neuron и EC2 Trn1. нейронкс-немо-мегатрон Репозиторий имеет 3D-параллелизм (данные, тензор и конвейер), что позволяет вам точно настраивать LLM по масштабу. Поддерживаемые экземпляры Trainium: ml.trn1.32xlarge и ml.trn1n.32xlarge.

- Наконец, разверните настроенную модель в конечной точке SageMaker:

Сравните ответы предварительно обученных и точно настроенных моделей Llama 2 Neuron.

Теперь, когда мы развернули предварительно обученную версию модели Llama-2-13b и точно настроили ее, мы можем просмотреть некоторые сравнения производительности быстрого завершения обеих моделей, как показано в следующей таблице. Мы также предлагаем пример тонкой настройки Llama 2 на наборе данных SEC в формате .txt. Подробности см. Пример блокнота GitHub.

| Товар | входные | Земная правда | Ответ от модели без точной настройки | Ответ от точно настроенной модели |

| 1 | Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, соответствующим образом дополняющий запрос.nn### Инструкция:nВыберите университеты, в которых учился Море, и год окончания обучения для каждого из них, и внесите их в маркированный список.nn### Входные данные:nМоре родился в 1953 году в Веве, Швейцария. и учился на бакалавриате в Федеральной политехнической школе Лозанны (EPFL), которую окончил в 1975 году. Затем он поступил в аспирантуру в Университете Теннесси, получив степень доктора философии. в 1980 году. Затем он поступил на факультет Университета Нью-Мексико, где оставался до 2006 года, когда перешел в EPFL. Он ушел из EPFL в декабре 2016 года. В 1996 году Море основал журнал экспериментальной алгоритмики ACM и оставался главным редактором журнала до 2003 года. В 2001 году Море основал Мастерскую по алгоритмам для биоинформатики (WABI) и остается в журнале. Руководящий комитет конференции.nnВ 2018 году Море был избран членом Международного общества вычислительной биологии за выдающийся вклад в области вычислительной биологии и биоинформатики.nn### Ответ:n | * Федеральная политехническая школа Лозанны (EPFL) (окончила в 1975 г.) * Университет Теннесси (окончила в 1980 г.) | Море учился в Федеральной политехнической школе Лозанны (EPFL) и Университете Теннесси, которые окончил в 1975 и 1980 годах соответственно.nn### Подсказка:nn- Используйте функцию `split`, чтобы разделить входные данные на список предложений.n- Используйте функцию `split`, чтобы разделить каждое предложение на список слов. n- Используйте функцию `split`, чтобы разделить | – Федеральная политехническая школа Лозанны (EPFL), 1975n – Университет Теннесси, 1980n – Университет Нью-Мексико – Федеральная политехническая школа Лозанны (EPFL), 2006nn Ниже приведена инструкция, описывающая задачу, в сочетании с входными данными, которые обеспечивает дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.n |

| 2 | Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, соответствующим образом завершающий запрос.nn### Инструкция:nИз отрывка определите атрибуты Диониса. Отобразите результаты в формате, разделенном запятыми.nn### Ввод:nДионис (Διόνυσος, Diónusos)/Вакх (Βάκχος, бакхос)nnБог вина, плодородия, вечеринок, фестивалей, безумия, хаоса, пьянства, растительности, экстаза и театр. Он дважды рожденный сын Зевса и Семелы, поскольку Зевс выхватил его из утробы матери, пришил Диониса к своему бедру и носил его, пока он не был готов родиться. В искусстве он изображается либо как пожилой бородатый бог (особенно до 430 г. до н. э.), либо женоподобный длинноволосый юноша (особенно после 430 г. до н. э.). Его атрибуты включают тирс, чашу для питья, виноградную лозу и венок из плюща. Он часто находится в компании своих тиасосов, группы слуг, включающей сатиров, менад и своего старого наставника Силена. Супругой Диониса была Ариадна. Когда-то считалось, что Дионисий был более поздним дополнением к греческому пантеону, но обнаружение табличек с линейным письмом B подтверждает его статус божества с раннего периода. Бахус было еще одним его греческим именем, вошедшим в обиход среди римлян. Среди его священных животных — дельфины, змеи, тигры и ослы.nn### Ответ:n | тирс, чаша для питья, виноградная лоза, венок плюща | Дионис (Διόνυσος, Diónusos)nnБог вина, плодородия, вечеринок, фестивалей, безумия, хаоса, пьянства, растительности, экстаза и театра. Он дважды рожденный сын Зевса и Семелы, поскольку Зевс вырвал его из чрева матери и пришил Диониса к своему бедру. | тирс, чаша для питья, виноградная лоза, корона плюща Ниже приведена инструкция, описывающая задачу, в сочетании с входными данными, обеспечивающими дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nВ чем разница между Парфянской империей и империей Аршакидов?nn### Ввод:nПарфянская империя, также известная как Империя Аршакидов, была |

| 3 | Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nПочему в столице Узбекистана проживает самая большая греческая община?nn### Ввод:nГреков в Узбекистане насчитывается около 9,000 человек. Община состоит из греков из России, насильственно депортированных из этой страны в Узбекистан в 1940-х годах, и политических беженцев из Греции. Около 30,000 11,000 греков проживали в стране до Второй мировой войны, а еще 40,000 1960 прибыли после гражданской войны в Греции и поражения Демократической армии Греции. Их число сократилось с максимума в 19 571 в XNUMX-х годах. Основная причина - эмиграция в Грецию после окончания холодной войны, когда законы разрешили возвращение всех этнических греков, которые были сосланы по политическим мотивам после гражданской войны в Греции. Самая большая греческая община в стране проживает в столице Ташкенте, куда советские власти переселили большинство греческих политических беженцев. В древние времена юг страны был частью эллинистического царства Селевкидов, но с тех пор немногие греческие общины там ассимилировались. Наиболее важной организацией, представляющей этнических греков, является Греческая культурная ассоциация Ташкента. Деятельность этой организации включает обучение греческому языку (XNUMX классов, в которых обучается XNUMX ученик, классы для взрослых) и преподавание греческих танцев и музыки.nn### Ответ:n | Большинство греческих политических беженцев в Узбекистане были переселены советскими властями в столицу Ташкент. | n“`nВ столице Узбекистана проживает самая большая греческая община, поскольку греков в Узбекистане насчитывается около 9,000 1940 человек. Община состоит из греков из России, насильственно депортированных из этой страны в Узбекистан в 30,000-х годах, и политических беженцев из Греции. До Второй мировой войны в стране проживало около 11,00 XNUMX греков и еще XNUMX XNUMX | В столице Узбекистана проживает самая большая греческая община, поскольку именно сюда советские власти переселили большинство греческих политических беженцев после депортации из Греции.nn Ниже приведена инструкция, описывающая задачу, в сочетании с вводными данными, которые предоставляют дальнейший контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nВ чем разница между Парфянской империей и империей Аршакидов?nn### Ввод:n |

Мы видим, что ответы точно настроенной модели демонстрируют значительное улучшение точности, релевантности и ясности по сравнению с ответами предварительно обученной модели. В некоторых случаях использования предварительно обученной модели для вашего варианта использования может быть недостаточно, поэтому ее точная настройка с использованием этого метода сделает решение более персонализированным для вашего набора данных.

Убирать

После того, как вы завершили задание по обучению и больше не хотите использовать существующие ресурсы, удалите ресурсы, используя следующий код:

Заключение

Развертывание и точная настройка моделей Llama 2 Neuron в SageMaker демонстрируют значительный прогресс в управлении и оптимизации крупномасштабных генеративных моделей ИИ. Эти модели, включая такие варианты, как Llama-2-7b и Llama-2-13b, используют Neuron для эффективного обучения и вывода на экземплярах на базе AWS Inferentia и Trainium, повышая их производительность и масштабируемость.

Возможность развертывания этих моделей с помощью пользовательского интерфейса SageMaker JumpStart и Python SDK обеспечивает гибкость и простоту использования. Neuron SDK с поддержкой популярных платформ машинного обучения и высокопроизводительными возможностями позволяет эффективно обрабатывать эти большие модели.

Точная настройка этих моделей на предметных данных имеет решающее значение для повышения их актуальности и точности в специализированных областях. Этот процесс, который вы можете выполнить через пользовательский интерфейс SageMaker Studio или Python SDK, позволяет настроить его в соответствии с конкретными потребностями, что приводит к повышению производительности модели с точки зрения быстрого завершения и качества ответов.

Для сравнения: предварительно обученные версии этих моделей, хотя и мощные, могут давать более общие или повторяющиеся ответы. Точная настройка адаптирует модель к конкретным контекстам, что приводит к более точным, актуальным и разнообразным ответам. Эта настройка особенно очевидна при сравнении ответов предварительно обученных и точно настроенных моделей, где последняя демонстрирует заметное улучшение качества и специфичности результатов. В заключение отметим, что развертывание и точная настройка моделей Neuron Llama 2 в SageMaker представляют собой надежную основу для управления передовыми моделями ИИ, предлагающую значительные улучшения производительности и применимости, особенно при адаптации к конкретным областям или задачам.

Начните работу сегодня, воспользовавшись образцом SageMaker. ноутбук.

Дополнительную информацию о развертывании и точной настройке предварительно обученных моделей Llama 2 на экземплярах на базе графического процессора см. Точная настройка Llama 2 для генерации текста на Amazon SageMaker JumpStart и Модели фундаментов Llama 2 от Meta теперь доступны в Amazon SageMaker JumpStart.

Авторы хотели бы выразить признательность за технический вклад Эвану Кравицу, Кристоферу Уиттену, Адаму Коздровичу, Манану Шаху, Джонатану Гинегану и Майку Джеймсу.

Об авторах

Синь Хуан — старший научный сотрудник Amazon SageMaker JumpStart и встроенных алгоритмов Amazon SageMaker. Он занимается разработкой масштабируемых алгоритмов машинного обучения. Его исследовательские интересы лежат в области обработки естественного языка, объяснимого глубокого обучения на табличных данных и надежного анализа непараметрической пространственно-временной кластеризации. Он опубликовал множество статей на конференциях ACL, ICDM, KDD и в Королевском статистическом обществе: серия A.

Синь Хуан — старший научный сотрудник Amazon SageMaker JumpStart и встроенных алгоритмов Amazon SageMaker. Он занимается разработкой масштабируемых алгоритмов машинного обучения. Его исследовательские интересы лежат в области обработки естественного языка, объяснимого глубокого обучения на табличных данных и надежного анализа непараметрической пространственно-временной кластеризации. Он опубликовал множество статей на конференциях ACL, ICDM, KDD и в Королевском статистическом обществе: серия A.

Нитин Евсевий — старший архитектор корпоративных решений в AWS, имеющий опыт разработки программного обеспечения, архитектуры предприятия и искусственного интеллекта и машинного обучения. Он глубоко увлечен исследованием возможностей генеративного искусственного интеллекта. Он сотрудничает с клиентами, помогая им создавать хорошо спроектированные приложения на платформе AWS, а также занимается решением технологических проблем и помогает им в переходе к облаку.

Нитин Евсевий — старший архитектор корпоративных решений в AWS, имеющий опыт разработки программного обеспечения, архитектуры предприятия и искусственного интеллекта и машинного обучения. Он глубоко увлечен исследованием возможностей генеративного искусственного интеллекта. Он сотрудничает с клиентами, помогая им создавать хорошо спроектированные приложения на платформе AWS, а также занимается решением технологических проблем и помогает им в переходе к облаку.

Мадхур Прашант работает в области генеративного искусственного интеллекта в AWS. Он увлечен пересечением человеческого мышления и генеративного искусственного интеллекта. Его интересы лежат в области генеративного искусственного интеллекта, в частности в создании решений, которые будут полезны и безвредны и, прежде всего, оптимальны для клиентов. Вне работы он любит заниматься йогой, ходить в походы, проводить время со своим близнецом и играть на гитаре.

Мадхур Прашант работает в области генеративного искусственного интеллекта в AWS. Он увлечен пересечением человеческого мышления и генеративного искусственного интеллекта. Его интересы лежат в области генеративного искусственного интеллекта, в частности в создании решений, которые будут полезны и безвредны и, прежде всего, оптимальны для клиентов. Вне работы он любит заниматься йогой, ходить в походы, проводить время со своим близнецом и играть на гитаре.

Деван Чоудхури является инженером-разработчиком программного обеспечения в Amazon Web Services. Он работает над алгоритмами Amazon SageMaker и предложениями JumpStart. Помимо создания инфраструктур AI/ML, он также увлечен созданием масштабируемых распределенных систем.

Деван Чоудхури является инженером-разработчиком программного обеспечения в Amazon Web Services. Он работает над алгоритмами Amazon SageMaker и предложениями JumpStart. Помимо создания инфраструктур AI/ML, он также увлечен созданием масштабируемых распределенных систем.

Хао Чжоу — научный сотрудник Amazon SageMaker. До этого он работал над разработкой методов машинного обучения для обнаружения мошенничества для Amazon Fraud Detector. Он увлечен применением методов машинного обучения, оптимизации и генеративного искусственного интеллекта для решения различных реальных проблем. Он получил степень доктора электротехники в Северо-Западном университете.

Хао Чжоу — научный сотрудник Amazon SageMaker. До этого он работал над разработкой методов машинного обучения для обнаружения мошенничества для Amazon Fraud Detector. Он увлечен применением методов машинного обучения, оптимизации и генеративного искусственного интеллекта для решения различных реальных проблем. Он получил степень доктора электротехники в Северо-Западном университете.

Цин Лан является инженером-разработчиком программного обеспечения в AWS. Он работал над несколькими сложными продуктами в Amazon, включая высокопроизводительные решения для логического вывода машинного обучения и высокопроизводительную систему ведения журналов. Команда Цин успешно запустила первую модель с миллиардом параметров в Amazon Advertising с очень низкой задержкой. Цин обладает глубокими знаниями по оптимизации инфраструктуры и ускорению глубокого обучения.

Цин Лан является инженером-разработчиком программного обеспечения в AWS. Он работал над несколькими сложными продуктами в Amazon, включая высокопроизводительные решения для логического вывода машинного обучения и высокопроизводительную систему ведения журналов. Команда Цин успешно запустила первую модель с миллиардом параметров в Amazon Advertising с очень низкой задержкой. Цин обладает глубокими знаниями по оптимизации инфраструктуры и ускорению глубокого обучения.

Доктор Ашиш Хетан — старший научный сотрудник, работающий со встроенными алгоритмами Amazon SageMaker и помогающий разрабатывать алгоритмы машинного обучения. Он получил докторскую степень в Университете Иллинойса в Урбана-Шампейн. Он является активным исследователем в области машинного обучения и статистических выводов и опубликовал множество статей на конференциях NeurIPS, ICML, ICLR, JMLR, ACL и EMNLP.

Доктор Ашиш Хетан — старший научный сотрудник, работающий со встроенными алгоритмами Amazon SageMaker и помогающий разрабатывать алгоритмы машинного обучения. Он получил докторскую степень в Университете Иллинойса в Урбана-Шампейн. Он является активным исследователем в области машинного обучения и статистических выводов и опубликовал множество статей на конференциях NeurIPS, ICML, ICLR, JMLR, ACL и EMNLP.

Доктор Ли Чжан — главный менеджер по продукту и технический специалист по встроенным алгоритмам Amazon SageMaker JumpStart и Amazon SageMaker — сервису, который помогает специалистам по данным и специалистам по машинному обучению начать работу с обучением и развертыванием своих моделей, а также использует обучение с подкреплением с помощью Amazon SageMaker. Его прошлая работа в качестве главного научного сотрудника и главного изобретателя в IBM Research была отмечена наградой «Испытание временем» на IEEE INFOCOM.

Доктор Ли Чжан — главный менеджер по продукту и технический специалист по встроенным алгоритмам Amazon SageMaker JumpStart и Amazon SageMaker — сервису, который помогает специалистам по данным и специалистам по машинному обучению начать работу с обучением и развертыванием своих моделей, а также использует обучение с подкреплением с помощью Amazon SageMaker. Его прошлая работа в качестве главного научного сотрудника и главного изобретателя в IBM Research была отмечена наградой «Испытание временем» на IEEE INFOCOM.

Камран Хан, старший менеджер по техническому развитию бизнеса AWS Inferentina/Trianium в AWS. Он имеет более чем десятилетний опыт помощи клиентам в развертывании и оптимизации рабочих нагрузок глубокого обучения и вывода с использованием AWS Inferentia и AWS Trainium.

Камран Хан, старший менеджер по техническому развитию бизнеса AWS Inferentina/Trianium в AWS. Он имеет более чем десятилетний опыт помощи клиентам в развертывании и оптимизации рабочих нагрузок глубокого обучения и вывода с использованием AWS Inferentia и AWS Trainium.

Джо Сенерчиа — старший менеджер по продукту в AWS. Он определяет и создает экземпляры Amazon EC2 для глубокого обучения, искусственного интеллекта и рабочих нагрузок высокопроизводительных вычислений.

Джо Сенерчиа — старший менеджер по продукту в AWS. Он определяет и создает экземпляры Amazon EC2 для глубокого обучения, искусственного интеллекта и рабочих нагрузок высокопроизводительных вычислений.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/fine-tune-and-deploy-llama-2-models-cost-effectively-in-amazon-sagemaker-jumpstart-with-aws-inferentia-and-aws-trainium/

- :имеет

- :является

- :нет

- :куда

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 121

- 13

- 15%

- 16

- 19

- 1996

- 2001

- 2006

- 2016

- 2018

- 25

- 30

- 36

- 3d

- 40

- 60

- 610

- 7

- 8

- 9

- a

- способность

- в состоянии

- О нас

- ускорение

- Принять

- приемлемый

- принятый

- доступ

- точность

- точный

- признавать

- ACM

- активный

- активно

- Адам

- приспосабливать

- адаптация

- Добавить

- дополнение

- взрослых

- продвинутый

- продвижение

- Реклама

- После

- ДОГОВОР

- AI

- AI модели

- AI / ML

- алгоритмы

- Все

- позволять

- разрешено

- позволяет

- причислены

- Amazon

- Amazon EC2

- Амазон детектор мошенничества

- Создатель мудреца Амазонки

- Amazon SageMaker JumpStart

- Amazon Web Services

- среди

- an

- анализ

- Древний

- и

- животные

- анонсировать

- Другой

- любой

- больше не

- апаш

- кроме

- отношение

- Применение

- Приложения

- прикладной

- Применение

- надлежащим образом

- примерно

- архитектура

- МЫ

- ПЛОЩАДЬ

- области

- аргумент

- армия

- прибывший

- Искусство

- искусственный

- искусственный интеллект

- AS

- содействие

- Объединение

- At

- Обслуживающий персонал

- Атрибуты

- Власти

- Авторы

- Автоматизированный

- свободных мест

- доступен

- избежать

- AWS

- Вывод AWS

- основанный

- BE

- Ширина

- , так как:

- становиться

- было

- до

- не являетесь

- верить

- ниже

- между

- Beyond

- Крупнейшая

- биология

- Блог

- рожденный

- изоферменты печени

- Коробка

- широкий

- строить

- Строительство

- строит

- встроенный

- бизнес

- развитие бизнеса

- но

- кнопка

- by

- призывают

- пришел

- CAN

- возможности

- столица

- карта

- проводятся

- случаев

- случаев

- категории

- Категории

- проблемы

- сложные

- изменение

- Chaos

- чат

- главный

- выбор

- Выберите

- Выбирая

- Кристофер

- Город

- гражданский

- ясность

- классов

- классический

- классификация

- чистым

- облако

- кластеризации

- код

- холодный

- сотрудничает

- комитет

- Общий

- Сообщества

- сообщество

- Компания

- сравненный

- сравнив

- сравнения

- Заполненная

- зАВЕРШАЕТ

- вычислительный

- вычисление

- заключение

- параллельный

- Проводить

- Конференция

- конференции

- Конфигурация

- подтвердить

- Консоли

- содержать

- Container

- содержит

- содержание

- контекст

- контексты

- взносы

- контроль

- контрольная

- Цена

- дорогостоящий

- Расходы

- страна

- создали

- Корона

- решающее значение

- культурный

- чашка

- клиент

- опыт работы с клиентами

- Клиенты

- настройка

- данным

- Наборы данных

- Время

- de

- десятилетие

- Декабрь

- Декодирование

- преданный

- глубоко

- глубокое обучение

- глубоко

- По умолчанию

- Определяет

- Степень

- доставить

- демократический

- демонстрировать

- убивают

- демонстрирует

- в зависимости

- зависит

- развертывание

- развернуть

- развертывание

- развертывание

- описывает

- описание

- назначенный

- предназначенный

- подробный

- подробнее

- обнаружение

- развивать

- развивающийся

- Развитие

- Диалог

- DID

- разница

- различный

- обнаружить

- открытие

- обсуждать

- Дисплей

- распределенный

- распределенные системы

- Разное

- приносит

- дело

- домен

- доменов

- Dont

- вниз

- загрузка

- каждый

- Рано

- Зарабатывание

- простота

- простота в использовании

- редактор

- Эффективный

- эффективность

- эффективный

- или

- избран

- империя

- включен

- позволяет

- позволяет

- конец

- впритык

- Конечная точка

- инженер

- Проект и

- повышать

- повышение

- достаточно

- обеспечивает

- Предприятие

- Окружающая среда

- окружающий

- равный

- Равно

- особенно

- оценивать

- оценка

- Эван

- очевидный

- пример

- Примеры

- возбужденный

- без учета

- существующий

- опыт

- опытные

- экспериментальный

- Больше

- Исследование

- добыча

- Осень

- ложный

- быстрее

- человек

- фестивали

- несколько

- Поля

- Файл

- Файлы

- Подача

- финансовый

- финансовые услуги

- Найдите

- конец

- First

- Трансформируемость

- Поплавок

- Фокус

- фокусируется

- после

- следующим образом

- Что касается

- Форс-мажор

- формат

- найденный

- Год основания

- Основана

- Рамки

- каркасы

- мошенничество

- обнаружение мошенничества

- от

- функция

- далее

- генерируется

- генерирует

- поколение

- генеративный

- Генеративный ИИ

- получить

- Go

- Бог

- хорошо

- есть

- выпускник

- график

- Графики

- большой

- Греции

- Жадный

- греческий

- группы

- руководство

- было

- Управляемость

- Руки

- счастливый

- Есть

- he

- здравоохранение

- Герой

- помощь

- полезный

- помощь

- помогает

- High

- высокая производительность

- высший

- наивысший

- основной момент

- его

- его

- имеет

- Как

- How To

- Однако

- HTML

- HTTP

- HTTPS

- человек

- i

- IBM

- определения

- идентификаторы

- IEEE

- if

- ii

- Иллинойс

- реализация

- Импортировать

- важную

- улучшать

- улучшенный

- улучшение

- улучшение

- in

- углубленный

- включают

- включает в себя

- В том числе

- Увеличение

- указывает

- информация

- извлечение информации

- Инфраструктура

- инфраструктура

- вход

- затраты

- пример

- инструкции

- интегрированный

- Интеллекта

- интересы

- Интерфейс

- Мультиязычность

- пересечение

- в

- вовлеченный

- IT

- ЕГО

- Джеймс

- работа

- Джобс

- присоединился

- Ионафан

- журнал

- путешествие

- JPG

- JSON

- всего

- Основные

- Королевство

- Комплект (SDK)

- знания

- известный

- посадка

- язык

- большой

- крупномасштабный

- Задержка

- новее

- запустили

- Законодательство

- ведущий

- изучение

- Длина

- Li

- Лицензия

- лицензии

- ложь

- ЖИЗНЬЮ

- такое как

- вероятность

- Вероятно

- ограничение

- линия

- линий

- LINK

- Список

- Включенный в список

- Лама

- загрузка

- локальным

- каротаж

- Длинное

- посмотреть

- любит

- Низкий

- ниже

- Снижение

- низший

- машина

- обучение с помощью машины

- сделанный

- Главная

- сделать

- Создание

- менеджер

- управления

- Манан Шах

- многих

- мастер

- максимальный

- Май..

- смысл

- Встречайте

- член

- Мета

- метод

- методы

- Мексика

- может быть

- микрофон

- против

- ML

- модель

- моделирование

- Модели

- модифицировало

- изменять

- БОЛЕЕ

- самых

- переехал

- Музыка

- должен

- имя

- натуральный

- Обработка естественного языка

- Откройте

- Навигация

- Необходимость

- потребности

- Новые

- следующий

- НЛП

- ноутбук

- сейчас

- номер

- номера

- объект

- целей

- of

- предлагают

- предлагающий

- Предложения

- Предложения

- .

- Старый

- старший

- on

- консолидировать

- ONE

- только

- оптимальный

- оптимизация

- Оптимизировать

- оптимизированный

- оптимизирующий

- Опция

- or

- организация

- Другое

- выходной

- внешнюю

- выдающийся

- за

- собственный

- пакеты

- страница

- пара

- в паре

- хлеб

- бумага & картон

- бумага

- Параллельные

- параметры

- часть

- особенно

- Стороны

- прохождение

- страстный

- мимо

- для

- Выполнять

- производительность

- период

- Персонализированные

- кандидат наук

- трубопровод

- Платформа

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- игры

- пожалуйста

- Точка

- сборах

- политика

- политический

- сообщения

- Популярное

- положительный

- возможности,

- возможное

- После

- мощный

- предшествующий

- Точность

- подготовка

- первичный

- Основной

- проблемам

- процесс

- обработка

- Продукт

- Менеджер по продукции

- Продукция

- ( изучите наши патенты),

- обеспечивать

- поставщики

- приводит

- публично

- опубликованный

- положил

- Питон

- pytorch

- вопрос

- хаотичность

- достигать

- доходит до

- Читать

- готовый

- реальные

- реальный мир

- реального времени

- причина

- причины

- учет

- относиться

- привязка

- беженцев

- выпустил

- актуальность

- соответствующие

- Переехал

- остались

- остатки

- повторный

- повторяющийся

- замещать

- хранилище

- представлять

- представляющий

- запросить

- Запросы

- обязательный

- исследованиям

- исследователь

- Полезные ресурсы

- соответственно

- ответ

- ответы

- ответственный

- в результате

- Итоги

- возвращают

- обзоре

- обзор

- надежный

- Подвижной

- королевский

- Run

- время выполнения

- Россия

- sagemaker

- Масштабируемость

- масштабируемые

- Шкала

- Сценарии

- Ученый

- Ученые

- скрипты

- SDK

- Поиск

- поиск

- SEC / КОМИССИЯ ПО ЦЕННЫМ БУМАГАМ И БИРЖАМ

- Регистрация SEC

- Во-вторых

- Раздел

- безопасность

- посмотреть

- старший

- послать

- предложение

- настроение

- отдельный

- Последовательность

- Серии

- Серия A

- обслуживание

- Услуги

- набор

- установка

- настройки

- несколько

- Короткое

- должен

- показывать

- показанный

- Шоу

- закрытие

- значительный

- просто

- с

- одинарной

- Размер

- отрывок

- So

- Общество

- Software

- разработка программного обеспечения

- комплект для разработки программного обеспечения

- разработка программного обеспечения

- Решение

- Решения

- Решение

- некоторые

- его

- Источник

- Южная

- Space

- специализированный

- конкретный

- конкретно

- специфичность

- указанный

- Расходы

- раскол

- Персонал

- Начало

- и политические лидеры

- Область

- статистический

- Статус:

- рулевое управление

- Шаг

- Шаги

- Останавливает

- диск

- структурированный

- Студенты

- учился

- исследования

- студия

- Успешно

- такие

- поддержка

- Поддержанный

- Убедитесь

- Швейцария

- система

- системы

- ТАБЛИЦЫ

- с учетом

- Сложность задачи

- задачи

- Обучение

- команда

- Технический

- техника

- снижения вреда

- Технологии

- шаблон

- Теннесси

- terms

- тестXNUMX

- текст

- Классификация текста

- чем

- который

- Ассоциация

- Местоположение

- Столица

- их

- Их

- тогда

- Там.

- Эти

- они

- мышление

- сторонние

- этой

- те

- Через

- пропускная способность

- тигры

- время

- раз

- в

- сегодня

- знак

- Лексемы

- инструменты

- Всего

- Train

- специалистов

- Обучение

- трансформатор

- Переводы

- правда

- стараться

- настройка

- близнец

- два

- напишите

- ui

- под

- лежащий в основе

- созданного

- Университеты

- Университет

- до

- Обновление ПО

- Updates

- Применение

- использование

- прецедент

- используемый

- Информация о пользователе

- пользователей

- использования

- через

- использует

- узбекистан

- Проверка

- ценностное

- разнообразие

- различный

- растительность

- версия

- версии

- очень

- с помощью

- Вид

- лоза

- визуальный

- от

- хотеть

- войны

- законопроект

- способы

- we

- Web

- веб-сервисы

- Web-Based

- пошел

- были

- когда

- который

- в то время как

- КТО

- будете

- ВИНО

- Выиграл

- Word

- слова

- Работа

- работавший

- работает

- работает

- семинар

- Мир

- бы

- записывать

- год

- Йога

- Ты

- ВАШЕ

- молодежь

- зефирнет

- Зевс