Недавние модели больших языков (LLM) позволили добиться огромного прогресса в понимании естественного языка. Однако они склонны давать уверенные, но бессмысленные объяснения, что создает серьезное препятствие для установления доверия пользователей. В этом посте мы покажем, как включить отзывы людей о неправильных цепочках рассуждений для рассуждений с несколькими переходами, чтобы повысить производительность при выполнении этих задач. Вместо того, чтобы собирать цепочки рассуждений с нуля, спрашивая людей, мы вместо этого учимся на обширных отзывах людей о цепочках рассуждений, сгенерированных моделью, с использованием подсказочных способностей LLM. Мы собираем два таких набора данных отзывов людей в форме (исправление, объяснение, тип ошибки) для наборов данных StrategyQA и Sports Understanding и оцениваем несколько общих алгоритмов, чтобы извлечь уроки из таких отзывов. Предлагаемые нами методы работают конкурентоспособно с подсказкой по цепочке мыслей с использованием базового Flan-T5, и наш лучше оценивает правильность собственного ответа.

Обзор решения

С появлением больших языковых моделей в этой области произошел огромный прогресс в различных тестах обработки естественного языка (NLP). Среди них прогресс был поразительным в относительно более простых задачах, таких как краткий контекст или фактический ответ на вопрос, по сравнению с более сложными задачами, требующими рассуждений, такими как ответы на многоступенчатые вопросы. Производительность некоторых задач с использованием LLM может быть похожа на случайное угадывание в меньших масштабах, но значительно улучшается в больших масштабах. Несмотря на это, подсказочные способности LLM могут предоставить некоторые важные факты, необходимые для ответа на вопрос.

Однако эти модели не могут надежно генерировать правильные цепочки рассуждений или объяснения. Эти уверенные, но бессмысленные объяснения еще более распространены, когда LLM обучаются с использованием Reinforcement Learning from Human Feedback (RLHF), где может произойти взлом вознаграждения.

Руководствуясь этим, мы пытаемся ответить на следующий исследовательский вопрос: можем ли мы улучшить рассуждения LLM, изучая отзывы людей о цепочках рассуждений, созданных моделями? На следующем рисунке представлен обзор нашего подхода: сначала мы побуждаем модель генерировать цепочки рассуждений для многоэтапных вопросов, затем собираем различные отзывы людей об этих цепочках для диагностики и предлагаем алгоритмы обучения для обучения на собранных данных.

Мы собираем разнообразные отзывы людей о двух многоэтапных наборах данных, StrategyQA и Sports Understanding от BigBench. Для каждого вопроса и сгенерированной моделью цепочки рассуждений мы собираем правильную цепочку рассуждений, тип ошибки в сгенерированной моделью цепочке рассуждений и описание (на естественном языке) того, почему эта ошибка представлена в предоставленной цепочке рассуждений. Окончательный набор данных содержит отзывы для 1,565 образцов из StrategyQA и 796 примеров из Sports Understanding.

Мы предлагаем несколько алгоритмов обучения, чтобы учиться на собранных отзывах. Во-первых, мы предлагаем вариант самосогласованности в подсказке по цепочке мыслей, рассматривая его взвешенный вариант, который можно узнать из обратной связи. Во-вторых, мы предлагаем итеративное уточнение, при котором мы итеративно уточняем созданную моделью цепочку рассуждений до тех пор, пока она не станет правильной. Мы эмпирически демонстрируем на двух наборах данных, что точная настройка LLM, а именно Flan-T5 с использованием предложенных алгоритмов, работает сравнимо с базовым уровнем обучения в контексте. Что еще более важно, мы показываем, что точно настроенная модель лучше оценивает правильность своего собственного ответа по сравнению с базовой моделью Flan-T5.

Сбор данных

В этом разделе мы описываем детали собранных нами отзывов и протокол аннотаций, которым следовали при сборе данных. Мы собрали отзывы для поколений моделей на основе двух наборов данных, основанных на рассуждениях: StrategyQA и Sports Understanding от BigBench. Мы использовали GPT-J, чтобы сгенерировать ответ для StrategyQA, и Flan-T5, чтобы сгенерировать ответ для набора данных Sports Understanding. В каждом случае модели предлагалось k контекстных примеров, содержащих вопрос, ответ и объяснение, за которыми следовал контрольный вопрос.

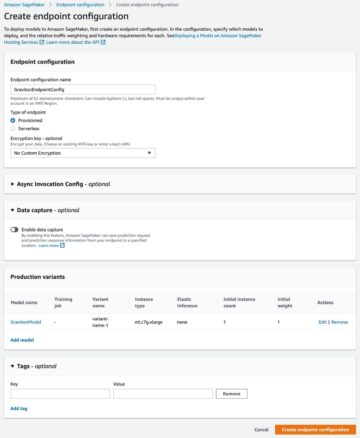

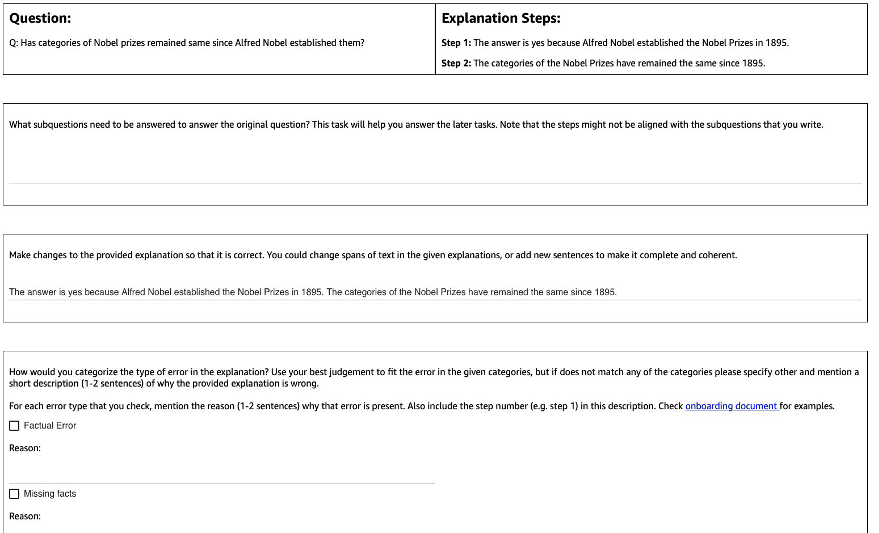

На следующем рисунке показан интерфейс, который мы использовали. Аннотаторам дается вопрос, ответ, сгенерированный моделью, и объяснение, разбитое на этапы.

По каждому вопросу мы собрали следующие отзывы:

- Подвопросы – Аннотаторы разбивают исходный вопрос на более простые подвопросы, необходимые для ответа на исходный вопрос. Это задание было добавлено после пилотного проекта, в ходе которого мы обнаружили, что добавление этого задания помогает подготовить комментаторов и улучшить качество остальных заданий.

- Коррекция – Аннотаторам предоставляется текстовое поле произвольной формы, предварительно заполненное сгенерированным моделью ответом и объяснением, и предлагается отредактировать его, чтобы получить правильный ответ и объяснение.

- Тип ошибки – Среди наиболее распространенных типов ошибок, которые мы обнаружили в поколениях моделей (фактическая ошибка, отсутствующие факты, нерелевантные факты и логическое несоответствие), аннотаторов попросили выбрать один или несколько типов ошибок, которые относятся к данному ответу и объяснению.

- Описание ошибки – Аннотаторам было поручено не только классифицировать ошибки, но и дать всестороннее обоснование их категоризации, в том числе указать точный шаг, на котором произошла ошибка, и как это применимо к предоставленному ответу и объяснению.

Мы использовали Amazon SageMaker Ground Truth Plus в нашей коллекции данных. Сбор данных происходил в течение нескольких раундов. Сначала мы провели два небольших пилотных проекта по 30 и 200 примеров соответственно, после чего команда аннотаторов получила подробный отзыв об аннотации. Затем мы провели сбор данных в двух пакетах для StrategyQA и в одном пакете для Sports Understanding, периодически предоставляя обратную связь — в общей сложности 10 аннотаторов работали над задачей в течение периода, близкого к 1 месяцу.

Мы собрали отзывы о 1,565 примерах для StrategyQA и 796 примерах для Sports Understanding. В следующей таблице показан процент примеров, в которых не было ошибок при создании модели, и доля примеров, содержащих ошибки определенного типа. Стоит отметить, что в некоторых примерах может быть несколько типов ошибок.

| Тип ошибки | Стратегия контроля качества | Понимание спорта |

| Ничто | 17.6% | 31.28% |

| Фактическая ошибка | 27.6% | 38.1% |

| Отсутствующие факты | 50.4% | 46.1% |

| Нерелевантные факты | 14.6% | 3.9% |

| Логическая несогласованность | 11.2% | 5.2% |

Алгоритмы обучения

На каждый вопрос q, а также сгенерированный моделью ответ и объяснение m, мы собрали следующие отзывы: правильный ответ и объяснение c, тип ошибки присутствует в m (обозначается t) и описание ошибки d, как описано в предыдущем разделе.

Мы использовали следующие методы:

- Многозадачное обучение – Простая отправная точка для извлечения уроков из разнообразных доступных отзывов – относиться к каждому из них как к отдельной задаче. Более конкретно, мы настраиваем Flan-T5 (текст в текст) с целью максимизировать p(c|q) + p(t|q, m) + p(d|q, m). Для каждого термина в задаче используется отдельная инструкция, соответствующая задаче (например, «Предсказать ошибку в заданном ответе»). Мы также преобразуем категориальную переменную t в предложение естественного языка. Во время вывода мы используем инструкцию для терма р (с | д) («Предсказать правильный ответ на данный вопрос»), чтобы сгенерировать ответ на тестовый вопрос.

- Взвешенная самосогласованность – Мотивированные успехом самосогласования в подсказках по цепочке мыслей, мы предлагаем его взвешенный вариант. Вместо того, чтобы рассматривать каждое выбранное объяснение из модели как правильное и рассматривать совокупное голосование, мы вместо этого сначала рассматриваем правильность объяснения, а затем соответствующим образом агрегируем. Сначала мы настраиваем Flan-T5 с той же целью, что и при многозадачном обучении. Во время логического вывода по заданному контрольному вопросу q, мы пробуем несколько возможных ответов с инструкцией для р (с | д)): a1, a2, .., an. Для каждого выборочного ответа ai, используем инструкцию для терма р (т | д, м) («Предсказать ошибку в данном ответе»), чтобы определить, содержит ли он ошибку ti = argmax p (t | q, a_i). Каждый ответ ai присваивается вес 1, если он правильный, в противном случае ему присваивается вес меньше 1 (настраиваемый гиперпараметр). Окончательный ответ получается путем взвешенного голосования по всем ответам. a1 в an.

- Итеративное уточнение – В предыдущих предложенных методах модель напрямую генерирует правильный ответ c обусловленный вопросом q. Здесь мы предлагаем уточнить сгенерированный моделью ответ m получить правильный ответ на поставленный вопрос. В частности, мы сначала настраиваем Flan-T5 (текст в текст с целью) с помощью максимизировать p(t; c|q, m), Где ; обозначает конкатенацию (тип ошибки t затем правильный ответ c). Один из способов увидеть эту цель состоит в том, что модель сначала обучается идентифицировать ошибку в данном поколении. m, а затем удалить эту ошибку, чтобы получить правильный ответ c. Во время логического вывода мы можем использовать модель итеративно, пока она не даст правильный ответ на тестовый вопрос. q, мы сначала получаем начальную генерацию модели m (с использованием предварительно обученного Flan-T5). Затем мы итеративно генерируем тип ошибки ti и потенциально правильный ответ ci до ti = нет ошибки (на практике мы устанавливаем гиперпараметру максимальное количество итераций), и в этом случае окончательный правильный ответ будет СI-1 (получен из р(ти; ci | q, ci-1)).

Итоги

Для обоих наборов данных мы сравниваем все предложенные алгоритмы обучения с базовым уровнем обучения в контексте. Все модели оцениваются в наборе для разработчиков StrategyQA и Sports Understanding. В следующей таблице показаны результаты.

| Способ доставки | Стратегия контроля качества | Понимание спорта |

| Flan-T5 4-этапная цепочка мыслей в контексте обучения | 67.39 ± 2.6% | 58.5% |

| Многозадачное обучение | 66.22 ± 0.7% | 54.3 ± 2.1% |

| Взвешенная самосогласованность | 61.13 ± 1.5% | 51.3 ± 1.9% |

| Итеративное уточнение | 61.85 ± 3.3% | 57.0 ± 2.5% |

Как было замечено, некоторые методы работают сравнимо с базовым уровнем обучения в контексте (многозадачность для StrategyQA и итеративное уточнение для Sports Understanding), что демонстрирует потенциал сбора постоянной обратной связи от людей о выходных данных модели и использования ее для улучшения языковых моделей. Это отличается от недавней работы, такой как RLHF, где обратная связь ограничена категоричностью и обычно бинарна.

Как показано в следующей таблице, мы исследуем, как модели, адаптированные с учетом отзывов людей об ошибках рассуждений, могут помочь улучшить калибровку или осознание заведомо неправильных объяснений. Это оценивается путем предложения модели предсказать, содержит ли ее генерация какие-либо ошибки.

| Способ доставки | Исправление ошибок | Стратегия контроля качества |

| Flan-T5 4-этапная цепочка мыслей в контексте обучения | Нет | 30.17% |

| Многозадачная модель с тонкой настройкой | Да | 73.98% |

Более подробно мы подсказываем языковой модели с ее собственным сгенерированным ответом и цепочкой рассуждений (для которых мы собирали отзывы), а затем снова подсказываем, чтобы предсказать ошибку в генерации. Используем соответствующую инструкцию к заданию («Выявить ошибку в ответе»). Модель оценивается правильно, если она предсказывает «отсутствие ошибок» или «верно» в генерации, если аннотаторы пометили пример как не содержащий ошибок, или если она предсказывает любой из типов ошибок в генерации (наряду с «неверно» или « неправильно»), когда аннотаторы пометили это как имеющее ошибку. Обратите внимание, что мы оцениваем не способность модели правильно идентифицировать тип ошибки, а скорее наличие ошибки. Оценка выполняется на наборе из 173 дополнительных примеров из набора разработчика StrategyQA, которые были собраны, но не видны во время тонкой настройки. Четыре примера из них зарезервированы для запроса языковой модели (первая строка в предыдущей таблице).

Обратите внимание, что мы не показываем базовый результат с нулевым выстрелом, потому что модель не может генерировать полезные ответы. Мы наблюдаем, что использование обратной связи человека для исправления ошибок в цепочках рассуждений может улучшить предсказание модели того, совершает ли она ошибки или нет, что может улучшить осведомленность или калибровку неправильных объяснений.

Заключение

В этом посте мы показали, как курировать наборы данных отзывов людей с помощью мелкозернистых исправлений ошибок, что является альтернативным способом улучшить мыслительные способности LLM. Экспериментальные результаты подтверждают, что человеческая обратная связь об ошибках рассуждений может улучшить производительность и калибровку при решении сложных многоэтапных вопросов.

Если вам нужна человеческая обратная связь для улучшения ваших больших языковых моделей, посетите Маркировка данных Amazon SageMaker и консоль Ground Truth Plus.

Об авторах

Эрран Ли является менеджером по прикладным наукам в сервисах humain-in-the-loop, AWS AI, Amazon. Его исследовательские интересы включают глубокое 3D-обучение, а также обучение зрению и репрезентации языка. Ранее он был старшим научным сотрудником Alexa AI, главой отдела машинного обучения Scale AI и главным научным сотрудником Pony.ai. До этого он работал с командой восприятия в Uber ATG и командой платформы машинного обучения в Uber, работая над машинным обучением для автономного вождения, системами машинного обучения и стратегическими инициативами ИИ. Он начал свою карьеру в Bell Labs и был адъюнкт-профессором Колумбийского университета. Он преподавал учебные пособия на ICML'17 и ICCV'19, а также был соорганизатором нескольких семинаров в NeurIPS, ICML, CVPR, ICCV по машинному обучению для автономного вождения, трехмерному зрению и робототехнике, системам машинного обучения и противоборствующему машинному обучению. Он имеет докторскую степень в области компьютерных наук в Корнельском университете. Он является научным сотрудником ACM и IEEE.

Эрран Ли является менеджером по прикладным наукам в сервисах humain-in-the-loop, AWS AI, Amazon. Его исследовательские интересы включают глубокое 3D-обучение, а также обучение зрению и репрезентации языка. Ранее он был старшим научным сотрудником Alexa AI, главой отдела машинного обучения Scale AI и главным научным сотрудником Pony.ai. До этого он работал с командой восприятия в Uber ATG и командой платформы машинного обучения в Uber, работая над машинным обучением для автономного вождения, системами машинного обучения и стратегическими инициативами ИИ. Он начал свою карьеру в Bell Labs и был адъюнкт-профессором Колумбийского университета. Он преподавал учебные пособия на ICML'17 и ICCV'19, а также был соорганизатором нескольких семинаров в NeurIPS, ICML, CVPR, ICCV по машинному обучению для автономного вождения, трехмерному зрению и робототехнике, системам машинного обучения и противоборствующему машинному обучению. Он имеет докторскую степень в области компьютерных наук в Корнельском университете. Он является научным сотрудником ACM и IEEE.

Нитиш Джоши был стажером по прикладным наукам в AWS AI, Amazon. Он является аспирантом в области компьютерных наук в Курантском институте математических наук Нью-Йоркского университета, консультируемый профессором Хе Хе. Он работает над машинным обучением и обработкой естественного языка и был связан с исследовательской группой Machine Learning for Language (ML2). Его в целом интересовало надежное понимание языка: как в построении моделей, устойчивых к сдвигам распределения (например, за счет расширения данных с участием человека), так и в разработке более эффективных способов оценки/измерения надежности моделей. Ему также было любопытно узнать о последних разработках в области контекстного обучения и понять, как это работает.

Нитиш Джоши был стажером по прикладным наукам в AWS AI, Amazon. Он является аспирантом в области компьютерных наук в Курантском институте математических наук Нью-Йоркского университета, консультируемый профессором Хе Хе. Он работает над машинным обучением и обработкой естественного языка и был связан с исследовательской группой Machine Learning for Language (ML2). Его в целом интересовало надежное понимание языка: как в построении моделей, устойчивых к сдвигам распределения (например, за счет расширения данных с участием человека), так и в разработке более эффективных способов оценки/измерения надежности моделей. Ему также было любопытно узнать о последних разработках в области контекстного обучения и понять, как это работает.

Кумар Челлапилла является генеральным менеджером и директором Amazon Web Services и руководит разработкой сервисов машинного обучения/ИИ, таких как системы «человек в цикле», AI DevOps, геопространственное машинное обучение и разработка ADAS/автономных транспортных средств. До прихода в AWS Кумар был техническим директором в Uber ATG и Lyft Level 5 и руководил командами, использующими машинное обучение для развития возможностей самостоятельного вождения, таких как восприятие и картографирование. Он также работал над применением методов машинного обучения для улучшения поиска, рекомендаций и рекламных продуктов в LinkedIn, Twitter, Bing и Microsoft Research.

Кумар Челлапилла является генеральным менеджером и директором Amazon Web Services и руководит разработкой сервисов машинного обучения/ИИ, таких как системы «человек в цикле», AI DevOps, геопространственное машинное обучение и разработка ADAS/автономных транспортных средств. До прихода в AWS Кумар был техническим директором в Uber ATG и Lyft Level 5 и руководил командами, использующими машинное обучение для развития возможностей самостоятельного вождения, таких как восприятие и картографирование. Он также работал над применением методов машинного обучения для улучшения поиска, рекомендаций и рекламных продуктов в LinkedIn, Twitter, Bing и Microsoft Research.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- ПлатонАйСтрим. Анализ данных Web3. Расширение знаний. Доступ здесь.

- Чеканка будущего с Эдриенн Эшли. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/improve-multi-hop-reasoning-in-llms-by-learning-from-rich-human-feedback/

- :имеет

- :является

- :нет

- :куда

- 1

- 10

- 100

- 13

- 200

- 22

- 30

- 39

- 3d

- 7

- a

- способности

- способность

- О нас

- соответственно

- ACM

- добавленный

- добавить

- дополнительный

- адрес

- состязательный

- Реклама

- Аффилированные

- После

- снова

- AI

- Alexa

- алгоритмы

- Все

- вдоль

- причислены

- альтернатива

- Amazon

- Создатель мудреца Амазонки

- Amazon Web Services

- среди

- an

- и

- ответ

- ответы

- любой

- прикладной

- Применить

- Применение

- подхода

- соответствующий

- МЫ

- AS

- назначенный

- At

- автономный

- доступен

- осведомленность

- AWS

- Использование темпера с изогнутым основанием

- основанный

- Базовая линия

- BE

- , так как:

- было

- до

- Колокол

- тесты

- Лучшая

- Bing

- изоферменты печени

- Коробка

- широко

- Строительство

- строительные модели

- но

- by

- CAN

- возможности

- Карьера

- случаев

- определенный

- цепь

- цепи

- сложные

- главный

- классифицировать

- Закрыть

- собирать

- Сбор

- лыжных шлемов

- COLUMBIA

- Общий

- сравнимый

- сравнить

- сравненный

- комплексный

- компьютер

- Информатика

- проводятся

- уверенный

- уверенно

- Рассматривать

- принимая во внимание

- Консоли

- содержит

- контекст

- конвертировать

- Cornell

- исправления

- подкреплять

- любопытный

- данным

- Наборы данных

- глубоко

- глубокое обучение

- демонстрировать

- демонстрирует

- описывать

- описано

- описание

- проектирование

- Несмотря на

- подробность

- подробный

- подробнее

- Дев

- развивать

- Развитие

- события

- различный

- непосредственно

- директор

- распределение

- Разное

- do

- сделанный

- Dont

- вождение

- в течение

- e

- каждый

- включен

- Проект и

- ошибка

- ошибки

- налаживание

- оценивать

- оценивается

- оценка

- Даже

- пример

- Примеры

- объяснение

- Обратная связь

- человек

- поле

- фигура

- окончательный

- Во-первых,

- следует

- после

- Что касается

- форма

- найденный

- 4

- от

- сбор

- Общие

- порождать

- генерируется

- генерирует

- порождающий

- поколение

- поколения

- Геопространственное машинное обучение

- Дайте

- данный

- Отдаете

- земля

- группы

- взлом

- Есть

- имеющий

- he

- помощь

- помогает

- здесь

- его

- Как

- How To

- Однако

- HTTPS

- человек

- Людей

- определения

- IEEE

- if

- иллюстрирует

- улучшать

- in

- В том числе

- включать

- начальный

- инициативы

- вместо

- Институт

- заинтересованный

- интересы

- Интерфейс

- в

- исследовать

- IT

- итерации

- ЕГО

- JPG

- Labs

- язык

- большой

- больше

- Лиды

- УЧИТЬСЯ

- узнали

- изучение

- привело

- уровень

- Ограниченный

- LLM

- логический

- искать

- Lyft

- машина

- обучение с помощью машины

- ДЕЛАЕТ

- менеджер

- отображение

- математический

- максимальный

- Май..

- методы

- Microsoft

- отсутствующий

- ошибка

- ошибки

- ML

- ml2

- модель

- Модели

- Месяц

- БОЛЕЕ

- самых

- мотивированные

- с разными

- а именно

- натуральный

- Обработка естественного языка

- Новые

- New York

- НЛП

- нет

- номер

- цель

- наблюдать

- препятствие

- получать

- полученный

- произошло

- of

- on

- ONE

- постоянный

- только

- начало

- or

- оригинал

- в противном случае

- наши

- внешний

- за

- обзор

- собственный

- процент

- восприятие

- Выполнять

- производительность

- выполняет

- период

- периодический

- выбирать

- пилот

- Часть

- Платформа

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- плюс

- представляет

- возможное

- После

- потенциал

- практика

- предсказывать

- прогноз

- предсказывает

- Подготовить

- представить

- представлены

- превалирующий

- предыдущий

- предварительно

- Предварительный

- обработка

- Продукция

- Профессор

- Прогресс

- доля

- предлагает

- предложило

- протокол

- обеспечивать

- при условии

- приводит

- вопрос

- Вопросы

- случайный

- скорее

- последний

- рекомендаций

- совершенствовать

- относительно

- соответствующие

- удаление

- представление

- требовать

- обязательный

- исследованиям

- зарезервированный

- соответственно

- ОТДЫХ

- результат

- Итоги

- Предложение

- Богатые

- робототехника

- надежный

- прочность

- туры

- РЯД

- sagemaker

- то же

- Шкала

- масштаб ай

- Весы

- Наука

- НАУКА

- Ученый

- Поиск

- Во-вторых

- Раздел

- видел

- SELF

- самостоятельное вождение

- старший

- предложение

- отдельный

- Услуги

- набор

- несколько

- Смены

- Короткое

- показывать

- показанный

- Шоу

- значительный

- существенно

- аналогичный

- просто

- небольшой

- меньше

- некоторые

- конкретный

- конкретно

- раскол

- Спорт

- и политические лидеры

- Шаг

- Шаги

- Стратегический

- "Студент"

- успех

- такие

- системы

- ТАБЛИЦЫ

- Сложность задачи

- задачи

- команда

- команды

- снижения вреда

- тестXNUMX

- чем

- который

- Ассоциация

- их

- Их

- тогда

- Эти

- они

- этой

- те

- Через

- в

- Всего

- специалистов

- Обучение

- лечить

- лечения

- огромный

- Доверие

- Правда

- учебные пособия

- два

- напишите

- Типы

- Uber

- понимание

- Университет

- использование

- используемый

- пользователей

- через

- обычно

- Вариант

- различный

- автомобиль

- Вид

- видение

- Войти

- Голос

- законопроект

- Путь..

- способы

- we

- Web

- веб-сервисы

- вес

- были

- когда

- будь то

- , которые

- зачем

- будете

- Работа

- работавший

- работает

- работает

- Семинары

- стоимость

- Неправильно

- йорк

- ВАШЕ

- зефирнет