Сегодня мы рады сообщить, что Микстрал-8х7Б Модель большого языка (LLM), разработанная Mistral AI, доступна клиентам через Amazon SageMaker JumpStart развернуть одним щелчком мыши для выполнения вывода. Mixtral-8x7B LLM — это предварительно обученная разреженная смесь экспертных моделей, основанная на магистральной сети с 7 миллиардами параметров и восемью экспертами на каждый уровень прямой связи. Вы можете опробовать эту модель с помощью SageMaker JumpStart, центра машинного обучения (ML), который предоставляет доступ к алгоритмам и моделям, чтобы вы могли быстро приступить к работе с ML. В этом посте мы расскажем, как обнаружить и развернуть модель Mixtral-8x7B.

Что такое Микстрал-8х7Б

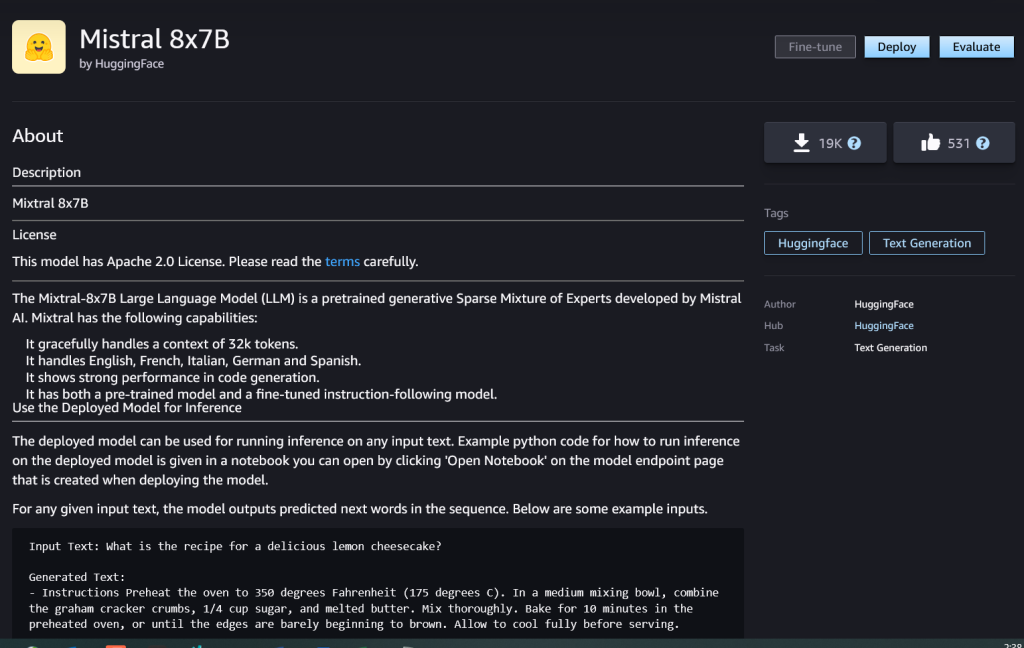

Mixtral-8x7B — это базовая модель, разработанная Mistral AI, поддерживающая текст на английском, французском, немецком, итальянском и испанском языках, а также возможность генерации кода. Он поддерживает различные варианты использования, такие как суммирование текста, классификация, завершение текста и завершение кода. В режиме чата ведет себя хорошо. Чтобы продемонстрировать простоту настройки модели, Mistral AI также выпустила модель инструкций Mixtral-8x7B для сценариев использования чата, настроенную с использованием различных общедоступных наборов данных разговоров. Модели Mixtral имеют большую длину контекста — до 32,000 XNUMX токенов.

Mixtral-8x7B обеспечивает значительное улучшение производительности по сравнению с предыдущими современными моделями. Его редкая смесь экспертной архитектуры позволяет ему достичь лучших результатов в 9 из 12 тестов обработки естественного языка (NLP), протестированных Мистраль ИИ. Mixtral соответствует производительности моделей, в 10 раз превышающих их размеры, или превосходит их. Используя лишь небольшую часть параметров на токен, он обеспечивает более высокую скорость вывода и меньшие вычислительные затраты по сравнению с плотными моделями эквивалентных размеров — например, с общим количеством 46.7 миллиардов параметров, но только 12.9 миллиардов используемых на токен. Такое сочетание высокой производительности, многоязычной поддержки и вычислительной эффективности делает Mixtral-8x7B привлекательным выбором для приложений НЛП.

Модель доступна по разрешительной лицензии Apache 2.0 для использования без ограничений.

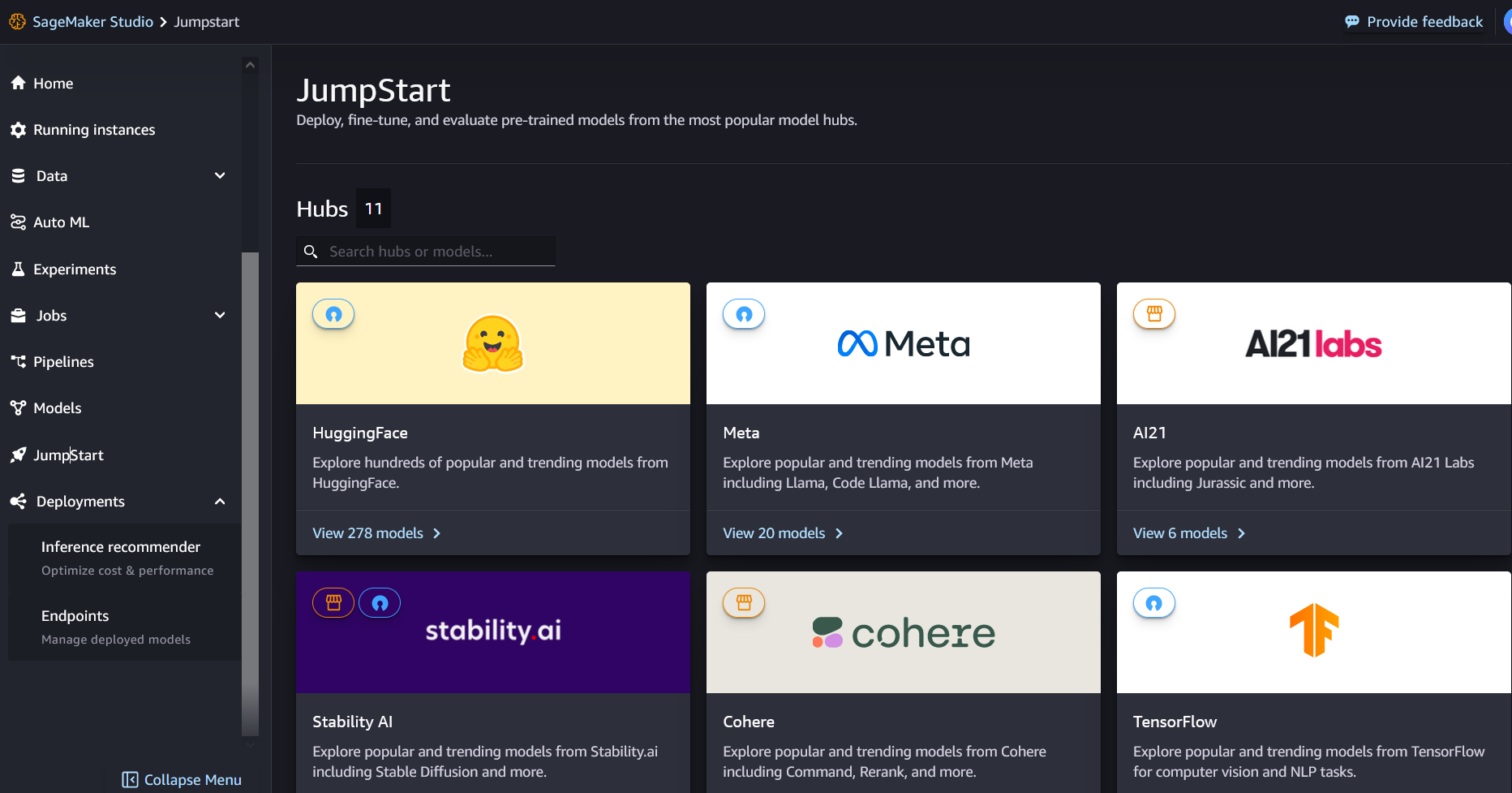

Что такое SageMaker JumpStart

С помощью SageMaker JumpStart специалисты по машинному обучению могут выбирать из растущего списка наиболее эффективных базовых моделей. Специалисты по машинному обучению могут развертывать базовые модели для выделенных Создатель мудреца Амазонки экземпляров в сетевой изолированной среде и настраивайте модели с помощью SageMaker для обучения и развертывания моделей.

Теперь вы можете обнаружить и развернуть Mixtral-8x7B несколькими щелчками мыши. Студия Amazon SageMaker или программно с помощью SageMaker Python SDK, что позволяет получить производительность модели и элементы управления MLOps с помощью функций SageMaker, таких как Конвейеры Amazon SageMaker, Amazon SageMaker Отладчикили журналы контейнера. Модель развертывается в безопасной среде AWS и под контролем вашего VPC, что помогает обеспечить безопасность данных.

Откройте для себя модели

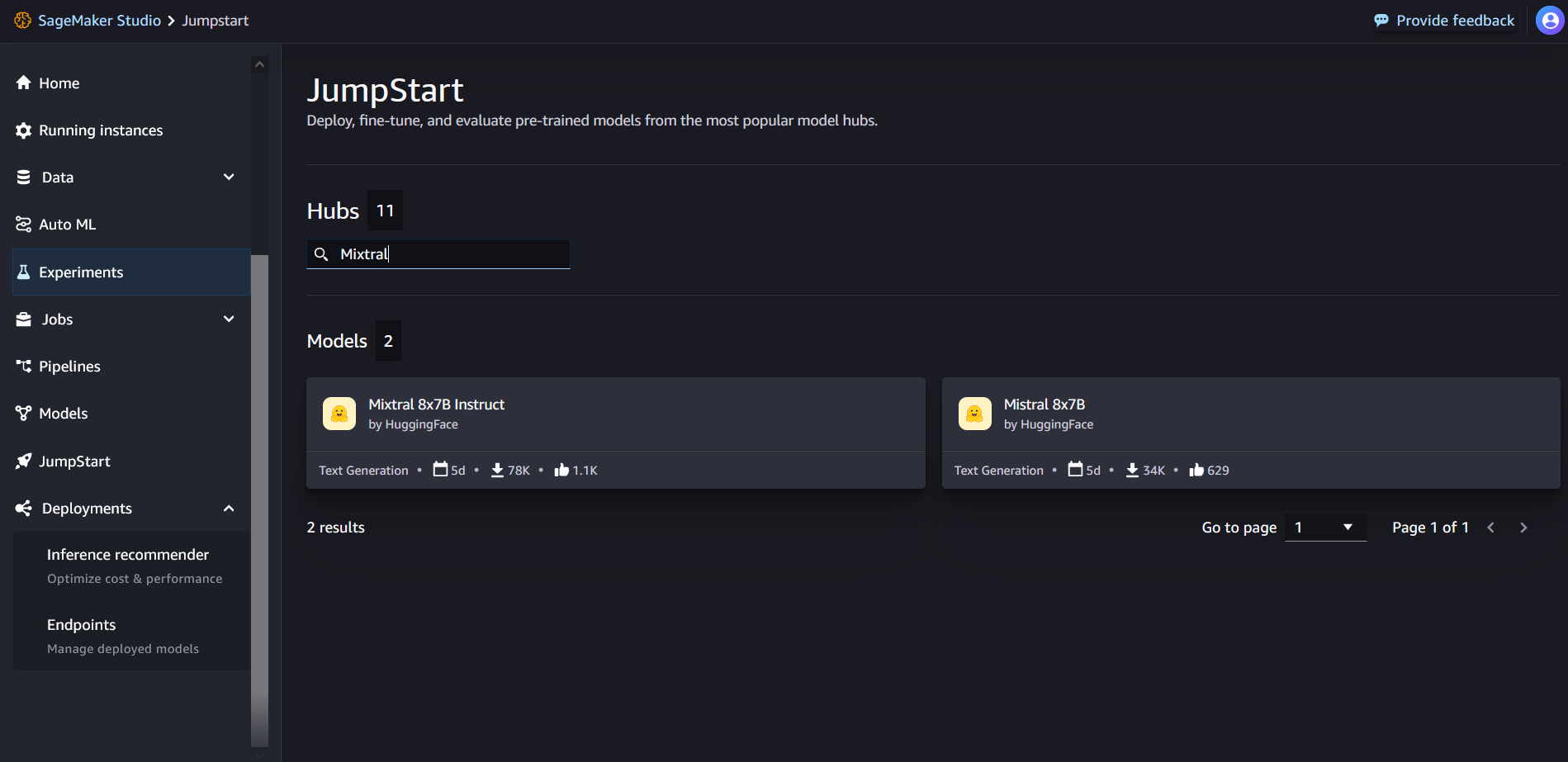

Доступ к базовым моделям Mixtral-8x7B можно получить через SageMaker JumpStart в пользовательском интерфейсе SageMaker Studio и SageMaker Python SDK. В этом разделе мы рассмотрим, как находить модели в SageMaker Studio.

SageMaker Studio — это интегрированная среда разработки (IDE), которая предоставляет единый визуальный веб-интерфейс, где вы можете получить доступ к специально созданным инструментам для выполнения всех этапов разработки машинного обучения, от подготовки данных до создания, обучения и развертывания моделей машинного обучения. Дополнительные сведения о том, как начать работу и настроить SageMaker Studio, см. Студия Amazon SageMaker.

В SageMaker Studio вы можете получить доступ к SageMaker JumpStart, выбрав Толчок в навигационной панели.

На целевой странице SageMaker JumpStart вы можете выполнить поиск «Mixtral» в поле поиска. Вы увидите результаты поиска, показывающие Mixtral 8x7B и Mixtral 8x7B Instruct.

Вы можете выбрать карточку модели, чтобы просмотреть сведения о модели, такие как лицензия, данные, используемые для обучения, и способы использования. Вы также найдете Развертывание кнопку, которую можно использовать для развертывания модели и создания конечной точки.

Развернуть модель

Развертывание начнется, когда вы выберете Развертывание. После завершения развертывания конечная точка будет создана. Вы можете протестировать конечную точку, передав образец полезных данных запроса вывода или выбрав вариант тестирования с помощью SDK. Когда вы выберете вариант использования SDK, вы увидите пример кода, который можно использовать в предпочитаемом вами редакторе блокнотов в SageMaker Studio.

Для развертывания с использованием SDK мы начинаем с выбора модели Mixtral-8x7B, указанной в model_id with value huggingface-llm-mixtral-8x7b. Вы можете развернуть любую из выбранных моделей в SageMaker с помощью следующего кода. Аналогичным образом вы можете развернуть инструкцию Mixtral-8x7B, используя собственный идентификатор модели:

При этом модель развертывается в SageMaker с конфигурациями по умолчанию, включая тип экземпляра по умолчанию и конфигурации VPC по умолчанию. Вы можете изменить эти конфигурации, указав значения, отличные от значений по умолчанию, в JumpStartМодель.

После развертывания вы можете выполнить логический вывод для развернутой конечной точки с помощью предиктора SageMaker:

Пример подсказки

Вы можете взаимодействовать с моделью Mixtral-8x7B, как с любой стандартной моделью генерации текста, где модель обрабатывает входную последовательность и выводит предсказанные следующие слова в последовательности. В этом разделе мы приводим примеры подсказок.

Генерация кода

Используя предыдущий пример, мы можем использовать подсказки для генерации кода, как показано ниже:

Вы получите следующий вывод:

Подсказка для анализа настроений

В Mixtral 8x7B вы можете выполнить анализ настроений, используя следующую подсказку:

Вы получите следующий вывод:

Подсказки с ответами на вопросы

В Mixtral-8x7B вы можете использовать подсказку для ответа на вопросы, как показано ниже:

Вы получите следующий вывод:

Микстрал-8х7Б Инструкция

Версия Mixtral-8x7B, настроенная на инструкции, принимает форматированные инструкции, в которых роли диалога должны начинаться с приглашения пользователя и чередоваться между инструкциями пользователя и помощником (образцовым ответом). Формат инструкций должен строго соблюдаться, иначе модель будет генерировать неоптимальные результаты. Шаблон, используемый для создания приглашения для модели Instruct, определяется следующим образом:

Обратите внимание, что <s> и </s> являются специальными токенами для начала строки (BOS) и конца строки (EOS), тогда как [INST] и [/INST] являются обычными строками.

Следующий код показывает, как можно отформатировать приглашение в формате инструкции:

Поиск знаний

Вы можете использовать следующий код для запроса на получение знаний:

Вы получите следующий вывод:

Кодирование

Модели Mixtral могут демонстрировать проверенные преимущества для задач кодирования, как показано в следующем коде:

Математика и рассуждения

Микстральные модели также демонстрируют высокую математическую точность:

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :имеет

- :является

- :нет

- :куда

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26%

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- способности

- О нас

- выше

- ускоряющий

- Принимает

- доступ

- Учетные записи

- точность

- Достигать

- Достигает

- через

- активный

- добавленный

- добавить

- После

- против

- AI

- AI / ML

- алгоритмы

- Все

- причислены

- Amazon

- Создатель мудреца Амазонки

- Amazon SageMaker JumpStart

- Amazon Web Services

- количество

- an

- анализ

- и

- и инфраструктура

- анонсировать

- ответ

- любой

- апаш

- привлекательный

- Приложения

- прикладной

- Применение

- архитектура

- МЫ

- аргумент

- гайд

- AS

- помощник

- At

- доступен

- AWS

- назад

- Позвоночник

- основанный

- колотить

- аккумулятор

- байесовский

- BE

- , так как:

- было

- до

- начало

- считает,

- Колокол

- протестированные

- тесты

- Лучшая

- между

- Билл

- биллинг

- миллиард

- булавка

- купил

- Коробка

- Ломать

- приносить

- строить

- Строительство

- встроенный

- бизнес

- но

- by

- вычислять

- призывают

- под названием

- Объявления

- CAN

- карта

- случаев

- случаев

- изменение

- чат

- выбор

- Выберите

- Выбирая

- Крис

- классификация

- нажмите на

- код

- Кодирование

- сочетание

- сравненный

- скомпилированный

- завершение

- вычислительный

- Вычисление

- компьютер

- Компьютерное зрение

- конференции

- постоянно

- Container

- содержание

- контекст

- продолжается

- непрерывно

- контрольная

- Разговор

- Цена

- Расходы

- может

- Создайте

- создали

- решающее значение

- чашка

- Текущий

- Клиенты

- настройка

- настроить

- данным

- безопасность данных

- Наборы данных

- день

- Дней

- преданный

- По умолчанию

- определенный

- Демократизация

- демонстрировать

- развертывание

- развернуть

- развертывание

- развертывание

- развертывает

- выводить

- подробнее

- развивать

- развитый

- Застройщик

- Развитие

- ДИКТ

- DID

- обнаружить

- do

- приносит

- долларов

- доменов

- сделанный

- вниз

- Падение

- Герцог

- Университет Дюка

- каждый

- Экономические

- редактор

- затрат

- яйца

- еще

- включить

- позволяет

- позволяет

- конец

- Конечная точка

- Проект и

- Английский

- обеспечивать

- Окружающая среда

- EOS

- равный

- Эквивалент

- этический

- пример

- превышает

- возбужденный

- без учета

- эксперту

- эксперты

- Объяснять

- объяснение

- расширение

- семья

- быстрее

- Особенности

- несколько

- Файлы

- фильтры

- Найдите

- Во-первых,

- после

- следующим образом

- Что касается

- формат

- Год основания

- доля

- Французский

- от

- функция

- будущее

- общее назначение

- порождать

- генерируется

- поколение

- генеративный

- Генеративный ИИ

- Немецкий

- получить

- Go

- хорошо

- есть

- Рост

- ненавидеть

- Есть

- he

- помощь

- помощь

- помогает

- ее

- здесь

- High

- Холмы

- его

- Как

- How To

- HTML

- HTTPS

- хаб

- i

- ICE

- мороженое

- ID

- if

- Иллинойс

- болезнь

- Импортировать

- важную

- улучшать

- улучшение

- in

- включают

- В том числе

- включенный

- Инфраструктура

- вход

- затраты

- пример

- инструкции

- интегрировать

- интегрированный

- взаимодействовать

- интересы

- Интерфейс

- Изобретенный

- изолированный

- IT

- итальянский

- ЕГО

- саму трезвость

- JPG

- Дети

- знания

- залив

- Labs

- посадка

- язык

- большой

- Фамилия

- слой

- Лиды

- изучение

- Длина

- позволять

- Лицензия

- такое как

- нравится

- рамки

- LINK

- Список

- Listening

- мало

- LLM

- логика

- искать

- ниже

- машина

- обучение с помощью машины

- сделанный

- ДЕЛАЕТ

- Создание

- менеджер

- многих

- спички

- математике

- математика

- me

- средний

- смесь

- ML

- млн операций в секунду

- режим

- модель

- Модели

- модифицировало

- Месяц

- БОЛЕЕ

- мотоцикл

- много

- умноженная

- Музыка

- должен

- my

- натуральный

- Обработка естественного языка

- Навигация

- отрицательный

- сеть

- Нейтральные

- Новые

- следующий

- НЛП

- Ничто

- в своих размышлениях

- ноутбук

- сейчас

- номер

- of

- Масло

- on

- консолидировать

- ONE

- только

- операционный

- операционная система

- Опция

- or

- Другое

- в противном случае

- внешний

- выходной

- выходы

- внешнюю

- за

- собственный

- страница

- выплачен

- хлеб

- бумага

- параметр

- параметры

- Прохождение

- страсть

- страстный

- пути

- для

- Выполнять

- производительность

- кандидат наук

- Телефон

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- Точка

- портативный

- положительный

- После

- предшествующий

- предсказанный

- Predictor

- привилегированный

- подготовка

- предыдущий

- Основной

- Печать / PDF

- процедурный

- процесс

- Процессы

- обработка

- Продукт

- FitPartner™

- Программирование

- наводящие

- процветание

- обеспечивать

- поставщики

- приводит

- публично

- опубликованный

- Питон

- Четверть

- вопрос

- быстро

- RE

- Reading

- рецепт

- рекурсивный

- уменьшить

- относиться

- регулярный

- выпустил

- отчету

- запросить

- исследованиям

- исследователь

- Полезные ресурсы

- уважаемый

- ответ

- ответственный

- Ограничения

- результат

- Итоги

- возвращают

- Возвращает

- верховая езда

- Снижение

- Роли

- роли

- Комната

- Run

- Бег

- s

- SA

- sagemaker

- соль

- масштабируемые

- Шкала

- Наука

- Ученый

- SDK

- Поиск

- Раздел

- безопасный

- безопасность

- посмотреть

- выберите

- выбранный

- выбор

- выбор

- старший

- настроение

- отдельный

- Последовательность

- Серии

- Услуги

- набор

- показал

- показанный

- Шоу

- значительный

- Аналогичным образом

- просто

- с

- одинарной

- Размер

- So

- Соцсети

- Общество

- Software

- Решение

- Испанский

- особый

- специалист

- указанный

- скорость

- Расходы

- стандарт

- Начало

- и политические лидеры

- начинается

- современное состояние

- статистический

- Шаг

- Шаги

- По-прежнему

- остановившийся

- магазин

- простой

- Стратегический

- поток

- сильные

- строка

- структурированный

- студия

- такие

- поддержка

- поддержки

- Поддержка

- система

- принимает

- задачи

- вкус

- команда

- Технологии

- шаблон

- тестXNUMX

- проверенный

- Тестирование

- текст

- который

- Ассоциация

- Будущее

- тогда

- Эти

- они

- этой

- Через

- время

- Временные ряды

- раз

- в

- вместе

- знак

- Лексемы

- слишком

- инструменты

- Всего

- Train

- Обучение

- правда

- стараться

- Tweet

- напишите

- ui

- под

- Университет

- Юникс

- отпереть

- до

- использование

- прецедент

- используемый

- Информация о пользователе

- использования

- через

- Использующий

- Долина

- ценностное

- Наши ценности

- разнообразие

- версия

- Видео

- Вид

- видение

- Войти

- визуальный

- от

- законопроект

- Вода

- we

- Web

- веб-сервисы

- Web-Based

- ЧТО Ж

- Что

- Что такое

- когда

- в то время как

- , которые

- белый

- КТО

- будете

- в

- без

- слова

- Работа

- бы

- записывать

- письменный

- Ты

- ВАШЕ

- зефирнет

Рахна Чадха является главным архитектором решений AI/ML в области стратегических счетов в AWS. Рахна — оптимистка, считающая, что этичное и ответственное использование ИИ может улучшить общество в будущем и принести экономическое и социальное процветание. В свободное время Рахна любит проводить время со своей семьей, ходить в походы и слушать музыку.

Рахна Чадха является главным архитектором решений AI/ML в области стратегических счетов в AWS. Рахна — оптимистка, считающая, что этичное и ответственное использование ИИ может улучшить общество в будущем и принести экономическое и социальное процветание. В свободное время Рахна любит проводить время со своей семьей, ходить в походы и слушать музыку. Доктор Кайл Ульрих является ученым-прикладником с

Доктор Кайл Ульрих является ученым-прикладником с  Кристофер Уиттен — разработчик программного обеспечения в команде JumpStart. Он помогает масштабировать выбор моделей и интегрировать модели с другими сервисами SageMaker. Крис страстно желает ускорить повсеместное распространение ИИ в различных сферах бизнеса.

Кристофер Уиттен — разработчик программного обеспечения в команде JumpStart. Он помогает масштабировать выбор моделей и интегрировать модели с другими сервисами SageMaker. Крис страстно желает ускорить повсеместное распространение ИИ в различных сферах бизнеса. Доктор Фабио Нонато де Паула — старший менеджер, специалист GenAI SA, помогающий поставщикам моделей и клиентам масштабировать генеративный искусственный интеллект в AWS. Фабио страстно желает демократизировать доступ к технологиям генеративного искусственного интеллекта. В свободное от работы время Фабио катается на мотоцикле по холмам долины Сонома или читает ComiXology.

Доктор Фабио Нонато де Паула — старший менеджер, специалист GenAI SA, помогающий поставщикам моделей и клиентам масштабировать генеративный искусственный интеллект в AWS. Фабио страстно желает демократизировать доступ к технологиям генеративного искусственного интеллекта. В свободное от работы время Фабио катается на мотоцикле по холмам долины Сонома или читает ComiXology. Доктор Ашиш Хетан — старший научный сотрудник, работающий со встроенными алгоритмами Amazon SageMaker и помогающий разрабатывать алгоритмы машинного обучения. Он получил докторскую степень в Университете Иллинойса в Урбана-Шампейн. Он является активным исследователем в области машинного обучения и статистических выводов и опубликовал множество статей на конференциях NeurIPS, ICML, ICLR, JMLR, ACL и EMNLP.

Доктор Ашиш Хетан — старший научный сотрудник, работающий со встроенными алгоритмами Amazon SageMaker и помогающий разрабатывать алгоритмы машинного обучения. Он получил докторскую степень в Университете Иллинойса в Урбана-Шампейн. Он является активным исследователем в области машинного обучения и статистических выводов и опубликовал множество статей на конференциях NeurIPS, ICML, ICLR, JMLR, ACL и EMNLP. Карл Альбертсен руководит продуктом, разработкой и наукой для Amazon SageMaker Algorithms и JumpStart, центра машинного обучения SageMaker. Он увлечен применением машинного обучения для раскрытия ценности бизнеса.

Карл Альбертсен руководит продуктом, разработкой и наукой для Amazon SageMaker Algorithms и JumpStart, центра машинного обучения SageMaker. Он увлечен применением машинного обучения для раскрытия ценности бизнеса.