Predstavitev

Pred dvema letoma je v projektu, imenovanem Onkraj merila Imitation Gameali BIG-bench je 450 raziskovalcev sestavilo seznam 204 nalog, namenjenih testiranju zmogljivosti velikih jezikovnih modelov, ki poganjajo chatbote, kot je ChatGPT. Pri večini nalog se je zmogljivost predvidljivo in gladko izboljšala, ko so se modeli povečevali – večji ko je bil model, boljši je bil. Toda pri drugih nalogah skok v sposobnosti ni bil gladek. Uspešnost je bila nekaj časa blizu ničle, nato pa je zmogljivost poskočila. Druge študije so odkrile podobne skoke v sposobnosti.

Avtorji so to opisali kot "prelomno" vedenje; drugi raziskovalci so to primerjali s faznim prehodom v fiziki, kot ko tekoča voda zmrzne v led. notri papir objavljeno avgusta 2022, so raziskovalci ugotovili, da ta vedenja niso le presenetljiva, ampak tudi nepredvidljiva, in da bi morala obveščati razvijajoče se pogovore o varnosti, potencialu in tveganju umetne inteligence. Sposobnosti so poimenovali "pojavljajo,« beseda, ki opisuje kolektivno vedenje, ki se pojavi šele, ko sistem doseže visoko stopnjo kompleksnosti.

Toda stvari morda niso tako preproste. Nov članek trojice raziskovalcev na Univerzi Stanford trdi, da je nenaden pojav teh sposobnosti samo posledica načina, kako raziskovalci merijo uspešnost LLM. Sposobnosti, trdijo, niso niti nepredvidljive niti nenadne. "Prehod je veliko bolj predvidljiv, kot si ljudje pripisujejo," je dejal Sanmi Koyejo, računalniški znanstvenik na Stanfordu in glavni avtor časopisa. "Močne trditve o nastanku so prav toliko povezane z načinom, kako se odločimo za merjenje, kot s tem, kar počnejo modeli."

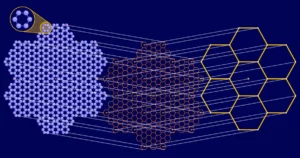

To vedenje opažamo in preučujemo šele zdaj zaradi tega, kako veliki so ti modeli postali. Veliki jezikovni modeli se urijo z analizo ogromnih podatkovni nizi besedila — besede iz spletnih virov, vključno s knjigami, spletnimi iskanji in Wikipedijo — ter iskanje povezav med besedami, ki se pogosto pojavljajo skupaj. Velikost se meri v smislu parametrov, približno analogno vsem načinom povezovanja besed. Več kot je parametrov, več povezav lahko najde LLM. GPT-2 je imel 1.5 milijarde parametrov, medtem ko GPT-3.5, LLM, ki poganja ChatGPT, uporablja 350 milijard. GPT-4, ki je bil predstavljen marca 2023 in je zdaj podlaga za Microsoft Copilot, menda uporablja 1.75 bilijona.

Ta hitra rast je prinesla presenetljivo povečanje zmogljivosti in učinkovitosti in nihče ne oporeka temu, da lahko dovolj veliki LLM dokončajo naloge, ki jih manjši modeli ne zmorejo, vključno s tistimi, za katere niso bili usposobljeni. Trio na Stanfordu, ki je nastanek označil za »privid«, priznava, da LLM postanejo učinkovitejši, ko se povečujejo; pravzaprav, dodatna kompleksnost večjih modelov naj bi omogočilo boljše reševanje težjih in raznolikih problemov. Toda trdijo, da ne glede na to, ali je ta izboljšava videti gladka in predvidljiva ali nazobčana in ostra, je rezultat izbire metrike - ali celo pomanjkanja testnih primerov - in ne notranjega delovanja modela.

Primer je trimestno seštevanje. V študiji BIG-bench iz leta 2022 so raziskovalci poročali, da z manj parametri tako GPT-3 kot drug LLM z imenom LAMDA nista uspela natančno dokončati težav pri dodajanju. Ko pa se je GPT-3 usposabljal s 13 milijardami parametrov, se je njegova sposobnost spremenila, kot da bi s pritiskom na stikalo. Nenadoma bi lahko dodal - in tudi LAMDA bi lahko pri 68 milijardah parametrov. To nakazuje, da se zmožnost dodajanja pojavi pri določenem pragu.

Toda raziskovalci s Stanforda poudarjajo, da so bili LLM-ji ocenjeni samo na podlagi natančnosti: bodisi so to lahko naredili odlično ali pa ne. Tudi če je LLM pravilno predvidel večino števk, ni uspelo. To se mi ni zdelo prav. Če računate 100 plus 278, potem se zdi 376 veliko natančnejši odgovor kot na primer −9.34.

Namesto tega so Koyejo in njegovi sodelavci preizkusili isto nalogo z uporabo metrike, ki dodeljuje delne kredite. »Lahko se vprašamo: Kako dobro napove prvo števko? Potem drugi? Potem tretji?" rekel je.

Koyejo je idejo za novo delo pripisal svojemu podiplomskemu študentu Rylanu Schaefferju, ki je po njegovih besedah opazil, da se zdi, da se uspešnost LLM spreminja glede na to, kako se merijo njegove sposobnosti. Skupaj z Brandom Mirando, še enim podiplomskim študentom Stanforda, sta izbrala nove metrike, ki kažejo, da z večanjem parametrov magistri študija napovedujejo vse bolj pravilno zaporedje števk v težavah z dodajanjem. To nakazuje, da zmožnost dodajanja ni nastajajoča – kar pomeni, da je podvržena nenadnemu, nepredvidljivemu skoku – ampak postopna in predvidljiva. Ugotovijo, da z drugo merilno palico nastanek izgine.

Predstavitev

Toda drugi znanstveniki poudarjajo, da delo ne ovrže v celoti ideje o nastanku. Prispevek trojice na primer ne pojasnjuje, kako predvideti, kdaj ali katere meritve bodo pokazale nenadno izboljšanje LLM, je dejal Tianshi Li, računalničar na Northeastern University. "Torej so v tem smislu te sposobnosti še vedno nepredvidljive," je dejala. Drugi, kot je Jason Wei, računalniški znanstvenik, zdaj pri OpenAI, ki je sestavil seznam nastajajočih sposobnosti in je bil avtor na BIG-bench paper, so trdili da so bila prejšnja poročila o pojavu utemeljena, ker je za sposobnosti, kot je aritmetika, resnično pomemben le pravi odgovor.

"Vsekakor se obeta zanimiv pogovor," je rekel Alex Tamkin, raziskovalec pri startupu AI Anthropic. Novi dokument spretno razčleni večstopenjske naloge, da prepozna prispevke posameznih komponent, je dejal. »Toda to ni celotna zgodba. Ne moremo reči, da so vsi ti skoki fatamorgana. Še vedno menim, da literatura kaže, da tudi če imate enostopenjske napovedi ali uporabljate neprekinjene meritve, še vedno imate prekinitve in ko povečate velikost svojega modela, lahko še vedno vidite, da postaja boljši na skokovit način.«

In četudi je nastanek današnjih LLM mogoče razložiti z različnimi merilnimi orodji, to verjetno ne bo veljalo za jutrišnje večje, bolj zapletene LLM. "Ko bomo LLM dvignili na naslednjo raven, si bodo neizogibno izposodili znanje iz drugih nalog in drugih modelov," je dejal Xia »Ben« Hu, računalniški znanstvenik na univerzi Rice.

To razvijajoče se razmišljanje o nastanku ni le abstraktno vprašanje, ki bi ga raziskovalci morali upoštevati. Za Tamkina govori neposredno o nenehnih prizadevanjih za napovedovanje, kako se bodo LLM obnašali. "Te tehnologije so tako široke in tako uporabne," je dejal. »Upam, da bo skupnost to uporabila kot izhodiščno točko kot nadaljnji poudarek na tem, kako pomembno je zgraditi znanost o napovedovanju teh stvari. Kako naj nas ne preseneti naslednja generacija modelov?«

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://www.quantamagazine.org/how-quickly-do-large-language-models-learn-unexpected-skills-20240213/

- :ima

- : je

- :ne

- ][str

- $GOR

- 1

- 100

- 13

- 2022

- 2023

- 204

- 350

- 75

- a

- sposobnosti

- sposobnost

- POVZETEK

- natančnost

- natančna

- natančno

- dodajte

- dodano

- Poleg tega

- Avgust

- AI

- vsi

- an

- analiziranje

- in

- Še ena

- odgovor

- Antropično

- zdi

- primerno

- SE

- trdijo

- okoli

- AS

- vprašati

- At

- Avgust

- Avtor

- Avtorji

- Nagrade

- stran

- BE

- ker

- postanejo

- vedenje

- vedenja

- Boljše

- med

- Billion

- knjige

- sposodim

- tako

- odmori

- široka

- prinesel

- izgradnjo

- vendar

- by

- izračun

- se imenuje

- CAN

- Zmogljivosti

- primeru

- nekatere

- spremenite

- spremenilo

- klepetalnice

- ChatGPT

- izbira

- Izberite

- izbral

- terjatve

- sodelavci

- Kolektivna

- skupnost

- zbranih

- dokončanje

- kompleksnost

- zapleten

- deli

- računalnik

- povezane

- povezave

- Posledica

- Razmislite

- premislek

- naprej

- neprekinjeno

- prispevkov

- Pogovor

- pogovorov

- popravi

- pravilno

- bi

- kredit

- krediti

- debutiral

- vsekakor

- opisano

- opisuje

- zasnovan

- drugačen

- težko

- števk

- neposredno

- razne

- do

- ne

- Ne

- tem

- navzdol

- prej

- Učinkovito

- učinkovitost

- prizadevanja

- bodisi

- pojav

- nastane

- Poudarek

- ogromno

- dovolj

- Tudi

- razvija

- Primer

- Primeri

- Pojasnite

- razložiti

- Dejstvo

- ni uspelo

- Moda

- manj

- Najdi

- iskanje

- prva

- Flip

- za

- je pokazala,

- iz

- polno

- v celoti

- igra

- generacija

- dobili

- pridobivanje

- Daj

- prisodil

- postopno

- diplomiral

- Grow

- Rast

- imel

- Imajo

- he

- tukaj

- visoka

- njegov

- upam,

- Kako

- Kako

- Vendar

- HTML

- HTTPS

- i

- ICE

- Ideja

- if

- Pomembno

- izboljšalo

- Izboljšanje

- in

- Vključno

- Povečajte

- povečal

- vedno

- individualna

- neizogibno

- obvesti

- notranja

- Namesto

- Zanimivo

- v

- IT

- ITS

- presojalo

- skoči

- Skočil

- Skoki

- samo

- znanje

- jezik

- velika

- večja

- skoki

- UČITE

- Stopnja

- kot

- Verjeten

- Povezave

- Tekočina

- Seznam

- literatura

- LLM

- POGLEDI

- revije

- Znamka

- marec

- Zadeve

- Maj ..

- kar pomeni,

- merjenje

- merjenje

- meritev

- Meritve

- Microsoft

- Model

- modeli

- več

- Najbolj

- veliko

- Imenovan

- Blizu

- Niti

- Novo

- Naslednja

- št

- Northeastern University

- opozoriti

- Pojem

- zdaj

- of

- Ponudbe

- pogosto

- on

- enkrat

- ONE

- tiste

- v teku

- na spletu

- samo

- OpenAI

- or

- Ostalo

- drugi

- ven

- Papir

- parametri

- ljudje

- popolnoma

- performance

- faza

- Fizika

- platon

- Platonova podatkovna inteligenca

- PlatoData

- plus

- Točka

- mogoče

- potencial

- moč

- Pooblastila

- napovedati

- Predvidljivo

- napovedano

- napoved

- Napovedi

- Težave

- Projekt

- objavljeno

- Quantamagazine

- vprašanje

- hitro

- hitro

- precej

- Doseže

- res

- priznajo

- ostalo

- Prijavljeno

- domnevno

- Poročila

- Raziskave

- raziskovalci

- Rezultati

- Riž

- Pravica

- Tveganje

- grobo

- Varnost

- Je dejal

- Enako

- pravijo,

- Lestvica

- pomanjšana

- Znanost

- Znanstvenik

- Znanstveniki

- iskanja

- drugi

- glej

- videnje

- zdi se

- Zdi se,

- višji

- Občutek

- Zaporedje

- oster

- je

- shouldnt

- Prikaži

- Prikaz

- Razstave

- Podoben

- Enostavno

- Velikosti

- spretnosti

- manj

- nemoteno

- gladko

- So

- zvok

- Viri

- Govori

- Stanford

- Univerza Stanford

- zagon

- Še vedno

- Zgodba

- študent

- Študije

- študija

- Študij

- taka

- nenadoma

- Predlaga

- prenapetost

- presenečen

- presenetljivo

- Preklop

- sistem

- Naloga

- Naloge

- Tehnologije

- Pogoji

- Test

- Testiran

- kot

- da

- O

- POTEM

- te

- jih

- stvari

- mislim

- tretja

- ta

- Prag

- do

- današnje

- skupaj

- tudi

- orodja

- Vlak

- usposobljeni

- Prehod

- Bilijona

- Trio

- podvrže

- Nepričakovana

- univerza

- nepredvidljivo

- uporaba

- uporablja

- uporabo

- je

- Voda

- način..

- načini

- we

- web

- webp

- Dobro

- so bili

- Kaj

- kdaj

- ali

- ki

- medtem

- WHO

- Wikipedia

- bo

- z

- beseda

- besede

- delo

- dela

- bi

- let

- Vi

- Vaša rutina za

- zefirnet

- nič