Podatki uporabnikov: LLMs’ Vital Food

ja! RT @bryce všeč mi je ta citat »Če za to ne plačate, niste stranka; vi ste izdelek, ki se prodaja." http://bit.ly/93JYCJ

— Tim O'Reilly (@timoreilly) September 2, 2010

Bodite na tekočem s kripto novicami, prejemajte dnevne posodobitve v svoj nabiralnik.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- :ima

- : je

- :ne

- 7

- 8

- a

- sposobnost

- absolutna

- Po

- natančna

- prilagajanje

- naslavljanje

- Dodaja

- napredno

- Avgust

- se strinja

- AI

- Storitve AI

- AI sistemi

- Cilje

- Alexa

- Poravnava

- vsi

- omogoča

- Prav tako

- vedno

- Amazon

- an

- in

- Antropično

- pričakujte

- kaj

- primerno

- SE

- AS

- domnevati

- At

- Na voljo

- izogibanje

- zaveda

- temeljijo

- BE

- ker

- počutje

- Menimo

- koristno

- Boljše

- med

- by

- CAN

- terjatve

- stranke

- komercialna

- Zaveza

- se zavezuje

- Podjetja

- podjetje

- konkurenčno

- Koncept

- Skrbi

- nenehno

- vsebina

- ozadje

- stalno

- nadzor

- Priročen

- pogovorov

- avtorske pravice

- bi

- ključnega pomena

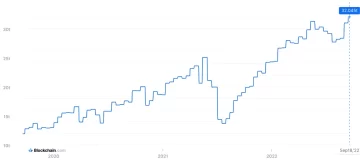

- kripto

- Kripto novice

- Trenutna

- stranka

- Stranke, ki so

- vsak dan

- Temnomodra

- datum

- zasebnost podatkov

- Razprava

- desetletja

- Dešifriraj

- globoko

- globoko učenje

- privzeto

- Obramba

- dostavo

- odvisno

- zavrača

- spori

- raznolikost

- do

- dokument

- ne

- dolarjev

- dont

- med

- Zaslužek

- Edge

- učinkovitost

- bodisi

- sodelovanje

- izboljšanje

- zagotavlja

- bistvena

- etično

- etika

- Primer

- Izmenjava

- izkušnje

- obsežen

- obseg

- zunanja

- s katerimi se sooča

- za

- Nekdanji

- Ustanovljeno

- brezplačno

- iz

- pridobivanje

- ustvarjajo

- ustvarila

- ustvarja

- generativno

- Generativna AI

- dobili

- pridobivanje

- velikani

- Daj

- Go

- odobri

- prijem

- raste

- močno

- pošten

- čast

- Vendar

- http

- HTTPS

- človeškega

- ideale

- if

- izboljšanje

- in

- individualna

- Podatki

- intelektualne

- intelektualne lastnine

- namere

- interakcije

- notranji

- IP

- IT

- ITS

- sam

- Ključne

- jezik

- velika

- Zadnji

- zakon

- vodi

- UČITE

- učenje

- Pravne informacije

- Vzvod

- kot

- Llama

- LLM

- ljubezen

- Znamka

- Izdelava

- Maj ..

- mediji

- Meta

- milijoni

- Model

- modeli

- več

- Najbolj

- omrežij

- Živčne

- nevronske mreže

- Novo

- novice

- pridobitev

- of

- on

- OpenAI

- or

- domnevno

- drugače

- naši

- ven

- izhodi

- več

- lastne

- lastnik

- plačana

- Stranke

- zabava

- vzorci

- Plačajte

- plačilna

- Osebni

- personalizacija

- Prilagojene

- slike

- platon

- Platonova podatkovna inteligenca

- PlatoData

- politika

- potencial

- moč

- močan

- vaje

- napovedati

- Napovedi

- nastavitve

- prevladujoč

- zasebnost

- zasebna

- Proizvedeno

- Izdelek

- pozove

- nepremičnine

- zagotavljajo

- zagotavlja

- javnega

- zaupanje javnosti

- javno

- kvota

- racing

- RE

- resnični svet

- prejme

- izboljšati

- obravnavajo

- relativna

- sprostitev

- pomembno

- Prijavljeno

- zahteva

- raziskovalci

- odgovorna

- Razkrito

- pravice

- tekmecev

- rt

- Ryan

- s

- pravijo,

- pravi

- Prizor

- Storitev

- Storitve

- nastavite

- Delite s prijatelji, znanci, družino in partnerji :-)

- shouldnt

- Skepticizem

- So

- socialna

- družbeni mediji

- prodaja

- ČAROV

- Tiskovni predstavnik

- zagon

- Izjava

- bivanje

- Korak

- sistemi

- Tandem

- tech

- tehnični velikani

- tehnike

- Pogoji

- besedilo

- da

- O

- njihove

- Njih

- te

- jih

- ta

- Tim

- do

- danes

- vrh

- Vlak

- usposobljeni

- usposabljanje

- Preglednost

- Trends

- Zaupajte

- pod

- razumeli

- razumevanje

- prihajajoče

- posodobljeno

- posodobitve

- nadgrajen

- naložili

- uporaba

- Rabljeni

- uporabnik

- Uporabniki

- uporabo

- dragocene

- različnih

- različica

- Video posnetki

- ključnega pomena

- Voice

- Obseg

- je

- we

- so bili

- kdaj

- ali

- ki

- zakaj

- bo

- z

- beseda

- bi

- Vi

- Vaša rutina za

- zefirnet