Organizacije uporabljajo storitve strojnega učenja (ML) in AI za izboljšanje uporabniške izkušnje, zmanjšanje operativnih stroškov in odklepanje novih možnosti za izboljšanje poslovnih rezultatov. Podatki podpirajo primere uporabe ML in AI in so strateška prednost organizacije. Ker podatki rastejo z eksponentno hitrostjo, si organizacije prizadevajo vzpostaviti integrirano, stroškovno učinkovito in zmogljivo podatkovno platformo za predhodno obdelavo podatkov, izvajanje inženiringa funkcij ter gradnjo, usposabljanje in operacionalizacijo modelov ML v velikem obsegu. Da bi to dosegli, AWS ponuja enotno sodobno podatkovno platformo, ki jo poganja Preprosta storitev shranjevanja Amazon (Amazon S3) kot podatkovno jezero z namensko izdelanimi orodji in procesorji za podporo analitiki in delovnim obremenitvam ML. Za enotno izkušnjo ML lahko uporabite Amazon SageMaker Studio, ki ponuja izvorna integracija z interaktivnimi sejami AWS Glue za izvajanje inženiringa funkcij v velikem obsegu z zaščito občutljivih podatkov. V tej objavi prikazujemo, kako implementirati to rešitev.

Amazon SageMaker je v celoti upravljana storitev ML, ki vam omogoča gradnjo, usposabljanje in uvajanje modelov v velikem obsegu za širok nabor primerov uporabe. Za usposabljanje modelov lahko uporabite katerega koli od vgrajeni algoritmi znotraj SageMakerja, da hitro začnete z usposabljanjem in uvajanjem modelov ML.

Ključna komponenta procesa gradnje in razvoja modela je inženiring funkcij. AWS lepilo je ena od priporočenih možnosti za doseganje inženiringa funkcij v velikem obsegu. AWS Glue vam omogoča izvajanje integracije in transformacije podatkov na porazdeljen način na brezstrežniški infrastrukturi Apache Spark in olajša uporabo priljubljene knjižnice Spark ML za inženiring funkcij in razvoj modelov. Poleg tega lahko uporabite AWS Glue za inkrementalno obdelavo podatkov prek delovni zaznamki, prejemajte podatke iz več kot 100 virov z uporabo priključki, in izvajajte nenadne ali nepredvidljive delovne obremenitve z uporabo samodejno skaliranje.

Druga pomembna zahteva za aplikacije, ki temeljijo na ML, je varnost podatkov in nadzor dostopa. Običajna zahteva je strožji nadzor nad tem, kdo lahko dostopa do najobčutljivejših podatkov kot del procesa inženiringa funkcij in gradnje modela z upoštevanjem načela dostopa z najmanjšimi pravicami. Če želite to doseči, lahko uporabite integracijo AWS Glue z Oblikovanje jezera AWS za povečano upravljanje in upravljanje sredstev podatkovnega jezera. Z Lake Formation lahko konfigurirate natančen nadzor dostopa do podatkov in varnostne politike na vrhu podatkovnega jezera Amazon S3. Politike so definirane na osrednji lokaciji, kar omogoča več analitičnih storitev in storitev ML, kot je AWS Glue, Amazonska Atenain SageMaker za interakcijo s podatki, shranjenimi v Amazon S3.

AWS Glue vključuje a odkrivanje osebno določljivih podatkov (PII). preoblikovanje, ki omogoča odkrivanje, maskiranje ali odstranjevanje entitet, kot je potrebno, za večjo skladnost in upravljanje. S pretvorbo PII lahko zaznate podatke PII v naborih podatkov in samodejno uporabite natančen nadzor dostopa z uporabo Lake Formation, da omejite občutljive podatke za različne skupine uporabnikov.

Uporaba primera

Osredotočeni smo na primer uporabe modela nagnjenosti, ki vključuje nabor podatkov o trženju strank in vključuje dve uporabniški osebi: podatkovnega inženirja in podatkovnega znanstvenika. Nabor podatkov vsebuje informacije za posamezne stranke, vključno z virom potencialnih strank, kontaktnimi opombami, delovno vlogo, nekaterimi oznakami, ogledi strani na obisk in še več. Nabor podatkov vključuje tudi občutljive podatke, kot so osebne telefonske številke.

Podatkovni inženir je odgovoren za izgradnjo cevovoda za obdelavo podatkov od konca do konca, vključno s pripravo podatkov, predprocesiranjem in nadzorom dostopa. Podatkovni znanstvenik je odgovoren za inženiring funkcij ter usposabljanje in uvajanje modela ML. Upoštevajte, da podatkovni znanstvenik ne sme dostopati do občutljivih podatkov PII za inženiring funkcij ali usposabljanje modela ML.

Kot del tega primera uporabe podatkovni inženir zgradi podatkovni cevovod za predhodno obdelavo nabora podatkov, pregleda nabor podatkov za vse informacije, ki omogočajo osebno prepoznavo, in omeji dostop do stolpca PII uporabniku podatkovnega znanstvenika. Posledično, ko podatkovni znanstvenik uporablja nabor podatkov za izvajanje inženiringa funkcij in izdelavo modelov ML, nima dostopa do občutljivega stolpca PII (v tem primeru telefonske številke). Postopek inženiringa funkcij vključuje pretvorbo stolpcev vrste niz v obliko, ki je optimalna za modele ML. Kot napreden primer uporabe lahko razširite ta vzorec dostopa za implementacijo varnosti na ravni vrstice in celice z uporabo Lake Formation.

Pregled rešitev

Rešitev vsebuje naslednje korake na visoki ravni:

- Nastavite vire z Oblikovanje oblaka AWS.

- Vnaprej obdelajte nabor podatkov, vključno z odkrivanjem PII in podrobnim nadzorom dostopa, v interaktivni seji AWS Glue.

- Izvedite inženiring funkcij na interaktivni seji AWS Glue.

- Usposobite in uvedite model ML z uporabo algoritma XGBoost, vgrajenega v SageMaker.

- Ocenite model ML.

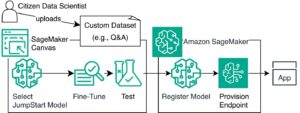

Naslednji diagram prikazuje arhitekturo rešitev.

Predpogoji

Če želite dokončati to vadnico, morate imeti naslednje predpogoje:

Nastavite vire z AWS CloudFormation

Ta objava vključuje predlogo CloudFormation za hitro nastavitev. Lahko ga pregledate in prilagodite svojim potrebam. Če raje nastavite vire na Konzola za upravljanje AWS in AWS CLI namesto AWS CloudFormation, si oglejte navodila v dodatku na koncu te objave.

Predloga CloudFormation ustvari naslednje vire:

- Vedra S3 z vzorčnim naborom podatkov

- An AWS Lambda funkcijo za nalaganje nabora podatkov

- AWS upravljanje identitete in dostopa (IAM), uporabniki, vloge in pravilniki

- Nastavitve in dovoljenja podatkovnega jezera Lake Formation

- Uporabniški profili SageMaker

Če želite ustvariti vire, izvedite naslednje korake:

- Prijavite se v konzolo.

- Izberite Izstrelite sklad:

- Izberite Naslednji.

- za DataEngineerPwd in DataScientistPwd, vnesite svoje geslo za uporabnike podatkovnega inženirja in podatkovnega znanstvenika.

- za GlueDatabaseName, vnesite

demo. - za GlueTableName, vnesite

web_marketing. - za S3BucketNameForInput, vnesite

blog-studio-pii-dataset-. - za S3BucketNameForOutput, vnesite

blog-studio-output-. - za SageMakerDomainId, vnesite svoj ID domene SageMaker, ki ste ga pripravili v predpogojnih korakih.

- Izberite Naslednji.

- Na naslednji strani izberite Naslednji.

- Preglejte podrobnosti na zadnji strani in izberite Priznavam, da lahko AWS CloudFormation ustvari vire IAM.

- Izberite ustvarjanje.

Ustvarjanje sklada lahko traja do 10 minut. Sklad ustvari vloge IAM in uporabniške profile SageMaker za dve osebi: podatkovnega inženirja in podatkovnega znanstvenika. Ustvari tudi predstavitev baze podatkov in tabelo web_marketing z vzorčnim naborom podatkov.

V času ustvarjanja sklada ima oseba podatkovnega inženirja popoln dostop do tabele, osebnost podatkovnega znanstvenika pa še nima dostopa do tabele.

Vnaprej obdelajte nabor podatkov

Začnimo s predhodno obdelavo podatkov v interaktivni seji AWS Glue. Oseba podatkovnega inženirja želi preveriti podatke, da ugotovi, ali obstajajo občutljivi podatki ali ne, in podeliti minimalno dovoljenje za dostop osebi podatkovnega znanstvenika. Zvezek lahko prenesete iz tej lokaciji.

- Prijavite se v konzolo z uporabnikom data-engineer.

- Na konzoli SageMaker izberite uporabniki.

- Izberite uporabnika podatkovnega inženirja in izberite Odprti studio.

- Ustvarite nov zvezek in izberite SparkAnalytics 1.0 za Image in Lepilo PySpark za Kernel.

- Začnite interaktivno sejo z naslednjo čarovnijo, da namestite novejšo različico Boto3 (to je potrebno za uporabo

create_data_cells_filtermetoda): - Inicializacija seje:

- Ustvarite AWS Glue DynamicFrame iz novo ustvarjene tabele in razrešite vrste izbire na podlagi kataloške sheme, ker želimo uporabiti shemo, definirano v katalogu, namesto samodejno ugotovljene sheme na podlagi podatkov:

- V tabeli preverite, ali obstajajo podatki PII z zaznavanjem PII AWS Glue:

- Preverite, ali stolpci, razvrščeni kot PII, vsebujejo občutljive podatke ali ne (če ne, posodobite classified_map, da izpustite neobčutljive stolpce):

- Nastavite dovoljenja Lake Formation z uporabo filtra podatkovnih celic za samodejno zaznane stolpce in omejite stolpce na osebo podatkovnega znanstvenika:

- Prijavite se v Studio kot podatkovni znanstvenik in preverite, ali stolpci PII niso vidni. Zvezek lahko prenesete iz tej lokaciji.

- Ustvarite nov zvezek in izberite SparkAnalytics 1.0 za Image in Lepilo PySpark za Kernel:

Izvedite inženiring funkcij

Knjižnico Apache Spark ML uporabljamo za izvajanje inženiringa funkcij kot uporabnik podatkovnega znanstvenika in nato zapišemo izhod v Amazon S3.

- V naslednji celici uporabimo funkcije iz Knjižnica Apache Spark ML:

StringIndexerpreslika nizovni stolpec oznak v stolpec indeksov oznak.OneHotEncoderpreslika kategorično značilnost, predstavljeno kot indeks oznake, v binarni vektor z največ eno samo eno vrednostjo, ki označuje prisotnost določene kategorične značilnosti. Ta transformacija se uporablja za algoritme ML, ki pričakujejo neprekinjene funkcije.VectorAssemblerje transformator, ki združuje dani seznam stolpcev v en sam vektorski stolpec, ki se nato uporablja pri usposabljanju modelov ML za algoritme, kot so logistična regresija in drevesa odločanja.

- Končni transformirani DataFrame je mogoče ustvariti s knjižnico Pipeline. Cevovod je določen kot zaporedje stopenj. Te stopnje potekajo po vrstnem redu in vhodni DataFrame se preoblikuje, ko gre skozi vsako stopnjo.

- Nato razdelimo nabor podatkov v DataFrame za usposabljanje, validacijo in testiranje ter ga shranimo v vedro S3 za usposabljanje modela ML (v naslednji kodi vnesite ID računa AWS):

Usposobite in uvedite model ML

V prejšnjem razdelku smo dokončali inženiring funkcij, ki je vključeval pretvorbo stolpcev nizov, kot je npr region, jobrolein usedpromo v obliko, ki je optimalna za modele ML. Vključili smo tudi rubrike kot npr pageviewspervisit in totalwebvisits, ki nam bo pomagal predvideti nagnjenost stranke k nakupu izdelka.

Zdaj usposabljamo model ML z branjem nabora podatkov o usposabljanju in validaciji z uporabo algoritma XGBoost, ki je vgrajen v SageMaker. Nato razmestimo model in izvedemo preverjanje točnosti. Zvezek lahko prenesete iz tej lokaciji.

V naslednji celici beremo podatke iz drugega vedra S3, ki vključuje rezultate naših operacij inženiringa funkcij. Nato uporabimo vgrajeni algoritem XGBoost za usposabljanje modela.

- Odprite nov zvezek. Izberite Znanost podatki za Image in Python 3 za Kernel (vnesite ID računa AWS v naslednjo kodo):

- Ko je usposabljanje končano, lahko uvedemo model z uporabo storitev gostovanja SageMaker:

Ocenite model ML

Testni nabor podatkov uporabljamo za ovrednotenje modela in izbrišemo končno točko sklepanja, ko končamo, da se izognemo kakršnim koli tekočim bremenitvam.

- Ocenite model z naslednjo kodo:

Rezultat točnosti vzorca je bil 84.6 %. Zaradi naključne razdelitve nabora podatkov je to lahko nekoliko drugačno za vaš tek.

- Končno točko sklepanja lahko izbrišemo z naslednjo kodo:

Čiščenje

Zdaj pa k zadnjemu koraku, čiščenju virov.

- Izpraznite dve vedri, ustvarjeni prek sklada CloudFormation.

- Izbrišite aplikacije, povezane z uporabnikom

profiles data-scientistindata-engineerznotraj Studia. - Izbrišite sklad CloudFormation.

zaključek

V tej objavi smo prikazali rešitev, ki osebam, kot so podatkovni inženirji in podatkovni znanstveniki, omogoča izvajanje inženiringa funkcij v velikem obsegu. Z interaktivnimi sejami AWS Glue lahko enostavno dosežete inženiring funkcij v velikem obsegu s samodejnim zaznavanjem PII in natančnim nadzorom dostopa, ne da bi morali upravljati kakršno koli osnovno infrastrukturo. Če uporabljate Studio kot enotno vstopno točko, lahko dobite poenostavljeno in integrirano izkušnjo za izgradnjo celovitega poteka dela ML: od priprave in zavarovanja podatkov do gradnje, usposabljanja, prilagajanja in uvajanja modelov ML. Če želite izvedeti več, obiščite Začetek uporabe interaktivnih sej AWS Glue in Amazon SageMaker Studio.

Zelo smo navdušeni nad to novo zmogljivostjo in želimo videti, kaj boste z njo zgradili!

Dodatek: Nastavite vire prek konzole in AWS CLI

Izpolnite navodila v tem razdelku za nastavitev virov s konzolo in AWS CLI namesto predloge CloudFormation.

Predpogoji

Če želite dokončati to vadnico, morate imeti dostop do AWS CLI (glejte Začetek uporabe AWS CLI) ali uporabite dostop do ukazne vrstice iz AWS CloudShell.

Konfigurirajte skupino IAM, uporabnike, vloge in pravilnike

V tem razdelku ustvarimo dva uporabnika IAM: data-engineer in data-scientist, ki pripadata skupini IAM data-platform-group. Nato v skupino IAM dodamo eno samo politiko IAM.

- Na konzoli IAM, ustvarite pravilnik na zavihku JSON za ustvarjanje novega pravilnika, ki ga upravlja IAM z imenom

DataPlatformGroupPolicy. Pravilnik dovoljuje uporabnikom v skupini dostop do programa Studio, vendar le z uporabo uporabniškega profila SageMaker z oznako, ki se ujema z njihovim uporabniškim imenom IAM. Za zagotavljanje dovoljenj uporabite naslednji dokument pravilnika JSON: - Ustvarite skupino IAM se imenuje

data-platform-group. - Poiščite in skupini priložite upravljano politiko AWS z imenom DataPlatformGroupPolicy.

- Ustvarite uporabnike IAM imenovan podatkovni inženir in podatkovni znanstvenik v skupini IAM data-platform-group.

- Ustvarite nov upravljani pravilnik z imenom SageMakerExecutionPolicy (vnesite svojo regijo in ID računa v naslednji kodi):

- Ustvarite nov upravljani pravilnik imenovan

SageMakerAdminPolicy: - Ustvari IAM vlogo za SageMaker za podatkovnega inženirja (data-engineer), ki se uporablja kot ustrezna izvršilna vloga uporabniškega profila. Na Priloži pravilnik o dovoljenjih strani, je privzeto priložen AmazonSageMakerFullAccess (pravilnik, ki ga upravlja AWS). Ta pravilnik pozneje odstranite, da ohranite minimalne privilegije.

- za Ime vloge, za poimenovanje vloge SageMakerStudioExecutionRole_data-engineer uporabite dogovor o poimenovanju, predstavljen na začetku tega razdelka.

- za oznake, dodajte ključ userprofilename in vrednost data-engineer.

- Izberite Ustvari vlogo.

- Če želite dodati preostale politike, na vloge izberite ime vloge, ki ste jo pravkar ustvarili.

- Pod Dovoljenja, odstranite pravilnik AmazonSageMakerFullAccess.

- o Priloži pravilnik o dovoljenjih izberite pravilnik AWS AwsGlueSessionUserRestrictedServiceRole ter pravilnika SageMakerExecutionPolicy in SageMakerAdminPolicy, ki ste ju ustvarili.

- Izberite Priložite pravilnike.

- spreminjanje zaupni odnos vaše vloge:

- Ustvari IAM vlogo za SageMaker za podatkovnega znanstvenika (data-scientist), ki se uporablja kot ustrezna izvršilna vloga uporabniškega profila.

- za Ime vloge, poimenujte vlogo SageMakerStudioExecutionRole_data-scientist.

- za oznake, dodajte ključ userprofilename in vrednost data-scientist.

- Izberite Ustvari vlogo.

- Če želite dodati preostale politike, na vloge izberite ime vloge, ki ste jo pravkar ustvarili.

- Pod Dovoljenja, odstranite pravilnik AmazonSageMakerFullAccess.

- o Priloži pravilnik o dovoljenjih izberite pravilnik, ki ga upravlja AWS, AwsGlueSessionUserRestrictedServiceRole, in pravilnik, ki ga upravlja stranka, SageMakerExecutionPolicy, ki ste ga ustvarili.

- Izberite Priložite pravilnike.

- spreminjanje zaupni odnos vaše vloge:

Konfigurirajte uporabniške profile SageMaker

Če želite ustvariti svoje uporabniške profile SageMaker z studiouserid oznako, izvedite naslednje korake:

- Uporabite AWS CLI ali CloudShell, da ustvarite uporabniški profil Studio za podatkovnega inženirja (vnesite ID svojega računa in ID domene Studio v naslednji kodi):

- Ponovite korak, da ustvarite uporabniški profil za podatkovnega znanstvenika, pri čemer zamenjate ID računa in ID domene Studio:

Ustvarite vedra S3 in naložite vzorčni nabor podatkov

V tem razdelku ustvarite dve vedri S3. Prvo vedro vsebuje vzorčni nabor podatkov, povezanih s spletnim trženjem. Drugo vedro podatkovni znanstvenik uporablja za shranjevanje rezultatov nalog inženiringa funkcij, ta izhodni nabor podatkov pa se uporablja za usposabljanje modela ML.

Najprej ustvarite vedro S3 za vhodne podatke:

- Prenos nabor podatkov.

- Na konzoli Amazon S3 izberite Žlice v podoknu za krmarjenje.

- Izberite Ustvari vedro.

- za Regija, izberite regijo z domeno SageMaker, ki vključuje uporabniške profile, ki ste jih ustvarili.

- za Ime vedra, vnesite

blog-studio-pii-dataset-. - Izberite Ustvari vedro.

- Izberite vedro, ki ste ga ustvarili, in izberite Pošiljanje.

- v izberite datoteke oddelek, izberite Dodaj datoteke in naložite nabor podatkov, ki ste ga prenesli.

Zdaj ustvarite vedro za izhodne podatke: - o Žlice stran, izberite Ustvari vedro.

- za Regija, izberite regijo z domeno SageMaker, ki vključuje uporabniške profile, ki ste jih ustvarili.

- za Ime vedra, vnesite

blog-studio-output-. - Izberite Ustvari vedro.

Ustvarite bazo podatkov in tabelo AWS Glue

V tem razdelku ustvarite zbirko podatkov AWS Glue in tabelo za nabor podatkov.

- Na konzoli Lake Formation pod Katalog podatkov v podoknu za krmarjenje izberite Baze podatkov.

- Izberite Dodaj bazo podatkov.

- za Ime, vnesite demo.

- Izberite Ustvarite bazo podatkov.

- Pod Katalog podatkov, izberite Mize.

- za Ime, vnesite

web_marketing. - za Baze podatkovtako, da izberete

demo. - za Vključi pot, vnesite pot vašega vedra S3 za vhodne podatke.

- za Razvrstitev, izberite CSV.

- Pod Shema, izberite Naloži shemo.

- V besedilno polje vnesite naslednjo matriko JSON:

- Izberite Pošiljanje.

- Izberite Prijave se.

- Pod Podrobnosti tabele, izberite Uredi tabelo.

- Pod Lastnosti tabele, izberite Dodaj.

- za Ključne, vnesite

skip.header.line.countIn za vrednost, vnesite 1. - Izberite Shrani.

Konfigurirajte dovoljenja Lake Formation

V tem razdelku nastavite dovoljenja Lake Formation, da omogočite vlogo IAM SageMakerStudioExecutionRole_data-engineer ustvariti bazo podatkov in registrirati lokacijo S3 znotraj jezerske formacije.

Najprej registrirajte lokacijo podatkovnega jezera za upravljanje tabel pod lokacijo v dovoljenjih Lake Formation:

- Izberite Lokacije podatkovnega jezera.

- Izberite Registriraj lokacijo.

- za Pot Amazon S3, vnesite

s3://blog-studio-pii-dataset-/(vedro, ki vsebuje nabor podatkov). - Izberite Registriraj lokacijo.

Zdaj vlogam IAM dodelite dovoljenja baze podatkov in tabel Lake FormationSageMakerStudioExecutionRole_data-engineerinSageMakerStudioExecutionRole_data-scientist.Najprej podelite dovoljenje za bazo podatkov zaSageMakerStudioExecutionRole_data-engineer: - Pod Dovoljenja, izberite Dovoljenja podatkovnega jezera.

- Pod Dovoljenje za podatke, izberite Grant.

- za Ravnatelji, izberite Uporabniki in vloge IAMin izberite vlogo

SageMakerStudioExecutionRole_data-engineer. - za Oznake pravilnika ali viri kataloga, izberite Viri imenskega kataloga podatkov.

- za Baze podatkov, izberite demo.

- za Dovoljenja baze podatkov, izberite Super.

- Izberite Grant.

Nato dodelite dovoljenje za tabeloSageMakerStudioExecutionRole_data-engineer: - Pod Dovoljenje za podatke, izberite Grant.

- za Ravnatelji, izberite Uporabniki in vloge IAMin izberite vlogo

SageMakerStudioExecutionRole_data-engineer. - za Oznake pravilnika ali viri kataloga, izberite Viri imenskega kataloga podatkov.

- za Baze podatkov, izberite

demo. - za Mize, izberite

web_marketing. - za Tabela dovoljenja, izberite Super.

- za Dopustno dovoljenja, izberite Super.

- Izberite Grant.

Končno podelite dovoljenje za bazo podatkov zaSageMakerStudioExecutionRole_data-scientist: - Pod Dovoljenje za podatke, izberite Grant.

- za Ravnatelji, izberite Uporabniki in vloge IAMin izberite vlogo

SageMakerStudioExecutionRole_data-scientist. - za Oznake pravilnika ali viri kataloga, izberite Viri imenskega kataloga podatkov.

- za Baze podatkov, izberite

demo. - za Dovoljenja baze podatkov, izberite Opišite.

- Izberite Grant.

O avtorjih

Praveen Kumar je arhitekt analitičnih rešitev pri AWS s strokovnim znanjem in izkušnjami pri načrtovanju, gradnji in implementaciji sodobnih podatkovnih in analitičnih platform z uporabo storitev v oblaku. Področja njegovih interesov so brezstrežniška tehnologija, sodobna podatkovna skladišča v oblaku, pretakanje in aplikacije ML.

Noritaka Sekiyama je glavni arhitekt velikih podatkov v skupini AWS Glue. Uživa v sodelovanju z različnimi ekipami, da doseže rezultate, kot je ta objava. V prostem času z družino rad igra video igre.

- Napredno (300)

- AI

- ai art

- ai art generator

- imajo robota

- Amazon SageMaker

- Umetna inteligenca

- certificiranje umetne inteligence

- umetna inteligenca v bančništvu

- robot z umetno inteligenco

- roboti z umetno inteligenco

- programska oprema za umetno inteligenco

- Veliki podatki AWS

- AWS lepilo

- Oblikovanje jezera AWS

- Strojno učenje AWS

- blockchain

- blockchain konferenca ai

- coingenius

- pogovorna umetna inteligenca

- kripto konferenca ai

- dall's

- globoko učenje

- strojno učenje

- platon

- platon ai

- Platonova podatkovna inteligenca

- Igra Platon

- PlatoData

- platogaming

- lestvica ai

- sintaksa

- miselno vodstvo

- zefirnet