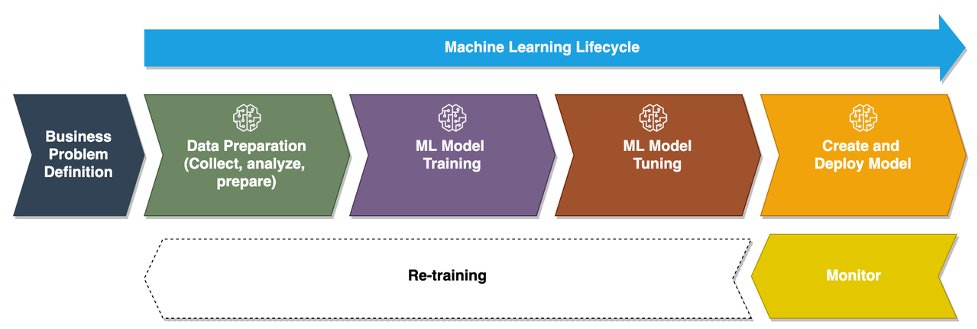

Ko se podjetja premikajo od izvajanja ad hoc modelov strojnega učenja (ML) k uporabi AI/ML za preoblikovanje svojega poslovanja v velikem obsegu, postaja sprejetje operacij ML (MLOps) neizogibno. Kot je prikazano na naslednji sliki, se življenjski cikel ML začne z oblikovanjem poslovnega problema kot primera uporabe ML, ki mu sledi vrsta faz, vključno s pripravo podatkov, inženiringom funkcij, gradnjo modela, uvajanjem, stalnim spremljanjem in ponovnim usposabljanjem. V mnogih podjetjih je veliko teh korakov še vedno ročnih in ohlapno povezanih med seboj. Zato je pomembno avtomatizirati življenjski cikel ML od konca do konca, kar omogoča pogoste poskuse za doseganje boljših poslovnih rezultatov. Priprava podatkov je eden od ključnih korakov v tem življenjskem ciklu, saj je natančnost modela ML odvisna od kakovosti nabora podatkov za usposabljanje.

Podatkovni znanstveniki in inženirji ML porabijo nekje med 70–80 % svojega časa za zbiranje, analiziranje, čiščenje in preoblikovanje podatkov, potrebnih za usposabljanje modelov. Amazon SageMaker Data Wrangler je popolnoma upravljana zmogljivost Amazon SageMaker tako podatkovni znanstveniki in inženirji ML hitreje analizirajo in pripravijo podatke za svoje projekte ML z malo ali brez kode. Ko gre za operacionalizacijo življenjskega cikla ML od konca do konca, je priprava podatkov skoraj vedno prvi korak v procesu. Glede na to, da obstaja veliko načinov za izgradnjo cevovoda ML od konca do konca, v tej objavi razpravljamo o tem, kako lahko preprosto integrirate Data Wrangler z nekaterimi dobro znanimi tehnologijami za avtomatizacijo delovnega toka in orkestracijo.

Pregled rešitev

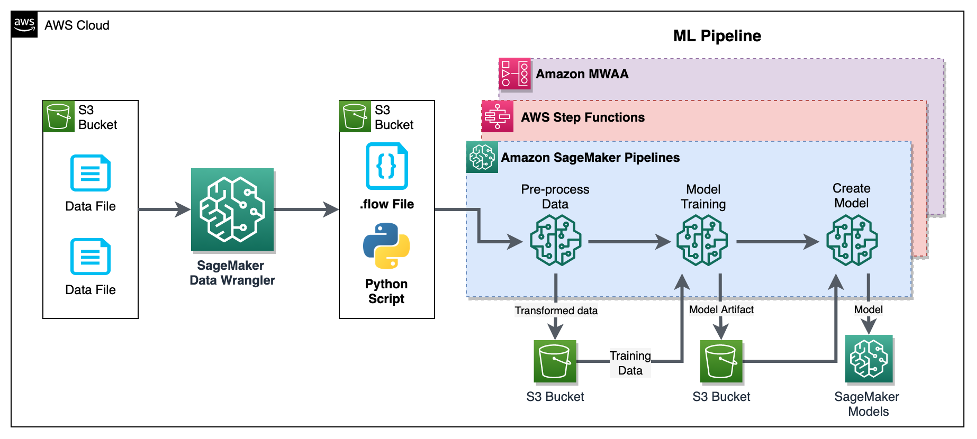

V tej objavi prikazujemo, kako lahko uporabniki integrirajo pripravo podatkov s programom Data Wrangler Amazonski cevovodi SageMaker, Korak funkcije AWSin pretok zraka apache z Amazon Managed Workflow za Apache Airflow (Amazon MWAA). Cevovodi so funkcija SageMaker, ki je namensko izdelana in enostavna storitev stalne integracije in stalne dostave (CI/CD) za ML. Step Functions je brezstrežniška storitev vizualnega poteka dela z nizko kodo, ki se uporablja za orkestriranje storitev AWS in avtomatizacijo poslovnih procesov. Amazon MWAA je upravljana storitev orkestracije za Apache Airflow, ki olajša upravljanje podatkov od konca do konca in cevovodov ML.

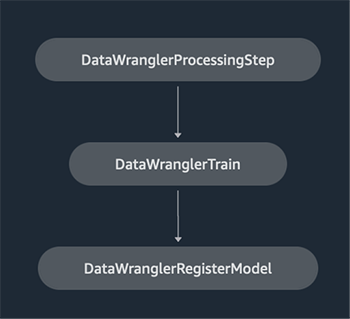

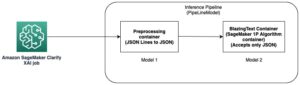

Za namene predstavitve upoštevamo primer uporabe za pripravo podatkov za usposabljanje modela ML z vgrajenim SageMakerjem XGBoost algoritem ki nam bo pomagal prepoznati goljufive zahtevke za zavarovanje vozil. Uporabili smo sintetično ustvarjen nabor vzorčnih podatkov za usposabljanje modela in izdelavo modela SageMaker z uporabo artefaktov modela iz procesa usposabljanja. Naš cilj je operacionalizirati ta proces od konca do konca z vzpostavitvijo poteka dela ML. Čeprav so poteki dela ML lahko bolj dodelani, uporabljamo minimalen potek dela za namene predstavitve. Prvi korak delovnega toka je priprava podatkov s programom Data Wrangler, sledi korak usposabljanja modela in na koncu korak ustvarjanja modela. Naslednji diagram prikazuje potek dela naše rešitve.

V naslednjih razdelkih vas vodimo skozi nastavitev toka Data Wrangler in integracijo Data Wranglerja s cevovodi, funkcijami korakov in Apache Airflow.

Nastavite tok Data Wrangler

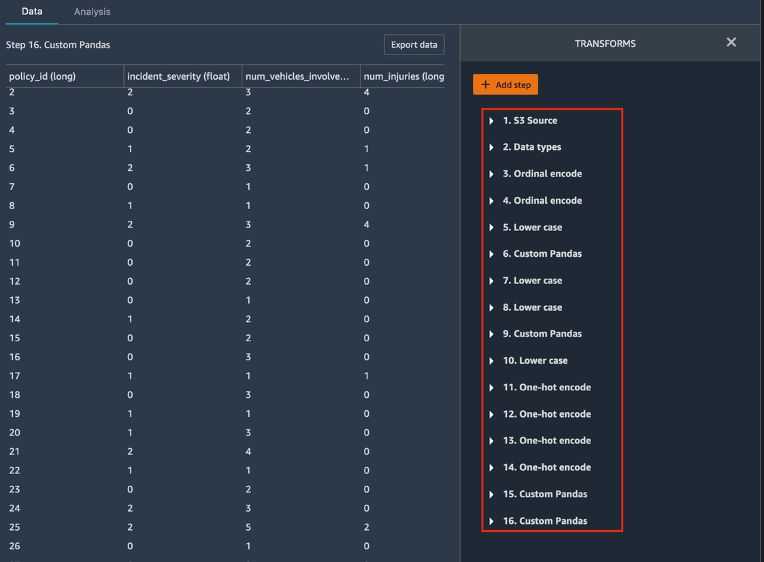

Začnemo z ustvarjanjem toka Data Wrangler, imenovanega tudi a pretok podatkov, uporabljati uporabniški vmesnik pretoka podatkov preko Amazon SageMaker Studio IDE. Naš vzorčni nabor podatkov je sestavljen iz dveh podatkovnih datotek: zahtevki.csv in kupci.csv, ki so shranjeni v an Preprosta storitev shranjevanja Amazon (Amazon S3) vedro. Za uporabo Data Wranglerja uporabljamo uporabniški vmesnik podatkovnega toka vgrajene transformacije takšno kategorično kodiranje, oblikovanje nizov in imputiranje v stolpce funkcij v vsaki od teh datotek. Tudi mi se prijavimo preoblikovanje po meri v nekaj stolpcev funkcij z nekaj vrsticami kode Python po meri Pandas DataFrame. Naslednji posnetek zaslona prikazuje transformacije, uporabljene za datoteko claims.csv v uporabniškem vmesniku toka podatkov.

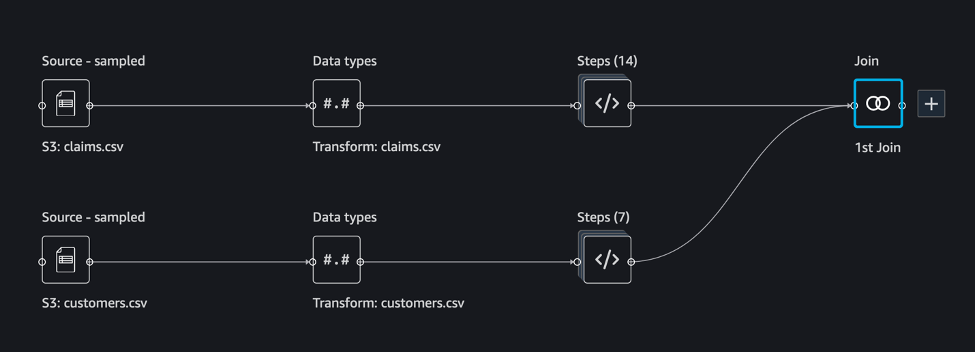

Nazadnje združimo rezultate uporabljenih transformacij obeh podatkovnih datotek, da ustvarimo en sam nabor podatkov za usposabljanje za naš model usposabljanja. Uporabljamo vgrajen Data Wrangler pridruži naborom podatkov zmožnost, ki nam omogoča izvajanje operacij združevanja, podobnih SQL, nad tabelarnimi podatki. Naslednji posnetek zaslona prikazuje tok podatkov v uporabniškem vmesniku toka podatkov v Studiu. Za navodila po korakih za ustvarjanje pretoka podatkov s programom Data Wrangler glejte GitHub repozitorij.

Zdaj lahko uporabite datoteko pretoka podatkov (.flow) za izvajanje transformacij podatkov v naših neobdelanih podatkovnih datotekah. Uporabniški vmesnik za pretok podatkov lahko samodejno ustvari prenosne računalnike Python, ki jih lahko uporabljamo in neposredno integriramo s cevovodi z uporabo SDK-ja SageMaker. Za funkcije korakov uporabljamo Funkcije koraka AWS Data Science Python SDK za integracijo naše obdelave Data Wrangler s cevovodom Step Functions. Za Amazon MWAA uporabljamo a operater zračnega toka po meri in Operater Airflow SageMaker. Vsak od teh pristopov podrobno obravnavamo v naslednjih razdelkih.

Integrirajte Data Wrangler s cevovodi

SageMaker Pipelines je izvorno orodje za orkestracijo poteka dela za gradnjo cevovodov ML, ki izkoriščajo neposredno integracijo SageMaker. Skupaj z Register modelov SageMaker, Cevovodi izboljšajo operativno odpornost in ponovljivost vaših delovnih tokov ML. Te komponente za avtomatizacijo delovnega toka vam omogočajo, da preprosto povečate svojo sposobnost gradnje, usposabljanja, testiranja in uvajanja na stotine modelov v proizvodnji; ponovite hitreje; zmanjšanje napak zaradi ročne orkestracije; in zgraditi ponovljive mehanizme. Vsak korak v cevovodu lahko sledi rodu, vmesne korake pa je mogoče shraniti v predpomnilnik za hitro ponovno izvajanje cevovoda. Ti lahko ustvarite cevovode s SDK SageMaker Python.

Potek dela, zgrajen s cevovodi SageMaker, je sestavljen iz zaporedja korakov, ki tvorijo usmerjeni aciklični graf (DAG). V tem primeru začnemo z a korak obdelave, ki vodi a Naloga obdelave SageMaker na podlagi datoteke toka Data Wrangler za ustvarjanje nabora podatkov za usposabljanje. Nato nadaljujemo z a korak treninga, kjer urimo model XGBoost z uporabo SageMakerjevega vgrajenega algoritma XGBoost in učnega nabora podatkov, ustvarjenega v prejšnjem koraku. Ko je model usposobljen, končamo ta potek dela z a korak RegisterModel za registracijo usposobljenega modela v registru modelov SageMaker.

Namestitev in sprehod

Za izvajanje tega vzorca uporabimo prenosni računalnik Jupyter, ki izvaja Python3 na sliki jedra Data Science v okolju Studio. Zaženete ga lahko tudi na primerku prenosnega računalnika Jupyter lokalno na vašem računalniku, tako da nastavite poverilnice za prevzem izvajalske vloge SageMaker. Prenosni računalnik je lahek in ga je mogoče izvajati na primerku ml.t3.medium. Podrobna navodila po korakih najdete v GitHub repozitorij.

Za ustvarjanje kode Pipelines lahko uporabite funkcijo izvoza v programu Data Wrangler ali pa ustvarite svoj skript iz nič. V našem vzorčnem skladišču zaradi poenostavitve uporabljamo kombinacijo obeh pristopov. Na visoki ravni so naslednji koraki za izdelavo in zagon delovnega toka cevovodov:

- Ustvarite datoteko toka iz programa Data Wrangler ali uporabite namestitveni skript za ustvarjanje datoteke toka iz vnaprej konfigurirane predloge.

- Ustvari Preprosta storitev shranjevanja Amazon (Amazon S3) vedro in naložite svojo datoteko toka in vhodne datoteke v vedro. V našem vzorčnem zvezku uporabljamo privzeto vedro SageMaker S3.

- Sledite navodilom v zvezku, da ustvarite objekt Processor na podlagi datoteke toka Data Wrangler in objekt Estimator s parametri opravila usposabljanja.

- Ker v našem primeru uporabljamo samo funkcije SageMaker in privzeto vedro S3, lahko uporabimo privzeto izvajalno vlogo Studia. Enako AWS upravljanje identitete in dostopa (IAM) prevzamejo potek cevovoda, opravilo obdelave in opravilo usposabljanja. Vlogo izvajanja lahko dodatno prilagodite glede na minimalne privilegije.

- Nadaljujte z navodili za ustvarjanje cevovoda s koraki, ki se nanašajo na objekta procesorja in ocenjevalnika, nato pa zaženite cevovod. Opravila obdelave in usposabljanja se izvajajo v upravljanih okoljih SageMaker in trajajo nekaj minut.

- V Studiu si lahko ogledate podrobnosti cevovoda in spremljate potek cevovoda. Prav tako lahko nadzirate temeljna opravila obdelave in usposabljanja s konzole SageMaker ali iz amazoncloudwatch.

Integrirajte Data Wrangler s funkcijami korakov

S funkcijami korakov lahko izrazite zapleteno poslovno logiko kot poteke dela z nizko kodo, ki temeljijo na dogodkih in povezujejo različne storitve AWS. The SDK za podatkovne znanosti o korakih je odprtokodna knjižnica, ki podatkovnim znanstvenikom omogoča ustvarjanje delovnih tokov, ki lahko vnaprej obdelajo nabore podatkov ter gradijo, uvajajo in spremljajo modele ML z uporabo SageMaker in funkcij Step. Funkcije korakov temeljijo na avtomatih stanja in nalogah. Funkcije korakov ustvarijo delovne tokove iz klicanih korakov države, in izraža ta potek dela v Jezik Amazonovih držav. Ko ustvarite delovni tok s programom Step Functions Data Science SDK, ta ustvari avtomat stanja, ki predstavlja vaš delovni tok in korake v korakih Functions.

Za ta primer uporabe smo zgradili delovni tok funkcij korakov, ki temelji na običajnem vzorcu, uporabljenem v tej objavi, ki vključuje korak obdelave, korak usposabljanja in RegisterModel korak. V tem primeru te korake uvozimo iz SDK-ja za Python Data Science Python Functions Step. Te korake povežemo v istem vrstnem redu, da ustvarimo delovni tok funkcij korakov. Delovni tok uporablja datoteko toka, ki je bila ustvarjena iz programa Data Wrangler, vendar lahko uporabite tudi lastno datoteko toka Data Wrangler. Ponovno uporabimo nekaj kode Data Wranglerja funkcija izvoza zaradi enostavnosti. Zaženemo logiko predprocesiranja podatkov, ki jo ustvari datoteka toka Data Wrangler, da ustvarimo nabor podatkov za usposabljanje, usposobimo model z algoritmom XGBoost in shranimo artefakt usposobljenega modela kot model SageMaker. Poleg tega v repo GitHub prikazujemo tudi, kako nam funkcije korakov omogočajo, da poskušamo ujeti napake ter obravnavamo napake in ponovne poskuse z FailStateStep in CatchStateStep.

Nastali diagram poteka, kot je prikazan na naslednjem posnetku zaslona, je na voljo na konzoli Step Functions po začetku delovnega toka. To pomaga podatkovnim znanstvenikom in inženirjem vizualizirati celoten potek dela in vsak korak v njem ter dostopati do povezanih dnevnikov CloudWatch za vsak korak.

Namestitev in sprehod

Za izvedbo tega vzorca uporabimo prenosni računalnik Python, ki deluje z jedrom Data Science v okolju Studio. Zaženete ga lahko tudi na primerku prenosnega računalnika Python lokalno na vašem računalniku, tako da nastavite poverilnice za prevzem izvajalske vloge SageMaker. Prenosni računalnik je lahek in ga je mogoče zagnati na primer na srednjem primerku t3. Podrobna navodila po korakih najdete v GitHub repozitorij.

Uporabite lahko izvozno funkcijo v programu Data Wrangler, da ustvarite kodo cevovodov in jo spremenite za funkcije korakov ali ustvarite svoj skript iz nič. V našem vzorčnem skladišču zaradi poenostavitve uporabljamo kombinacijo obeh pristopov. Na visoki ravni so naslednji koraki za izdelavo in zagon delovnega toka funkcij korakov:

- Ustvarite datoteko toka iz programa Data Wrangler ali uporabite namestitveni skript za ustvarjanje datoteke toka iz vnaprej konfigurirane predloge.

- Ustvarite vedro S3 in naložite svojo datoteko toka in vhodne datoteke v vedro.

- Konfigurirajte svojo izvajalsko vlogo SageMaker z zahtevanimi dovoljenji, kot je bilo omenjeno prej. Za podrobna navodila glejte repozitorij GitHub.

- Sledite navodilom za zagon zvezka v repozitoriju, da začnete potek dela. Posel obdelave se izvaja v okolju Spark, ki ga upravlja SageMaker, in lahko traja nekaj minut.

- Pojdite na konzolo Step Functions in vizualno spremljajte potek dela. Za odpravljanje napak se lahko pomaknete tudi do povezanih dnevnikov CloudWatch.

Tukaj preglejmo nekaj pomembnih delov kode. Če želite definirati potek dela, najprej definiramo korake v poteku dela za stroj stanja Step Function. Prvi korak je data_wrangler_step za obdelavo podatkov, ki uporablja datoteko toka Data Wrangler kot vhod za preoblikovanje neobdelanih podatkovnih datotek. Definiramo tudi imenovani korak usposabljanja modela in korak ustvarjanja modela training_step in model_step, oz. Na koncu ustvarimo potek dela tako, da verižimo vse korake, ki smo jih ustvarili, kot je prikazano v naslednji kodi:

V našem primeru smo zgradili delovni tok tako, da vzame imena opravil kot parametre, ker so edinstvena in jih je treba naključno generirati med vsakim zagonom cevovoda. Ta imena posredujemo, ko poteka potek dela. Načrtujete lahko tudi potek dela Step Functions za zagon z uporabo CloudWatch (glejte Načrtujte potek dela brez strežnika s funkcijami AWS Step in Amazon CloudWatch), priklican z uporabo Dogodki Amazon S3, ali priklicano iz Amazon EventBridge (Glej Ustvarite pravilo EventBridge, ki sproži delovni tok funkcij korakov). Za namene predstavitve lahko prikličemo potek dela Step Functions iz uporabniškega vmesnika konzole Step Functions ali z uporabo naslednje kode iz zvezka.

Integrirajte Data Wrangler z Apache Airflow

Drug priljubljen način ustvarjanja delovnih tokov ML je uporaba Apache Airflow. Apache Airflow je odprtokodna platforma, ki vam omogoča programsko ustvarjanje, razporejanje in spremljanje delovnih tokov. Amazon MWAA olajša postavitev in upravljanje cevovodov ML od konca do konca z Apache Airflow v velikem obsegu v oblaku. Cevovod zračnega toka je sestavljen iz zaporedja nalog, imenovanih tudi a potek dela. Delovni tok je definiran kot DAG, ki zajema naloge in odvisnosti med njimi ter določa, kako naj tečejo v delovnem toku.

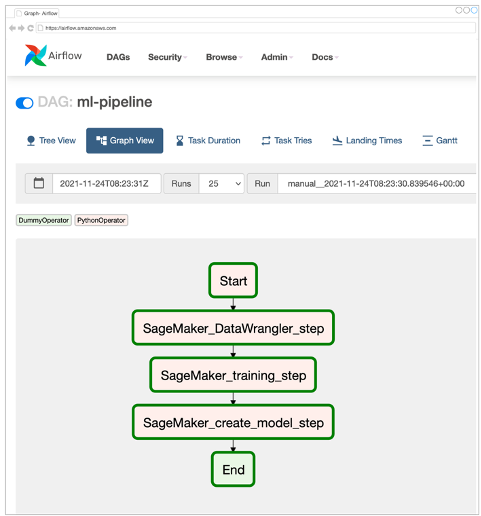

Znotraj okolja Amazon MWAA smo ustvarili Airflow DAG za implementacijo našega delovnega toka MLOps. Vsaka naloga v delovnem toku je izvršljiva enota, napisana v programskem jeziku Python, ki izvede neko dejanje. Naloga je lahko bodisi operater ali senzor. V našem primeru uporabljamo an Operater Airflow Python skupaj z SDK SageMaker Python za zagon skripta Data Wrangler Python in uporabo prvotno podprtega Airflowa Operatorji SageMaker za usposabljanje algoritma XGBoost, vgrajenega v SageMaker, in ustvarjanje modela iz nastalih artefaktov. Ustvarili smo tudi uporaben operater Data Wrangler po meri (SageMakerDataWranglerOperator) za Apache Airflow, ki ga lahko uporabite za obdelavo datotek toka Data Wrangler za obdelavo podatkov brez potrebe po kakršni koli dodatni kodi.

Naslednji posnetek zaslona prikazuje Airflow DAG s petimi koraki za implementacijo našega poteka dela MLOps.

Začetni korak uporablja operator Python za inicializacijo konfiguracij za preostale korake v delovnem toku. SageMaker_DataWrangler_Step uporablja SageMakerDataWranglerOperator in datoteko pretoka podatkov, ki smo jo ustvarili prej. SageMaker_training_step in SageMaker_create_model_step uporabite vgrajene operaterje SageMaker za usposabljanje modela oziroma ustvarjanje modela. Naše okolje Amazon MWAA uporablja najmanjšo vrsto instance (mw1.small), ker se večina obdelave izvaja prek opravil obdelave, ki uporablja lastno vrsto instance, ki jo je mogoče definirati kot konfiguracijske parametre v delovnem toku.

Namestitev in sprehod

Podrobna navodila po korakih za namestitev te rešitve najdete v našem GitHub repozitorij. Za nastavitev Airflow DAG smo uporabili prenosni računalnik Jupyter s kodnimi celicami Python. Ob predpostavki, da ste že ustvarili datoteko s pretokom podatkov, je spodaj pregled namestitvenih korakov na visoki ravni:

- Ustvari vedro S3 in naslednje mape, ki jih zahteva Amazon MWAA.

- Ustvarite okolje Amazon MWAA. Upoštevajte, da smo za to rešitev uporabili različico Airflow 2.0.2.

- Ustvarite in naložite a

requirements.txtdatoteko z vsemi odvisnostmi Pythona, ki jih zahtevajo naloge Airflow, in jo naložite v/requirementsv primarnem segmentu Amazon MWAA S3. To uporablja upravljano okolje Airflow za namestitev odvisnosti Pythona. - Naložite

SMDataWranglerOperator.pydatoteko na/dagsimenik. Ta skript Python vsebuje kodo za operater Airflow po meri za Data Wrangler. Ta operater se lahko uporablja za naloge za obdelavo katere koli datoteke .flow. - Ustvarite in naložite

config.pyscenarij za/dagsimenik. Ta skript Python se uporablja za prvi korak našega DAG za ustvarjanje konfiguracijskih objektov, ki jih zahtevajo preostali koraki poteka dela. - Na koncu ustvarite in naložite

ml_pipelines.pydatoteko na/dagsimenik. Ta skript vsebuje definicijo DAG za potek dela Airflow. Tu definiramo vsako od nalog in med njimi vzpostavimo odvisnosti. Amazon MWAA redno anketira/dagsimenik za zagon tega skripta za ustvarjanje DAG ali posodobitev obstoječega z najnovejšimi spremembami.

Sledi koda za SageMaker_DataWrangler_step, ki uporablja običaj SageMakerDataWranglerOperator. Z le nekaj vrsticami kode v skriptu Python z definicijo DAG lahko pokažete na SageMakerDataWranglerOperator na lokacijo datoteke toka Data Wrangler (ki je lokacija S3). Ta operater uporablja v zakulisju Opravila obdelave SageMaker za obdelavo datoteke .flow za uporabo definiranih transformacij v vaših neobdelanih podatkovnih datotekah. Določite lahko tudi vrsta primerka in število primerkov, ki jih potrebuje opravilo obdelave Data Wrangler.

O config parameter sprejme slovar (pari ključ-vrednost) dodatnih konfiguracij, ki jih zahteva opravilo obdelave, kot je izhodna predpona končne izhodne datoteke, vrsta izhodne datoteke (CSV ali Parquet) in URI za vgrajen vsebnik Data Wrangler slika. Naslednja koda je tisto, kar config slovar za SageMakerDataWranglerOperator izgleda kot. Te konfiguracije so potrebne za obdelavo SageMaker procesor. Za podrobnosti o vsakem od teh konfiguracijskih parametrov glejte sagemaker.processing.Processor().

Čiščenje

Da se izognete prihodnjim stroškom, izbrišite vire, ustvarjene za rešitve, ki ste jih implementirali.

- Temu sledite Navodila na voljo v repozitoriju GitHub za čiščenje virov, ustvarjenih z rešitvijo SageMaker Pipelines.

- Temu sledite Navodila na voljo v repozitoriju GitHub za čiščenje virov, ustvarjenih z rešitvijo Step Functions.

- Temu sledite Navodila na voljo v repozitoriju GitHub za čiščenje virov, ustvarjenih z rešitvijo Amazon MWAA.

zaključek

Ta objava je pokazala, kako lahko preprosto integrirate Data Wrangler z nekaterimi dobro znanimi tehnologijami za avtomatizacijo delovnega toka in orkestracijo v AWS. Najprej smo pregledali vzorčni primer uporabe in arhitekturo za rešitev, ki uporablja Data Wrangler za predhodno obdelavo podatkov. Nato smo pokazali, kako lahko integrirate Data Wrangler s cevovodi, stopenjskimi funkcijami in Amazon MWAA.

Kot naslednji korak lahko najdete in preizkusite vzorce kode in zvezke v našem GitHub repozitorij z uporabo podrobnih navodil za vsako rešitev, obravnavano v tej objavi. Če želite izvedeti več o tem, kako lahko Data Wrangler pomaga vašim delovnim obremenitvam ML, obiščite Data Wrangler Stran izdelka in Pripravite podatke ML z Amazon SageMaker Data Wrangler.

O avtorjih

Rodrigo Alarcon je višji arhitekt ML Strategy Solutions pri AWS s sedežem v Santiagu v Čilu. V svoji vlogi Rodrigo pomaga podjetjem različnih velikosti ustvarjati poslovne rezultate z rešitvami AI in ML v oblaku. Njegovi interesi vključujejo strojno učenje in kibernetsko varnost.

Rodrigo Alarcon je višji arhitekt ML Strategy Solutions pri AWS s sedežem v Santiagu v Čilu. V svoji vlogi Rodrigo pomaga podjetjem različnih velikosti ustvarjati poslovne rezultate z rešitvami AI in ML v oblaku. Njegovi interesi vključujejo strojno učenje in kibernetsko varnost.

Ganapathi Krishnamoorthi je višji arhitekt za rešitve ML pri AWS. Ganapathi ponuja predpisane smernice startup in poslovnim strankam ter jim pomaga pri načrtovanju in uvajanju aplikacij v oblaku v velikem obsegu. Specializiran je za strojno učenje in je osredotočen na pomoč strankam pri uporabi AI/ML za njihove poslovne rezultate. Ko ni v službi, rad raziskuje na prostem in posluša glasbo.

Ganapathi Krishnamoorthi je višji arhitekt za rešitve ML pri AWS. Ganapathi ponuja predpisane smernice startup in poslovnim strankam ter jim pomaga pri načrtovanju in uvajanju aplikacij v oblaku v velikem obsegu. Specializiran je za strojno učenje in je osredotočen na pomoč strankam pri uporabi AI/ML za njihove poslovne rezultate. Ko ni v službi, rad raziskuje na prostem in posluša glasbo.

Anjan Biswas je višji arhitekt rešitev za storitve AI s poudarkom na AI/ML in podatkovni analitiki. Anjan je del svetovne ekipe za storitve AI in sodeluje s strankami, da bi jim pomagal razumeti in razviti rešitve za poslovne težave z AI in ML. Anjan ima več kot 14 let izkušenj pri delu z globalno dobavno verigo, proizvodnjo in maloprodajnimi organizacijami ter strankam dejavno pomaga začeti in širiti storitve umetne inteligence AWS.

Anjan Biswas je višji arhitekt rešitev za storitve AI s poudarkom na AI/ML in podatkovni analitiki. Anjan je del svetovne ekipe za storitve AI in sodeluje s strankami, da bi jim pomagal razumeti in razviti rešitve za poslovne težave z AI in ML. Anjan ima več kot 14 let izkušenj pri delu z globalno dobavno verigo, proizvodnjo in maloprodajnimi organizacijami ter strankam dejavno pomaga začeti in širiti storitve umetne inteligence AWS.

- AI

- ai art

- ai art generator

- imajo robota

- Upravljani poteki dela Amazon za Apache Airflow (Amazon MWAA)

- Amazon SageMaker

- Amazon SageMaker Data Wrangler

- Umetna inteligenca

- certificiranje umetne inteligence

- umetna inteligenca v bančništvu

- robot z umetno inteligenco

- roboti z umetno inteligenco

- programska oprema za umetno inteligenco

- Strojno učenje AWS

- Korak funkcije AWS

- blockchain

- blockchain konferenca ai

- coingenius

- pogovorna umetna inteligenca

- kripto konferenca ai

- dall's

- globoko učenje

- strojno učenje

- platon

- platon ai

- Platonova podatkovna inteligenca

- Igra Platon

- PlatoData

- platogaming

- lestvica ai

- sintaksa

- zefirnet