Falsk fotografering är inget nytt. På 1910-talet blev den brittiske författaren Arthur Conan Doyle berömd lurad av två systrar i skolåldern som hade tagit fram fotografier av eleganta älvor som snurrade i deras trädgård.

Idag är det svårt att tro att dessa bilder kunde ha lurat någon, men det var inte förrän på 1980-talet en expert vid namn Geoffrey Crawley hade modet att direkt tillämpa sin kunskap om filmfotografi och härleda det uppenbara.

Fotografierna var falska, vilket senare erkändes av en av systrarna själva.

Jakt på artefakter och sunt förnuft

Digital fotografering har öppnat upp en mängd tekniker för både falskare och detektiver.

Rättsmedicinsk undersökning av misstänkta bilder innebär numera jakt på egenskaper som är inneboende i digital fotografering, som t.ex. metadata inbäddad i bilderna, använda programvara som Adobe Photoshop för att korrigera förvrängningar i bilder, och letar efter tydliga tecken på manipulation, som att regioner dupliceras för att dölja originaldetaljer.

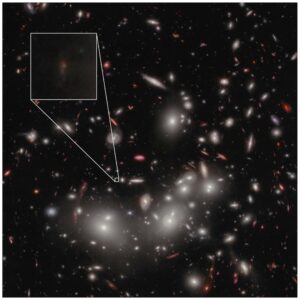

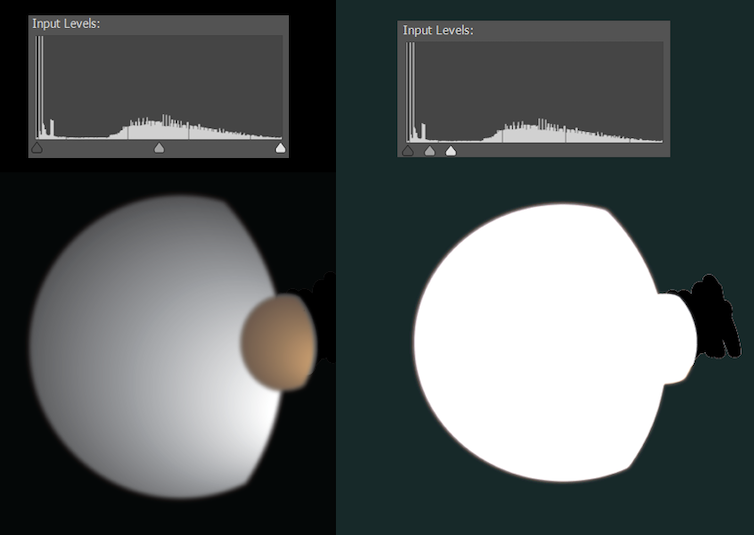

Ibland är digitala redigeringar för subtila för att upptäcka, men hoppar in i bilden när vi justerar hur ljusa och mörka pixlar fördelas. Till exempel, 2010 släppte NASA en foto av Saturnus månar Dione och Titan. Det var inte på något sätt falskt, utan hade städats upp för att ta bort herrelösa artefakter - som fick konspirationsteoretikers uppmärksamhet.

Nyfiken lägger jag in bilden i Photoshop. Illustrationen nedan återskapar ungefär hur detta såg ut.

De flesta digitala fotografier är i komprimerade format som JPEG, förtunnade genom att ta bort mycket av informationen som fångas av kameran. Standardiserade algoritmer säkerställer att informationen som tas bort har minimal synlig påverkan – men den lämnar spår.

Komprimeringen av valfri del av en bild beror på vad som händer i bilden och aktuella kamerainställningar; när en falsk bild kombinerar flera källor är det ofta möjligt att upptäcka detta genom noggrann analys av kompressionsartefakterna.

Vissa rättsmedicinska metoder har lite att göra med formatet på en bild, men är i huvudsak visuellt detektivarbete. Lyser alla på fotografiet på samma sätt? Är skuggor och reflektioner meningsfulla? Visar öron och händer ljus och skugga på rätt ställen? Vad reflekteras i människors ögon? Skulle alla linjer och vinklar i rummet stämma om vi modellerade scenen i 3D?

Arthur Conan Doyle kan ha blivit lurad av älvor, men jag tror att hans skapelse Sherlock Holmes skulle vara hemma i världen av rättsmedicinska fotoanalyser.

En ny era av artificiell intelligens

Smakämnen nuvarande explosion av bilder skapad av text-till-bild artificiell intelligens verktyg är på många sätt mer radikal än övergången från film till digital fotografering.

Vi kan nu trolla fram vilken bild vi vill, bara genom att skriva. Dessa bilder är inte franken-foton gjorda genom att blanda ihop redan existerande pixlar. De är helt nya bilder med innehållet, kvaliteten och stilen som anges.

Fram till nyligen har de komplexa neurala nätverk som används för att generera dessa bilder haft begränsad tillgänglighet för allmänheten. Detta ändrades den 23 augusti 2022, då det släpptes för allmänheten öppen källkod Stable Diffusion. Nu kan alla som har ett Nvidia-grafikkort på spelnivå i sin dator skapa AI-bildinnehåll utan något forskningslabb eller affärsportvakt för sina aktiviteter.

Detta har fått många att fråga, "kan vi någonsin tro vad vi ser online igen?”. Det beror på.

Text-till-bild AI får sina kunskaper från träning – analysen av ett stort antal bild/textningspar. Styrkan och svagheterna hos varje system härrör delvis från vilka bilder det har tränats på. Här är ett exempel: så här ser Stable Diffusion George Clooney stryka.

Detta är långt ifrån realistiskt. Allt Stable Diffusion behöver gå på är informationen den har lärt sig, och även om det är tydligt att den har sett George Clooney och kan länka den strängen av bokstäver till skådespelarens drag, är den inte en Clooney-expert.

Den skulle dock ha sett och smält många fler bilder av medelålders män i allmänhet, så låt oss se vad som händer när vi ber om en generisk medelålders man i samma scenario.

Detta är en klar förbättring, men ändå inte riktigt realistisk. Som alltid har varit fallet är den knepiga geometrin hos händer och öron bra ställen att leta efter tecken på fejk – även om vi i det här mediet tittar på den rumsliga geometrin snarare än berättelserna om omöjlig belysning.

Det kan finnas andra ledtrådar. Om vi varsamt rekonstruerade rummet, skulle hörnen vara fyrkantiga? Skulle hyllorna vara vettiga? En rättsmedicinsk expert som är van vid att undersöka digitala fotografier skulle förmodligen kunna ringa till det.

Vi kan inte längre tro våra ögon

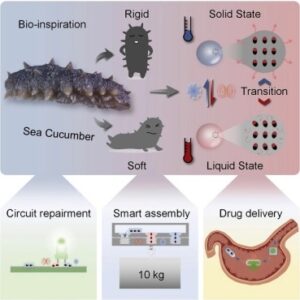

Om vi utökar ett text-till-bild-systems kunskaper kan det bli ännu bättre. Du kan lägga till dina egna beskrivna fotografier för att komplettera befintlig utbildning. Denna process är känd som textinversion.

Nyligen har Google släppt Drömbås, en alternativ, mer sofistikerad metod för att injicera specifika personer, föremål eller till och med konststilar i text-till-bild AI-system.

Denna process kräver kraftig hårdvara, men resultaten är häpnadsväckande. En del fantastiska arbeten har börjat delas på Reddit. Titta på bilderna i inlägget nedan som visar bilder inlagda i DreamBooth och realistiska falska bilder från Stable Diffusion.

Vi kan inte längre tro våra ögon, men vi kanske fortfarande kan lita på kriminaltekniska experters, åtminstone för nu. Det är fullt möjligt att framtida system medvetet kan tränas för att lura dem också.

Vi går snabbt in i en era där perfekt fotografering och till och med video kommer att vara vanligt. Tiden kommer att utvisa hur betydelsefullt detta kommer att bli, men under tiden är det värt att komma ihåg lektionen från Cottingley Fairy-bilderna - ibland vill folk bara tro, även på uppenbara förfalskningar.![]()

Denna artikel publiceras från Avlyssningen under en Creative Commons licens. Läs ursprungliga artikeln.

Image Credit: Brendan Murphy / author tillhandahålls