Jag är ett stort fan av Anthony Bourdains reseshow Delar okända. I varje avsnitt besöker kocken avlägsna byar över hela världen och dokumenterar liv, mat och kulturer för regionala stammar med ett öppet hjärta och sinne.

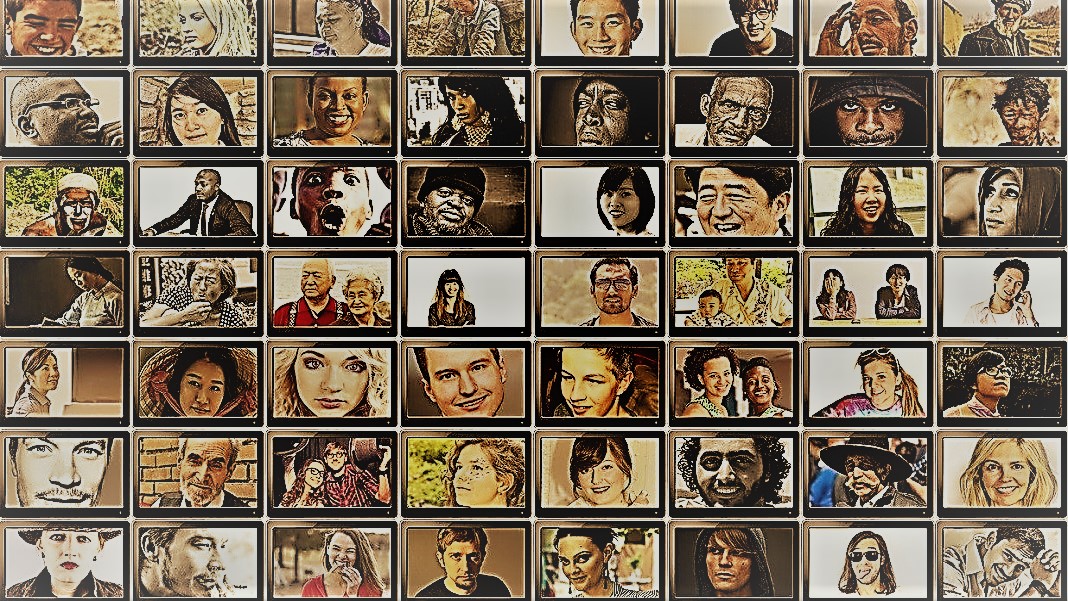

Showen ger en inblick i mänsklighetens häpnadsväckande mångfald. Samhällsvetare har ett liknande mål – att förstå beteendet hos olika människor, grupper och kulturer – men använder en mängd olika metoder i kontrollerade situationer. För båda är stjärnorna i dessa sysselsättningar ämnena: människor.

Men vad händer om du ersatte människor med AI-chatbotar?

Idén låter absurd. Ändå, tack vare tillkomsten av ChatGPT och andra stora språkmodeller (LLM), flirtar samhällsvetare med idén att använda dessa verktyg för att snabbt konstruera olika grupper av "simulerade människor" och köra experiment för att undersöka deras beteende och värderingar som en proxy till sina biologiska motsvarigheter.

Om du föreställer dig digitalt återskapade mänskliga sinnen, så är det inte det. Tanken är att utnyttja ChatGPT:s expertis när det gäller att efterlikna mänskliga svar. Eftersom modellerna skrapar enorma mängder onlinedata – bloggar, Youtube-kommentarer, fanfiction, böcker – fångar de lätt relationer mellan ord på flera språk. Dessa sofistikerade algoritmer kan också avkoda nyanserade aspekter av språket, såsom ironi, sarkasm, metaforer och känslomässiga toner, en kritisk aspekt av mänsklig kommunikation i varje kultur. Dessa styrkor sätter LLMs upp för att efterlikna flera syntetiska personligheter med ett brett spektrum av övertygelser.

Ytterligare en bonus? Jämfört med mänskliga deltagare tröttnar inte ChatGPT och andra LLM, vilket gör det möjligt för forskare att samla in data och testa teorier om mänskligt beteende med oöverträffad hastighet.

Idén, även om den är kontroversiell, har redan stöd. En ny artikel genom att granska det begynnande fältet fann man att i vissa noggrant utformade scenarier korrelerade ChatGPT:s svar med de från ungefär 95 procent av de mänskliga deltagarna.

AI "kan förändra spelet för samhällsvetenskaplig forskning," sade Dr. Igor Grossman vid University of Waterloo, som tillsammans med kollegor nyligen skrev en framåtblicksartikel i Vetenskap. Nyckeln för att använda Homo silicus i forskning? Noggrann biashantering och datatrohet, sa teamet.

Undersöka det mänskliga samhälleliga sinnet

Vad är egentligen samhällsvetenskap?

Enkelt uttryckt är det att studera hur människor – antingen som individer eller som grupp – beter sig under olika omständigheter, hur de interagerar med varandra och utvecklas som en kultur. Det är ett paraply av akademisk strävan med flera grenar: ekonomi, statsvetenskap, antropologi och psykologi.

Disciplinen tar upp ett brett spektrum av ämnen som är framträdande i den nuvarande tidsandan. Vilken påverkan har sociala medier på mental hälsa? Vilken är den nuvarande allmänhetens attityder till klimatförändringar när svåra väderepisoder ökar? Hur värderar olika kulturer kommunikationsmetoder – och vad utlöser missförstånd?

En samhällsvetenskaplig studie börjar med en fråga och en hypotes. En av mina favoriter: tolererar kulturer kroppslukt olika? (Nej skojar, ämnet har studerats ganska mycket, och ja, det finns en skillnad!)

Forskare använder sedan en mängd olika metoder, som frågeformulär, beteendetester, observation och modellering för att testa sina idéer. Enkäter är ett särskilt populärt verktyg, eftersom frågorna kan utformas strikt och granskas och enkelt nå ett brett spektrum av människor när de distribueras online. Forskare analyserar sedan skriftliga svar och drar insikter om mänskligt beteende. Med andra ord är en deltagares språkanvändning avgörande för dessa studier.

Så hur passar ChatGPT in?

"Homo Silicus"

För Grossman representerar LLM:erna bakom chatbots som ChatGPT eller Googles Bard en aldrig tidigare skådad möjlighet att omforma samhällsvetenskapliga experiment.

Eftersom de är utbildade på massiva datamängder kan LLM:er "representera en stor mängd mänskliga erfarenheter och perspektiv", sa författarna. Eftersom modellerna "strövar" fritt utan gränser över internet – som människor som ofta reser internationellt – kan de anta och visa ett bredare utbud av svar jämfört med rekryterade mänskliga försökspersoner.

ChatGPT blir inte heller påverkad av andra medlemmar i en studie eller tröttnar, vilket potentiellt tillåter det att generera mindre partiska svar. Dessa egenskaper kan vara särskilt användbara i "högriskprojekt" - till exempel att efterlikna svaren från människor som lever i länder i krig eller under svåra regimer genom inlägg på sociala medier. I sin tur kan svaren informera om verkliga interventioner.

På liknande sätt kan LLM:er som utbildats i kulturella heta ämnen som könsidentitet eller desinformation återskapa olika teoretiska eller ideologiska skolor för att informera om politik. Istället för att möta hundratusentals mänskliga deltagare kan AI snabbt generera svar baserat på online-diskurs.

Bortsett från potentiella verkliga användningsområden kan LLM:er också fungera som digitala ämnen som interagerar med mänskliga deltagare i samhällsvetenskapliga experiment, något som liknar nonplayer-karaktärer (NPC) i videospel. Till exempel kan LLM anta olika "personligheter" och interagera med mänskliga volontärer över hela världen online med hjälp av text genom att ställa samma fråga till dem. Eftersom algoritmer inte sover kan den köras 24/7. De resulterande uppgifterna kan sedan hjälpa forskare att utforska hur olika kulturer utvärderar liknande information och hur åsikter – och felaktig information – sprids.

Baby steg

Tanken på att använda chatbots i stället för människor i studier är ännu inte mainstream.

Men det finns tidiga bevis för att det skulle kunna fungera. A förtryckstudie släppt denna månad från Georgia Tech, Microsoft Research och Olin College fann att en LLM replikerade mänskliga svar i många klassiska psykologiska experiment, inklusive den ökända Milgram chockexperiment.

Ändå kvarstår en kritisk fråga: hur väl kan dessa modeller verkligen fånga en människas svar?

Det finns flera stötestenar.

Först är kvaliteten på algoritmen och träningsdata. Det mesta onlineinnehållet domineras av bara en handfull språk. En LLM som utbildats på dessa data kan lätt efterlikna känslan, perspektivet eller till och med moraliskt omdöme hos människor som använder dessa språk – i sin tur ärver bias från träningsdata.

"Denna bias reproduktion är ett stort problem eftersom det kan förstärka de skillnader som samhällsvetare strävar efter att avslöja i sin forskning," sade Grossman.

Vissa forskare oroar sig också för att LLM är rättvisa uppstötande vad de får höra. Det är motsatsen till en samhällsvetenskaplig studie, där huvudpoängen är att fånga mänskligheten i all dess mångfaldiga och komplexa skönhet. Å andra sidan är ChatGPT och liknande modeller kända för att "hallucinera,” som tar fram information som låter rimlig men är falsk.

För nu, "stora språkmodeller förlitar sig på "skuggor" av mänskliga upplevelser," sade Grossman. Eftersom dessa AI-system till stor del är svarta lådor är det svårt att förstå hur eller varför de genererar vissa svar – lite oroande när man använder dem som mänskliga proxyservrar i beteendeexperiment.

Trots begränsningar tillåter "LLM:er samhällsvetare att bryta från traditionella forskningsmetoder och närma sig sitt arbete på innovativa sätt", sa författarna. Som ett första steg kan Homo silicus hjälpa till att brainstorma och snabbt testa hypoteser, med lovande sådana som valideras ytterligare i mänskliga populationer.

Men för att samhällsvetenskapen verkligen ska välkomna AI måste det finnas transparens, rättvisa och lika tillgång till dessa kraftfulla system. LLM:er är svåra och dyra att träna, med nyare modeller alltmer stängda bakom rejäla betalväggar.

"Vi måste försäkra att samhällsvetenskapliga LLM:er, precis som alla vetenskapliga modeller, är öppen källkod, vilket innebär att deras algoritmer och idealiskt data är tillgängliga för alla att granska, testa och modifiera." sade studieförfattaren Dr Dawn Parker vid University of Waterloo. "Endast genom att upprätthålla transparens och replikerbarhet kan vi säkerställa att AI-stödd samhällsvetenskaplig forskning verkligen bidrar till vår förståelse av mänsklig erfarenhet."

Image Credit: Gerd Altmann / Pixabay

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Fordon / elbilar, Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- BlockOffsets. Modernisera miljökompensation ägande. Tillgång här.

- Källa: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- : har

- :är

- :inte

- $UPP

- 23

- a

- Om Oss

- akademiska

- tillgång

- tvärs

- Agera

- anta

- första advent

- AI

- algoritm

- algoritmer

- Alla

- tillåter

- tillåta

- redan

- också

- mängder

- an

- analysera

- och

- Anthony

- tillvägagångssätt

- ÄR

- arizona

- array

- Artikeln

- AS

- aspekt

- aspekter

- At

- Författaren

- Författarna

- tillgänglig

- baserat

- BE

- Skönhet

- därför att

- varit

- beteende

- bakom

- Där vi får lov att vara utan att konstant prestera,

- föreställningar

- mellan

- förspänning

- partisk

- Bit

- Svart

- Block

- kropp

- Bonus

- gränser

- båda

- boxar

- brain

- grenar

- Ha sönder

- men

- by

- KAN

- fånga

- noggrann

- vissa

- byta

- tecken

- chatbots

- ChatGPT

- omständigheter

- Klimat

- Klimatförändring

- kollegor

- samla

- College

- kommentarer

- Kommunikation

- jämfört

- komplex

- Oro

- konstruera

- innehåll

- bidrar

- kontrolleras

- kontroversiell

- kunde

- länder

- kredit

- kritisk

- kritisk aspekt

- kultur

- kultur

- Aktuella

- datum

- datauppsättningar

- utformade

- utveckla

- olika

- svårt

- digital

- digitalt

- Visa

- distribueras

- flera

- Mångfald

- do

- gör

- inte

- inte

- dr

- dra

- varje

- Tidig

- lätt

- Ekonomi

- enorm

- säkerställa

- episod

- lika

- speciellt

- utvärdera

- Även

- Varje

- exakt

- exempel

- dyra

- erfarenhet

- Erfarenheter

- experiment

- expertis

- utforska

- rättvisa

- falsk

- fläkt

- Fiktion

- trohet

- fält

- Förnamn

- passa

- livsmedel

- För

- hittade

- från

- ytterligare

- lek

- Games

- Kön

- generera

- georgien

- skaffa sig

- Glimt

- globen

- Googles

- Gruppens

- sidan

- näve

- Har

- Hälsa

- Hjärta

- hjälpa

- HET

- Hur ser din drömresa ut

- html

- http

- HTTPS

- stor

- humant

- Mänsklig erfarenhet

- Mänskligheten

- Människa

- Hundratals

- Tanken

- idealt

- idéer

- Identitet

- if

- Inverkan

- in

- I andra

- Inklusive

- Öka

- alltmer

- individer

- ökänd

- påverkas

- underrätta

- informationen

- innovativa

- insikter

- interagera

- in

- ironi

- IT

- DESS

- jpg

- bara

- Nyckel

- känd

- språk

- Språk

- Large

- till stor del

- mindre

- tycka om

- begränsningar

- Bor

- levande

- LLM

- Huvudsida

- Vanliga

- upprätthålla

- större

- Framställning

- ledning

- massiv

- Maj..

- betyder

- Media

- Medlemmar

- mentala

- Mental hälsa

- metoder

- Microsoft

- emot

- sinnen

- desinformation

- modellering

- modeller

- modifiera

- Månad

- moralisk

- mest

- multipel

- måste

- my

- begynnande

- Behöver

- Nej

- nu

- talrik

- of

- Ofta

- on

- ONE

- ettor

- nätet

- öppet

- öppen källkod

- Möjlighet

- or

- Övriga

- vår

- deltagare

- Personer

- procent

- Personligheter

- perspektiv

- perspektiv

- plato

- Platon Data Intelligence

- PlatonData

- plausibel

- Punkt

- Strategier

- politiska

- Populära

- populationer

- inlägg

- potentiellt

- den mäktigaste

- sond

- framträdande

- lovande

- bevis

- ger

- ombud

- Psykologi

- allmän

- utförandet

- kvalitet

- fråga

- frågor

- område

- snabbt

- snarare

- nå

- verkliga världen

- verkligen

- senaste

- nyligen

- redesign

- dieter

- regionala

- Förhållanden

- frigörs

- förlita

- resterna

- avlägsen

- ersättas

- replikerbarhet

- replikeras

- representerar

- reproduktion

- forskning

- respons

- svar

- resulterande

- ungefär

- Körning

- Nämnda

- Samma

- scenarier

- Skolor

- Vetenskap

- VETENSKAPER

- vetenskaplig

- vetenskapsmän

- känsla

- in

- flera

- svår

- show

- liknande

- helt enkelt

- situationer

- sova

- Social hållbarhet

- sociala medier

- Sociala medier inlägg

- samhällelig

- något

- sofistikerade

- fart

- Stjärnor

- startar

- Steg

- styrkor

- strävar

- studier

- Läsa på

- Studerar

- stöte

- sådana

- stödja

- syntetisk

- System

- Tackles

- Tryck

- grupp

- tech

- testa

- tester

- än

- Tack

- den där

- Smakämnen

- deras

- Dem

- sedan

- teoretiska

- Där.

- Dessa

- de

- detta

- de

- fastän?

- trodde

- tusentals

- Genom

- trött

- till

- verktyg

- verktyg

- ämnen

- mot

- traditionell

- Tåg

- tränad

- Utbildning

- Öppenhet

- färdas

- oroande

- verkligen

- SVÄNG

- paraply

- avslöja

- under

- förstå

- förståelse

- universitet

- utan motstycke

- användning

- användningar

- med hjälp av

- validerade

- värde

- Värden

- mängd

- Omfattande

- mycket

- kontrollerad

- Video

- videospel

- Besök

- försökspersoner

- kriget

- sätt

- we

- Väder

- välkommen

- VÄL

- Vad

- när

- som

- VEM

- varför

- bred

- Brett utbud

- bredare

- wikipedia

- kommer

- med

- utan

- ord

- Arbete

- fungerar

- oro

- skriven

- ja

- ännu

- Om er

- Youtube

- tidsandan

- zephyrnet