DeepMind har gjort det igen.

Efter att ha löst en grundläggande utmaning inom biologi—förutsäga proteinstruktur-och reda ut matematiken i knutteorin, har det tagit sikte på en grundläggande datorprocess inbäddad i tusentals vardagliga applikationer. Från att analysera bilder till modelleringsväder eller till och med undersöka artificiella neurala nätverks inre funktion, AI skulle teoretiskt kunna påskynda beräkningar över en rad olika områden, öka effektiviteten samtidigt som energianvändningen och kostnaderna minskar.

Men mer imponerande är det hur de gjorde det. Den rekordstora algoritmen, kallad AlphaTensor, är en spinoff av Alpha Zero, som berömt slog mänskliga spelare i schack och Go.

"Algorithmer har använts i hela världens civilisationer för att utföra grundläggande operationer i tusentals år," skrev medförfattare Drs. Matej Balog och Alhussein Fawzi på DeepMind. "Men att upptäcka algoritmer är mycket utmanande."

AlphaTensor banar ett spår till en ny värld där AI designar program som överträffar allt människans ingenjörer, samtidigt som den förbättrar sin egen maskins "hjärna".

"Detta arbete tränger in på okänt territorium genom att använda AI för ett optimeringsproblem som människor har arbetat med i decennier ... lösningarna som det hittar kan omedelbart utvecklas för att förbättra beräkningskörningstiderna", säger Dr. Federico Levi, seniorredaktör på Natur, Vilket publicerade studien.

Ange matrismultiplikationen

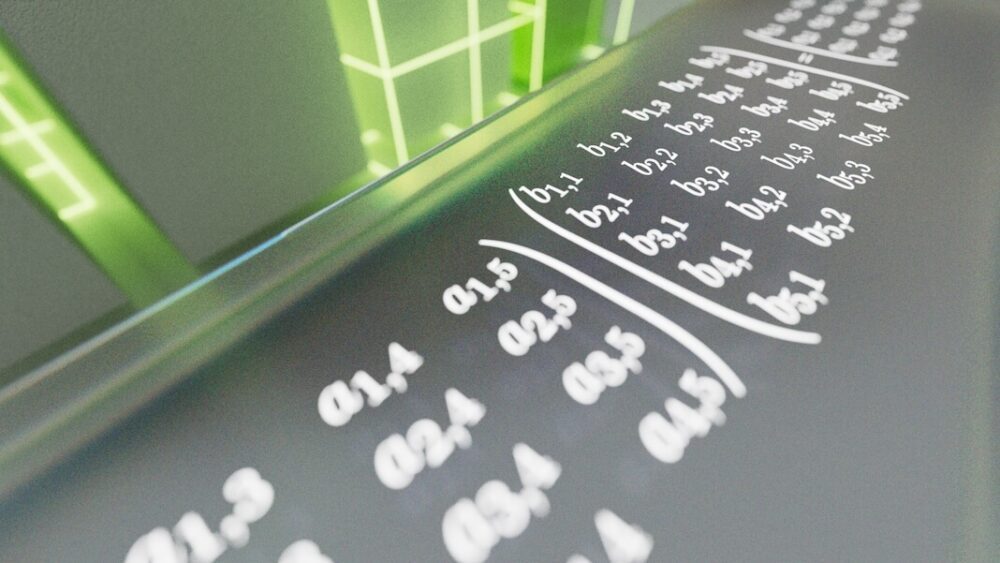

Problemet som AlphaTensor ställs inför är matrismultiplikation. Om du plötsligt föreställer dig rader och kolumner med gröna siffror som rullar ner på skärmen, är du inte ensam. Grovt sett är en matris ungefär så — ett rutnät av siffror som digitalt representerar data som du väljer. Det kan vara pixlar i en bild, frekvenserna för ett ljudklipp eller utseendet och handlingar hos karaktärer i videospel.

Matrismultiplikation tar två rutnät med tal och multiplicerar det ena med det andra. Det är en beräkning som ofta lärs ut i gymnasiet men som också är avgörande för datorsystem. Här multipliceras rader av tal i en matris med kolumner i en annan. Resultaten genererar ett resultat – till exempel ett kommando för att zooma in eller luta din vy av en videospelsscen. Även om dessa beräkningar fungerar under huven, beror alla som använder en telefon eller dator på deras resultat varje dag.

Du kan se hur problemet kan bli extremt svårt, extremt snabbt. Att multiplicera stora matriser är otroligt energi- och tidskrävande. Varje talpar måste multipliceras individuellt för att konstruera en ny matris. När matriserna växer blir problemet snabbt ohållbart – ännu mer än att förutsäga de bästa schack- eller Go-dragen. Vissa experter uppskattar att det finns fler sätt att lösa matrismultiplikation än antalet atomer i universum.

Redan 1969 visade Volker Strassen, en tysk matematiker, att det finns sätt att skära hörn genom att skära en omgång av två-till-två matrismultiplikation från totalt åtta till sju. Det kanske inte låter imponerande, men Strassens metod visade att det är möjligt att slå långvariga standarder för operationer – det vill säga algoritmer – för matrismultiplikation. Hans tillvägagångssätt, Strassen-algoritmen, har regerat som den mest effektiva metoden i över 50 år.

Men vad händer om det finns ännu effektivare metoder? "Ingen känner till den bästa algoritmen för att lösa det," Dr. François Le Gall vid Nagoya University i Japan, som inte var involverad i arbetet, berättade MIT Technology Review. "Det är ett av de största öppna problemen inom datavetenskap."

AI Chasing Algoritmer

Om mänsklig intuition vacklar, varför inte utnyttja ett mekaniskt sinne?

I den nya studien gjorde DeepMind-teamet matrismultiplikation till ett spel. I likhet med sin föregångare AlphaZero använder AlphaTensor djup förstärkningsinlärning, en maskininlärningsmetod inspirerad av hur biologiska hjärnor lär sig. Här interagerar en AI-agent (ofta ett artificiellt neuralt nätverk) med sin omgivning för att lösa ett flerstegsproblem. Om det lyckas får det en "belöning" – det vill säga att AI:s nätverksparametrar uppdateras så att det är mer sannolikt att det lyckas igen i framtiden.

Det är som att lära sig vända en pannkaka. Massor kommer initialt att falla på golvet, men så småningom kommer dina neurala nätverk att lära sig arm- och handrörelserna för en perfekt flip.

Träningsplatsen för AlphaTensor är ett slags 3D-brädspel. Det är i huvudsak ett pussel för en spelare som ungefär liknar Sudoku. AI:n måste multiplicera rutnät av siffror i så få möjliga steg som möjligt, samtidigt som den väljer från en myriad av tillåtna drag – över en biljon av dem.

Dessa tillåtna rörelser designades noggrant i AlphaTensor. Vid en pressträff förklarade medförfattaren Dr. Hussain Fawzi: "Att formulera utrymmet för algoritmisk upptäckt är mycket intrikat ... ännu svårare är, hur kan vi navigera i detta utrymme."

Med andra ord, när vi står inför en häpnadsväckande mängd alternativ, hur kan vi begränsa dem för att förbättra våra chanser att hitta nålen i höstacken? Och hur kan vi bäst lägga en strategi för att komma till nålen utan att gräva igenom hela höstacken?

Ett knep som teamet införlivat i AlphaTensor är en metod som kallas trädsökning. Snarare än, metaforiskt sett, att slumpmässigt gräva genom höstacken, undersöker AI här "vägar" som kan leda till ett bättre resultat. Den mellanliggande inlärningen hjälper sedan AI:n att planera sitt nästa drag för att öka chanserna till framgång. Teamet visade också algoritmexemplen på framgångsrika spel, som att lära ett barn schackets inledande drag. Slutligen, när AI:n upptäckte värdefulla rörelser, tillät teamet det att ordna om dessa operationer för mer skräddarsydd inlärning i jakten på ett bättre resultat.

Att bryta ny mark

AlphaTensor spelade bra. I en serie tester utmanade teamet AI:n att hitta de mest effektiva lösningarna för matriser upp till fem gånger fem – det vill säga med fem nummer vardera i en rad eller kolumn.

Algoritmen återupptäckte snabbt Strassens ursprungliga hack, men överträffade sedan alla lösningar som tidigare utarbetats av det mänskliga sinnet. Genom att testa AI med olika storlekar på matriser hittade AlphaTensor mer effektiva lösningar för över 70. "Faktum är att AlphaTensor vanligtvis upptäcker tusentals algoritmer för varje storlek på matrisen," sa teamet. "Det är häftigt."

I ett fall, multiplicerade en fem gånger fem matris med en fyra gånger fem, skar AI det tidigare rekordet på 80 individuella multiplikationer till endast 76. Det lyste också på större matriser, vilket minskade antalet beräkningar som behövs för två elva-av-elva matriser från 919 till 896.

Proof-of-concept i handen, teamet vände sig till praktisk användning. Datorchips är ofta utformade för att optimera olika beräkningar - GPU:er för grafik, till exempel, eller AI-chips för maskininlärning– och att matcha en algoritm med den bäst lämpade hårdvaran ökar effektiviteten.

Här använde teamet AlphaTensor för att hitta algoritmer för två populära chips inom maskininlärning: NVIDIA V100 GPU och Google TPU. Sammantaget ökade de AI-utvecklade algoritmerna beräkningshastigheten med upp till 20 procent.

Det är svårt att säga om AI också kan snabba upp smartphones, bärbara datorer eller andra vardagliga enheter. Men "den här utvecklingen skulle vara mycket spännande om den kan användas i praktiken", säger MIT:s Dr Virginia Williams. "En ökning av prestanda skulle förbättra många applikationer."

Sinnet hos en AI

Trots att AlphaTensor slog det senaste mänskliga rekordet för matrismultiplikation kan DeepMind-teamet ännu inte förklara varför.

"Det har fått den här fantastiska intuitionen genom att spela dessa spel", sa DeepMind-forskaren och medförfattaren Dr. Pushmeet Kohli vid en pressträff.

Utvecklande algoritmer behöver inte heller vara människan mot maskiner.

Medan AlphaTensor är ett språngbräda mot snabbare algoritmer, kan även snabbare existera. "Eftersom den behöver begränsa sin sökning till algoritmer av en specifik form, kan den missa andra typer av algoritmer som kan vara mer effektiva," skrev Balog och Fawzi.

Kanske en ännu mer spännande väg skulle kombinera mänsklig och maskinell intuition. "Det skulle vara trevligt att ta reda på om den här nya metoden faktiskt sammanfattar alla de tidigare, eller om du kan kombinera dem och få något ännu bättre," sade Williams. Andra experter håller med. Med en mängd algoritmer till sitt förfogande kan forskare börja dissekera dem efter ledtrådar till vad som fick AlphaTensors lösningar att ticka, vilket banar väg för nästa genombrott.

Bildkredit: DeepMind