ChatGPT, DALL-E, Stabil diffusion, och andra generativa AI:er har tagit världen med storm. De skapar fantastisk poesi och bilder. De sipprar in i alla avkrokar av vår värld, från marknadsföring till att skriva juridiska kort och upptäckt av droger. De verkar som affischbarnet för en framgångssaga mellan människa och maskin.

Men under huven ser det mindre peachy ut. Dessa system är enorma energisvin, som kräver datacenter som spottar ut tusentals ton koldioxidutsläpp – vilket ytterligare betonar ett redan flyktigt klimat – och suger upp miljarder dollar. När de neurala nätverken blir mer sofistikerade och mer utbredda kommer energiförbrukningen sannolikt att skjuta i höjden ännu mer.

Mycket bläck har spillts på generativa AI koldioxidavtryck. Dess energibehov kan bli dess undergång, vilket hindrar utvecklingen när den växer ytterligare. Med nuvarande hårdvara förväntas generativ AI "stoppa snart om den fortsätter att förlita sig på standarddatorhårdvara." sade Dr Hechen Wang på Intel Labs.

Det är hög tid att vi bygger hållbar AI.

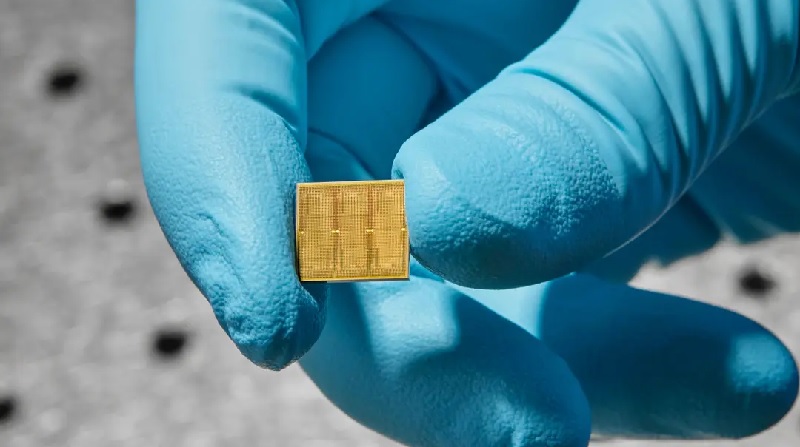

Denna vecka, en studie från IBM tog ett praktiskt steg i den riktningen. De skapade ett 14-nanometer analogt chip packat med 35 miljoner minnesenheter. Till skillnad från nuvarande kretsar, sker beräkning direkt inom dessa enheter, vilket eliminerar behovet av att skicka data fram och tillbaka - i sin tur sparar energi.

Data shuttling kan öka energiförbrukningen allt från 3 till 10,000 XNUMX gånger över vad som krävs för den faktiska beräkningen, sa Wang.

Chipet var mycket effektivt när det utmanades med två taligenkänningsuppgifter. En, Google Speech Commands, är liten men praktisk. Här är hastigheten nyckeln. Den andra, Librispeech, är ett mastodontsystem som hjälper till att transkribera tal till text, vilket beskattar chipets förmåga att bearbeta enorma mängder data.

När det ställs mot konventionella datorer presterade chippet lika exakt men avslutade jobbet snabbare och med mycket mindre energi, och använde mindre än en tiondel av vad som normalt krävs för vissa uppgifter.

"Dessa är, såvitt vi vet, de första demonstrationerna av kommersiellt relevanta noggrannhetsnivåer på en kommersiellt relevant modell ... med effektivitet och massiv parallellism" för ett analogt chip, sa teamet.

Brainy bytes

Detta är knappast det första analoga chippet. Men det driver idén om neuromorfisk datoranvändning till det praktiska riket - ett chip som en dag kan driva din telefon, ditt smarta hem och andra enheter med en effektivitet nära hjärnans.

Öh va? Låt oss backa.

Nuvarande datorer är byggda på Von Neumann arkitektur. Se det som ett hus med flera rum. Den ena, den centrala processorenheten (CPU), analyserar data. En annan lagrar minne.

För varje beräkning måste datorn skicka data fram och tillbaka mellan dessa två rum, och det tar tid och energi och minskar effektiviteten.

Hjärnan, däremot, kombinerar både beräkning och minne till en studiolägenhet. Dess svampliknande korsningar, kallade synapser, bildar både neurala nätverk och lagrar minnen på samma plats. Synapser är mycket flexibla och justerar hur starkt de kopplas till andra neuroner baserat på lagrat minne och nya inlärningar - en egenskap som kallas "vikter". Våra hjärnor anpassar sig snabbt till en ständigt föränderlig miljö genom att justera dessa synaptiska vikter.

IBM har legat i framkant när det gäller design analoga chips som härmar hjärnberäkning. Ett genombrott kom 2016, när de introducerade ett chip baserat på ett fascinerande material som vanligtvis finns på omskrivbara CD-skivor. Materialet ändrar sitt fysiska tillstånd och formförskjuts från en goopy soppa till kristallliknande strukturer när det zappas med elektricitet - liknande en digital 0 och 1.

Här är nyckeln: chippet kan också existera i ett hybridtillstånd. Med andra ord, i likhet med en biologisk synaps, kan den konstgjorda koda en myriad av olika vikter – inte bara binära – vilket gör att den kan samla flera beräkningar utan att behöva flytta en enda bit data.

Jekyll och Hyde

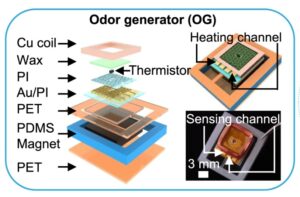

Den nya studien byggde på tidigare arbete genom att även använda fasförändringsmaterial. De grundläggande komponenterna är "minnesbrickor". Var och en är fullproppad med tusentals fasförändringsmaterial i en rutnätsstruktur. Plattorna kommunicerar lätt med varandra.

Varje bricka styrs av en programmerbar lokal styrenhet, vilket gör att teamet kan justera komponenten – i likhet med en neuron – med precision. Chipet lagrar ytterligare hundratals kommandon i sekvens, vilket skapar en sorts svart låda som låter dem gräva tillbaka och analysera dess prestanda.

Sammantaget innehöll chippet 35 miljoner fasförändringsminnesstrukturer. Anslutningarna uppgick till 45 miljoner synapser – långt ifrån den mänskliga hjärnan, men mycket imponerande på ett 14 nanometers chip.

Dessa bedövande siffror utgör ett problem för att initiera AI-chippet: det finns helt enkelt för många parametrar att söka igenom. Teamet tog itu med problemet med vad som motsvarar en AI-dagis, förprogrammerade synaptiska vikter innan beräkningarna börjar. (Det är lite som att krydda en ny gjutjärnspanna innan du lagar mat med den.)

De "skräddarsydda sina nätverksträningstekniker med hårdvarans fördelar och begränsningar i åtanke" och satte sedan vikterna för de mest optimala resultaten, förklarade Wang, som inte var involverad i studien.

Det löste sig. I ett första test körde chipet lätt genom 12.4 biljoner operationer per sekund för varje watt effekt. Energiförbrukningen är "tiotals eller till och med hundratals gånger högre än för de mest kraftfulla CPU:erna och GPU:erna", sa Wang.

Chipet spikade en kärnberäkningsprocess som ligger bakom djupa neurala nätverk med bara några klassiska hårdvarukomponenter i minnesbrickorna. Däremot behöver traditionella datorer hundratals eller tusentals transistorer (en basenhet som utför beräkningar).

Det alla talar om

Teamet utmanade sedan chipet till två taligenkänningsuppgifter. Var och en betonade en annan aspekt av chipet.

Det första testet var snabbhet när den utmanades med en relativt liten databas. Använda Google Talkommandon databas, krävde uppgiften att AI-chippet skulle upptäcka 12 nyckelord i en uppsättning av ungefär 65,000 30 klipp av tusentals människor som talade XNUMX korta ord (”litet” är relativt i djupinlärningsuniversum). När du använder ett accepterat riktmärke—MLPerf— chippet presterade sju gånger snabbare än i tidigare arbete.

Chipet lyste också när det utmanades med en stor databas, Librispeech. Korpusen innehåller över 1,000 XNUMX timmar läst engelskt tal som vanligtvis används för att träna AI för att analysera tal och automatisk tal-till-text-transkription.

Sammantaget använde teamet fem chips för att så småningom koda mer än 45 miljoner vikter med hjälp av data från 140 miljoner fasförändringsenheter. När det ställdes mot konventionell hårdvara var chipet ungefär 14 gånger mer energieffektivt – bearbetade nästan 550 prover varje sekund per watt energiförbrukning – med en felfrekvens på lite över 9 procent.

Även om de är imponerande, är analoga chips fortfarande i sin linda. De visar "enormt löfte för att bekämpa hållbarhetsproblemen förknippade med AI", sa Wang, men vägen framåt kräver att man tar bort några fler hinder.

En faktor är att finslipa designen av själva minnestekniken och dess omgivande komponenter – det vill säga hur chippet är upplagt. IBMs nya chip innehåller ännu inte alla element som behövs. Ett nästa kritiskt steg är att integrera allt på ett enda chip samtidigt som dess effektivitet bibehålls.

På mjukvarusidan kommer vi också att behöva algoritmer som är speciellt anpassade för analoga chips och mjukvara som lätt översätter kod till språk som maskiner kan förstå. När dessa chips blir allt mer kommersiellt gångbara kommer utvecklingen av dedikerade applikationer att hålla drömmen om en framtida analog chip vid liv.

"Det tog decennier att forma de beräkningsekosystem där CPU:er och GPU:er fungerar så framgångsrikt," sa Wang. "Och det kommer förmodligen att ta år att etablera samma typ av miljö för analog AI."

Image Credit: Ryan Lavine för IBM

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Fordon / elbilar, Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- ChartPrime. Höj ditt handelsspel med ChartPrime. Tillgång här.

- BlockOffsets. Modernisera miljökompensation ägande. Tillgång här.

- Källa: https://singularityhub.com/2023/08/25/ibms-brain-inspired-analog-chip-aims-to-make-ai-more-sustainable/

- : har

- :är

- :inte

- $UPP

- 000

- 1

- 10

- 12

- 14

- 30

- 9

- a

- förmåga

- ovan

- accepterade

- Ackumulera

- noggrannhet

- exakt

- faktiska

- anpassa

- mot

- AI

- Syftet

- algoritmer

- Alla

- tillåta

- tillåter

- redan

- också

- mängder

- an

- analysera

- analyser

- och

- Annan

- var som helst

- Lägenhet

- tillämpningar

- ÄR

- konstgjord

- AS

- associerad

- At

- Automat

- tillbaka

- baserat

- grundläggande

- BE

- blir

- varit

- innan

- börja

- Fördelarna

- mellan

- miljarder

- Bit

- Svart

- båda

- Box

- Hjärna

- genombrott

- SLUTRESULTAT

- byggt

- men

- by

- beräkningar

- kallas

- KAN

- kol

- CDS

- Centers

- centrala

- utmanade

- Förändringar

- barn

- chip

- Pommes frites

- Rensa

- klipp

- koda

- kombinerar

- kommersiellt

- vanligen

- kommunicera

- komponenter

- beräkning

- beräkningar

- dator

- datorer

- databehandling

- Kontakta

- Anslutningar

- konsumtion

- innehålla

- innehöll

- innehåller

- fortsätter

- Däremot

- kontrolleras

- styrenhet

- konventionell

- Kärna

- kunde

- skapa

- skapas

- Skapa

- kredit

- kritisk

- Aktuella

- datum

- datacenter

- Databas

- datauppsättningar

- dag

- årtionden

- minskar

- dedicerad

- djup

- djupt lärande

- Efterfrågan

- Designa

- design

- utveckla

- Utveckling

- enheter

- olika

- GRÄV

- digital

- riktning

- direkt

- Upptäckten

- gör

- dollar

- undergång

- dr

- drömmen

- drog

- varje

- ekosystem

- effektivitet

- effektivitet

- effektiv

- element

- energi

- Energiförbrukning

- Engelska

- Miljö

- lika

- fel

- etablera

- Även

- så småningom

- ständigt föränderliga

- Varje

- allt

- existerar

- förklarade

- faktor

- långt

- Far Cry

- fascinerande

- snabbare

- få

- Förnamn

- flexibel

- För

- förgrunden

- formen

- vidare

- Framåt

- hittade

- från

- ytterligare

- framtida

- generativ

- Generativ AI

- GPUs

- Rutnät

- Växer

- sidan

- händer

- hårdvara

- Har

- har

- hjälper

- här.

- Hög

- högre

- höggradigt

- Hem

- huva

- ÖPPETTIDER

- Huset

- Hur ser din drömresa ut

- Men

- html

- HTTPS

- humant

- Hundratals

- häck

- Hybrid

- IBM

- Tanken

- if

- bild

- bilder

- imponerande

- in

- I andra

- Öka

- alltmer

- inledande

- Integrera

- Intel

- in

- introducerade

- involverade

- IT

- DESS

- sig

- Jobb

- jpg

- bara

- Ha kvar

- Nyckel

- nyckelord

- kunskap

- Labs

- språk

- Large

- inlärning

- Adress

- mindre

- nivåer

- tycka om

- sannolikt

- begränsningar

- lokal

- läge

- du letar

- Maskiner

- upprätthålla

- göra

- många

- Marknadsföring

- massiv

- Materialet

- material

- max-bredd

- Minnen

- Minne

- miljon

- emot

- mer

- mest

- flytta

- multipel

- myriad

- Natur

- Nära

- nästan

- Behöver

- behövs

- behov

- nätverk

- neurala nätverk

- neuromorf databehandling

- nervceller

- Nya

- nytt chip

- Nästa

- normalt

- nummer

- of

- on

- ONE

- till

- driva

- Verksamhet

- optimala

- or

- Övriga

- vår

- ut

- över

- packad

- parametrar

- bana

- Personer

- för

- procent

- prestanda

- utfört

- utför

- telefon

- fysisk

- urkärnade

- plato

- Platon Data Intelligence

- PlatonData

- Poesi

- kraft

- den mäktigaste

- Praktisk

- Precision

- presentera

- föregående

- förmodligen

- Problem

- problem

- process

- bearbetning

- löfte

- egenskapen

- skjuter

- snabbt

- Betygsätta

- Läsa

- rike

- erkännande

- relativ

- relativt

- relevanta

- förlita

- Obligatorisk

- Kräver

- vilar

- Resultat

- Rum

- ungefär

- Nämnda

- Samma

- sparande

- Andra

- Seek

- verka

- Sekvens

- in

- sju

- Forma

- Kort

- show

- sida

- liknande

- helt enkelt

- enda

- raket

- Small

- smarta

- Smart hem

- So

- Mjukvara

- några

- snart

- sofistikerade

- tala

- specifikt

- tal

- Taligenkänning

- tal-till-text

- fart

- Spot

- standard

- Ange

- Steg

- Fortfarande

- lagra

- lagras

- lagrar

- Storm

- Historia

- starkt

- struktur

- strukturer

- studio

- Läsa på

- framgång

- framgångssaga

- Framgångsrikt

- kring

- Hållbarhet

- hållbart

- Synapsen

- synapser

- system

- System

- Ta

- tagen

- tar

- uppgift

- uppgifter

- grupp

- tekniker

- Teknologi

- testa

- än

- den där

- Smakämnen

- världen

- deras

- Dem

- sedan

- Där.

- Dessa

- de

- saker

- tror

- de

- tusentals

- Genom

- tid

- gånger

- till

- ton

- alltför

- tog

- traditionell

- Tåg

- Biljon

- SVÄNG

- två

- under

- underliggande

- förstå

- enhet

- enheter

- Universum

- till skillnad från

- Begagnade

- med hjälp av

- vanligen

- mycket

- genomförbar, livskraftig

- flyktiga

- var

- we

- vecka

- Vad

- när

- som

- medan

- VEM

- brett

- kommer

- med

- inom

- utan

- ord

- Arbete

- arbetade

- världen

- skrivning

- år

- ännu

- Din

- zephyrnet