1IRIF, CNRS – Université Paris Cité, Frankrike

2QC Ware, Palo Alto, USA och Paris, Frankrike

3School of Informatics, University of Edinburgh, Skottland, Storbritannien

4F. Hoffmann La Roche AG

Hitta det här uppsatsen intressant eller vill diskutera? Scite eller lämna en kommentar på SciRate.

Abstrakt

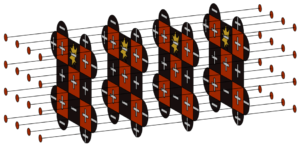

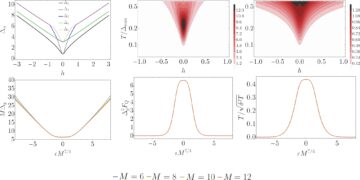

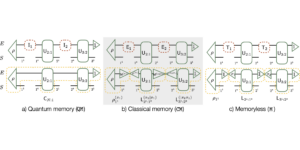

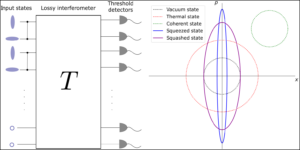

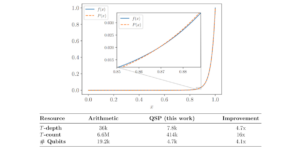

I detta arbete designas och analyseras kvanttransformatorer i detalj genom att utvidga de toppmoderna klassiska neurala nätverksarkitekturerna för transformatorer som är kända för att vara mycket presterande inom naturlig språkbehandling och bildanalys. Med utgångspunkt i det tidigare arbetet, som använder parametriserade kvantkretsar för dataladdning och ortogonala neurala lager, introducerar vi tre typer av kvanttransformatorer för träning och slutledning, inklusive en kvanttransformator baserad på sammansatta matriser, vilket garanterar en teoretisk fördel med kvantuppmärksamhetsmekanismen jämfört med deras klassiska motsvarighet både vad gäller asymptotisk körtid och antalet modellparametrar. Dessa kvantarkitekturer kan byggas med grunda kvantkretsar och producera kvalitativt olika klassificeringsmodeller. De tre föreslagna kvantuppmärksamhetslagren varierar på spektrumet mellan att nära följa de klassiska transformatorerna och uppvisa fler kvantegenskaper. Som byggstenar i kvanttransformatorn föreslår vi en ny metod för att ladda en matris som kvanttillstånd såväl som två nya tränarbara kvantortogonala lager som kan anpassas till olika nivåer av anslutning och kvalitet hos kvantdatorer. Vi utförde omfattande simuleringar av kvanttransformatorerna på vanliga medicinska bilddatauppsättningar som visade konkurrenskraftiga och ibland bättre prestanda jämfört med de klassiska riktmärkena, inklusive de bästa klassiska syntransformatorerna i klassen. Kvanttransformatorerna vi tränade på dessa småskaliga datauppsättningar kräver färre parametrar jämfört med klassiska standardriktmärken. Slutligen implementerade vi våra kvanttransformatorer på supraledande kvantdatorer och fick uppmuntrande resultat för upp till sex qubit-experiment.

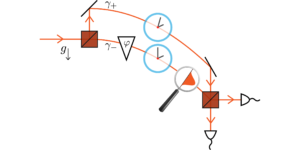

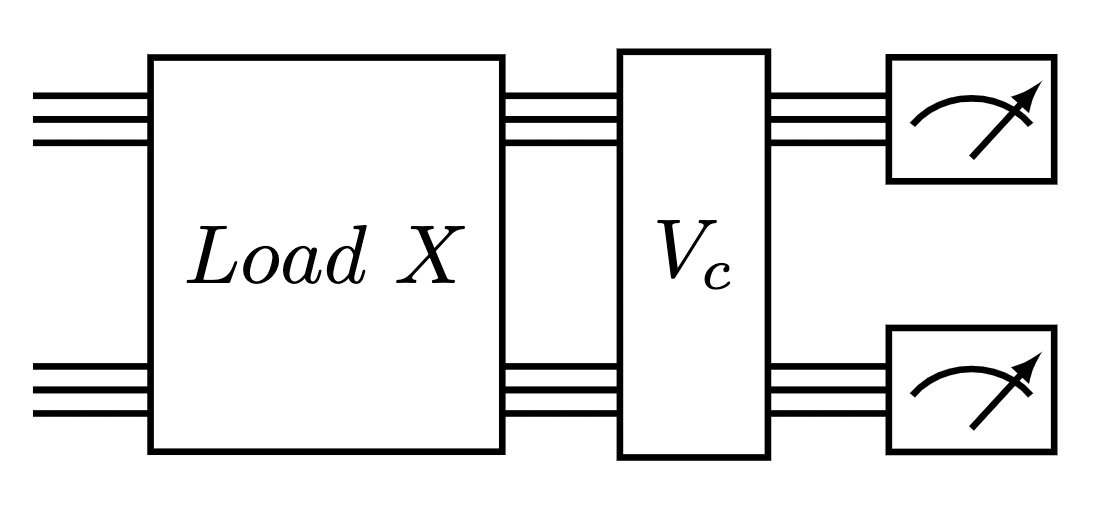

Utvald bild: Kvantkrets för att utföra ett uppmärksamhetslager av Compound Transformer. En matrisdataladdare följt av ett ortogonalt kvantlager.

Populär sammanfattning

► BibTeX-data

► Referenser

[1] Jacob Biamonte, Peter Wittek, Nicola Pancotti, Patrick Rebentrost, Nathan Wiebe och Seth Lloyd. "Kvantmaskininlärning". Nature 549, 195–202 (2017).

https: / / doi.org/ 10.1038 / nature23474

[2] Iris Cong, Soonwon Choi och Mikhail D Lukin. "Quantum konvolutionella neurala nätverk". Nature Physics 15, 1273–1278 (2019).

https://doi.org/10.1038/s41567-019-0648-8

[3] Kishor Bharti, Alba Cervera-Lierta, Thi Ha Kyaw, Tobias Haug, Sumner Alperin-Lea, Abhinav Anand, Matthias Degroote, Hermanni Heimonen, Jakob S Kottmann, Tim Menke, et al. "Brusiga kvantalgoritmer i mellanskala". Reviews of Modern Physics 94, 015004 (2022).

https: / / doi.org/ 10.1103 / RevModPhys.94.015004

[4] Marco Cerezo, Andrew Arrasmith, Ryan Babbush, Simon C Benjamin, Suguru Endo, Keisuke Fujii, Jarrod R McClean, Kosuke Mitarai, Xiao Yuan, Lukasz Cincio, et al. "Variationella kvantalgoritmer". Nature Reviews Physics 3, 625–644 (2021).

https://doi.org/10.1038/s42254-021-00348-9

[5] Jonas Landman, Natansh Mathur, Yun Yvonna Li, Martin Strahm, Skander Kazdaghli, Anupam Prakash och Iordanis Kerenidis. "Kvantummetoder för neurala nätverk och tillämpning på medicinsk bildklassificering". Quantum 6, 881 (2022).

https://doi.org/10.22331/q-2022-12-22-881

[6] Bobak Kiani, Randall Balestriero, Yann LeCun och Seth Lloyd. "projunn: Effektiv metod för att träna djupa nätverk med enhetliga matriser". Advances in Neural Information Processing Systems 35, 14448–14463 (2022).

[7] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Łukasz Kaiser och Illia Polosukhin. "Uppmärksamhet är allt du behöver". Framsteg inom neurala informationsbehandlingssystem 30 (2017).

[8] Jacob Devlin, Ming-Wei Chang, Kenton Lee och Kristina Toutanova. "Bert: Förträning av djupa dubbelriktade transformatorer för språkförståelse" (2018).

[9] Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit och Neil Houlsby. "En bild är värd 16×16 ord: Transformers för bildigenkänning i skala". Internationell konferens om läranderepresentationer (2021). url: openreview.net/forum?id=YicbFdNTTy.

https:///openreview.net/forum?id=YicbFdNTTy

[10] Yi Tay, Mostafa Dehghani, Dara Bahri och Donald Metzler. "Effektiva transformatorer: En undersökning". ACM Computing Surveys (CSUR) (2020).

https: / / doi.org/ 10.1145 / 3530811

[11] Dzmitry Bahdanau, Kyunghyun Cho och Yoshua Bengio. "Neural Machine Translation by Jointly Learning to Align and Translate" (2016). arXiv:1409.0473 [cs, stat].

arXiv: 1409.0473

[12] J. Schmidhuber. "Minska förhållandet mellan inlärningskomplexitet och antal tidsvarierande variabler i helt återkommande nät". I Stan Gielen och Bert Kappen, redaktörer, ICANN '93. Sidorna 460–463. London (1993). Springer.

https://doi.org/10.1007/978-1-4471-2063-6_110

[13] Jürgen Schmidhuber. "Lära sig att kontrollera snabba minnen: ett alternativ till dynamiska återkommande nätverk". Neural Computation 4, 131-139 (1992).

https:///doi.org/10.1162/neco.1992.4.1.131

[14] Peter Cha, Paul Ginsparg, Felix Wu, Juan Carrasquilla, Peter L McMahon och Eun-Ah Kim. "Uppmärksamhetsbaserad kvanttomografi". Machine Learning: Science and Technology 3, 01LT01 (2021).

https:///doi.org/10.1088/2632-2153/ac362b

[15] Riccardo Di Sipio, Jia-Hong Huang, Samuel Yen-Chi Chen, Stefano Mangini och Marcel Worring. "Gryningen av kvantbearbetning av naturligt språk". I ICASSP 2022-2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Sidorna 8612–8616. IEEE (2022).

https:///doi.org/10.1109/ICASSP43922.2022.9747675

[16] Guangxi Li, Xuanqiang Zhao och Xin Wang. "Quantum självuppmärksamhet neurala nätverk för textklassificering" (2022).

[17] Fabio Sanches, Sean Weinberg, Takanori Ide och Kazumitsu Kamiya. "Korta kvantkretsar i förstärkningsinlärningspolicyer för fordonsdirigeringsproblemet". Physical Review A 105, 062403 (2022).

https: / / doi.org/ 10.1103 / PhysRevA.105.062403

[18] YuanFu Yang och Min Sun. "Detektering av halvledardefekter genom hybrid klassisk kvantdjupinlärning". CVPRPages 2313–2322 (2022).

https:///doi.org/10.1109/CVPR52688.2022.00236

[19] Maxwell Henderson, Samriddhi Shakya, Shashindra Pradhan och Tristan Cook. "Kvanvolutionella neurala nätverk: driver bildigenkänning med kvantkretsar". Quantum Machine Intelligence 2, 1–9 (2020).

https: / / doi.org/ 10.1007 / s42484-020-00012-y

[20] Edward Farhi och Hartmut Neven. "Klassificering med kvantneurala nätverk på korttidsprocessorer" (2018). URL: doi.org/10.48550/arXiv.1802.06002.

https:///doi.org/10.48550/arXiv.1802.06002

[21] Kosuke Mitarai, Makoto Negoro, Masahiro Kitagawa och Keisuke Fujii. "Kvantumkretslärande". Fysisk granskning A 98, 032309 (2018).

https: / / doi.org/ 10.1103 / PhysRevA.98.032309

[22] Kui Jia, Shuai Li, Yuxin Wen, Tongliang Liu och Dacheng Tao. "Ortogonala djupa neurala nätverk". IEEE-transaktioner om mönsteranalys och maskinintelligens (2019).

https: / / doi.org/ 10.1109 / TPAMI.2019.2948352

[23] Roger A Horn och Charles R Johnson. "Matrisanalys". Cambridge University Press. (2012).

https: / / doi.org/ 10.1017 / CBO9780511810817

[24] Iordanis Kerenidis och Anupam Prakash. "Quantum machine learning with subspace states" (2022).

[25] Brooks Foxen, Charles Neill, Andrew Dunsworth, Pedram Roushan, Ben Chiaro, Anthony Megrant, Julian Kelly, Zijun Chen, Kevin Satzinger, Rami Barends, et al. "Demonstrera en kontinuerlig uppsättning två-qubit-grindar för kortsiktiga kvantalgoritmer". Physical Review Letters 125, 120504 (2020).

https: / / doi.org/ 10.1103 / PhysRevLett.125.120504

[26] Sonika Johri, Shantanu Debnath, Avinash Mocherla, Alexandros Singk, Anupam Prakash, Jungsang Kim och Iordanis Kerenidis. "Närmaste tyngdpunktsklassificering på en fångade jonkvantdator". npj Quantum Information 7, 122 (2021).

https://doi.org/10.1038/s41534-021-00456-5

[27] James W Cooley och John W Tukey. "En algoritm för maskinberäkning av komplexa fourierserier". Mathematics of computing 19, 297–301 (1965).

https://doi.org/10.1090/S0025-5718-1965-0178586-1

[28] Li Jing, Yichen Shen, Tena Dubcek, John Peurifoy, Scott A. Skirlo, Yann LeCun, Max Tegmark och Marin Soljacic. "Inställbara effektiva enhetliga neurala nätverk (eunn) och deras tillämpning på rnns". I internationell konferens om maskininlärning. (2016). URL: api.semanticscholar.org/CorpusID:5287947.

https:///api.semanticscholar.org/CorpusID:5287947

[29] Léo Monbroussou, Jonas Landman, Alex B. Grilo, Romain Kukla och Elham Kashefi. "Träningsförmåga och uttrycksförmåga hos hamming-viktsbevarande kvantkretsar för maskininlärning" (2023). arXiv:2309.15547.

arXiv: 2309.15547

[30] Enrico Fontana, Dylan Herman, Shouvanik Chakrabarti, Niraj Kumar, Romina Yalovetzky, Jamie Heredge, Shree Hari Sureshbabu och Marco Pistoia. "Adjoint är allt du behöver: Karakteriserande karga platåer i quantum ansätze" (2023). arXiv:2309.07902.

arXiv: 2309.07902

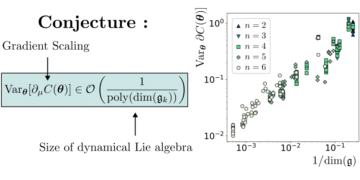

[31] Michael Ragone, Bojko N. Bakalov, Frédéric Sauvage, Alexander F. Kemper, Carlos Ortiz Marrero, Martin Larocca och M. Cerezo. "En enhetlig teori om karga platåer för djupa parametriserade kvantkretsar" (2023). arXiv:2309.09342.

arXiv: 2309.09342

[32] Xuchen You och Xiaodi Wu. "Exponentiellt många lokala minima i kvantneurala nätverk". I internationell konferens om maskininlärning. Sidorna 12144–12155. PMLR (2021).

[33] Eric R. Anschuetz och Bobak Toussi Kiani. "Kvantvariationsalgoritmer är översvämmade med fällor". Nature Communications 13 (2022).

https://doi.org/10.1038/s41467-022-35364-5

[34] Ilya O. Tolstikhin, Neil Houlsby, Alexander Kolesnikov, Lucas Beyer, Xiaohua Zhai, Thomas Unterthiner, Jessica Yung, Daniel Keysers, Jakob Uszkoreit, Mario Lucic och Alexey Dosovitskiy. "Mlp-mixer: En hel-mlp-arkitektur för vision". I NeurIPS. (2021).

[35] Jiancheng Yang, Rui Shi och Bingbing Ni. "Medmnist classification decathlon: A lightweight automl benchmark for medicinsk bildanalys" (2020).

https:///doi.org/10.1109/ISBI48211.2021.9434062

[36] Jiancheng Yang, Rui Shi, Donglai Wei, Zequan Liu, Lin Zhao, Bilian Ke, Hanspeter Pfister och Bingbing Ni. "Medmnist v2-en storskalig lättviktsriktmärke för 2d och 3d biomedicinsk bildklassificering". Scientific Data 10, 41 (2023).

https://doi.org/10.1038/s41597-022-01721-8

[37] Angelos Katharopoulos, Apoorv Vyas, Nikolaos Pappas och François Fleuret. "Transformatorer är rnns: Snabba autoregressiva transformatorer med linjär uppmärksamhet". I internationell konferens om maskininlärning. Sidorna 5156–5165. PMLR (2020).

[38] James Bradbury, Roy Frostig, Peter Hawkins, Matthew James Johnson, Chris Leary, Dougal Maclaurin, George Necula, Adam Paszke, Jake VanderPlas, Skye Wanderman-Milne och Qiao Zhang. "JAX: komponerbara transformationer av Python+NumPy-program". Github (2018). URL: http:///github.com/google/jax.

http: / / github.com/ google / jax

[39] Diederik P. Kingma och Jimmy Ba. "Adam: En metod för stokastisk optimering". CoRR abs/1412.6980 (2015).

[40] Hyeonwoo Noh, Tackgeun You, Jonghwan Mun och Bohyung Han. "Regulering av djupa neurala nätverk med brus: dess tolkning och optimering". NeurIPS (2017).

[41] Xue Ying. "En översikt över övermontering och dess lösningar". I Journal of Physics: Conference Series. Volym 1168, sid 022022. IOP Publishing (2019).

https://doi.org/10.1088/1742-6596/1168/2/022022

Citerad av

[1] David Peral García, Juan Cruz-Benito och Francisco José García-Peñalvo, "Systematic Literature Review: Quantum Machine Learning and its applications", arXiv: 2201.04093, (2022).

[2] El Amine Cherrat, Snehal Raj, Iordanis Kerenidis, Abhishek Shekhar, Ben Wood, Jon Dee, Shouvanik Chakrabarti, Richard Chen, Dylan Herman, Shaohan Hu, Pierre Minssen, Ruslan Shaydulin, Yue Sun, Romina Yalovetzky och Marco Pistoia, "Quantum Deep Hedging", Quantum 7, 1191 (2023).

[3] Léo Monbroussou, Jonas Landman, Alex B. Grilo, Romain Kukla och Elham Kashefi, "Trainability and Expressivity of Hamming-Weight Preserving Quantum Circuits for Machine Learning", arXiv: 2309.15547, (2023).

[4] Sohum Thakkar, Skander Kazdaghli, Natansh Mathur, Iordanis Kerenidis, André J. Ferreira-Martins och Samurai Brito, "Förbättrad finansiell prognoser via kvantmaskininlärning", arXiv: 2306.12965, (2023).

[5] Jason Iaconis och Sonika Johri, "Tensor Network Based Efficient Quantum Data Loading of Images", arXiv: 2310.05897, (2023).

[6] Nishant Jain, Jonas Landman, Natansh Mathur och Iordanis Kerenidis, "Quantum Fourier Networks for Solving Parametric PDEs", arXiv: 2306.15415, (2023).

[7] Daniel Mastropietro, Georgios Korpas, Vyacheslav Kungurtsev och Jakub Marecek, "Fleming-Viot hjälper till att påskynda variationsmässiga kvantalgoritmer i närvaro av karga platåer", arXiv: 2311.18090, (2023).

[8] Aliza U. Siddiqui, Kaitlin Gili och Chris Ballance, "Stressing Out Modern Quantum Hardware: Performance Evaluation and Execution Insights", arXiv: 2401.13793, (2024).

Ovanstående citat är från SAO / NASA ADS (senast uppdaterad framgångsrikt 2024-02-22 13:37:43). Listan kan vara ofullständig eftersom inte alla utgivare tillhandahåller lämpliga och fullständiga citatdata.

Det gick inte att hämta Crossref citerade data under senaste försöket 2024-02-22 13:37:41: Det gick inte att hämta citerade data för 10.22331 / q-2024-02-22-1265 från Crossref. Detta är normalt om DOI registrerades nyligen.

Detta papper publiceras i Quantum under Creative Commons Attribution 4.0 International (CC BY 4.0) licens. Upphovsrätten kvarstår med de ursprungliga upphovsrättsinnehavarna som författarna eller deras institutioner.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://quantum-journal.org/papers/q-2024-02-22-1265/

- :är

- :inte

- ][s

- $UPP

- 1

- 10

- 11

- 12

- 125

- 13

- 14

- 15%

- 16

- 17

- 19

- 20

- 2012

- 2015

- 2016

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 2024

- 22

- 23

- 24

- 25

- 26%

- 27

- 28

- 29

- 2D

- 30

- 31

- 32

- 33

- 35%

- 36

- 39

- 3d

- 40

- 41

- 43

- 7

- 8

- 9

- 98

- a

- ovan

- SAMMANDRAG

- tillgång

- ACM

- Adam

- Dessutom

- framsteg

- Fördel

- fördelar

- anknytningar

- AL

- alex

- Alexander

- algoritm

- algoritmer

- rikta

- Alla

- alternativ

- an

- analys

- och

- Andrew

- Anthony

- api

- Ansökan

- tillämpningar

- arkitektur

- arkitekturer

- ÄR

- AS

- antaganden

- At

- försök

- uppmärksamhet

- Författaren

- Författarna

- AutoML

- karg

- baserat

- BE

- ben

- riktmärke

- riktmärken

- Benjamin

- Bättre

- mellan

- dubbelriktad

- biomedicinsk

- Block

- båda

- Ha sönder

- Byggnad

- byggt

- by

- beräkning

- cambridge

- KAN

- kapacitet

- carlos

- cha

- chang

- egenskaper

- Charles

- chen

- CHO

- chris

- klassificering

- nära

- kommentar

- Commons

- Trygghet i vårdförloppet

- jämfört

- konkurrenskraftig

- fullborda

- komplex

- Komplexiteten

- komponerbar

- Luktämne

- beräkning

- dator

- datorer

- databehandling

- Konferens

- Anslutningar

- kontinuerlig

- kontroll

- upphovsrätt

- kunde

- motsvarighet

- motsvarigheter

- skapa

- Daniel

- datum

- datauppsättningar

- David

- djup

- djupt lärande

- demonstrera

- utformade

- detalj

- Detektering

- olika

- diskutera

- donald

- under

- dynamisk

- E&T

- redaktörer

- Edward

- effektivitet

- effektiv

- el

- uppmuntra

- förbättra

- eric

- utvärdering

- Även

- exekvera

- utförande

- uppvisar

- experiment

- utforska

- sträcker

- omfattande

- SNABB

- februari

- färre

- Slutligen

- finansiella

- fokusering

- följt

- efter

- För

- Francisco

- från

- fullständigt

- grindar

- George

- GitHub

- Gomez

- garantier

- hårdvara

- Harvard

- säkring

- hjälpa

- hjälper

- hållare

- http

- HTTPS

- huang

- Hybrid

- IEEE

- if

- illia

- bild

- Bildklassificering

- Bildigenkänning

- bilder

- genomföras

- förbättras

- in

- Inklusive

- informationen

- insikter

- institutioner

- Intelligens

- intressant

- Internationell

- tolkning

- införa

- DESS

- Jacob

- james

- jamie

- JavaScript

- jimmy

- John

- Johnson

- jon

- jones

- tidskriften

- John

- kim

- känd

- kumar

- språk

- storskalig

- Efternamn

- lager

- skikt

- inlärning

- Lämna

- Lee

- nivåer

- hävstångs

- Li

- Licens

- lättvikt

- tycka om

- Lin

- linjär

- Lista

- litteraturen

- Lastaren

- läser in

- lokal

- london

- Maskinen

- maskininlärning

- många

- ram

- mario

- Martin

- matematik

- Matris

- Matthew

- max

- max-bredd

- Maxwell

- Maj..

- mcclean

- mekanism

- medicinsk

- Minnen

- metod

- metoder

- Michael

- mikhail

- min

- modell

- modeller

- Modern Konst

- Månad

- mer

- Natural

- Naturlig språkbehandling

- Natur

- Nära

- Behöver

- Nets

- nät

- nätverk

- neurala

- neurala nätverk

- neurala nätverk

- Nya

- Brus

- normala

- roman

- antal

- erhållna

- of

- on

- ONE

- öppet

- optimering

- or

- ursprungliga

- vår

- ut

- över

- Översikt

- sida

- sidor

- Palo Alto

- Papper

- parametrar

- paris

- patrick

- Mönster

- paul

- prestanda

- utfört

- Peter

- fysisk

- Fysik

- Pierre

- plato

- Platon Data Intelligence

- PlatonData

- Strategier

- polosukhin

- potentiell

- Strömförsörjning

- Prakash

- Närvaron

- presentera

- konservering

- tryck

- föregående

- Problem

- bearbetning

- processorer

- producera

- Program

- lovande

- föreslå

- föreslagen

- ge

- publicerade

- utgivare

- förlag

- publicering

- kvalitet

- Quantum

- kvantalgoritmer

- Kvantdator

- kvantdatorer

- kvantkalkylering

- kvantinformation

- kvantmaskininlärning

- qubit

- R

- RAMI

- ratio

- nyligen

- erkännande

- återkommande

- referenser

- registrerat

- resterna

- kräver

- Resultat

- översyn

- Omdömen

- Richard

- roche

- romain

- routing

- roy

- Körning

- runtime

- Ryan

- s

- Skala

- Vetenskap

- Vetenskap och teknik

- vetenskaplig

- scott

- sean

- Serier

- in

- grunt

- visade

- Signal

- Simon

- simuleringar

- SEX

- Lösningar

- Lösa

- några

- Spektrum

- tal

- fart

- standard

- state-of-the-art

- Stater

- Läsa på

- Framgångsrikt

- sådana

- lämplig

- sol

- supraledande

- Undersökning

- System

- uppgifter

- tay

- Teknologi

- termin

- villkor

- text

- Textklassificering

- den där

- Smakämnen

- deras

- teoretiska

- Teorin

- Dessa

- de

- detta

- thomas

- tre

- tim

- tid

- gånger

- Titel

- till

- tränad

- Utbildning

- Transaktioner

- transformationer

- transformator

- transformatorer

- Översätt

- Översättning

- instängd

- fällor

- två

- typer

- under

- förståelse

- enhetlig

- unika

- universitet

- uppdaterad

- på

- URL

- USA

- användningar

- med hjälp av

- variera

- varierande

- vehikel

- mycket

- via

- syn

- volym

- W

- Wang

- vill

- var

- we

- VÄL

- som

- med

- trä

- ord

- Arbete

- värt

- wu

- xiao

- år

- Avkastning

- YING

- Om er

- Yuan

- zephyrnet

- Zhao