Amazon SageMaker Data Wrangler hjälper dig att förstå, aggregera, transformera och förbereda data för maskininlärning (ML) från ett enda visuellt gränssnitt. Den innehåller över 300 inbyggda datatransformationer så att du snabbt kan normalisera, transformera och kombinera funktioner utan att behöva skriva någon kod.

Datavetenskapsutövare genererar, observerar och bearbetar data för att lösa affärsproblem där de behöver transformera och extrahera funktioner från datauppsättningar. Transformeringar som ordinarie kodning eller one-hot encoding lär dig kodningar på din datauppsättning. Dessa kodade utgångar kallas tränade parametrar. Eftersom datamängder förändras över tiden kan det bli nödvändigt att anpassa kodningar på tidigare osynliga data för att hålla transformationsflödet relevant för dina data.

Vi är glada över att kunna presentera funktionen för ombyggnad av tränade parameter, som gör att du kan använda tidigare tränade parametrar och anpassa dem efter önskemål. I det här inlägget visar vi hur du använder den här funktionen.

Översikt över funktionen för återanpassning av Data Wrangler

Vi illustrerar hur den här funktionen fungerar med följande exempel, innan vi dyker in i detaljerna för den återmonterade parameterfunktionen.

Anta att din kunddatauppsättning har en kategorisk funktion för country representeras som strängar som Australia och Singapore. ML-algoritmer kräver numeriska inmatningar; därför måste dessa kategoriska värden kodas till numeriska värden. Att koda kategorisk data är processen att skapa en numerisk representation för kategorier. Till exempel om din kategori land har värden Australia och Singapore, kan du koda denna information i två vektorer: [1, 0] för att representera Australia och [0, 1] för att representera Singapore. Transformationen som används här är one-hot-kodning och den nya kodade utgången återspeglar de tränade parametrarna.

Efter att ha tränat modellen kan dina kunder med tiden öka och du har mer distinkta värden i landslistan. Den nya datamängden kan innehålla en annan kategori, India, som inte var en del av den ursprungliga datamängden, vilket kan påverka modellens noggrannhet. Därför är det nödvändigt att träna om din modell med den nya data som har samlats in över tiden.

För att lösa detta problem måste du uppdatera kodningen för att inkludera den nya kategorin och uppdatera vektorrepresentationen enligt din senaste datauppsättning. I vårt exempel bör kodningen återspegla den nya kategorin för country, vilket är India. Vi hänvisar vanligtvis till denna process för att uppdatera en kodning som en återanpassningsoperation. När du har utfört återanpassningsoperationen får du den nya kodningen: Australia: [1, 0, 0], Singapore: [0, 1, 0] och India: [0, 0, 1]. Att montera om den enkla kodningen och sedan träna om modellen på den nya datamängden resulterar i bättre kvalitetsförutsägelser.

Data Wranglers refittränade parameterfunktion är användbar i följande fall:

- Ny data läggs till i datasetet – Omskolning av ML-modellen är nödvändig när datasetet berikas med nya data. För att uppnå optimala resultat måste vi anpassa de tränade parametrarna på den nya datamängden.

- Träning på en fullständig datauppsättning efter att ha utfört funktionsteknik på exempeldata – För en stor datamängd övervägs ett urval av datamängden för inlärning av tränade parametrar, som kanske inte representerar hela din dataset. Vi måste lära oss om de tränade parametrarna på hela datasetet.

Följande är några av de vanligaste Data Wrangler-transformationerna som utförs på datamängden och som drar nytta av alternativet för återanpassningsutbildade parameter:

För mer information om transformationer i Data Wrangler, se Transformera data.

I det här inlägget visar vi hur man bearbetar dessa tränade parametrar på dataset med Data Wrangler. Du kan använda Data Wrangler-flöden i produktionsjobb för att bearbeta din data när den växer och förändras.

Lösningsöversikt

För det här inlägget visar vi hur man använder Data Wranglers funktion för ombyggnad av utbildade parameter med den allmänt tillgängliga datamängden på Kaggle: Bostäder i USA från Zillow, fastigheter till salu i USA. Den har hemförsäljningspriser över olika geodistributioner av hem.

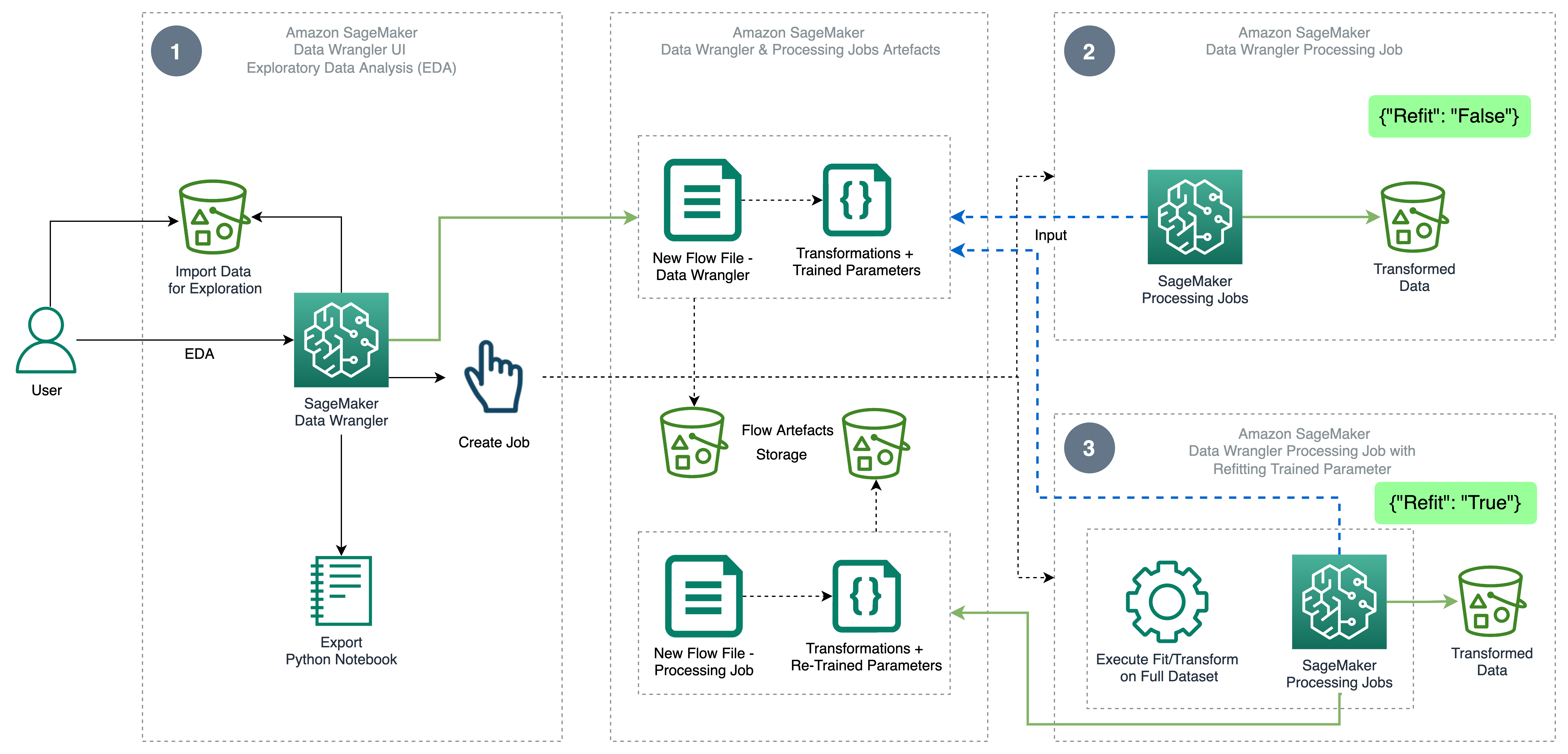

Följande diagram illustrerar högnivåarkitekturen för Data Wrangler med hjälp av funktionen för återanpassning av tränade parameter. Vi visar också effekten på datakvaliteten utan den ombyggda parametern och kontrasterar resultaten i slutet.

Arbetsflödet innehåller följande steg:

- Utför utforskande dataanalys – Skapa ett nytt flöde på Data Wrangler för att starta den utforskande dataanalysen (EDA). Importera affärsdata för att förstå, rensa, aggregera, transformera och förbereda din data för utbildning. Hänvisa till Utforska Amazon SageMaker Data Wrangler-funktioner med exempeldatauppsättningar för mer information om hur du utför EDA med Data Wrangler.

- Skapa ett databearbetningsjobb – Det här steget exporterar alla transformationer som du gjort på datamängden som en flödesfil lagrad i den konfigurerade Amazon enkel lagringstjänst (Amazon S3) plats. Databearbetningsjobbet med flödesfilen som genereras av Data Wrangler tillämpar transformationerna och tränade parametrar som lärts in på din datauppsättning. När databearbetningsjobbet är klart laddas utdatafilerna upp till Amazon S3-platsen som konfigurerats i destinationsnoden. Observera att ombyggnadsalternativet är avstängt som standard. Som ett alternativ till att utföra bearbetningsjobbet omedelbart kan du också schemalägga ett bearbetningsjobb med några få klick med Data Wrangler – Skapa jobb för att köra vid specifika tidpunkter.

- Skapa ett databearbetningsjobb med den återmonterade parameterfunktionen – Välj den nya refittränade parameterfunktionen medan du skapar jobbet för att framtvinga återinlärning av dina tränade parametrar på din fullständiga eller förstärkta datauppsättning. Enligt Amazon S3-platskonfigurationen för lagring av flödesfilen skapar eller uppdaterar databearbetningsjobbet den nya flödesfilen. Om du konfigurerar samma Amazon S3-plats som i steg 2, uppdaterar databearbetningsjobbet flödesfilen som genereras i steg 2, som kan användas för att hålla ditt flöde relevant för dina data. När bearbetningsjobbet har slutförts laddas utdatafilerna upp till den S3-bucket som är konfigurerad för målnoden. Du kan använda det uppdaterade flödet på hela din datauppsättning för ett produktionsarbetsflöde.

Förutsättningar

Innan du börjar ladda upp datasetet till en S3-bucket och importera det sedan till Data Wrangler. För instruktioner, se Importera data från Amazon S3.

Låt oss nu gå igenom stegen som nämns i arkitekturdiagrammet.

Utför EDA i Data Wrangler

För att testa funktionen för ombyggnad av utbildade parameter, ställ in följande analys och transformation i Data Wrangler. I slutet av installationen av EDA skapar Data Wrangler en flödesfil som fångas med tränade parametrar från datamängden.

- Skapa ett nytt flöde i Amazon SageMaker Data Wrangler för utforskande dataanalys.

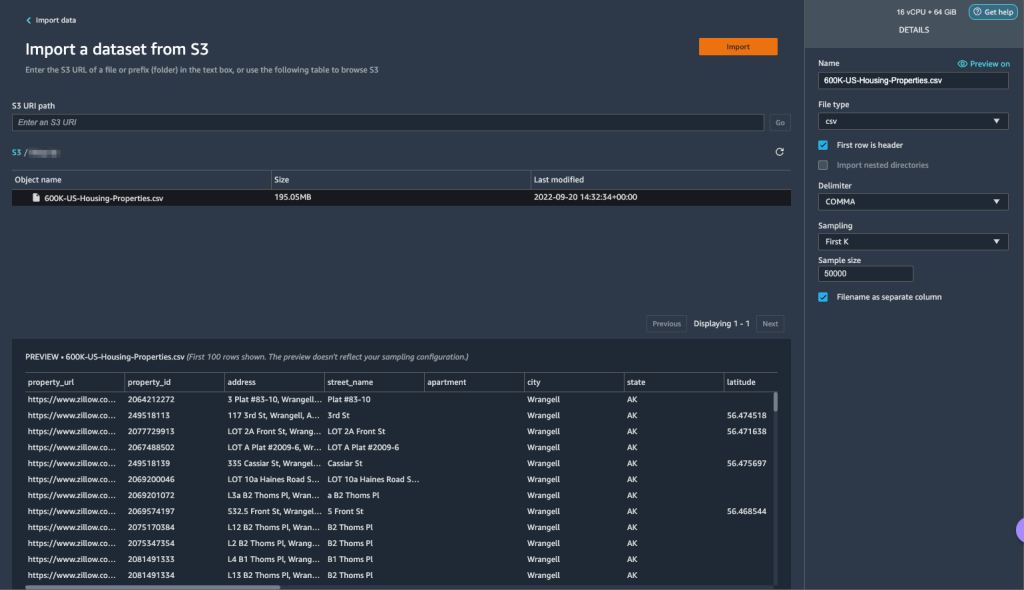

- Importera företagsdata du laddade upp till Amazon S3.

- Du kan förhandsgranska data och alternativ för att välja filtyp, avgränsare, sampling och så vidare. För det här exemplet använder vi Först K samplingsalternativ tillhandahållet av Data Wrangler för att importera de första 50,000 XNUMX posterna från datamängden.

- Välja Importera.

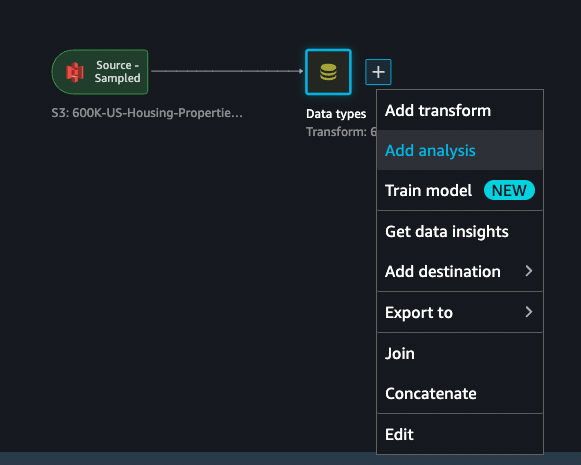

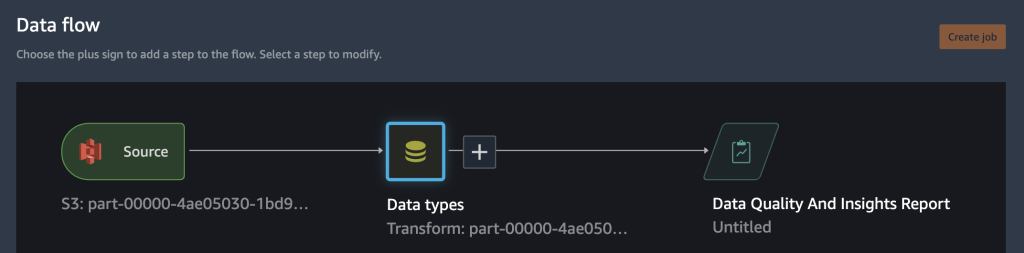

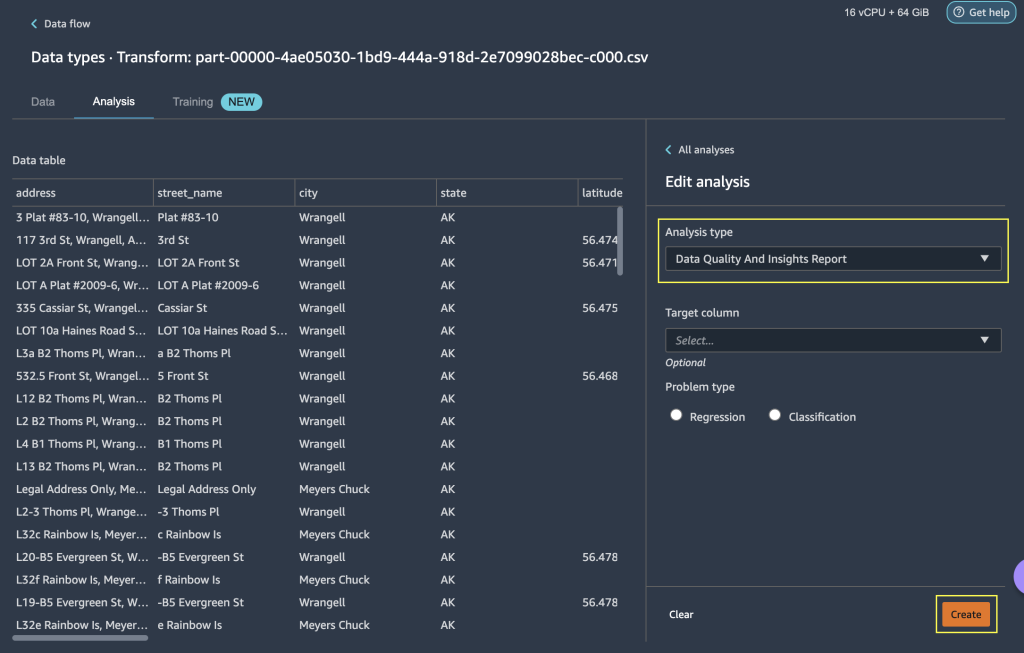

- När du har kollat in datatypsmatchningen som tillämpas av Data Wrangler lägger du till en ny analys.

- För Analystypväljer Rapport för datakvalitet och insikter.

- Välja Skapa.

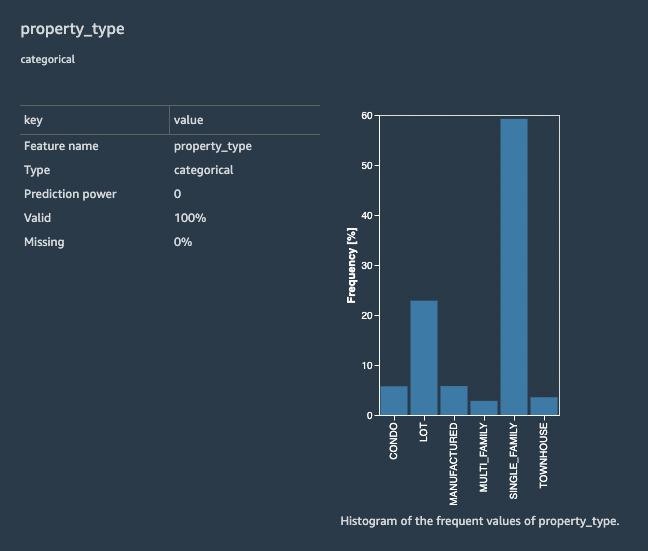

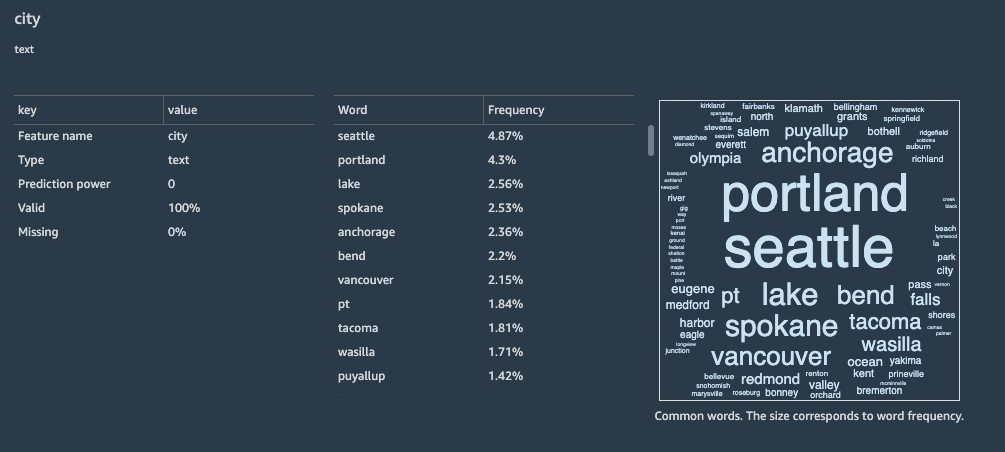

Med rapporten Datakvalitet och insikter får du en kort sammanfattning av datamängden med allmän information som saknade värden, ogiltiga värden, funktionstyper, antal extremvärden och mer. Du kan välja funktioner property_type och city för att tillämpa transformationer på datamängden för att förstå funktionen för återinpassning av utbildade parameter.

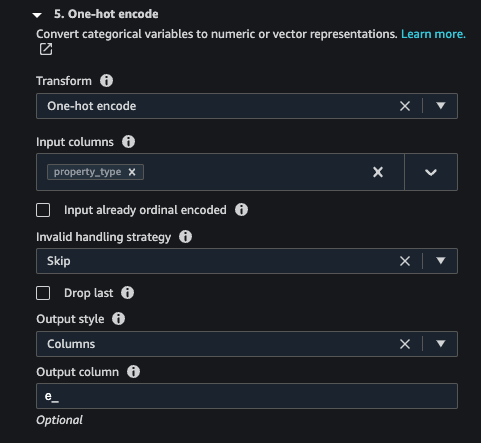

Låt oss fokusera på funktionen property_type från datamängden. I rapportens Funktionsdetaljer avsnitt, kan du se property_type, som är en kategorisk funktion, och sex unika värden härledda från 50,000 XNUMX samplade dataset av Data Wrangler. Den kompletta datamängden kan ha fler kategorier för funktionen property_type. För en funktion med många unika värden kanske du föredrar ordinalkodning. Om funktionen har ett fåtal unika värden kan en engångskodning användas. För det här exemplet väljer vi one-hot-kodning på property_type.

På samma sätt för city feature, som är en textdatatyp med ett stort antal unika värden, låt oss tillämpa ordinalkodning på denna funktion.

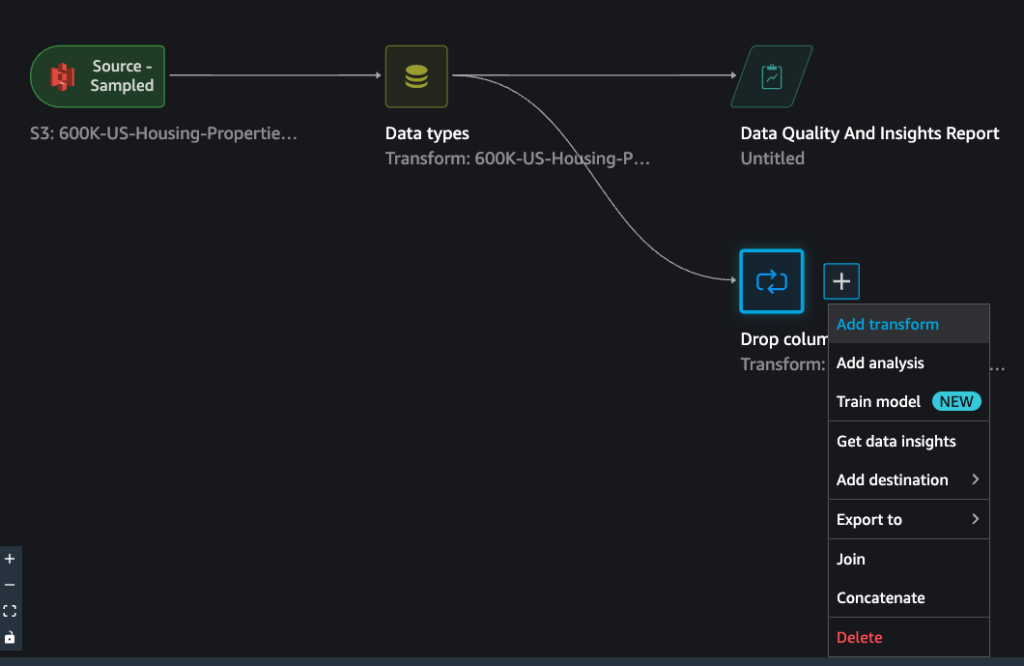

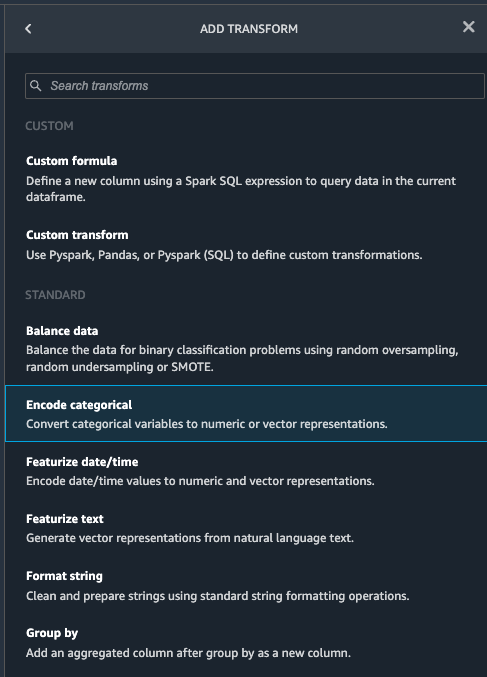

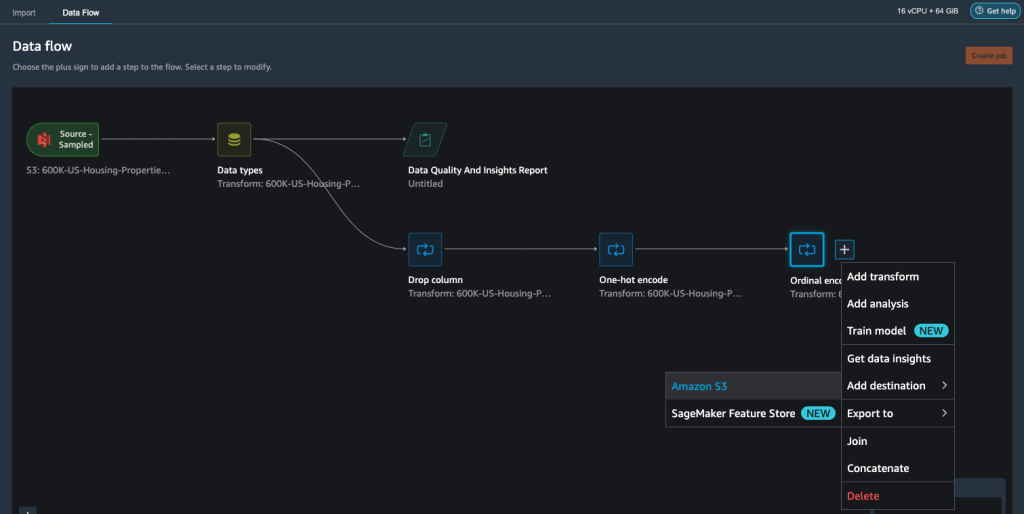

- Navigera till Data Wrangler-flödet, välj plustecknet och välj Lägg till transform.

- Välj Koda kategoriskt alternativ för att omvandla kategoriska egenskaper.

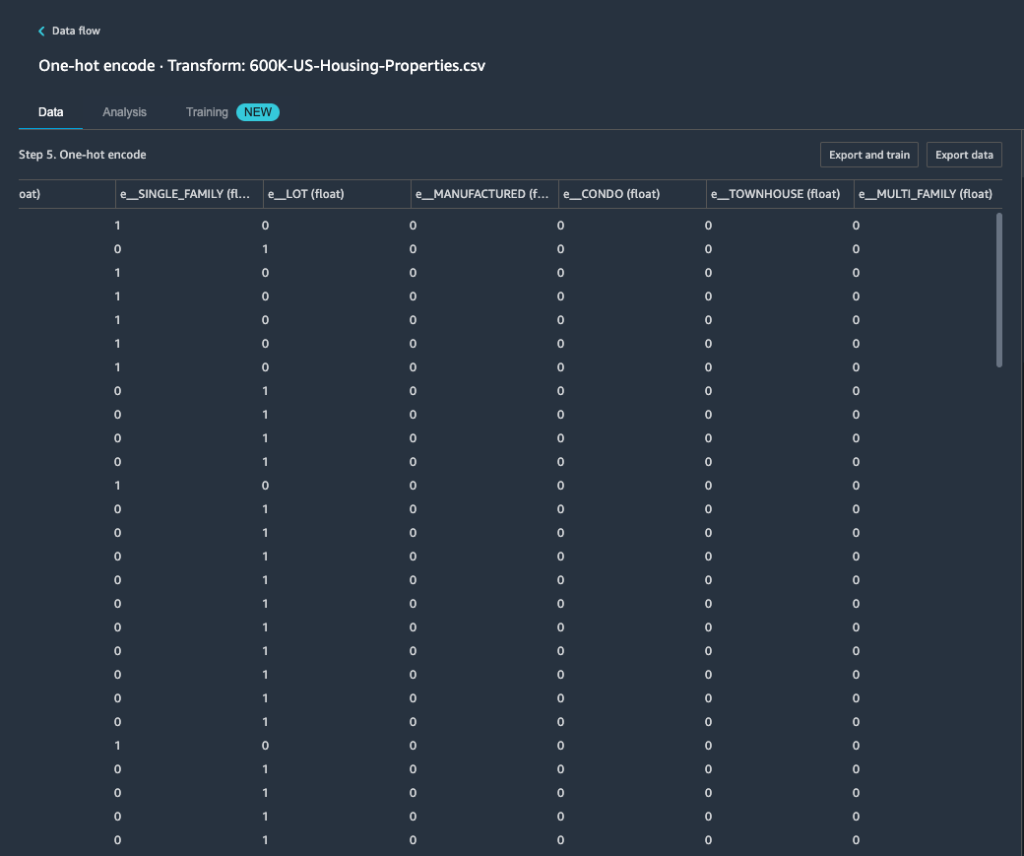

Från rapporten Datakvalitet och insikter, funktionen property_type visar sex unika kategorier: CONDO, LOT, MANUFACTURED, SINGLE_FAMILY, MULTI_FAMILYoch TOWNHOUSE.

- För Förvandlaväljer En het kodning.

Efter att ha tillämpat en varm kodning på funktionen property_type, kan du förhandsgranska alla sex kategorier som separata funktioner som läggs till som nya kolumner. Observera att 50,000 XNUMX poster samplades från din datauppsättning för att generera denna förhandsvisning. När du kör ett Data Wrangler-bearbetningsjobb med detta flöde, tillämpas dessa transformationer på hela din datauppsättning.

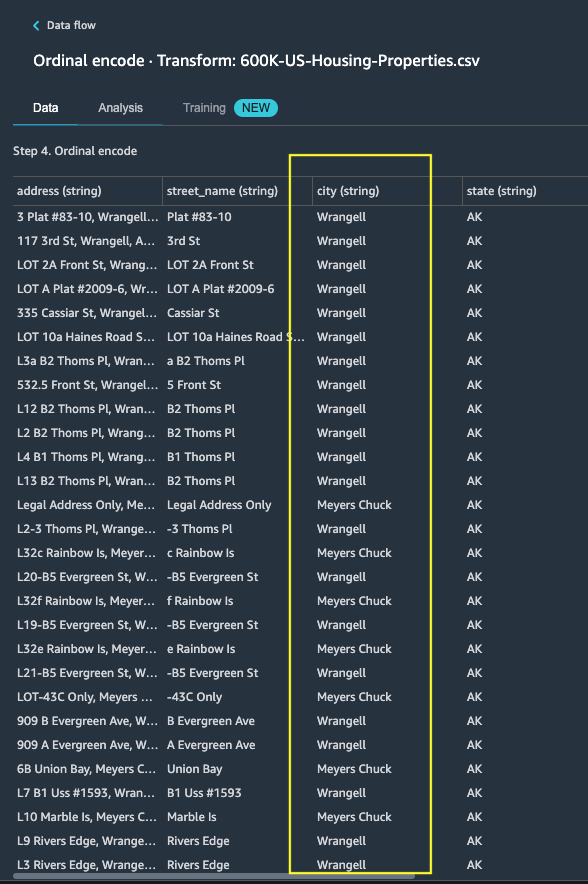

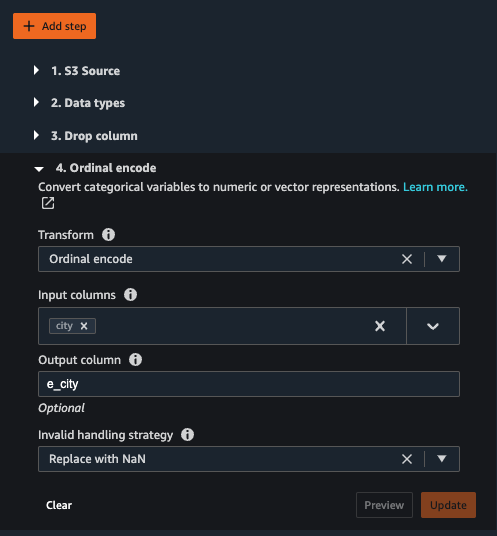

- Lägg till en ny transformation och välj Koda kategoriskt för att tillämpa en transformation på funktionen

city, som har ett större antal unika kategoriska textvärden. - För att koda denna funktion till en numerisk representation, välj Ordinär kodning för Förvandla.

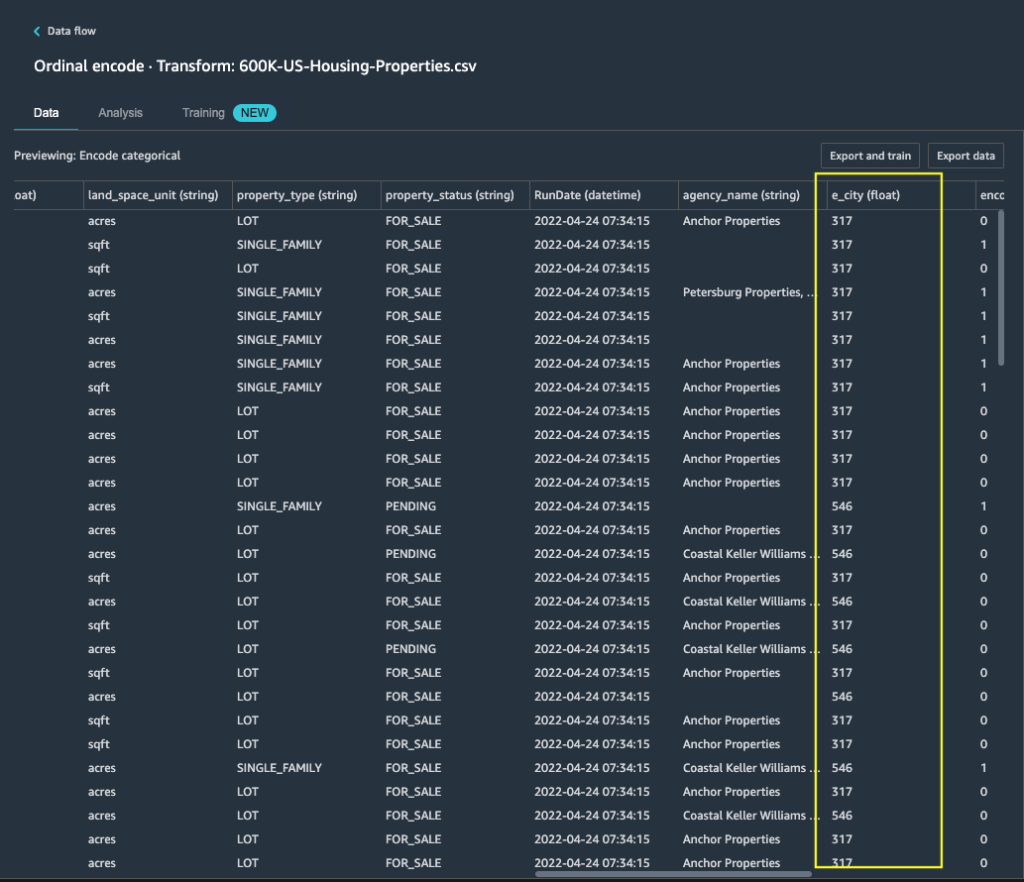

- Välj Förhandsgranska på denna transformation.

Du kan se att den kategoriska funktionen city mappas till ordningsvärden i utdatakolumnen e_city.

- Lägg till detta steg genom att välja Uppdatering.

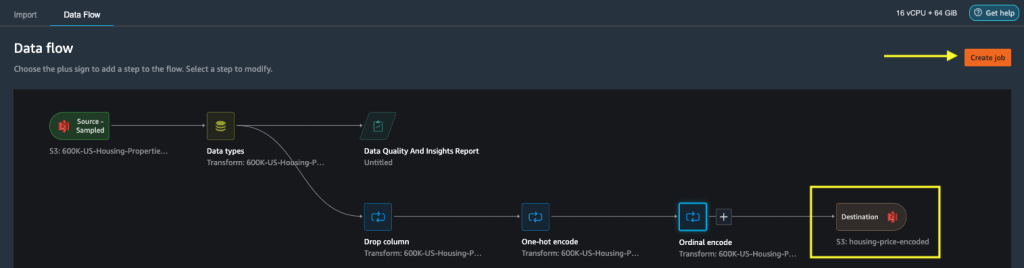

- Du kan ställa in destinationen till Amazon S3 för att lagra de tillämpade transformationerna på datasetet för att generera utdata som CSV-fil.

Data Wrangler lagrar arbetsflödet du definierade i användargränssnittet som en flödesfil och laddar upp till det konfigurerade databearbetningsjobbets Amazon S3-plats. Den här flödesfilen används när du skapar Data Wrangler-bearbetningsjobb för att tillämpa transformationerna på större datauppsättningar, eller för att transformera nya förstärkningsdata för att träna om modellen.

Starta ett Data Wrangler-databearbetningsjobb utan återanpassning aktiverat

Nu kan du se hur refit-alternativet använder tränade parametrar på nya datamängder. För denna demonstration definierar vi två Data Wrangler-bearbetningsjobb som arbetar på samma data. Det första bearbetningsjobbet kommer inte att möjliggöra återanpassning; för det andra bearbetningsjobbet använder vi refit. Vi jämför effekterna på slutet.

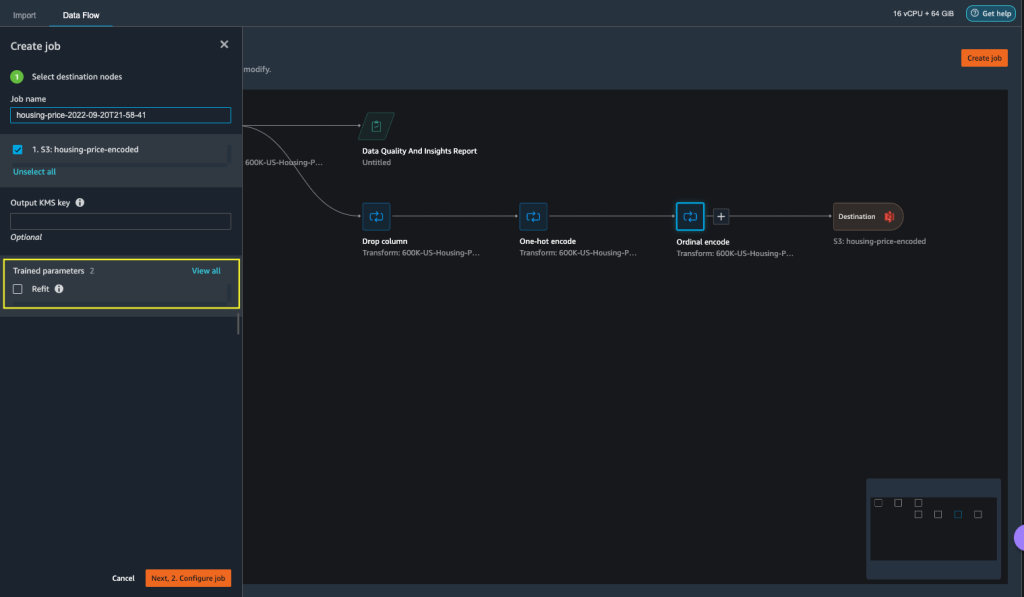

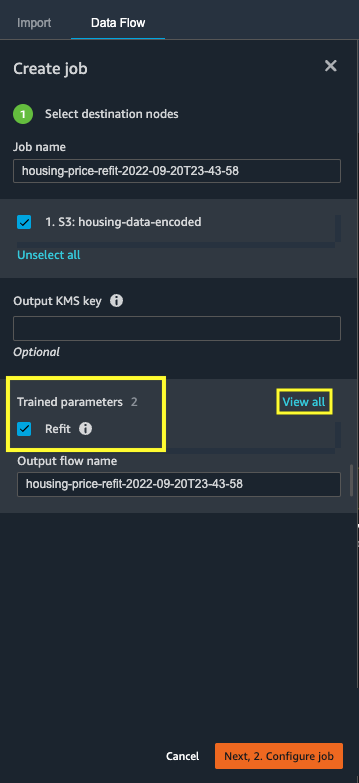

- Välja Skapa jobb för att initiera ett databearbetningsjobb med Data Wrangler.

- För Jobb namn, ange ett namn.

- Enligt Utbildade parametrar, välj inte Montera.

- Välja Konfigurera jobb.

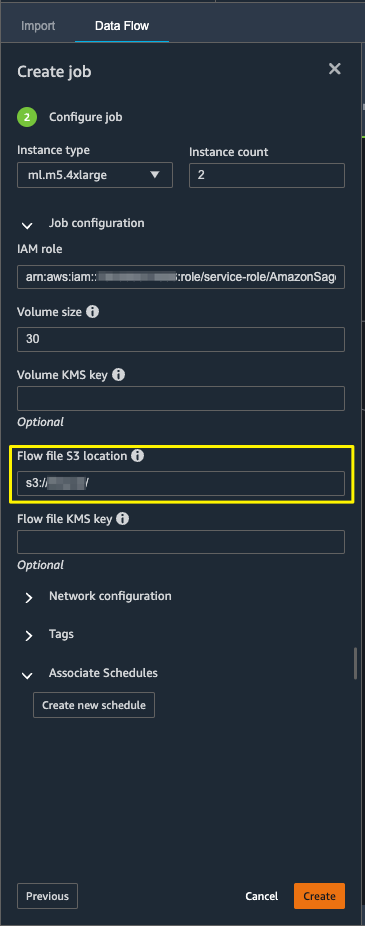

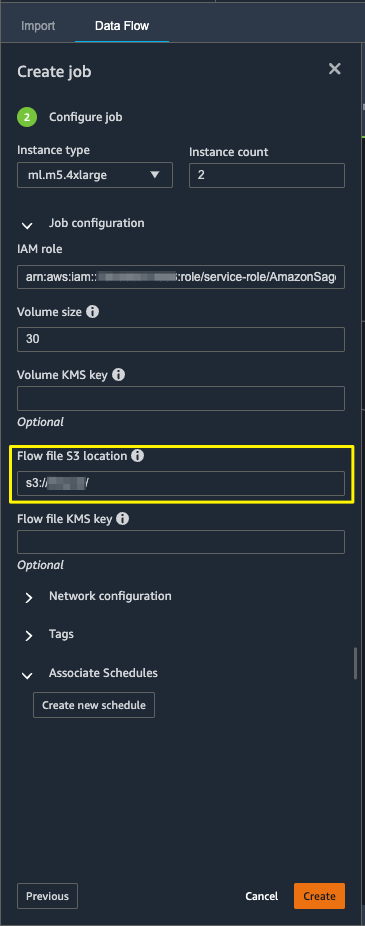

- Konfigurera jobbparametrarna som instanstyper, volymstorlek och Amazon S3-plats för att lagra utflödesfilen.

- Data Wrangler skapar en flödesfil i flödesfilens S3-plats. Flödet använder transformationer för att träna parametrar, och vi använder senare omanpassningsalternativet för att träna om dessa parametrar.

- Välja Skapa.

Vänta tills databearbetningsjobbet har slutförts för att se de transformerade data i S3-bucketen konfigurerade i destinationsnoden.

Starta ett Data Wrangler-databearbetningsjobb med återanpassning aktiverat

Låt oss skapa ett annat bearbetningsjobb aktiverat med funktionen för ombyggnad av tränade parameter aktiverad. Det här alternativet upprätthåller de tränade parametrarna som lärs om på hela datamängden. När detta databearbetningsjobb är klart skapas eller uppdateras en flödesfil till den konfigurerade Amazon S3-platsen.

- Välja Skapa jobb.

- För Jobb namn, ange ett namn.

- För Utbildade parametrar, Välj Montera.

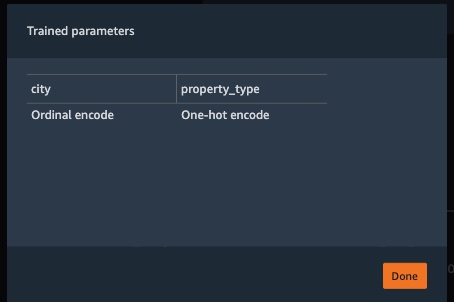

- Om du väljer Visa alla, kan du granska alla tränade parametrar.

- Välja Konfigurera jobb.

- Ange platsen för Amazon S3-flödesfilen.

- Välja Skapa.

Vänta tills databearbetningsjobbet är klart.

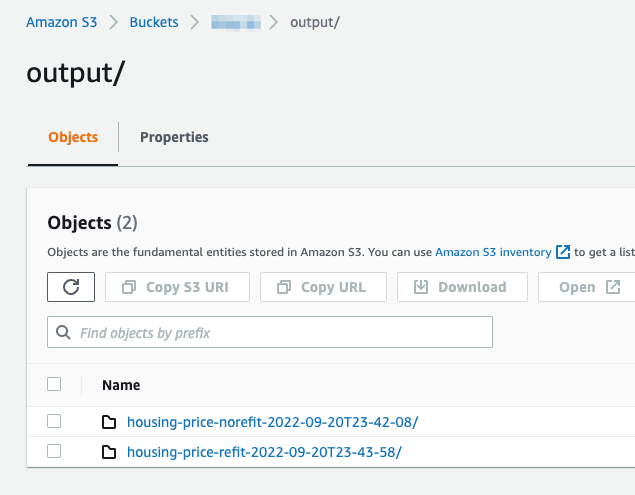

Se den konfigurerade S3-bucket i destinationsnoden för att se data som genereras av databearbetningsjobbet som kör de definierade transformationerna.

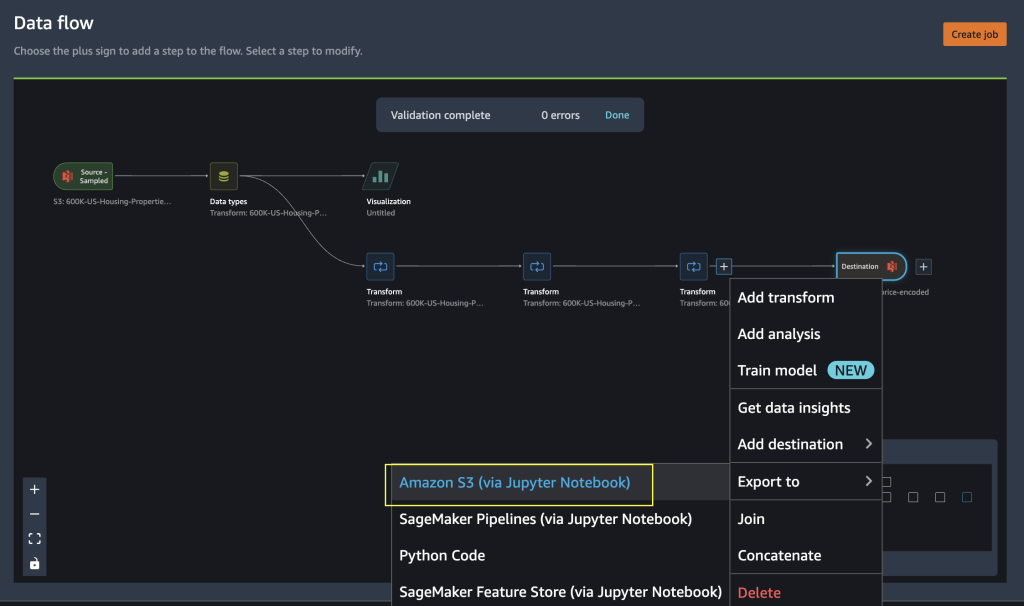

Exportera till Python-kod för att köra Data Wrangler-bearbetningsjobb

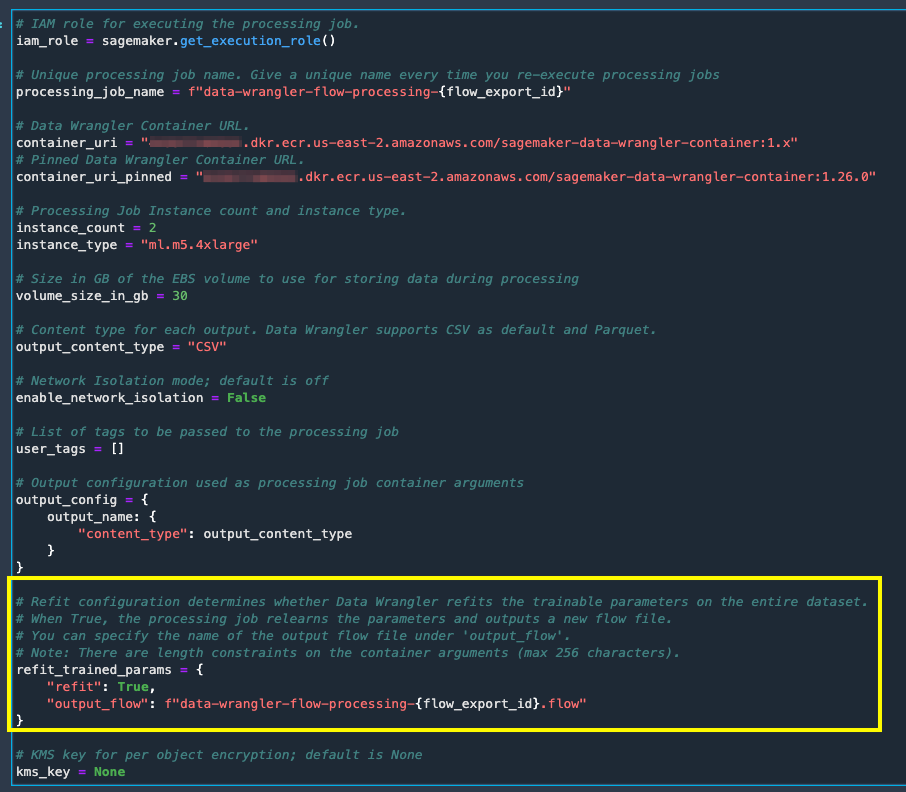

Som ett alternativ till att starta bearbetningsjobben med alternativet Skapa jobb i Data Wrangler, kan du utlösa databearbetningsjobben genom att exportera Data Wrangler-flödet till en Jupyter-anteckningsbok. Data Wrangler genererar en Jupyter-anteckningsbok med ingångar, utgångar, bearbetningsjobbkonfigurationer och kod för jobbstatuskontroller. Du kan ändra eller uppdatera parametrarna enligt dina datatransformationskrav.

- Välj plustecknet bredvid finalen Förvandla nod.

- Välja Exportera till och Amazon S3 (via Jupyter Notebook).

Du kan se en Jupyter-anteckningsbok öppnad med ingångar, utgångar, bearbetningsjobbkonfigurationer och kod för jobbstatuskontroller.

- För att genomdriva alternativet för återmontering av tränade parametrar via kod, ställ in

refitparametern tillTrue.

Jämför databearbetningsjobbresultat

Jämför databearbetningsjobbresultat

När Data Wrangler-bearbetningsjobben är klara måste du skapa två nya Data Wrangler-flöden med utdata som genereras av databearbetningsjobben lagrade i den konfigurerade Amazon S3-destinationen.

Du kan referera till den konfigurerade platsen i Amazon S3-målmappen för att granska databearbetningsjobbens utdata.

För att inspektera bearbetningsjobbresultaten skapar du två nya Data Wrangler-flöden med hjälp av rapporten Datakvalitet och insikter för att jämföra transformationsresultaten.

- Skapa ett nytt flöde i Amazon SageMaker Data Wrangler.

- Importera databearbetningsjobbet utan återanpassningsaktiverad utdatafil från Amazon S3.

- Lägg till en ny analys.

- För Analystypväljer Rapport för datakvalitet och insikter.

- Välja Skapa.

Upprepa stegen ovan och skapa ett nytt datawrangler-flöde för att analysera databearbetningsjobbets utdata med återanpassning aktiverad.

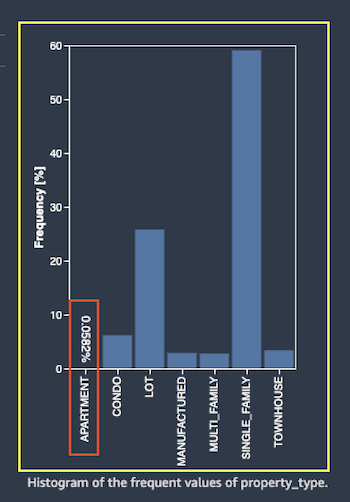

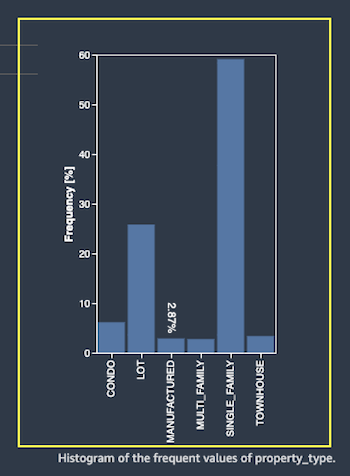

Låt oss nu titta på utdata från bearbetningsjobb för funktionen property_type med hjälp av datakvalitets- och insiktsrapporterna. Bläddra till funktionsinformationen i listan Data and Insights Reports feature_type.

Jobbet för bearbetning av utbildade parametrar har återställt de tränade parametrarna på hela datamängden och kodat det nya värdet APARTMENT med sju distinkta värden i hela datasetet.

Det normala bearbetningsjobbet tillämpade provdatauppsättningens utbildade parametrar, som bara har sex distinkta värden för property_type funktion. För data med feature_type APARTMENT, den ogiltig hanteringsstrategi Skip tillämpas och databearbetningsjobbet lär sig inte denna nya kategori. One-hot-kodningen har hoppat över den här nya kategorin som finns på den nya datan, och kodningen hoppar över kategorin APARTMENT.

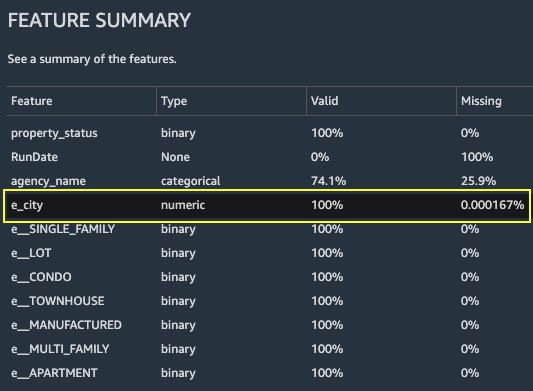

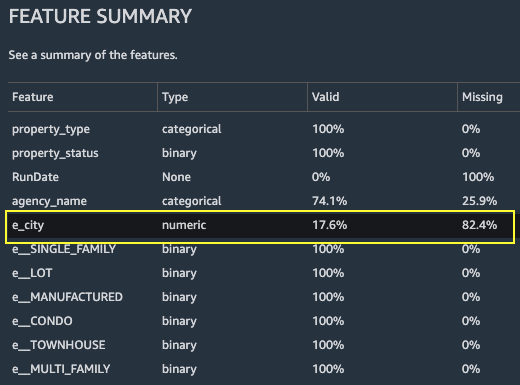

Låt oss nu fokusera på en annan funktion, city. Det återmonterade parameterbearbetningsjobbet har lärt sig om alla tillgängliga värden för city med tanke på de nya uppgifterna.

Som visas i Funktionsöversikt avsnittet i rapporten, kolumnen för nya kodade funktioner e_city har 100 % giltiga parametrar genom att använda funktionen för återmontering av utbildade parameter.

Däremot har det normala bearbetningsjobbet 82.4 % av saknade värden i kolumnen för nya kodade funktioner e_city. Detta fenomen beror på att endast provuppsättningen av inlärda inlärda parametrar tillämpas på den fullständiga datamängden och ingen omanpassning tillämpas av databearbetningsjobbet.

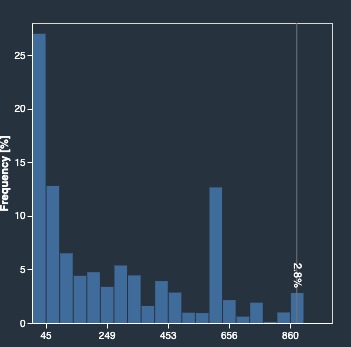

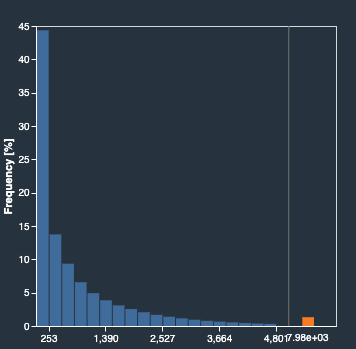

Följande histogram visar den ordinalkodade funktionen e_city. Det första histogrammet är av funktionen som transformerats med återanpassningsalternativet.

Nästa histogram är av funktionen som transformerats utan återanpassningsalternativ. Den orange kolumnen visar saknade värden (NaN) i rapporten Datakvalitet och insikter. De nya värdena som inte lärs från exempeldatauppsättningen ersätts som Not a Number (NaN) som konfigurerats i Data Wrangler UI:s ogiltig hanteringsstrategi.

Databearbetningsjobbet med den refittränade parametern lärde om property_type och city funktioner med tanke på de nya värdena från hela datamängden. Utan den inlärda ombyggnadsparametern använder databearbetningsjobbet endast den samplade datauppsättningens förinlärda tränade parametrar. Den tillämpar dem sedan på den nya datan, men de nya värdena beaktas inte för kodning. Detta kommer att få konsekvenser för modellens noggrannhet.

Städa upp

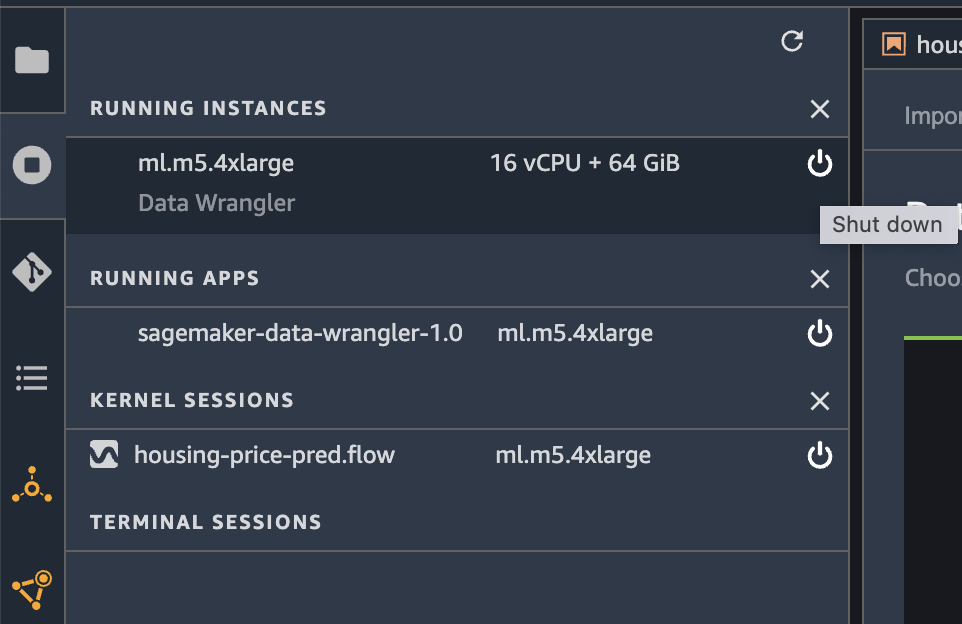

När du inte använder Data Wrangler är det viktigt att stänga av instansen som den körs på för att undvika extra avgifter.

För att undvika att förlora arbete, spara ditt dataflöde innan du stänger av Data Wrangler.

- För att spara ditt dataflöde in Amazon SageMaker Studioväljer FilOch välj sedan Spara data Wrangler Flow. Data Wrangler sparar automatiskt ditt dataflöde var 60:e sekund.

- För att stänga av Data Wrangler-instansen, i Studio, välj Löpande instanser och kärnor.

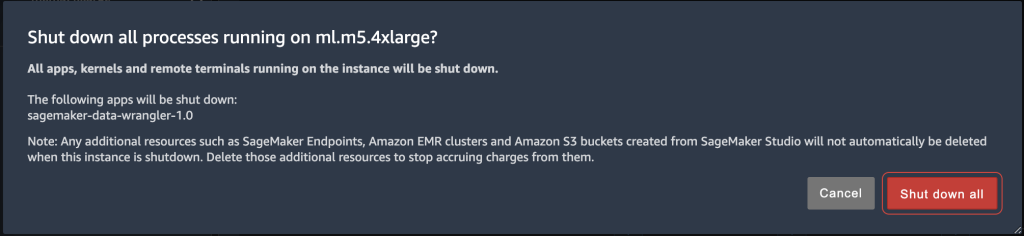

- Enligt KÖR APPAR, välj avstängningsikonen bredvid sagemaker-data-wrangler-1.0-appen.

- Välja Stäng av allt att bekräfta.

Data Wrangler körs på en ml.m5.4xlarge instans. Denna instans försvinner från KÖRINSTANSER när du stänger av Data Wrangler-appen.

När du har stängt av Data Wrangler-appen måste den startas om nästa gång du öppnar en Data Wrangler-flödesfil. Detta kan ta några minuter.

Slutsats

I det här inlägget gav vi en översikt över den ombyggda parameterfunktionen i Data Wrangler. Med den här nya funktionen kan du lagra de tränade parametrarna i Data Wrangler-flödet, och databearbetningsjobben använder de tränade parametrarna för att tillämpa de inlärda transformationerna på stora datamängder eller förstärkningsdatauppsättningar. Du kan använda det här alternativet för att vektorisera textfunktioner, numeriska data och hantering av extremvärden.

Att bevara tränade parametrar under hela databearbetningen av ML-livscykeln förenklar och minskar databearbetningsstegen, stöder robust funktionsteknik och stöder modellträning och förstärkningsträning på ny data.

Vi uppmuntrar dig att prova den här nya funktionen för dina databehandlingskrav.

Om författarna

Hariharan Suresh är Senior Solutions Architect på AWS. Han brinner för databaser, maskininlärning och att designa innovativa lösningar. Innan han började på AWS var Hariharan produktarkitekt, specialist på implementering av kärnbanker och utvecklare och arbetade med BFSI-organisationer i över 11 år. Utanför tekniken tycker han om att skärmflyga och cykla.

Hariharan Suresh är Senior Solutions Architect på AWS. Han brinner för databaser, maskininlärning och att designa innovativa lösningar. Innan han började på AWS var Hariharan produktarkitekt, specialist på implementering av kärnbanker och utvecklare och arbetade med BFSI-organisationer i över 11 år. Utanför tekniken tycker han om att skärmflyga och cykla.

Santosh Kulkarni är en Enterprise Solutions Architect på Amazon Web Services som arbetar med sportkunder i Australien. Han brinner för att bygga storskaliga distribuerade applikationer för att lösa affärsproblem med sin kunskap inom AI/ML, big data och mjukvaruutveckling.

Santosh Kulkarni är en Enterprise Solutions Architect på Amazon Web Services som arbetar med sportkunder i Australien. Han brinner för att bygga storskaliga distribuerade applikationer för att lösa affärsproblem med sin kunskap inom AI/ML, big data och mjukvaruutveckling.

Vishaal Kapoor är senior tillämpad forskare med AWS AI. Han brinner för att hjälpa kunder att förstå deras data i Data Wrangler. På fritiden cyklar han mountainbike, åker snowboard och umgås med sin familj.

Vishaal Kapoor är senior tillämpad forskare med AWS AI. Han brinner för att hjälpa kunder att förstå deras data i Data Wrangler. På fritiden cyklar han mountainbike, åker snowboard och umgås med sin familj.

Aniketh Manjunath är en mjukvaruutvecklingsingenjör på Amazon SageMaker. Han hjälper till att stödja Amazon SageMaker Data Wrangler och brinner för distribuerade maskininlärningssystem. Utanför jobbet tycker han om att vandra, titta på film och spela cricket.

Aniketh Manjunath är en mjukvaruutvecklingsingenjör på Amazon SageMaker. Han hjälper till att stödja Amazon SageMaker Data Wrangler och brinner för distribuerade maskininlärningssystem. Utanför jobbet tycker han om att vandra, titta på film och spela cricket.

- AI

- ai konst

- ai art generator

- har robot

- Amazon SageMaker

- Amazon SageMaker Data Wrangler

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- AWS maskininlärning

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- Mellan (200)

- maskininlärning

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- skala ai

- syntax

- zephyrnet