I januari 2024, Amazon SageMaker lanserade en ny version (0.26.0) av Large Model Inference (LMI) Deep Learning Containers (DLC). Den här versionen erbjuder stöd för nya modeller (inklusive Mixture of Experts), prestanda- och användbarhetsförbättringar över slutledningsbackends, såväl som nya generationsdetaljer för ökad kontroll och förutsägbarhet (såsom orsaken till att generationen slutförts och sannolikheter för logg på tokennivå).

LMI DLCs erbjuder ett gränssnitt med låg kod som förenklar användning av toppmoderna inferensoptimeringstekniker och hårdvara. LMI låter dig tillämpa tensorparallellism; de senaste effektiva teknikerna för uppmärksamhet, batchning, kvantisering och minneshantering; token streaming; och mycket mer, genom att bara kräva modell-ID och valfria modellparametrar. Med LMI DLC:er på SageMaker kan du accelerera tid till värde för din generativ artificiell intelligens (AI) applikationer, avlastning av infrastrukturrelaterade tunga lyft och optimera stora språkmodeller (LLM) för den hårdvara du väljer för att uppnå bästa pris-prestanda i klassen.

I det här inlägget utforskar vi de senaste funktionerna som introduceras i den här utgåvan, undersöker prestandabenchmarks och ger en detaljerad guide om hur du distribuerar nya LLM:er med LMI DLC:er med hög prestanda.

Nya funktioner med LMI DLC:er

I det här avsnittet diskuterar vi nya funktioner över LMI-backends och går igenom några andra som är backend-specifika. LMI stöder för närvarande följande backends:

- LMI-Distribuerat bibliotek – Detta är AWS-ramverket för att köra slutledning med LLM, inspirerat av OSS, för att uppnå bästa möjliga latens och noggrannhet på resultatet

- LMI vLLM – Det här är AWS-backend-implementeringen av den minneseffektiva vLLM slutledningsbibliotek

- LMI TensorRT-LLM verktygslåda – Det här är AWS-backend-implementeringen av NVIDIA TensorRT-LLM, som skapar GPU-specifika motorer för att optimera prestanda på olika GPU:er

- LMI DeepSpeed – Det här är AWS-anpassningen av DeepSpeed, som lägger till sann kontinuerlig batchning, SmoothQuant-kvantisering och möjligheten att dynamiskt justera minnet under slutledning

- LMI NeuronX – Du kan använda detta för distribution på AWS Inferentia2 och AWS Trainium-baserade instanser, med äkta kontinuerlig batchning och speedups, baserat på AWS Neuron SDK

Följande tabell sammanfattar de nyligen tillagda funktionerna, både vanliga och backend-specifika.

|

Vanligt för backends |

|||

|

|||

|

Backend-specifik |

|||

|

LMI-Distribuerat |

vLLM | TensorRT-LLM |

NeuronX |

|

|

|

|

Nya modeller stöds

Nya populära modeller stöds över backends, som Mistral-7B (alla backends), MoE-baserade Mixtral (alla backends utom Transformers-NeuronX) och Llama2-70B (Transformers-NeuronX).

Tekniker för kontextfönsterförlängning

Rotary Positional Embedding (RoPE)-baserad kontextskalning är nu tillgänglig på LMI-Dist, vLLM och TensorRT-LLM backends. RoPE-skalning möjliggör förlängning av en modells sekvenslängd under inferens till praktiskt taget vilken storlek som helst, utan behov av finjustering.

Följande är två viktiga överväganden när du använder RoPE:

- Modellförvirring – När sekvenslängden ökar, så kan modellens bryderi. Denna effekt kan delvis kompenseras genom att utföra minimal finjustering av ingångssekvenser större än de som användes i den ursprungliga träningen. För en fördjupad förståelse av hur RoPE påverkar modellkvalitet, se Förlängning av linan.

- Slutledningsprestanda – Längre sekvenslängder kommer att förbruka högre acceleratorns höga bandbreddsminne (HBM). Denna ökade minnesanvändning kan negativt påverka antalet samtidiga förfrågningar som din accelerator kan hantera.

Lade till generationsdetaljer

Du kan nu få två finkorniga detaljer om genereringsresultat:

- finish_reason – Detta ger anledningen till att generationen har slutförts, vilket kan vara att nå den maximala generationslängden, generera en end-of-sentence (EOS)-token eller generera en användardefinierad stopptoken. Den returneras med den senast streamade sekvensbiten.

- log_probs – Detta returnerar loggsannolikheten som tilldelas av modellen för varje token i den strömmade sekvensbiten. Du kan använda dessa som en grov uppskattning av modellens konfidens genom att beräkna den gemensamma sannolikheten för en sekvens som summan av

log_probsav de individuella tokens, vilket kan vara användbart för att poängsätta och rangordna modellutdata. Tänk på att sannolikheter för LLM-token i allmänhet är översäkra utan kalibrering.

Du kan aktivera genereringsresultatutmatningen genom att lägga till details=True i din indatanyttolast till LMI, och lämna alla andra parametrar oförändrade:

payload = {“inputs”:“your prompt”,

“parameters”:{max_new_tokens”:256,...,“details”:True}

}Konsoliderade konfigurationsparametrar

Slutligen har LMI-konfigurationsparametrar också konsoliderats. För mer information om alla vanliga och backend-specifika installationskonfigurationsparametrar, se Stora modellinferenskonfigurationer.

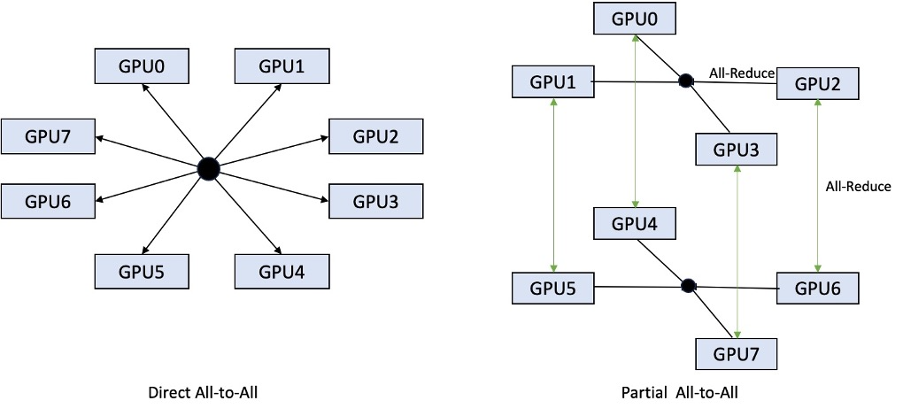

LMI-Distribuerad backend

På AWS re:Invent 2023 lade LMI-Dist till nya, optimerade kollektiva operationer för att påskynda kommunikationen mellan GPU: er, vilket resulterar i lägre latens och högre genomströmning för modeller som är för stora för en enda GPU. Dessa kollektiv är tillgängliga exklusivt för SageMaker, för p4d-instanser.

Medan den tidigare iterationen endast stödde sharding över alla 8 GPU:er, introducerar LMI 0.26.0 stöd för en tensorparallellgrad på 4, i ett partiellt allt-till-alla-mönster. Detta kan kombineras med SageMaker slutledningskomponenter, med vilken du granulärt kan konfigurera hur många acceleratorer som ska allokeras till varje modell som används bakom en slutpunkt. Tillsammans ger dessa funktioner bättre kontroll över resursutnyttjandet av den underliggande instansen, vilket gör att du kan öka modellens multi-tenancy genom att vara värd för olika modeller bakom en slutpunkt, eller finjustera den sammanlagda genomströmningen av din distribution för att matcha din modell och trafikegenskaper.

Följande figur jämför direkt allt-till-alla med partiellt allt-till-alla.

TensorRT-LLM backend

NVIDIAs TensorRT-LLM introducerades som en del av den tidigare LMI DLC-utgåvan (0.25.0), vilket möjliggör toppmodern GPU-prestanda och optimeringar som SmoothQuant, FP8 och kontinuerlig batchning för LLM:er när du använder NVIDIA GPU:er.

TensorRT-LLM kräver att modeller kompileras till effektiva motorer innan de distribueras. LMI TensorRT-LLM DLC kan automatiskt hantera att kompilera en lista över modeller som stöds just-in-time (JIT), innan servern startas och modellen laddas för realtidsslutning. Version 0.26.0 av DLC utökar listan över modeller som stöds för JIT-kompilering, och introducerar modellerna Baichuan, ChatGLM, GPT2, GPT-J, InternLM, Mistral, Mixtral, Qwen, SantaCoder och StarCoder.

JIT-kompilering lägger till flera minuters overhead till slutpunktsprovisionering och skalningstid, så det rekommenderas alltid att kompilera din modell i förväg. För en guide om hur du gör detta och en lista över modeller som stöds, se TensorRT-LLM i förväg sammanställning av modeller handledning. Om din valda modell inte stöds ännu, se TensorRT-LLM manuell sammanställning av modeller handledning för att kompilera någon annan modell som stöds av TensorRT-LLM.

Dessutom exponerar LMI nu inbyggd TensorRT-LLM SmootQuant-kvantisering, med parametrar för att styra alfa- och skalningsfaktor efter token eller kanal. För mer information om relaterade konfigurationer, se TensorRT-LLM.

vLLM-backend

Den uppdaterade versionen av vLLM som ingår i LMI DLC har prestandaförbättringar på upp till 50 % som drivs av CUDA-grafläge istället för ivrigt läge. CUDA-grafer accelererar GPU-arbetsbelastningen genom att starta flera GPU-operationer på en gång istället för att starta dem individuellt, vilket minskar omkostnader. Detta är särskilt effektivt för små modeller när man använder tensorparallellism.

Den extra prestandan kommer vid en kompromiss med ökad GPU-minnesförbrukning. CUDA-grafläget är nu standard för vLLM-backend, så om du är begränsad till mängden tillgängligt GPU-minne kan du ställa in option.enforce_eager=True för att tvinga PyTorch ivrigt läge.

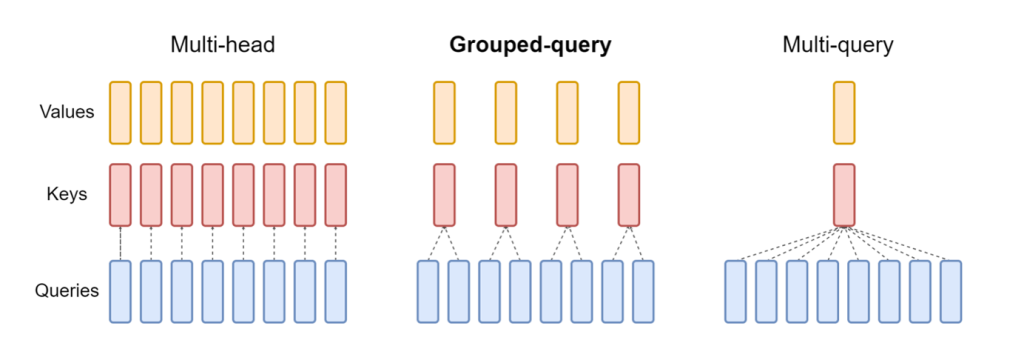

Transformers-NeuronX backend

Den uppdaterade utgåvan av NeuronX som ingår i LMI NeuronX DLC stöder nu modeller som har mekanismen för grupperad sökning, som Mistral-7B och LLama2-70B. Grupperad frågeuppmärksamhet är en viktig optimering av standardtransformatorns uppmärksamhetsmekanism, där modellen tränas med färre nyckel- och värdehuvuden än frågehuvuden. Detta minskar storleken på KV-cachen på GPU-minnet, vilket möjliggör större samtidighet och förbättrar pris-prestanda.

Följande figur illustrerar uppmärksamhetsmetoder för flera huvuden, grupperade frågor och flera frågor (källa).

Olika KV-cache-sharingstrategier är tillgängliga för att passa olika typer av arbetsbelastningar. För mer information om skärningsstrategier, se Stöd för Grouped-Query Attention (GQA).. Du kan aktivera din önskade strategi (shard-over-heads, till exempel) med följande kod:

Dessutom introducerar den nya implementeringen av NeuronX DLC ett cache-API för TransformerNeuronX som möjliggör åtkomst till KV-cachen. Det låter dig infoga och ta bort KV-cache-rader från nya förfrågningar medan du lämnar batchade slutsatser. Innan detta API introducerades, beräknades KV-cachen om för alla nyligen tillagda förfrågningar. Jämfört med LMI V7 (0.25.0) har vi förbättrat latensen med mer än 33 % med samtidiga förfrågningar och stöder mycket högre genomströmning.

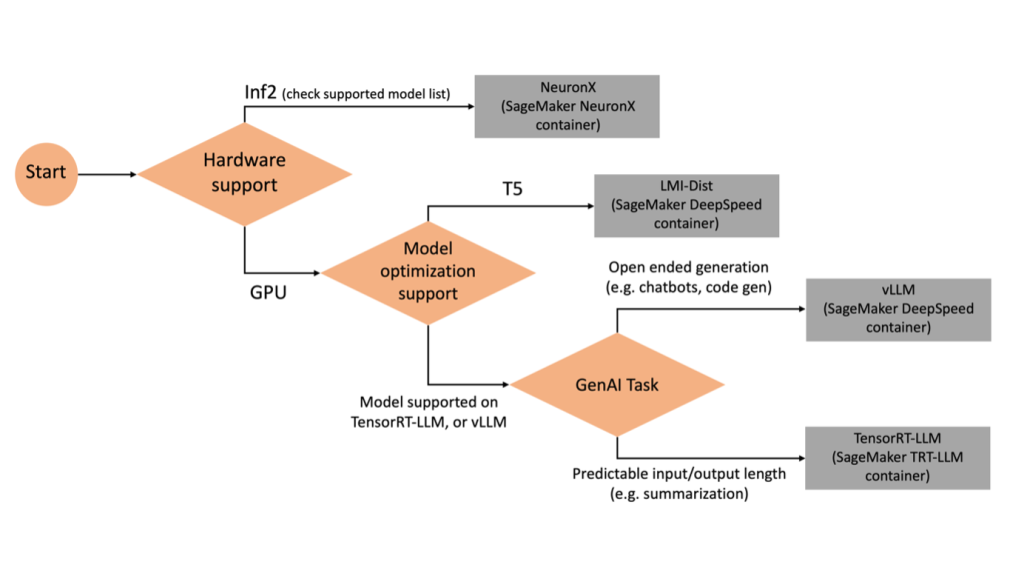

Att välja rätt backend

För att bestämma vilken backend som ska användas baserat på den valda modellen och uppgiften, använd följande flödesschema. För individuella användarhandböcker för backend tillsammans med modeller som stöds, se LMI Backend Användarguider.

Distribuera Mixtral med LMI DLC med ytterligare attribut

Låt oss gå igenom hur du kan distribuera Mixtral-8x7B-modellen med LMI 0.26.0-behållare och generera ytterligare detaljer som log_prob och finish_reason som en del av produktionen. Vi diskuterar också hur du kan dra nytta av dessa ytterligare attribut genom ett användningsfall för innehållsgenerering.

Den kompletta anteckningsboken med detaljerade instruktioner finns i GitHub repo.

Vi börjar med att importera biblioteken och konfigurera sessionsmiljön:

Du kan använda SageMaker LMI-behållare för att vara värd för modeller utan någon ytterligare slutledningskod. Du kan konfigurera modellservern antingen genom miljövariablerna eller en serving.properties fil. Alternativt kan du ha en model.py fil för eventuell för- eller efterbearbetning och en requirements.txt fil för eventuella ytterligare paket som måste installeras.

I det här fallet använder vi serving.properties fil för att konfigurera parametrarna och anpassa LMI-behållarens beteende. För mer information, se GitHub repo. Repoet förklarar detaljer om de olika konfigurationsparametrarna som du kan ställa in. Vi behöver följande nyckelparametrar:

- motor – Anger körtidsmotorn som DJL ska använda. Detta driver sönderdelningen och modellladdningsstrategin i acceleratorerna för modellen.

- option.model_id – Specificerar Amazon enkel lagringstjänst (Amazon S3) URI för den förtränade modellen eller modell-ID för en förtränad modell som finns i ett modellförråd på Kramande ansikte. I det här fallet tillhandahåller vi modell-ID för Mixtral-8x7B-modellen.

- option.tensor_parallel_degree – Ställer in antalet GPU-enheter som Accelerate behöver för att partitionera modellen. Den här parametern styr också antalet arbetare per modell som kommer att startas när DJL-serveringen körs. Vi sätter detta värde till

max(max GPU på den aktuella maskinen). - option.rolling_batch – Möjliggör kontinuerlig batchning för att optimera acceleratorutnyttjandet och den totala genomströmningen. För TensorRT-LLM-behållaren använder vi

auto. - option.model_loading_timeout – Ställer in timeoutvärdet för nedladdning och laddning av modellen för att tjäna slutledning.

- option.max_rolling_batch – Ställer in den maximala storleken på den kontinuerliga batchen, och definierar hur många sekvenser som kan bearbetas parallellt vid varje given tidpunkt.

Vi paketerar serving.properties konfigurationsfilen i tar.gz-formatet, så att den uppfyller SageMakers värdkrav. Vi konfigurerar DJL LMI-behållaren med tensorrtllm som backend-motor. Dessutom anger vi den senaste versionen av behållaren (0.26.0).

Därefter laddar vi upp den lokala tarballen (som innehåller serving.properties konfigurationsfil) till ett S3-prefix. Vi använder bild-URI för DJL-behållaren och Amazon S3-platsen till vilken modellen som serverar artefakter tarball laddades upp, för att skapa SageMaker-modellobjektet.

Som en del av LMI 0.26.0 kan du nu använda ytterligare två finkorniga detaljer om den genererade utdata:

- log_probs – Detta är loggsannolikheten som tilldelas av modellen för varje token i den streamade sekvensbiten. Du kan använda dessa som en grov uppskattning av modellens konfidens genom att beräkna den gemensamma sannolikheten för en sekvens som summan av loggsannolikheterna för de individuella tokens, vilket kan vara användbart för att poängsätta och rangordna modellutdata. Tänk på att sannolikheter för LLM-token i allmänhet är översäkra utan kalibrering.

- finish_reason – Detta är anledningen till att generationen är klar, vilket kan vara att nå den maximala generationslängden, generera en EOS-token eller generera en användardefinierad stopptoken. Detta returneras med den senast streamade sekvensen.

Du kan aktivera dessa genom att passera "details"=True som en del av din input till modellen.

Låt oss se hur du kan generera dessa detaljer. Vi använder ett exempel på innehållsgenerering för att förstå deras tillämpning.

Vi definierar en LineIterator helper class, som har funktioner för att lätt hämta bytes från en svarsström, buffra dem och bryta ner bufferten i rader. Tanken är att servera bytes från bufferten samtidigt som man hämtar fler bytes från strömmen asynkront.

Generera och använd token-sannolikhet som en ytterligare detalj

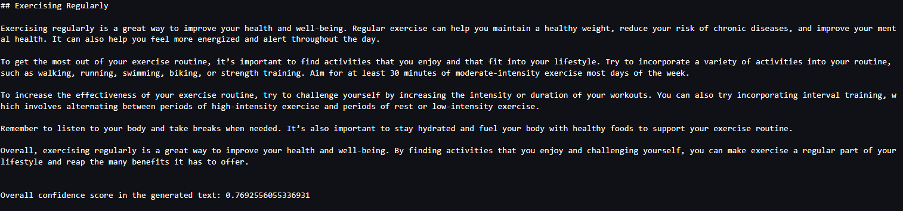

Överväg ett användningsfall där vi genererar innehåll. Specifikt har vi i uppdrag att skriva ett kort stycke om fördelarna med att träna regelbundet för en livsstilsfokuserad webbplats. Vi vill generera innehåll och producera en indikativ poäng för det förtroende som modellen har för det genererade innehållet.

Vi anropar modellens slutpunkt med vår prompt och fångar det genererade svaret. Vi sätter "details": True som en körtidsparameter i ingången till modellen. Eftersom loggsannolikheten genereras för varje utdatatoken, lägger vi till de individuella loggsannolikheterna till en lista. Vi fångar också den fullständiga genererade texten från svaret.

För att beräkna den övergripande konfidenspoängen, beräknar vi medelvärdet av alla individuella tokensannolikheter och får sedan exponentialvärdet mellan 0 och 1. Detta är vårt antagna totala konfidenspoäng för den genererade texten, vilket i det här fallet är ett stycke om fördelarna regelbunden träning.

Detta var ett exempel på hur du kan skapa och använda log_prob, i samband med ett användningsfall för innehållsgenerering. På samma sätt kan du använda log_prob som mått på konfidenspoäng för klassificeringsanvändningsfall.

Alternativt kan du använda den för den övergripande utgångssekvensen eller poängsättning på meningsnivå för att utvärdera påverkan av parametrar som temperatur på den genererade utgången.

Generera och använd slutförklaring som en ytterligare detalj

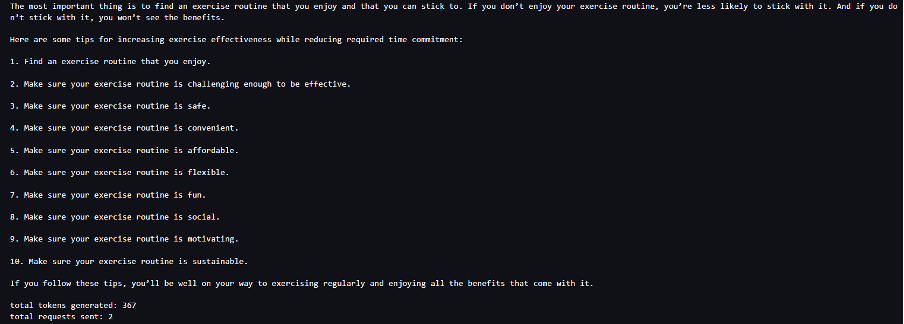

Låt oss bygga på samma användningsfall, men den här gången får vi i uppdrag att skriva en längre artikel. Dessutom vill vi se till att utdata inte trunkeras på grund av problem med generationslängden (max tokenlängd) eller på grund av att stopptokens påträffas.

För att åstadkomma detta använder vi finish_reason attribut som genereras i utgången, övervaka dess värde och fortsätt generera tills hela utgången genereras.

Vi definierar en slutledningsfunktion som tar en nyttolast-ingång och anropar SageMaker-slutpunkten, strömmar tillbaka ett svar och bearbetar svaret för att extrahera genererad text. Nyttolasten innehåller prompttexten som indata och parametrar som max tokens och detaljer. Svaret läses i en ström och bearbetas rad för rad för att extrahera de genererade textsymbolerna till en lista. Vi extraherar detaljer som finish_reason. Vi anropar inferensfunktionen i en loop (kedjade förfrågningar) samtidigt som vi lägger till mer sammanhang varje gång, och spårar antalet genererade tokens och antalet förfrågningar som skickas tills modellen är klar.

Som vi kan se, även om max_new_token parametern är inställd på 256, använder vi attributet finish_reason detail som en del av utdata för att koppla flera förfrågningar till slutpunkten, tills hela utdata genereras.

På samma sätt, baserat på ditt användningsfall, kan du använda stop_reason att upptäcka otillräcklig utdatasekvenslängd specificerad för en given uppgift eller oavsiktligt slutförande på grund av en mänsklig stoppsekvens.

Slutsats

I det här inlägget gick vi igenom version 0.26.0 av AWS LMI-behållaren. Vi lyfte fram viktiga prestandaförbättringar, stöd för nya modeller och nya användarvänlighetsfunktioner. Med dessa funktioner kan du bättre balansera kostnads- och prestandaegenskaper samtidigt som du ger dina slutanvändare en bättre upplevelse.

För att lära dig mer om LMI DLC-funktioner, se Modellparallellism och stor modellinferens. Vi är glada över att se hur du använder dessa nya funktioner från SageMaker.

Om författarna

João Moura är Senior AI/ML Specialist Solutions Architect på AWS. João hjälper AWS-kunder – från små startups till stora företag – att utbilda och distribuera stora modeller effektivt, och mer brett bygga ML-plattformar på AWS.

João Moura är Senior AI/ML Specialist Solutions Architect på AWS. João hjälper AWS-kunder – från små startups till stora företag – att utbilda och distribuera stora modeller effektivt, och mer brett bygga ML-plattformar på AWS.

Rahul Sharma är Senior Solutions Architect på AWS och hjälper AWS-kunder att designa och bygga AI/ML-lösningar. Innan han började på AWS har Rahul tillbringat flera år inom finans- och försäkringssektorn och hjälpt kunder att bygga data- och analytiska plattformar.

Rahul Sharma är Senior Solutions Architect på AWS och hjälper AWS-kunder att designa och bygga AI/ML-lösningar. Innan han började på AWS har Rahul tillbringat flera år inom finans- och försäkringssektorn och hjälpt kunder att bygga data- och analytiska plattformar.

Qing Lan är en mjukvaruutvecklingsingenjör i AWS. Han har arbetat med flera utmanande produkter i Amazon, inklusive högpresterande ML-slutledningslösningar och högpresterande loggsystem. Qings team lanserade framgångsrikt den första miljardparametermodellen i Amazon Advertising med mycket låg latens som krävs. Qing har djupgående kunskaper om infrastrukturoptimering och Deep Learning-acceleration.

Qing Lan är en mjukvaruutvecklingsingenjör i AWS. Han har arbetat med flera utmanande produkter i Amazon, inklusive högpresterande ML-slutledningslösningar och högpresterande loggsystem. Qings team lanserade framgångsrikt den första miljardparametermodellen i Amazon Advertising med mycket låg latens som krävs. Qing har djupgående kunskaper om infrastrukturoptimering och Deep Learning-acceleration.

Jian Sheng är en mjukvaruutvecklingsingenjör på Amazon Web Services som har arbetat med flera viktiga aspekter av maskininlärningssystem. Han har varit en viktig bidragsgivare till SageMaker Neo-tjänsten, med fokus på kompilering av djupinlärning och optimering av ramverkskörning. På senare tid har han riktat sina ansträngningar och bidragit till att optimera maskininlärningssystemet för slutledning av stora modeller.

Jian Sheng är en mjukvaruutvecklingsingenjör på Amazon Web Services som har arbetat med flera viktiga aspekter av maskininlärningssystem. Han har varit en viktig bidragsgivare till SageMaker Neo-tjänsten, med fokus på kompilering av djupinlärning och optimering av ramverkskörning. På senare tid har han riktat sina ansträngningar och bidragit till att optimera maskininlärningssystemet för slutledning av stora modeller.

Tyler Österberg är en mjukvaruutvecklingsingenjör på AWS. Han är specialiserad på att skapa högpresterande maskininlärningsupplevelser inom SageMaker. På senare tid har hans fokus varit på att optimera prestandan för Inferentia Deep Learning Containers på SageMaker-plattformen. Tyler utmärker sig i att implementera effektiva värdlösningar för stora språkmodeller och förbättra användarupplevelsen med hjälp av banbrytande teknologi.

Tyler Österberg är en mjukvaruutvecklingsingenjör på AWS. Han är specialiserad på att skapa högpresterande maskininlärningsupplevelser inom SageMaker. På senare tid har hans fokus varit på att optimera prestandan för Inferentia Deep Learning Containers på SageMaker-plattformen. Tyler utmärker sig i att implementera effektiva värdlösningar för stora språkmodeller och förbättra användarupplevelsen med hjälp av banbrytande teknologi.

Rupinder Grewal är Senior AI/ML Specialist Solutions Architect med AWS. Han fokuserar för närvarande på servering av modeller och MLOps på Amazon SageMaker. Innan denna roll arbetade han som maskininlärningsingenjör med att bygga och vara värdmodeller. Utanför jobbet tycker han om att spela tennis och cykla på bergsstigar.

Rupinder Grewal är Senior AI/ML Specialist Solutions Architect med AWS. Han fokuserar för närvarande på servering av modeller och MLOps på Amazon SageMaker. Innan denna roll arbetade han som maskininlärningsingenjör med att bygga och vara värdmodeller. Utanför jobbet tycker han om att spela tennis och cykla på bergsstigar.

Dhawal Patel är en huvudarkitekt för maskininlärning på AWS. Han har arbetat med organisationer som sträcker sig från stora företag till medelstora startups med problem relaterade till distribuerad datoranvändning och artificiell intelligens. Han fokuserar på djupinlärning inklusive NLP- och Computer Vision-domäner. Han hjälper kunder att uppnå högpresterande modellslutningar på SageMaker.

Dhawal Patel är en huvudarkitekt för maskininlärning på AWS. Han har arbetat med organisationer som sträcker sig från stora företag till medelstora startups med problem relaterade till distribuerad datoranvändning och artificiell intelligens. Han fokuserar på djupinlärning inklusive NLP- och Computer Vision-domäner. Han hjälper kunder att uppnå högpresterande modellslutningar på SageMaker.

Raghu Ramesha är senior ML Solutions Architect med Amazon SageMaker Service-teamet. Han fokuserar på att hjälpa kunder att bygga, distribuera och migrera ML-produktionsarbetsbelastningar till SageMaker i stor skala. Han är specialiserad på domäner för maskininlärning, AI och datorseende och har en magisterexamen i datavetenskap från UT Dallas. På fritiden tycker han om att resa och fotografera.

Raghu Ramesha är senior ML Solutions Architect med Amazon SageMaker Service-teamet. Han fokuserar på att hjälpa kunder att bygga, distribuera och migrera ML-produktionsarbetsbelastningar till SageMaker i stor skala. Han är specialiserad på domäner för maskininlärning, AI och datorseende och har en magisterexamen i datavetenskap från UT Dallas. På fritiden tycker han om att resa och fotografera.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/boost-inference-performance-for-mixtral-and-llama-2-models-with-new-amazon-sagemaker-containers/

- : har

- :är

- :inte

- :var

- $UPP

- 1

- 10

- 100

- 125

- 13

- 14

- 15%

- 2023

- 2024

- 212

- 25

- 26%

- 27

- 7

- 8

- 9

- 98

- a

- förmåga

- Om oss

- accelerera

- acceleration

- accelerator

- acceleratorer

- tillgång

- åstadkomma

- noggrannhet

- Uppnå

- tvärs

- anpassning

- lägga till

- lagt till

- Tillagda funktioner

- tillsats

- Annat

- Dessutom

- Lägger

- justera

- negativt

- reklam

- påverka

- aggregat

- AI

- AI / ML

- Alla

- allokeras

- tillåta

- tillåter

- längs

- alfa

- också

- alltid

- amason

- Amazon SageMaker

- Amazon Web Services

- mängd

- an

- Analytisk

- och

- vilken som helst

- api

- API: er

- Ansökan

- tillämpningar

- Ansök

- ÄR

- Artikeln

- konstgjord

- artificiell intelligens

- AS

- aspekter

- delad

- At

- uppmärksamhet

- attribut

- automatiskt

- tillgänglig

- AWS

- AWS re: Invent

- tillbaka

- backend

- backends

- Balansera

- Bandbredd

- baserat

- dosering

- BE

- därför att

- varit

- innan

- beteende

- bakom

- Där vi får lov att vara utan att konstant prestera,

- riktmärken

- fördel

- Fördelarna

- BÄST

- Bättre

- mellan

- Stor

- kropp

- lyft

- båda

- Ha sönder

- brett

- buffert

- SLUTRESULTAT

- Byggnad

- men

- by

- Cache

- beräkna

- Ring

- Samtal

- KAN

- kapacitet

- fånga

- Vid

- fall

- kedja

- kedjad

- utmanande

- Kanal

- egenskaper

- Diagram

- ta

- val

- klass

- klassificering

- koda

- Kollektiv

- kombinerad

- kommer

- Gemensam

- Kommunikation

- jämfört

- sammanställas

- fullborda

- fullbordan

- dator

- Datavetenskap

- Datorsyn

- databehandling

- konkurrent

- ledande

- förtroende

- konfiguration

- konfigurering

- överväganden

- konsumera

- konsumtion

- Behållare

- Behållare

- innehåller

- innehåll

- Innehållsgenerering

- sammanhang

- fortsätta

- kontinuerlig

- bidrog

- bidragsgivare

- kontroll

- kontroller

- Pris

- kunde

- bearbetning

- skapa

- skapar

- Aktuella

- För närvarande

- Kunder

- skräddarsy

- allra senaste

- spetsteknik

- Dallas

- datum

- beslutar

- Beslutet

- djup

- djupt lärande

- Standard

- definiera

- definierande

- Examen

- distribuera

- utplacerade

- utplacera

- utplacering

- Designa

- önskas

- detalj

- detaljerad

- detaljer

- upptäcka

- Utveckling

- enheter

- Diagrammet

- olika

- rikta

- riktad

- diskutera

- distribueras

- distribuerad databehandling

- do

- domäner

- ner

- nedladdning

- enheter

- grund

- under

- dynamiskt

- varje

- ivrig

- effekt

- Effektiv

- effektiv

- effektivt

- ansträngningar

- antingen

- inbäddning

- möjliggöra

- möjliggör

- möjliggör

- änden

- Slutpunkt

- Motor

- ingenjör

- Motorer

- förbättra

- företag

- Hela

- Miljö

- EOS

- uppskatta

- utvärdera

- Även

- undersöka

- exempel

- Utom

- exciterade

- uteslutande

- utförande

- erfarenhet

- Erfarenheter

- experter

- Förklarar

- utforska

- exponentiell

- förlängning

- extrahera

- extrakt

- faktor

- Leverans

- Funktioner

- Med

- Hämtas

- färre

- Figur

- Fil

- finansiering

- slut

- Förnamn

- flöda

- Fokus

- fokuserar

- fokusering

- efter

- För

- kraft

- format

- Ramverk

- Fri

- från

- fueled

- full

- fungera

- funktioner

- allmänhet

- generera

- genereras

- generera

- generering

- skaffa sig

- ges

- ger

- Go

- GPU

- gpu-prestanda

- GPUs

- diagram

- grafer

- större

- Växer

- styra

- Guider

- lämnandet

- hantera

- hårdvara

- Har

- he

- huvuden

- tung

- tunga lyft

- hjälpa

- hjälper

- Hög

- högpresterande

- högre

- Markerad

- hans

- innehar

- värd

- värd

- värd

- Hur ser din drömresa ut

- How To

- html

- http

- HTTPS

- humant

- ID

- Tanken

- if

- illustrerar

- bild

- genomförande

- genomföra

- importera

- med Esport

- importera

- förbättras

- förbättringar

- förbättra

- in

- djupgående

- ingår

- Inklusive

- Öka

- ökat

- Ökar

- ökning

- indikativ

- individuellt

- Individuellt

- slutsatsen

- informationen

- Infrastruktur

- inledande

- ingång

- ingångar

- inuti

- inspirerat

- installerad

- exempel

- istället

- instruktioner

- försäkring

- Intelligens

- interagera

- Gränssnitt

- in

- introducerade

- Introducerar

- införa

- problem

- IT

- iteration

- DESS

- Januari

- JIT

- sammanfogning

- gemensam

- jpeg

- jpg

- json

- bara

- Nyckel

- kunskap

- språk

- Large

- Stora företag

- större

- Efternamn

- Latens

- senaste

- lanserades

- lansera

- LÄRA SIG

- inlärning

- lämnar

- Längd

- Nivå

- bibliotek

- lyft

- tycka om

- linje

- rader

- Lista

- Lama

- LLM

- läser in

- lokal

- läge

- log

- skogsavverkning

- längre

- Låg

- lägre

- Maskinen

- maskininlärning

- göra

- förvaltade

- ledning

- manuell

- många

- master

- Match

- max

- maximal

- betyda

- mäta

- mekanism

- möter

- Minne

- metoder

- Metrics

- migrera

- minimum

- minuter

- blandning

- ML

- MLOps

- Mode

- modell

- modeller

- Övervaka

- mer

- Berg

- mycket

- multipel

- namn

- nativ

- Behöver

- behov

- NEO

- Nya

- Nya funktioner

- nytt

- Nästa

- nlp

- Ingen

- anteckningsbok

- nu

- antal

- numpy

- Nvidia

- objektet

- of

- erbjudanden

- Erbjudanden

- offset

- on

- ONE

- endast

- Verksamhet

- optimering

- optimeringar

- Optimera

- optimerad

- optimera

- Alternativet

- or

- organisationer

- ursprungliga

- Us

- Övriga

- Övrigt

- vår

- produktion

- utgångar

- utanför

- över

- övergripande

- OH

- paket

- paket

- Parallell

- parameter

- parametrar

- del

- särskilt

- Förbi

- Tidigare

- Mönster

- för

- prestanda

- fotografi

- plattform

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- i

- Populära

- placera

- möjlig

- Inlägg

- förutsägelse

- presentera

- föregående

- Principal

- Skriva ut

- Innan

- sannolikheter

- problem

- Bearbetad

- processer

- Produktion

- Produkter

- egenskaper

- ge

- tillhandahålla

- pytorch

- kvalitet

- fråga

- höja

- som sträcker sig

- Rankning

- RE

- nå

- Läsa

- Läsning

- realtid

- Anledningen

- nyligen

- rekommenderas

- minskar

- hänvisa

- region

- regelbunden

- regelbundet

- relaterad

- frigöra

- ta bort

- Repository

- begära

- förfrågningar

- Obligatorisk

- Krav

- Kräver

- resurs

- respons

- resulterande

- Resultat

- avkastning

- återgår

- höger

- Roll

- Körning

- kör

- runtime

- sagemaker

- Samma

- Skala

- skalning

- Vetenskap

- göra

- poäng

- §

- sektor

- se

- Seek

- vald

- SJÄLV

- senior

- skickas

- Sekvens

- tjänar

- server

- service

- Tjänster

- portion

- session

- in

- uppsättningar

- flera

- sharding

- Sharma

- skall

- Liknande

- Enkelt

- förenklar

- enda

- Storlek

- Small

- So

- Mjukvara

- mjukvaruutveckling

- Lösningar

- några

- specialist

- specialiserat

- specifikt

- specificerade

- fart

- spent

- starta

- igång

- Starta

- Startups

- state-of-the-art

- Fortfarande

- Sluta

- förvaring

- strategier

- Strategi

- ström

- strömmas

- streaming

- strömmar

- studio

- Senare

- Framgångsrikt

- sådana

- följer

- stödja

- Som stöds

- Stöder

- säker

- system

- System

- bord

- tar

- uppgift

- grupp

- tekniker

- Teknologi

- tennis

- text

- än

- den där

- Smakämnen

- skarven

- Linjen

- deras

- Dem

- Dessa

- detta

- de

- fastän?

- Genom

- genomströmning

- tid

- till

- tillsammans

- token

- tokens

- alltför

- spår

- trafik

- Tåg

- tränad

- Utbildning

- transformator

- Traveling

- träd

- sann

- prova

- två

- tyler

- typer

- oförändrad

- underliggande

- förstå

- förståelse

- tills

- Uppdatering

- uppdaterad

- uppladdad

- användbarhet

- Användning

- användning

- användningsfall

- Begagnade

- användbara

- Användare

- med hjälp av

- värde

- olika

- version

- mycket

- praktiskt taget

- syn

- gå

- promenerade

- vill

- var

- we

- webb

- webbservice

- Webbplats

- VÄL

- Vad

- när

- som

- medan

- VEM

- kommer

- fönster

- med

- inom

- utan

- Arbete

- arbetade

- arbetare

- arbetssätt

- skrivning

- år

- ännu

- Om er

- Din

- zephyrnet