Konstgjord intelligens (AI) har skapat furor nyligen med sin möjlighet att revolutionera hur människor närmar sig och löser olika uppgifter och komplexa problem. Från sjukvård till finans, AI och dess associerade maskininlärningsmodeller har visat sin potential att effektivisera komplicerade processer, förbättra beslutsmönster och avslöja värdefulla insikter.

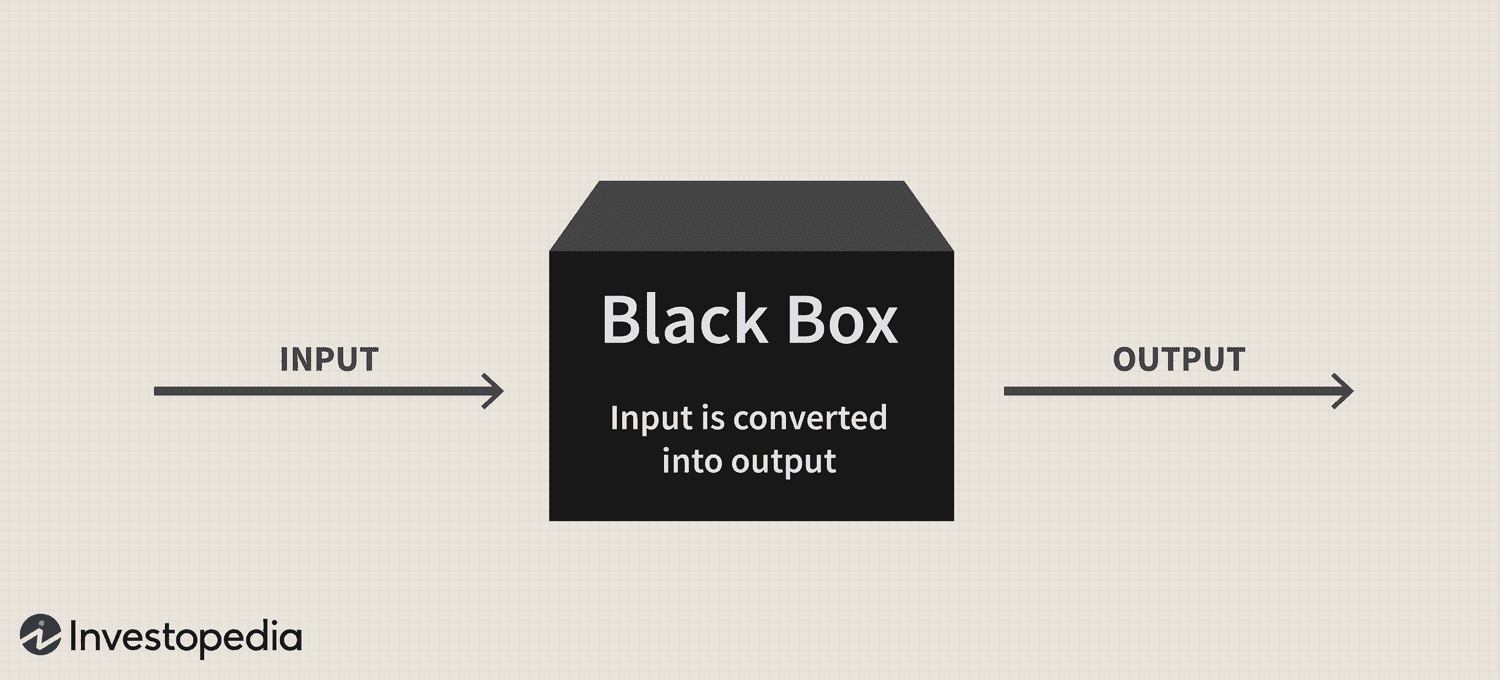

Men trots teknikens enorma potential har ett kvardröjande problem med "svarta lådan" fortsatt att utgöra en betydande utmaning för dess antagande, vilket väcker frågor om transparensen och tolkningsbarheten hos dessa sofistikerade system.

I korthet härrör black box-problemet från svårigheten att förstå hur AI-system och maskininlärningsmodeller bearbetar data och genererar förutsägelser eller beslut. Dessa modeller förlitar sig ofta på invecklade algoritmer som inte är lätta att förstå för människor, vilket leder till bristande ansvarighet och förtroende.

Därför, när AI blir alltmer integrerad i olika aspekter av våra liv, är det avgörande att ta itu med detta problem för att säkerställa en ansvarsfull och etisk användning av denna kraftfulla teknik.

Den svarta lådan: En översikt

Den "svarta lådan"-metaforen härrör från föreställningen att AI-system och maskininlärningsmodeller fungerar på ett sätt som är dolt från mänsklig förståelse, ungefär som innehållet i en förseglad, ogenomskinlig låda. Dessa system bygger på komplexa matematiska modeller och högdimensionella datamängder, som skapar intrikata relationer och mönster som styr deras beslutsprocesser. Men dessa inre funktioner är inte lättillgängliga eller begripliga för människor.

Rent praktiskt är problemet med AI-svarta lådan svårigheten att dechiffrera resonemanget bakom ett AI-systems förutsägelser eller beslut. Denna fråga är särskilt utbredd i modeller för djupinlärning som neurala nätverk, där flera lager av sammankopplade noder bearbetar och transformerar data på ett hierarkiskt sätt. De invecklade modellerna och de icke-linjära transformationerna de utför gör det oerhört utmanande att spåra logiken bakom deras utdata.

Nikita Brudnov, VD för BR Group – en AI-baserad marknadsanalysinstrumentpanel – sa till Cointelegraph att bristen på transparens i hur AI-modeller kommer fram till vissa beslut och förutsägelser kan vara problematisk i många sammanhang, såsom medicinsk diagnos, ekonomiskt beslutsfattande och rättsliga förfaranden, vilket avsevärt påverkar det fortsatta införandet av AI.

Magazine: Joe Lubin: Sanningen om ETH-grundarna splittrade och "Crypto Google"

"Under de senaste åren har mycket uppmärksamhet ägnats åt utvecklingen av tekniker för att tolka och förklara beslut som fattas av AI-modeller, som att generera poäng för funktionsviktighet, visualisera beslutsgränser och identifiera kontrafaktiska hypotetiska förklaringar," sa han och tillade:

"Men dessa tekniker är fortfarande i sin linda, och det finns ingen garanti för att de kommer att vara effektiva i alla fall."

Brudnov tror vidare att med ytterligare decentralisering kan tillsynsmyndigheter kräva att beslut som tas av AI-system är mer transparenta och ansvarsfulla för att säkerställa deras etiska giltighet och övergripande rättvisa. Han föreslog också att konsumenter kan tveka att använda AI-drivna produkter och tjänster om de inte förstår hur de fungerar och deras beslutsprocess.

James Wo, grundaren av DFG – ett värdepappersföretag som aktivt investerar i AI-relaterad teknik – tror att problemet med svarta lådan inte kommer att påverka antagandet under överskådlig framtid. Per Wo, de flesta användare bryr sig inte nödvändigtvis om hur befintliga AI-modeller fungerar och är glada över att helt enkelt få nytta av dem, åtminstone för nu.

"På medellång sikt, när nyheten med dessa plattformar försvinner, kommer det definitivt att finnas mer skepsis mot black box-metoden. Frågorna kommer också att öka när AI-användningen kommer in i krypto och Web3, där det finns ekonomiska insatser och konsekvenser att överväga”, medgav han.

Inverkan på förtroende och transparens

En domän där frånvaron av transparens kan påverka förtroendet avsevärt är AI-driven medicinsk diagnostik. Till exempel kan AI-modeller analysera komplex medicinsk data inom vården för att generera diagnoser eller behandlingsrekommendationer. Men när läkare och patienter inte kan förstå logiken bakom dessa förslag, kan de ifrågasätta tillförlitligheten och giltigheten av dessa insikter. Denna skepsis kan ytterligare leda till tveksamhet när det gäller att anta AI-lösningar, vilket potentiellt hindrar framsteg inom patientvård och personlig medicin.

På det finansiella området kan AI-system användas för kreditvärdering, upptäckt av bedrägerier och riskbedömning. Problemet med den svarta lådan kan dock skapa osäkerhet angående rättvisan och riktigheten i dessa kreditpoäng eller resonemanget bakom bedrägerivarningar, vilket begränsar teknikens förmåga att digitalisera branschen.

Kryptoindustrin står också inför återverkningarna av problemet med black box. Till exempel är digitala tillgångar och blockchain-teknik rotade i decentralisering, öppenhet och verifierbarhet. AI-system som saknar transparens och tolkningsmöjligheter kommer att utgöra en koppling mellan användarnas förväntningar och verkligheten hos AI-drivna lösningar i detta utrymme.

Regleringsfrågor

Ur en regulatorisk synvinkel innebär AI-svarta lådan unika utmaningar. Till att börja med kan opaciteten hos AI-processer göra det allt svårare för tillsynsmyndigheter att bedöma om dessa system överensstämmer med befintliga regler och riktlinjer. Dessutom kan brist på transparens komplicera tillsynsmyndigheternas förmåga att utveckla nya ramverk som kan hantera de risker och utmaningar som AI-tillämpningar innebär.

Lagstiftare kan kämpa för att utvärdera AI-systems rättvisa, partiskhet och datasekretesspraxis och deras potentiella inverkan på konsumenträttigheter och marknadsstabilitet. Utan en tydlig förståelse av beslutsprocesserna för AI-drivna system kan tillsynsmyndigheter dessutom möta svårigheter med att identifiera potentiella sårbarheter och säkerställa att lämpliga skyddsåtgärder finns på plats för att minska riskerna.

En anmärkningsvärd lagstiftningsutveckling när det gäller denna teknik har varit Europeiska unionens artificiell intelligenslag, som närmar sig att bli en del av blockets stadgar efter att ha nått en provisorisk politisk överenskommelse den 27 april.

I grunden syftar AI-lagen till att skapa en pålitlig och ansvarsfull miljö för AI-utveckling inom EU. Lagstiftare har antagit ett klassificeringssystem som kategoriserar olika typer av AI efter risk: oacceptabelt, högt, begränsat och minimalt. Detta ramverk är utformat för att ta itu med olika problem relaterade till AI-svarta lådan, inklusive frågor kring transparens och ansvarsskyldighet.

Oförmågan att effektivt övervaka och reglera AI-system har redan ansträngt relationerna mellan olika branscher och tillsynsorgan.

I början av förra månaden var den populära AI-chatboten ChatGPT förbjudna i Italien i 29 dagar, främst på grund av integritetsproblem som tagits upp av landets dataskyddsmyndighet för misstänkta brott mot EU:s allmänna dataskyddsförordningar (GDPR). Plattformen fick dock återuppta sina tjänster den 29 april efter att vd Sam Altman meddelat att han och hans team hade vidtagit specifika åtgärder för att följa tillsynsmyndighetens krav, inklusive avslöjandet av dess databehandlingsmetoder och implementeringen av dess implementering av ålders- grindåtgärder.

Otillräcklig reglering av AI-system kan urholka allmänhetens förtroende för AI-tillämpningar eftersom användare blir allt mer oroade över inneboende fördomar, felaktigheter och etiska konsekvenser.

Att lösa problemet med den svarta lådan

För att lösa problemet med AI-svarta lådan effektivt är det viktigt att använda en kombination av tillvägagångssätt som främjar transparens, tolkningsbarhet och ansvarsskyldighet. Två sådana kompletterande strategier är förklarlig AI (XAI) och modeller med öppen källkod.

XAI är ett forskningsområde dedikerat till att överbrygga gapet mellan komplexiteten i AI-system och behovet av mänsklig tolkning. XAI fokuserar på att utveckla tekniker och algoritmer som kan ge mänskligt förståeliga förklaringar till AI-drivna beslut, vilket ger insikter i resonemanget bakom dessa val.

Metoder som ofta används i XAI inkluderar surrogatmodeller, funktionsviktighetsanalys, känslighetsanalys och lokala tolkningsbara modellagnostiska förklaringar. Implementering av XAI över branscher kan hjälpa intressenter att bättre förstå AI-drivna processer, vilket ökar förtroendet för tekniken och underlättar efterlevnaden av regulatoriska krav.

Tillsammans med XAI kan främjande av antagandet av AI-modeller med öppen källkod vara en effektiv strategi för att ta itu med problemet med svarta lådan. Modeller med öppen källkod ger full tillgång till de algoritmer och data som driver AI-system, vilket gör det möjligt för användare och utvecklare att granska och förstå de underliggande processerna.

Denna ökade transparens kan bidra till att bygga förtroende och främja samarbete mellan utvecklare, forskare och användare. Dessutom kan tillvägagångssättet med öppen källkod skapa mer robusta, ansvarsfulla och effektiva AI-system.

Problemet med den svarta lådan i kryptorymden

Problemet med den svarta lådan har betydande konsekvenser för olika aspekter av kryptorymden, inklusive handelsstrategier, marknadsförutsägelser, säkerhetsåtgärder, tokenisering och smarta kontrakt.

När det gäller handelsstrategier och marknadsförutsägelser vinner AI-drivna modeller i popularitet när investerare försöker dra nytta av algoritmisk handel. Problemet med den svarta lådan hindrar dock användarnas förståelse av hur dessa modeller fungerar, vilket gör det utmanande att bedöma deras effektivitet och potentiella risker. Följaktligen kan denna opacitet också resultera i obefogat förtroende för AI-drivna investeringsbeslut eller göra investerare alltför beroende av automatiserade system.

AI kommer att spela en avgörande roll för att förbättra säkerhetsåtgärderna inom blockchain-ekosystemet genom att upptäcka bedrägliga transaktioner och misstänkta aktiviteter. Ändå komplicerar problemet med den svarta lådan verifieringsprocessen för dessa AI-drivna säkerhetslösningar. Bristen på transparens i beslutsfattandet kan urholka förtroendet för säkerhetssystemen, vilket ger upphov till oro över deras förmåga att skydda användarnas tillgångar och information.

Nyligen: Consensus 2023: Företag visar intresse för Web3, trots amerikanska regulatoriska utmaningar

Tokenisering och smarta kontrakt – två viktiga komponenter i blockchain-ekosystemet – bevittnar också ökad integration av AI. Problemet med den svarta lådan kan dock skymma logiken bakom AI-genererade tokens eller smart kontraktsutförande.

I takt med att AI revolutionerar olika branscher, blir det mer pressande att ta itu med problemet med black box. Genom att främja samarbete mellan forskare, utvecklare, beslutsfattare och industriintressenter kan lösningar utvecklas för att främja transparens, ansvarighet och förtroende för AI-system. Därför kommer det att bli intressant att se hur detta nya tekniska paradigm fortsätter att utvecklas.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoAiStream. Web3 Data Intelligence. Kunskap förstärkt. Tillgång här.

- Minting the Future med Adryenn Ashley. Tillgång här.

- Köp och sälj aktier i PRE-IPO-företag med PREIPO®. Tillgång här.

- Källa: https://cointelegraph.com/news/ai-s-black-box-problem-challenges-and-solutions-for-a-transparent-future

- : har

- :är

- :inte

- :var

- 2023

- 27

- a

- förmåga

- Om oss

- tillgång

- tillgänglig

- ansvar

- ansvarig

- noggrannhet

- tvärs

- Agera

- aktivt

- aktiviteter

- tillsats

- Dessutom

- adress

- adresse

- antagen

- Anta

- Antagande

- framsteg

- påverka

- Efter

- byrå

- Avtal

- AI

- AI-lagen

- AI chatbot

- AI-powered

- Syftet

- Varningar

- algoritmisk

- algoritmisk handel

- algoritmer

- Alla

- redan

- också

- bland

- an

- analys

- analytics

- analysera

- och

- meddelade

- tillämpningar

- tillvägagångssätt

- tillvägagångssätt

- lämpligt

- April

- ÄR

- OMRÅDE

- runt

- konstgjord

- artificiell intelligens

- AS

- aspekter

- bedömning

- Tillgångar

- associerad

- At

- uppmärksamhet

- Automatiserad

- BE

- blir

- blir

- passande

- varit

- bakom

- tror

- Bättre

- mellan

- förspänning

- förspänner

- Svart

- blockchain

- blockchain ekosystem

- Blockchain-teknik

- organ

- boken

- gränser

- Box

- överbryggande

- SLUTRESULTAT

- bygga förtroende

- byggt

- företag

- by

- KAN

- kan inte

- kapitalisera

- vilken

- fall

- VD

- vissa

- utmanar

- utmaningar

- utmanande

- chatbot

- ChatGPT

- val

- klassificering

- klassificeringssystem

- klar

- kliniker

- Cointelegraph

- samverkan

- kombination

- komplementär

- komplex

- Komplexiteten

- Efterlevnad

- komponenter

- förstå

- aktuella

- oro

- Konsekvenser

- Följaktligen

- Tänk

- Konsumenten

- Konsumenträttigheter

- konsumenter

- innehåll

- kontexter

- fortsatte

- fortsätter

- kontrakt

- kontrakt

- Kärna

- kunde

- lands

- skapa

- skapas

- kredit

- avgörande

- crypto

- Kryptoindustri

- kryptoutrymme

- instrumentbräda

- datum

- dataintegritet

- databehandling

- dataskydd

- datauppsättningar

- Decentralisering

- Beslutet

- Beslutsfattande

- beslut

- dedicerad

- djup

- djupt lärande

- definitivt

- krav

- demonstreras

- utformade

- Trots

- Detektering

- utveckla

- utvecklade

- utvecklare

- utveckla

- Utveckling

- olika

- svårt

- svårigheter

- Svårighet

- digital

- Digitala tillgångar

- Digitalisera

- do

- domän

- inte

- driv

- grund

- lätt

- ekosystemet

- Effektiv

- effektivt

- effektivitet

- anställd

- möjliggör

- förbättra

- förbättra

- säkerställa

- säkerställa

- Går in

- Miljö

- väsentlig

- ETH

- etisk

- EU

- Giltigt körkort

- utvärdera

- utvecklas

- exempel

- utförande

- befintliga

- förväntningar

- förklara

- Ansikte

- ytorna

- underlättande

- rättvisa

- Leverans

- finansiering

- finansiella

- Firm

- fokuserar

- För

- förutsebar

- formen

- Foster

- främja

- grundare

- grundare

- Ramverk

- ramar

- bedrägeri

- spårning av bedrägerier

- bedräglig

- från

- full

- fungera

- ytterligare

- Vidare

- framtida

- få

- spalt

- GDPR

- Allmänt

- generell information

- generera

- generera

- bevilja

- Grupp

- garanti

- styra

- riktlinjer

- hade

- lyckligt

- Har

- he

- hälso-och sjukvård

- hjälpa

- Hög

- hindrar

- hans

- Hur ser din drömresa ut

- Men

- HTTPS

- humant

- Människa

- identifiera

- if

- enorma

- Inverkan

- slag

- genomförande

- genomföra

- implikationer

- vikt

- in

- Oförmågan

- innefattar

- Inklusive

- Öka

- ökat

- alltmer

- industrier

- industrin

- informationen

- inneboende

- insikter

- integrerade

- integrering

- Intelligens

- sammankopplade

- intresse

- intressant

- in

- investering

- För Investerare

- investerar

- fråga

- problem

- IT

- Italien

- DESS

- Brist

- Efternamn

- lagstiftare

- skikt

- leda

- ledande

- inlärning

- t minst

- Adress

- rättsliga förfaranden

- tycka om

- Begränsad

- Bor

- lokal

- Logiken

- Maskinen

- maskininlärning

- gjord

- göra

- Framställning

- sätt

- många

- marknad

- marknadsförutsägelser

- Marknadsföring

- matematisk

- Maj..

- åtgärder

- medicinsk

- medicinska data

- läkemedel

- Metodik

- kanske

- minimum

- Mildra

- modeller

- Övervaka

- Månad

- mer

- Dessutom

- mest

- rörliga

- mycket

- multipel

- nödvändigtvis

- Behöver

- nätverk

- neurala nätverk

- Icke desto mindre

- Nya

- Nej

- noder

- anmärkningsvärd

- Begrepp

- roman

- nyhet

- nu

- of

- sänkt

- erbjuda

- Ofta

- on

- gång

- opak

- öppen källkod

- Öppenheten

- driva

- or

- vår

- övergripande

- betalas

- paradigmet

- del

- särskilt

- Patienten

- patienter

- mönster

- Personer

- Utföra

- personlig

- Plats

- plattform

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- Spela

- beslutsfattare

- politiska

- Populära

- popularitet

- Möjligheten

- potentiell

- potentiellt

- den mäktigaste

- Praktisk

- praxis

- Förutsägelser

- presentera

- presenterar

- förhärskande

- primärt

- privatpolicy

- Problem

- problem

- förfaranden

- process

- processer

- bearbetning

- Produkter

- främja

- främja

- skydd

- ge

- provisorisk

- allmän

- allmänhetens förtroende

- fråga

- frågor

- insamlat

- höja

- logiska grunden

- nå

- Verkligheten

- rike

- senaste

- nyligen

- rekommendationer

- om

- Reglera

- reglering

- föreskrifter

- Tillsynsmyndigheter

- regulatorer

- relaterad

- Förhållanden

- tillförlitlighet

- förlita

- återverkningar

- kräver

- Krav

- forskning

- forskare

- ansvarig

- resultera

- Fortsätt

- revolutionera

- revolutionerar

- rättigheter

- Risk

- riskbedömning

- risker

- robusta

- Roll

- regler

- skyddsåtgärder

- Nämnda

- Sam

- Sam Altman

- poäng

- säkerhet

- Säkerhetsåtgärder

- se

- Seek

- Känslighet

- Tjänster

- uppsättningar

- show

- signifikant

- signifikant

- helt enkelt

- Skepsis

- smarta

- smart kontrakt

- Smarta kontrakt

- Lösningar

- LÖSA

- sofistikerade

- Källa

- Utrymme

- specifik

- delas

- Stabilitet

- intressenter

- stå

- står

- stjälkar

- Steg

- Fortfarande

- strategier

- Strategi

- effektivisera

- Kamp

- sådana

- misstänksam

- system

- System

- Tandem

- uppgifter

- grupp

- tech

- tekniker

- Tekniken

- Teknologi

- villkor

- den där

- Smakämnen

- deras

- Dem

- Där.

- Dessa

- de

- detta

- till

- tokenization

- tokens

- Trace

- Handel

- Trading Strategies

- Transaktioner

- Förvandla

- transformationer

- Öppenhet

- transparent

- behandling

- Litar

- trovärdig

- sanningen

- två

- typer

- Osäkerhet

- avslöja

- underliggande

- förstå

- förståeligt

- förståelse

- unika

- på

- us

- användning

- Användare

- användare

- verktyg

- Värdefulla

- olika

- Verifiering

- Överträdelser

- avgörande

- sårbarheter

- var

- Web3

- när

- som

- kommer

- med

- inom

- utan

- bevittnar

- wo

- Arbete

- fungerar

- år

- zephyrnet