Detta är ett gästinlägg av AK Roy från Qualcomm AI.

Amazon Elastic Compute Cloud (Amazon EC2) DL2q-instanser, som drivs av Qualcomm AI 100 Standardacceleratorer, kan användas för att kostnadseffektivt distribuera arbetsbelastningar för djupinlärning (DL) i molnet. De kan också användas för att utveckla och validera prestanda och noggrannhet för DL-arbetsbelastningar som kommer att distribueras på Qualcomm-enheter. DL2q-instanser är de första instanserna som tar med Qualcomms artificiella intelligenta (AI)-teknik till molnet.

Med åtta Qualcomm AI 100 Standard-acceleratorer och 128 GiB totalt acceleratorminne kan kunder också använda DL2q-instanser för att köra populära generativa AI-applikationer, såsom innehållsgenerering, textsammanfattning och virtuella assistenter, såväl som klassiska AI-applikationer för naturlig språkbehandling och datorseende. Dessutom har Qualcomm AI 100-acceleratorer samma AI-teknik som används för smartphones, autonom körning, persondatorer och utökade verklighetsheadset, så DL2q-instanser kan användas för att utveckla och validera dessa AI-arbetsbelastningar före implementering.

Nya höjdpunkter för DL2q-instanser

Varje DL2q-instans innehåller åtta Qualcomm Cloud AI100-acceleratorer, med en sammanlagd prestanda på över 2.8 PetaOps av Int8-inferensprestanda och 1.4 PetaFlops av FP16-inferensprestanda. Förekomsten har sammanlagt 112 AI-kärnor, acceleratorminneskapacitet på 128 GB och minnesbandbredd på 1.1 TB per sekund.

Varje DL2q-instans har 96 vCPU:er, en systemminneskapacitet på 768 GB och stöder en nätverksbandbredd på 100 Gbps samt Amazon Elastic Block Store (Amazon EBS) lagring på 19 Gbps.

| Instansnamn | vCPU: er | Cloud AI100 acceleratorer | Acceleratorminne | Acceleratorminne BW (aggregerat) | Instansminne | Exempel nätverk | Lagringsbandbredd (Amazon EBS). |

| DL2q.24xlarge | 96 | 8 | 128 GB | 1.088 TB / s | 768 GB | 100 Gbps | 19 Gbps |

Qualcomm Cloud AI100 acceleratorinnovation

Cloud AI100 accelerator system-on-chip (SoC) är en specialbyggd, skalbar flerkärnig arkitektur som stöder ett brett utbud av djupinlärning användningsfall som sträcker sig från datacenter till kanten. SoC använder skalära, vektor- och tensorberäkningskärnor med en branschledande on-die SRAM-kapacitet på 126 MB. Kärnorna är sammankopplade med ett nätverk-på-chip-nät (NoC) med hög bandbredd och låg latens.

AI100-acceleratorn stöder ett brett och omfattande utbud av modeller och användningsområden. Tabellen nedan belyser utbudet av modellstödet.

| Modellkategori | Antal modeller | Exempel |

| NLP | 157 | BERT, BART, FasterTransformer, T5, Z-kod MOE |

| Generativ AI – NLP | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| Generativ AI – Bild | 3 | Stabil diffusion v1.5 och v2.1, OpenAI CLIP |

| CV – Bildklassificering | 45 | ViT, ResNet, ResNext, MobileNet, EfficientNet |

| CV – Objektdetektering | 23 | YOLO v2, v3, v4, v5 och v7, SSD-ResNet, RetinaNet |

| CV – Övrigt | 15 | LPRNet, superupplösning/SRGAN, ByteTrack |

| Bilnätverk* | 53 | Perception och LIDAR, fotgängare, körfält och trafikljusdetektering |

| Total | > 300 â € < | â € < |

* De flesta fordonsnätverk är sammansatta nätverk som består av en sammansmältning av enskilda nätverk.

Det stora SRAM-minnet på DL2q-acceleratorn möjliggör effektiv implementering av avancerade prestandatekniker som MX6-mikroexponentprecision för lagring av vikterna och MX9-mikroexponentprecision för accelerator-till-acceleratorkommunikation. Mikroexponenttekniken beskrivs i följande branschmeddelande om Open Compute Project (OCP): AMD, Arm, Intel, Meta, Microsoft, NVIDIA och Qualcomm standardiserar nästa generations smala precisionsdataformat för AI » Open Compute Project.

Förekomstanvändaren kan använda följande strategi för att maximera prestanda per kostnad:

- Lagra vikter med MX6-mikroexponentprecisionen i DDR-minnet på acceleratorn. Genom att använda MX6-precisionen maximeras utnyttjandet av den tillgängliga minneskapaciteten och minnesbandbredden för att leverera klassens bästa genomströmning och latens.

- Beräkna i FP16 för att leverera den nödvändiga användningsfallets noggrannhet, samtidigt som du använder det överlägsna SRAM-minnet på chipet och extra TOP:s på kortet, för att implementera högpresterande MX6 till FP16-kärnor med låg latens.

- Använd en optimerad batchstrategi och en högre batchstorlek genom att använda det stora on-chip SRAM som finns tillgängligt för att maximera återanvändningen av vikter, samtidigt som aktiveringarna på chipet bibehålls så mycket som möjligt.

DL2q AI Stack och verktygskedja

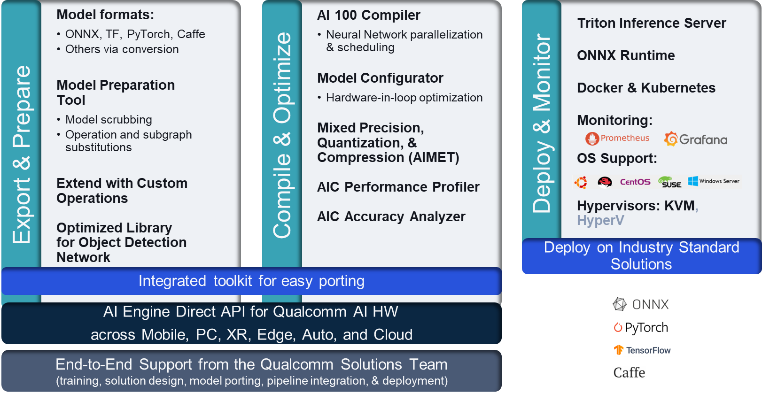

DL2q-instansen åtföljs av Qualcomm AI Stack som ger en konsekvent utvecklarupplevelse över Qualcomm AI i molnet och andra Qualcomm-produkter. Samma Qualcomm AI stack och bas AI-teknik körs på DL2q-instanserna och Qualcomm edge-enheter, vilket ger kunderna en konsekvent utvecklarupplevelse, med ett enhetligt API över deras moln-, fordons-, persondator-, utökade verklighets- och smartphoneutvecklingsmiljöer.

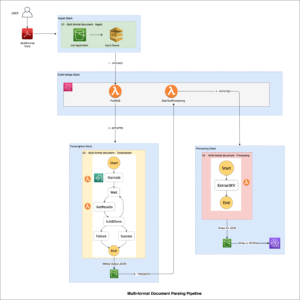

Verktygskedjan gör det möjligt för instansanvändaren att snabbt gå ombord på en tidigare utbildad modell, kompilera och optimera modellen för instansfunktionerna och därefter distribuera de kompilerade modellerna för produktionsinferensanvändningsfall i tre steg som visas i följande figur.

För att lära dig mer om hur du ställer in en modells prestanda, se Cloud AI 100 nyckelprestandaparametrar Dokumentation.

Kom igång med DL2q-instanser

I det här exemplet kompilerar och distribuerar du en förutbildad BERT modell från Kramande ansikte på en EC2 DL2q-instans med en förbyggd tillgänglig DL2q AMI, i fyra steg.

Du kan använda antingen en förbyggd Qualcomm DLAMI på instansen eller börja med en Amazon Linux2 AMI och bygg din egen DL2q AMI med Cloud AI 100 Platform och Apps SDK som är tillgänglig i denna Amazon Simple Storage Service (Amazon S3) hink: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

Stegen som följer använder den förbyggda DL2q AMI, Qualcomm Base AL2 DLAMI.

Använd SSH för att komma åt din DL2q-instans med Qualcomm Base AL2 DLAMI AMI och följ steg 1 till 4.

Steg 1. Konfigurera miljön och installera nödvändiga paket

- Installera Python 3.8.

- Konfigurera den virtuella Python 3.8-miljön.

- Aktivera den virtuella Python 3.8-miljön.

- Installera de nödvändiga paketen, som visas i krav.txt-dokument tillgänglig på Qualcomms offentliga Github-webbplats.

- Importera nödvändiga bibliotek.

Steg 2. Importera modellen

- Importera och tokenisera modellen.

- Definiera en provinmatning och extrahera

inputIdsochattentionMask. - Konvertera modellen till ONNX, som sedan kan skickas till kompilatorn.

- Du kommer att köra modellen i FP16-precision. Så du måste kontrollera om modellen innehåller några konstanter utanför FP16-intervallet. Skicka modellen till

fix_onnx_fp16funktion för att generera den nya ONNX-filen med de korrigeringar som krävs.

Steg 3. Kompilera modellen

Smakämnen qaic-exec kompilatorverktyg för kommandoradsgränssnitt (CLI) används för att kompilera modellen. Indata till denna kompilator är ONNX-filen som genererades i steg 2. Kompilatorn producerar en binär fil (kallas QPC, För Qualcomm programbehållare) i sökvägen som definieras av -aic-binary-dir argument.

I kompileringskommandot nedan använder du fyra AI-beräkningskärnor och en batchstorlek på en för att kompilera modellen.

QPC genereras i bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc mapp.

Steg 4. Kör modellen

Ställ in en session för att köra inferensen på en Cloud AI100 Qualcomm-accelerator i DL2q-instansen.

Qualcomm qaic Python-biblioteket är en uppsättning API:er som ger stöd för att köra slutledning på Cloud AI100-acceleratorn.

- Använd Session API-anropet för att skapa en sessionsinstans. Session API-anropet är startpunkten för att använda qaic Python-biblioteket.

- Omstrukturera data från utgångsbuffert med

output_shapeochoutput_type. - Avkoda den producerade produktionen.

Här är utdata för inmatningsmeningen "Hunden [MASK] på mattan."

Det är allt. Med bara några få steg kompilerade och körde du en PyTorch-modell på en Amazon EC2 DL2q-instans. För att lära dig mer om introduktion och kompilering av modeller på DL2q-instansen, se Cloud AI100 Handledningsdokumentation.

För att lära dig mer om vilka DL-modellarkitekturer som passar bra för AWS DL2q-instanser och den aktuella modellstödsmatrisen, se Qualcomm Cloud AI100 dokumentation.

Tillgänglig nu

Du kan lansera DL2q-instanser idag i västra USA (Oregon) och Europa (Frankfurt) AWS-regioner som På begäran, Reserveradoch Spotinstanser, eller som en del av en Sparplan. Som vanligt med Amazon EC2 betalar du bara för det du använder. För mer information, se Amazon EC2-prissättning.

DL2q-instanser kan distribueras med hjälp av AWS Deep Learning AMI (DLAMI), och behållarbilder är tillgängliga via hanterade tjänster som t.ex Amazon SageMaker, Amazon Elastic Kubernetes Service (Amazon EKS), Amazon Elastic Container Service (Amazon ECS)och AWS ParallelCluster.

För mer information, besök Amazon EC2 DL2q-instans sida och skicka feedback till AWS re:Post för EC2 eller genom dina vanliga AWS-supportkontakter.

Om författarna

AK Roy är en direktör för produkthantering på Qualcomm, för moln- och datacenter AI-produkter och -lösningar. Han har över 20 års erfarenhet av produktstrategi och utveckling, med nuvarande fokus på klassens bästa prestanda och prestanda/$ end-to-end-lösningar för AI-inferens i molnet, för det breda utbudet av användningsfall, inklusive GenAI, LLMs, Auto och Hybrid AI.

AK Roy är en direktör för produkthantering på Qualcomm, för moln- och datacenter AI-produkter och -lösningar. Han har över 20 års erfarenhet av produktstrategi och utveckling, med nuvarande fokus på klassens bästa prestanda och prestanda/$ end-to-end-lösningar för AI-inferens i molnet, för det breda utbudet av användningsfall, inklusive GenAI, LLMs, Auto och Hybrid AI.

Jianying Lang är en Principal Solutions Architect vid AWS Worldwide Specialist Organization (WWSO). Hon har över 15 års arbetslivserfarenhet inom HPC och AI-området. På AWS fokuserar hon på att hjälpa kunder att distribuera, optimera och skala sina AI/ML-arbetsbelastningar på accelererade beräkningsinstanser. Hon brinner för att kombinera teknikerna inom HPC och AI. Jianying har en doktorsexamen i beräkningsfysik från University of Colorado i Boulder.

Jianying Lang är en Principal Solutions Architect vid AWS Worldwide Specialist Organization (WWSO). Hon har över 15 års arbetslivserfarenhet inom HPC och AI-området. På AWS fokuserar hon på att hjälpa kunder att distribuera, optimera och skala sina AI/ML-arbetsbelastningar på accelererade beräkningsinstanser. Hon brinner för att kombinera teknikerna inom HPC och AI. Jianying har en doktorsexamen i beräkningsfysik från University of Colorado i Boulder.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- : har

- :är

- $UPP

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- 15 år

- 15%

- 17

- 19

- 20

- 20 år

- 22

- 23

- 7

- 75

- 8

- 84

- a

- Om oss

- ovan

- accelererad

- accelerator

- acceleratorer

- tillgång

- åtföljas

- noggrannhet

- tvärs

- aktiveringar

- Dessutom

- avancerat

- aggregat

- AI

- AI / ML

- Alla

- också

- amason

- Amazon EC2

- Amazon Web Services

- an

- och

- Tillkännagivande

- vilken som helst

- api

- API: er

- tillämpningar

- appar

- arkitektur

- ÄR

- Argumentet

- ARM

- konstgjord

- AS

- assistenter

- At

- bil

- fordonsindustrin

- autonom

- tillgänglig

- AWS

- AXLAR

- Bandbredd

- bas

- BE

- innan

- nedan

- Bortom

- SOPTUNNA

- Blockera

- Bloom

- föra

- bred

- buffert

- SLUTRESULTAT

- by

- Ring

- kallas

- KAN

- kapacitet

- Kapacitet

- kortet

- Vid

- ta

- klassiska

- cloud

- Colorado

- kombinera

- Kommunikation

- omfattande

- beräkningar

- Compute

- dator

- Datorsyn

- datorer

- databehandling

- konsekvent

- Bestående

- kontakter

- Behållare

- innehåller

- innehåll

- Innehållsgenerering

- skapa

- Aktuella

- Kunder

- datum

- Datacenter

- djup

- djupt lärande

- definierade

- Examen

- leverera

- levererar

- distribuera

- utplacerade

- utplacering

- beskriven

- utveckla

- Utvecklare

- Utveckling

- anordning

- enheter

- Diffusion

- Direktör

- dokumentation

- Dog

- drivande

- dynamisk

- kant

- effektiv

- antingen

- sysselsätter

- möjliggör

- början till slut

- inträde

- Miljö

- miljöer

- Europa

- exempel

- erfarenhet

- utvidgad verklighet

- extrahera

- falsk

- Leverans

- återkoppling

- få

- fält

- Fält

- Figur

- Fil

- Förnamn

- passa

- Fokus

- fokuserar

- följer

- efter

- För

- hittade

- fyra

- Frankfurt

- från

- fungera

- sammansmältning

- allmänhet

- generera

- genereras

- generering

- generativ

- Generativ AI

- GitHub

- ges

- god

- Gäst

- gäst inlägg

- he

- headset

- hjälpa

- här.

- högpresterande

- högre

- höjdpunkter

- innehar

- HPC

- html

- HTTPS

- Hybrid

- i

- IDX

- if

- bild

- bilder

- genomföra

- genomförande

- importera

- in

- Inklusive

- inkorporerar

- individuellt

- industrin

- branschledande

- informationen

- ingång

- installera

- exempel

- Intel

- Intelligent

- sammankopplade

- Gränssnitt

- IT

- jpg

- bara

- Nyckel

- Lane

- språk

- Large

- Latens

- lansera

- LÄRA SIG

- inlärning

- bibliotek

- Bibliotek

- ljus

- linje

- laster

- förvaltade

- ledning

- mask

- Matris

- max

- Maximera

- maximerar

- maximal

- Minne

- maska

- meta

- Microsoft

- min

- modell

- modeller

- modifierad

- mer

- mest

- namn

- smal

- Natural

- Naturlig språkbehandling

- nödvändigt för

- Behöver

- nät

- nätverk

- nätverk

- Nya

- nästa generation

- nu

- numpy

- Nvidia

- objektet

- of

- on

- Ombord

- Onboarding

- ONE

- endast

- öppet

- OpenAI

- Optimera

- optimerad

- or

- Oregon

- organisation

- OS

- Övriga

- ut

- produktion

- utgångar

- över

- egen

- paket

- sida

- del

- passera

- Godkänd

- brinner

- bana

- Betala

- för

- prestanda

- personlig

- phd

- Fysik

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- Punkt

- Populära

- möjlig

- Inlägg

- drivs

- Precision

- tidigare

- Principal

- bearbetning

- producerad

- producerar

- Produkt

- produktledning

- Produktion

- Produkter

- Program

- projektet

- ger

- tillhandahålla

- allmän

- Python

- pytorch

- Qualcomm

- snabbt

- område

- RE

- Läsning

- Verkligheten

- regioner

- Obligatorisk

- Krav

- kvarhållande

- avkastning

- återanvända

- roy

- Körning

- rinnande

- kör

- Samma

- Save

- sparande

- skalbar

- Skala

- sDK

- Andra

- se

- sända

- mening

- Sekvens

- service

- Tjänster

- session

- in

- hon

- visas

- Enkelt

- förenkla

- webbplats

- Storlek

- smartphone

- smartphones

- So

- Lösningar

- spänning

- specialist

- stapel

- standard

- starta

- igång

- Steg

- Steg

- förvaring

- lagra

- misslyckande

- Strategi

- Senare

- sådana

- överlägsen

- stödja

- Stödjande

- Stöder

- SYS

- system

- bord

- tekniker

- Teknologi

- text

- den där

- Smakämnen

- deras

- sedan

- Dessa

- de

- detta

- tre

- Genom

- genomströmning

- thru

- till

- i dag

- symbolisera

- verktyg

- Överdelar

- brännaren

- Totalt

- trafik

- tränad

- transformatorer

- sann

- trimma

- handledning

- enhetlig

- universitet

- us

- användning

- användningsfall

- användarfall

- Begagnade

- Användare

- med hjälp av

- vanliga

- v1

- BEKRÄFTA

- värde

- Virtuell

- syn

- Besök

- we

- webb

- webbservice

- VÄL

- väster

- Vad

- som

- medan

- bred

- Brett utbud

- kommer

- med

- ord

- arbetssätt

- inom hela sverige

- år

- Om er

- Din

- zephyrnet