Användardata: LLMs Vital Food

Ja! RT @bryce älskar det här citatet "If you're not paying for it, you're not the customer; du är produkten som säljs." http://bit.ly/93JYCJ

— Tim O'Reilly (@timoreilly) September 2, 2010

Håll dig uppdaterad om kryptonyheter, få dagliga uppdateringar i din inkorg.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- : har

- :är

- :inte

- 7

- 8

- a

- förmåga

- Absolut

- Enligt

- exakt

- anpassning

- adresse

- Lägger

- avancerat

- sedan

- instämmer

- AI

- AI-tjänster

- AI-system

- Syftet

- alexa

- Justerar

- Alla

- tillåter

- också

- alltid

- amason

- an

- och

- Antropisk

- förutse

- vilken som helst

- tillämplig

- ÄR

- AS

- utgå ifrån

- At

- tillgänglig

- undvika

- medveten

- baserat

- BE

- därför att

- Där vi får lov att vara utan att konstant prestera,

- tros

- fördelaktigt

- Bättre

- mellan

- by

- KAN

- hävdar

- klienter

- kommersiella

- engagemang

- begår

- Företag

- företag

- konkurrenskraftig

- begrepp

- oro

- ständigt

- innehåll

- sammanhang

- kontinuerligt

- kontroll

- Bekväm

- konversationer

- upphovsrätt

- kunde

- avgörande

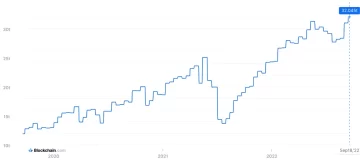

- crypto

- crypto News

- Aktuella

- kund

- Kunder

- dagligen

- mörkt

- datum

- dataintegritet

- diskussion

- årtionden

- Avkryptera

- djup

- djupt lärande

- Standard

- Försvara

- leverera

- beror

- friskriver

- tvister

- Mångfald

- do

- dokumentera

- gör

- dollar

- inte

- under

- tjänar

- kant

- effektivitet

- antingen

- ingrepp

- förbättra

- säkerställer

- väsentlig

- etisk

- etik

- exempel

- utbyta

- erfarenhet

- omfattande

- utsträckning

- extern

- vänd

- För

- Tidigare

- Grundad

- Fri

- från

- få

- generera

- genereras

- genererar

- generativ

- Generativ AI

- skaffa sig

- få

- jättar

- Ge

- Go

- bevilja

- grepp

- Växer

- kraftigt

- ärlig

- ära

- Men

- http

- HTTPS

- humant

- ideal

- if

- förbättra

- in

- individuellt

- informationen

- intellektuella

- immateriella rättigheter

- intentioner

- interaktioner

- inre

- IP

- IT

- DESS

- sig

- Nyckel

- språk

- Large

- senaste

- Lag

- leda

- LÄRA SIG

- inlärning

- Adress

- Hävstång

- tycka om

- Lama

- LLM

- älskar

- göra

- Framställning

- Maj..

- Media

- meta

- miljoner

- modell

- modeller

- mer

- mest

- nätverk

- neurala

- neurala nätverk

- Nya

- nyheter

- erhållande

- of

- on

- OpenAI

- or

- skenbart

- annat

- vår

- ut

- utgångar

- över

- egen

- äger

- betalas

- parter

- parti

- mönster

- Betala

- betalar

- personlig

- personalisering

- personlig

- Bilder

- plato

- Platon Data Intelligence

- PlatonData

- policy

- potentiell

- kraft

- den mäktigaste

- praxis

- förutse

- Förutsägelser

- preferenser

- förhärskande

- privatpolicy

- privat

- producerad

- Produkt

- prompter

- egenskapen

- ge

- ger

- allmän

- allmänhetens förtroende

- publicly

- citera

- Racing

- RE

- verkliga världen

- erhåller

- förfina

- betraktar

- relativ

- frigöra

- relevanta

- Rapporterad

- förfrågningar

- forskare

- ansvarig

- avslöjade

- rättigheter

- rivaler

- rt

- Ryan

- s

- säga

- säger

- scen

- service

- Tjänster

- in

- Dela

- skall

- Skepsis

- So

- Social hållbarhet

- sociala medier

- säljs

- BOKSTAVERA

- talesman

- start

- .

- bo

- Steg

- System

- Tandem

- tech

- tekniska jättar

- tekniker

- villkor

- text

- den där

- Smakämnen

- deras

- Dem

- Dessa

- de

- detta

- tim

- till

- i dag

- topp

- Tåg

- tränad

- Utbildning

- Öppenhet

- Trender

- Litar

- under

- förstå

- förståelse

- kommande

- uppdaterad

- Uppdateringar

- uppgraderad

- uppladdad

- användning

- Begagnade

- Användare

- användare

- med hjälp av

- Värdefulla

- olika

- version

- Video

- avgörande

- Röst

- volym

- var

- we

- były

- när

- om

- som

- varför

- kommer

- med

- ord

- skulle

- Om er

- Din

- zephyrnet