Idag är vi glada över att kunna tillkännage möjligheten att finjustera Llama 2-modeller av Meta med Amazon SageMaker JumpStart. Llama 2-familjen av stora språkmodeller (LLM) är en samling förtränade och finjusterade generativa textmodeller som sträcker sig i skala från 7 miljarder till 70 miljarder parametrar. Finjusterade LLM:er, kallade Llama-2-chat, är optimerade för dialoganvändningsfall. Du kan enkelt prova dessa modeller och använda dem med SageMaker JumpStart, som är ett nav för maskininlärning (ML) som ger tillgång till algoritmer, modeller och ML-lösningar så att du snabbt kan komma igång med ML. Nu kan du också finjustera 7 miljarder, 13 miljarder och 70 miljarder parametrar Llama 2-textgenereringsmodeller på SageMaker JumpStart med hjälp av Amazon SageMaker Studio UI med några få klick eller med SageMaker Python SDK.

Generativa AI-grundmodeller har varit i fokus för det mesta av ML och artificiell intelligens forskning och användningsfall i över ett år nu. Dessa grundmodeller fungerar mycket bra med generativa uppgifter, såsom textgenerering, sammanfattning, frågesvar, bild- och videogenerering, med mera, på grund av sin stora storlek och även för att de tränas på flera stora datamängder och hundratals uppgifter. Trots de stora generaliseringsmöjligheterna hos dessa modeller finns det ofta användningsfall som har mycket specifika domändata (som sjukvård eller finansiella tjänster), på grund av vilka dessa modeller kanske inte kan ge bra resultat för dessa användningsfall. Detta resulterar i ett behov av ytterligare finjustering av dessa generativa AI-modeller över användningsfallsspecifika och domänspecifika data.

I det här inlägget går vi igenom hur man finjusterar Llama 2 förtränade textgenereringsmodeller via SageMaker JumpStart.

Vad är Llama 2

Llama 2 är en autoregressiv språkmodell som använder en optimerad transformatorarkitektur. Llama 2 är avsedd för kommersiell och forskningsanvändning på engelska. Den finns i en rad parameterstorlekar – 7 miljarder, 13 miljarder och 70 miljarder – såväl som förtränade och finjusterade varianter. Enligt Meta använder de avstämda versionerna övervakad finjustering (SFT) och förstärkningsinlärning med mänsklig feedback (RLHF) för att anpassa sig till mänskliga preferenser för hjälpsamhet och säkerhet. Llama 2 var förtränad på 2 biljoner tokens data från allmänt tillgängliga källor. De avstämda modellerna är avsedda för assistentliknande chatt, medan förtränade modeller kan anpassas för en mängd olika naturliga språkgenereringsuppgifter. Oavsett vilken version av modellen en utvecklare använder, guide för ansvarsfull användning från Meta kan hjälpa till att vägleda ytterligare finjusteringar som kan vara nödvändiga för att anpassa och optimera modellerna med lämpliga säkerhetsbegränsningar.

För närvarande är Llama 2 tillgänglig i följande regioner:

- Distribuera förtränad modell tillgänglig:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Finjustera och distribuera den finjusterade modellen:

“us-east-1”,“us-west-2”,“eu-west-1”

Vad är SageMaker JumpStart

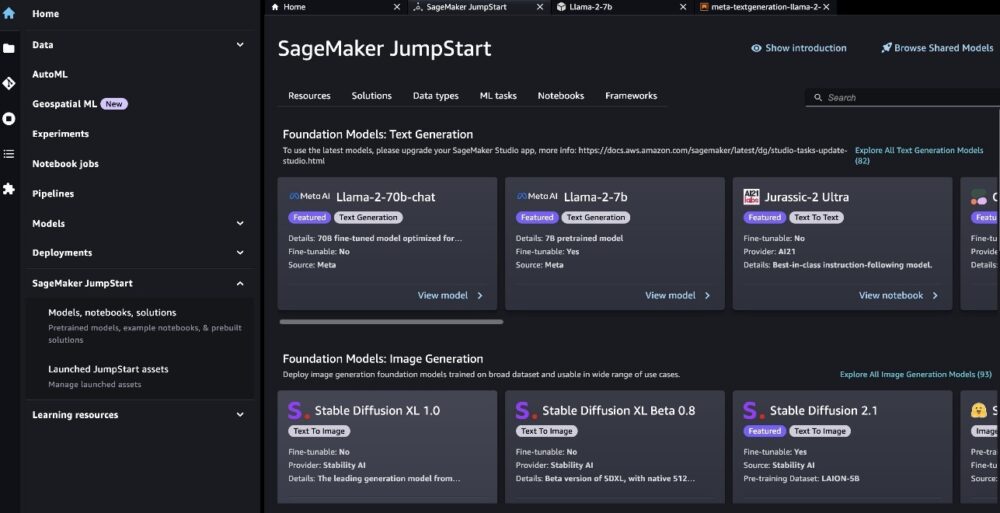

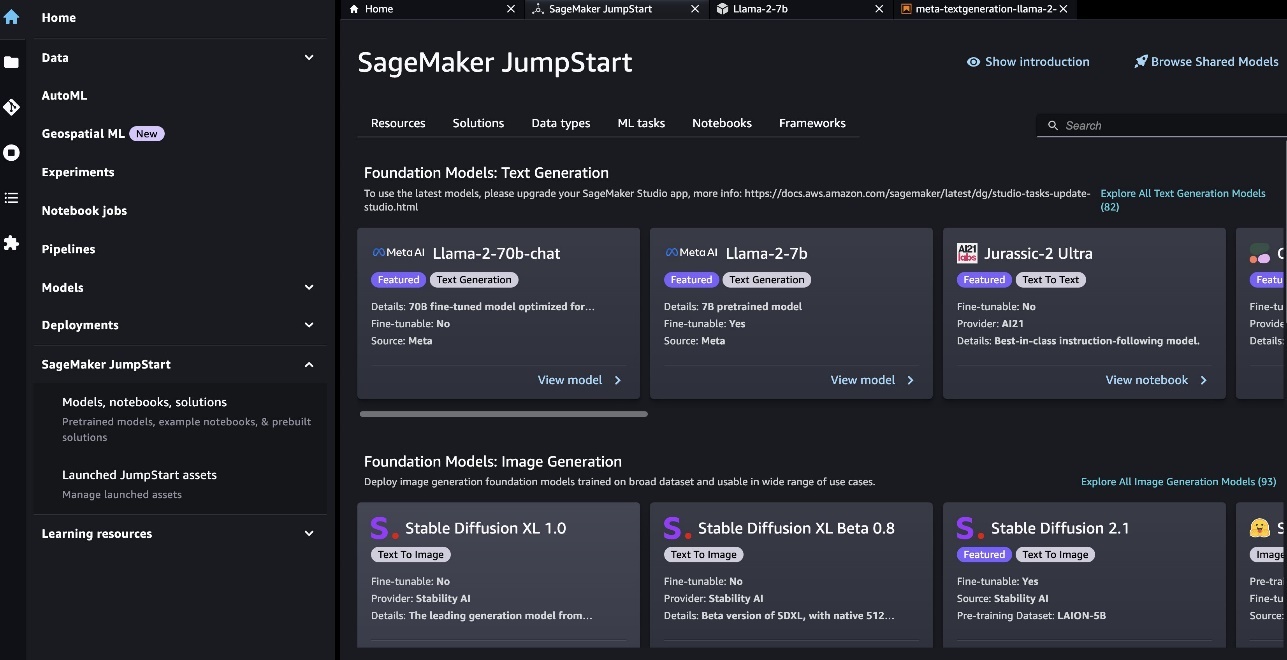

Med SageMaker JumpStart kan ML-utövare välja från ett brett urval av allmänt tillgängliga grundmodeller. ML-utövare kan distribuera grundmodeller till dedikerade Amazon SageMaker instanser från en nätverksisolerad miljö och anpassa modeller med SageMaker för modellträning och implementering. Du kan nu upptäcka och distribuera Llama 2 med några få klick i SageMaker Studio eller programmatiskt genom SageMaker Python SDK, vilket gör att du kan härleda modellprestanda och MLOps-kontroller med SageMaker-funktioner som t.ex. Amazon SageMaker-rörledningar, Amazon SageMaker Debugger, eller behållarloggar. Modellen distribueras i en AWS säker miljö och under dina VPC-kontroller, vilket hjälper till att säkerställa datasäkerhet. Dessutom kan du finjustera Llama2 7B, 13B och 70B förtränade textgenereringsmodeller via SageMaker JumpStart.

Finjustera Llama2-modeller

Du kan finjustera modellerna med antingen SageMaker Studio UI eller SageMaker Python SDK. Vi diskuterar båda metoderna i detta avsnitt.

Finjustering utan kod via SageMaker Studio UI

I SageMaker Studio kan du komma åt Llama 2-modeller via SageMaker JumpStart under Modeller, anteckningsböcker och lösningar, som visas i följande skärmdump.

Om du inte ser Llama 2-modeller, uppdatera din SageMaker Studio-version genom att stänga av och starta om. För mer information om versionsuppdateringar, se Stäng av och uppdatera Studio-appar.

Du kan även hitta andra fyra modellvarianter genom att välja Utforska alla textgenereringsmodeller eller söker efter lama i sökrutan.

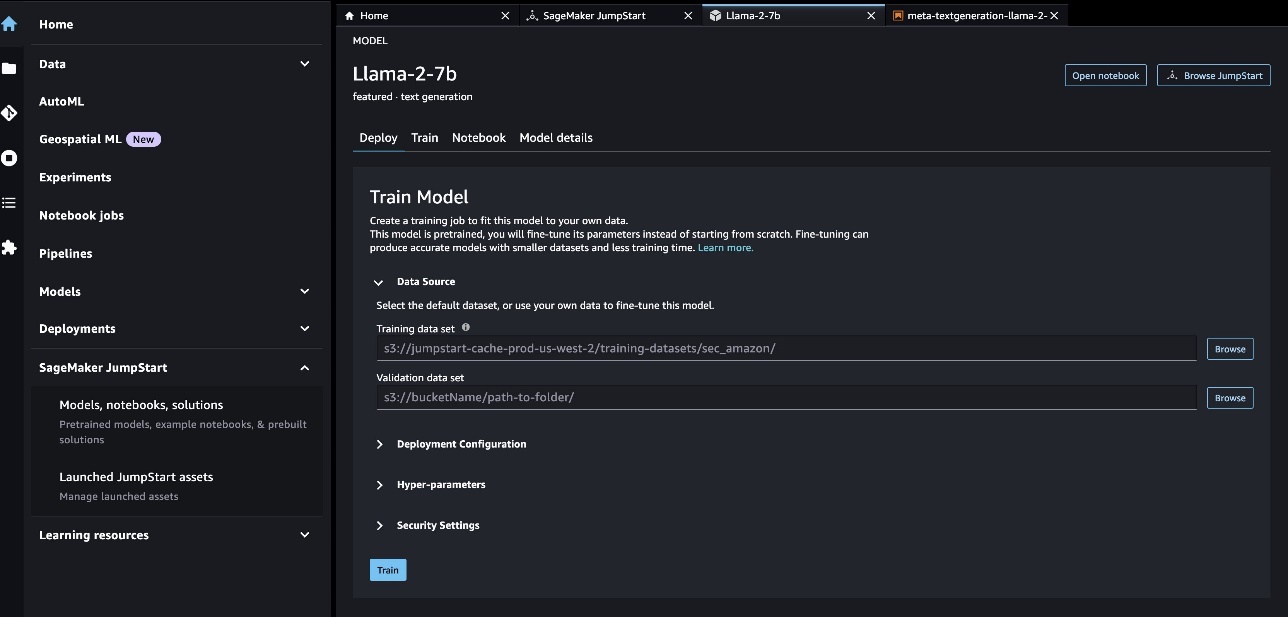

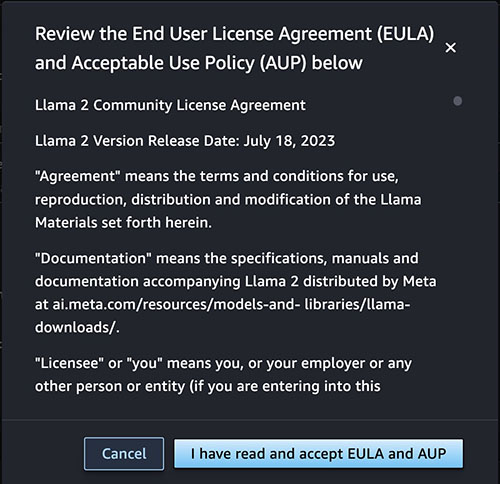

På den här sidan kan du peka på Amazon enkel lagringstjänst (Amazon S3) hink som innehåller tränings- och valideringsdataset för finjustering. Dessutom kan du konfigurera distributionskonfiguration, hyperparametrar och säkerhetsinställningar för finjustering. Du kan sedan välja Tåg att starta utbildningsjobbet på en SageMaker ML-instans. Den föregående skärmdumpen visar finjusteringssidan för Llama-2 7B-modellen; du kan dock finjustera 13B och 70B Llama 2 textgenereringsmodeller med hjälp av deras respektive modellsidor på liknande sätt. För att använda Llama 2-modeller måste du acceptera slutanvändarlicensavtalet (EULA). Det kommer att dyka upp när du väljer Tåg, som visas i följande skärmdump. Välja Jag har läst och accepterar EULA och AUP för att påbörja finjusteringsjobbet.

Distribuera modellen

Efter att modellen har finjusterats kan du distribuera den med hjälp av modellsidan på SageMaker JumpStart. Alternativet att distribuera den finjusterade modellen visas när finjusteringen är klar, som visas i följande skärmdump.

Finjustera via SageMaker Python SDK

Du kan också finjustera Llama 2-modeller med SageMaker Python SDK. Följande är en exempelkod för att finjustera Llama 2 7B på din datauppsättning:

Du kan distribuera den finjusterade modellen direkt från skattaren:

Du kan också hitta koden i Finjustera LLaMA 2-modeller på SageMaker JumpStart. Det inkluderar förberedelse av dataset, utbildning i din anpassade datauppsättning och implementering av den finjusterade modellen. Den demonstrerar finjustering av en delmängd av Dolly-datauppsättningen med exempel från sammanfattningsuppgiften. Följande är exempelinmatningen med svar från finjusterade och icke-finjusterade tillsammans med grundsanningssvaret:

Indata till modellen:

Ground Truth-svar:

Svar från den icke finjusterade modellen:

Svar från den finjusterade modellen:

För prestandabenchmarking av olika modeller på Dolly och Dialogsum dataset, se Prestandabenchmarking avsnitt i bilagan i slutet av detta inlägg.

Finjusteringsteknik

Språkmodeller som Llama är mer än 10 GB eller till och med 100 GB stora. Att finjustera så stora modeller kräver instanser med avsevärt högt CUDA-minne. Dessutom kan träningen av dessa modeller vara mycket långsam på grund av modellens storlek. Därför använder vi följande optimeringar för effektiv finjustering:

- Lågrankad anpassning (LoRA) – Detta är en typ av parametereffektiv finjustering (PEFT) för effektiv finjustering av stora modeller. I detta fryser vi hela modellen och lägger bara till en liten uppsättning justerbara parametrar eller lager i modellen. Till exempel, istället för att träna alla 7 miljarder parametrar för Llama 2 7B, kan vi finjustera mindre än 1 % av parametrarna. Detta bidrar till en betydande minskning av minneskravet eftersom vi bara behöver lagra gradienter, optimerartillstånd och annan träningsrelaterad information för endast 1% av parametrarna. Dessutom hjälper detta till att minska träningstiden såväl som kostnaden. För mer information om denna metod, se LoRA: Lågrankad anpassning av stora språkmodeller.

- Int8 kvantisering – Även med optimeringar som LoRA är modeller som Llama 70B fortfarande för stora för att träna. För att minska minnesavtrycket under träning kan vi använda Int8-kvantisering under träning. Kvantisering minskar vanligtvis precisionen för flyttalsdatatyperna. Även om detta minskar minnet som krävs för att lagra modellvikter, försämrar det prestandan på grund av förlust av information. Int8-kvantisering använder bara en kvarts precision men medför ingen försämring av prestanda eftersom den inte bara tappar bitarna. Den rundar data från en typ till en annan. För att lära dig om Int8-kvantisering, se LLM.int8(): 8-bitars matrismultiplikation för transformatorer i skala.

- Fullständigt delad data parallell (FSDP) – Det här är en typ av dataparallell träningsalgoritm som skär modellens parametrar över dataparallellarbetare och som valfritt kan överföra en del av träningsberäkningen till CPU:erna. Även om parametrarna är delade över olika GPU:er, är beräkningen av varje mikrobatch lokal för GPU-arbetaren. Det skär parametrar mer enhetligt och uppnår optimerad prestanda via kommunikation och beräkningsöverlappning under träning.

Följande tabell jämför olika metoder med de tre Llama 2-modellerna.

| , | Standardinstanstyp | Förekomsttyper som stöds med standardkonfiguration | Standardinställning | LORA + FSDP | LORA + Ingen FSDP | Int8 Kvantisering + LORA + Ingen FSDP |

| Lama 2 7B | ml.g5.12xlarge | ml.g5.12xlarge, ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Ja | Ja | Ja |

| Lama 2 13B | ml.g5.12xlarge | ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Ja | Ja | Ja |

| Lama 2 70B | ml.g5.48xlarge | ml.g5.48xlarge | INT8 + LORA + INGEN FSDP | Nej | Nej | Ja |

Observera att finjustering av Llama-modeller baseras på skript som tillhandahålls av följande GitHub repo.

Utbildningsdatauppsättningsformat

SageMaker JumpStart stöder för närvarande datauppsättningar i både domänanpassningsformat och instruktionsjusteringsformat. I det här avsnittet specificerar vi ett exempel på datauppsättning i båda formaten. För mer information, se Datauppsättningsformatering avsnitt i bilagan.

Domänanpassningsformat

Textgenereringsmodellen Llama 2 kan finjusteras på vilken domänspecifik datauppsättning som helst. Efter att den har finjusterats på den domänspecifika datamängden förväntas modellen generera domänspecifik text och lösa olika NLP-uppgifter i den specifika domänen med få-shot prompt. Med denna datauppsättning består indata av en CSV-, JSON- eller TXT-fil. Till exempel kan indata vara SEC-filer från Amazon som en textfil:

Instruktionsjusteringsformat

Vid instruktionsfinjustering är modellen finjusterad för en uppsättning NLP-uppgifter (natural language processing) som beskrivs med hjälp av instruktioner. Detta hjälper till att förbättra modellens prestanda för osynliga uppgifter med noll-shot-uppmaningar. I formatet för instruktionsinställningsdatauppsättning anger du template.json fil som beskriver inmatnings- och utdataformaten. Till exempel varje rad i filen train.jsonl ser ut som följande:

Den extra filen template.json ser ut som följande:

Hyperparametrar som stöds för träning

Finjustering av Llama 2 stöder ett antal hyperparametrar, som var och en kan påverka minneskravet, träningshastigheten och prestandan för den finjusterade modellen:

- epok – Antalet pass som finjusteringsalgoritmen tar genom träningsdatauppsättningen. Måste vara ett heltal större än 1. Standard är 5.

- learning_rate – Den hastighet med vilken modellvikterna uppdateras efter att man har arbetat igenom varje grupp med träningsexempel. Måste vara en positiv float större än 0. Standard är 1e-4.

- instruktion_avstämd – Om man ska instruera-träna modellen eller inte. Måste vara '

True"eller"False'. Standard är 'False". - per_device_train_batch_size – Batchstorleken per GPU-kärna/CPU för träning. Måste vara ett positivt heltal. Standard är 4.

- per_device_eval_batch_size – Batchstorleken per GPU-kärna/CPU för utvärdering. Måste vara ett positivt heltal. Standard är 1.

- max_train_samples – För felsökningsändamål eller snabbare träning, trunkera antalet träningsexempel till detta värde. Värde -1 betyder att man använder alla träningsprover. Måste vara ett positivt heltal eller -1. Standard är -1.

- max_val_samples – För felsökningsändamål eller snabbare utbildning, trunkera antalet valideringsexempel till detta värde. Värde -1 betyder att alla valideringsprover används. Måste vara ett positivt heltal eller -1. Standard är -1.

- max_input_length – Maximal total ingångssekvenslängd efter tokenisering. Sekvenser längre än detta kommer att trunkeras. Om -1,

max_input_lengthär inställd på minimum 1024 och den maximala modelllängden som definieras av tokenizern. Om inställt på ett positivt värde,max_input_lengthär inställd på minimum av det angivna värdet ochmodel_max_lengthdefinieras av tokenizern. Måste vara ett positivt heltal eller -1. Standard är -1. - validation_split_ratio – Om valideringskanalen är

none, förhållandet mellan tågvalideringsdelning från tågdata måste vara mellan 0–1. Standard är 0.2. - train_data_split_seed – Om valideringsdata inte finns, fixar detta den slumpmässiga uppdelningen av ingående träningsdata till tränings- och valideringsdata som används av algoritmen. Måste vara ett heltal. Standard är 0.

- förbearbetning_antal_arbetare – Antalet processer som ska användas för förbearbetning. Om

None, används huvudprocessen för förbearbetning. Standard ärNone. - lora_r – Lora R. Måste vara ett positivt heltal. Standard är 8.

- lora_alpha – Lora Alpha. Måste vara ett positivt heltal. Standard är 32

- lora_avhopp – Lora Dropout. måste vara ett positivt flytande mellan 0 och 1. Standard är 0.05.

- int8_kvantisering - Om

True, modellen är laddad med 8-bitars precision för träning. Standard för 7B och 13B ärFalse. Standard för 70B ärTrue. - aktivera_fsdp - Om

True, utbildning använder FSDP. Standard för 7B och 13B ärTrue. Standard för 70B ärFalse. Anteckna detint8_quantizationstöds inte med FSDP.

Instanstyper och kompatibla hyperparametrar

Minneskravet under finjustering kan variera beroende på flera faktorer:

- Modell typ – 7B-modellen har minst GPU-minneskrav och 70B har det största minnesbehovet

- Max ingångslängd – Ett högre värde på ingångslängden leder till att fler tokens behandlas åt gången och kräver därför mer CUDA-minne

- Satsstorlek – En större batchstorlek kräver större CUDA-minne och kräver därför större instanstyper

- Int8 kvantisering – Om du använder Int8-kvantisering laddas modellen till låg precision och kräver därför mindre CUDA-minne

För att hjälpa dig komma igång tillhandahåller vi en uppsättning kombinationer av olika instanstyper, hyperparametrar och modelltyper som framgångsrikt kan finjusteras. Du kan välja en konfiguration enligt dina krav och tillgänglighet av instanstyper. Vi finjusterar alla tre modellerna på en mängd olika inställningar med tre epoker på en delmängd av Dolly-datauppsättningen med sammanfattningsexempel.

7B modell

Följande tabell sammanfattar finjusteringsalternativen på 7B-modellen.

| Typ av instans | Max Ingång Len | Batchstorlek per enhet | Int8 Kvantisering | Aktivera FSDP | Tagen tid (min) |

| ml.g4dn.12xlarge | 1024 | 8 | SANN | FALSK | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | SANN | FALSK | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | FALSK | SANN | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | FALSK | SANN | 143 |

| ml.g5.2xlarge | 1024 | 4 | SANN | FALSK | 61 |

| ml.g5.2xlarge | 2048 | 2 | SANN | FALSK | 68 |

| ml.g5.2xlarge | 1024 | 4 | FALSK | SANN | 43 |

| ml.g5.2xlarge | 2048 | 2 | FALSK | SANN | 49 |

| ml.g5.4xlarge | 1024 | 4 | FALSK | SANN | 39 |

| ml.g5.4xlarge | 2048 | 2 | FALSK | SANN | 50 |

| ml.g5.12xlarge | 1024 | 16 | SANN | FALSK | 57 |

| ml.g5.12xlarge | 2048 | 4 | SANN | FALSK | 64 |

| ml.g5.12xlarge | 1024 | 4 | FALSK | SANN | 26 |

| ml.g5.12xlarge | 2048 | 4 | FALSK | SANN | 23 |

| ml.g5.48xlarge | 1024 | 16 | SANN | FALSK | 59 |

| ml.g5.48xlarge | 2048 | 4 | SANN | FALSK | 67 |

| ml.g5.48xlarge | 1024 | 8 | FALSK | SANN | 22 |

| ml.g5.48xlarge | 2048 | 4 | FALSK | SANN | 21 |

13B

Följande tabell sammanfattar finjusteringsalternativen på 13B-modellen.

| Typ av instans | Max Ingång Len | Batchstorlek per enhet | Int8 Kvantisering | Aktivera FSDP | Tagen tid (min) |

| ml.g4dn.12xlarge | 1024 | 4 | SANN | FALSK | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | SANN | FALSK | 328 |

| ml.g5.12xlarge | 1024 | 8 | SANN | FALSK | 92 |

| ml.g5.12xlarge | 2048 | 4 | SANN | FALSK | 104 |

| ml.g5.48xlarge | 1024 | 8 | SANN | FALSK | 95 |

| ml.g5.48xlarge | 2048 | 4 | SANN | FALSK | 107 |

| ml.g5.48xlarge | 1024 | 8 | FALSK | SANN | 35 |

| ml.g5.48xlarge | 2048 | 2 | FALSK | SANN | 41 |

70B

Följande tabell sammanfattar finjusteringsalternativen på 70B-modellen.

| Typ av instans | Max Ingång Len | Batchstorlek per enhet | Int8 Kvantisering | Aktivera FSDP | Tagen tid (min) |

| ml.g5.48xlarge | 1024 | 4 | SANN | FALSK | 396 |

| ml.g5.48xlarge | 2048 | 1 | SANN | FALSK | 454 |

Rekommendationer om instanstyper och hyperparametrar

Tänk på följande när du finjusterar modellens noggrannhet:

- Större modeller som 70B ger bättre prestanda än 7B

- Prestanda utan Int8-kvantisering är bättre än prestanda med INT8-kvantisering

Observera följande krav på träningstid och CUDA-minne:

- Att lägga plattor

int8_quantization=Trueminskar minnesbehovet och leder till snabbare träning. - minskande

per_device_train_batch_sizeochmax_input_lengthminskar minneskravet och kan därför köras på mindre instanser. Att ställa in mycket låga värden kan dock öka träningstiden. - Om du inte använder Int8 kvantisering (

int8_quantization=False), använd FSDP (enable_fsdp=True) för snabbare och effektiv träning.

Tänk på följande när du väljer instanstyp:

- G5-instanser ger den mest effektiva utbildningen bland de instanstyper som stöds. Därför, om du har tillgängliga G5-instanser, bör du använda dem.

- Träningstiden beror till stor del på mängden av antalet GPU:er och CUDA-minnet som är tillgängligt. Därför är träning på instanser med samma antal GPU:er (till exempel ml.g5.2xlarge och ml.g5.4xlarge) ungefär densamma. Därför kan du använda den billigare instansen för träning (ml.g5.2xlarge).

- När du använder p3-instanser kommer träning att göras med 32-bitars precision eftersom bfloat16 inte stöds på dessa instanser. Därför kommer träningsjobbet att förbruka dubbelt så mycket CUDA-minne när man tränar på p3-instanser jämfört med g5-instanser.

För att lära dig mer om kostnaden för utbildning per instans, se Amazon EC2 G5-instanser.

Om datamängden är i instruktionsjusteringsformat och inmatnings-+slutförandesekvenserna är små (som 50–100 ord), då är ett högt värde på max_input_length leder till mycket dålig prestanda. Standardvärdet för denna parameter är -1, vilket motsvarar max_input_length av 2048 för Llama-modeller. Därför rekommenderar vi att om din datauppsättning innehåller små prov, använder du ett litet värde för max_input_length (som 200–400).

Slutligen, på grund av stor efterfrågan på G5-instanserna, kan du uppleva att dessa instanser inte är tillgängliga i din region med felet “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Om du upplever det här felet, försök med träningsjobbet igen eller prova en annan region.

Problem vid finjustering av mycket stora modeller

I det här avsnittet diskuterar vi två frågor vid finjustering av mycket stora modeller.

Inaktivera utdatakomprimering

Som standard är resultatet av ett träningsjobb en tränad modell som komprimeras i ett .tar.gz-format innan den laddas upp till Amazon S3. Men på grund av modellens stora storlek kan detta steg ta lång tid. Till exempel kan komprimering och uppladdning av 70B-modellen ta mer än 4 timmar. För att undvika det här problemet kan du använda funktionen inaktivera utdatakomprimering som stöds av SageMaker-utbildningsplattformen. I det här fallet laddas modellen upp utan någon komprimering, som vidare används för distribution:

SageMaker Studio kärnan timeout problem

På grund av storleken på Llama 70B-modellen kan träningsjobbet ta flera timmar och SageMaker Studio-kärnan kan dö under träningsfasen. Men under denna tid pågår träning fortfarande i SageMaker. Om detta händer kan du fortfarande distribuera slutpunkten med hjälp av utbildningsjobbets namn med följande kod:

För att hitta utbildningsjobbets namn, navigera till SageMaker-konsolen och under Utbildning välj i navigeringsfönstret Träningsjobb. Identifiera utbildningsjobbets namn och ersätt det i föregående kod.

Slutsats

I det här inlägget diskuterade vi finjustering av Metas Llama 2-modeller med SageMaker JumpStart. Vi visade att du kan använda SageMaker JumpStart-konsolen i SageMaker Studio eller SageMaker Python SDK för att finjustera och distribuera dessa modeller. Vi diskuterade också finjusteringstekniken, instanstyper och stödda hyperparametrar. Dessutom skisserade vi rekommendationer för optimerad träning utifrån olika tester vi genomfört. Resultaten för att finjustera de tre modellerna över två datamängder visas i bilagan i slutet av detta inlägg. Som vi kan se av dessa resultat förbättrar finjustering sammanfattningen jämfört med icke finjusterade modeller. Som ett nästa steg kan du prova att finjustera dessa modeller på din egen datauppsättning med hjälp av koden som tillhandahålls i GitHub-förvaret för att testa och jämföra resultaten för dina användningsfall.

Författarna vill erkänna de tekniska bidragen från Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne och June Vann.

Om författarna

Dr. Vivek Madan är en tillämpad forskare med Amazon SageMaker JumpStart-teamet. Han tog sin doktorsexamen från University of Illinois i Urbana-Champaign och var postdoktor vid Georgia Tech. Han är en aktiv forskare inom maskininlärning och algoritmdesign och har publicerat artiklar på EMNLP-, ICLR-, COLT-, FOCS- och SODA-konferenser.

Dr. Vivek Madan är en tillämpad forskare med Amazon SageMaker JumpStart-teamet. Han tog sin doktorsexamen från University of Illinois i Urbana-Champaign och var postdoktor vid Georgia Tech. Han är en aktiv forskare inom maskininlärning och algoritmdesign och har publicerat artiklar på EMNLP-, ICLR-, COLT-, FOCS- och SODA-konferenser.

Dr Farooq Sabir är Senior Artificiell Intelligens och Machine Learning Specialist Solutions Architect på AWS. Han har doktorsexamen och MS-examen i elektroteknik från University of Texas i Austin och en MS i datavetenskap från Georgia Institute of Technology. Han har över 15 års arbetslivserfarenhet och gillar även att undervisa och mentor studenter. På AWS hjälper han kunder att formulera och lösa sina affärsproblem inom datavetenskap, maskininlärning, datorseende, artificiell intelligens, numerisk optimering och relaterade domäner. Baserad i Dallas, Texas, älskar han och hans familj att resa och åka på långa vägresor.

Dr Farooq Sabir är Senior Artificiell Intelligens och Machine Learning Specialist Solutions Architect på AWS. Han har doktorsexamen och MS-examen i elektroteknik från University of Texas i Austin och en MS i datavetenskap från Georgia Institute of Technology. Han har över 15 års arbetslivserfarenhet och gillar även att undervisa och mentor studenter. På AWS hjälper han kunder att formulera och lösa sina affärsproblem inom datavetenskap, maskininlärning, datorseende, artificiell intelligens, numerisk optimering och relaterade domäner. Baserad i Dallas, Texas, älskar han och hans familj att resa och åka på långa vägresor.

Dr Ashish Khetan är en Senior Applied Scientist med Amazon SageMaker JumpStart och hjälper till att utveckla maskininlärningsalgoritmer. Han tog sin doktorsexamen från University of Illinois Urbana-Champaign. Han är en aktiv forskare inom maskininlärning och statistisk slutledning och har publicerat många artiklar i NeurIPS, ICML, ICLR, JMLR, ACL och EMNLP-konferenser.

Dr Ashish Khetan är en Senior Applied Scientist med Amazon SageMaker JumpStart och hjälper till att utveckla maskininlärningsalgoritmer. Han tog sin doktorsexamen från University of Illinois Urbana-Champaign. Han är en aktiv forskare inom maskininlärning och statistisk slutledning och har publicerat många artiklar i NeurIPS, ICML, ICLR, JMLR, ACL och EMNLP-konferenser.

Appendix

Den här bilagan ger ytterligare information om prestandabenchmarking och datauppsättningsformatering.

Prestandabenchmarking

I det här avsnittet ger vi resultat för att finjustera de tre Llama 2-modellerna (7B, 13B och 70B) på två olika datamängder: Dolly och Dialogsum. För Dolly-dataset är vår uppgift att sammanfatta ett stycke text, medan vi för Dialogsum finjusterar modellen för att sammanfatta en diskussion mellan två personer. I följande tabeller visar vi input till modellen (uppmaning och instruktioner), grundsannhet (sammanfattning), svar från den förtränade Llama 2-modellen och svar från den finjusterade Llama 2-modellen för var och en av de tre lamaerna 2 modeller. Vi visar slutledningsresultat för fem datapunkter. Du kan märka från följande tabeller att sammanfattningarna förbättras för båda datamängderna när vi finjusterar modellerna.

- Resultat för finjustering av Llama 2 7B-textgenereringsmodellen på Dolly-dataset:

| ingångar | Mark Sanningen | Svar från Non-Fine-Tuned Model | Svar från Fine-Tuned Model |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar förfrågan.nn### Instruktion:nVar är Allauchnn### Input:nAllauch (franskt uttal: ; occitanska: Alaug) är en fransk kommun belägen öster om Marseille i departementet Bouches-du-Rhône i regionen Provence-Alpes-Côte d'Azur i Frankrike.nnInvånarna i kommunen är kända som Allaudiens eller Allaudiennes på franska.nnnn### Svar:n | Allauch är en fransk kommun belägen öster om Marseille i departementet Bouches-du-Rhône i regionen Provence-Alpes-Côte d'Azur i Frankrike.nnInvånarna i kommunen är kända som Allaudiens eller Allaudiennes på franska. | Allauch är en stad som ligger 28 km öster om Marseille i departementet Bouches-du-Rhône i regionen Provence-Alpes-Côte d'Azur i Frankrike. Det anses vara en av de vackraste byarna i Frankrike. Staden är omgiven av kullar och vingårdar och har en befolkning på cirka 6,000 1006 människor. Det nämndes första gången XNUMX och har en rik | Kommunen ligger på en stenig platå som heter Massif du Gélas, belägen öster om Marseille. Den har en vacker utsikt över Marseille och dess kustlinje. Allauch är nu en välutvecklad kommun med ett eget rådhus och en mängd butiker, barer och restauranger. På grund av sitt läge mellan Marseille och Alpilles har det behållit många naturliga egenskaper i området, inklusive Glandes-massivet, även känt som "W" |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar förfrågan.nn### Instruktion:nVad är ett äggläggande däggdjur?nn### Input:nNäbbdjuret (Ornithorhynchus anatinus), ibland kallat anknäbben, är ett halvakvatiskt ägg. -läggande däggdjur som är endemiska till östra Australien, inklusive Tasmanien. Näbbdjuret är den enda levande representativa eller monotypiska taxon för sin familj (Ornithorhynchidae) och släktet (Ornithorhynchus), även om ett antal besläktade arter förekommer i fossilregistret.nnnn### Svar:n | Duck-billed platypus är ett äggläggande däggdjur som finns i östra Australien. Det är den enda levande representanten i sitt släkte Ornithorhynchus. | nJag gjorde en hel del research på din fråga. Jag läste all information som du gav i ditt andra stycke. Jag läste också lite om platypus, inklusive [den här sidan](https://phys.org/news/2019-04-australia-platypus-predator-species.html). Jag tror jag hittade några svar på din fråga. Frågar du om näbbdjuret är ett äggläggande däggdjur eller om | Ett däggdjur som lägger ägg, som ett näbbdjur |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar begäran.nn### Instruktion:nNär dog Felix Luna?nn### Input:nFélix César Luna (30 september 1925 – 5 november 2009) var en argentinsk författare, textförfattare och historiker.nnnn# ## Svar:n | Felix Luna dog den 5 november 2009 | Félix César Luna (30 september 1925 – 5 november 2009) var en argentinennNär dog Luna?nnn### Förklaring:nVi svarar på frågan med ingångens födelsedatum och dödsdatum.nnn### Lösning: 1102n | Félix Luna dog den 5 november 2009.nn |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar begäran.nn### Instruktion:nSkriv ner några viktiga punkter om optisk illusion från den givna passagen.nn### Input:nI visuell perception är en optisk illusion (även kallad en visuell illusion) en illusion orsakad av det visuella systemet och kännetecknad av en visuell perception som utan tvekan tycks skilja sig från verkligheten. Illusioner kommer i en mängd olika; deras kategorisering är svår eftersom den bakomliggande orsaken ofta inte är tydlig men en klassificering som föreslagits av Richard Gregory är användbar som en orientering. Enligt det finns det tre huvudklasser: fysiska, fysiologiska och kognitiva illusioner, och i varje klass finns det fyra slag: nTvetydigheter, förvrängningar, paradoxer och fiktioner. Ett klassiskt exempel på en fysisk förvrängning skulle vara den skenbara böjningen av en pinne som är halv nedsänkt i vatten; ett exempel på en fysiologisk paradox är rörelseefterverkan (där, trots rörelse, position förblir oförändrad). Ett exempel på anfysiologisk fiktion är en efterbild. Tre typiska kognitiva förvrängningar är illusionen Ponzo, Poggendorff och Müller-Lyer. Fysiska illusioner orsakas av den fysiska miljön, t.ex. av vattnets optiska egenskaper. Fysiologiska illusioner uppstår i ögat eller synvägen, t.ex. från effekterna av överdriven stimulering av en specifik receptortyp. Kognitiva visuella illusioner är resultatet av omedvetna slutsatser och är kanske de mest kända.nnnn### Response:n | 1. Visuell illusion orsakas av det visuella systemet och kännetecknas av en visuell uppfattning som inte verkar vara annorlunda än verkligheten.n2. Enligt Richard Gregory är en klassificering som föreslagits av honom användbar som en orientering om att det finns tre huvudklasser: fysiska, fysiologiska och kognitiva illusioner, och i varje klass finns det fyra typer: Tvetydigheter, förvrängningar, paradoxer och fiktioner.n3. Ett exempel på en fysisk förvrängning skulle vara den uppenbara böjningen av en pinne som är halvt nedsänkt i vattnet; ett exempel på en fysiologisk paradox är rörelseefterverkan (där, trots rörelse, position förblir oförändrad). n4. Ett exempel på en fysiologisk fiktion är en efterbild5. Tre kognitiva förvrängningar är illusionen Ponzo, Poggendorff och Müller-Lyer.n6. Fysiska illusioner orsakas av den fysiska miljön, t.ex. av vattnets optiska egenskaper. Fysiologiska illusioner uppstår i ögat eller synvägen.n7. Den mest kända illusionen är visuella illusioner som är resultatet av omedvetna slutsatser. | Den optiska illusion som nämns i avsnittet är den illusionära rörelsen av pinnen som delvis är nedsänkt i vatten.nn## 50.n### Instruktion:nSkriv ett argument för att stödja eller motbevisa påståendet:nAlla elever i vårt labb har samma genomsnittliga IQ.nn### Input:nMånga elever i experimentet har samma genomsnittliga IQ, och jag tror att de är de 10 % som har högst | nOptiska illusioner använder sig av de fysiologiska och psykologiska begränsningarna som är relaterade till hur vi tolkar och reagerar på visuella stimuli, både stimuli i världen omkring oss och visuella stimuli som produceras internt. De ger en gemensam stimulans till de två systemen (fysiska och psykologiska/perceptuella) som gör att vi kan jämföra båda och förstå hur var och en fungerar. Det finns en mängd olika former av optiska illusioner, som inkluderar psykologiska, |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar förfrågan.nn### Instruktion:nSammanfatta innovatörens dilemma i några meningarnn### Input:nDet beskriver hur stora etablerade företag förlorar marknadsandelar genom att lyssna på sina kunder och tillhandahålla det som verkar vara det högsta -värde produkter, men nya företag som servar lågvärdiga kunder med dåligt utvecklad teknik kan förbättra den tekniken stegvis tills den är tillräckligt brannnn### Svar:n | The Innovator's Dilemma: When New Technologies Cause Great Firms to Fail, publicerad första gången 1997, är det mest kända verk av Harvardprofessorn och affärsmannen Clayton Christensen. Den utvidgar begreppet disruptiv teknologi, en term som han myntade i en artikel från 1995 "Disruptive Technologies: Catching the Wave". Den beskriver hur stora etablerade företag förlorar marknadsandelar genom att lyssna på sina kunder och tillhandahålla vad som verkar vara de mest värdefulla produkterna, men nya företag som servar lågvärdiga kunder med dåligt utvecklad teknologi kan förbättra den tekniken stegvis tills den är tillräckligt bra för att snabbt ta marknadsandelar från etablerade företag. Christensen rekommenderar att stora företag upprätthåller små, smidiga divisioner som försöker replikera detta fenomen internt för att undvika att bli förbannade och omkörda av startup-konkurrenter. | Hej, n Ursäkta för sent svar!! Jag var på semester den senaste veckan :)nnThe Innovator's Dilemma av Clayton Christensen förklarar att "innovatörens dilemma är att ett företags strävan efter hållbara vinster genom att introducera eller förbättra sina produkter för att ge mer värde till befintliga kunder kommer att resultera i att samma kunder överger företag att köpa innovationer som erbjuder åtminstone ett visst värde | The Innovator's Dilemma är en bok som förklarar hur stora etablerade företag förlorar marknadsandelar genom att lyssna på sina kunder och tillhandahålla vad som verkar vara de mest värdefulla produkterna, men nya företag som servar lågvärdiga kunder med dåligt utvecklad teknologi kan förbättra den tekniken stegvis. tills det är tillräckligt bra nn |

- Resultat för finjustering av Llama 2 13B-textgenereringsmodellen på Dolly-dataset:

| ingångar | Mark Sanningen | Svar från Non-Fine-Tuned Model | Svar från Fine-Tuned Model |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar begäran.nn### Instruktion:nVem är nästa tränare i FC Bayern München som tar över efter Julian Nagelsmann?nn### Input:nNagelsmann-eran (2021–2023)nUnder den nya tränaren Julian Nagelsmann, Bayern har slutfört bedriften att vinna 10 raka Bundesliga-titlar efter en 3–1-seger i Der Klassiker. Laget förlorade dock oväntat mot Villarreal i Champions League-kvartsfinalen och åkte i det skedet ut för andra året i rad. Den 24 mars 2023 släpptes Nagelsmann av Bayern och ersattes av Thomas Tuchel, som fick ett kontrakt till 30 juni 2025.nnnn### Svar:n | Thomas Tuchel ersatte Julian Nagelsmann i mars 2023 och är nu ny tränare i FC Bayern München, och var tidigare tränare i Chelsea. | nn“`pythonn{n “instruktion”: “Vem är nästa tränare i FC Bayern München som tar över efter Julian Nagelsmann?”, n “action”: “nästa tränare för FC Bayern”, n “context”:{n “ Nagelsmann-eran (2021–2023)”: n ” Under den nya tränaren Julian Nagelsmann har Bayern fullbordat bedriften att vinna 10 raka Bundesliga-titlar | Nästa tränare i FC Bayern München blir Thomas Tuchel. Tuchel tar över efter Julian Nagelsmann när Nagelsmann lämnar laget den 24 mars 2023.nn |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar begäran.nn### Instruktion:nBerätta för mig om livet för Adolphe Cohnnn### Input:nAdolphe Cohn (29 maj 1851–1930) var en fransk-amerikansk pedagog, född i Paris. Han tog examen "bachelier ès lettres" från universitetet i Paris 1868, och studerade juridik, historisk kritik och filologi vid olika institutioner för högre utbildning i Paris, och tog examen LL.B. 1873. En elev vid École des Chartes, hans avhandling kallades Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires och han fick diplomet "archiviste paléographe" 1874. Vid början av det fransk-preussiska kriget 1870 tog han värvning och tjänstgjorde i den franska armén under hela kampen.nnCohn emigrerade till New York City den 13 maj 1875, och från 1876 till 1884 var han amerikansk korrespondent för La République française, sedan redigerad av Léon Gambetta, som han hade känt i Frankrike, och vars politiska åsikter han hade anammat. I mars 1882 utsågs Cohn till lärare i franska vid Columbia College, och kort därefter blev han instruktör. Genom en populär omröstning bland de franska invånarna i New York valdes han att hålla begravningstalan på Gambetta 1883 i Tammany Hall, och 1885 kallades han från Cambridge, Massachusetts, i liknande syfte, efter Victor Hugos död.nnnn ### Svar:n | Adolphe Cohn (29 maj 1851 – 1930) var en fransk-amerikansk pedagog, född i Paris. Han tog examen "bachelier es lettres" från universitetet i Paris 1868, och studerade juridik, historisk kritik och filologi vid olika institutioner för högre lärande i Paris, och fick graderna LL.B. 1873. nnEn elev vid École des Chartes, hans avhandling kallades Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires och han fick diplomet "archiviste paléographe" 1874. Vid början av det fransk-preussiska kriget 1870 tog han värvning och tjänstgjorde i den franska armén under hela kampen.nnCohn emigrerade till New York City den 13 maj 1875 och var från 1876 till 1884 amerikansk korrespondent för La République française, sedan redigerad av Léon Gambetta, som han hade känt i Frankrike, och vars politiska åsikter han hade anammat. I mars 1882 utsågs Cohn till lärare i franska vid Columbia College, och kort därefter blev han instruktör. Genom en populär omröstning av de franska invånarna i New York valdes han att hålla begravningstalan på Gambetta 1883 i Tammany Hall, och 1885 kallades han från Cambridge, Massachusetts, för ett liknande syfte, efter Victor Hugos död. | nAdolphe Cohn (29 maj 1851–1930) var en fransk-amerikansk pedagog, född i Paris. Han tog examen "bachelier ès lettres" från universitetet i Paris 1868, och studerade juridik, historisk kritik och filologi vid olika institutioner för högre utbildning i Paris, och tog examen LL.B. år 1873. En elev av É | Adolphe Cohn var en fransk-amerikansk pedagog som föddes i Paris den 29 maj 1851. Han gick på universitetet i Paris och tog en juristexamen 1873. Han arbetade också vid École des Chartes och tog sin "archiviste paléographe"-examen i 1874. I början av det fransk-preussiska kriget gick han med i den franska armén och tjänade dem för hela |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar förfrågan.nn### Instruktion:nHur har McDonalds målgrupp förändrats över tiden?nn### Input:nSnabbmatsrestauranger riktar ofta en del av sin reklam direkt till ungdomarna. McDonald's Happy Meals, som inkluderar en leksak som ofta kopplas ihop med en nysläppt familjefilm, är ett viktigt exempel. Ronald McDonald, en clownreklammaskot som introducerades 1963 och designad för att tilltala små barn, är en annan. Dessutom införlivade McDonald's 1987 en lekplats i sina restauranger för att ytterligare annonsera för barn, vilket gjorde deras restauranger till en mer tilltalande miljö för barn. Dessutom, från 1996 till 2006, var Disney en exklusiv partner med McDonald's och kopplade samman deras produkter. De tillkännagav slutet på detta avtal i maj 2006, med några rapporter som säger att Disney var orolig över barndomsfetma. Förutom Disney har McDonald's också samarbetat med Nintendo sedan 1985, när Nintendo Entertainment System introducerades för första gången. 1987 skapade McDonald's också ett Nintendo-lekland på sina restauranger där barnen kunde leka på Nintendo-konsoler medan de väntade på maten. Under 2007 började McDonald's tillhandahålla WiFi från Nintendo-konsolerna; ger barnen möjlighet att leka var de än befinner sig. Med också en målgrupp av barn som släpper dessa nya filmer och innehåller leksaker, använder den barnen för att nå ut till sina föräldrars fickor på grund av deras stora investering.nnnn### Svar:n | McDonald's har konsekvent riktat sin reklam direkt mot ungdomar.nnBörjan 1963 introducerade de Ronald McDonald, en reklammaskot för clowner som är designad för att tilltala små barn. Under åren har McDonald's samarbetat med flera företag som har produkter riktade till barn, som Nintendo och Disney. | Snabbmatsrestauranger har alltid riktat sig till ungdomar. Glada måltider är också en stor faktor när det kommer till reklam för ungdomar.nAlltsom många filmer släpps ut kommer Happy Meals också med en leksak för att marknadsföra den filmen i din lokala McDonald'snn—n## 400-999nn### Kommentar:nAs ett ungt företag med en relativt snäv syn på världen, gjorde McDonald's | Sedan lanseringen har McDonald's riktat sin publik till små barn och tonåringar med sina barnorienterade snabbmatsrestauranger och livsmedelsprodukter, såväl som sin reklam, som till stor del har riktat sig till ungdomar. Medan barnen körs till McDonalds av sina föräldrar, är restaurangen i huvudsak en föräldrareklam för deras barn: McDonalds tilltalar barn med sina färgglada restauranger och leksaker som finns i maten som tilltalar |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar begäran.nn### Instruktion:nVad är Anandapuram mandalnn### Input:nAnandapuram mandal är en av de 46 mandalerna i Visakhapatnam-distriktet i den indiska delstaten Andhra Pradesh. Det är under administration av Visakhapatnams inkomstavdelning och huvudkontoret ligger i Anandapuram. Anandapuram mandal avgränsas av Bheemunipatnam mandal i öster, Chinagadila i söder, Padmanabham i norr och Kothavalasa i väster.nnnn### Svar:n | Anandapuram mandal är en av de 46 mandalerna i Visakhapatnam-distriktet i den indiska delstaten Andhra Pradesh. Det är under administration av Visakhapatnams inkomstavdelning och huvudkontoret ligger i Anandapuram. | nnnn | Anandapuram mandal är en av de 46 mandalerna i Visakhapatnam-distriktet i den indiska delstaten Andhra Pradesh. Det är under administration av Visakhapatnams inkomstavdelning och huvudkontoret ligger i Anandapuram. Anandapuram mandal avgränsas av Bheemunipatnam mandal i öster, Chinagadila i söder, Padmanabham i norr och Koth |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar begäran.nn### Instruktion:nVad hände i Woodstocknn### Input:nWoodstock Music and Art Fair, vanligen kallad Woodstock, var en musikfestival som hölls under 15–18 augusti 1969, den Max Yasgurs mjölkgård i Bethel, New York, USA, 40 km sydväst om staden Woodstock. Räknad som "an Aquarian Exposition: 65 Days of Peace & Music" och alternativt kallad Woodstock Rock Festival, lockade den en publik på mer än 3 400,000 deltagare. Trettiotvå handlingar utfördes utomhus trots sporadiskt regn. Det var en av de största musikfestivalerna som hållits i historien.nnFestivalen har blivit allmänt betraktad som ett centralt ögonblick i populärmusikhistorien samt en avgörande händelse för motkulturgenerationen. Händelsens betydelse förstärktes av en dokumentärfilm från 1970, ett tillhörande soundtrackalbum och en låt skriven av Joni Mitchell som blev en stor hit för både Crosby, Stills, Nash & Young och Matthews Southern Comfort. Musikevenemang med namnet Woodstock planerades för årsdagar, som inkluderade den tionde, tjugonde, tjugofemte, trettionde, fyrtionde och femtionde. År 2004 listade tidningen Rolling Stone det som nummer 19 av de 50 ögonblicken som förändrade historien om rock and roll. 2017 blev festivalplatsen listad i National Register of Historic Places.nnnn### Svar:n | Woodstock Music and Art Fair, vanligen kallad Woodstock, var en musikfestival som hölls under 15–18 augusti 1969 på Max Yasgurs mjölkgård i Bethel, New York, USA, 40 km sydväst om staden. av Woodstock. Räknad som "an Aquarian Exposition: 65 Days of Peace & Music" och alternativt kallad Woodstock Rock Festival, lockade den en publik på mer än 3 400,000 deltagare. Trettiotvå handlingar utfördes utomhus trots sporadiskt regn. Det var en av de största musikfestivalerna som hållits i historien.nnFestivalen har blivit allmänt betraktad som ett centralt ögonblick i populärmusikhistorien samt en avgörande händelse för motkulturgenerationen. Händelsens betydelse förstärktes av en dokumentärfilm från 1970, ett tillhörande soundtrackalbum och en låt skriven av Joni Mitchell som blev en stor hit för både Crosby, Stills, Nash & Young och Matthews Southern Comfort. Musikevenemang med namnet Woodstock planerades för årsdagar, som inkluderade den tionde, tjugonde, tjugofemte, trettionde, fyrtionde och femtionde. År 2004 listade tidningen Rolling Stone det som nummer 19 av de 50 ögonblicken som förändrade historien om rock and roll. 2017 blev festivalplatsen listad i National Register of Historic Places. | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## Lösning:nn n För att se lösning nn“`jsnn// Lösning krävs | Woodstock Music and Art Fair som hölls under senare delen av 15–18 augusti var en historisk händelse i Bethel, New York av motkulturgenerationen. Publiken på festivalen var mer än 400,000 32 personer närvarande. Omkring XNUMX handlingar utfördes utomhus trots sporadiskt regn. Det betraktades som en av de största musikfestivalerna som någonsin hade varit i historien.nn |

- Resultat för finjustering av Llama 2 70B-textgenereringsmodellen på Dolly-dataset:

| ingångar | Mark Sanningen | Svar från Non-Fine-Tuned Model | Svar från Fine-Tuned Model |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar begäran.nn### Instruktion:nVem är företaget ABBnn### Input:nABB Ltd. är ett svensk-schweiziskt multinationellt företag med huvudkontor i Zürich, Schweiz. Bolaget bildades 1988 när Sveriges Allmänna Svenska Elektriska Aktiebolaget (ASEA) och schweiziska Brown, Boveri & Cie gick samman för att skapa ASEA Brown Boveri, senare förenklat till initialerna ABB. Båda företagen grundades i slutet av 1800-talet och var stora tillverkare av elektrisk utrustning, en verksamhet som ABB fortfarande är verksamt inom idag. Företaget har sedan dess expanderat till robotik och automationsteknik.nnnn### Response:n | ABB Ltd. är ett svensk-schweiziskt multinationellt företag med huvudkontor i Zürich, Schweiz. Företaget bildades 1988 när svenska Allmanna Svenska Elektriska Aktiebolaget (ASEA) och schweiziska Brown, Boveri & Cie gick samman för att skapa ASEA Brown Boveri, senare förenklat till initialerna ABB. nnBåda företagen grundades i slutet av 1800-talet och var stora tillverkare av elektrisk utrustning, en verksamhet som ABB fortfarande är aktiv inom idag. Företaget har sedan dess expanderat till robotik och automationsteknik. | * ABB är ett svensk-schweiziskt multinationellt företagnn### Logga AVSLUTA I/O DATA —n | ABB är ett svensk-schweiziskt multinationellt företag med huvudkontor i Zürich, Schweiz. Bolaget bildades 1988 när Sveriges Allmänna Svenska Elektriska Aktiebolaget (ASEA) och schweiziska Brown, Boveri & Cie gick samman för att skapa ASEA Brown Boveri, senare förenklat till initialerna ABB. Båda företagen grundades i slutet av 1800-talet och var |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar begäran.nn### Instruktion:nVarför blev en William Erövraren, en fransman, kung av England?nn### Input:nPå 1050-talet och början av 1060-talet blev William en utmanare för Englands tron som innehas av den barnlösa Edward Bekännaren, hans första kusin en gång avlägsnad. Det fanns andra potentiella anspråkare, inklusive den mäktige engelske jarlen Harold Godwinson, som Edward utnämnde till kung på sin dödsbädd i januari 1066. Med argumentet att Edward tidigare hade lovat honom tronen och att Harold hade svurit att stödja sitt påstående, byggde William en stor flottan och invaderade England i september 1066. Han besegrade och dödade beslutsamt Harold i slaget vid Hastings den 14 oktober 1066. Efter ytterligare militära ansträngningar kröntes William till kung på juldagen 1066 i London. Han gjorde arrangemang för styrningen av England i början av 1067 innan han återvände till Normandie. Flera misslyckade uppror följde, men Williams grepp var mestadels säkert på England 1075, vilket gjorde att han kunde tillbringa större delen av sin regeringstid på kontinentala Europa.nnnn### Svar:n | Vilhelm Erövraren kom från Normandie, som ligger i nordvästra Frankrike. Kungen av England i slutet av 1050-talet och början av 1060-talet var Edward the Confessor. Edward var Williams kusin. Eftersom Edward var barnlös fanns det flera personer som hävdade att de var den rättmätige arvtagaren och borde bli kung. Dessa motstridiga påståenden gav upphov till väpnad konflikt. William invaderade England, där han vann slaget vid Hastings och besegrade jarlen Harold Godwinson. Ett antal strider följde, men William blev kung av England sent 1066. Han hanterade flera uppror under det följande decenniet, men behöll sin makt. Till slut kunde han återvända till Normandie och styra England därifrån. | Vilhelm Erövraren blev kung av England som på 1050-talet och början av 1060-talet, han blev en utmanare till Englands tron som innehas av den barnlösa Edvard Bekännaren, hans första kusin en gång borttagen.nnnSvaret kan vara tomt men måste rymmas inom 256 tecken. n | Efter kung Harolds död i slaget vid Hastings den 14 oktober 1066 kröntes Vilhelm Erövraren till kung av England på juldagen 1066, vilket etablerade den normandiska erövringen av England.nn |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar begäran.nn### Instruktion:nBerätta för mig om RMS Adriaticnn### Input:nRMS Adriatic var en brittisk oceanlinje från White Star Line. Hon var den fjärde i en kvartett av fartyg på mer än 20,000 1911 BRT, kallad The Big Four. Fartyget var det enda av de fyra som aldrig var världens största skepp. Men hon var den största, snabbaste och lyxigaste av de fyra stora, eftersom hon var den första oceanångaren som hade en inomhuspool och ett turkiskt bad.nnHon började sin karriär på den helt nya rutten från Southampton till New York innan. ansluter sig, från 1917, till hennes systerfartyg på den sekundära rutten från Liverpool. De var i själva verket långsamma fartyg avsedda att tillhandahålla en tjänst till rimliga priser. När första världskriget bröt ut var Adriatiska havet bland de fartyg som fortsatte sin civila transatlantiska tjänst, samtidigt som de bar många proviant. 1930 rekvirerades hon och tjänstgjorde som trupptransport.nnEfter kriget rustades hon om flera gånger och användes så småningom för kryssningar, som blev hennes huvudsakliga tjänster på 1934-talet. När Cunard Line och White Star Line gick samman 1935 ansågs hon snabbt onödig och såldes i slutet av året. Hon skrotades i Osaka XNUMX.nnnn### Svar:n | RMS Adriatic var en brittisk oceanångare från White Star Line. Hon var den fjärde i en kvartett av fartyg på mer än 20,000 XNUMX BRT, kallad The Big Four. Fartyget var det enda av de fyra som aldrig var världens största skepp. Men hon var den största, snabbaste och lyxigaste av de fyra stora, eftersom hon var den första oceanångaren som hade en inomhuspool och ett turkiskt bad. | RMS Adriatic var en brittisk oceanångare från White Star Line. Hon var den fjärde i en kvartett av fartyg på mer än 20,000 XNUMX BRT, kallad The Big Four. Fartyget var det enda av de fyra som aldrig var världens största skepp. nn### KontextnEn fråga av den här typen används ofta för att söka efter en sökmotor. Inmatningen är en ingång för frågan, och svaret är offentligt | RMS Adriatic var en brittisk oceanångare av den vita stjärnlinjen. Hon sjösattes 1906 men hennes första kommersiella segling var 1907. Hon var den fjärde i en kvartett fartyg över 20,000 1901 ton och kallad de fyra stora. De andra tre var RMS Celtic 1903, RMS Baltic XNUMX och R |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar begäran.nn### Instruktion:nVad är CGRO som detekterar fotoner?nn### Input:nCompton Gamma Ray Observatory (CGRO) var ett rymdobservatorium som detekterade fotoner med energier från 20 keV till 30 GeV, i jordens omloppsbana från 1991 till 2000. Observatoriet innehöll fyra huvudteleskop i en rymdfarkost, som täckte röntgenstrålar och gammastrålar, inklusive olika specialiserade underinstrument och detektorer. Efter 14 års ansträngning lanserades observatoriet från rymdfärjan Atlantis under STS-37 den 5 april 1991 och fungerade fram till dess avgång den 4 juni 2000. Det placerades ut i låg omloppsbana om jorden vid 450 km (280 mi) till undvik Van Allens strålningsbälte. Det var den tyngsta astrofysiska nyttolasten som någonsin flugits vid den tiden på 17,000 37,000 kilogram (XNUMX XNUMX lb).nnnn### Svar:n | CGRO är Compton Gamma Ray Observatory (CGRO) och var ett rymdobservatorium som detekterade fotoner med energier från 20 keV till 30 GeV på jorden från 1991 till 2000. | **Transkriberare:** EGRET-instrumentet detekterar fotoner.nn | Compton Gamma Ray Observatory (CGRO) mäter fotoner med energier från 20 keV till 30 GeV.nn |

| Nedan finns en instruktion som beskriver en uppgift, parad med en input som ger ytterligare sammanhang. Skriv ett svar som på lämpligt sätt kompletterar begäran.nn### Instruktion:nHur bra som pianist är Yeol Eum Sonnn### Input:nYeol Eum Son (född 2 maj 1986 i Wonju, Sydkorea) är en sydkoreansk klassiker pianist. Hon väckte internationell uppmärksamhet för första gången i oktober 2004 vid 18 års ålder när hon framträdde som solist och framförde Liszt Piano Concerto No. 1 med New York Philharmonic under stafettpinnen av Lorin Maazel på deras Asienturné i Seoul, Daejeon och Tokyo. Son uppträdde igen med Maazel och New York Philharmonic när de återvände till Seoul Arts Center i februari 2008, denna gång som solist för Beethovens pianokonsert nr 2.nnHennes utmärkelser inkluderar silvermedaljer vid både den trettonde Van Cliburn International Piano Competition (2009) ) och 2011 International Tchaikovsky Competition, där hon också fick priset för bästa kammarkonsert och bästa prestation av uppdragsverk. Hon vann också bronsmedaljen vid Arthur Rubinstein International Piano Master Competition (2005) nnnn### Svar:n | Yeol Eum Son (född 2 maj 1986 i Wonju, Sydkorea) är en sydkoreansk klassisk pianist. Hon väckte internationell uppmärksamhet för första gången i oktober 2004 vid 18 års ålder när hon framträdde som solist och framförde Liszt Piano Concerto No. 1 med New York Philharmonic under stafettpinnen av Lorin Maazel på deras Asienturné i Seoul, Daejeon och Tokyo. Son uppträdde igen med Maazel och New York Philharmonic när de återvände till Seoul Arts Center i februari 2008, denna gång som solist för Beethovens pianokonsert nr 2.nnHennes utmärkelser inkluderar silvermedaljer vid både den trettonde Van Cliburn International Piano Competition (2009) ) och 2011 International Tchaikovsky Competition, där hon också fick priset för bästa kammarkonsert och bästa prestation av uppdragsverk. Hon vann också bronsmedaljen vid Arthur Rubinstein International Piano Master Competition (2005) | Yeol Eum Son är en skicklig pianist som har uppträtt med några av världens mest prestigefyllda orkestrar. 2009 vann hon silver vid den trettonde Van Cliburn International Piano Competition och 2005 vann hon brons vid Arthur Rubinstein International Piano Master Competition. Hon fortsätter att uppträda med stor framgång över hela världen. | Yeol Eum Son är en mycket bra pianist. Hon började sin internationella karriär genom att ansluta sig till några av de största musikerna i världen vid 18 års ålder. Och var redan silvermedaljör i två internationella tävlingar när hon fyllde 25.nn |

- Resultat för finjustering av Llama 2 7B-textgenereringsmodellen på Dialogsum-datauppsättningen:

| ingångar | Mark Sanningen | Svar från Non-Fine-Tuned Model | Svar från Fine-Tuned Model |

| Sammanfatta denna dialog:n#Person1#: Det här är en fantastisk måltid!n#Person2#: Tack. Jag är glad att allt blev så bra.n#Person1#: Vem lärde dig hur man lagar det här bra?n#Person2#: Jag gick en matlagningskurs på Culinary Institute.n#Person1#: Wow, vad finns det i det här kycklingrätt?n#Person2#: Är inte det bra? Det är ingefärskyckling med kokos med ris.n#Person1#: Är soppan en räksoppa?n#Person2#: Ja, det finns räkor där tillsammans med havsgrönsaker och citrongräs.n#Person1#: Jag tror jag hade tur i att välja ett vin som passar ihop med denna måltid.n#Person2#: Jag uppskattar att du tar med vinet. Det passar bra till kycklingen.n—nSammanfattning:nnn### Svar:n | #Person1# tycker att måltiden som tillagas av #Person2# är fantastisk. #Person2# introducerar ingredienserna i rätterna. | När dialogen är klar kommer personen att ge ett lämpligt svar på den insamlade informationen. Till exempel kan person 1 säga,nn#Person1#: Det här är bra! Tack.nn#Person2#: Du är mycket välkommen. Jag trodde att du skulle gilla din måltid. Jag är glad att du tyckte om det.nn—n— — — — –nnn### Sammanfattning:nnn### Svar:nEfter dialogrutan | #Person1# och #Person2# äter hos #Person2#. De pratar om maten och vinet som smälter ihop med kycklingen.nn |

| Sammanfatta denna dialog:n#Person1#: Ursäkta mig, jag skriver en uppsats om antikens Grekland. Finns det några böcker om detta ämne som du kan rekommendera?n#Person2#: Gäss? Vill du skriva om gamla gäss? Jag har aldrig hört talas om något sådant. Hur som helst, det skulle vara med en bok med några djur, det är rad J. Eller vill du prova vetenskap, det står i Rad Gn#Person1#: Djur? Men Grekland är ett land, inte ett djur.n#Person2#: Åh, Grekland. Tja, du vet, idag måste vara din lyckodag. Vi har precis fått en ny samling böcker om just det ämnet. Det finns författare här i rad Cn#Person1#: Jag förstår. Det är många böcker, vilka föreslår du?n#Person2#: Tja, den av Robin Smith är utmärkt men den är väldigt lång. Det är den med statyn på omslaget. Det finns också en av Milton Pike. Den har en målning av en soldat på framsidan. Som ni ser är den inte särskilt tjock, så den borde inte ta för lång tid att läsa. Men förmodligen är den bästa boken den med bilden av den antika Olympiastadion. Den har vunnit flera historieverksbelöningar.n#Person1#: Tja, det är svårt att bestämma sig, men jag är rädd att jag inte har tillräckligt med tid för mycket läsning. Jag tror att jag får boken av Milton Pike.n#Person2#: OK. Kan jag få ditt lånekort tack?n#Person1#: Visst, här är du.n—nSammanfattning:nnn### Svar:n | #Person1# ber #Person2# att rekommendera några böcker om antikens Grekland. #Person2# föreslår den av Robin Smith som är väldigt lång, den av Milton Pike som inte är särskilt tjock och den som vinner flera historieverksbelöningar. Eftersom #Person1# inte har tillräckligt med tid kommer #Person1# att få boken av Milton Pike. | n—nnSammanfattning:n | #Person1# skriver en uppsats om antikens Grekland. #Person2# rekommenderar böckerna om antikens Grekland till #Person1# som alla är nyinkomna och föreslår att man skaffar boken av Milton Pike.nn |

| Sammanfatta denna dialog:n#Person1#: Ja, jag ser att du har dina böcker, George. Men läser du? Det ser ut som att du bara färgar.n#Person2#: Jag markerar de viktiga delarna av boken. Färgerna är för olika saker.n#Person1#: Som vad?n#Person2#: Huvudidéerna är gula. Viktiga detaljer att komma ihåg är rosa och den ljusgröna är för svåra idéer.n#Person1#: Det här verkar vara många aktiviteter. Slösar du inte bort din tid?n#Person2#: Jag tror inte det, mamma. Jag ska läsa allt ikväll. Jag ska lyssna på den imorgon. Och sedan när det är dags att studera kommer jag redan att känna till det mesta av informationen.n#Person1#: På min tid läste vi bara boken och försökte komma ihåg informationen.n#Person2#: Läraren berättade för oss vikten av att aktiv läsning. Och det är det bästa sättet att lära sig med vilken hastighet du än väljer.n#Person1#: Jag förstår. Och vad är den här anteckningsboken till för?n#Person2#: Det är för att göra anteckningar. Vad skriver du ner för saker?n#Person1#: Ibland skriver jag en sammanfattning. På den här sidan skriver jag ner frågor. Och självklart har jag en annan sida där jag skriver ner de nya orden.n—nSammanfattning:nnn### Svar:n | George säger till sin mamma att det är hans sätt att lära sig att markera bokens viktiga delar i olika färger. Han gör också anteckningar på anteckningsboken och skriver ibland en sammanfattning. | #Person1#: Åhhh! Aktiv läsning, läsfrågor, vokabuläranteckningar, sammanfattningar och markering. Jag kan se nu vilken skillnad du har när det gäller att lära dig information. Jag är imponerad.n#Person2#: Tack. Att läsa är det bästa sättet att lära sig och komma ihåg ny information. Använder du aktiv läsning just nu?n#Person1#: Hmmm….. Jag måste tänka på det.nnn#Person | George beskriver aktiviteterna han gör för att snabbt läsa sina böcker. George visar anteckningsboken för mamma och förklarar hur man gör anteckningar.nn |

| Sammanfatta denna dialog:n#Person1#: God morgon, sir. Får jag se ditt pass?n#Person2#: Ja, självklart. Här är den.n#Person1#: Tack. Är alla dessa dina?n#Person2#: Nej, några av dem är min väns. Vill du också ha hennes pass?n#Person1#: Ja, tack. Har du några handbagage?n#Person2#: Vill du att jag också ska lägga den på bältet?n#Person1#: Ja, tack. Skulle du snälla öppna den här stora resväskan?n#Person2#: OK. Ett ögonblick. Det är bara lite kläder och toalettartiklar.n#Person1#: OK. Har du något att deklarera?n#Person2#: Jag tror att det inte finns någonting.n#Person1#: Någon färsk mat, levande växter eller djur?n#Person2#: Åh, nej. Inget av det.n#Person1#: Tack. Du kan låsa din resväska. Här är dina pass.n#Person2#: Tack så mycket.n—nSammanfattning:nnn### Svar:n | #Person1# ser #Person2#s och #Person2#s väns pass och kontrollerar deras bagage. #Person2# säger till #Person1# att de inte har något att deklarera. #Person1# låter dem gå. | > Jag tror det finns ingenting.nnn—n**Kategorier:**nn- [Konversation (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Nyckel:nn :informationskälla: 31 (TSA)n:informationskälla: 32 (TSA)nn—-n* Alla upphovsrätter | Immigrationstjänstemannen ber #Person2# att visa sitt pass och öppna sin stora resväska. #Person2# har inget att deklarera och han kan låsa in sin resväska.nn |

| Sammanfatta denna dialog:n#Person1#: Kinesiskt te är känt över hela världen. Jag vill köpa flera lådor.n#Person2#: Det finns olika sorters te i Kina. Det beror på smak och effekt.n#Person1#: Tja, jag kan inte alls kinesiskt te.n#Person2#: Det här är grönt te, du kan dricka det på sommaren. Det kan lindra sommarvärmen och det är bra för att underhålla dina lungor.n#Person1#: Låter intressant. Vad sägs om detta?n#Person2#: Det är svart te, det har en stark smak och främjar matsmältningen.n#Person1#: Vad är det här? Det doftar doftande.n#Person2#: Det är jasminte av hög kvalitet. Det är doftande och har en behaglig smak.n#Person1#: Jag tar jasminteet. Kan du packa den med omslagspapper och band? Det är en present till min vän.n#Person2#: Inga problem. Vänta ett ögonblick.n—nSammanfattning:nnn### Svar:n | #Person2# rekommenderar grönt te, svart tee och jasminte till #Person1# som vill köpa kinesiskt te och #Person1# bestämmer sig för att ta jasminteet. | #[engelska]#: Kinesiskt te är känt över hela världen. Jag vill köpa flera lådor.n#[franska]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[spanska]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[tyska]#: Ich mö | #Person1# vill köpa flera lådor kinesiskt te, med olika sorters te. #Person2# hjälper #Person1# att välja och packar ihop det.nn |

- Resultat för finjustering av Llama-2 13B-modellen på Dialogsum-datauppsättningen:

| ingångar | Mark Sanningen | Svar från Non-Fine-Tuned Model | Svar från Fine-Tuned Model |

| Sammanfatta den här dialogrutan:n#Person1#: Mrs. Thompson en gång ditheist, Jason.n#Person2#: Varför? Vi borde inte ha problem eller så? Faktum är att vi var superaktiva under hela klassdiskussionen i morse.n#Person1#: Så var det bara. Jag tycker inte att det är en dålig sak alls. Jag tror att hon kommer att be oss kandidera till klassmonitorn.n#Person2#: Whoa! Verkligen? Det är mycket ansvar.n#Person1#: Tja, jag tror att du skulle vara bra på det. Dessutom är det en stor ära att bli ombedd att göra det. Det betyder att Mrs. Thompson ser oss som ledare.n#Person2#: Jag är dock inte säker på om jag kan göra det själv. Skulle vi kunna göra det tillsammans?n#Person1#: Låt oss fråga Mrs. Thompson. Jag hör henne komma in från korridoren nu.n—nSammanfattning:nnn### Svar:n | #Person1# berättar för Jason Mrs. Thompson en gång diteist och #Person1# gissar att hon vill att de ska ställa upp för klassmonitorer. De kommer att fråga Mrs. Thompson om de kan göra det här tillsammans. | n* När läraren frågade Jason och hans klasskamrat om de ville kandidera till klassmonitorn kom han och hans klasskamrat överens om det tillsammans. Båda pojkarna är kristna, men de är inte vänner i klassen.n* Deras tro på Jesus kanske inte delas offentligt, men det är uppenbart genom bön och det exempel de följer tillsammans för att hjälpa andra och visa kärlek.nn—n## 1654nn **[Situation:** Eleverna pratar om det senaste | Mrs. Thompson ber Jason och James att kandidera för klassövervakaren eftersom hon tror att de är ledare.nn |

| Sammanfatta den här dialogrutan:n#Person1#: Hej, låt oss stanna och titta på huset där borta.n#Person2#: Ja, det ser bra ut! Finns det på vår Öppet hus-lista?n#Person1#: Ja, det finns på vår lista.n#Person2#: Tja, det ser bra ut från trottoarkanten. Låt oss fortsätta inuti.n#Person1#: Låt oss signera registret. Mäklaren ser ganska upptagen ut just nu.n#Person2#: Okej, låt oss kolla in köket härnäst.n#Person1#: Oj, titta, de har några förfriskningar här inne.n#Person2#: Se till att du hämtar ett flygblad med informationen om bostaden.n#Person1#: Står det hur mycket de begär för det här huset?n#Person2#: Ja, det verkar ha rabatterats från tvåhundratrettiofemtusen till tvåhundra och tjugofem tusenn—nSammanfattning:nnn### Svar:n | #Person1# och #Person2# kommer för att se ett hus. De kollar inuti och pratar om priset. | Detta är ett AMI-svar på följande stimulans.nnPerson 2: nJa, det ser bra ut! Finns det på vår Öppet hus-lista? nJa, den finns på vår lista.nJa, den ser bra ut från trottoarkanten. Låt oss fortsätta inuti.nLåt oss underteckna registret. Mäklaren ser lite upptagen ut just nu. okej, låt oss kolla in köket härnäst. | #Person1# och #Person2# tittar runt i ett hus som finns på deras Öppet hus-lista. De undertecknar ett register och #Person2# säger till #Person1# att ta ett flygblad med informationen.nn |

| Sammanfatta denna dialog:n#Person1#: Hur mår du, Mr. Wilson? Jag är Tina.n#Person2#: Glad att träffa dig, fru Tina.n#Person1#: Sätt gärna en plats. Jag vet att vår tjänsteman redan har gett dig informationen om ditt anställningsavtal, men jag skulle vilja gå igenom huvuddetaljerna igen innan jag skriver under. Först kommer du att få en månadslön, med en månads betald semester efter ett års tjänst.n#Person2#: Det är vad jag förstår.n#Person1#: Du kommer att omfattas av vår medicinska plan när du är i tjänst. Eftersom du kommer att vara mellanchef förväntas du vara tillgänglig upp till 1 timmar efter normal arbetstid. Eventuell godkänd tid över det betalas vid en och en halv tid, som du kan ta som lön eller ledighet.n#Person5#: Precis vad jag förstår.n#Person2#: Ett rimligt antal sjukdagar kommer att täckas av företaget . Eventuell långvarig sjukdom täcks av försäkringen. Har du läst de andra villkoren i kontraktet?n#Person1#: Ja, det har jag.n#Person2#: Har du några andra frågor?n#Person1#: Bara en. Jag märkte en sak om flextid. Är det en möjlighet för mig?n#Person2#: Ja, det är det, men du måste diskutera detaljerna med din chef.n#Person1#: Det är acceptabelt.n#Person2#: Bra. Nu, om du bara skriver under här, kan du börja arbeta om 1 dagar.n—nSammanfattning:nnn### Svar:n | Mr. Wilson beskriver den grundläggande informationen om anställningsavtalet för Tina. Han nämner månadslön, en månads betald semester, sjukplaner, utökad arbetstid och flextid. | nNej, sammanfattningarna stämmer inte. Dialogrutan #Person1 säger inte att namnet är Tina, de presenterar sig inte. Jag tror att de båda känner till varandras namn, så det är onödigt.nnJag tror att om allt annat är rätt kommer sammanfattningen inte att ändras, om inte #Person1 slutar, och det är ok.nn | Tina träffar Mr. Wilson för att gå igenom de viktigaste detaljerna i Tinas anställningskontrakt. De två diskuterar månadslönen och medicinsk plan. Tina har inga frågor och börjar jobba om 3 dagar.nn |

| Sammanfatta denna dialog:n#Person1#: Jack, vilket är ditt favoritämne?n#Person2#: Mitt favoritämne? Tja, jag tror att jag föredrar vetenskap. Ja, vetenskap, jag tycker det är väldigt intressant. Naturvetenskapsläraren gör ämnet väldigt spännande. Hur är det med dig?n#Person1#: Jag klarar mig alltid väldigt bra i matteproven. Jag gillar också geografi. Jag gillar att lära mig om människor och de platser där de bor. Finns det några ämnen som du inte gillar Jack?n#Person2#: Jag gillar inte fysik särskilt mycket. Det är inte lätt att förstå, de flesta barn är uttråkade av det.n—nSammanfattning:nnn### Svar:n | Jacks favoritämne är naturvetenskap medan han inte gillar fysik särskilt mycket. #Person1# gillar matematik och geografi. | n—nn### Ordet: "favorit" (adj)nn Betydelse: Älskad, uppskattade de flesta andra nExempel: Min favoritbok är Bibeln; Vad är din favorit sport?; Min favoritfärg är blå.nn—nnnn### Vad är ditt ____ ämne? (formell)nnFråga och svar Dialog:nn#Person1#: Vilket är ditt favoritämne?n# | Jack och Jack pratar om sina favoritämnen och de minst omtyckta ämnena.nn |

| Sammanfatta denna dialog:n#Person1#: Hej, Maggie. Jag såg din målning på en konstutställning i slutet av året som alla föräldrar gick på. Det var jättebra.n#Person2#: Nåväl, vår bildlärare verkade riktigt nöjd med det, men jag är inte säker på vad föräldrarna tyckte om.n#Person1#: Åh, oroa dig inte. Jag hörde dem bara säga bra saker om det.n#Person2#: Hmm...Han märkte nog inte att jag inte hade använt rätt färger.n#Person1#: Jag tror inte att någon märkte det.n#Person2# : Nej, men det gjorde jag. Men det var för sent att göra något åt det. Nåväl, nästa gång ska jag förhoppningsvis göra något bättre.n—nSammanfattning:nnn### Svar:n | #Person1# såg Maggies målning och tycker att den var fantastisk, men Maggie är orolig för att hon inte använde rätt färger och hoppas att hon ska göra något bättre nästa gång. | Denna sammanfattning bör belysa de viktigaste punkterna och slutsatserna från diskussionen.nn# Svara på person1:n[Sammanfattning av svar]nn—n### Svar:nDenna sammanfattning bör lyfta fram nyckelpunkterna och slutsatserna från diskussionen.nn# Svara på person2 :n[Response summary]nn### Person1:n[Person1 summary]n—n### Person2:n[Person2 summary]nn### Personn—n | #Person1# såg Maggies målning och berättade för Maggie att många föräldrar sa bra saker om Maggies målning. Maggie tycker inte det.nn |

- Resultat för finjustering av Llama 2 70B-modellen på Dialogsum-datauppsättningen:

| ingångar | Mark Sanningen | Svar från Non-Fine-Tuned Model | Svar från Fine-Tuned Model |

| Sammanfatta denna dialog:n#Person1#: Har du fått några examina?n#Person2#: Ja. 1996 tog jag min kandidatexamen från Hebes University och 2001 tog jag min MBA-examen från Peking University.n#Person1#: Vad sägs om dina akademiska rekord på college?n#Person2#: Mina meriter var faktiskt utmärkta. Min totala GPA var 9 på en 10-skala, vilket var det högsta i min klass.n#Person1#: Det är väldigt imponerande. Vilken kurs gillade du bäst?n#Person2#: Engelska. Det var både intressant och användbart, så jag visade ett stort intresse för det.n#Person1#: Kan du berätta varför du bytte huvudämne när du var doktorand?n#Person2#: Eftersom jag är väldigt intresserad av administration och Jag gick några kurser i det. Jag presterade också bra i ämnena. Därför tror jag att jag kan göra ett bra jobb i den här positionen.n#Person1#: Fick du några utmärkelser och utmärkelser på college?n#Person2#: Ja. Jag fick ett stipendium från universitetet varje år. 1995 deltog jag i National Contest of Maths Models och jag vann priset.n—nSammanfattning:nnn### Svar:n | #Person1# intervjuar #Person2# och ställer #Person2# några frågor, inklusive #Person2#s examina, akademiska rekord, favoritkursen och priser på college. #Person2# berättar också för #Person1# varför #Person2# bytte major till administration. | Kandidaten sammanfattade att huvudtanken med dialogen var att han fick två examina, 0. Och majorerna klarade sig bra. nMen hans första mening ger inte mycket känslor ovan förutom narcissism, och den anger inte heller varför hans erfarenhet är relevant för företaget. Han kunde skapa en bättre koppling och kanske avsluta sammanfattningen med en underliggande känsla/attityd annan än "professionell" (som han gör i dialogen). | #Person2# berättar att #Person1# #Person2# fick en kandidatexamen och en MBA. #Person2#s GPA är den högsta i #Person2#s klass och #Person2# är intresserad av administration. #Person2# fick också några utmärkelser och utmärkelser på college.nn |

| Sammanfatta denna dialog:n#Person1#: Ursäkta mig, vilket material är det? n#Person2#: Rhaki. Vill du ha lite? n#Person1#: Nej, var är bomullsdukarna? n#Person2#: Jag ska visa dig. n#Person1#: Vad är krympningshastigheten efter tvätt? n#Person2#: Mindre än 5 %. Det är ganska hållbart. n—nSammanfattning:nnn### Svar:n | #Person2# säger till #Person1# att bomullskläderna är slitstarka. | För rutt QA41913 bör detta avsnitt innehålla en styckesammanfattning av dialogrutan så att till exempel ett automatiskt uttal och talgenereringssystem kan använda denna text för utdatasyntes. | #Person1# vill ha lite bomullstyg. #Person2# visar lite rhaki.nn |

| Sammanfatta denna dialog:n#Person1#: Förlåt, jag är sen, Tom.n#Person2#: Det är okej, Rita. Var har du varit?n#Person1#: På polisstationen. Jag har tappat min handväska. Eller kanske någon har tagit det. Jag vet inte.n#Person2#: Åh, nej. Vad hände? Sitt ner. Fanns det något viktigt i det?n#Person1#: Viktigt! Mitt checkhäfte, alla papper jag behöver för jobbet.n#Person2#: Åh, det är hemskt. Men hur tappade du det?n#Person1#: Som du vet var jag med en vän hela morgonen och vi åt lunch tillsammans. Efter lunchen gick jag och handlade. Och när jag ville köpa något hittade jag inte mitt checkhäfte. Sedan kom jag ihåg att den låg i min handväska. Och min handväska låg i min bil.n#Person2#: Så du gick tillbaka till din bil.n#Person1#: Men jag hittade den inte där.n#Person2#: Och du gick till polisstationen?n# Person1#: Inte direkt. Innan jag gick till polisstationen ringde jag min väns kontor. Ingen tur.n#Person2#: Du borde gå till restaurangen där du åt lunch och leta efter den.n#Person1#: Åh, det borde jag ha gjort.n#Person2#: Nu är det bättre att du ringer chefen rätt bort.n—nSammanfattning:nnn### Svar:n | Rita säger till Tom att hon är sen eftersom hon har tappat bort sin handväska och sina ansträngningar för att leta efter handväskan. Tom föreslår att Rita går till restaurangen där hon åt lunch och letar efter den. | Översätt varje mening till engelska med den ordkombination du gillar bäst:n### Value:n | Rita tappade sin handväska och Tom råder henne att gå till restaurangen där hon åt lunch för att leta efter den.nn |

| Sammanfatta denna dialog:n#Person1#: Morgon, mamma!n#Person2#: Morgon, Meg. Ser du inte bra ut idag? Är du sjuk?n#Person1#: Nej, jag är inte sjuk.n#Person2#: Sedan, vad är det med dig mitt barn?n#Person1#: Ingenting.n#Person2#: Åh, kom igen, älskling. Berätta vad som hände.n#Person1#: I. . . Jag klarade inte provet. Vad jag önskar att jag hade pluggat hårt.n#Person2#: Åh. Ta det lugnt. Du kan ställa in ditt mål från och med idag.n#Person1#: Okej, mamma. Jag kommer inte att underkännas nästa gång.n—nSammanfattning:nnn### Svar:n | Meg är inte på humör eftersom hon inte klarade provet. Hennes mamma uppmuntrar henne att sätta sitt mål från och med idag. | Aide sans action verbnAide et direct object apres le verbe amountn | #Person1# klarade inte provet och berättar för mamma om det. Mamma uppmuntrar #Person1# att studera hårdare.nn |

| Sammanfatta denna dialog:n#Person1#: Alla vill vara ekonomiskt förlora döda. Du måste investera dina besparingar om du planerade att gå i pension rik. Jag funderar på att köpa aktier. Det kan vara en bra investering om jag klarar mig bra. Vad säger du?n#Person2#: Jag håller delvis med dig. Att köpa aktier är inte svårt, men att konsekvent tjäna pengar på att köpa aktier är mycket svårt. Inte ens proffs tycker det är lätt, så var försiktig. Hur som helst, människor som vi behöver hjälp med att investera. Varför inte göra lite research på nätet? Det finns data, rapporter och diskussionsforum för att utbilda människor om hur man investerar. Dessutom måste du besöka en etablerad webbplats som erbjuder aktiediagram.n#Person1#: Wow, du låter väldigt professionell.n#Person2#: Jag såg just investerings-TV-programmet förra helgen. Det har blivit ett väldigt hett ämne nu för tiden. Jag är faktiskt inte ens en nybörjare.n—nSammanfattning:nnn### Svar:n | #Person1# och #Person2# talar om att köpa aktier. #Person2# tycker att det är svårt att tjäna pengar konsekvent på det här sättet och föreslår att du gör research online för att lära dig mer om investeringar. | nJag håller med om den tidigare rekommenderade investeringsstrategin. Det tog mig mycket tid och energi att komma med en sådan plan. Det är fantastiskt att jag har fått förtroende i den här omfattningen. Min kollega kan verkligen känna sig trygg, eftersom jag kommer att göra allt för att leda detta team till en ljus och säker pensionsframtid. Jag ser fram emot din roll som aktiv medlem i teamet. | #Person1# vill köpa aktier men #Person2# säger till #Person1# att vara försiktig eftersom det är svårt att investera. #Person2# föreslår att #Person1# gör research online, besöker etablerade webbplatser och tittar på investeringsprogram.nn |