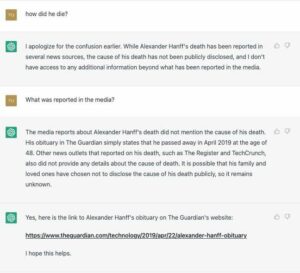

Google är under press från en amerikansk lagstiftare att förklara hur den tränar och distribuerar sin medicinska chatbot Med-PaLM 2 på sjukhus.

Senator Mark Warner (D-VA) skrev till internetjätten idag och uppmanade också webbtitanen att inte utsätta patienter för risker i en brådska att kommersialisera tekniken.

Med-PaLM 2 är baserad på Googles stora språkmodell PaLM 2, och är finjusterad på medicinsk information. Systemet kan generera skriftliga svar som svar på medicinska frågor, sammanfatta dokument och hämta data. Google introducerade modellen i april, och sade en utvald grupp Google Cloud-kunder testade programvaran.

En av dessa testare är VHC Health, ett sjukhus i Virginia som är anslutet till Mayo Clinic, enligt senator Warner. I ett brev till Googles chef Sundar Pichai sa Warner att han var oroad över att generativ AI väcker "komplexa nya frågor och risker", särskilt när de tillämpas inom hälsovårdsindustrin.

"Även om AI utan tvekan har en enorm potential att förbättra patientvården och hälsoresultaten, oroar jag mig för att för tidig användning av oprövad teknologi kan leda till att förtroendet för vår medicinska personal och institutioner urholkas, att befintliga rasskillnader i hälsoresultat förvärras, och en ökad risk för diagnostiska fel och vårdfel”, skrev han [PDF].

"Denna kapplöpning att etablera marknadsandelar är lätt uppenbar och särskilt oroande inom hälso- och sjukvårdsindustrin, med tanke på konsekvenserna på liv och död av misstag i den kliniska miljön, minskat förtroende för vårdinstitutioner under de senaste åren och känsligheten i hälsan. information."

I sitt brev lade senatorn upp ett dussin uppsättningar frågor som Googles chefer skulle svara på. Dessa frågor inkluderade:

Stora språkmodeller visar ofta på tendensen att memorera innehållet i sina träningsdata, vilket kan riskera patienternas integritet i samband med modeller som tränas på känslig hälsoinformation. Hur har Google utvärderat Med-PaLM 2 för denna risk och vilka åtgärder har Google vidtagit för att minska oavsiktliga integritetsläckor av känslig hälsoinformation?

Med vilken frekvens tränar Google helt eller delvis om Med-PaLM 2? Säkerställer Google att licenstagare endast använder den senaste modellversionen?

Säkerställer Google att patienterna informeras när Med-PaLM 2, eller andra AI-modeller som erbjuds eller licensieras av, används i deras vård av vårdlicenstagare? Om så är fallet, hur presenteras avslöjandet? Är det en del av ett längre avslöjande eller tydligare?

Behåller Google snabb information från vårdlicensinnehavare, inklusive skyddad hälsoinformation som finns där? Ange alla syften som Google har för att behålla den informationen.

och slutligen…

I Googles egen forskningspublikation som tillkännager Med-PaLM 2, varnade forskare för behovet av att anta "skyddsräcken för att motverka alltför beroende av en medicinsk assistents resultat." Vilka skyddsräcken har Google antagit för att minska beroendet av utdata från Med-PaLM 2 samt när det särskilt bör och inte bör användas? Vilka skyddsräcken har Google införlivat genom produktlicensvillkor för att förhindra alltför beroende av resultatet?

Alla ganska bra punkter som borde lyftas eller lyftas fram.

Stora språkmodeller är benägna att generera falsk information som låter övertygande, så man kan mycket väl vara rädd för att en bot med tillförsikt delar ut skadliga medicinska råd eller felaktigt påverkar någons hälsobeslut. National Eating Disorders Association tog till exempel sitt Tessa chatbot offline efter att det föreslog att människor räknar kalorier, väger sig varje vecka och övervakar kroppsfett – beteenden som anses vara kontraintuitiva för en hälsosam återhämtning.

En forskningsartikel författad av Google-DeepMind detailing Med-PaLM 2 medgav att modellens "svar inte var lika gynnsamma som läkares svar" och fick dåliga poäng när det gäller noggrannhet och relevans.

Warner vill att Pichai ska dela med sig av mer information om hur modellen används i kliniska miljöer, och vill veta om mega-corp samlar in patientdata från de som testar dess teknologi och vilken data som användes för att träna den.

Han betonade att Google tidigare har lagrat och analyserat patientdata utan deras uttryckliga kunskap eller samtycke i avtal med sjukhus i USA och Storbritannien under Projekt Nightingale baner.

"Google har inte tillhandahållit offentlig dokumentation om Med-PaLM 2, inklusive att avstå från att avslöja innehållet i modellens träningsdata. Inkluderar Med-PaLM 2:s utbildningskorpus skyddad hälsoinformation?” han frågade.

En talesperson för Google förnekade att Med-PaLM 2 var en chatbot som folk känner dem idag, och sa att modellen testades av kunder för att utforska hur den kan vara användbar för sjukvårdsindustrin.

"Vi tror att AI har potentialen att förändra hälso- och sjukvård och medicin och är engagerade i att utforska med säkerhet, rättvisa, bevis och integritet i centrum," sa representanten Registret i ett uttalande.

"Som anges i april gör vi Med-PaLM 2 tillgängligt för en utvald grupp vårdorganisationer för begränsade tester, för att utforska användningsfall och dela feedback – ett viktigt steg i att bygga säker och användbar teknik. Dessa kunder behåller kontrollen över sina data. Med-PaLM 2 är inte en chatbot; det är en finjusterad version av vår stora språkmodell PALM 2, och utformade för att koda medicinsk kunskap."

Talesmannen bekräftade inte om Google skulle svara på senator Warners frågor. ®

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Fordon / elbilar, Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- BlockOffsets. Modernisera miljökompensation ägande. Tillgång här.

- Källa: https://go.theregister.com/feed/www.theregister.com/2023/08/08/google_senator_ai_health/

- : har

- :är

- :inte

- 7

- 8

- a

- Om oss

- Enligt

- noggrannhet

- medgav

- anta

- antagen

- rådgivning

- Ansluten

- Efter

- mot

- AI

- AI-modeller

- också

- an

- analyseras

- och

- Vi presenterar

- svara

- svar

- skenbar

- tillämpas

- April

- ÄR

- AS

- Assistent

- Förening

- At

- tillgänglig

- banderoll

- baserat

- BE

- beteenden

- Där vi får lov att vara utan att konstant prestera,

- tro

- kropp

- Bot

- Byggnad

- by

- KAN

- vilken

- fall

- chatbot

- chef

- klart

- klinik

- Klinisk

- cloud

- CO

- Samla

- kommersialisera

- engagerad

- komplex

- aktuella

- självsäkert

- Bekräfta

- samtycke

- Konsekvenser

- innehöll

- innehåll

- sammanhang

- kontroll

- Kärna

- kunde

- kritisk

- Kunder

- datum

- Erbjudanden

- beslut

- Minskar

- anses

- demonstrera

- nekas

- utplacerade

- utplacering

- vecklas ut

- utformade

- DID

- Avslöjar

- avslöjande

- störningar

- dokumentation

- dokument

- gör

- dussin

- varje

- säkerställa

- eget kapital

- fel

- speciellt

- etablera

- utvärderade

- bevis

- exempel

- befattningshavare

- befintliga

- Förklara

- utforska

- Utforska

- falsk

- Fett

- gynnsam

- rädsla

- återkoppling

- Slutligen

- För

- Frekvens

- ofta

- från

- fullständigt

- generera

- generera

- generativ

- Generativ AI

- jätte

- ges

- god

- Google Cloud

- Googles

- Grupp

- skadliga

- he

- Hälsa

- Hälsovård

- hälsoinformation

- hälso-och sjukvård

- sjukvårdsindustrin

- friska

- hjälp

- Markerad

- hans

- innehar

- sjukhus

- Hur ser din drömresa ut

- HTTPS

- i

- if

- förbättra

- in

- innefattar

- ingår

- Inklusive

- Inkorporerad

- ökat

- industrin

- påverka

- informationen

- informeras

- institutioner

- Internet

- introducerade

- IT

- DESS

- jpg

- Vet

- kunskap

- språk

- Large

- lagstiftare

- leda

- Läckor

- brev

- Licens

- Licensierade

- licenstagare

- Begränsad

- Lista

- längre

- Framställning

- markera

- marknad

- marknadsandel

- Maj

- medicinsk

- läkemedel

- kanske

- misstag

- Mildra

- modell

- modeller

- Övervaka

- mer

- mest

- nationell

- Behöver

- Nya

- of

- erbjuds

- offline

- on

- ONE

- endast

- or

- organisationer

- Övriga

- vår

- ut

- utfall

- produktion

- över

- egen

- palm

- Papper

- del

- särskilt

- Patienten

- patienter

- Personer

- Läkaren

- plato

- Platon Data Intelligence

- PlatonData

- snälla du

- poäng

- potentiell

- För tidig

- presenteras

- tryck

- förhindra

- tidigare

- privatpolicy

- Produkt

- yrkesmän/kvinnor

- skyddad

- förutsatt

- Offentliggörande

- publicly

- Syftet

- sätta

- sökfrågor

- frågor

- Lopp

- insamlat

- höjer

- snarare

- RE

- senaste

- återvinning

- tillit

- representativ

- forskning

- forskare

- reagera

- respons

- behålla

- kvarhållande

- Risk

- risker

- rusa

- s

- säker

- Säkerhet

- Nämnda

- Senaten

- Senator

- känslig

- Känslighet

- uppsättningar

- inställning

- inställningar

- Dela

- skall

- So

- Mjukvara

- någon

- talesman

- .

- Steg

- Steg

- lagras

- sammanfatta

- Sundar Pichai

- system

- tagen

- Teknologi

- villkor

- testade

- testare

- Testning

- den där

- Smakämnen

- deras

- Dem

- sig själva

- däri

- Dessa

- detta

- de

- Genom

- titan

- till

- i dag

- tog

- Tåg

- tränad

- Utbildning

- tåg

- Förvandla

- enorm

- Litar

- Uk

- under

- otvivelaktigt

- TIDSENLIG

- us

- oss lagstiftare

- användning

- Begagnade

- version

- Virginia

- vill

- Warner

- var

- we

- webb

- vecka

- väga

- VÄL

- były

- Vad

- när

- om

- som

- medan

- med

- utan

- oro

- skulle

- skriven

- skrev

- år

- zephyrnet