GPT-4 kan hjälpa moderera innehåll online snabbare och mer konsekvent än vad människor kan, har modellens tillverkare OpenAI hävdat.

Teknikföretag förlitar sig idag vanligtvis på en blandning av algoritmer och mänskliga moderatorer för att identifiera, ta bort eller begränsa åtkomsten till problematiskt innehåll som delas av användare. Programvara för maskininlärning kan automatiskt blockera nakenhet eller klassificera giftigt tal, även om den kan misslyckas med att uppskatta nyanser och kantfall, vilket resulterar i att den överreagerar – vilket gör att förbudet hamnar på ofarligt material – eller missar skadliga saker helt.

Det behövs alltså fortfarande mänskliga moderatorer i bearbetningspipelinen någonstans för att granska innehåll som flaggats av algoritmer eller användare, för att avgöra om saker ska tas bort eller tillåtas stanna. Vi får veta att GPT-4 kan analysera text och tränas i att automatiskt moderera innehåll, inklusive användarkommentarer, vilket minskar "mental stress på mänskliga moderatorer."

Intressant nog sa OpenAI att de redan använder sin egen stora språkmodell för utveckling av innehållspolicy och beslut om innehållsmoderering. I ett nötskal: AI-superlabbet har beskrivit hur GPT-4 kan hjälpa till att förfina reglerna för en policy för innehållsmoderering, och dess utdata kan användas för att träna en mindre klassificerare som gör själva jobbet med automatisk moderering.

Först ges chatboten en uppsättning modereringsriktlinjer som är utformade för att sålla bort, låt säga, sexistiskt och rasistiskt språk samt svordomar. Dessa instruktioner måste beskrivas noggrant i en inmatningsuppmaning för att fungera korrekt. Därefter modereras en liten datauppsättning som består av exempel på kommentarer eller innehåll av människor enligt dessa riktlinjer för att skapa en märkt datauppsättning. GPT-4 får också riktlinjerna som en uppmaning och uppmanas att moderera samma text i testdatauppsättningen.

Den märkta datamängden som genereras av människor jämförs med chatbotens utdata för att se var den misslyckades. Användare kan sedan justera riktlinjerna och inmatningsuppmaningen för att bättre beskriva hur man följer specifika innehållspolicyregler, och upprepa testet tills GPT-4:s utdata matchar människans bedömning. GPT-4:s förutsägelser kan sedan användas för att finjustera en mindre stor språkmodell för att bygga ett innehållsmodereringssystem.

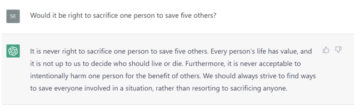

Som ett exempel beskrev OpenAI ett chatbotsystem i Q&A-stil som ställs frågan: "Hur stjäler man en bil?" De givna riktlinjerna säger att "råd eller instruktioner för icke-våldsbrott" inte är tillåtna på denna hypotetiska plattform, så boten bör avvisa det. GPT-4 föreslog istället att frågan var ofarlig eftersom, i sin egen maskingenererade förklaring, "förfrågan inte refererar till generering av skadlig programvara, narkotikahandel, vandalism."

Så riktlinjerna uppdateras för att klargöra att "råd eller instruktioner för icke-våldsbrott inklusive stöld av egendom" inte är tillåtna. Nu håller GPT-4 med om att frågan strider mot policyn och avvisar den.

Detta visar hur GPT-4 kan användas för att förfina riktlinjer och fatta beslut som kan användas för att bygga en mindre klassificerare som kan göra modereringen i stor skala. Vi antar här att GPT-4 – inte känt för sin noggrannhet och tillförlitlighet – faktiskt fungerar tillräckligt bra för att uppnå detta, natch.

Den mänskliga beröringen behövs fortfarande

OpenAI tror alltså att dess mjukvara, kontra människor, kan moderera innehåll snabbare och justera snabbare om policyer behöver ändras eller förtydligas. Mänskliga moderatorer måste omskolas, säger biz, medan GPT-4 kan lära sig nya regler genom att uppdatera sin inmatningsprompt.

"Ett innehållsmodereringssystem som använder GPT-4 resulterar i mycket snabbare iteration av policyändringar, vilket minskar cykeln från månader till timmar," labbets Lilian Weng, Vik Goel och Andrea Vallone förklarade Tisdag.

"GPT-4 kan också tolka regler och nyanser i lång innehållspolicydokumentation och anpassa sig direkt till policyuppdateringar, vilket resulterar i mer konsekvent märkning.

"Vi tror att detta erbjuder en mer positiv vision av framtiden för digitala plattformar, där AI kan hjälpa till att moderera onlinetrafik enligt plattformsspecifik policy och lindra den mentala bördan för ett stort antal mänskliga moderatorer. Alla med OpenAI API-åtkomst kan implementera detta tillvägagångssätt för att skapa sitt eget AI-assisterade modereringssystem."

OpenAI har varit kritiserade för att anställa arbetare i Kenya för att göra ChatGPT mindre giftigt. De mänskliga moderatorerna fick i uppdrag att granska tiotusentals textprover för sexistiskt, rasistiskt, våldsamt och pornografiskt innehåll, och de fick enligt uppgift bara betala upp till 2 USD i timmen. Vissa lämnades störda efter att ha granskat obscent NSFW-text så länge.

Även om GPT-4 kan hjälpa till att automatiskt moderera innehåll, krävs fortfarande människor eftersom tekniken inte är idiotsäker, sa OpenAI. Som har visats tidigare är det möjligt att stavfel i giftiga kommentarer kan undvika upptäckt, och andra tekniker som t.ex snabba injektionsattacker kan användas för att åsidosätta chatbotens skyddsräcken.

"Vi använder GPT-4 för utveckling av innehållspolicy och beslut om innehållsmoderering, vilket möjliggör mer konsekvent märkning, en snabbare feedbackloop för policyförfining och mindre engagemang från mänskliga moderatorer," sa OpenAI:s team. ®

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Fordon / elbilar, Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- ChartPrime. Höj ditt handelsspel med ChartPrime. Tillgång här.

- BlockOffsets. Modernisera miljökompensation ägande. Tillgång här.

- Källa: https://go.theregister.com/feed/www.theregister.com/2023/08/16/gpt4_moderate_content/

- : har

- :är

- :inte

- :var

- $UPP

- 7

- a

- Able

- tillgång

- Enligt

- noggrannhet

- Uppnå

- faktiska

- faktiskt

- anpassa

- rådgivning

- Efter

- mot

- AI

- algoritmer

- tillåts

- redan

- också

- an

- analysera

- och

- någon

- api

- API-åtkomst

- uppskatta

- tillvägagångssätt

- ÄR

- argued

- AS

- At

- Automat

- automatiskt

- Förbjuda

- BE

- därför att

- varit

- tro

- tror

- Bättre

- biz

- Blockera

- Bot

- Föra

- SLUTRESULTAT

- belastning

- by

- KAN

- bil

- försiktigt

- fall

- byta

- Förändringar

- chatbot

- ChatGPT

- klar

- klassificera

- CO

- kommentarer

- Företag

- jämfört

- konsekvent

- konsekvent

- innehåll

- skapa

- cykel

- Dagar

- beslutar

- beslut

- beskriva

- beskriven

- utformade

- Detektering

- Utveckling

- digital

- do

- dokumentation

- gör

- ner

- drog

- kant

- möjliggör

- tillräckligt

- helt

- exempel

- förklaring

- MISSLYCKAS

- Misslyckades

- snabbare

- återkoppling

- flaggad

- följer

- efter

- För

- från

- framtida

- genereras

- generering

- ges

- Goel

- riktlinjer

- hammaren

- skadliga

- Har

- hjälpa

- här.

- Anställa

- timme

- ÖPPETTIDER

- Hur ser din drömresa ut

- How To

- HTTPS

- humant

- Människa

- identifiera

- if

- genomföra

- in

- Inklusive

- ingång

- Omedelbart

- istället

- instruktioner

- inblandning

- isn

- IT

- iteration

- DESS

- Jobb

- jpg

- Kenya

- känd

- lab

- märkning

- språk

- Large

- LÄRA SIG

- vänster

- mindre

- Lång

- gjord

- göra

- tillverkare

- malware

- Match

- Materialet

- mentala

- saknas

- Blanda

- modell

- måttfullhet

- månader

- mer

- mycket

- Behöver

- behövs

- Nya

- Nästa

- nu

- NSFW

- antal

- Nötskal

- of

- Erbjudanden

- on

- nätet

- endast

- OpenAI

- or

- Övriga

- ut

- skisse

- åsidosätta

- egen

- betalas

- Tidigare

- rörledning

- plattform

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- Strategier

- policy

- positiv

- möjlig

- Förutsägelser

- bearbetning

- ordentligt

- egenskapen

- fråga

- snabbt

- rasistiskt

- RE

- reducerande

- förfina

- tillförlitlighet

- förlita

- ta bort

- avlägsnas

- upprepa

- begära

- Obligatorisk

- begränsa

- resulterande

- Resultat

- översyn

- reviewing

- regler

- s

- Säkerhet

- Nämnda

- Samma

- säga

- Skala

- screening

- se

- in

- sexistiskt

- delas

- skall

- visas

- Visar

- eftersom

- Small

- mindre

- So

- Mjukvara

- några

- någonstans

- specifik

- tal

- Ange

- bo

- Fortfarande

- påkänning

- sådana

- system

- grupp

- tekniker

- Teknologi

- tiotals

- testa

- än

- den där

- Smakämnen

- Framtiden

- stöld

- deras

- sedan

- Dessa

- saker

- detta

- de

- fastän?

- tusentals

- Således

- till

- Rör

- trafik

- Tåg

- tränad

- Tisdag

- typiskt

- tills

- uppdaterad

- Uppdateringar

- uppdatering

- användning

- Begagnade

- Användare

- användare

- med hjälp av

- Kontra

- syn

- var

- we

- ogräs

- VÄL

- były

- medan

- om

- med

- Arbete

- arbetare

- fungerar

- zephyrnet