Bias-detektering i data och modellresultat är ett grundläggande krav för att bygga modeller för ansvarsfull artificiell intelligens (AI) och maskininlärning (ML). Tyvärr är det inte en lätt uppgift att upptäcka bias för de allra flesta utövare på grund av det stora antalet sätt som det kan mätas på och olika faktorer som kan bidra till ett partiskt resultat. Till exempel kan ett obalanserat urval av träningsdata resultera i en modell som är mindre exakt för vissa delmängder av data. Bias kan också introduceras av själva ML-algoritmen – även med en välbalanserad träningsdatauppsättning kan resultaten gynna vissa delmängder av data jämfört med andra.

För att upptäcka bias måste du ha en grundlig förståelse för olika typer av bias och motsvarande bias mått. Till exempel, när detta skrivs, Amazon SageMaker Clarify erbjuder 21 olika mätvärden att välja mellan.

I det här inlägget använder vi ett användningsfall för inkomstförutsägelse (förutsäger användarinkomster från indatafunktioner som utbildning och antal arbetade timmar per vecka) för att visa olika typer av fördomar och motsvarande mätvärden i SageMaker Clarify. Vi utvecklar också ett ramverk som hjälper dig att bestämma vilka mätvärden som är viktiga för din applikation.

Introduktion till SageMaker Clarify

ML-modeller används i allt högre grad för att hjälpa till att fatta beslut inom en mängd olika domäner, såsom finansiella tjänster, hälsovård, utbildning och mänskliga resurser. I många situationer är det viktigt att förstå varför ML-modellen gjorde en specifik förutsägelse och även om förutsägelserna påverkades av bias.

SageMaker Clarify tillhandahåller verktyg för båda dessa behov, men i det här inlägget fokuserar vi bara på bias-detekteringsfunktionen. För att lära dig mer om förklarabarhet, kolla in Förklara fakta om Bundesliga Match xGoals med Amazon SageMaker Clarify.

SageMaker Clarify är en del av Amazon SageMaker, som är en helt hanterad tjänst för att bygga, träna och distribuera ML-modeller.

Exempel på frågor om partiskhet

För att grunda diskussionen är följande exempel på frågor som ML-byggare och deras intressenter kan ha angående partiskhet. Listan består av några generella frågor som kan vara relevanta för flera ML-applikationer, samt frågor om specifika applikationer som dokumenthämtning.

Du kan fråga, med tanke på intressegrupperna i träningsdatan (till exempel män vs. kvinnor) vilka mätvärden jag ska använda för att svara på följande frågor:

- Speglar grupprepresentationen i träningsdata den verkliga världen?

- Gynnar måletiketterna i träningsdata en grupp framför den andra genom att tilldela den mer positiva etiketter?

- Har modellen olika noggrannhet för olika grupper?

- I en modell vars syfte är att identifiera kvalificerade kandidater för anställning, har modellen samma precision för olika grupper?

- I en modell vars syfte är att hämta dokument som är relevanta för en ingångsfråga, hämtar modellen relevanta dokument från olika grupper i samma proportion?

I resten av det här inlägget utvecklar vi ett ramverk för hur man kan överväga att svara på dessa frågor och andra genom statistiken som finns tillgänglig i SageMaker Clarify.

Använd fall och sammanhang

Det här inlägget använder ett befintligt exempel på ett SageMaker Clarify-jobb från Rättvisa och förklarlighet med SageMaker Clarify anteckningsbok och förklarar de genererade biasmetriska värdena. Den bärbara datorn tränar en XGBoost-modell på UCI Adult dataset (Dua, D. och Graff, C. (2019). UCI Machine Learning Repository. Irvine, CA: University of California, School of Information and Computer Science).

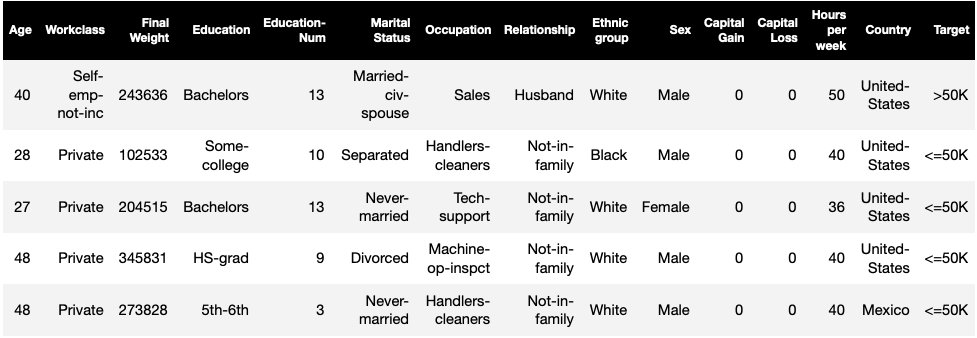

ML-uppgiften i denna datauppsättning är att förutsäga om en person har en årlig inkomst på mer eller mindre än $50,000 XNUMX. Följande tabell visar några instanser tillsammans med deras funktioner. Att mäta bias i inkomstförutsägelser är viktigt eftersom vi skulle kunna använda dessa förutsägelser för att informera beslut som rabatterbjudanden och riktad marknadsföring.

Bias terminologi

Innan vi dyker djupare, låt oss gå igenom några viktiga terminologier. För en fullständig lista över termer, se Amazon SageMaker klargör villkoren för partiskhet och rättvisa.

- etikett – Målfunktionen som ML-modellen är tränad att förutsäga. En observerad etikett hänvisar till etikettvärdet som observerats i data som används för att träna eller testa modellen. A förutspådd etikett är det värde som förutsägs av ML-modellen. Etiketter kan vara binära och är ofta kodade som 0 och 1. Vi antar att 1 representerar en gynnsam eller positiv etikett (till exempel inkomst mer än eller lika med $50,000 0), och XNUMX representerar en ogynnsam eller negativ etikett. Etiketter kan också bestå av fler än två värden. Även i dessa fall utgör ett eller flera av värdena gynnsamma märkningar. För enkelhetens skull tar det här inlägget endast hänsyn till binära etiketter. För information om hantering av etiketter med fler än två värden och etiketter med kontinuerliga värden (till exempel i regression), se Whitepaper för Amazon AI Fairness and Explainability.

- Aspekt – En kolumn eller funktion för vilken bias mäts. I vårt exempel är aspekten

sexoch tar två värden:womanochman, kodad somfemaleochmalei data (detta data extraheras från 1994 års folkräkning och upprätthåller en binär option). Även om inlägget tar hänsyn till en enskild aspekt med bara två värden, för mer komplexa fall som involverar flera aspekter eller aspekter med mer än två värden, se Whitepaper för Amazon AI Fairness and Explainability. - Bias – En betydande obalans i indata eller modellförutsägelser över olika aspektvärden. Vad som är "väsentligt" beror på din ansökan. För de flesta mätvärden innebär ett värde på 0 ingen obalans. Bias-mått i SageMaker Clarify är indelade i två kategorier:

- Förträning – När den förekommer indikerar förträningsbias endast obalanser i data.

- Efter träning – Bias efter träning tar dessutom hänsyn till modellernas förutsägelser.

Låt oss undersöka varje kategori separat.

Pretraining bias

Pretraining bias metrics i SageMaker Clarify svara på följande fråga: Har alla facettvärden lika (eller liknande) representation i data? Det är viktigt att inspektera data för pretraining-bias eftersom det kan översättas till posttraining-bias i modellförutsägelserna. Till exempel kan en modell tränad på obalanserad data där ett fasettvärde visas mycket sällan uppvisa avsevärt sämre noggrannhet för det fasettvärdet. Lika representation kan beräknas över följande:

- Hela träningsdatan oavsett etiketter

- Enbart delmängden av träningsdata med positiva etiketter

- Varje etikett separat

Följande figur ger en sammanfattning av hur varje mätvärde passar in i var och en av de tre kategorierna.

Vissa kategorier består av mer än ett mått. De grundläggande måtten (grå rutor) svarar på frågan om bias i den kategorin i enklaste form. Mätvärden i vita rutor täcker dessutom specialfall (till exempel Simpsons paradox) och användarpreferenser (till exempel fokus på vissa delar av befolkningen vid beräkning av prediktiv prestanda).

Fasettvärdesrepresentation oavsett etiketter

Det enda måttet i denna kategori är klassobalans (CI). Målet med detta mått är att mäta om alla fasettvärden har lika representation i data.

CI är skillnaden i andelen av data som utgörs av de två facettvärdena. I vårt exempeldataset, för facetten sex, visar uppdelningen (visas i cirkeldiagrammet) att kvinnor utgör 32.4 % av träningsdatan, medan män utgör 67.6 %. Som ett resultat:

CI = 0.676 - 0.324 = 0.352

En allvarlig obalans i hög klass kan leda till sämre prediktiv prestanda för fasettvärdet med mindre representation.

Fasettvärdesrepresentation endast på nivån för positiva etiketter

Ett annat sätt att mäta lika representation är att kontrollera om alla fasettvärden innehåller en liknande del av prover med positiva observerade etiketter. Positiva märkningar består av gynnsamma resultat (till exempel beviljade lån, utvalda för jobbet), så att analysera positiva märkningar separat hjälper till att bedöma om de gynnsamma besluten fördelas jämnt.

I vårt exempeldataset delas de observerade etiketterna upp i positiva och negativa värden, som visas i följande figur.

11.4 % av alla kvinnor och 31.4 % av alla män har den positiva etiketten (mörkt skuggat område i vänster och höger staplar). Skillnaden i positiva proportioner i etiketter (DPL) mäter denna skillnad.

DPL = 0.314 - 0.114 = 0.20

Det avancerade måttet i denna kategori, villkorlig demografisk skillnad i etiketter (CDDL), mäter skillnaderna i de positiva etiketterna, men stratifierar dem med avseende på en annan variabel. Detta mått hjälper till att kontrollera för Simpsons paradox, ett fall där en beräkning över hela data visar bias, men bias försvinner när data grupperas med avseende på viss sidoinformation.

Smakämnen 1973 UC Berkeley Admissions Study ger ett exempel. Enligt uppgifterna togs män in i högre takt än kvinnor. Men när de granskades på nivån för enskilda universitetsavdelningar antogs kvinnor i liknande eller högre takt vid varje institution. Denna observation kan förklaras av Simpsons paradox, som uppstod här eftersom kvinnor sökte sig till skolor som var mer konkurrenskraftiga. Som ett resultat antogs färre kvinnor totalt sett jämfört med män, även om de skola för skola antogs i samma eller högre takt.

För mer information om hur CDDL beräknas, se Whitepaper för Amazon AI Fairness and Explainability.

Fasettvärdesrepresentation på nivån för varje etikett separat

Jämställdhet i representation kan också mätas för varje enskild märkning, inte bara den positiva märkningen.

Mätvärden i denna kategori beräknar skillnaden i etikettfördelningen för olika aspektvärden. Etikettfördelningen för ett fasettvärde innehåller alla observerade etikettvärden, tillsammans med andelen prover med etikettens värde. Till exempel, i figuren som visar etikettfördelningar, har 88.6 % av kvinnorna en negativ observerad etikett och 11.4 % har en positiv observerad etikett. Så etikettfördelningen för kvinnor är [0.886, 0.114] och för män är [0.686, 0.314].

Det grundläggande måttet i denna kategori, Kullback-Leibler divergens (KL), mäter denna skillnad som:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

De avancerade måtten i denna kategori, Jensen-Shannon divergens (JS), Lp-norm (LP), Total Variation Distance (TVD) och Kolmogorov-Smirnov (KS), mäter också skillnaden mellan fördelningarna men har olika matematiska egenskaper. Utom i speciella fall kommer de att leverera insikter liknande KL. Till exempel, även om KL-värdet kan vara oändligt när ett fasettvärde inte innehåller några sampel med en viss etikett (till exempel inga män med en negativ etikett), undviker JS dessa oändliga värden. För mer detaljer om dessa skillnader, se Whitepaper för Amazon AI Fairness and Explainability.

Förhållandet mellan DPL (Kategori 2) och distributionsbaserade mätvärden för KL/JS/LP/TVD/KS (Kategori 3)

Distributionsbaserade mätvärden är mer naturligt tillämpliga på icke-binära etiketter. För binära etiketter, på grund av det faktum att obalans i den positiva etiketten kan användas för att beräkna obalansen i negativ etikett, levererar distributionsmåtten samma insikter som DPL. Därför kan du bara använda DPL i sådana fall.

Bias efter träning

Bias-mått efter träning i SageMaker Clarify hjälper oss att svara på två nyckelfrågor:

- Representeras alla facettvärden i samma takt i positiva (gynnsamma) modellförutsägelser?

- Har modellen liknande prediktiv prestanda för alla fasettvärden?

Följande figur visar hur mätvärdena kopplas till var och en av dessa frågor. Den andra frågan kan delas upp ytterligare beroende på vilken märkning prestandan mäts med avseende på.

Lika representation i positiva modellförutsägelser

Mätvärden i den här kategorin kontrollerar om alla aspektvärden innehåller en liknande del av prover med positiv förutsagd märkning av modellen. Denna klass av mått är mycket lik förträningsmåtten för DPL och CDDL – den enda skillnaden är att denna kategori tar hänsyn till förutspådda etiketter istället för observerade etiketter.

I vår exempeldatauppsättning tilldelas 4.5 % av alla kvinnor den positiva märkningen av modellen, och 13.7 % av alla män tilldelas den positiva märkningen.

Det grundläggande måttet i denna kategori, skillnad i positiva proportioner i förutspådda etiketter (DPPL), mäter skillnaden i de positiva klasstilldelningarna.

DPPL = 0.137 - 0.045 = 0.092

Lägg märke till hur en högre andel män i träningsdatan hade en positiv observerad märkning. På liknande sätt tilldelas en högre andel män en positiv förutspådd märkning.

För att gå vidare till de avancerade mätvärdena i denna kategori mäter Disparate Impact (DI) samma skillnad i positiva klasstilldelningar, men istället för skillnaden beräknar den förhållandet:

DI = 0.045 / 0.137 = 0.328

Både DI och DPPL förmedlar kvalitativt liknande insikter men skiljer sig åt i vissa hörnfall. Till exempel tenderar förhållandena att explodera till mycket stora tal om nämnaren är liten. Ta ett exempel på siffrorna 0.1 och 0.0001. Förhållandet är 0.1/0.0001 = 10,000 0.1 medan skillnaden är 0.0001 – 0.1 ≈ 0. Till skillnad från de andra mätvärdena där ett värde på 1 innebär ingen bias, för DI motsvarar ingen bias värdet XNUMX.

Conditional Demographic Disparity in Predicted Labels (CDDPL) mäter skillnaden i fasettvärdesrepresentation i den positiva etiketten, men precis som förträningsmåttet för CDDL, kontrollerar den också för Simpsons paradox.

Counterfactual Fliptest (FT) mäter om liknande prover från de två facettvärdena får liknande beslut från modellen. En modell som tilldelar olika beslut till två prover som liknar varandra men skiljer sig i fasettvärden kan anses vara partisk mot att fasettvärdet tilldelas den ogynnsamma (negativa) etiketten. Givet det första facettvärdet (kvinnor) bedömer det om liknande medlemmar med det andra facettvärdet (män) har en annan modellförutsägelse. Liknande medlemmar väljs baserat på k-närmaste granne-algoritmen.

Lika prestanda

Modellförutsägelserna kan ha liknande representation i positiva etiketter från olika aspektvärden, men modellens prestanda på dessa grupper kan skilja sig markant. I många applikationer kan det vara önskvärt att ha en liknande prediktiv prestanda över olika aspektvärden. Mätvärdena i den här kategorin mäter skillnaden i prediktiv prestanda över fasettvärden.

Eftersom data kan delas upp på många olika sätt baserat på de observerade eller förutspådda etiketterna, finns det många olika sätt att mäta prediktiv prestanda.

Lika prediktiv prestanda oavsett etiketter

Du kan överväga modellens prestanda på hela data, oavsett observerade eller förutspådda etiketter – det vill säga den övergripande noggrannheten.

Följande figurer visar hur modellen klassificerar indata från de två facettvärdena i vårt exempeldataset. Sanna negativa (TN) är fall där både den observerade och förutsagda märkningen var 0. Falskt positiva (FP) är felklassificeringar där den observerade märkningen var 0 men den förutsagda märkningen var 1. Sant positiva (TP) och falska negativa (FN) definieras liknande.

|

|

För varje fasettvärde är modellens övergripande prestanda, det vill säga noggrannheten för det fasettvärdet:

Noggrannhet = (TN + TP🇧🇷TN + FP + FN + TP)

Med denna formel är noggrannheten för kvinnor 0.930 och för män är 0.815. Detta leder till det enda måttet i denna kategori, noggrannhetsskillnad (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 betyder att noggrannheten för båda grupperna är densamma. Större (positiva eller negativa) värden indikerar större skillnader i noggrannhet.

Lika prestanda endast på positiva etiketter

Du kan begränsa modellprestandaanalysen till enbart positiva etiketter. Om applikationen till exempel handlar om att upptäcka defekter på ett löpande band kan det vara önskvärt att kontrollera att icke-defekta delar (positiv etikett) av olika slag (facettvärden) klassificeras som icke-defekta i samma takt. Denna kvantitet kallas återkallelse, eller sann positiv frekvens:

Recall = TP / (TP + FN)

I vår exempeldatauppsättning är återkallelsen för kvinnor 0.389 och återkallelsen för män är 0.425. Detta leder till det grundläggande måttet i denna kategori, Recall Difference (RD):

RD = 0.425 - 0.389 = 0.036

Låt oss nu överväga de tre avancerade mätvärdena i den här kategorin, se vilka användarpreferenser de kodar och hur de skiljer sig från grundmåttet för RD.

För det första, istället för att mäta prestandan på de positiva observerade etiketterna, kan du mäta den på de positivt förutsagda etiketterna. Givet ett fasettvärde, som kvinnor, och alla prover med det fasettvärdet som förutspås vara positiva av modellen, hur många är egentligen korrekt klassificerade som positiva? Denna kvantitet kallas acceptansgrad (AR), eller precision:

AR = TP / (TP + FP)

I vårt exempel är AR för kvinnor 0.977 och AR för män är 0.970. Detta leder till skillnaden i acceptansgrad (DAR):

DAR = 0.970 - 0.977 = -0.007

Ett annat sätt att mäta bias är genom att kombinera de två föregående mätvärdena och mäta hur många fler positiva förutsägelser modellerna tilldelar ett fasettvärde jämfört med de observerade positiva etiketterna. SageMaker Clarify mäter denna fördel med modellen som förhållandet mellan antalet observerade positiva etiketter för det fasettvärdet och antalet förutsagda positiva etiketter, och hänvisar till det som villkorlig acceptans (CA):

CA = (TP + FN🇧🇷TP + FP)

I vårt exempel är CA för kvinnor 2.510 och för män är 2.283. Skillnaden i CA leder till det sista måttet i denna kategori, Difference in Conditional Acceptance (DCA):

DCA = 2.283 - 2.510 = -0.227

Lika prestanda endast på negativa etiketter

På ett sätt som liknar positiva etiketter kan bias också beräknas som prestandaskillnaden på de negativa etiketterna. Att överväga negativa etiketter separat kan vara viktigt i vissa applikationer. Till exempel, i vårt defektdetekteringsexempel, kanske vi vill upptäcka defekta delar (negativ etikett) av olika slag (facettvärde) i samma takt.

Det grundläggande måttet i denna kategori, specificitet, är analogt med återkallningsmåttet (true positive rate). Specificitet beräknar modellens noggrannhet på prover med detta fasettvärde som har en observerad negativ etikett:

specificitet = TN / (TN + FP)

I vårt exempel (se förväxlingstabellerna) är specificiteten för kvinnor och män 0.999 respektive 0.994. Följaktligen Specificitetsskillnad (SD) är:

SD = 0.994 - 0.999 = -0.005

Går vi vidare, precis som acceptansgraden, är den analoga kvantiteten för negativa etiketter – avvisningsfrekvensen (RR) –:

RR = TN / (TN + FN)

RR för kvinnor är 0.927 och för män är 0.791, vilket leder till måttet Difference in Rejection Rate (DRR):

DRR = 0.927 - 0.791 = -0.136

Slutligen är den negativa etikettanalogen för villkorlig acceptans, villkorligt avslag (CR), förhållandet mellan antalet observerade negativa etiketter för det fasettvärdet och antalet förutsagda negativa etiketter:

CR = (TN + FP🇧🇷TN + FN)

CR för kvinnor är 0.928 och för män är 0.796. Det sista måttet i denna kategori är Difference in Conditional Rejection (DCR):

DCR = 0.796 - 0.928 = 0.132

Lika prestanda på positiva eller negativa etiketter

SageMaker Clarify kombinerar de två föregående kategorierna genom att beakta modellprestandaförhållandet på de positiva och negativa etiketterna. Specifikt, för varje fasettvärde, beräknar SageMaker Clarify förhållandet mellan falska negativa (FN) och falska positiva (FP). I vårt exempel är FN/FP-förhållandet för kvinnor 679/10 = 67.9 och för män är 3678/84 = 43.786. Detta leder till måttet Treatment Equality (TE), som mäter skillnaden mellan FP/FN-förhållandet:

TE = 67.9 - 43.786 = 24.114

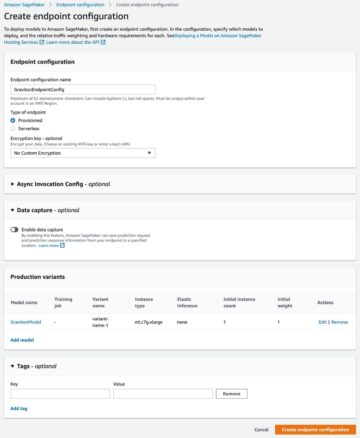

Följande skärmdump visar hur du kan använda SageMaker Clarify med Amazon SageMaker Studio för att visa värdena samt intervall och korta beskrivningar av olika bias-mått.

Frågor om bias: Vilka mätvärden ska man börja med?

Kom ihåg exempelfrågorna om partiskhet i början av det här inlägget. Efter att ha gått igenom mätvärdena från olika kategorier, överväg frågorna igen. För att besvara den första frågan, som rör representationerna av olika grupper i träningsdatan, kan du börja med måttet Class Obalans (CI). På samma sätt, för de återstående frågorna, kan du börja med att titta på skillnaden i positiva proportioner i etiketter (DPL), precisionsskillnad (AD), skillnad i acceptansgrad (DAR) respektive återkallningsskillnad (RD).

Bias utan facettvärden

För enkelhetens skull uteslöt denna beskrivning av mätvärden för efterträning det generaliserade entropiindexet (GE). Detta mått mäter bias utan att ta hänsyn till fasettvärdet och kan vara till hjälp för att bedöma hur modellfelen är fördelade. För detaljer, se Generaliserad entropi (GE).

Slutsats

I det här inlägget såg du hur de 21 olika måtten i SageMaker Clarify mäter bias i olika stadier av ML-pipelinen. Du lärde dig om olika mätvärden via ett användningsfall för inkomstförutsägelse, hur du väljer mätvärden för ditt användningsfall och vilka du kan börja med.

Kom igång med din ansvarsfulla AI-resa genom att bedöma fördomar i dina ML-modeller genom att använda demo-anteckningsboken Rättvisa och förklarbarhet med SageMaker Clarify. Du kan hitta den detaljerade dokumentationen för SageMaker Clarify, inklusive den formella definitionen av mått, på Vad är rättvisa och modellförklaring för maskininlärningsförutsägelser. För öppen källkod-implementering av bias-måtten, se aws-sagemaker-clarify GitHub-förrådet. För en detaljerad diskussion inklusive begränsningar, se Whitepaper för Amazon AI Fairness and Explainability.

Om författarna

Bilal Zafar är en tillämpad vetenskapsman på AWS, som arbetar med rättvisa, förklarlighet och säkerhet i maskininlärning.

Bilal Zafar är en tillämpad vetenskapsman på AWS, som arbetar med rättvisa, förklarlighet och säkerhet i maskininlärning.

Denis V. Batalov är en lösningsarkitekt för AWS, specialiserad på maskininlärning. Han har varit på Amazon sedan 2005. Denis har en doktorsexamen inom området AI. Följ honom på Twitter: @dbatalov.

Michele Donini är Sr Applied Scientist vid AWS. Han leder ett team av forskare som arbetar med ansvarsfull AI och hans forskningsintressen är Algorithmic Fairness och Explainable Machine Learning.

Michele Donini är Sr Applied Scientist vid AWS. Han leder ett team av forskare som arbetar med ansvarsfull AI och hans forskningsintressen är Algorithmic Fairness och Explainable Machine Learning.

- AI

- ai konst

- ai art generator

- har robot

- Amazon SageMaker

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- AWS maskininlärning

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- maskininlärning

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- skala ai

- syntax

- zephyrnet