Idag är vi glada att kunna meddela att Llama 2-fundamentmodeller utvecklade av Meta är tillgängliga för kunder via Amazon SageMaker JumpStart. Llama 2-familjen av stora språkmodeller (LLM) är en samling förtränade och finjusterade generativa textmodeller som sträcker sig i skala från 7 miljarder till 70 miljarder parametrar. Finjusterade LLM:er, kallade Llama-2-chat, är optimerade för dialoganvändningsfall. Du kan enkelt prova dessa modeller och använda dem med SageMaker JumpStart, som är ett nav för maskininlärning (ML) som ger tillgång till algoritmer, modeller och ML-lösningar så att du snabbt kan komma igång med ML.

I det här inlägget går vi igenom hur man använder Llama 2-modeller via SageMaker JumpStart.

Vad är Llama 2

Llama 2 är en autoregressiv språkmodell som använder en optimerad transformatorarkitektur. Llama 2 är avsedd för kommersiell och forskningsanvändning på engelska. Den finns i en rad parameterstorlekar – 7 miljarder, 13 miljarder och 70 miljarder – såväl som förtränade och finjusterade varianter. Enligt Meta använder de avstämda versionerna övervakad finjustering (SFT) och förstärkningsinlärning med mänsklig feedback (RLHF) för att anpassa sig till mänskliga preferenser för hjälpsamhet och säkerhet. Llama 2 var förtränad på 2 biljoner tokens data från allmänt tillgängliga källor. De avstämda modellerna är avsedda för assistentliknande chatt, medan förtränade modeller kan anpassas för en mängd olika naturliga språkgenereringsuppgifter. Oavsett vilken version av modellen en utvecklare använder, guide för ansvarsfull användning från Meta kan hjälpa till att vägleda ytterligare finjusteringar som kan vara nödvändiga för att anpassa och optimera modellerna med lämpliga säkerhetsbegränsningar.

Vad är SageMaker JumpStart

Med SageMaker JumpStart kan ML-utövare välja från ett brett urval av grundmodeller med öppen källkod. ML-utövare kan distribuera grundmodeller till dedikerade Amazon SageMaker instanser från en nätverksisolerad miljö och anpassa modeller med SageMaker för modellträning och implementering.

Du kan nu upptäcka och distribuera Llama 2 med några få klick in Amazon SageMaker Studio eller programmatiskt genom SageMaker Python SDK, vilket gör att du kan härleda modellprestanda och MLOps-kontroller med SageMaker-funktioner som t.ex. Amazon SageMaker-rörledningar, Amazon SageMaker Debugger, eller behållarloggar. Modellen distribueras i en AWS säker miljö och under dina VPC-kontroller, vilket hjälper till att säkerställa datasäkerhet. Llama 2-modeller är tillgängliga idag i Amazon SageMaker Studio, initialt i us-east 1 och us-west 2 regioner.

Upptäck modeller

Du kan komma åt grundmodellerna genom SageMaker JumpStart i SageMaker Studio UI och SageMaker Python SDK. I det här avsnittet går vi igenom hur du upptäcker modellerna i SageMaker Studio.

SageMaker Studio är en integrerad utvecklingsmiljö (IDE) som tillhandahåller ett enda webbaserat visuellt gränssnitt där du kan komma åt specialbyggda verktyg för att utföra alla ML-utvecklingssteg, från att förbereda data till att bygga, träna och distribuera dina ML-modeller. För mer information om hur du kommer igång och konfigurerar SageMaker Studio, se Amazon SageMaker Studio.

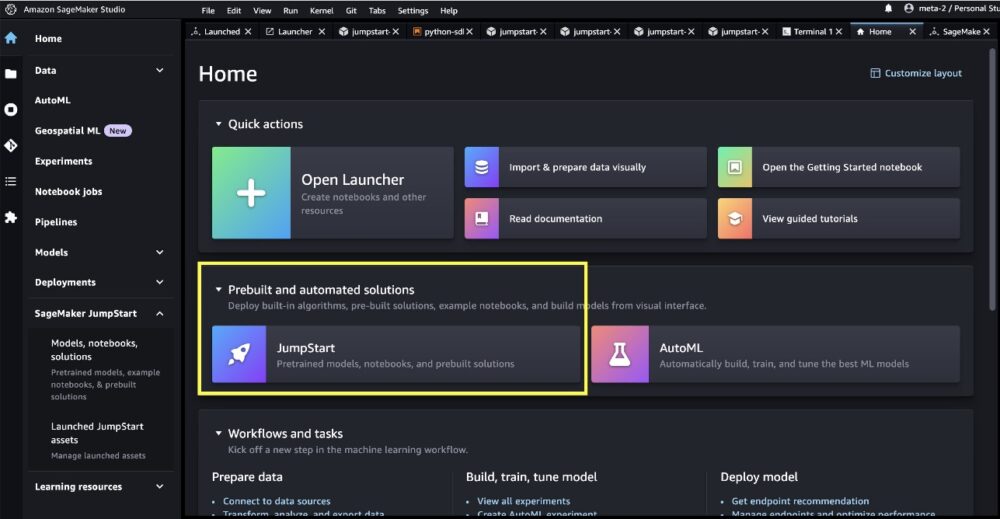

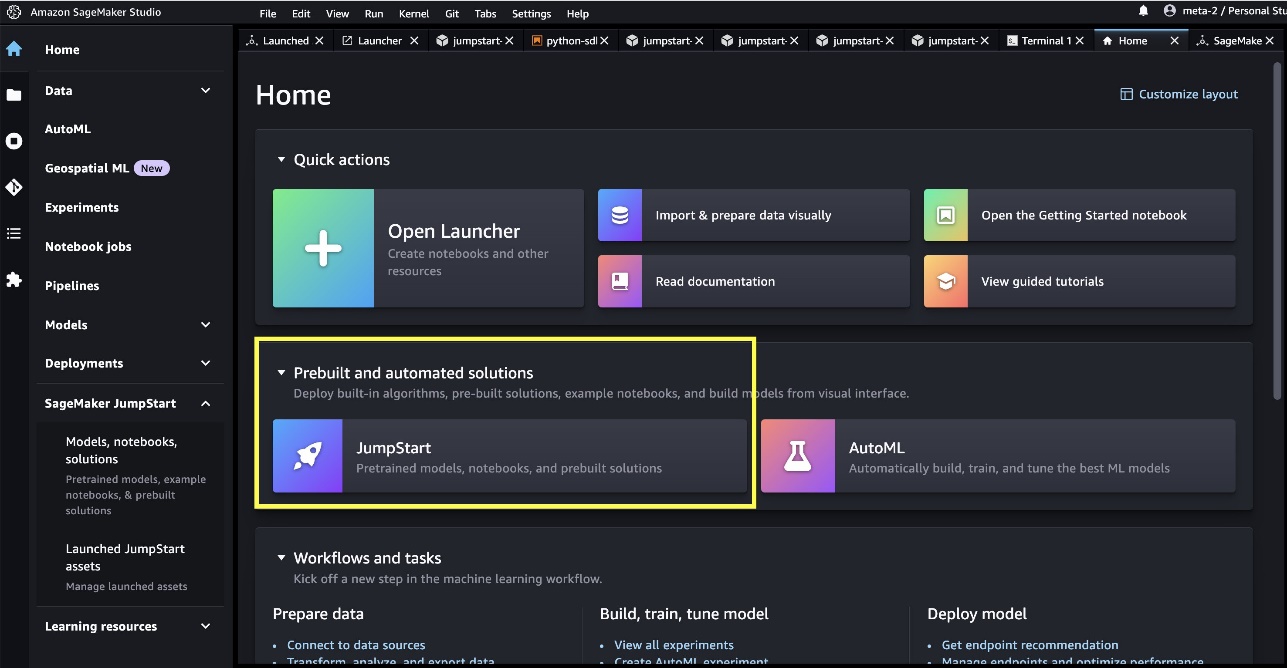

När du väl är på SageMaker Studio kan du komma åt SageMaker JumpStart, som innehåller förutbildade modeller, bärbara datorer och förbyggda lösningar, under Förbyggda och automatiserade lösningar.

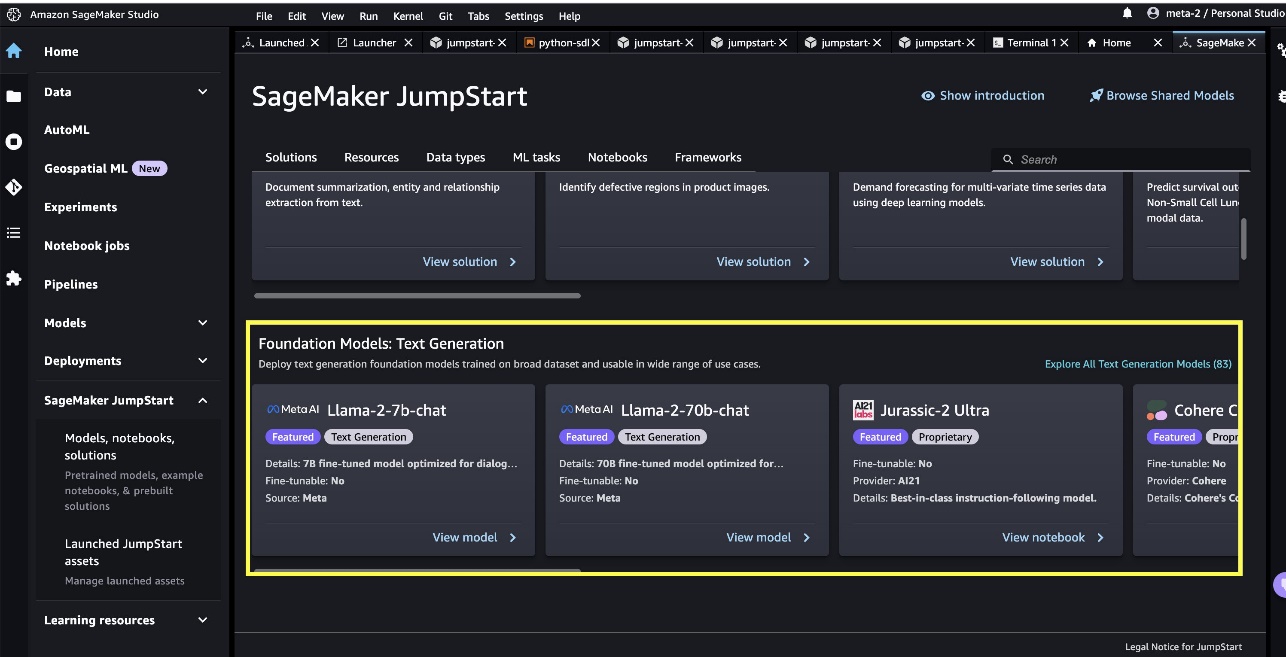

Från SageMaker JumpStart-målsidan kan du söka efter lösningar, modeller, bärbara datorer och andra resurser. Du kan hitta två flaggskepp Llama 2-modeller i Grundmodeller: Textgenerering karusell. Om du inte ser Llama 2-modeller, uppdatera din SageMaker Studio-version genom att stänga av och starta om. För mer information om versionsuppdateringar, se Stäng av och uppdatera Studio-appar.

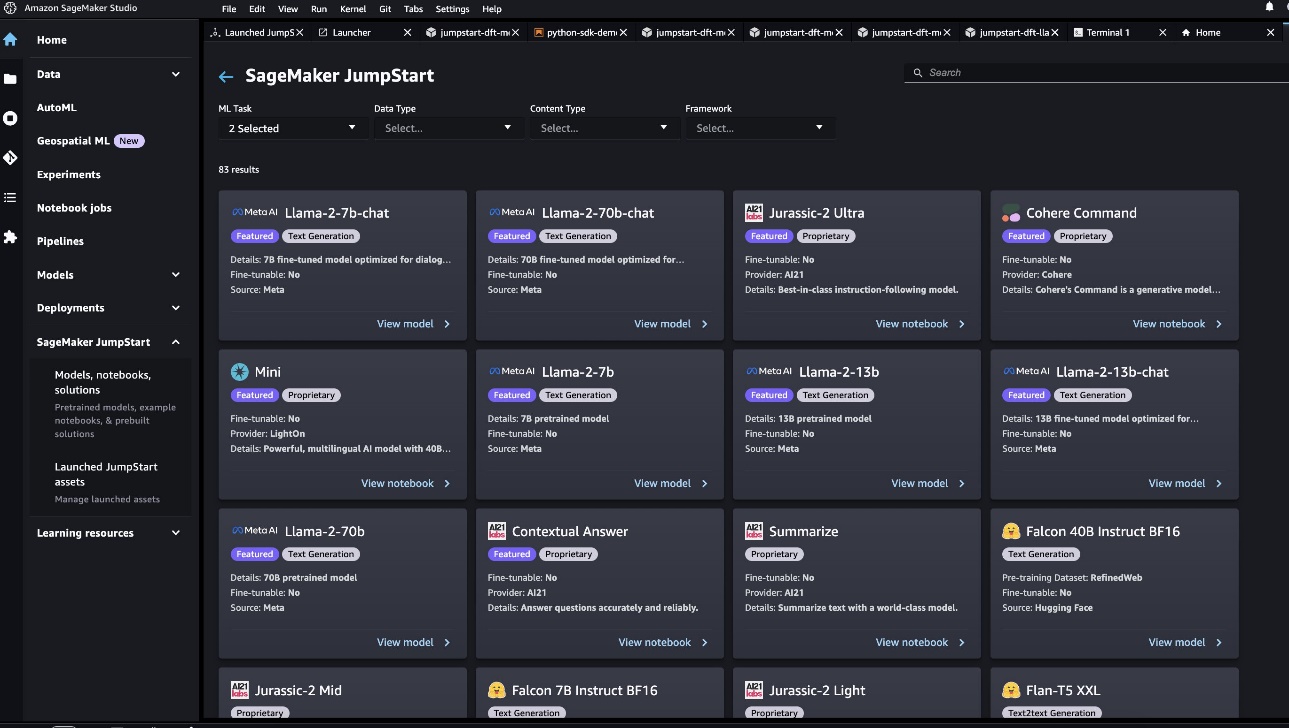

Du kan även hitta andra fyra modellvarianter genom att välja Utforska alla textgenereringsmodeller eller söker efter llama i sökrutan.

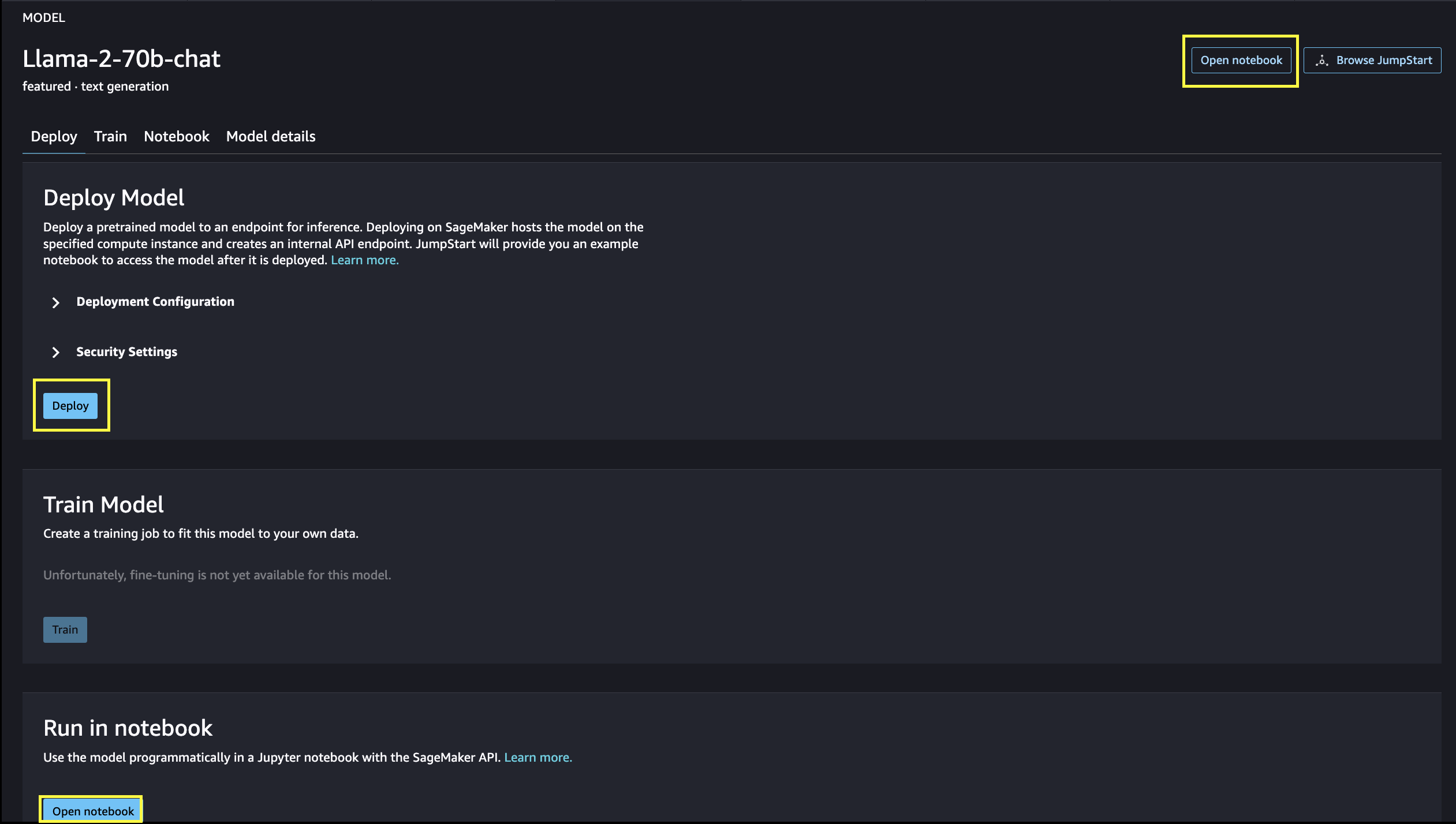

Du kan välja modellkortet för att se detaljer om modellen såsom licens, data som används för att träna och hur du använder den. Du kan också hitta två knappar, Distribuera och Öppna Notebook, som hjälper dig att använda modellen.

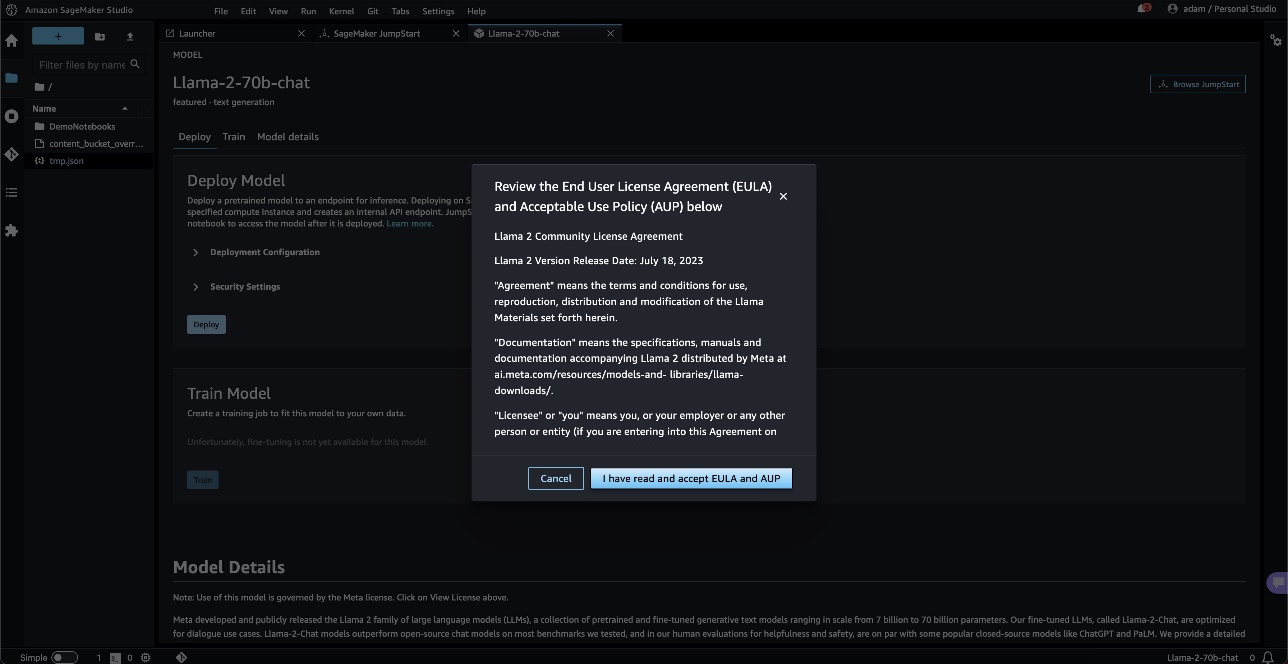

När du väljer någon av knapparna kommer ett popup-fönster att visa slutanvändarlicensavtalet och policyn för acceptabel användning som du kan bekräfta.

När du har bekräftat går du vidare till nästa steg för att använda modellen.

Distribuera en modell

När du väljer Distribuera och bekräfta villkoren, kommer modellimplementeringen att börja. Alternativt kan du distribuera via exempelanteckningsboken som dyker upp genom att välja Öppna Notebook. Exemplet på anteckningsboken ger vägledning från början till slut om hur man distribuerar modellen för slutledning och städar upp resurser.

För att distribuera med en bärbar dator börjar vi med att välja en lämplig modell, specificerad av model_id. Du kan distribuera vilken som helst av de valda modellerna på SageMaker med följande kod:

Detta distribuerar modellen på SageMaker med standardkonfigurationer, inklusive standardinstanstyp och standard VPC-konfigurationer. Du kan ändra dessa konfigurationer genom att ange icke-standardvärden i JumpStartModel. Efter att den har distribuerats kan du köra slutledning mot den distribuerade slutpunkten genom SageMaker-prediktorn:

Finjusterade chattmodeller (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) accepterar en chatthistorik mellan användaren och chattassistenten och genererar den efterföljande chatten. De förtränade modellerna (Llama-2-7b, Llama-2-13b, Llama-2-70b) kräver en strängprompt och utför textkomplettering på den angivna prompten. Se följande kod:

Observera att som standard, accept_eula är inställt på falskt. Du måste ställa in accept_eula=true för att anropa slutpunkten framgångsrikt. Genom att göra det accepterar du användarlicensavtalet och policyn för acceptabel användning som nämnts tidigare. Du kan också ladda ner licensavtalet.

Custom_attributes som används för att passera EULA är nyckel-/värdepar. Nyckeln och värdet separeras med = och par är åtskilda av ;. Om användaren skickar samma nyckel mer än en gång, behålls det sista värdet och skickas till skripthanteraren (dvs., i detta fall, används för villkorlig logik). Till exempel om accept_eula=false; accept_eula=true skickas sedan till servern accept_eula=true hålls och skickas till skripthanteraren.

Inferensparametrar styr textgenereringsprocessen vid slutpunkten. Den maximala kontrollen för nya tokens hänvisar till storleken på utdata som genereras av modellen. Observera att detta inte är detsamma som antalet ord eftersom modellens ordförråd inte är detsamma som det engelska ordförrådet, och varje token kanske inte är ett engelskspråkigt ord. Temperaturen styr slumpmässigheten i utgången. Högre temperatur resulterar i mer kreativa och hallucinerade utgångar. Alla inferensparametrar är valfria.

Följande tabell listar alla Llama-modeller som finns tillgängliga i SageMaker JumpStart tillsammans med model_ids, standardinstanstyper och det maximala antalet totala tokens (summan av antalet inmatade tokens och antalet genererade tokens) som stöds för var och en av dessa modeller.

| Modellnamn | Modell-ID | Max totalt antal tokens | Standardinstanstyp |

| Lama-2-7b | meta-textgeneration-llama-2-7b | 4096 | ml.g5.2xlarge |

| Lama-2-7b-chatt | meta-textgeneration-llama-2-7b-f | 4096 | ml.g5.2xlarge |

| Lama-2-13b | meta-textgeneration-llama-2-13b | 4096 | ml.g5.12xlarge |

| Lama-2-13b-chatt | meta-textgeneration-llama-2-13b-f | 4096 | ml.g5.12xlarge |

| Lama-2-70b | meta-textgeneration-llama-2-70b | 4096 | ml.g5.48xlarge |

| Lama-2-70b-chatt | meta-textgeneration-llama-2-70b-f | 4096 | ml.g5.48xlarge |

Observera att SageMaker-slutpunkter har en tidsgräns på 60s. Således, även om modellen kan generera 4096 tokens, kommer begäran att misslyckas om textgenereringen tar mer än 60s. För modellerna 7B, 13B och 70B rekommenderar vi att du ställer in max_new_tokens inte mer än 1500, 1000 respektive 500, samtidigt som det totala antalet tokens är mindre än 4K.

Slutlednings- och exempelmeddelanden för Llama-2-70b

Du kan använda lamamodeller för textkomplettering för vilken text som helst. Genom textgenerering kan du utföra en mängd olika uppgifter, som att svara på frågor, språköversättning, sentimentanalys och många fler. Inmatad nyttolast till slutpunkten ser ut som följande kod:

Följande är några exempel på uppmaningar och texten som genereras av modellen. Alla utgångar genereras med inferensparametrar {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

I nästa exempel visar vi hur man använder lamamodeller med få skott i sammanhangsinlärning, där vi tillhandahåller träningsexempel som är tillgängliga för modellen. Observera att vi bara drar slutsatser om den utplacerade modellen och under denna process ändras inte modellvikterna.

Slutlednings- och exempeluppmaningar för Llama-2-70b-chat

Med Llama-2-Chat-modeller, som är optimerade för dialoganvändningsfall, är input till chattmodellens slutpunkter den tidigare historiken mellan chattassistenten och användaren. Du kan ställa frågor kontextuella till konversationen som har hänt hittills. Du kan också tillhandahålla systemkonfigurationen, till exempel personas som definierar chattassistentens beteende. Indatanyttolasten till slutpunkten ser ut som följande kod:

Följande är några exempel på uppmaningar och texten som genereras av modellen. Alla utgångar genereras med inferensparametrarna {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

I följande exempel har användaren haft ett samtal med assistenten om turistplatser i Paris. Därefter frågar användaren om det första alternativet som rekommenderas av chattassistenten.

I följande exempel ställer vi in systemets konfiguration:

Städa upp

När du är klar med att köra anteckningsboken, se till att ta bort alla resurser så att alla resurser som du skapade i processen raderas och din fakturering stoppas:

Slutsats

I det här inlägget visade vi hur du kommer igång med Llama 2-modeller i SageMaker Studio. Med detta har du tillgång till sex Llama 2-grundmodeller som innehåller miljarder parametrar. Eftersom grundmodeller är förutbildade kan de också hjälpa till att sänka utbildnings- och infrastrukturkostnader och möjliggöra anpassning för ditt användningsfall. För att komma igång med SageMaker JumpStart, besök följande resurser:

Om författarna

Juni vann är produktchef hos SageMaker JumpStart. Han fokuserar på att göra grundmodeller lätta att upptäcka och använda för att hjälpa kunder att bygga generativa AI-applikationer. Hans erfarenhet på Amazon inkluderar även mobil shoppingapplikation och sista mil leverans.

Juni vann är produktchef hos SageMaker JumpStart. Han fokuserar på att göra grundmodeller lätta att upptäcka och använda för att hjälpa kunder att bygga generativa AI-applikationer. Hans erfarenhet på Amazon inkluderar även mobil shoppingapplikation och sista mil leverans.

Dr. Vivek Madan är en tillämpad forskare med Amazon SageMaker JumpStart-teamet. Han tog sin doktorsexamen från University of Illinois i Urbana-Champaign och var postdoktor vid Georgia Tech. Han är en aktiv forskare inom maskininlärning och algoritmdesign och har publicerat artiklar på EMNLP-, ICLR-, COLT-, FOCS- och SODA-konferenser.

Dr. Vivek Madan är en tillämpad forskare med Amazon SageMaker JumpStart-teamet. Han tog sin doktorsexamen från University of Illinois i Urbana-Champaign och var postdoktor vid Georgia Tech. Han är en aktiv forskare inom maskininlärning och algoritmdesign och har publicerat artiklar på EMNLP-, ICLR-, COLT-, FOCS- och SODA-konferenser.  Dr Kyle Ulrich är en tillämpad forskare med Amazon SageMaker JumpStart-teamet. Hans forskningsintressen inkluderar skalbara maskininlärningsalgoritmer, datorseende, tidsserier, Bayesianska icke-parametriska och Gaussiska processer. Hans doktorsexamen är från Duke University och han har publicerat artiklar i NeurIPS, Cell och Neuron.

Dr Kyle Ulrich är en tillämpad forskare med Amazon SageMaker JumpStart-teamet. Hans forskningsintressen inkluderar skalbara maskininlärningsalgoritmer, datorseende, tidsserier, Bayesianska icke-parametriska och Gaussiska processer. Hans doktorsexamen är från Duke University och han har publicerat artiklar i NeurIPS, Cell och Neuron.  Dr Ashish Khetan är en Senior Applied Scientist med Amazon SageMaker JumpStart och hjälper till att utveckla maskininlärningsalgoritmer. Han tog sin doktorsexamen från University of Illinois Urbana-Champaign. Han är en aktiv forskare inom maskininlärning och statistisk slutledning och har publicerat många artiklar i NeurIPS, ICML, ICLR, JMLR, ACL och EMNLP-konferenser.

Dr Ashish Khetan är en Senior Applied Scientist med Amazon SageMaker JumpStart och hjälper till att utveckla maskininlärningsalgoritmer. Han tog sin doktorsexamen från University of Illinois Urbana-Champaign. Han är en aktiv forskare inom maskininlärning och statistisk slutledning och har publicerat många artiklar i NeurIPS, ICML, ICLR, JMLR, ACL och EMNLP-konferenser.  Sundar Ranganathan är Global Head of GenAI/Frameworks GTM Specialists på AWS. Han fokuserar på att utveckla GTM-strategi för stora språkmodeller, GenAI och storskaliga ML-arbetsbelastningar över AWS-tjänster som Amazon EC2, EKS, EFA, AWS Batch och Amazon SageMaker. Hans erfarenhet inkluderar ledande roller inom produktledning och produktutveckling på NetApp, Micron Technology, Qualcomm och Mentor Graphics.

Sundar Ranganathan är Global Head of GenAI/Frameworks GTM Specialists på AWS. Han fokuserar på att utveckla GTM-strategi för stora språkmodeller, GenAI och storskaliga ML-arbetsbelastningar över AWS-tjänster som Amazon EC2, EKS, EFA, AWS Batch och Amazon SageMaker. Hans erfarenhet inkluderar ledande roller inom produktledning och produktutveckling på NetApp, Micron Technology, Qualcomm och Mentor Graphics.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Fordon / elbilar, Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- BlockOffsets. Modernisera miljökompensation ägande. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- : har

- :är

- :inte

- :var

- $UPP

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360-graders

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- Able

- Om Oss

- Acceptera

- godtagbart

- tillgång

- tillgänglighet

- tillgänglig

- Enligt

- bekräfta

- tvärs

- aktiv

- lägga till

- tillsats

- Annat

- adress

- Efter

- igen

- mot

- Avtal

- AI

- algoritm

- algoritmer

- rikta

- Alla

- tillåter

- längs

- också

- alltid

- am

- amason

- Amazon EC2

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon SageMaker Studio

- Amazon Web Services

- amerikan

- an

- analys

- och

- och infrastruktur

- Meddela

- Annan

- svara

- vilken som helst

- någon

- Ansökan

- tillämpningar

- tillämpas

- uppskatta

- lämpligt

- Arc

- arkitektur

- ÄR

- Konst

- AS

- bistå

- Assistent

- At

- Atmosfär

- Sevärdheter

- Automatiserad

- tillgänglig

- AWS

- Banan

- grundläggande

- Slaget

- Bayesian

- BE

- vackert

- Skönhet

- blev

- därför att

- blir

- varit

- öl

- innan

- beteende

- Peking

- tro

- tros

- BÄST

- mellan

- fakturering

- Miljarder

- miljarder

- Svart

- Box

- Ha sönder

- hänförande

- bred

- SLUTRESULTAT

- Byggnad

- byggt

- men

- Knappen

- by

- kallas

- KAN

- kapital

- bil

- kortet

- Karusellen

- Vid

- fall

- KATT

- byta

- Chocolate

- Välja

- välja

- Stad

- klassiska

- koda

- samling

- kombinerad

- kombinerar

- kommer

- kommande

- kommersiella

- företag

- fullbordan

- dator

- Datorsyn

- konferenser

- säker

- konfiguration

- anses

- konstant

- konstruktion

- innehålla

- Behållare

- innehåller

- innehåll

- kontextuella

- fortsätta

- kontinuerligt

- kontroll

- kontroller

- Bekväm

- Konversation

- Kostar

- land

- mod

- täcka

- skapa

- skapas

- Kreativ

- kultur

- kultur

- Cup

- Kunder

- anpassning

- skräddarsy

- datum

- datasäkerhet

- dedicerad

- engagemang

- Standard

- definiera

- leverans

- distribuera

- utplacerade

- utplacera

- utplacering

- vecklas ut

- Designa

- utformade

- önskas

- destination

- destinationer

- detaljer

- utveckla

- utvecklade

- Utvecklare

- utveckla

- Utveckling

- dialog

- Skillnaden

- olika

- svårt

- Upptäck

- utmärkande

- do

- dokumentärer

- gör

- gjort

- inte

- fördubblats

- ner

- Duke

- hertig universitet

- under

- e

- varje

- Tidigare

- lätt

- lätt

- Edward

- Einstein

- antingen

- möjliggöra

- möjliggör

- änden

- början till slut

- Slutpunkt

- Teknik

- Engelska

- njuta

- tillräckligt

- säkerställa

- Miljö

- Utrustning

- Eter

- Även

- händelser

- alla

- exempel

- exempel

- exciterade

- erfarenhet

- experimentera

- experiment

- uttrycker

- MISSLYCKAS

- Misslyckades

- verkligt

- falsk

- familj

- kända

- långt

- feat

- skisserat

- Funktioner

- återkoppling

- fot

- få

- filmer

- slutlig

- Slutligen

- hitta

- Förnamn

- flaggskepp

- Flyta

- flöden

- fokuserar

- efter

- För

- Framåt

- hittade

- fundament

- fyra

- Frankrike

- franska

- från

- fullständigt

- ytterligare

- framtida

- Allmänt

- generera

- genereras

- generering

- generativ

- Generativ AI

- georgien

- skaffa sig

- Ge

- glas

- Välgörenhet

- Go

- kommer

- grafik

- stor

- större

- banbrytande

- Väx

- vägleda

- styra

- hade

- Handtag

- hänt

- lyckligt

- Hård

- hårt arbete

- Har

- har

- he

- huvud

- hjälpa

- hjälpa

- hjälper

- här.

- hi

- Hög

- högre

- hans

- historisk

- historia

- bostäder

- Hur ser din drömresa ut

- How To

- html

- HTTPS

- Nav

- humant

- i

- ikoniska

- Tanken

- if

- ii

- Illinois

- Inverkan

- importera

- med Esport

- imponerande

- in

- innefattar

- innefattar

- Inklusive

- Inkorporerad

- informationen

- Infrastruktur

- initialt

- ingång

- inspirerat

- inspirerande

- exempel

- Omedelbart

- instruktioner

- integrerade

- avsedd

- intressen

- Gränssnitt

- in

- isolerat

- IT

- DESS

- resa

- jpg

- bara

- hålla

- hålls

- Nyckel

- Snäll

- Vet

- känd

- landning

- landmärke

- språk

- Large

- storskalig

- största

- Efternamn

- Sent

- lansera

- Lagar

- Ledarskap

- LÄRA SIG

- Lär dig och växa

- inlärning

- t minst

- mindre

- nivåer

- Licens

- livet

- ljus

- tycka om

- BEGRÄNSA

- listor

- litteraturen

- ll

- Lama

- Logiken

- Lång

- länge sedan

- du letar

- UTSEENDE

- älskar

- älskade

- lägre

- Maskinen

- maskininlärning

- gjord

- göra

- GÖR

- Framställning

- ledning

- chef

- många

- förundras

- Materia

- maximal

- Maj..

- betyder

- mäta

- Media

- Medium

- nämnts

- meddelande

- meta

- mikron

- minut

- minuter

- blandning

- ML

- MLOps

- Mobil

- modell

- modeller

- ögonblick

- månader

- mer

- mest

- Mest populär

- rörelse

- film

- mycket

- museum

- museer

- Musik

- namn

- Natural

- nödvändigt för

- Behöver

- behövs

- nät

- Nya

- New York

- Nästa

- Nej

- anteckningsbok

- nu

- antal

- talrik

- NY

- of

- erbjudanden

- erbjuda

- Erbjudanden

- Olja

- on

- gång

- ONE

- endast

- öppet

- öppen källkod

- Optimera

- optimerad

- Alternativet

- or

- Övriga

- Övrigt

- annat

- vår

- ut

- produktion

- över

- övergripande

- sida

- par

- Papper

- papper

- parameter

- parametrar

- paris

- del

- passera

- Godkänd

- passerar

- Tidigare

- fred

- Utföra

- prestanda

- permanenta

- telefon

- Fotografierna

- Fysik

- bit

- Pizza

- plast

- plato

- Platon Data Intelligence

- PlatonData

- spelat

- policy

- pop-up

- Populära

- Inlägg

- post

- Predictor

- preferenser

- förbereda

- presentera

- föregående

- process

- processer

- Produkt

- produktutveckling

- produktledning

- produktchef

- förslag

- stolt

- ge

- förutsatt

- ger

- tillhandahålla

- allmän

- kollektivtrafik

- publicly

- publicerade

- Syftet

- sätta

- Python

- Qualcomm

- frågor

- Snabbt

- snabbt

- ramper

- slumpmässighet

- område

- som sträcker sig

- redo

- skäl

- motta

- Receptet

- rekommenderar

- rekommenderas

- hänvisar

- Oavsett

- regioner

- relativ

- relativitet

- upprepade

- representerar

- begära

- Kräver

- forskning

- forskaren

- Resurser

- respektive

- Svara

- REST

- resultera

- Resultat

- River

- Roll

- roller

- Körning

- rinnande

- s

- Säkerhet

- sagemaker

- salt

- Samma

- skalbar

- Skala

- Forskare

- vetenskapsmän

- sDK

- HAV

- Sök

- söka

- §

- säkra

- säkerhet

- se

- se

- verkade

- vald

- väljer

- Val

- sända

- senior

- känsla

- Serier

- Tjänster

- portion

- in

- inställning

- Forma

- Haj

- Gå och Handla

- skall

- show

- visade

- Visar

- stänga

- signifikans

- signifikant

- Enkelt

- helt enkelt

- enda

- webbplats

- Områden

- SEX

- Storlek

- Långsamt

- Small

- So

- än så länge

- Social hållbarhet

- sociala medier

- Lösningar

- några

- Källa

- Källor

- speciell

- specialister

- specificerade

- fart

- står

- starta

- igång

- Ange

- Stater

- statistisk

- Steg

- Steg

- slutade

- Strategi

- Sträng

- struktur

- studio

- Bedövning

- ämne

- senare

- framgång

- Framgångsrikt

- sådana

- Som stöds

- säker

- Symbolen

- system

- bord

- Ta

- tar

- uppgifter

- smak

- grupp

- tech

- Teknologi

- temporär

- villkor

- än

- Tack

- den där

- Smakämnen

- Huvudstaden

- Framtiden

- källan

- världen

- deras

- Dem

- Teorin

- Där.

- Dessa

- de

- saker

- tror

- detta

- fastän?

- Genom

- Tiger mönster

- tid

- Tidsföljder

- gånger

- Titel

- till

- i dag

- tillsammans

- token

- tokens

- verktyg

- topp

- Totalt

- Torn

- Tåg

- Utbildning

- transformator

- Översätt

- Översättning

- transport

- Biljon

- prova

- två

- Typ

- typer

- ui

- under

- oförglömlig

- unika

- universitet

- tills

- Uppdatering

- Uppdateringar

- användbar

- användning

- användningsfall

- Begagnade

- Användare

- användare

- användningar

- med hjälp av

- värde

- Värden

- mängd

- version

- versioner

- mycket

- via

- utsikt

- visningar

- syn

- Besök

- besökare

- volym

- ville

- kriget

- var

- we

- webb

- webbservice

- Webb-baserad

- Webbplats

- VÄL

- Whale

- Vad

- Vad är

- när

- medan

- som

- medan

- varför

- kommer

- fönster

- med

- ord

- ord

- Arbete

- fungerar

- världen

- världsberömd

- linda

- år

- york

- Om er

- Din

- själv

- zephyrnet

- Postnummer