När organisationer distribuerar modeller till produktion, letar de ständigt efter sätt att optimera prestandan för sina grundmodeller (FM) som körs på de senaste acceleratorerna, som t.ex. AWS slutledning och GPU:er, så att de kan minska sina kostnader och minska svarslatens för att ge slutanvändarna den bästa upplevelsen. Vissa FM:er använder dock inte fullt ut de acceleratorer som finns tillgängliga med de instanser de är utplacerade på, vilket leder till en ineffektiv användning av hårdvaruresurser. Vissa organisationer distribuerar flera FM till samma instans för att bättre utnyttja alla tillgängliga acceleratorer, men detta kräver komplex infrastrukturorkestrering som är tidskrävande och svår att hantera. När flera FM-enheter delar samma instans har varje FM sina egna skalningsbehov och användningsmönster, vilket gör det svårt att förutsäga när du behöver lägga till eller ta bort instanser. Till exempel kan en modell användas för att driva en användarapplikation där användningen kan öka under vissa timmar, medan en annan modell kan ha ett mer konsekvent användningsmönster. Förutom att optimera kostnaderna vill kunderna ge den bästa slutanvändarupplevelsen genom att minska latensen. För att göra detta distribuerar de ofta flera kopior av en FM till fältförfrågningar från användare parallellt. Eftersom FM-utgångar kan sträcka sig från en enda mening till flera stycken, varierar tiden det tar att slutföra slutledningsbegäran avsevärt, vilket leder till oförutsägbara toppar i latens om förfrågningarna dirigeras slumpmässigt mellan instanserna. Amazon SageMaker stöder nu nya slutledningsfunktioner som hjälper dig att minska distributionskostnaderna och fördröjningen.

Du kan nu skapa inferenskomponentbaserade slutpunkter och distribuera modeller för maskininlärning (ML) till en SageMaker-slutpunkt. En slutledningskomponent (IC) abstraherar din ML-modell och gör att du kan tilldela processorer, GPU eller AWS Neuron acceleratorer och skalningspolicyer per modell. Inferenskomponenter erbjuder följande fördelar:

- SageMaker kommer optimalt att placera och packa modeller på ML-instanser för att maximera utnyttjandet, vilket leder till kostnadsbesparingar.

- SageMaker kommer att skala upp och ned varje modell baserat på din konfiguration för att möta dina ML-applikationskrav.

- SageMaker kommer att skala för att lägga till och ta bort instanser dynamiskt för att säkerställa att kapaciteten är tillgänglig samtidigt som inaktiv beräkning hålls till ett minimum.

- Du kan skala ner till noll kopior av en modell för att frigöra resurser för andra modeller. Du kan också ange att viktiga modeller alltid ska vara laddade och redo att betjäna trafik.

Med dessa funktioner kan du minska kostnaderna för modelldistribution med i genomsnitt 50 %. Kostnadsbesparingarna kommer att variera beroende på din arbetsbelastning och trafikmönster. Låt oss ta ett enkelt exempel för att illustrera hur packning av flera modeller på en enda slutpunkt kan maximera utnyttjandet och spara kostnader. Låt oss säga att du har en chattapplikation som hjälper turister att förstå lokala seder och bästa praxis byggd med två varianter av Llama 2: en finjusterad för europeiska besökare och den andra finjusterad för amerikanska besökare. Vi förväntar oss trafik för den europeiska modellen mellan 00:01–11:59 UTC och den amerikanska modellen mellan 12:00–23:59 UTC. Istället för att distribuera dessa modeller på sina egna dedikerade instanser där de kommer att vara inaktiva halva tiden, kan du nu distribuera dem på en enda slutpunkt för att spara kostnader. Du kan skala ner den amerikanska modellen till noll när det inte behövs för att frigöra kapacitet för den europeiska modellen och vice versa. Detta gör att du kan använda din hårdvara effektivt och undvika slöseri. Det här är ett enkelt exempel med två modeller, men du kan enkelt utöka denna idé till att packa hundratals modeller på en enda slutpunkt som automatiskt skalas upp och ner med din arbetsbelastning.

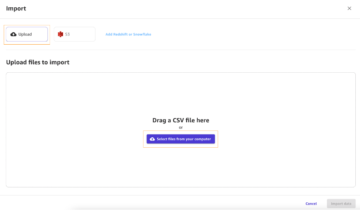

I det här inlägget visar vi dig de nya funktionerna hos IC-baserade SageMaker-ändpunkter. Vi leder dig också genom att distribuera flera modeller med hjälp av slutledningskomponenter och API:er. Slutligen beskriver vi några av de nya observerbarhetsfunktionerna och hur du ställer in policyer för automatisk skalning för dina modeller och hanterar instansskalning för dina slutpunkter. Du kan också distribuera modeller genom vår nya förenklade, interaktiva användarupplevelse. Vi stöder också avancerade routingfunktioner för att optimera latensen och prestanda för dina slutledningsarbetsbelastningar.

Byggblock

Låt oss ta en djupare titt och förstå hur dessa nya funktioner fungerar. Följande är lite ny terminologi för SageMaker-värd:

- Slutledningskomponent – Ett SageMaker-värdobjekt som du kan använda för att distribuera en modell till en slutpunkt. Du kan skapa en slutledningskomponent genom att ange följande:

- SageMaker-modellen eller specifikation av en SageMaker-kompatibel bild och modellartefakter.

- Beräkningsresurskrav, som specificerar behoven för varje kopia av din modell, inklusive CPU-kärnor, värdminne och antal acceleratorer.

- Modellexemplar – En körtidskopia av en slutledningskomponent som kan betjäna förfrågningar.

- Hanterad instans automatisk skalning – En SageMaker-värdfunktion för att skala upp eller ned antalet beräkningsinstanser som används för en slutpunkt. Instansskalning reagerar på skalningen av inferenskomponenter.

För att skapa en ny slutledningskomponent kan du ange en behållarbild och en modellartefakt, eller så kan du använda SageMaker-modeller som du kanske redan har skapat. Du måste också specificera beräkningsresurskraven såsom antalet värd-CPU-kärnor, värdminne eller antalet acceleratorer som din modell behöver för att köra.

När du distribuerar en slutledningskomponent kan du ange MinCopies för att säkerställa att modellen redan är laddad i den mängd som du behöver, redo att betjäna förfrågningar.

Du har också möjlighet att ställa in dina policyer så att slutledningskomponenten kopierar skala till noll. Till exempel, om du inte har någon laddning som körs mot en IC, kommer modellkopian att laddas ur. Detta kan frigöra resurser som kan ersättas av aktiva arbetsbelastningar för att optimera utnyttjandet och effektiviteten av din slutpunkt.

När slutledningsförfrågningar ökar eller minskar, kan antalet kopior av dina IC:er också skalas upp eller ned baserat på din automatiska skalningspolicy. SageMaker kommer att hantera placeringen för att optimera packningen av dina modeller för tillgänglighet och kostnad.

Dessutom, om du aktiverar hanterad instans automatisk skalning, kommer SageMaker att skala beräkningsinstanser enligt antalet slutledningskomponenter som behöver laddas vid en given tidpunkt för att betjäna trafik. SageMaker kommer att skala upp instanserna och packa dina instanser och slutledningskomponenter för att optimera för kostnaden samtidigt som modellens prestanda bevaras. Även om vi rekommenderar användning av hanterad instansskalning, har du också möjlighet att hantera skalningen själv, om du skulle välja det, genom automatisk skalning av programmet.

SageMaker kommer att balansera inferenskomponenter och skala ner instanserna om de inte längre behövs av inferenskomponenter och sparar dina kostnader.

Genomgång av API:er

SageMaker har introducerat en ny enhet som heter InferenceComponent. Detta frikopplar detaljerna för att vara värd för ML-modellen från själva slutpunkten. De InferenceComponent låter dig ange nyckelegenskaper för modellen som värd, som SageMaker-modellen du vill använda eller behållardetaljer och modellartefakter. Du anger också antalet kopior av själva komponenterna som ska distribueras, och antalet acceleratorer (GPU, Inf eller Trn acceleratorer) eller CPU (vCPU) som krävs. Detta ger dig mer flexibilitet att använda en enda slutpunkt för valfritt antal modeller du planerar att distribuera till den i framtiden.

Låt oss titta på Boto3 API-anrop för att skapa en slutpunkt med en slutledningskomponent. Observera att det finns några parametrar som vi tar upp senare i detta inlägg.

Följande är exempelkod för CreateEndpointConfig:

Följande är exempelkod för CreateEndpoint:

Följande är exempelkod för CreateInferenceComponent:

Denna frikoppling av InferenceComponent till en slutpunkt ger flexibilitet. Du kan vara värd för flera modeller på samma infrastruktur, lägga till eller ta bort dem när dina krav ändras. Varje modell kan uppdateras oberoende efter behov. Dessutom kan du skala modeller efter dina affärsbehov. InferenceComponent låter dig också styra kapaciteten per modell. Med andra ord kan du bestämma hur många kopior av varje modell som ska vara värd. Denna förutsägbara skalning hjälper dig att möta de specifika latenskraven för varje modell. Övergripande, InferenceComponent ger dig mycket mer kontroll över dina värdmodeller.

I följande tabell visar vi en jämförelse sida vid sida av högnivåmetoden för att skapa och anropa en slutpunkt utan InferenceComponent och med InferenceComponent. Observera att CreateModel() nu är valfritt för IC-baserade slutpunkter.

| Steg | Modellbaserade slutpunkter | Slutpunkter komponentbaserade slutpunkter |

| 1 | Skapa modell(...) | CreateEndpointConfig(...) |

| 2 | CreateEndpointConfig(...) | Skapa slutpunkt(...) |

| 3 | Skapa slutpunkt(...) | CreateInferenceComponent(...) |

| 4 | InvokeEndpoint(...) | InvokeEndpoint(InferneceComponentName='värde'...) |

Införandet av InferenceComponent låter dig skala på modellnivå. Ser Fördjupa dig i instans- och IC-automatisk skalning för mer information om hur InferenceComponent fungerar med automatisk skalning.

När du anropar SageMaker-slutpunkten kan du nu ange den nya parametern InferenceComponentName för att träffa önskat InferenceComponentName. SageMaker kommer att hantera dirigering av begäran till instansen som är värd för den begärda InferenceComponentName. Se följande kod:

Som standard använder SageMaker slumpmässig routing av förfrågningarna till de instanser som backar din slutpunkt. Om du vill aktivera routing av minst utestående förfrågningar kan du ställa in routingstrategin i slutpunktskonfigurationens RoutingConfig:

Minst utestående förfrågningar dirigerar rutter till de specifika instanserna som har mer kapacitet att behandla förfrågningar. Detta kommer att ge mer enhetlig lastbalansering och resursutnyttjande.

Utöver CreateInferenceComponent, följande API:er är nu tillgängliga:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

InferenceComponent loggar och mätvärden

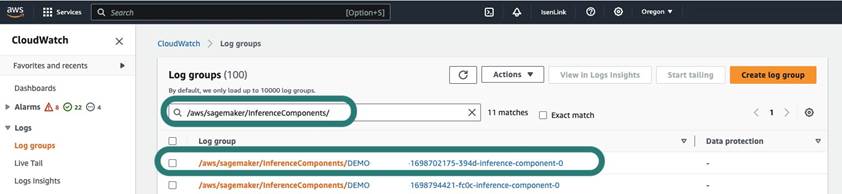

InferenceComponent loggar finns i /aws/sagemaker/InferenceComponents/<InferenceComponentName>. Alla loggar som skickas till stderr och stdout i behållaren skickas till dessa inloggningar amazoncloudwatch.

Med introduktionen av IC-baserade slutpunkter har du nu möjlighet att se ytterligare instansmått, slutledningskomponentmått och anropsmått.

För SageMaker-instanser kan du nu spåra GPUReservation och CPUReservation mätvärden för att se resurserna reserverade för en slutpunkt baserat på slutledningskomponenterna som du har distribuerat. Dessa mätvärden kan hjälpa dig att dimensionera dina slutpunkter och policyer för automatisk skalning. Du kan också se de sammanställda mätvärdena som är kopplade till alla modeller som distribueras till en slutpunkt.

SageMaker exponerar också mätvärden på en slutledningskomponentnivå, vilket kan visa en mer detaljerad bild av användningen av resurser för de slutledningskomponenter som du har distribuerat. Detta gör att du kan få en bild av hur mycket aggregerat resursutnyttjande som t.ex GPUUtilizationNormalized och GPUMemoryUtilizationNormalized för varje slutledningskomponent du har distribuerat som kan ha noll eller många kopior.

Slutligen tillhandahåller SageMaker anropsmått, som nu spårar anrop för inferenskomponenter aggregerat (Invocations) eller per exemplar instansierad (InvocationsPerCopy)

För en omfattande lista över mätvärden, se SageMaker Endpoint Invocation Metrics.

Automatisk skalning på modellnivå

För att implementera det automatiska skalningsbeteendet som vi beskrev, när du skapar SageMaker-slutpunktskonfigurationen och slutledningskomponenten, definierar du det initiala antalet instanser respektive det initiala antalet kopior. När du har skapat slutpunkten och motsvarande IC:er, för att tillämpa automatisk skalning på IC-nivå, måste du först registrera skalningsmålet och sedan associera skalningsprincipen till IC:n.

När vi implementerar skalningspolicyn använder vi SageMakerInferenceComponentInvocationsPerCopy, vilket är ett nytt mått som introducerats av SageMaker. Den fångar det genomsnittliga antalet anrop per modellkopia per minut.

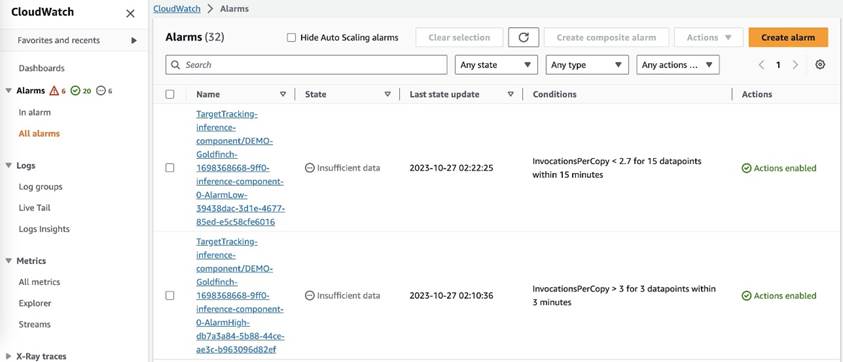

Efter att du har ställt in skalningspolicyn skapar SageMaker två CloudWatch-larm för varje autoskalningsmål: ett för att utlösa utskalning vid larm i 3 minuter (tre 1-minuters datapunkter) och ett för att utlösa inskalning om i larm i 15 minuter (15 1-minuters datapunkter), som visas i följande skärmdump. Tiden för att utlösa skalningsåtgärden är vanligtvis 1–2 minuter längre än dessa minuter eftersom det tar tid för slutpunkten att publicera mätvärden till CloudWatch, och det tar också tid för AutoScaling att reagera. Nedkylningsperioden är hur lång tid, i sekunder, efter att en in- eller utskalningsaktivitet har slutförts innan en annan utskalningsaktivitet kan starta. Om nedskalningen är kortare än uppdateringstiden för slutpunkten, har den ingen effekt, eftersom det inte är möjligt att uppdatera en SageMaker-slutpunkt när den är i Uppdaterar status.

Observera att när du ställer in automatisk skalning på IC-nivå måste du se till att MaxInstanceCount parametern är lika med eller mindre än det maximala antalet IC:er som denna endpoint kan hantera. Till exempel, om din slutpunkt bara är konfigurerad att ha en instans i slutpunktskonfigurationen och den här instansen bara kan vara värd för maximalt fyra kopior av modellen, då MaxInstanceCount bör vara lika med eller mindre än 4. Du kan dock också använda den hanterade automatiska skalningskapaciteten som tillhandahålls av SageMaker för att automatiskt skala antalet instanser baserat på det antal kopior som krävs för att uppfylla behovet av fler beräkningsresurser. Följande kodavsnitt visar hur man ställer in hanterad instansskalning under skapandet av slutpunktskonfigurationen. På detta sätt, när den automatiska skalningen på IC-nivå kräver mer instansräkning för att vara värd för modellkopiorna, skalar SageMaker automatiskt ut instansnumret för att tillåta skalningen på IC-nivå att bli framgångsrik.

Du kan tillämpa flera principer för automatisk skalning mot samma slutpunkt, vilket innebär att du kommer att kunna tillämpa den traditionella automatiska skalningsprincipen på de slutpunkter som skapats med IC:er och skala upp och ned baserat på andra slutpunktsmått. För mer information, se Optimera din maskininlärning med automatisk skalning på Amazon SageMaker. Men även om detta är möjligt rekommenderar vi fortfarande att du använder hanterad instansskalning framför att hantera skalningen själv.

Slutsats

I det här inlägget introducerade vi en ny funktion i SageMaker inference som hjälper dig att maximera utnyttjandet av beräkningsinstanser, skala till hundratals modeller och optimera kostnaderna, samtidigt som du ger förutsägbar prestanda. Dessutom gav vi en genomgång av API:erna och visade dig hur du konfigurerar och distribuerar inferenskomponenter för dina arbetsbelastningar.

Vi stöttar också avancerade routingfunktioner för att optimera latensen och prestanda för dina slutledningsarbetsbelastningar. SageMaker kan hjälpa dig att optimera dina slutledningsarbetsbelastningar för kostnad och prestanda och ge dig granularitet på modellnivå för hantering. Vi har skapat en uppsättning anteckningsböcker som kommer att visa dig hur du distribuerar tre olika modeller, använder olika behållare och tillämpar policyer för automatisk skalning i GitHub. Vi uppmuntrar dig att börja med notebook 1 och komma igång med de nya SageMaker-värdfunktionerna idag!

Om författarna

James Park är en lösningsarkitekt på Amazon Web Services. Han arbetar med Amazon.com för att designa, bygga och distribuera tekniklösningar på AWS och har ett särskilt intresse för AI och maskininlärning. På fritiden tycker han om att söka nya kulturer, nya upplevelser och att hålla sig uppdaterad med de senaste tekniktrenderna. Du kan hitta honom på LinkedIn.

James Park är en lösningsarkitekt på Amazon Web Services. Han arbetar med Amazon.com för att designa, bygga och distribuera tekniklösningar på AWS och har ett särskilt intresse för AI och maskininlärning. På fritiden tycker han om att söka nya kulturer, nya upplevelser och att hålla sig uppdaterad med de senaste tekniktrenderna. Du kan hitta honom på LinkedIn.

Melanie Li, PhD, är en Senior AI/ML Specialist TAM vid AWS baserad i Sydney, Australien. Hon hjälper företagskunder att bygga lösningar med hjälp av toppmoderna AI/ML-verktyg på AWS och ger vägledning om arkitektur och implementering av ML-lösningar med bästa praxis. På fritiden älskar hon att utforska naturen och umgås med familj och vänner.

Melanie Li, PhD, är en Senior AI/ML Specialist TAM vid AWS baserad i Sydney, Australien. Hon hjälper företagskunder att bygga lösningar med hjälp av toppmoderna AI/ML-verktyg på AWS och ger vägledning om arkitektur och implementering av ML-lösningar med bästa praxis. På fritiden älskar hon att utforska naturen och umgås med familj och vänner.

Marc Karp är en ML-arkitekt med Amazon SageMaker Service-teamet. Han fokuserar på att hjälpa kunder att designa, distribuera och hantera ML-arbetsbelastningar i stor skala. På fritiden tycker han om att resa och utforska nya platser.

Marc Karp är en ML-arkitekt med Amazon SageMaker Service-teamet. Han fokuserar på att hjälpa kunder att designa, distribuera och hantera ML-arbetsbelastningar i stor skala. På fritiden tycker han om att resa och utforska nya platser.

Alan Tan är en Senior Product Manager hos SageMaker, som leder arbetet med att slutföra stora modeller. Han brinner för att tillämpa maskininlärning på analysområdet. Utanför jobbet tycker han om att vara utomhus.

Alan Tan är en Senior Product Manager hos SageMaker, som leder arbetet med att slutföra stora modeller. Han brinner för att tillämpa maskininlärning på analysområdet. Utanför jobbet tycker han om att vara utomhus.

Raghu Ramesha är senior ML Solutions Architect med Amazon SageMaker Service-teamet. Han fokuserar på att hjälpa kunder att bygga, distribuera och migrera ML-produktionsarbetsbelastningar till SageMaker i stor skala. Han är specialiserad på domäner för maskininlärning, AI och datorseende och har en magisterexamen i datavetenskap från UT Dallas. På fritiden tycker han om att resa och fotografera.

Raghu Ramesha är senior ML Solutions Architect med Amazon SageMaker Service-teamet. Han fokuserar på att hjälpa kunder att bygga, distribuera och migrera ML-produktionsarbetsbelastningar till SageMaker i stor skala. Han är specialiserad på domäner för maskininlärning, AI och datorseende och har en magisterexamen i datavetenskap från UT Dallas. På fritiden tycker han om att resa och fotografera.

Rupinder Grewal är en Sr Ai/ML Specialist Solutions Architect med AWS. Han fokuserar för närvarande på servering av modeller och MLOps på SageMaker. Innan denna roll har han arbetat som Machine Learning Engineer med att bygga och hosta modeller. Utanför jobbet tycker han om att spela tennis och cykla på bergsstigar.

Rupinder Grewal är en Sr Ai/ML Specialist Solutions Architect med AWS. Han fokuserar för närvarande på servering av modeller och MLOps på SageMaker. Innan denna roll har han arbetat som Machine Learning Engineer med att bygga och hosta modeller. Utanför jobbet tycker han om att spela tennis och cykla på bergsstigar.

Dhawal Patel är en huvudarkitekt för maskininlärning på AWS. Han har arbetat med organisationer som sträcker sig från stora företag till medelstora startups med problem relaterade till distribuerad datoranvändning och artificiell intelligens. Han fokuserar på djupinlärning inklusive NLP- och Computer Vision-domäner. Han hjälper kunder att uppnå högpresterande modellslutningar på SageMaker.

Dhawal Patel är en huvudarkitekt för maskininlärning på AWS. Han har arbetat med organisationer som sträcker sig från stora företag till medelstora startups med problem relaterade till distribuerad datoranvändning och artificiell intelligens. Han fokuserar på djupinlärning inklusive NLP- och Computer Vision-domäner. Han hjälper kunder att uppnå högpresterande modellslutningar på SageMaker.

Saurabh Trikande är senior produktchef för Amazon SageMaker Inference. Han brinner för att arbeta med kunder och motiveras av målet att demokratisera maskininlärning. Han fokuserar på kärnutmaningar relaterade till att distribuera komplexa ML-applikationer, multi-tenant ML-modeller, kostnadsoptimeringar och att göra implementeringen av djupinlärningsmodeller mer tillgänglig. På sin fritid gillar Saurabh att vandra, lära sig om innovativ teknik, följa TechCrunch och umgås med sin familj.

Saurabh Trikande är senior produktchef för Amazon SageMaker Inference. Han brinner för att arbeta med kunder och motiveras av målet att demokratisera maskininlärning. Han fokuserar på kärnutmaningar relaterade till att distribuera komplexa ML-applikationer, multi-tenant ML-modeller, kostnadsoptimeringar och att göra implementeringen av djupinlärningsmodeller mer tillgänglig. På sin fritid gillar Saurabh att vandra, lära sig om innovativ teknik, följa TechCrunch och umgås med sin familj.

Lakshmi Ramakrishnan är huvudingenjör på Amazon SageMaker Machine Learning (ML) plattformsteam i AWS, vilket ger tekniskt ledarskap för produkten. Han har arbetat i flera ingenjörsroller i Amazon i över 9 år. Han har en civilingenjörsexamen i informationsteknologi från National Institute of Technology, Karnataka, Indien och en magisterexamen i datavetenskap från University of Minnesota Twin Cities.

Lakshmi Ramakrishnan är huvudingenjör på Amazon SageMaker Machine Learning (ML) plattformsteam i AWS, vilket ger tekniskt ledarskap för produkten. Han har arbetat i flera ingenjörsroller i Amazon i över 9 år. Han har en civilingenjörsexamen i informationsteknologi från National Institute of Technology, Karnataka, Indien och en magisterexamen i datavetenskap från University of Minnesota Twin Cities.

David Nigenda är en senior mjukvaruutvecklingsingenjör i Amazon SageMaker-teamet, som för närvarande arbetar med att förbättra arbetsflöden för maskininlärning i produktionen, samt lanserar nya inferensfunktioner. På fritiden försöker han hålla jämna steg med sina barn.

David Nigenda är en senior mjukvaruutvecklingsingenjör i Amazon SageMaker-teamet, som för närvarande arbetar med att förbättra arbetsflöden för maskininlärning i produktionen, samt lanserar nya inferensfunktioner. På fritiden försöker han hålla jämna steg med sina barn.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- : har

- :är

- :inte

- :var

- $UPP

- 1

- 10

- 100

- 114

- 12

- 13

- 15%

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- förmåga

- Able

- Om Oss

- sammandrag

- acceleratorer

- tillgänglig

- Enligt

- Uppnå

- Handling

- aktiv

- aktivitet

- lägga till

- tillsats

- Dessutom

- Annat

- Dessutom

- adress

- avancerat

- Efter

- mot

- aggregat

- AI

- AI / ML

- Alan

- larm

- Alla

- tillåter

- tillåter

- redan

- också

- Även

- alltid

- amason

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- amerikan

- mängd

- an

- analytics

- och

- Annan

- vilken som helst

- api

- API: er

- Ansökan

- tillämpningar

- Ansök

- Tillämpa

- tillvägagångssätt

- ÄR

- OMRÅDE

- konstgjord

- artificiell intelligens

- AS

- Associate

- associerad

- At

- Australien

- bil

- automatiskt

- tillgänglighet

- tillgänglig

- genomsnitt

- undvika

- AWS

- stöd

- baserat

- BE

- därför att

- innan

- beteende

- Fördelarna

- BÄST

- bästa praxis

- Bättre

- mellan

- SLUTRESULTAT

- Byggnad

- byggt

- företag

- men

- by

- kallas

- Samtal

- KAN

- kapacitet

- kapacitet

- kapabel

- Kapacitet

- fångar

- vissa

- utmaningar

- utmanande

- byta

- Välja

- Städer

- koda

- COM

- jämförelse

- fullborda

- slutför

- komplex

- komponent

- komponenter

- omfattande

- Compute

- dator

- Datavetenskap

- Datorsyn

- databehandling

- konfiguration

- konfigurerad

- konsekvent

- ständigt

- tidskrävande

- Behållare

- Behållare

- kontroll

- Kärna

- Motsvarande

- Pris

- kostnadsbesparingar

- Kostar

- kunde

- skapa

- skapas

- skapar

- Skapa

- skapande

- För närvarande

- Kunder

- tullen

- Dallas

- datum

- datapunkter

- Datum

- minskning

- dedicerad

- djup

- djupt lärande

- djupare

- Standard

- definiera

- Examen

- gräva

- demokrati

- demonstrerar

- beroende

- distribuera

- utplacerade

- utplacera

- utplacering

- distributioner

- beskriven

- Designa

- önskas

- detalj

- detaljer

- Bestämma

- Utveckling

- olika

- svårt

- distribueras

- distribuerad databehandling

- do

- domäner

- inte

- ner

- under

- dynamiskt

- varje

- lätt

- effekt

- effektivitet

- effektivt

- ansträngningar

- möjliggöra

- aktiverad

- möjliggör

- uppmuntra

- Slutpunkt

- ingenjör

- Teknik

- säkerställa

- Företag

- företag

- enhet

- lika

- Giltigt körkort

- exempel

- förvänta

- erfarenhet

- Erfarenheter

- utforska

- Utforska

- förlänga

- familj

- Leverans

- Funktioner

- fält

- hitta

- Förnamn

- Flexibilitet

- fokuserar

- efter

- För

- fundament

- fyra

- Fri

- vänner

- från

- fullständigt

- Vidare

- framtida

- skaffa sig

- gif

- GitHub

- Ge

- ges

- ger

- Målet

- GPU

- GPUs

- grynig

- vägleda

- Hälften

- hantera

- händer

- hårdvara

- Har

- he

- hjälpa

- hjälpa

- hjälper

- här

- Hög

- högnivå

- honom

- hans

- Träffa

- innehar

- värd

- värd

- värd

- ÖPPETTIDER

- Hur ser din drömresa ut

- How To

- Men

- http

- HTTPS

- Hundratals

- Tanken

- Idle

- if

- illustrera

- bild

- genomföra

- genomföra

- med Esport

- förbättra

- in

- I andra

- Inklusive

- Öka

- oberoende av

- indien

- ineffektiv

- informationen

- informationsteknologi

- Infrastruktur

- inledande

- innovativa

- innovativa tekniker

- exempel

- istället

- Institute

- Intelligens

- interaktiva

- intresse

- in

- introducerade

- Beskrivning

- IT

- DESS

- sig

- jpg

- Ha kvar

- hålla

- Nyckel

- barn

- Large

- Stora företag

- slutligen

- Latens

- senare

- senaste

- lansera

- Ledarskap

- ledande

- inlärning

- t minst

- Nivå

- tycka om

- Lista

- Lama

- läsa in

- lokal

- belägen

- längre

- se

- du letar

- älskar

- Maskinen

- maskininlärning

- göra

- Framställning

- hantera

- förvaltade

- ledning

- chef

- hantera

- många

- Master

- master

- Maximera

- maximal

- Maj..

- betyder

- Möt

- Minne

- metriska

- Metrics

- migrera

- minsta

- minut

- minuter

- ML

- MLOps

- modell

- modeller

- mer

- motiverad

- Berg

- mycket

- multipel

- nationell

- Natur

- Behöver

- behövs

- behov

- Nya

- nlp

- Nej

- Notera

- anteckningsbok

- nu

- antal

- objektet

- of

- erbjudanden

- Ofta

- on

- ONE

- endast

- till

- Optimera

- optimera

- Alternativet

- or

- orkestrering

- organisationer

- Övriga

- vår

- ut

- utomhus

- utgångar

- utanför

- utestående

- över

- övergripande

- egen

- Pack

- Parallell

- parameter

- parametrar

- särskilt

- brinner

- Mönster

- mönster

- för

- prestanda

- perioden

- phd

- fotografi

- Plats

- placering

- platser

- Planen

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- i

- poäng

- Strategier

- policy

- möjlig

- Inlägg

- kraft

- praxis

- förutse

- Förutsägbar

- konservering

- Principal

- Innan

- problem

- process

- Produkt

- produktchef

- Produktion

- egenskaper

- ge

- förutsatt

- ger

- tillhandahålla

- publicera

- mängd

- slumpmässig

- område

- som sträcker sig

- Reagera

- reagerar

- redo

- balansera

- rekommenderar

- minska

- reducerande

- hänvisa

- registrera

- relaterad

- ta bort

- bort

- ersättas

- begära

- förfrågningar

- kräver

- Obligatorisk

- Krav

- Kräver

- reserverad

- resurs

- Resurser

- respektive

- respons

- Roll

- roller

- rutter

- routing

- Körning

- rinnande

- runtime

- sagemaker

- SageMaker Inference

- Samma

- Save

- Besparingar

- säga

- Skala

- skalor

- skalning

- Vetenskap

- sekunder

- se

- söker

- senior

- skickas

- mening

- tjänar

- service

- Tjänster

- portion

- in

- inställning

- flera

- Dela

- hon

- skall

- show

- visade

- visas

- signifikant

- Enkelt

- förenklade

- enda

- sitta

- Storlek

- mindre

- kodavsnitt

- So

- Mjukvara

- mjukvaruutveckling

- Lösningar

- några

- specialist

- specialiserat

- specifik

- specifikation

- spendera

- Spendera

- spik

- spikar

- starta

- Startups

- state-of-the-art

- status

- vistas

- Fortfarande

- Strategi

- framgångsrik

- sådana

- leverera

- stödja

- Stöder

- säker

- sydney

- bord

- Ta

- tar

- Målet

- grupp

- TechCrunch

- Teknisk

- Tekniken

- Teknologi

- tennis

- terminologi

- än

- den där

- Smakämnen

- Området

- Framtiden

- deras

- Dem

- sedan

- Där.

- Dessa

- de

- detta

- de

- tre

- Genom

- tid

- till

- verktyg

- spår

- traditionell

- trafik

- Traveling

- Trender

- utlösa

- dubbla

- två

- förstå

- universitet

- oförutsägbar

- Uppdatering

- uppdaterad

- Användning

- användning

- Begagnade

- Användare

- Användarupplevelse

- användare

- användningar

- med hjälp av

- vanligen

- UTC

- utnyttja

- vice

- utsikt

- syn

- besökare

- gå

- genomgång

- vill

- Avfall

- Sätt..

- sätt

- we

- webb

- webbservice

- VÄL

- när

- medan

- som

- medan

- kommer

- med

- utan

- ord

- Arbete

- arbetade

- arbetsflöden

- arbetssätt

- fungerar

- år

- Om er

- Din

- själv

- zephyrnet

- noll-