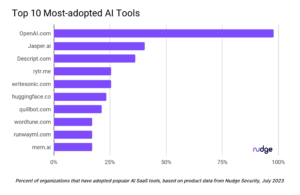

Maskininlärningsverktyg har varit en del av vanliga affärs- och IT-arbetsflöden i åratal, men den generativa AI-revolutionen som utvecklar sig driver en snabb ökning av både användning och medvetenhet om dessa verktyg. Även om AI erbjuder effektivitetsfördelar inom olika branscher, kräver dessa kraftfulla framväxande verktyg särskilda säkerhetsöverväganden.

Hur är Securing AI annorlunda?

Den nuvarande AI-revolutionen kan vara ny, men säkerhetsteam på Google och på andra håll har arbetat med AI-säkerhet i många år, om inte decennier. På många sätt, grundläggande principer för att säkra AI-verktyg är desamma som allmänna bästa praxis för cybersäkerhet. Behovet av att hantera åtkomst och skydda data genom grundläggande tekniker som kryptering och stark identitet förändras inte bara för att AI är inblandat.

Ett område där säkra AI är annorlunda är i aspekterna av datasäkerhet. AI-verktyg drivs – och i slutändan, programmerade – av data, vilket gör dem sårbara för nya attacker, som träningsdataförgiftning. Skadliga aktörer som kan mata AI-verktyget med felaktiga data (eller korrupta legitima träningsdata) kan potentiellt skada eller direkt bryta den på ett sätt som är mer komplext än vad som ses med traditionella system. Och om verktyget aktivt "lär sig" så att dess utdata ändras baserat på input över tiden, måste organisationer säkra det mot en avvikelse från dess ursprungliga avsedda funktion.

Med ett traditionellt (icke-AI) stort företagssystem är det du får ut av det vad du lägger i det. Du kommer inte att se en skadlig utdata utan en skadlig indata. Men som Google CISO Phil Venables sa i en podcast nyligen, "För att implementera [ett] AI-system måste du tänka på input- och outputhantering."

Komplexiteten hos AI-system och deras dynamiska natur gör dem svårare att säkra än traditionella system. Försiktighet måste iakttas både i ingångsstadiet, för att övervaka vad som går in i AI-systemet, och i slutskedet, för att säkerställa att utdata är korrekta och pålitliga.

Implementering av ett säkert AI-ramverk

Att skydda AI-systemen och förutse nya hot är högsta prioritet för att säkerställa att AI-systemen beter sig som avsett. Googles Secure AI Framework (SAIF) och dess Säkra AI: Liknande eller annorlunda? rapport är bra ställen att börja, som ger en översikt över hur man ska tänka på och hantera de särskilda säkerhetsutmaningarna och nya sårbarheter relaterade till utveckling av AI.

SAIF börjar med att skapa en tydlig förståelse för vilka AI-verktyg din organisation kommer att använda och vilken specifik affärsfråga de kommer att ta itu med. Att definiera detta i förväg är avgörande, eftersom det gör att du kan förstå vem i din organisation som kommer att vara involverad och vilken data verktyget behöver komma åt (vilket kommer att hjälpa till med den strikta datastyrning och innehållssäkerhetspraxis som krävs för att säkra AI). Det är också en bra idé att kommunicera lämpliga användningsfall och begränsningar för AI i hela din organisation; Denna policy kan hjälpa till att skydda mot inofficiell "skugg-IT"-användning av AI-verktyg.

Efter att ha tydligt identifierat verktygstyperna och användningsfallet bör din organisation sammansätta ett team för att hantera och övervaka AI-verktyget. Det teamet bör inkludera dina IT- och säkerhetsteam men också involvera ditt riskhanteringsteam och din juridiska avdelning, samt överväga integritets- och etiska problem.

När du har identifierat laget är det dags att börja träna. För att säkra AI ordentligt i din organisation måste du börja med en primer som hjälper alla att förstå vad verktyget är, vad det kan göra och var saker kan gå fel. När ett verktyg hamnar i händerna på anställda som inte är utbildade i AI:s förmågor och brister, ökar det risken avsevärt för en problematisk incident.

Efter att ha tagit dessa preliminära steg har du lagt grunden för att säkra AI i din organisation. Det finns sex kärnelement i Googles SAIF som du bör implementera, börja med säkra grunder som standard och gå vidare till att skapa effektiva korrigerings- och återkopplingscykler med rött teaming.

En annan viktig del av att säkra AI är att hålla människor i ögat så mycket som möjligt, samtidigt som man inser att manuell granskning av AI-verktyg kan vara bättre. Utbildning är avgörande när du utvecklas med att använda AI i din organisation – utbildning och omskolning, inte av själva verktygen, utan av dina team. När AI går bortom vad de faktiska människorna i din organisation förstår och kan dubbelkolla, ökar risken för problem snabbt.

AI-säkerheten utvecklas snabbt, och det är viktigt för de som arbetar på fältet att vara vaksamma. Det är avgörande att identifiera potentiella nya hot och utveckla motåtgärder för att förhindra eller mildra dem så att AI kan fortsätta att hjälpa företag och individer runt om i världen.

Läs mer Partner Perspectives från Google Cloud

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://www.darkreading.com/google-cloud-security/securing-ai-what-you-should-know

- :är

- :inte

- :var

- a

- Om Oss

- tillgång

- tvärs

- aktivt

- aktörer

- faktiska

- adress

- Antagande

- mot

- AI

- AI-system

- tillåter

- också

- an

- och

- förutse

- lämpligt

- ÄR

- OMRÅDE

- runt

- AS

- aspekter

- At

- Attacker

- medvetenhet

- bort

- baserat

- BE

- därför att

- varit

- börja

- Fördelarna

- BÄST

- bästa praxis

- Bättre

- Bortom

- båda

- Ha sönder

- företag

- men

- by

- KAN

- kapacitet

- vilken

- Vid

- fall

- utmaningar

- byta

- Förändringar

- CISO

- klar

- klart

- kommunicera

- komplex

- Komplexiteten

- oro

- överväganden

- med tanke på

- innehåll

- fortsätta

- Kärna

- korrekt

- kunde

- Skapa

- avgörande

- Aktuella

- Cybersäkerhet

- cykler

- datum

- datasäkerhet

- årtionden

- definierande

- Avdelning

- utveckla

- utveckla

- olika

- do

- doesn

- drivande

- dynamisk

- Effektiv

- effektivitet

- elementet

- element

- annorstädes

- smärgel

- anställda

- kryptering

- säkerställa

- Företag

- företag

- väsentlig

- upprättandet

- etisk

- alla

- utvecklas

- återkoppling

- fält

- bristfällig

- För

- fundament

- Stiftelser

- från

- fungera

- grundläggande

- Allmänt

- generativ

- Generativ AI

- skaffa sig

- Go

- kommer

- god

- fick

- styrning

- Guard

- händer

- hårdare

- Har

- hjälpa

- hjälper

- Hur ser din drömresa ut

- How To

- http

- HTTPS

- Människa

- Tanken

- identifierade

- identifiera

- identifiera

- Identitet

- if

- genomföra

- in

- incident

- innefattar

- Öka

- Ökar

- individer

- industrier

- ingång

- avsedd

- in

- engagera

- involverade

- fråga

- IT

- DESS

- jpg

- bara

- hålla

- Vet

- Large

- inlärning

- Adress

- legitim

- tycka om

- begränsningar

- GÖR

- Framställning

- hantera

- ledning

- Ledningsgrupp

- manuell

- många

- Maj..

- Mildra

- Övervaka

- mer

- förflyttar

- mycket

- måste

- Natur

- nödvändigt för

- Behöver

- Nya

- roman

- of

- Erbjudanden

- on

- or

- organisation

- organisationer

- ursprungliga

- ut

- produktion

- rent ut

- över

- Översikt

- del

- särskilt

- perspektiv

- PHIL

- platser

- plato

- Platon Data Intelligence

- PlatonData

- policy

- möjlig

- potentiell

- potentiellt

- drivs

- den mäktigaste

- praxis

- förhindra

- Principerna

- privatpolicy

- Problem

- programmerad

- Framsteg

- skrider

- ordentligt

- skydda

- tillhandahålla

- sätta

- snabbt

- snabb

- snabbt

- senaste

- känna igen

- relaterad

- förblir

- rapport

- kräver

- översyn

- Rotation

- Risk

- riskhanterings

- s

- Säkerhet

- Nämnda

- Samma

- säkra

- säkring

- säkerhet

- se

- sett

- skugga

- brister

- skall

- signifikant

- liknande

- So

- speciell

- specifik

- Etapp

- standard

- starta

- Starta

- startar

- Steg

- Strikt

- stark

- sådana

- system

- System

- tagen

- tar

- grupp

- lag

- tekniker

- än

- den där

- Smakämnen

- världen

- deras

- Dem

- sig själva

- Där.

- Dessa

- de

- saker

- tror

- detta

- de

- hot

- Genom

- tid

- till

- verktyg

- verktyg

- topp

- traditionell

- tränad

- Utbildning

- trovärdig

- typer

- Ytterst

- förstå

- förståelse

- uppvikning

- användning

- användningsfall

- användningar

- med hjälp av

- olika

- Ve

- avgörande

- sårbarheter

- Sårbara

- Sätt..

- VÄL

- Vad

- Vad är

- när

- som

- medan

- VEM

- kommer

- med

- utan

- Vann

- arbetade

- arbetsflöden

- arbetssätt

- världen

- Fel

- år

- Om er

- Din

- zephyrnet