Lanseringen av ChatGPT och ökande popularitet för generativ AI har fångat fantasin hos kunder som är nyfikna på hur de kan använda den här tekniken för att skapa nya produkter och tjänster på AWS, till exempel företagschattbotar, som är mer konverserande. Det här inlägget visar hur du kan skapa ett webbgränssnitt, som vi kallar Chat Studio, för att starta en konversation och interagera med grundmodeller som finns tillgängliga i Amazon SageMaker JumpStart som Llama 2, Stable Diffusion och andra modeller tillgängliga på Amazon SageMaker. När du har implementerat den här lösningen kan användare snabbt komma igång och uppleva funktionerna hos flera grundmodeller i konversations-AI via ett webbgränssnitt.

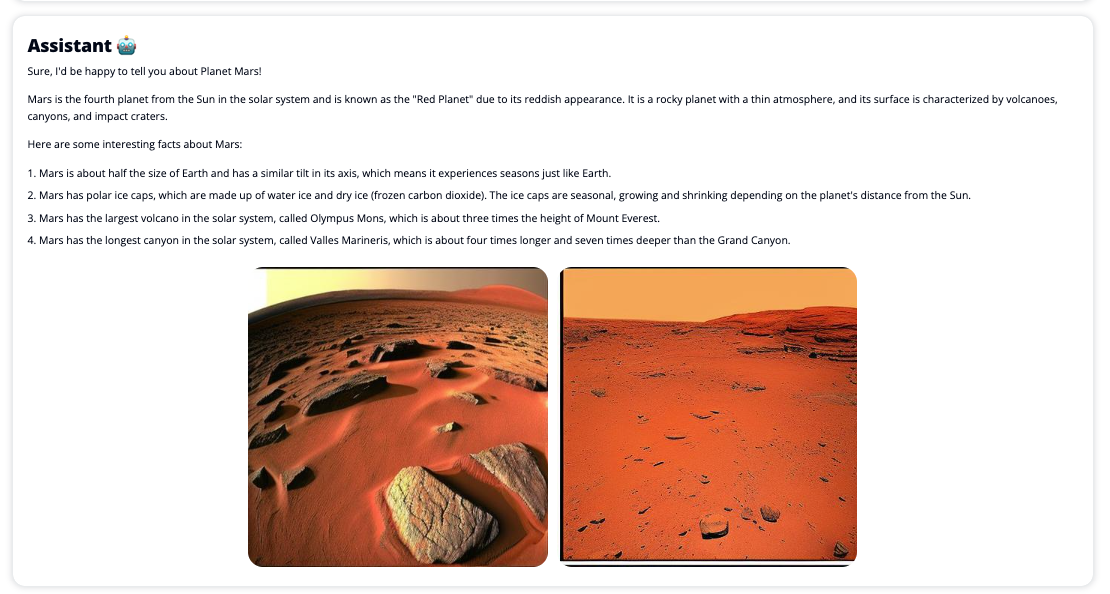

Chat Studio kan också valfritt anropa den stabila diffusionsmodellens slutpunkt för att returnera ett kollage av relevanta bilder och videor om användaren begär att media ska visas. Den här funktionen kan hjälpa till att förbättra användarupplevelsen genom att använda media som medföljande tillgångar till svaret. Det här är bara ett exempel på hur du kan berika Chat Studio med ytterligare integrationer för att nå dina mål.

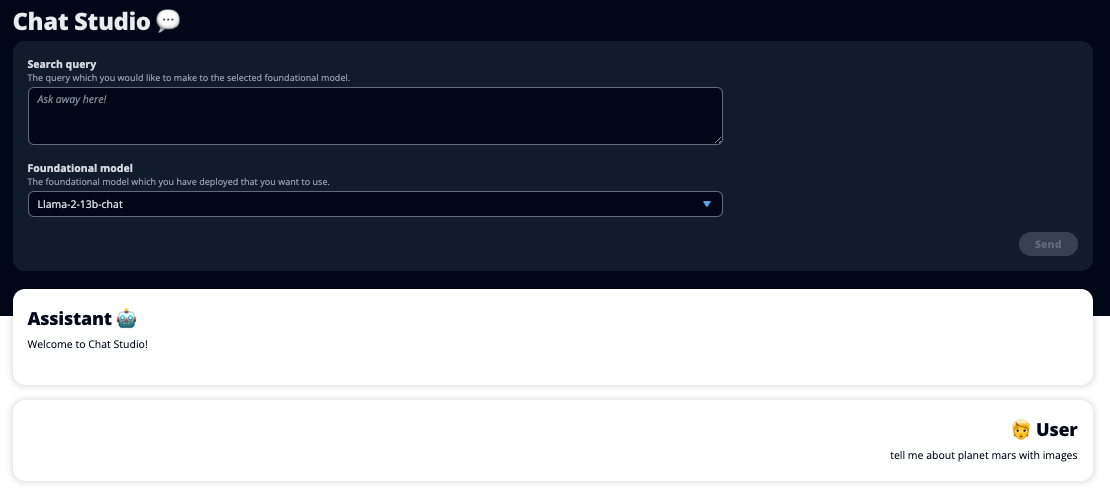

Följande skärmdumpar visar exempel på hur en användares fråga och svar ser ut.

Stora språkmodeller

Generativa AI-chatbotar som ChatGPT drivs av stora språkmodeller (LLM), som är baserade på ett djupt lärande neuralt nätverk som kan tränas på stora mängder omärkt text. Användningen av LLM möjliggör en bättre samtalsupplevelse som nära liknar interaktioner med riktiga människor, vilket främjar en känsla av anknytning och förbättrad användartillfredsställelse.

SageMaker foundation modeller

År 2021 kallade Stanford Institute for Human-Centered Artificial Intelligence vissa LLM:er som grundmodeller. Grundmodeller är förutbildade på en stor och bred uppsättning allmänna data och är tänkta att fungera som grunden för ytterligare optimeringar i ett brett spektrum av användningsfall, från generering av digital konst till flerspråkig textklassificering. Dessa grundmodeller är populära bland kunder eftersom att träna en ny modell från grunden tar tid och kan vara dyrt. SageMaker JumpStart ger tillgång till hundratals grundmodeller som underhålls från tredje parts öppen källkod och proprietära leverantörer.

Lösningsöversikt

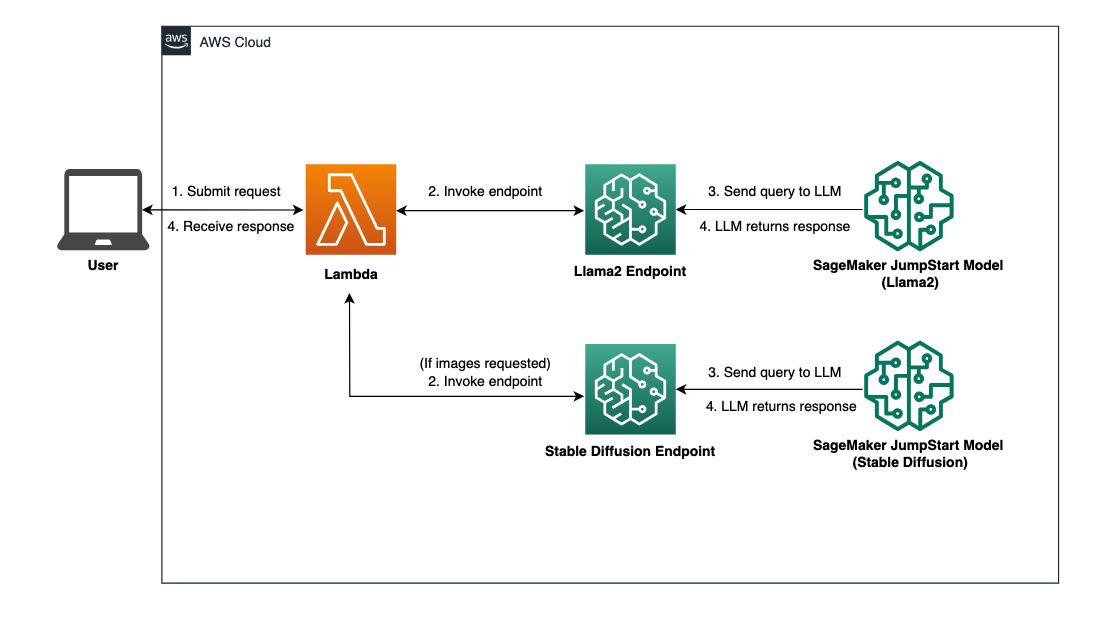

Det här inlägget går igenom ett arbetsflöde med låg kod för att distribuera förutbildade och anpassade LLM:er genom SageMaker, och skapa ett webbgränssnitt för gränssnitt med de utplacerade modellerna. Vi täcker följande steg:

- Distribuera SageMaker grundmodeller.

- Distribuera AWS Lambda och AWS identitets- och åtkomsthantering (IAM) behörigheter med hjälp av AWS molnformation.

- Konfigurera och kör användargränssnittet.

- Alternativt kan du lägga till andra SageMaker foundation-modeller. Detta steg utökar Chat Studios förmåga att interagera med ytterligare grundmodeller.

- Eventuellt kan du distribuera programmet med hjälp av AWS förstärka. Det här steget distribuerar Chat Studio till webben.

Se följande diagram för en översikt över lösningsarkitekturen.

Förutsättningar

För att gå igenom lösningen måste du ha följande förutsättningar:

- An AWS-konto med tillräcklig IAM-användarbehörighet.

npminstallerad i din lokala miljö. För instruktioner om hur man installerarnpm, hänvisa till Ladda ner och installera Node.js och npm.- En tjänstekvot på 1 för motsvarande SageMaker-slutpunkter. För Llama 2 13b Chat använder vi en ml.g5.48xlarge-instans och för Stable Diffusion 2.1 använder vi en ml.p3.2xlarge-instans.

För att begära en ökning av tjänstekvoten, på AWS Service Quotas-konsol, navigera till AWS-tjänster, SageMaker, och begäran om en tjänstekvot höjs till värdet 1 för ml.g5.48xlarge för endpoint-användning och ml.p3.2xlarge för endpoint-användning.

Begäran om tjänstekvot kan ta några timmar innan den godkänns, beroende på instanstypens tillgänglighet.

Distribuera SageMaker grundmodeller

SageMaker är en fullständigt hanterad maskininlärningstjänst (ML) för utvecklare för att snabbt bygga och träna ML-modeller med lätthet. Utför följande steg för att distribuera Llama 2 13b Chat och Stable Diffusion 2.1 grundmodeller med Amazon SageMaker Studio:

- Skapa en SageMaker-domän. För instruktioner, se Ombord på Amazon SageMaker Domain med snabbinställning.

En domän ställer in all lagring och låter dig lägga till användare för att komma åt SageMaker.

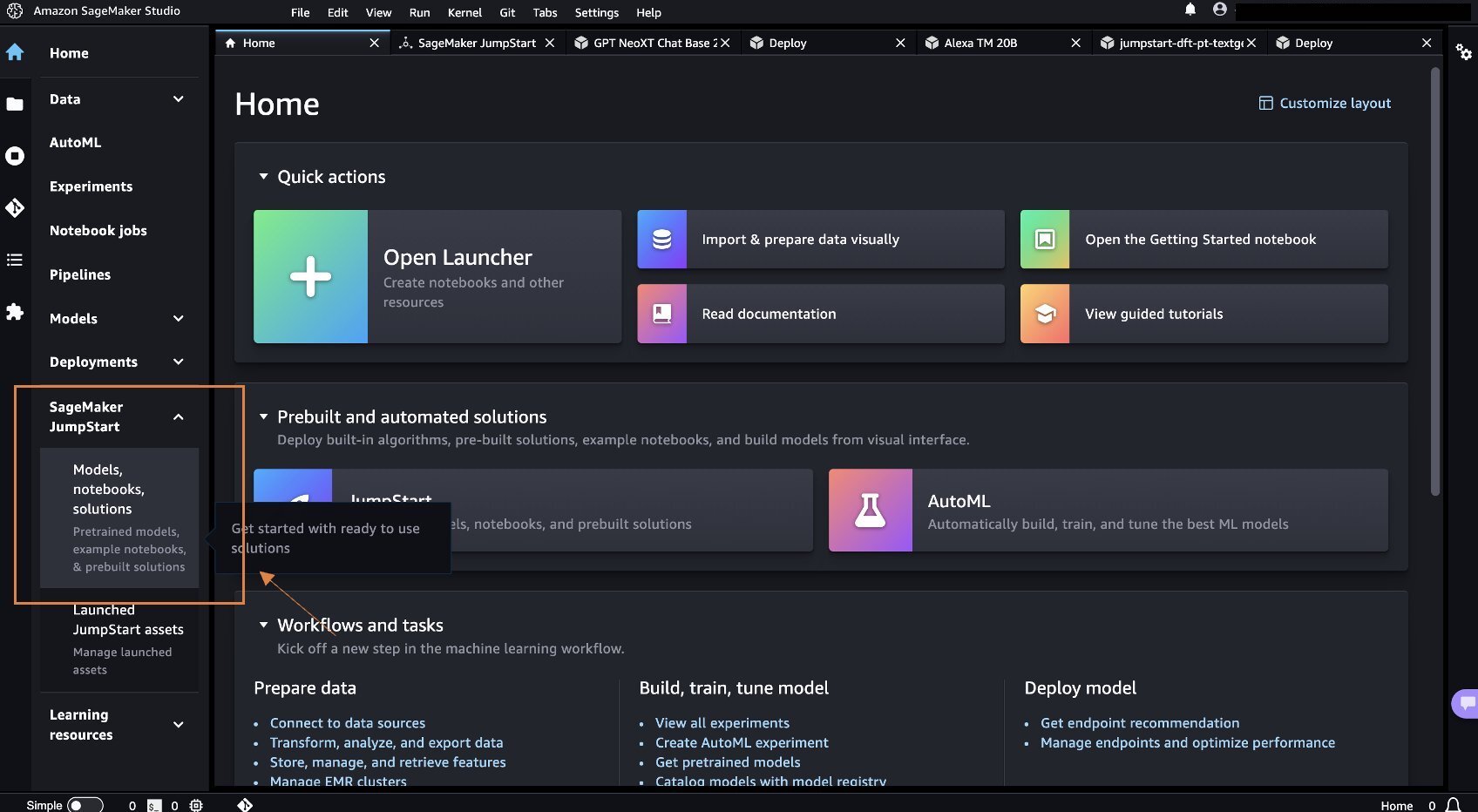

- Välj på SageMaker-konsolen Studio i navigeringsfönstret och välj sedan Öppen studio.

- När du startar Studio, under SageMaker JumpStart välj i navigeringsfönstret Modeller, anteckningsböcker, lösningar.

- Sök efter Llama 2 13b Chat i sökfältet.

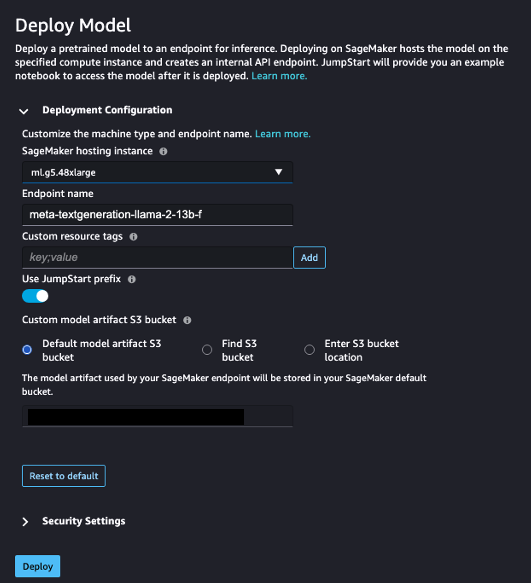

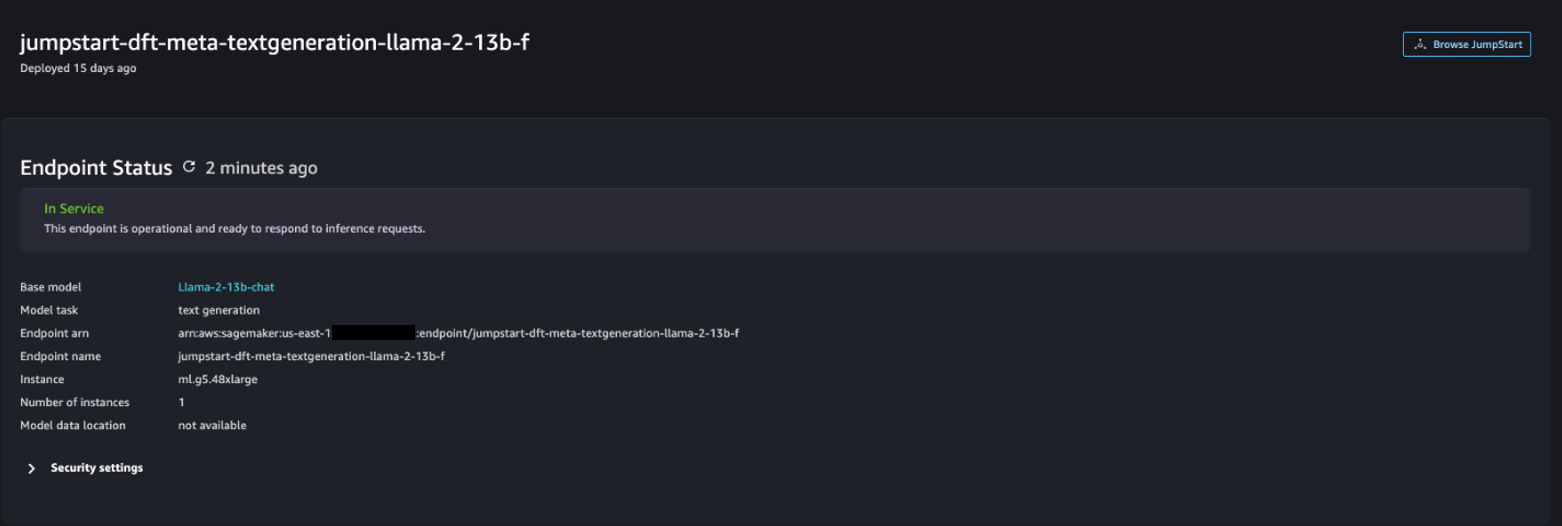

- Enligt Implementeringskonfiguration, För SageMaker värdinstansväljer ml.g5.48xlarge och för Slutpunktsnamn, stiga på

meta-textgeneration-llama-2-13b-f. - Välja Distribuera.

Efter att implementeringen har lyckats bör du kunna se In Service status.

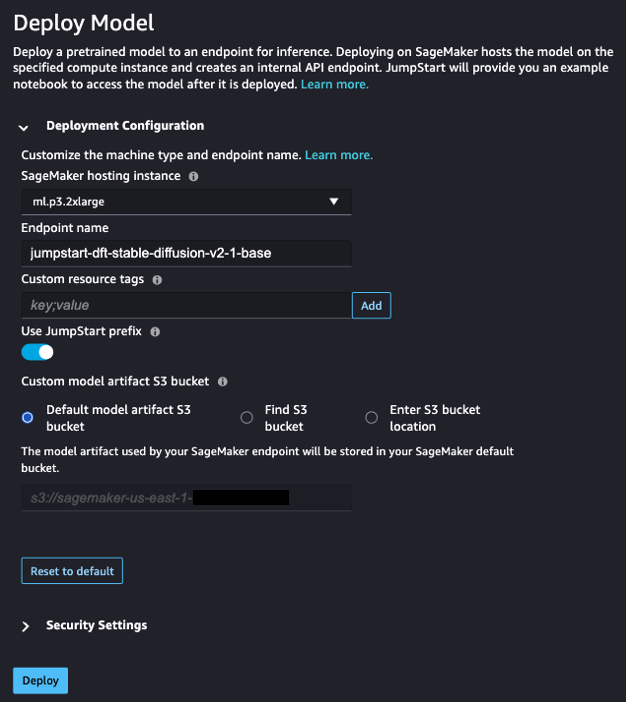

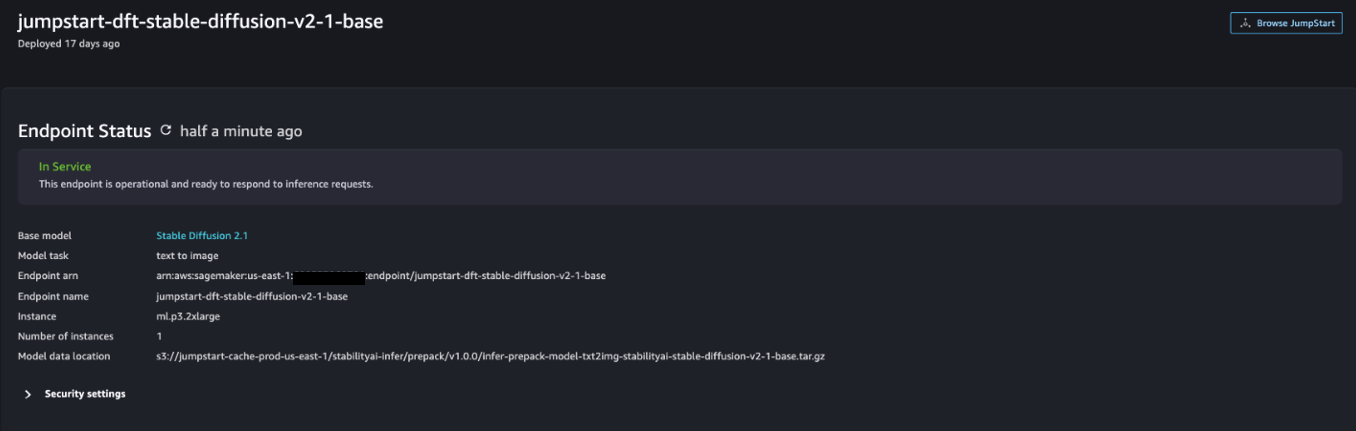

- På Modeller, anteckningsböcker, lösningar sida, sök efter Stable Diffusion 2.1.

- Enligt Implementeringskonfiguration, För SageMaker värdinstansväljer ml. mp3.2xstor och för Slutpunktsnamn, stiga på

jumpstart-dft-stable-diffusion-v2-1-base. - Välja Distribuera.

Efter att implementeringen har lyckats bör du kunna se In Service status.

Distribuera Lambda- och IAM-behörigheter med AWS CloudFormation

Det här avsnittet beskriver hur du kan starta en CloudFormation-stack som distribuerar en Lambda-funktion som bearbetar din användarförfrågan och anropar SageMaker-slutpunkten som du distribuerade, och distribuerar alla nödvändiga IAM-behörigheter. Slutför följande steg:

- Navigera till GitHub repository och ladda ner CloudFormation-mallen (

lambda.cfn.yaml) till din lokala dator. - På CloudFormation-konsolen väljer du Skapa stack rullgardinsmeny och välj Med nya resurser (standard).

- På Ange mall sida, välj Ladda upp en mallfil och Välj FIL.

- Välj

lambda.cfn.yamlfil som du laddade ner och välj sedan Nästa. - På Ange stapeldetaljer sida, ange ett stacknamn och API-nyckeln som du fick i förutsättningarna och välj sedan Nästa.

- På Konfigurera stackalternativ sida, välj Nästa.

- Granska och bekräfta ändringarna och välj Skicka.

Konfigurera webbgränssnittet

Det här avsnittet beskriver stegen för att köra webbgränssnittet (skapat med Cloudscape designsystem) på din lokala dator:

- Navigera till användaren på IAM-konsolen

functionUrl. - På Säkerhetsuppgifter fliken, välj Skapa åtkomstnyckel.

- På Få tillgång till viktiga bästa metoder och alternativ sida, välj Kommandoradsgränssnitt (CLI) Och välj Nästa.

- På Ställ in beskrivningstagg sida, välj Skapa åtkomstnyckel.

- Kopiera åtkomstnyckeln och den hemliga åtkomstnyckeln.

- Välja Färdig .

- Navigera till GitHub repository och ladda ner

react-llm-chat-studiokoda. - Starta mappen i din föredragna IDE och öppna en terminal.

- Navigera till

src/configs/aws.jsonoch mata in åtkomstnyckeln och den hemliga åtkomstnyckeln du fick. - Ange följande kommandon i terminalen:

- Öppen http://localhost:3000 i din webbläsare och börja interagera med dina modeller!

För att använda Chat Studio, välj en grundmodell på rullgardinsmenyn och skriv din fråga i textrutan. För att få AI-genererade bilder tillsammans med svaret, lägg till frasen "med bilder" i slutet av din fråga.

Lägg till andra SageMaker foundation-modeller

Du kan utöka kapaciteten för denna lösning ytterligare till att inkludera ytterligare SageMaker-fundamentmodeller. Eftersom varje modell förväntar sig olika inmatnings- och utdataformat när de anropar sin SageMaker-slutpunkt, måste du skriva lite transformationskod i callSageMakerEndpoints Lambda-funktionen för att gränssnittet med modellen.

Det här avsnittet beskriver de allmänna stegen och kodändringarna som krävs för att implementera en ytterligare modell som du väljer. Observera att grundläggande kunskaper i Python-språket krävs för steg 6–8.

- I SageMaker Studio, distribuera SageMaker grundmodell som du väljer.

- Välja SageMaker JumpStart och Starta JumpStart-tillgångar.

- Välj din nydistribuerade modellslutpunkt och välj Öppna Notebook.

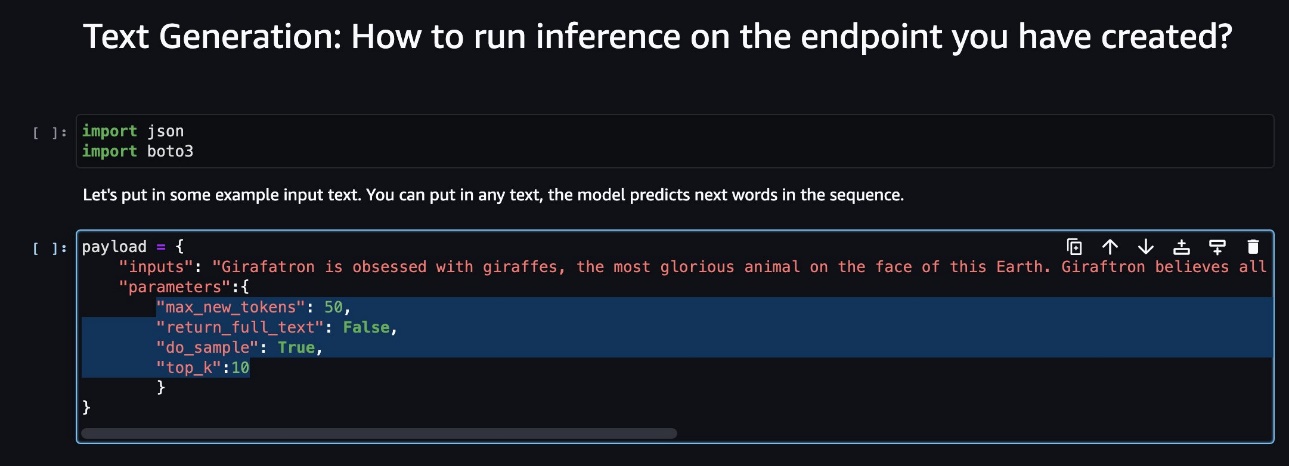

- Hitta nyttolastparametrarna på notebook-konsolen.

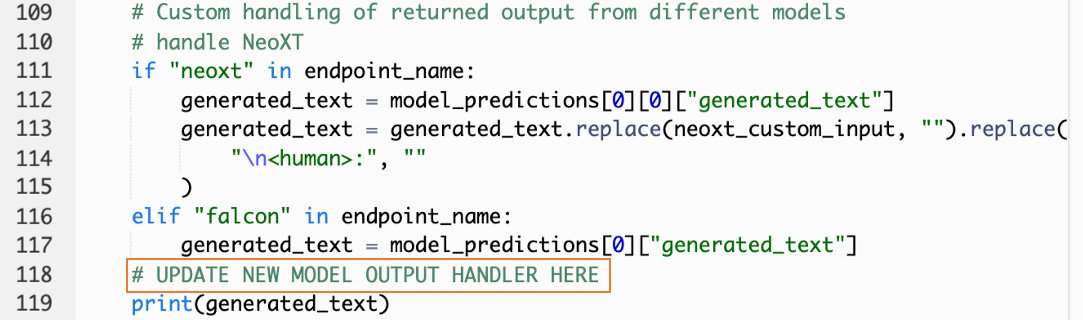

Det här är fälten som den nya modellen förväntar sig när den anropar sin SageMaker-slutpunkt. Följande skärmdump visar ett exempel.

- På lambdakonsolen, navigera till

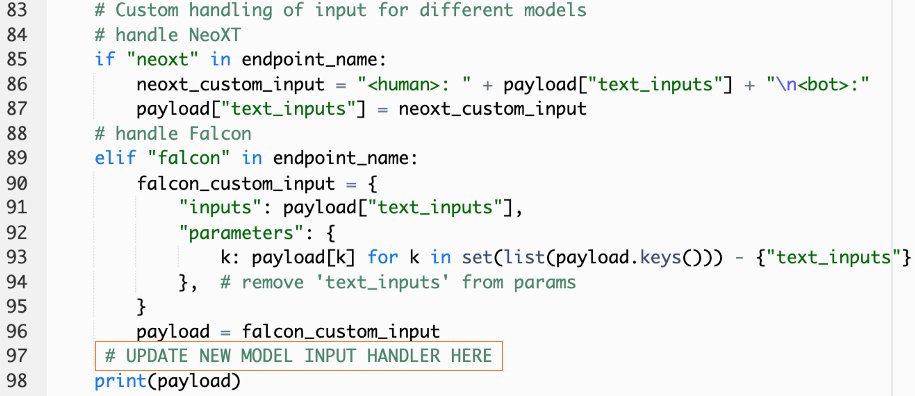

callSageMakerEndpoints. - Lägg till en anpassad inmatningshanterare för din nya modell.

I följande skärmdump transformerade vi ingången för Falcon 40B Instruct BF16 och GPT NeoXT Chat Base 20B FP16. Du kan infoga din anpassade parameterlogik enligt anvisningarna för att lägga till logiken för ingångstransformation med referens till nyttolastparametrarna som du kopierade.

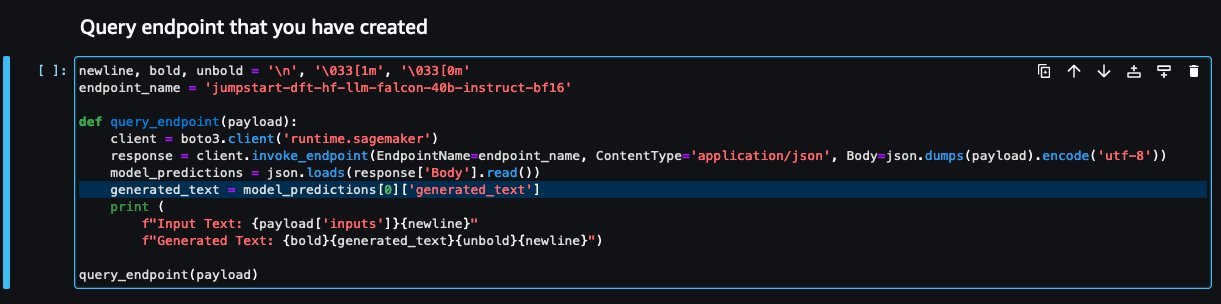

- Gå tillbaka till notebook-konsolen och leta upp

query_endpoint.

Den här funktionen ger dig en idé om hur du omvandlar utdata från modellerna för att extrahera det slutliga textsvaret.

- Med hänvisning till koden i

query_endpoint, lägg till en anpassad utdatahanterare för din nya modell.

- Välja Distribuera.

- Öppna din IDE, starta

react-llm-chat-studiokod och navigera tillsrc/configs/models.json. - Lägg till ditt modellnamn och modellslutpunkt och ange nyttolastparametrarna från steg 4 under

payloadmed följande format: - Uppdatera din webbläsare för att börja interagera med din nya modell!

Distribuera applikationen med Amplify

Amplify är en komplett lösning som gör att du snabbt och effektivt kan distribuera din applikation. Det här avsnittet beskriver stegen för att distribuera Chat Studio till en Amazon CloudFront distribution med Amplify om du vill dela din applikation med andra användare.

- Navigera till

react-llm-chat-studiokodmapp som du skapade tidigare. - Ange följande kommandon i terminalen och följ installationsinstruktionerna:

- Initiera ett nytt Amplify-projekt genom att använda följande kommando. Ange ett projektnamn, acceptera standardkonfigurationerna och välj AWS-åtkomstnycklar när du uppmanas att välja autentiseringsmetod.

- Värd för Amplify-projektet genom att använda följande kommando. Välja Amazon CloudFront och S3 när du uppmanas att välja plugin-läge.

- Slutligen, bygg och distribuera projektet med följande kommando:

- När implementeringen har lyckats öppnar du webbadressen i din webbläsare och börjar interagera med dina modeller!

Städa upp

Gör så här för att undvika framtida avgifter:

- Ta bort CloudFormation-stacken. För instruktioner, se Ta bort en stack på AWS CloudFormation-konsolen.

- Ta bort SageMaker JumpStart-slutpunkten. För instruktioner, se Ta bort slutpunkter och resurser.

- Ta bort SageMaker-domänen. För instruktioner, se Ta bort en Amazon SageMaker-domän.

Slutsats

I det här inlägget förklarade vi hur man skapar ett webbgränssnitt för gränssnitt med LLM:er distribuerade på AWS.

Med den här lösningen kan du interagera med din LLM och föra en konversation på ett användarvänligt sätt för att testa eller ställa LLM-frågorna och få ett kollage av bilder och videor om det behövs.

Du kan utöka denna lösning på olika sätt, som att integrera ytterligare grundmodeller, integrera med Amazon Kendra för att möjliggöra ML-driven intelligent sökning för att förstå företagsinnehåll och mer!

Vi inbjuder dig att experimentera med olika förutbildade LLM:er tillgängliga på AWS, eller bygga på eller till och med skapa dina egna LLM i SageMaker. Låt oss veta dina frågor och fynd i kommentarerna och ha kul!

Om författarna

Jarrett Yeo Shan Wei är en associerad molnarkitekt inom AWS Professional Services som täcker den offentliga sektorn över ASEAN och är en förespråkare för att hjälpa kunder att modernisera och migrera till molnet. Han har uppnått fem AWS-certifieringar och har också publicerat en forskningsartikel om gradientförstärkande maskinensembler i den åttonde internationella konferensen om AI. På fritiden fokuserar Jarrett på och bidrar till den generativa AI-scenen på AWS.

Jarrett Yeo Shan Wei är en associerad molnarkitekt inom AWS Professional Services som täcker den offentliga sektorn över ASEAN och är en förespråkare för att hjälpa kunder att modernisera och migrera till molnet. Han har uppnått fem AWS-certifieringar och har också publicerat en forskningsartikel om gradientförstärkande maskinensembler i den åttonde internationella konferensen om AI. På fritiden fokuserar Jarrett på och bidrar till den generativa AI-scenen på AWS.

Tammy Lim Lee Xin är Associate Cloud Architect på AWS. Hon använder teknik för att hjälpa kunder att leverera sina önskade resultat i sin molnanpassningsresa och brinner för AI/ML. Utanför jobbet älskar hon att resa, vandra och umgås med familj och vänner.

Tammy Lim Lee Xin är Associate Cloud Architect på AWS. Hon använder teknik för att hjälpa kunder att leverera sina önskade resultat i sin molnanpassningsresa och brinner för AI/ML. Utanför jobbet älskar hon att resa, vandra och umgås med familj och vänner.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/create-a-web-ui-to-interact-with-llms-using-amazon-sagemaker-jumpstart/

- : har

- :är

- $UPP

- 1

- 10

- 120

- 160

- 2021

- 3000

- 320

- 7

- 8

- 8:e

- a

- Able

- Om oss

- Acceptera

- tillgång

- bekräfta

- tvärs

- lägga till

- Annat

- Antagande

- förespråkare

- Efter

- AI

- AI / ML

- Alla

- tillåter

- längs

- också

- amason

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- förstärka

- an

- och

- api

- Ansökan

- godkänd

- arkitektur

- ÄR

- Konst

- konstgjord

- artificiell intelligens

- AS

- Asean

- be

- Tillgångar

- Associate

- At

- uppnås

- Autentisering

- tillgänglighet

- tillgänglig

- undvika

- AWS

- AWS molnformation

- AWS professionella tjänster

- bar

- bas

- baserat

- grundläggande

- BE

- därför att

- BÄST

- bästa praxis

- Bättre

- öka

- Box

- bred

- webbläsare

- SLUTRESULTAT

- by

- Ring

- Samtal

- KAN

- Kan få

- kapacitet

- kapacitet

- fångas

- fall

- certifieringar

- Förändringar

- avgifter

- chatbots

- ChatGPT

- val

- Välja

- klassificering

- nära

- cloud

- moln adoption

- koda

- kommentarer

- fullborda

- Konferens

- konfiguration

- anslutning

- Konsol

- innehåll

- bidrar

- Konversation

- konversera

- konversations AI

- Motsvarande

- täcka

- beläggning

- skapa

- skapas

- Skapa

- nyfiken

- beställnings

- Kunder

- datum

- djup

- djupt lärande

- Standard

- leverera

- beroende

- distribuera

- utplacerade

- utplacera

- utplacering

- vecklas ut

- beskrivning

- Designa

- önskas

- detaljer

- utvecklare

- olika

- Diffusion

- digital

- digital konst

- visas

- fördelning

- domän

- ladda ner

- Tidigare

- lätta

- effektivt

- möjliggöra

- änden

- Slutpunkt

- förbättra

- berika

- ange

- Företag

- Miljö

- Även

- Varje

- exempel

- exempel

- förväntar

- dyra

- erfarenhet

- experimentera

- förklarade

- förlänga

- sträcker

- extrahera

- familj

- Leverans

- få

- Fält

- Fil

- slutlig

- hitta

- resultat

- fem

- fokuserar

- följer

- efter

- För

- format

- främja

- fundament

- grundläggande

- Fri

- vänner

- från

- fullständigt

- fungera

- ytterligare

- framtida

- Allmänt

- generell information

- generera

- generativ

- Generativ AI

- skaffa sig

- ger

- Mål

- Har

- he

- hjälpa

- hjälpa

- hans

- hålla

- värd

- ÖPPETTIDER

- Hur ser din drömresa ut

- How To

- html

- http

- HTTPS

- Människa

- Hundratals

- Tanken

- Identitet

- if

- bilder

- fantasi

- genomföra

- förbättras

- in

- innefattar

- Öka

- indikerade

- ingång

- installera

- installerad

- installera

- exempel

- Institute

- instruktioner

- integrera

- integrationer

- Intelligens

- Intelligent

- interagera

- interagera

- interaktioner

- Gränssnitt

- Internationell

- in

- bjuda in

- DESS

- resa

- jpg

- bara

- bara en

- Nyckel

- Vet

- kunskap

- språk

- Large

- lansera

- lansera

- inlärning

- Lee

- Låt

- tycka om

- linje

- Lama

- LLM

- lokal

- Logiken

- se

- ser ut som

- älskar

- Maskinen

- maskininlärning

- förvaltade

- sätt

- Maj..

- menas

- Media

- Möt

- Meny

- metod

- migrera

- ML

- Mode

- modell

- modeller

- modernisera

- mer

- multipel

- måste

- namn

- Navigera

- Navigering

- nödvändigt för

- Behöver

- nät

- neurala

- neurala nätverk

- Nya

- nya produkter

- nytt

- nod

- node.js

- Notera

- anteckningsbok

- erhållna

- of

- on

- ONE

- öppet

- öppen källkod

- Tillbehör

- or

- Övriga

- utfall

- produktion

- utanför

- Översikt

- egen

- sida

- panelen

- Papper

- parameter

- parametrar

- brinner

- behörigheter

- plato

- Platon Data Intelligence

- PlatonData

- plugin

- Populära

- popularitet

- Inlägg

- drivs

- praxis

- föredragen

- förutsättningar

- privilegier

- processer

- Produkter

- professionell

- projektet

- proprietary

- ge

- förutsatt

- leverantörer

- ger

- allmän

- publicerade

- Python

- frågor

- Snabbt

- snabbt

- höja

- område

- verklig

- hänvisa

- referens

- relevanta

- begära

- förfrågningar

- Obligatorisk

- forskning

- Liknar

- Resurser

- respons

- avkastning

- Rise

- Körning

- sagemaker

- tillfredsställande

- scen

- repa

- skärmdumpar

- Sök

- Secret

- §

- sektor

- se

- välj

- känsla

- tjänar

- service

- Tjänster

- in

- uppsättningar

- inställning

- Dela

- hon

- skall

- show

- Visar

- kodavsnitt

- lösning

- några

- Källa

- Spendera

- stabil

- stapel

- standard

- stanford

- starta

- igång

- status

- Steg

- Steg

- förvaring

- studio

- sådana

- tillräcklig

- Ta

- tar

- Teknologi

- mall

- terminal

- testa

- text

- Textklassificering

- den där

- Smakämnen

- deras

- sedan

- Dessa

- de

- tredje part

- detta

- fastän?

- Genom

- tid

- till

- topp

- Tåg

- tränad

- Utbildning

- Förvandla

- Transformation

- transformerad

- Typ

- ui

- under

- förståelse

- URL

- us

- Användning

- användning

- Användare

- Användarupplevelse

- Användargränssnitt

- användarvänligt

- användare

- användningar

- med hjälp av

- värde

- olika

- Video

- gå

- promenader

- sätt

- we

- webb

- webbservice

- Vad

- när

- som

- VEM

- bred

- Brett utbud

- kommer

- önskar

- med

- Arbete

- arbetsflöde

- skriva

- yeo

- Om er

- Din

- zephyrnet