Det här blogginlägget är skrivet tillsammans med Hwalsuk Lee på Upstage.

Idag är vi glada att kunna meddela att Solenergi grundmodell utvecklad av Upstage är nu tillgänglig för kunder som använder Amazon SageMaker JumpStart. Solar är en stor språkmodell (LLM) 100% förutbildad med Amazon SageMaker som överträffar och använder sin kompakta storlek och kraftfulla meritlista för att specialisera sig på ändamålsenlig träning, vilket gör den mångsidig över språk, domäner och uppgifter.

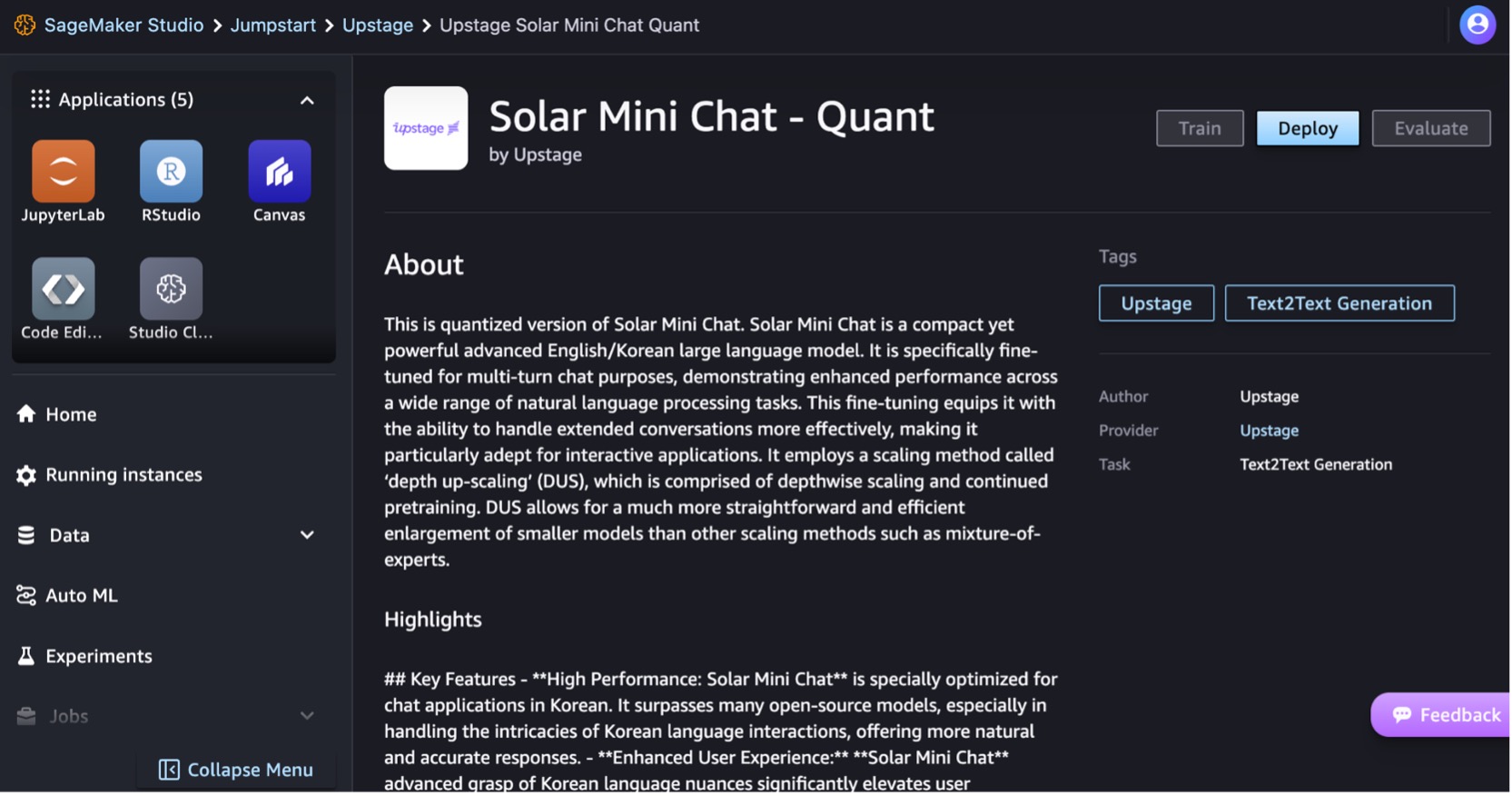

Du kan nu använda Solar Mini Chat och Solar Mini Chat – Kvant förtränade modeller inom SageMaker JumpStart. SageMaker JumpStart är maskininlärningsnavet (ML) i SageMaker som ger tillgång till grundmodeller utöver inbyggda algoritmer för att hjälpa dig att snabbt komma igång med ML.

I det här inlägget går vi igenom hur du upptäcker och distribuerar Solar-modellen via SageMaker JumpStart.

Vad är Solar-modellen?

Solar är en kompakt och kraftfull modell för engelska och koreanska språk. Den är speciellt finjusterad för chattsyften med flera svängar, och visar förbättrad prestanda över ett brett utbud av naturliga språkbehandlingsuppgifter.

Solar Mini Chat-modellen är baserad på Solar 10.7B, med en 32-lagers Lama 2 struktur, och initieras med förtränade vikter från Mistral 7B kompatibel med Llama 2-arkitekturen. Denna finjustering förser den med förmågan att hantera utökade konversationer mer effektivt, vilket gör den särskilt lämpad för interaktiva applikationer. Den använder en skalningsmetod som kallas djupskalning (DUS), som består av djupvis skalning och fortsatt förträning. DUS möjliggör en mycket mer okomplicerad och effektiv förstoring av mindre modeller än andra skalningsmetoder som t.ex. blandning av experter (MoE).

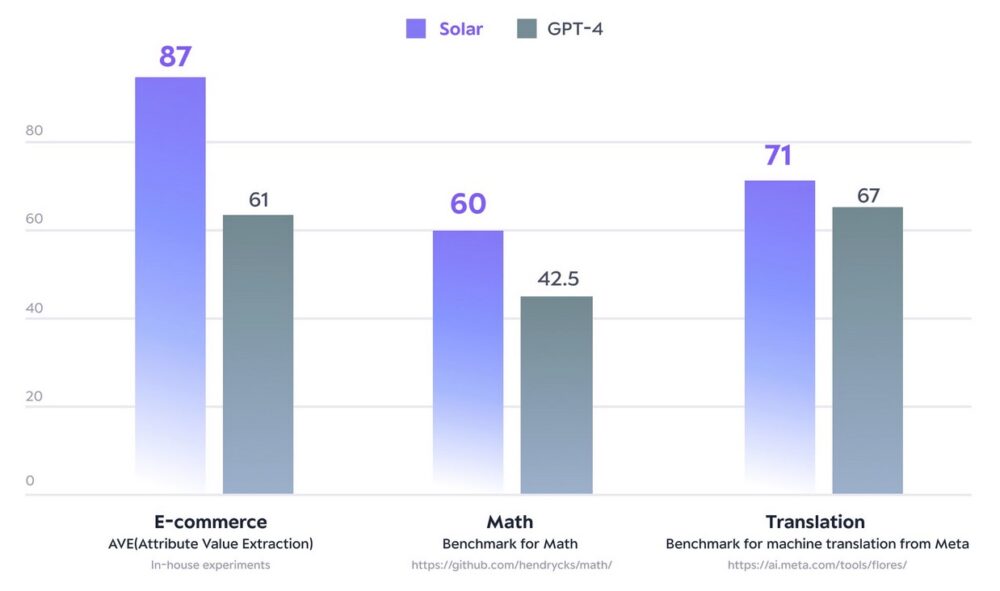

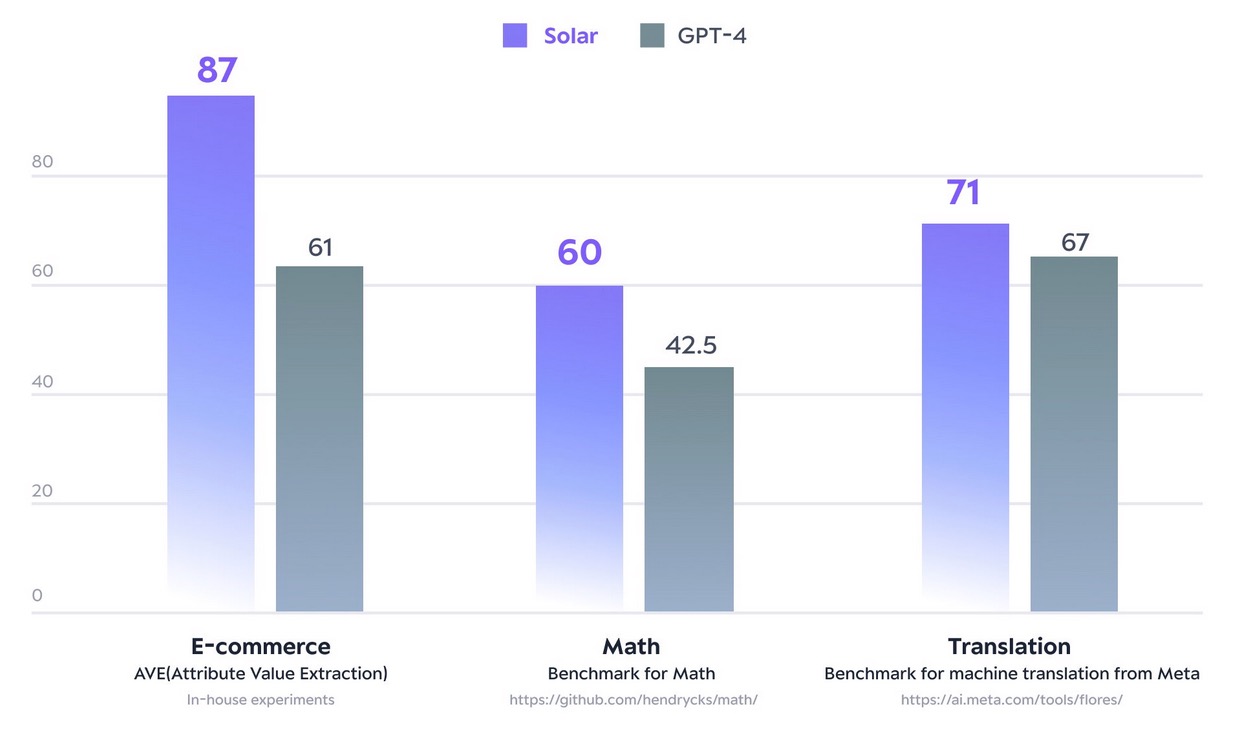

I december 2023 skapade Solar 10.7B-modellen vågor genom att nå toppen av Öppna LLM Leaderboard av Hugging Face. Genom att använda betydligt färre parametrar, levererar Solar 10.7B svar som är jämförbara med GPT-3.5, men är 2.5 gånger snabbare. Tillsammans med att toppa Open LLM Leaderboard överträffar Solar 10.7B GPT-4 med specialutbildade modeller på vissa domäner och uppgifter.

Följande figur illustrerar några av dessa mätvärden:

Med SageMaker JumpStart kan du distribuera Solar 10.7B-baserade förtränade modeller: Solar Mini Chat och en kvantifierad version av Solar Mini Chat, optimerad för chattapplikationer på engelska och koreanska. Solar Mini Chat-modellen ger ett avancerat grepp om koreanska språknyanser, vilket avsevärt höjer användarinteraktioner i chattmiljöer. Det ger exakta svar på användarinmatningar, vilket säkerställer tydligare kommunikation och effektivare problemlösning i engelska och koreanska chattapplikationer.

Kom igång med Solar-modeller i SageMaker JumpStart

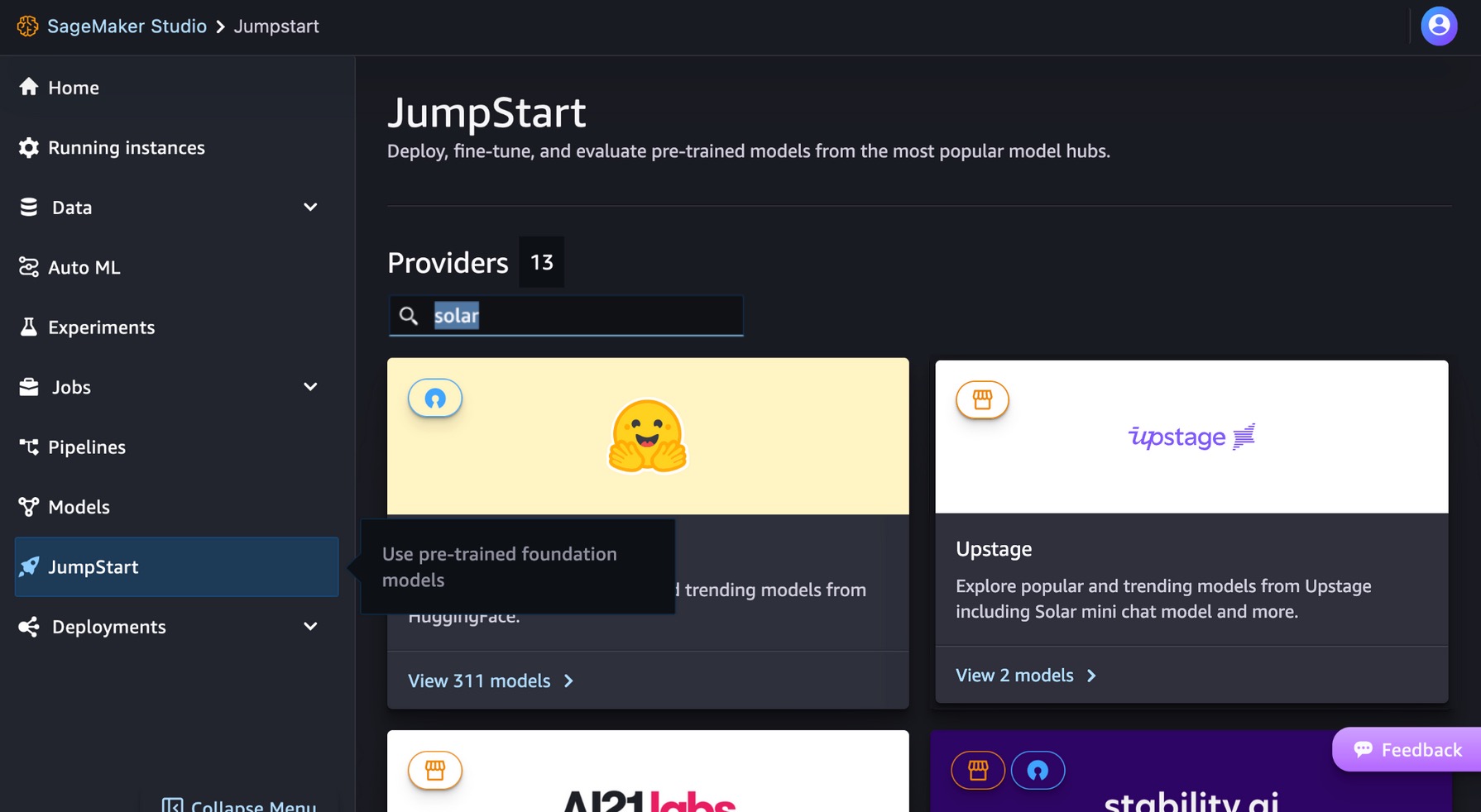

För att komma igång med Solar-modeller kan du använda SageMaker JumpStart, en fullständigt hanterad ML-navtjänst för att distribuera förbyggda ML-modeller i en produktionsklar värdmiljö. Du kan komma åt Solar-modeller genom SageMaker JumpStart i Amazon SageMaker Studio, en webbaserad integrerad utvecklingsmiljö (IDE) där du kan komma åt specialbyggda verktyg för att utföra alla ML-utvecklingssteg, från att förbereda data till att bygga, träna och distribuera dina ML-modeller.

Välj på SageMaker Studio-konsolen Försprång i navigeringsfönstret. Du kan ange "solar" i sökfältet för att hitta Upstages solcellsmodeller.

Låt oss distribuera Solar Mini Chat – Quant-modellen. Välj modellkortet för att se detaljer om modellen såsom licensen, data som används för att träna och hur du använder modellen. Du hittar också en Distribuera alternativet, som tar dig till en målsida där du kan testa slutledning med ett exempel på nyttolast.

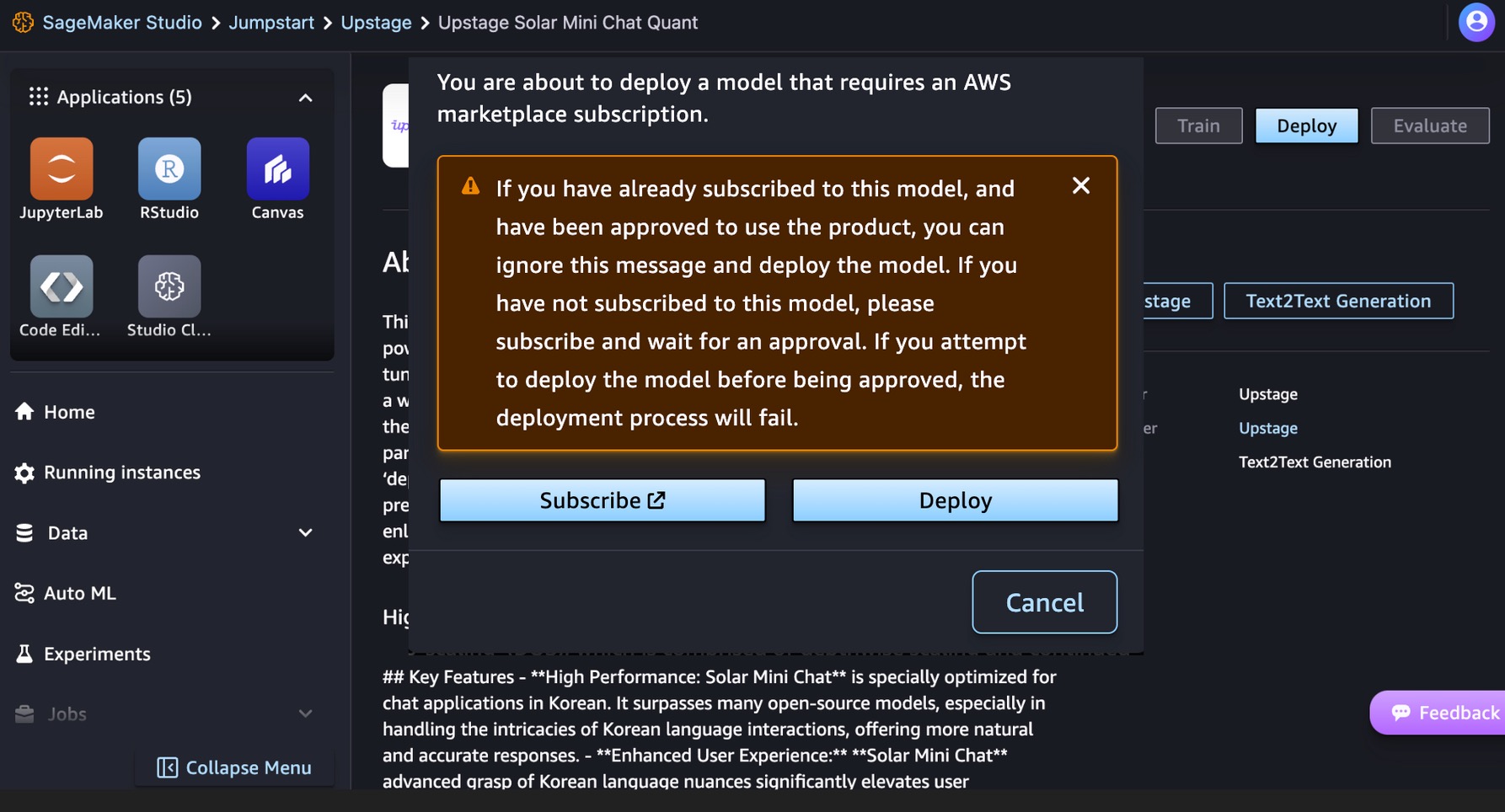

Denna modell kräver en AWS Marketplace prenumeration. Om du redan har prenumererat på den här modellen och har blivit godkänd för att använda produkten kan du distribuera modellen direkt.

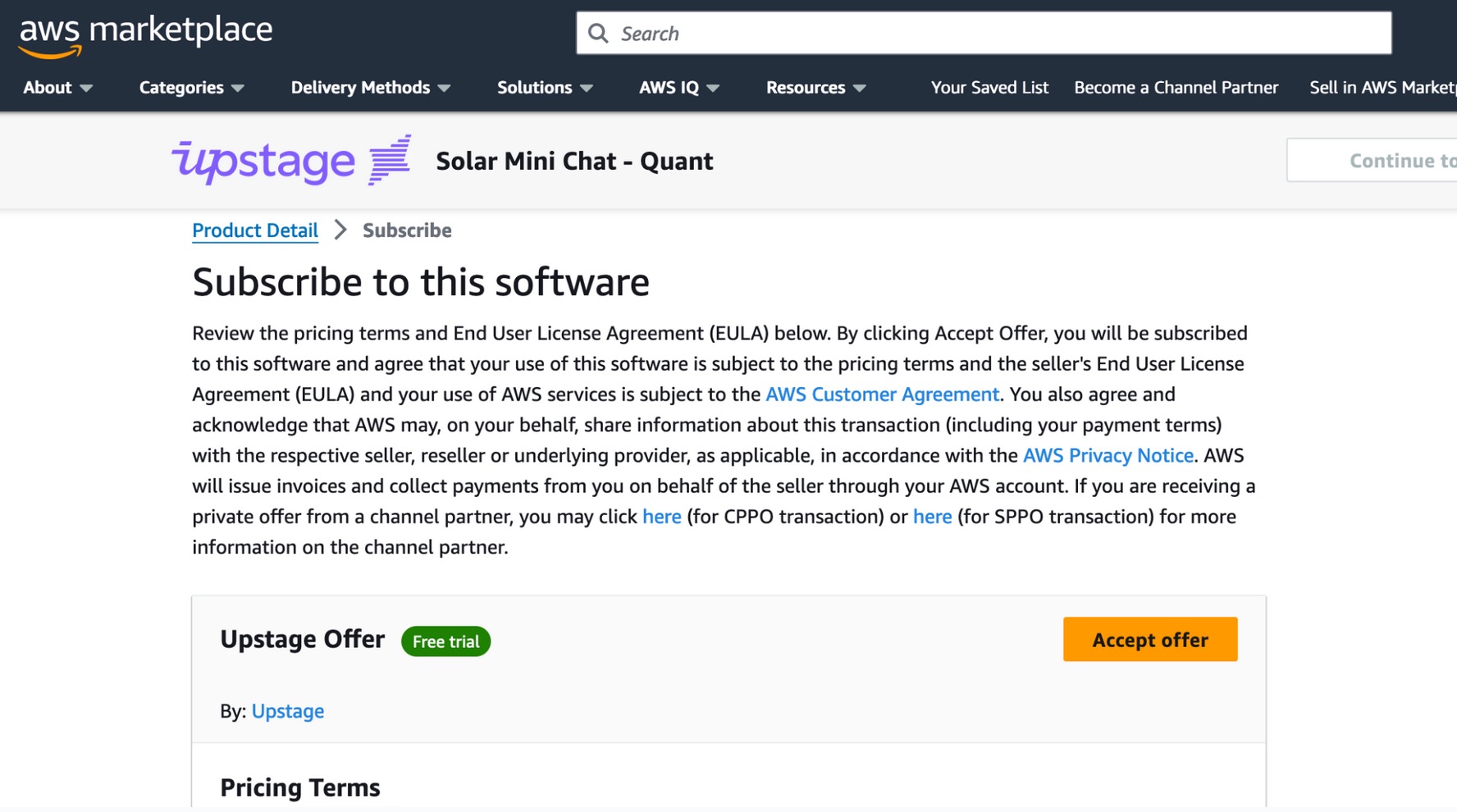

Om du inte har prenumererat på den här modellen, välj Prenumerera, gå till AWS Marketplace, granska prisvillkoren och slutanvändarlicensavtalet (EULA) och välj Acceptera erbjudande.

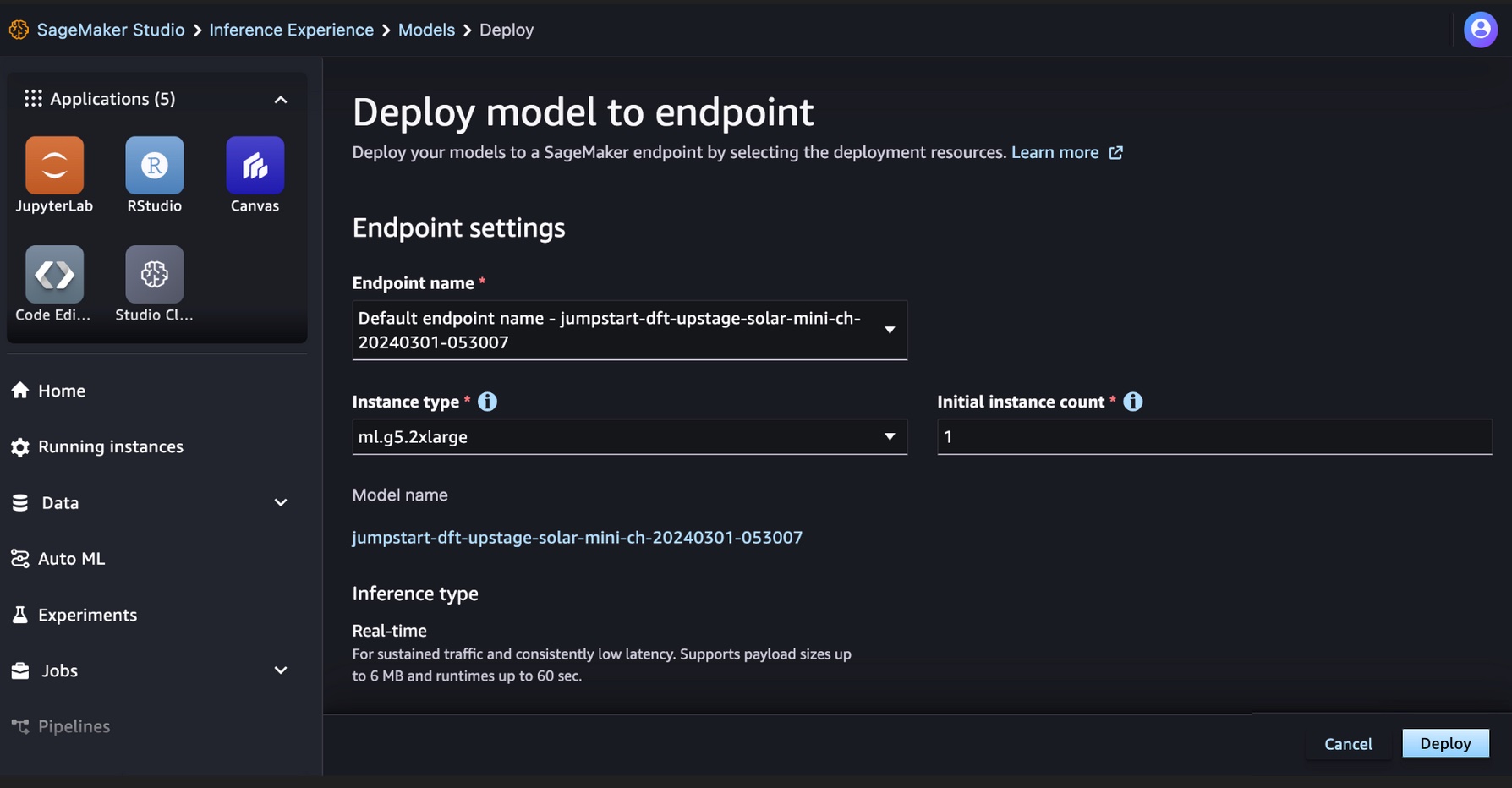

När du har prenumererat på modellen kan du distribuera din modell till en SageMaker-slutpunkt genom att välja distributionsresurserna, såsom instanstyp och initialt antal instanser. Välja Distribuera och vänta att en slutpunkt skapas för modellinferensen. Du kan välja en ml.g5.2xlarge exempel som ett billigare alternativ för slutledning med Solar-modellen.

När din SageMaker-slutpunkt har skapats kan du testa den genom de olika SageMaker-applikationsmiljöerna.

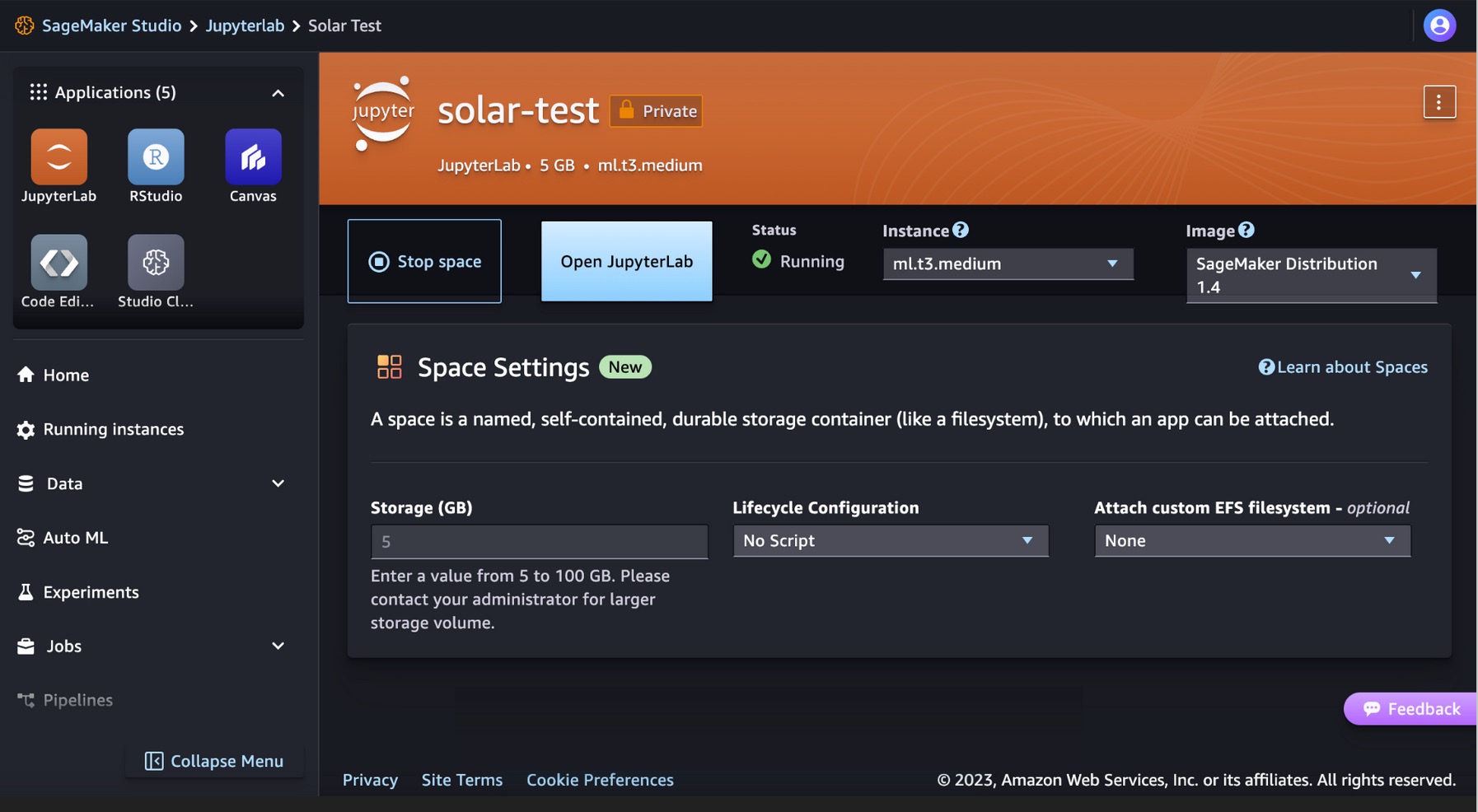

Kör din kod för Solar-modeller i SageMaker Studio JupyterLab

SageMaker Studio stöder olika applikationsutvecklingsmiljöer, inklusive JupyterLab, en uppsättning funktioner som utökar det fullt hanterade bärbara erbjudandet. Den innehåller kärnor som startar på några sekunder, en förkonfigurerad körtid med populär datavetenskap, ML-ramverk och högpresterande privat blocklagring. För mer information, se SageMaker JupyterLab.

Skapa ett JupyterLab-utrymme i SageMaker Studio som hanterar lagrings- och beräkningsresurserna som behövs för att köra JupyterLab-applikationen.

Du kan hitta koden som visar utplaceringen av Solar-modeller på SageMaker JumpStart och ett exempel på hur man använder den utplacerade modellen i GitHub repo. Du kan nu distribuera modellen med SageMaker JumpStart. Följande kod använder standardinstansen ml.g5.2xlarge för slutpunkten för Solar Mini Chat – Quant-modellens slutpunkt.

Solar-modeller stöder en förfrågnings-/svarnyttolast som är kompatibel med OpenAI:s slutpunkt för Chat-komplettering. Du kan testa chattexempel i en eller flera svängar med Python.

# Get a SageMaker endpoint

sagemaker_runtime = boto3.client("sagemaker-runtime")

endpoint_name = sagemaker.utils.name_from_base(model_name)

# Multi-turn chat prompt example

input = {

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Can you provide a Python script to merge two sorted lists?"

},

{

"role": "assistant",

"content": """Sure, here is a Python script to merge two sorted lists:

```python

def merge_lists(list1, list2):

return sorted(list1 + list2)

```

"""

},

{

"role": "user",

"content": "Can you provide an example of how to use this function?"

}

]

}

# Get response from the model

response = sagemaker_runtime.invoke_endpoint(EndpointName=endpoint_name, ContentType='application/json', Body=json.dumps (input))

result = json.loads(response['Body'].read().decode())

print resultDu har framgångsrikt utfört en slutledning i realtid med Solar Mini Chat-modellen.

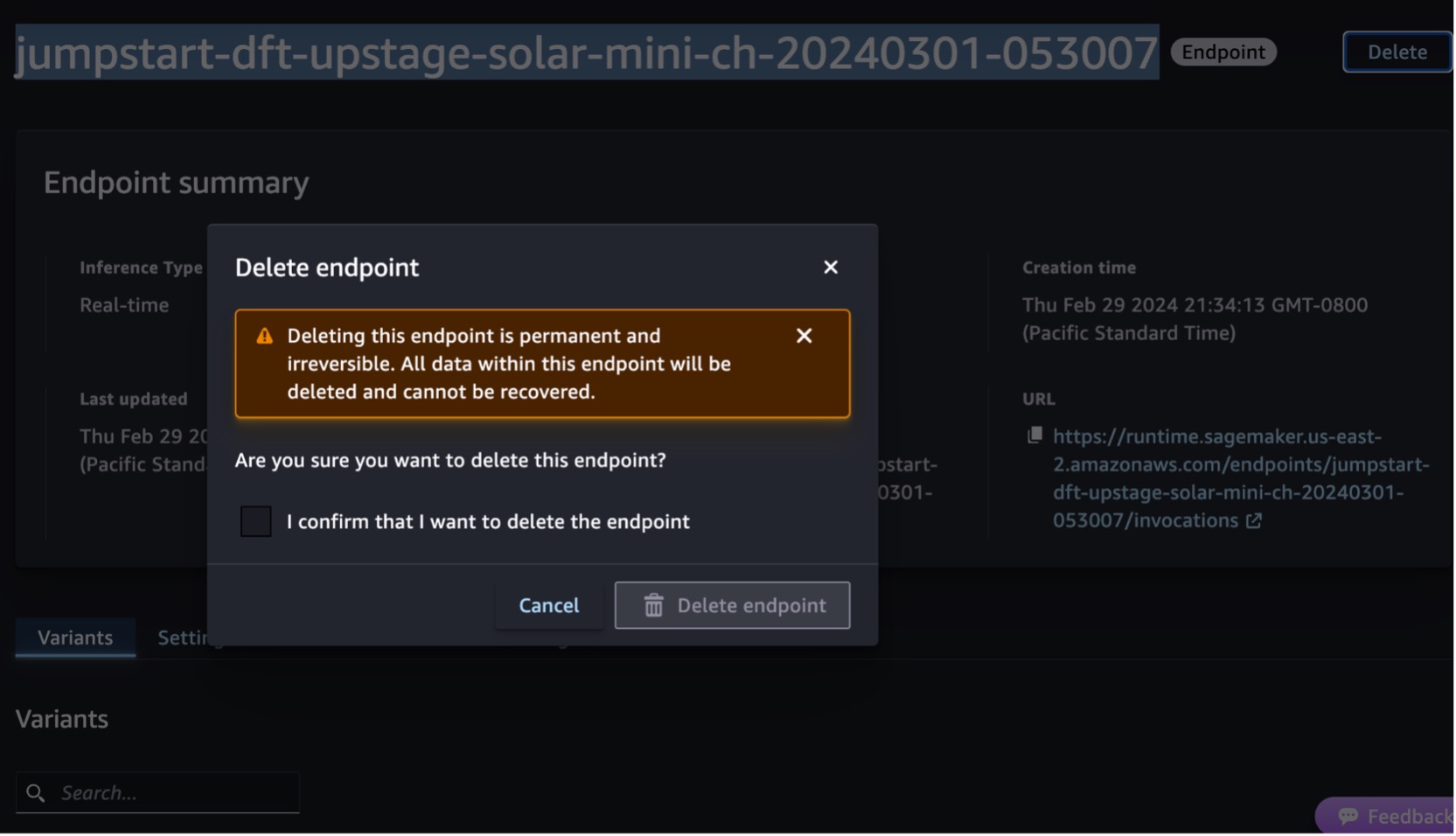

Städa upp

När du har testat slutpunkten tar du bort SageMaker slutpunkten och tar bort modellen för att undvika avgifter.

Du kan också köra följande kod för att ta bort slutpunkten och läget i SageMaker Studio JupyterLabs anteckningsbok:

# Delete the endpoint

model.sagemaker_session.delete_endpoint(endpoint_name)

model.sagemaker_session.delete_endpoint_config(endpoint_name)

# Delete the model

model.delete_model()För mer information, se Ta bort slutpunkter och resurser. Dessutom kan du stäng av SageMaker Studio-resurserna som inte längre behövs.

Slutsats

I det här inlägget visade vi dig hur du kommer igång med Upstages Solar-modeller i SageMaker Studio och distribuerar modellen för slutledning. Vi visade dig också hur du kan köra din Python-exempelkod på SageMaker Studio JupyterLab.

Eftersom Solar-modeller redan är förutbildade kan de hjälpa till att sänka utbildnings- och infrastrukturkostnader och möjliggöra anpassning för dina generativa AI-applikationer.

Prova det på SageMaker JumpStart-konsol or SageMaker Studio-konsol! Du kan också titta på följande video, Prova "Solar" med Amazon SageMaker.

Denna vägledning är endast i informationssyfte. Du bör fortfarande utföra din egen oberoende bedömning och vidta åtgärder för att säkerställa att du följer dina egna specifika praxis och standarder för kvalitetskontroll, och de lokala regler, lagar, förordningar, licenser och användarvillkor som gäller för dig, ditt innehåll, och den tredjepartsmodell som hänvisas till i denna vägledning. AWS har ingen kontroll eller auktoritet över tredjepartsmodellen som hänvisas till i denna vägledning, och lämnar inga utfästelser eller garantier för att tredjepartsmodellen är säker, virusfri, funktionsduglig eller kompatibel med din produktionsmiljö och standarder. AWS lämnar inga utfästelser, garantier eller garanterar att någon information i denna vägledning kommer att resultera i ett visst resultat eller resultat.

Om författarna

Channy Yun är en Principal Developer Advocate på AWS och brinner för att hjälpa utvecklare att bygga moderna applikationer på de senaste AWS-tjänsterna. Han är en pragmatisk utvecklare och bloggare i grunden, och han älskar gemenskapsdrivet lärande och delning av teknik.

Channy Yun är en Principal Developer Advocate på AWS och brinner för att hjälpa utvecklare att bygga moderna applikationer på de senaste AWS-tjänsterna. Han är en pragmatisk utvecklare och bloggare i grunden, och han älskar gemenskapsdrivet lärande och delning av teknik.

Hwalsuk Lee är Chief Technology Officer (CTO) på Upstage. Han har arbetat för Samsung Techwin, NCSOFT och Naver som AI-forskare. Han bedriver sin doktorsexamen i data- och elektroteknik vid Korea Advanced Institute of Science and Technology (KAIST).

Hwalsuk Lee är Chief Technology Officer (CTO) på Upstage. Han har arbetat för Samsung Techwin, NCSOFT och Naver som AI-forskare. Han bedriver sin doktorsexamen i data- och elektroteknik vid Korea Advanced Institute of Science and Technology (KAIST).

Brandon Lee är Senior Solutions Architect på AWS, och hjälper främst stora utbildningsteknikkunder inom offentlig sektor. Han har över 20 års erfarenhet av att leda applikationsutveckling på globala företag och stora företag.

Brandon Lee är Senior Solutions Architect på AWS, och hjälper främst stora utbildningsteknikkunder inom offentlig sektor. Han har över 20 års erfarenhet av att leda applikationsutveckling på globala företag och stora företag.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/solar-models-from-upstage-are-now-available-in-amazon-sagemaker-jumpstart/

- : har

- :är

- :inte

- :var

- 10

- 120

- 152

- 20

- 20 år

- 2023

- 7

- 990

- a

- förmåga

- Om oss

- Acceptera

- tillgång

- tvärs

- Dessutom

- Dessutom

- skicklig

- avancerat

- förespråkare

- Avtal

- AI

- algoritmer

- Alla

- tillåter

- längs

- redan

- också

- amason

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- och

- och infrastruktur

- Meddela

- vilken som helst

- Ansökan

- Application Development

- tillämpningar

- Ansök

- godkänd

- arkitektur

- ÄR

- AS

- bedömning

- Assistent

- At

- förstärka

- myndighet

- tillgänglig

- undvika

- AWS

- AWS Marketplace

- bar

- baserat

- BE

- varit

- Blockera

- Blogg

- kropp

- Brandon

- SLUTRESULTAT

- Byggnad

- inbyggd

- men

- by

- kallas

- KAN

- kapacitet

- kortet

- vissa

- avgifter

- chatt

- billigare

- chef

- Chief Technology Officer

- Välja

- klarare

- koda

- Kommunikation

- Gemenskapsdriven

- kompakt

- Företag

- jämförbar

- kompatibel

- fullbordan

- följa

- Består

- Compute

- dator

- Konsol

- innehåll

- fortsatte

- kontroll

- konversationer

- Företag

- Kostar

- räkna

- skapa

- skapas

- CTO

- Kunder

- anpassning

- datum

- datavetenskap

- December

- Standard

- levererar

- demonstrera

- distribuera

- utplacerade

- utplacera

- utplacering

- detaljer

- utvecklade

- Utvecklare

- utvecklare

- Utveckling

- direkt

- Upptäck

- gör

- domäner

- ner

- pedagogiska

- effektivt

- effektiv

- höjer

- sysselsätter

- möjliggöra

- änden

- Slutpunkt

- Teknik

- Engelska

- förbättrad

- säkerställa

- säkerställa

- ange

- Miljö

- miljöer

- exempel

- exempel

- exciterade

- erfarenhet

- förlängas

- Ansikte

- snabbare

- färre

- Figur

- hitta

- efter

- För

- fundament

- ramar

- från

- fullständigt

- fungera

- generativ

- Generativ AI

- skaffa sig

- Välgörenhet

- Go

- grepp

- garantier

- vägleda

- hantera

- Har

- he

- Hjärta

- hjälpa

- hjälp

- hjälpa

- hjälper

- här.

- högpresterande

- hans

- värd

- Hur ser din drömresa ut

- How To

- html

- HTTPS

- Nav

- if

- illustrerar

- in

- innefattar

- Inklusive

- oberoende

- informationen

- Upplysande

- Infrastruktur

- inledande

- ingång

- ingångar

- exempel

- Institute

- integrerade

- interaktioner

- interaktiva

- in

- IT

- DESS

- jpg

- json

- korea

- koreanska

- landning

- språk

- Språk

- Large

- senaste

- Lagar

- leader

- ledande

- inlärning

- Lee

- Licens

- licenser

- listor

- Lama

- LLM

- lokal

- längre

- älskar

- lägre

- Maskinen

- maskininlärning

- gjord

- göra

- Framställning

- förvaltade

- förvaltar

- marknadsplats

- åtgärder

- Sammanfoga

- meddelanden

- meta

- metod

- metoder

- Metrics

- ML

- Mode

- modell

- modeller

- Modern Konst

- mer

- mer effektiv

- mycket

- Natural

- Naturlig språkbehandling

- Naver

- Navigering

- behövs

- Nej

- i synnerhet

- anteckningsbok

- nu

- nyanser

- of

- erbjudanden

- erbjuda

- Officer

- on

- endast

- öppet

- operativa

- optimerad

- Alternativet

- or

- Övriga

- ut

- Resultat

- utklassar

- över

- egen

- sida

- panelen

- parametrar

- särskilt

- särskilt

- brinner

- Utföra

- prestanda

- utfört

- phd

- bild

- höjdpunkt

- plato

- Platon Data Intelligence

- PlatonData

- Populära

- Inlägg

- den mäktigaste

- praxis

- pragmatisk

- exakt

- förbereda

- prissättning

- primärt

- Principal

- Skriva ut

- privat

- Problem

- bearbetning

- Produkt

- Produktion

- ge

- ger

- allmän

- syfte

- Python

- kvalitet

- som

- snabbt

- område

- nå

- verklig

- realtid

- register

- refererade

- föreskrifter

- Obligatorisk

- Kräver

- forskaren

- Upplösning

- Resurser

- respons

- svar

- resultera

- avkastning

- översyn

- Roll

- regler

- Körning

- runtime

- sagemaker

- SageMaker Inference

- prov

- Samsung

- skalning

- Vetenskap

- Vetenskap och teknik

- skript

- Sök

- sekunder

- sektor

- säkra

- se

- välj

- väljer

- senior

- service

- Tjänster

- in

- delning

- skall

- visade

- visar

- signifikant

- Storlek

- mindre

- sol-

- Lösningar

- några

- Utrymme

- specialisera

- specifik

- specifikt

- standarder

- starta

- igång

- Steg

- Fortfarande

- förvaring

- okomplicerad

- struktur

- studio

- prenumerera

- prenumeration

- Framgångsrikt

- sådana

- stödja

- Stöder

- säker

- system

- Ta

- tar

- uppgifter

- Teknologi

- villkor

- testa

- testade

- än

- den där

- Smakämnen

- Dessa

- de

- tredje part

- detta

- Genom

- tid

- gånger

- till

- verktyg

- spår

- Tåg

- Utbildning

- två

- Typ

- användning

- Begagnade

- Användare

- användningar

- med hjälp av

- olika

- mångsidig

- version

- via

- Video

- utsikt

- vänta

- gå

- garantier

- Kolla på

- vågor

- we

- webb

- webbservice

- Webb-baserad

- som

- bred

- Brett utbud

- kommer

- med

- inom

- arbetade

- år

- Om er

- Din

- Youtube

- zephyrnet