Prata med nästan vem som helst - vem som helst människa, det vill säga - och ditt samtal kommer att stöta på vad Malihe Alihani kallar "friska friktioner", ögonblick där ditt mål i samtalet stöter mot din partners, ögonblick som kräver förtydliganden, skapar förvirring eller leder till oenighet.

Inte så med stora språkmodeller.

Alikhani, biträdande professor vid Khoury College of Computer Sciences vid Northeastern University, säger att stora språkmodeller som ChatGPT har ett allvarligt problem med säkerhet.

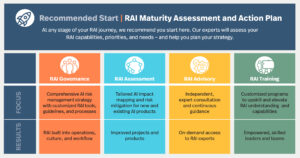

Alikhanis nya projekt, kallat Friction for Accountability in Conversational Transactions (FACT), är ett samarbete mellan Northeastern University, University of Illinois Urbana-Champaign och University of Southern California.

FACT-projektet finansieras genom ett anslag för utforskning av artificiell intelligens genom Defense Advanced Research Project Agency och syftar till att utveckla mer transparenta och rättvisa verktyg för artificiell intelligens.

"En av de saker som gör mänsklig kommunikation till ett fruktbart verktyg," säger Alikhani, "är det faktum att vi representerar vår osäkerhet i vårt tal, i vår ton. Vi sätter det i vårt ansiktsuttryck.”

De sunda friktioner som uppstår av osäkerhet i kommunikation mellan människa bidrar till att upprätthålla en mångfald av åsikter och synpunkter, fortsätter hon.

Men stora språkmodeller (eller LLM) är inte intresserade av att uttrycka sin osäkerhet, vilket resulterar i vad Alikhani kallar "syfantiskt beteende." Stora språkmodeller "vill maximera tillfredsställelsen" för sin användare, säger hon, och "inför aldrig någon friktion i konversationen, vare sig [modellen] är säker" på sina uttalanden eller inte.

Ytterligare problem uppstår med stora språkmodeller genom deras tendens att hallucinera. LLMs "hittar på fakta. De är väldigt bra på att övertyga folk om påhittade fakta.”

Trots dessa problem säger Alikhani också att människor är benägna att förlita sig för mycket på "fakta" som genereras av dessa artificiella intelligensmodeller, som "kan hitta på fakta för att göra dig lycklig."

En del av det som bidrar till att användarna är överdrivet beroende av LLM är deras "mänskliga beteenden", säger hon. "Det kommer att manipulera vår kognition."

Stora språkmodeller verkar också producera sina svar omedelbart, en annan faktor som får användare att anta korrekthet. "Det är svårt för oss AI-forskare att säga till folk," Ja, det är sammanhängande. Ja, det är snabbt. Ja, det stämmer in på din stil. Men det hallucinerar, säger Alikhani.

Under deras nya anslag kommer Alikhani och hennes team att designa verktyg som visar nivåerna av säkerhet en LLM har om ett uttalande den gör och introducera sunda friktioner i människa-AI-konversationer.

"Hur kan vi förutsäga och verbalisera systemets förtroende?" frågar Alikhani. Om en AI-modell är "bara 2% säker, bör den externisera det."

"Ett av huvudmålen med forskningen är att modellera osäkerhet, att externisera osäkerhet" och lära LLM hur man skildra den osäkerheten i en människa-AI-konversation. Detta kan visas i en användares gränssnitt som en percentilpoäng för modellens säkerhet, eller så kan modellen återspegla osäkerhet i dess svar på ett mer mänskligt sätt.

Till exempel, Alikhani föreställer sig en situation där en patient kan ställa en stor språkmodell en fråga om sin hälsa. Den nuvarande generationen av LLM kommer att försöka ge ett svar, även om det svaret kan visa sig vara farligt. Alikhani hoppas kunna bygga modeller som kan säga "'Jag vet inte. Du borde ringa din sjuksköterska.'”

"Robusthet är nyckeln till ansvarstagande inom AI", säger Alikhani. För närvarande är det vanligt att en LLM svarar med ett svar på en fråga vid tidpunkten för frågan och ett helt annat svar några minuter senare.

När det kommer till att designa AI som är både säker och ansvarsfull, hade tidigare AI-system som kunde hjälpa till med enkla uppgifter "inte tillgång till en massa andra datauppsättningar", säger Alikhani, "och de kunde inte säga saker som kan vara farliga , eftersom det inte fanns i deras data."

Exakt vad dessa datamängder inkluderar - eller utesluter - är nyckeln till att övervinna de fördomar som LLM visar mot "kön, men också subtilare fördomar, såsom in-versus ut-grupper och olika kognitiva fördomar som återspeglas i modeller för [stora språk]."

Nu hoppas Alikhani kunna designa modeller som servar människor med "olika möjligheter och preferenser", säger hon.

"Vi vill inte bara fortsätta bygga system för befolkningen vi har data för, utan vi tänker på vem vi lämnar bakom oss, och hur kan vi stoppa denna enorma klyfta av ojämlikhet istället för att göra den värre?" hon frågar. "Målet med mitt labb är att gå i den riktningen."

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://www.mtlc.co/large-language-models-can-lie-to-you-this-professor-wants-you-to-know-when-they-do/

- :är

- :inte

- :var

- $UPP

- 2%

- a

- Om oss

- tillgång

- ansvar

- ansvarig

- avancerat

- mot

- byrå

- AI

- AI-system

- Syftet

- nästan

- också

- an

- och

- Annan

- svara

- vilken som helst

- någon

- visas

- ÄR

- stiga upp

- konstgjord

- artificiell intelligens

- AS

- be

- be

- Assistent

- utgå ifrån

- At

- BE

- därför att

- beteenden

- bakom

- mellan

- förspänner

- båda

- SLUTRESULTAT

- Byggnad

- Bunch

- men

- by

- kalifornien

- Ring

- kallas

- Samtal

- KAN

- säkerhet

- ChatGPT

- kognition

- kognitiv

- SAMMANHÄNGANDE

- samverkan

- College

- kommer

- Gemensam

- Kommunikation

- fullständigt

- dator

- förtroende

- säker

- förvirring

- fortsätter

- bidrar

- Konversation

- konversera

- konversationer

- Rådet

- Aktuella

- Dangerous

- datum

- datauppsättningar

- Försvar

- demonstrera

- Designa

- design

- utveckla

- olika

- riktning

- Visa

- Mångfald

- do

- inte

- råka ut för

- rättvis

- Även

- utforskning

- uttryckande

- Uttrycket

- ansikts

- Faktum

- faktor

- fakta

- SNABB

- få

- För

- friktion

- från

- givande

- spalt

- genereras

- generering

- Målet

- Mål

- god

- bevilja

- lyckligt

- Hård

- Har

- Hälsa

- friska

- hjälpa

- här

- innehar

- hoppas

- Hur ser din drömresa ut

- How To

- HTTPS

- stor

- humant

- Människa

- if

- Illinois

- föreställer

- in

- innefattar

- ojämlikhet

- exempel

- ögonblickligen

- istället

- Intelligens

- intresserad

- Gränssnitt

- in

- införa

- problem

- IT

- DESS

- bara

- Ha kvar

- Nyckel

- Vet

- lab

- språk

- Large

- senare

- leda

- Ledarskap

- lämnar

- nivåer

- lie

- tycka om

- LLM

- gjord

- Huvudsida

- bibehålla

- göra

- GÖR

- Framställning

- Massa

- Maximera

- kanske

- minuter

- modell

- modeller

- ögonblick

- Ögonblick

- mer

- flytta

- my

- Nya

- Northeastern University

- of

- on

- ONE

- Åsikter

- or

- Övriga

- vår

- ut

- över

- övervinna

- Patienten

- Personer

- plato

- Platon Data Intelligence

- PlatonData

- befolkning

- förutse

- preferenser

- föregående

- Problem

- problem

- producera

- Professor

- projektet

- ge

- sätta

- fråga

- fråga

- reflektera

- reflekterad

- förlita

- representerar

- kräver

- forskning

- Svara

- svar

- resulterande

- säker

- säga

- säger

- VETENSKAPER

- vetenskapsmän

- göra

- verka

- allvarlig

- service

- hon

- skall

- Enkelt

- Situationen

- So

- Sydlig

- tal

- .

- uttalanden

- Sluta

- stil

- sådana

- system

- System

- uppgifter

- grupp

- tech

- tala

- tendens

- den där

- Smakämnen

- deras

- Dessa

- de

- saker

- tror

- detta

- de

- Genom

- tid

- till

- TON

- verktyg

- verktyg

- mot

- mot

- Transaktioner

- transparent

- prova

- trimma

- SVÄNG

- Osäkerhet

- universitet

- us

- Användare

- användare

- Kontra

- mycket

- synpunkter

- vill

- vill

- var

- Sätt..

- we

- Vad

- när

- om

- som

- VEM

- kommer

- med

- inom

- sämre

- ja

- Om er

- Din

- zephyrnet