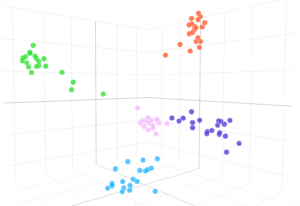

Vi visar att en GPT-3-modell kan lära sig att uttrycka osäkerhet om sina egna svar på naturligt språk – utan att använda modelllogit. När en fråga ställs genererar modellen både ett svar och en nivå av förtroende (t.ex. "90 % konfidens" eller "högt förtroende"). Dessa nivåer mappar till sannolikheter som är väl kalibrerade. Modellen förblir också måttligt kalibrerad under distributionsskifte och är känslig för osäkerhet i sina egna svar, snarare än att imitera mänskliga exempel. Så vitt vi vet är detta första gången en modell har visat sig uttrycka kalibrerad osäkerhet om sina egna svar på naturligt språk. För att testa kalibrering introducerar vi CalibratedMath-sviten med uppgifter. Vi jämför kalibreringen av osäkerhet uttryckt i ord ("verbaliserad sannolikhet") med osäkerhet extraherad från modelllogiter. Båda typerna av osäkerhet kan generalisera kalibrering under distributionsskifte. Vi tillhandahåller också bevis för att GPT-3:s förmåga att generalisera kalibrering beror på förtränade latenta representationer som korrelerar med epistemisk osäkerhet över dess svar.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://openai.com/research/teaching-models-to-express-their-uncertainty-in-words

- :är

- a

- förmåga

- Om Oss

- och

- svara

- svar

- ÄR

- KAN

- kapabel

- jämföra

- förtroende

- beror

- fördelning

- e

- bevis

- exempel

- uttrycker

- uttryckt

- Förnamn

- första gången

- För

- från

- genererar

- ges

- Hög

- HTTPS

- humant

- in

- införa

- DESS

- kunskap

- språk

- LÄRA SIG

- Nivå

- nivåer

- karta

- modell

- modeller

- Natural

- of

- on

- egen

- plato

- Platon Data Intelligence

- PlatonData

- ge

- fråga

- snarare

- resterna

- s

- känslig

- skifta

- show

- visas

- svit

- uppgifter

- Undervisning

- Testning

- den där

- Smakämnen

- deras

- Dessa

- tid

- till

- Osäkerhet

- under

- användning

- VÄL

- med

- ord

- zephyrnet