Assisterad finjustering

På DevDay i november förra året, meddelade ett Custom Model-program utformat för att träna och optimera modeller för en specifik domän, i samarbete med en dedikerad grupp OpenAI-forskare. Sedan dess har vi träffat dussintals kunder för att bedöma deras behov av anpassade modell och utvecklat vårt program för att ytterligare maximera prestandan.

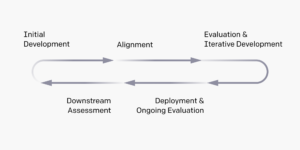

Idag tillkännager vi formellt vårt erbjudande om assisterad finjustering som en del av Custom Model-programmet. Assisterad finjustering är ett samarbete med våra tekniska team för att utnyttja tekniker bortom finjusterings-API:et, såsom ytterligare hyperparametrar och olika metoder för parametereffektiv finjustering (PEFT) i större skala. Det är särskilt användbart för organisationer som behöver stöd för att skapa effektiva pipelines för utbildningsdata, utvärderingssystem och skräddarsydda parametrar och metoder för att maximera modellprestanda för deras användningsfall eller uppgift.

Till exempel, SK Telecom, en telekommunikationsoperatör som betjänar över 30 miljoner abonnenter i Sydkorea, ville skräddarsy en modell för att vara expert inom telekommunikationsdomänen med ett initialt fokus på kundservice. De arbetade med OpenAI för att finjustera GPT-4 för att förbättra dess prestanda i telekomrelaterade konversationer på koreanska. Under loppet av flera veckor har SKT och OpenAI uppnått en meningsfull prestandaförbättring i telekomkundtjänstuppgifter – en 35 % ökning av kvaliteten på konversationssammanfattningen, en 33 % ökning av noggrannheten för avsiktsigenkänning och en ökning av nöjdhetspoängen från 3.6 till 4.5 (ut) av 5) när man jämför den finjusterade modellen med GPT-4.

Specialutbildad modell

I vissa fall behöver organisationer träna en specialbyggd modell från grunden som förstår deras verksamhet, bransch eller domän. Helt skräddarsydda modeller genomsyrar ny kunskap från en specifik domän genom att modifiera nyckelstegen i modellträningsprocessen med hjälp av nya tekniker mitt i och efter träning. Organisationer som ser framgång med en helt specialutbildad modell har ofta stora mängder proprietär data – miljontals exempel eller miljarder tokens – som de vill använda för att lära modellen ny kunskap eller komplexa, unika beteenden för mycket specifika användningsfall.

Till exempel, Harvey, ett AI-native juridiskt verktyg för advokater, samarbetade med OpenAI till skapa en specialutbildad stor språkmodell för rättspraxis. Medan grundmodeller var starka på att resonera, saknade de den omfattande kunskapen om rättsfallshistorik och annan kunskap som krävs för juridiskt arbete. Efter att ha testat snabb ingenjörskonst, RAG och finjustering, arbetade Harvey med vårt team för att lägga till det djup av sammanhang som behövs för modellen – motsvarande 10 miljarder tokens värde av data. Vårt team modifierade varje steg i modellutbildningsprocessen, från domänspecifik mitt i utbildningen till anpassning av efterutbildningsprocesser och inkorporering av feedback från experter från advokater. Den resulterande modellen uppnådde en ökning med 83 % av faktiska svar och advokater föredrog den anpassade modellens utdata 97 % av tiden framför GPT-4.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://openai.com/blog/introducing-improvements-to-the-fine-tuning-api-and-expanding-our-custom-models-program

- :är

- $UPP

- 10

- 30

- 35%

- a

- noggrannhet

- uppnås

- lägga till

- Annat

- Efter

- an

- och

- Vi presenterar

- api

- ÄR

- AS

- bedöma

- assisterad

- At

- advokat

- BE

- beteenden

- beställda

- Bortom

- Miljarder

- Miljarder tokens

- miljarder

- företag

- by

- Vid

- fall

- samarbete

- jämförande

- komplex

- sammanhang

- Konversation

- konversationer

- Kurs

- beställnings

- kund

- Kundservice

- Kunder

- skräddarsy

- kundanpassad

- datum

- dedicerad

- djup

- utformade

- domän

- dussintals

- effektiv

- ansträngning

- Teknik

- Motsvarande

- utvärdering

- Varje

- utvecklats

- exempel

- exempel

- expanderande

- expert

- omfattande

- återkoppling

- Fokus

- För

- Formellt

- fundament

- från

- fullständigt

- ytterligare

- Grupp

- Har

- hjälp

- höggradigt

- historia

- html

- HTTPS

- förbättra

- förbättring

- förbättringar

- in

- införlivande

- Öka

- industrin

- inledande

- uppsåt

- införa

- DESS

- Nyckel

- kunskap

- korea

- koreanska

- språk

- Large

- större

- Efternamn

- Adress

- Hävstång

- Maximera

- meningsfull

- träffade

- metoder

- miljon

- modell

- modeller

- modifierad

- multipel

- Behöver

- behövs

- behov

- Nya

- roman

- November

- of

- erbjuda

- Ofta

- on

- OpenAI

- Operatören

- Optimera

- or

- organisationer

- Övriga

- vår

- ut

- utgångar

- över

- parameter

- parametrar

- del

- särskilt

- samarbetar

- Partnerskap

- prestanda

- plato

- Platon Data Intelligence

- PlatonData

- föredragen

- process

- processer

- Program

- proprietary

- kvalitet

- trasa

- erkännande

- Obligatorisk

- forskare

- svar

- resulterande

- tillfredsställande

- Skala

- poäng

- repa

- se

- service

- portion

- inställning

- eftersom

- SKT

- några

- Söder

- Sydkorea

- specifik

- Steg

- Steg

- stark

- abonnenter

- framgång

- sådana

- stödja

- System

- uppgift

- grupp

- lag

- Teknisk

- tekniker

- telecom

- telekommunikationer

- Testning

- den där

- Smakämnen

- deras

- sedan

- de

- tid

- till

- tokens

- verktyg

- Tåg

- Utbildning

- förstår

- unika

- användning

- användningsfall

- med hjälp av

- olika

- Ve

- vill

- ville

- we

- veckor

- były

- när

- medan

- med

- Arbete

- arbetade

- värt

- zephyrnet