วันนี้เรารู้สึกตื่นเต้นที่จะประกาศว่า มิกซ์ทรัล-8x7B โมเดลภาษาขนาดใหญ่ (LLM) ซึ่งพัฒนาโดย Mistral AI พร้อมให้บริการแก่ลูกค้าผ่าน Amazon SageMaker JumpStart เพื่อปรับใช้ด้วยการคลิกเพียงครั้งเดียวสำหรับการอนุมาน Mixtral-8x7B LLM เป็นส่วนผสมแบบเบาบางที่ได้รับการฝึกอบรมล่วงหน้าของแบบจำลองผู้เชี่ยวชาญ โดยอิงตามแกนหลักของพารามิเตอร์ 7 พันล้านพร้อมด้วยผู้เชี่ยวชาญ 8 คนต่อเลเยอร์การป้อนไปข้างหน้า คุณสามารถลองใช้โมเดลนี้กับ SageMaker JumpStart ซึ่งเป็นฮับแมชชีนเลิร์นนิง (ML) ที่ให้การเข้าถึงอัลกอริทึมและโมเดล เพื่อให้คุณสามารถเริ่มต้นใช้งาน ML ได้อย่างรวดเร็ว ในโพสต์นี้ เราจะอธิบายวิธีการค้นหาและปรับใช้โมเดล Mixtral-7xXNUMXB

Mixtral-8x7B คืออะไร

Mixtral-8x7B เป็นโมเดลพื้นฐานที่พัฒนาโดย Mistral AI รองรับข้อความภาษาอังกฤษ ฝรั่งเศส เยอรมัน อิตาลี และสเปน พร้อมความสามารถในการสร้างโค้ด รองรับกรณีการใช้งานที่หลากหลาย เช่น การสรุปข้อความ การจัดหมวดหมู่ การเติมข้อความให้สมบูรณ์ และการเติมโค้ดให้สมบูรณ์ มันทำงานได้ดีในโหมดแชท เพื่อแสดงให้เห็นถึงความสามารถในการปรับแต่งโมเดลได้อย่างตรงไปตรงมา Mistral AI ยังได้เปิดตัวโมเดล Mixtral-8x7B-instruct สำหรับกรณีการใช้งานแชท โดยได้รับการปรับแต่งอย่างละเอียดโดยใช้ชุดข้อมูลการสนทนาที่เผยแพร่ต่อสาธารณะที่หลากหลาย โมเดล Mixtral มีความยาวบริบทขนาดใหญ่มากถึง 32,000 โทเค็น

Mixtral-8x7B ให้การปรับปรุงประสิทธิภาพอย่างมีนัยสำคัญมากกว่ารุ่นล้ำสมัยก่อนหน้านี้ การผสมผสานที่เบาบางของสถาปัตยกรรมผู้เชี่ยวชาญช่วยให้ได้รับผลลัพธ์ประสิทธิภาพที่ดีขึ้นจากเกณฑ์มาตรฐานการประมวลผลภาษาธรรมชาติ (NLP) 9 จาก 12 รายการทดสอบโดย มิสทรัล AI. Mixtral ตรงหรือเกินกว่าประสิทธิภาพของรุ่นที่มีขนาดถึง 10 เท่า ด้วยการใช้เพียงเศษเสี้ยวของพารามิเตอร์ต่อโทเค็น ทำให้ได้รับความเร็วในการอนุมานที่เร็วขึ้นและต้นทุนการคำนวณที่ลดลง เมื่อเทียบกับโมเดลที่มีความหนาแน่นสูงในขนาดที่เท่ากัน ตัวอย่างเช่น โดยมีพารามิเตอร์ทั้งหมด 46.7 พันล้านพารามิเตอร์ แต่มีเพียง 12.9 พันล้านที่ใช้ต่อโทเค็น การผสมผสานระหว่างประสิทธิภาพสูง การสนับสนุนหลายภาษา และประสิทธิภาพในการคำนวณทำให้ Mixtral-8x7B เป็นตัวเลือกที่น่าสนใจสำหรับแอปพลิเคชัน NLP

โมเดลนี้จัดทำขึ้นภายใต้ลิขสิทธิ์ Apache 2.0 ที่ได้รับอนุญาต สำหรับการใช้งานโดยไม่มีข้อจำกัด

SageMaker JumpStart คืออะไร

ด้วย SageMaker JumpStart ผู้ปฏิบัติงาน ML สามารถเลือกจากรายการโมเดลพื้นฐานที่มีประสิทธิภาพดีที่สุดที่มีเพิ่มขึ้นเรื่อยๆ ผู้ปฏิบัติงาน ML สามารถปรับใช้โมเดลพื้นฐานเพื่อการใช้งานเฉพาะได้ อเมซอน SageMaker อินสแตนซ์ภายในสภาพแวดล้อมที่แยกเครือข่าย และปรับแต่งโมเดลโดยใช้ SageMaker สำหรับการฝึกโมเดลและการปรับใช้

ตอนนี้คุณสามารถค้นพบและปรับใช้ Mixtral-8x7B ได้ด้วยการคลิกเพียงไม่กี่ครั้ง สตูดิโอ Amazon SageMaker หรือทางโปรแกรมผ่าน SageMaker Python SDK ทำให้คุณได้รับประสิทธิภาพของแบบจำลองและการควบคุม MLOps ด้วยคุณลักษณะของ SageMaker เช่น ท่อส่ง Amazon SageMaker, ดีบักเกอร์ Amazon SageMakerหรือบันทึกคอนเทนเนอร์ โมเดลนี้ได้รับการปรับใช้ในสภาพแวดล้อมที่ปลอดภัยของ AWS และอยู่ภายใต้การควบคุม VPC ของคุณ ซึ่งช่วยรับรองความปลอดภัยของข้อมูล

ค้นพบแบบจำลอง

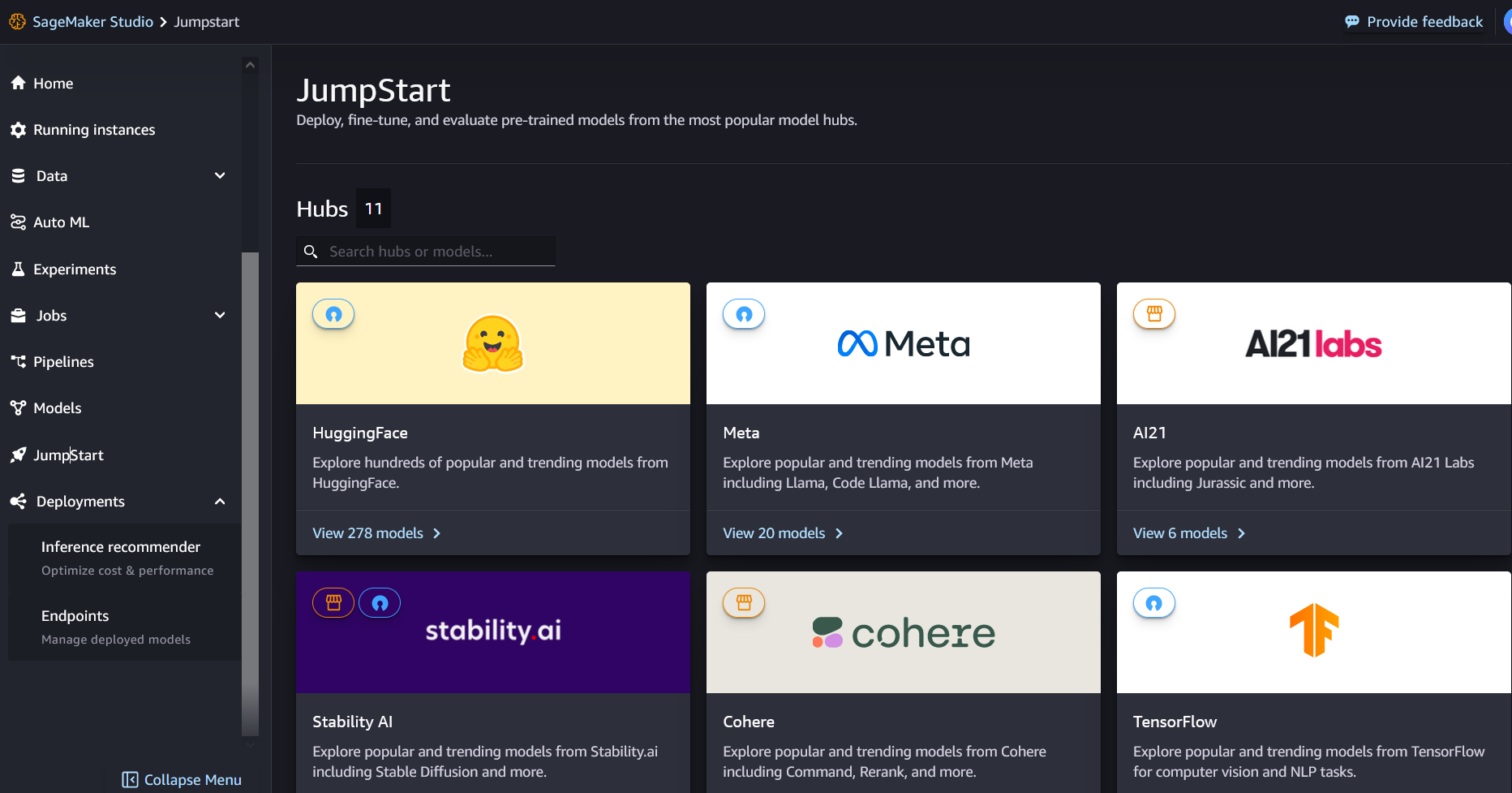

คุณสามารถเข้าถึงโมเดลพื้นฐาน Mixtral-8x7B ผ่าน SageMaker JumpStart ใน SageMaker Studio UI และ SageMaker Python SDK ในส่วนนี้ เราจะอธิบายวิธีค้นหาโมเดลใน SageMaker Studio

SageMaker Studio เป็นสภาพแวดล้อมการพัฒนาแบบผสานรวม (IDE) ที่มีอินเทอร์เฟซภาพบนเว็บเดียว ซึ่งคุณสามารถเข้าถึงเครื่องมือที่สร้างขึ้นตามวัตถุประสงค์เพื่อดำเนินการตามขั้นตอนการพัฒนา ML ทั้งหมด ตั้งแต่การเตรียมข้อมูลไปจนถึงการสร้าง การฝึกอบรม และนำโมเดล ML ของคุณไปใช้จริง สำหรับรายละเอียดเพิ่มเติมเกี่ยวกับวิธีเริ่มต้นใช้งานและตั้งค่า SageMaker Studio โปรดดูที่ สตูดิโอ Amazon SageMaker.

ใน SageMaker Studio คุณสามารถเข้าถึง SageMaker JumpStart ได้โดยการเลือก เริ่มกระโดด ในบานหน้าต่างนำทาง

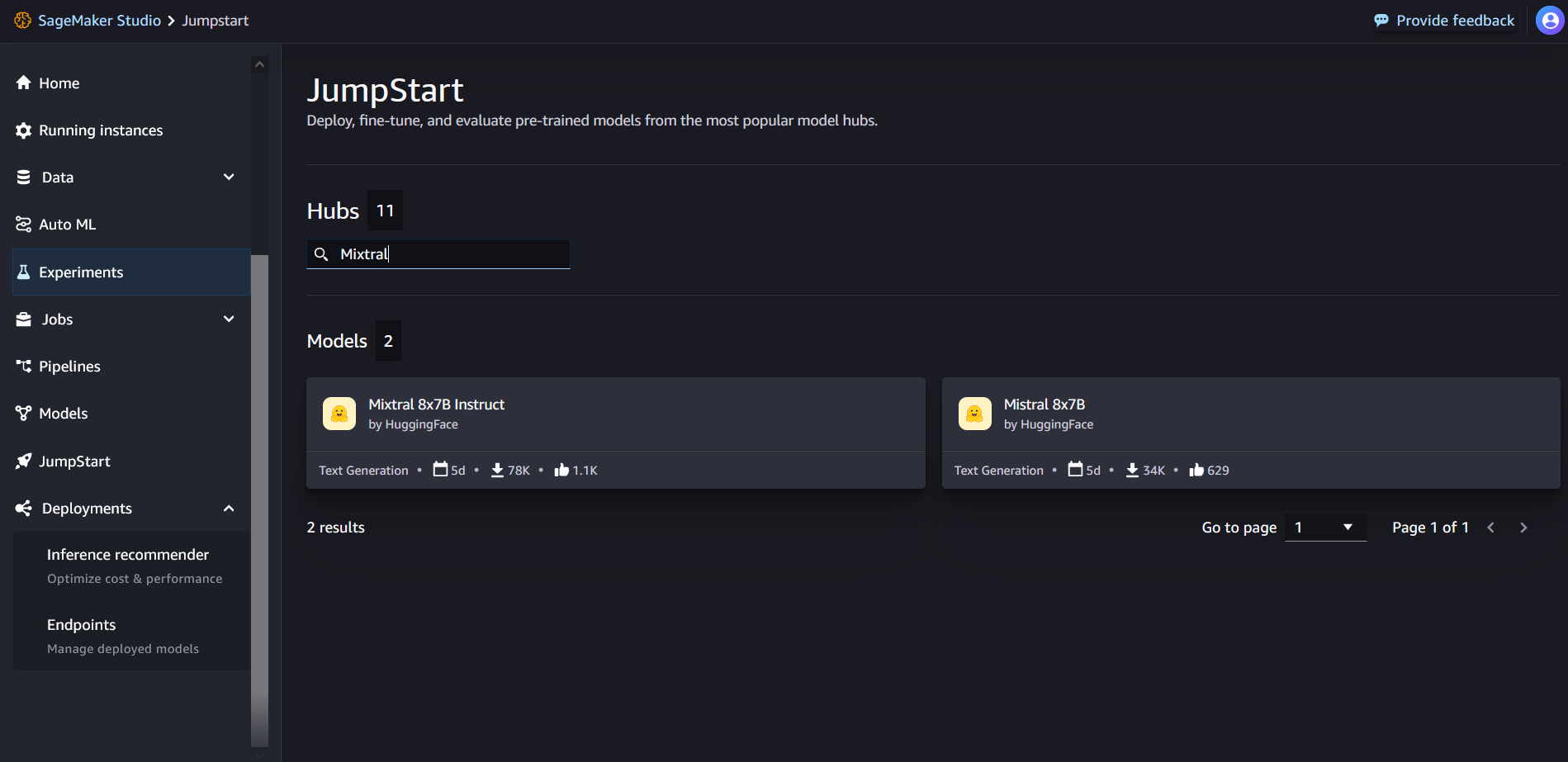

จากหน้า Landing Page ของ SageMaker JumpStart คุณสามารถค้นหา “Mixtral” ในช่องค้นหาได้ คุณจะเห็นผลการค้นหาที่แสดงคำสั่ง Mixtral 8x7B และ Mixtral 8x7B

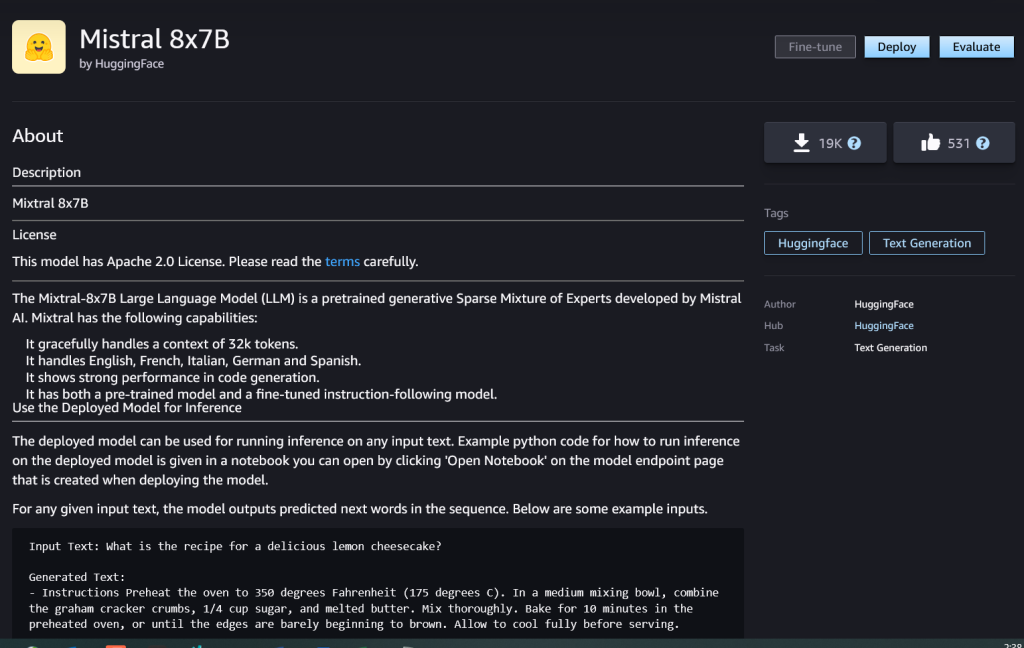

คุณสามารถเลือกการ์ดโมเดลเพื่อดูรายละเอียดเกี่ยวกับโมเดล เช่น ใบอนุญาต ข้อมูลที่ใช้ในการฝึก และวิธีการใช้งาน นอกจากนี้คุณยังจะได้พบกับ ปรับใช้ ปุ่ม ซึ่งคุณสามารถใช้เพื่อปรับใช้โมเดลและสร้างจุดสิ้นสุดได้

ปรับใช้โมเดล

การปรับใช้เริ่มต้นเมื่อคุณเลือก ปรับใช้. หลังจากการปรับใช้เสร็จสิ้น คุณได้สร้างอุปกรณ์ปลายทางแล้ว คุณสามารถทดสอบตำแหน่งข้อมูลได้โดยการส่งเพย์โหลดคำขอการอนุมานตัวอย่าง หรือเลือกตัวเลือกการทดสอบของคุณโดยใช้ SDK เมื่อคุณเลือกตัวเลือกเพื่อใช้ SDK คุณจะเห็นโค้ดตัวอย่างที่คุณสามารถใช้ในโปรแกรมแก้ไขสมุดบันทึกที่คุณต้องการใน SageMaker Studio

หากต้องการปรับใช้โดยใช้ SDK เราเริ่มต้นด้วยการเลือกรุ่น Mixtral-8x7B ที่ระบุโดย model_id with value huggingface-llm-mixtral-8x7b. คุณสามารถปรับใช้โมเดลที่เลือกบน SageMaker ด้วยโค้ดต่อไปนี้ ในทำนองเดียวกัน คุณสามารถปรับใช้คำสั่ง Mixtral-8x7B โดยใช้รหัสโมเดลของตัวเอง:

ซึ่งจะปรับใช้โมเดลบน SageMaker ด้วยการกำหนดค่าเริ่มต้น รวมถึงประเภทอินสแตนซ์เริ่มต้นและการกำหนดค่า VPC เริ่มต้น คุณสามารถเปลี่ยนการกำหนดค่าเหล่านี้ได้โดยการระบุค่าที่ไม่ใช่ค่าเริ่มต้น JumpStartโมเดล.

หลังจากปรับใช้แล้ว คุณสามารถเรียกใช้การอนุมานกับตำแหน่งข้อมูลที่ใช้งานผ่านตัวทำนาย SageMaker ได้:

ตัวอย่างคำแนะนำ

คุณสามารถโต้ตอบกับโมเดล Mixtral-8x7B ได้เหมือนกับโมเดลการสร้างข้อความมาตรฐานทั่วไป โดยที่โมเดลจะประมวลผลลำดับอินพุตและเอาต์พุตที่คาดการณ์คำถัดไปในลำดับ ในส่วนนี้ เราจะแสดงตัวอย่างพร้อมท์

การสร้างรหัส

จากตัวอย่างก่อนหน้านี้ เราสามารถใช้พร้อมท์การสร้างโค้ดดังต่อไปนี้:

คุณได้รับผลลัพธ์ต่อไปนี้:

พรอมต์การวิเคราะห์ความรู้สึก

คุณสามารถดำเนินการวิเคราะห์ความรู้สึกได้โดยใช้ข้อความแจ้งดังต่อไปนี้กับ Mixtral 8x7B:

คุณได้รับผลลัพธ์ต่อไปนี้:

เฉลยการตอบคำถาม

คุณสามารถใช้พร้อมท์การตอบคำถามดังต่อไปนี้กับ Mixtral-8x7B:

คุณได้รับผลลัพธ์ต่อไปนี้:

คำแนะนำ Mixtral-8x7B

Mixtral-8x7B เวอร์ชันปรับแต่งคำสั่งยอมรับคำสั่งที่มีรูปแบบ โดยที่บทบาทการสนทนาต้องเริ่มต้นด้วยพรอมต์ผู้ใช้และสลับระหว่างคำสั่งผู้ใช้กับผู้ช่วย (คำตอบแบบจำลอง) รูปแบบคำสั่งจะต้องได้รับการเคารพอย่างเคร่งครัด มิฉะนั้น โมเดลจะสร้างเอาต์พุตที่ด้อยประสิทธิภาพที่สุด เทมเพลตที่ใช้ในการสร้างพรอมต์สำหรับโมเดล Instruct มีการกำหนดไว้ดังนี้:

โปรดทราบว่า <s> และ </s> เป็นโทเค็นพิเศษสำหรับจุดเริ่มต้นของสตริง (BOS) และจุดสิ้นสุดของสตริง (EOS) ในขณะที่ [INST] และ [/INST] เป็นสตริงปกติ

รหัสต่อไปนี้แสดงวิธีที่คุณสามารถจัดรูปแบบพรอมต์ในรูปแบบคำสั่ง:

การสืบค้นความรู้

คุณสามารถใช้รหัสต่อไปนี้สำหรับพร้อมท์การเรียกค้นความรู้:

คุณได้รับผลลัพธ์ต่อไปนี้:

การเข้ารหัส

โมเดล Mixtral สามารถแสดงให้เห็นถึงจุดแข็งในการวัดประสิทธิภาพสำหรับงานเขียนโค้ด ดังที่แสดงในโค้ดต่อไปนี้:

คณิตศาสตร์และการให้เหตุผล

แบบจำลอง Mixtral ยังรายงานจุดแข็งในด้านความแม่นยำทางคณิตศาสตร์ด้วย:

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- $ ขึ้น

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26%

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- ความสามารถ

- เกี่ยวกับเรา

- ข้างบน

- เร่ง

- ยอมรับ

- เข้า

- บัญชี

- ความถูกต้อง

- บรรลุ

- ประสบความสำเร็จ

- ข้าม

- คล่องแคล่ว

- ที่เพิ่ม

- เพิ่ม

- หลังจาก

- กับ

- AI

- AI / ML

- อัลกอริทึม

- ทั้งหมด

- ด้วย

- อเมซอน

- อเมซอน SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- จำนวน

- an

- การวิเคราะห์

- และ

- และโครงสร้างพื้นฐาน

- ประกาศ

- คำตอบ

- ใด

- อาปาเช่

- อุทธรณ์

- การใช้งาน

- ประยุกต์

- การประยุกต์ใช้

- สถาปัตยกรรม

- เป็น

- อาร์กิวเมนต์

- บทความ

- AS

- ผู้ช่วย

- At

- ใช้ได้

- AWS

- กลับ

- กระดูกสันหลัง

- ตาม

- ทุบตี

- แบตเตอรี่

- เบย์เซียน

- BE

- เพราะ

- รับ

- ก่อน

- การเริ่มต้น

- เชื่อ

- ระฆัง

- เกณฑ์มาตรฐาน

- มาตรฐาน

- ดีกว่า

- ระหว่าง

- บิล

- การเรียกเก็บเงิน

- พันล้าน

- กล้า

- ซื้อ

- กล่อง

- ทำลาย

- นำมาซึ่ง

- สร้าง

- การก่อสร้าง

- built-in

- ธุรกิจ

- แต่

- by

- คำนวณ

- โทรศัพท์

- ที่เรียกว่า

- โทร

- CAN

- บัตร

- กรณี

- กรณี

- เปลี่ยนแปลง

- พูดคุย

- ทางเลือก

- Choose

- เลือก

- คริส

- การจัดหมวดหมู่

- คลิก

- รหัส

- การเข้ารหัส

- การผสมผสาน

- เมื่อเทียบกับ

- รวบรวม

- เสร็จสิ้น

- การคำนวณ

- คำนวณ

- คอมพิวเตอร์

- วิสัยทัศน์คอมพิวเตอร์

- การประชุม

- ไม่หยุดหย่อน

- ภาชนะ

- เนื้อหา

- สิ่งแวดล้อม

- อย่างต่อเนื่อง

- อย่างต่อเนื่อง

- การควบคุม

- การสนทนา

- ราคา

- ค่าใช้จ่าย

- ได้

- สร้าง

- ที่สร้างขึ้น

- สำคัญมาก

- ถ้วย

- ปัจจุบัน

- ลูกค้า

- การปรับแต่ง

- ปรับแต่ง

- ข้อมูล

- ความปลอดภัยของข้อมูล

- ชุดข้อมูล

- วัน

- วัน

- ทุ่มเท

- ค่าเริ่มต้น

- กำหนด

- democratizing

- สาธิต

- ปรับใช้

- นำไปใช้

- ปรับใช้

- การใช้งาน

- Deploys

- ได้มา

- รายละเอียด

- พัฒนา

- พัฒนา

- ผู้พัฒนา

- พัฒนาการ

- Dict

- DID

- ค้นพบ

- do

- ทำ

- ดอลลาร์

- โดเมน

- ทำ

- ลง

- หล่น

- ดยุค

- มหาวิทยาลัยดุ๊ก

- แต่ละ

- ด้านเศรษฐกิจ

- บรรณาธิการ

- อย่างมีประสิทธิภาพ

- ไข่

- อื่น

- ทำให้สามารถ

- ช่วยให้

- การเปิดใช้งาน

- ปลาย

- ปลายทาง

- ชั้นเยี่ยม

- ภาษาอังกฤษ

- ทำให้มั่นใจ

- สิ่งแวดล้อม

- EOS

- เท่ากัน

- เท่ากัน

- ตามหลักจริยธรรม

- ตัวอย่าง

- เกินกว่า

- ตื่นเต้น

- ไม่รวม

- ชำนาญ

- ผู้เชี่ยวชาญ

- อธิบาย

- คำอธิบาย

- นามสกุล

- ครอบครัว

- เร็วขึ้น

- คุณสมบัติ

- สองสาม

- ไฟล์

- ฟิลเตอร์

- หา

- ชื่อจริง

- ดังต่อไปนี้

- ดังต่อไปนี้

- สำหรับ

- รูป

- รากฐาน

- เศษ

- ภาษาฝรั่งเศส

- ราคาเริ่มต้นที่

- ฟังก์ชัน

- อนาคต

- จุดประสงค์ทั่วไป

- สร้าง

- สร้าง

- รุ่น

- กำเนิด

- กำเนิด AI

- ภาษาเยอรมัน

- ได้รับ

- Go

- ดี

- ได้

- การเจริญเติบโต

- เกลียด

- มี

- he

- ช่วย

- การช่วยเหลือ

- จะช่วยให้

- เธอ

- โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม

- จุดสูง

- ภูเขา

- ของเขา

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- HTML

- HTTPS

- Hub

- i

- ICE

- ไอศครีม

- ID

- if

- อิลลินอยส์

- การเจ็บป่วย

- นำเข้า

- สำคัญ

- ปรับปรุง

- การปรับปรุง

- in

- ประกอบด้วย

- รวมทั้ง

- Incorporated

- โครงสร้างพื้นฐาน

- อินพุต

- ปัจจัยการผลิต

- ตัวอย่าง

- คำแนะนำการใช้

- รวบรวม

- แบบบูรณาการ

- โต้ตอบ

- ผลประโยชน์

- อินเตอร์เฟซ

- การประดิษฐ์คิดค้น

- เปลี่ยว

- IT

- อิตาลี

- ITS

- ตัวเอง

- jpg

- เด็ก

- ความรู้

- Kyle

- ห้องปฏิบัติการ

- เชื่อมโยงไปถึง

- ภาษา

- ใหญ่

- ชื่อสกุล

- ชั้น

- นำไปสู่

- การเรียนรู้

- ความยาว

- ให้

- License

- กดไลก์

- ยอดไลก์

- ขีด จำกัด

- LINK

- รายการ

- การฟัง

- น้อย

- LLM

- ตรรกะ

- ที่ต้องการหา

- ลด

- เครื่อง

- เรียนรู้เครื่อง

- ทำ

- ทำให้

- การทำ

- ผู้จัดการ

- หลาย

- ที่ตรงกัน

- คณิตศาสตร์

- คณิตศาสตร์

- me

- กลาง

- สารผสม

- ML

- ม.ป.ป

- โหมด

- แบบ

- โมเดล

- การแก้ไข

- เดือน

- ข้อมูลเพิ่มเติม

- รถจักรยานยนต์

- มาก

- คูณ

- ดนตรี

- ต้อง

- my

- โดยธรรมชาติ

- ประมวลผลภาษาธรรมชาติ

- การเดินเรือ

- เชิงลบ

- เครือข่าย

- เป็นกลาง

- ใหม่

- ถัดไป

- NLP

- ไม่มี

- หมายเหตุ

- สมุดบันทึก

- ตอนนี้

- จำนวน

- of

- น้ำมัน

- on

- ครั้งเดียว

- ONE

- เพียง

- การดำเนินงาน

- ระบบปฏิบัติการ

- ตัวเลือกเสริม (Option)

- or

- อื่นๆ

- มิฉะนั้น

- ออก

- เอาท์พุต

- เอาท์พุท

- ด้านนอก

- เกิน

- ของตนเอง

- หน้า

- ต้องจ่าย

- บานหน้าต่าง

- เอกสาร

- พารามิเตอร์

- พารามิเตอร์

- ที่ผ่านไป

- กิเลส

- หลงใหล

- เส้นทาง

- ต่อ

- ดำเนินการ

- การปฏิบัติ

- phd

- โทรศัพท์

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- จุด

- แบบพกพา

- บวก

- โพสต์

- มาก่อน

- ที่คาดการณ์

- Predictor

- ที่ต้องการ

- การเตรียมความพร้อม

- ก่อน

- หลัก

- พิมพ์

- ขั้นตอน

- กระบวนการ

- กระบวนการ

- การประมวลผล

- ผลิตภัณฑ์

- โครงการ

- การเขียนโปรแกรม

- แจ้ง

- ความเจริญ

- ให้

- ผู้ให้บริการ

- ให้

- สาธารณชน

- การตีพิมพ์

- หลาม

- หนึ่งในสี่

- คำถาม

- อย่างรวดเร็ว

- RE

- การอ่าน

- สูตร

- ซ้ำ

- ลด

- อ้างอิง

- ปกติ

- การเผยแพร่

- รายงาน

- ขอ

- การวิจัย

- นักวิจัย

- แหล่งข้อมูล

- ที่เคารพนับถือ

- คำตอบ

- รับผิดชอบ

- ข้อ จำกัด

- ผล

- ผลสอบ

- กลับ

- รับคืน

- การขี่

- ความเสี่ยง

- บทบาท

- บทบาท

- ห้อง

- วิ่ง

- วิ่ง

- s

- SA

- sagemaker

- เกลือ

- ที่ปรับขนาดได้

- ขนาด

- วิทยาศาสตร์

- นักวิทยาศาสตร์

- SDK

- ค้นหา

- Section

- ปลอดภัย

- ความปลอดภัย

- เห็น

- เลือก

- เลือก

- การเลือก

- การเลือก

- ระดับอาวุโส

- ความรู้สึก

- แยก

- ลำดับ

- ชุด

- บริการ

- ชุด

- แสดงให้เห็นว่า

- แสดง

- แสดงให้เห็นว่า

- สำคัญ

- เหมือนกับ

- ง่าย

- ตั้งแต่

- เดียว

- ขนาด

- So

- สังคม

- สังคม

- ซอฟต์แวร์

- ทางออก

- สเปน

- พิเศษ

- ผู้เชี่ยวชาญ

- ที่ระบุไว้

- ความเร็ว

- การใช้จ่าย

- มาตรฐาน

- เริ่มต้น

- ข้อความที่เริ่ม

- เริ่มต้น

- รัฐของศิลปะ

- ทางสถิติ

- ขั้นตอน

- ขั้นตอน

- ยังคง

- หยุด

- จัดเก็บ

- ซื่อตรง

- ยุทธศาสตร์

- กระแส

- จุดแข็ง

- เชือก

- โครงสร้าง

- สตูดิโอ

- อย่างเช่น

- สนับสนุน

- ที่สนับสนุน

- รองรับ

- ระบบ

- ใช้เวลา

- งาน

- ลิ้มรส

- ทีม

- เทคโนโลยี

- เทมเพลต

- ทดสอบ

- การทดสอบ

- การทดสอบ

- ข้อความ

- ที่

- พื้นที่

- ก้าวสู่อนาคต

- แล้วก็

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- นี้

- ตลอด

- เวลา

- อนุกรมเวลา

- ครั้ง

- ไปยัง

- ร่วมกัน

- โทเค็น

- ราชสกุล

- เกินไป

- เครื่องมือ

- รวม

- รถไฟ

- การฝึกอบรม

- จริง

- ลอง

- tweet

- ชนิด

- ui

- ภายใต้

- มหาวิทยาลัย

- ยูนิกซ์

- ปลดล็อก

- จนกระทั่ง

- ใช้

- ใช้กรณี

- มือสอง

- ผู้ใช้งาน

- ใช้

- การใช้

- การใช้ประโยชน์

- หุบเขา

- ความคุ้มค่า

- ความคุ้มค่า

- ความหลากหลาย

- รุ่น

- วีดีโอ

- รายละเอียด

- วิสัยทัศน์

- เยี่ยมชมร้านค้า

- ภาพ

- เดิน

- คือ

- น้ำดื่ม

- we

- เว็บ

- บริการเว็บ

- web-based

- ดี

- อะไร

- ความหมายของ

- เมื่อ

- แต่ทว่า

- ที่

- ขาว

- WHO

- จะ

- กับ

- ภายใน

- ไม่มี

- คำ

- งาน

- จะ

- เขียน

- เขียน

- คุณ

- ของคุณ

- ลมทะเล

รจนาชาดา เป็น Principal Solution Architect AI/ML ในบัญชีเชิงกลยุทธ์ที่ AWS Rachna เป็นคนมองโลกในแง่ดีที่เชื่อว่าการใช้ AI อย่างมีจริยธรรมและมีความรับผิดชอบสามารถปรับปรุงสังคมในอนาคตและนำความเจริญทางเศรษฐกิจและสังคมมาให้ ในเวลาว่าง รัชนาชอบใช้เวลาอยู่กับครอบครัว เดินป่า และฟังเพลง

รจนาชาดา เป็น Principal Solution Architect AI/ML ในบัญชีเชิงกลยุทธ์ที่ AWS Rachna เป็นคนมองโลกในแง่ดีที่เชื่อว่าการใช้ AI อย่างมีจริยธรรมและมีความรับผิดชอบสามารถปรับปรุงสังคมในอนาคตและนำความเจริญทางเศรษฐกิจและสังคมมาให้ ในเวลาว่าง รัชนาชอบใช้เวลาอยู่กับครอบครัว เดินป่า และฟังเพลง ดร.ไคล์ อูลริช เป็นนักวิทยาศาสตร์ประยุกต์กับ

ดร.ไคล์ อูลริช เป็นนักวิทยาศาสตร์ประยุกต์กับ  คริสโตเฟอร์ วิตเทน เป็นผู้พัฒนาซอฟต์แวร์ในทีม JumpStart เขาช่วยปรับขนาดการเลือกโมเดลและบูรณาการโมเดลเข้ากับบริการ SageMaker อื่นๆ Chris มีความหลงใหลในการเร่งให้ AI แพร่หลายครอบคลุมขอบเขตธุรกิจที่หลากหลาย

คริสโตเฟอร์ วิตเทน เป็นผู้พัฒนาซอฟต์แวร์ในทีม JumpStart เขาช่วยปรับขนาดการเลือกโมเดลและบูรณาการโมเดลเข้ากับบริการ SageMaker อื่นๆ Chris มีความหลงใหลในการเร่งให้ AI แพร่หลายครอบคลุมขอบเขตธุรกิจที่หลากหลาย ดร.ฟาบิโอ โนนาโต เดอ เปาลา เป็นผู้จัดการอาวุโส ผู้เชี่ยวชาญ GenAI SA ที่ช่วยผู้ให้บริการโมเดลและลูกค้าปรับขนาด AI เชิงสร้างสรรค์ใน AWS Fabio มีความหลงใหลในการเข้าถึงเทคโนโลยี AI เชิงสร้างสรรค์ให้เป็นประชาธิปไตย นอกเหนือจากงาน คุณสามารถพบ Fabio ขี่มอเตอร์ไซค์ของเขาบนเนินเขาของ Sonoma Valley หรืออ่านหนังสือ ComiXology

ดร.ฟาบิโอ โนนาโต เดอ เปาลา เป็นผู้จัดการอาวุโส ผู้เชี่ยวชาญ GenAI SA ที่ช่วยผู้ให้บริการโมเดลและลูกค้าปรับขนาด AI เชิงสร้างสรรค์ใน AWS Fabio มีความหลงใหลในการเข้าถึงเทคโนโลยี AI เชิงสร้างสรรค์ให้เป็นประชาธิปไตย นอกเหนือจากงาน คุณสามารถพบ Fabio ขี่มอเตอร์ไซค์ของเขาบนเนินเขาของ Sonoma Valley หรืออ่านหนังสือ ComiXology ดร. Ashish Khetan เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสที่มีอัลกอริทึมในตัวของ Amazon SageMaker และช่วยพัฒนาอัลกอริทึมการเรียนรู้ของเครื่อง เขาได้รับปริญญาเอกจาก University of Illinois Urbana-Champaign เขาเป็นนักวิจัยที่กระตือรือร้นในด้านแมชชีนเลิร์นนิงและการอนุมานทางสถิติ และได้ตีพิมพ์บทความจำนวนมากในการประชุม NeurIPS, ICML, ICLR, JMLR, ACL และ EMNLP

ดร. Ashish Khetan เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสที่มีอัลกอริทึมในตัวของ Amazon SageMaker และช่วยพัฒนาอัลกอริทึมการเรียนรู้ของเครื่อง เขาได้รับปริญญาเอกจาก University of Illinois Urbana-Champaign เขาเป็นนักวิจัยที่กระตือรือร้นในด้านแมชชีนเลิร์นนิงและการอนุมานทางสถิติ และได้ตีพิมพ์บทความจำนวนมากในการประชุม NeurIPS, ICML, ICLR, JMLR, ACL และ EMNLP คาร์ล อัลเบิร์ตเซ่น เป็นผู้นำด้านผลิตภัณฑ์ วิศวกรรม และวิทยาศาสตร์สำหรับ Amazon SageMaker Algorithms และ JumpStart ซึ่งเป็นฮับแมชชีนเลิร์นนิงของ SageMaker เขาหลงใหลเกี่ยวกับการใช้แมชชีนเลิร์นนิงเพื่อปลดล็อกมูลค่าทางธุรกิจ

คาร์ล อัลเบิร์ตเซ่น เป็นผู้นำด้านผลิตภัณฑ์ วิศวกรรม และวิทยาศาสตร์สำหรับ Amazon SageMaker Algorithms และ JumpStart ซึ่งเป็นฮับแมชชีนเลิร์นนิงของ SageMaker เขาหลงใหลเกี่ยวกับการใช้แมชชีนเลิร์นนิงเพื่อปลดล็อกมูลค่าทางธุรกิจ