โพสต์นี้จะนำคุณผ่านความท้าทายทั่วไปที่ลูกค้าเผชิญเมื่อค้นหาเอกสารภายใน และให้คำแนะนำที่เป็นรูปธรรมเกี่ยวกับวิธีการใช้บริการของ AWS เพื่อสร้างบอทการสนทนา AI ที่สร้างซึ่งจะทำให้ข้อมูลภายในมีประโยชน์มากขึ้น

ข้อมูลที่ไม่มีโครงสร้างคิดเป็น 80% ของข้อมูลทั้งหมด พบได้ภายในองค์กรประกอบด้วยคลังคู่มือ PDF คำถามที่พบบ่อย อีเมล และเอกสารอื่นๆ ที่เพิ่มมากขึ้นทุกวัน ธุรกิจในปัจจุบันพึ่งพาพื้นที่เก็บข้อมูลภายในที่เติบโตอย่างต่อเนื่อง และปัญหาเกิดขึ้นเมื่อปริมาณข้อมูลที่ไม่มีโครงสร้างไม่สามารถจัดการได้ บ่อยครั้งที่ผู้ใช้พบว่าตนเองอ่านและตรวจสอบแหล่งข้อมูลภายในต่างๆ มากมายเพื่อค้นหาคำตอบที่ต้องการ

ฟอรัมคำถามและคำตอบภายในสามารถช่วยให้ผู้ใช้ได้รับคำตอบที่เฉพาะเจาะจงมาก แต่ยังต้องใช้เวลารอนานกว่าอีกด้วย ในกรณีของคำถามที่พบบ่อยภายในบริษัท การรอนานส่งผลให้ประสิทธิภาพการทำงานของพนักงานลดลง ฟอรัมคำถามและคำตอบนั้นขยายขนาดได้ยากเนื่องจากต้องใช้คำตอบที่เขียนด้วยตนเอง ด้วย generative AI ปัจจุบันมีการเปลี่ยนแปลงกระบวนทัศน์ในวิธีที่ผู้ใช้ค้นหาและค้นหาข้อมูล ขั้นตอนต่อไปคือการใช้ AI เจนเนอเรชั่นเพื่อย่อเอกสารขนาดใหญ่ให้เป็นข้อมูลที่มีขนาดเล็กลงเพื่อให้ผู้ใช้ใช้งานได้ง่ายขึ้น แทนที่จะใช้เวลานานในการอ่านข้อความหรือรอคำตอบ ผู้ใช้สามารถสร้างข้อมูลสรุปแบบเรียลไทม์โดยอิงจากที่เก็บข้อมูลภายในที่มีอยู่หลายแห่ง

ภาพรวมโซลูชัน

โซลูชันดังกล่าวช่วยให้ลูกค้าสามารถดึงข้อมูลคำตอบที่รวบรวมไว้สำหรับคำถามที่ถามเกี่ยวกับเอกสารภายในได้ โดยใช้โมเดลหม้อแปลงไฟฟ้าเพื่อสร้างคำตอบสำหรับคำถามเกี่ยวกับข้อมูลที่ไม่ได้รับการฝึกอบรม ซึ่งเป็นเทคนิคที่เรียกว่า Zero-shot prompting การนำโซลูชันนี้มาใช้ ลูกค้าจะได้รับประโยชน์ดังต่อไปนี้:

- ค้นหาคำตอบที่ถูกต้องสำหรับคำถามตามแหล่งที่มาของเอกสารภายในที่มีอยู่

- ลดเวลาที่ผู้ใช้ใช้ในการค้นหาคำตอบโดยใช้ Large Language Models (LLM) เพื่อให้คำตอบที่เกือบจะทันทีสำหรับคำถามที่ซับซ้อนโดยใช้เอกสารที่มีข้อมูลที่อัปเดตล่าสุด

- ค้นหาคำตอบก่อนหน้านี้ผ่านแดชบอร์ดส่วนกลาง

- ลดความเครียดที่เกิดจากการใช้เวลาอ่านข้อมูลด้วยตนเองเพื่อค้นหาคำตอบ

การดึงข้อมูล Augmented Generation (RAG)

การดึงข้อมูล Augmented Generation (RAG) ช่วยลดข้อบกพร่องบางประการของการสืบค้นที่ใช้ LLM โดยการค้นหาคำตอบจากฐานความรู้ของคุณ และใช้ LLM เพื่อสรุปเอกสารให้เป็นคำตอบที่กระชับ โปรดอ่านข้อความนี้ เสา เพื่อเรียนรู้วิธีการนำแนวทาง RAG ไปใช้ด้วย อเมซอน เคนดรา. ความเสี่ยงและข้อจำกัดต่อไปนี้เกี่ยวข้องกับการสืบค้นแบบ LLM ซึ่งแนวทาง RAG กับที่อยู่ Amazon Kendra:

- ภาพหลอนและการตรวจสอบย้อนกลับ – LLMS ได้รับการฝึกอบรมเกี่ยวกับชุดข้อมูลขนาดใหญ่และสร้างการตอบสนองต่อความน่าจะเป็น สิ่งนี้สามารถนำไปสู่คำตอบที่ไม่ถูกต้องซึ่งเรียกว่าภาพหลอน

- ไซโลข้อมูลที่หลากหลาย – ในการที่จะอ้างอิงข้อมูลจากหลายแหล่งภายในการตอบสนองของคุณ เราจำเป็นต้องตั้งค่าระบบนิเวศของตัวเชื่อมต่อเพื่อรวบรวมข้อมูล การเข้าถึงที่เก็บข้อมูลหลายแห่งต้องทำด้วยตนเองและใช้เวลานาน

- ความปลอดภัย – ความปลอดภัยและความเป็นส่วนตัวถือเป็นข้อพิจารณาที่สำคัญเมื่อปรับใช้บอทสนทนาที่ขับเคลื่อนโดย RAG และ LLM ทั้งๆที่ใช้. เข้าใจ Amazon เพื่อกรองข้อมูลส่วนบุคคลที่อาจได้รับจากการสอบถามของผู้ใช้ ยังคงมีความเป็นไปได้ที่จะเปิดเผยข้อมูลส่วนบุคคลหรือข้อมูลที่ละเอียดอ่อนโดยไม่ได้ตั้งใจ ทั้งนี้ขึ้นอยู่กับข้อมูลที่นำเข้า ซึ่งหมายความว่าการควบคุมการเข้าถึงแชทบอทเป็นสิ่งสำคัญในการป้องกันการเข้าถึงข้อมูลที่ละเอียดอ่อนโดยไม่ได้ตั้งใจ

- ความเกี่ยวข้องของข้อมูล – LLMS ได้รับการฝึกอบรมเกี่ยวกับข้อมูลจนถึงวันที่กำหนด ซึ่งหมายความว่าข้อมูลมักจะไม่เป็นปัจจุบัน ค่าใช้จ่ายที่เกี่ยวข้องกับโมเดลการฝึกอบรมเกี่ยวกับข้อมูลล่าสุดนั้นสูง เพื่อให้มั่นใจถึงการตอบสนองที่ถูกต้องและทันสมัย องค์กรต่างๆ จึงมีหน้าที่รับผิดชอบในการอัปเดตและเพิ่มคุณค่าเนื้อหาของเอกสารที่จัดทำดัชนีเป็นประจำ

- ต้นทุน – ต้นทุนที่เกี่ยวข้องกับการปรับใช้โซลูชันนี้ควรเป็นข้อพิจารณาสำหรับธุรกิจ ธุรกิจจำเป็นต้องประเมินงบประมาณและข้อกำหนดด้านประสิทธิภาพอย่างรอบคอบเมื่อนำโซลูชันนี้ไปใช้ การดำเนิน LLM อาจต้องใช้ทรัพยากรการคำนวณจำนวนมาก ซึ่งอาจเพิ่มต้นทุนการดำเนินงานได้ ต้นทุนเหล่านี้อาจกลายเป็นข้อจำกัดสำหรับแอปพลิเคชันที่ต้องดำเนินการในวงกว้าง อย่างไรก็ตามข้อดีประการหนึ่งของ AWS Cloud คือความยืดหยุ่นในการจ่ายเฉพาะสิ่งที่คุณใช้เท่านั้น AWS นำเสนอโมเดลราคาที่เรียบง่าย สม่ำเสมอ และจ่ายตามการใช้งาน ดังนั้นคุณจะถูกเรียกเก็บเงินเฉพาะทรัพยากรที่คุณใช้เท่านั้น

การใช้งาน Amazon SageMaker JumpStart

สำหรับโมเดลภาษาที่ใช้ Transformer องค์กรจะได้รับประโยชน์จากการใช้งาน อเมซอน SageMaker JumpStart ซึ่งมีคอลเลกชันโมเดลการเรียนรู้ของเครื่องที่สร้างไว้ล่วงหน้า Amazon SageMaker JumpStart นำเสนอโมเดลพื้นฐานการสร้างข้อความและการตอบคำถาม (ถามตอบ) ที่หลากหลาย ซึ่งสามารถติดตั้งและใช้งานได้อย่างง่ายดาย โซลูชันนี้รวมโมเดล FLAN T5-XL Amazon SageMaker JumpStart เข้าด้วยกัน แต่มีแง่มุมต่างๆ ที่ต้องคำนึงถึงเมื่อ การเลือกแบบจำลองรากฐาน.

บูรณาการความปลอดภัยในขั้นตอนการทำงานของเรา

ปฏิบัติตามแนวทางปฏิบัติที่ดีที่สุดของเสาหลักความมั่นคงของ กรอบงานที่มีสถาปัตยกรรมอย่างดี, Amazon Cognito Co ใช้สำหรับการรับรองความถูกต้อง พูลผู้ใช้ Amazon Cognito สามารถผสานรวมกับผู้ให้บริการข้อมูลประจำตัวบุคคลที่สามที่รองรับเฟรมเวิร์กต่างๆ ที่ใช้สำหรับการควบคุมการเข้าถึง รวมถึง Open Authorization (OAuth), OpenID Connect (OIDC) หรือ Security Assertion Markup Language (SAML) การระบุผู้ใช้และการดำเนินการช่วยให้โซลูชันสามารถรักษาความสามารถในการตรวจสอบย้อนกลับได้ โซลูชันนี้ยังใช้ การตรวจจับข้อมูลส่วนบุคคลที่สามารถระบุตัวตนได้ (PII) ของ Amazon Comprehend คุณลักษณะเพื่อระบุตัวตนและตรวจทาน PII โดยอัตโนมัติ PII ที่ปกปิดประกอบด้วยที่อยู่ หมายเลขประกันสังคม ที่อยู่อีเมล และข้อมูลที่ละเอียดอ่อนอื่นๆ การออกแบบนี้ช่วยให้แน่ใจว่า PII ใดๆ ที่ผู้ใช้ให้มาผ่านการสืบค้นอินพุตจะถูกแก้ไข PII จะไม่ถูกจัดเก็บ ใช้โดย Amazon Kendra หรือป้อนไปยัง LLM

แนวทางการแก้ปัญหา

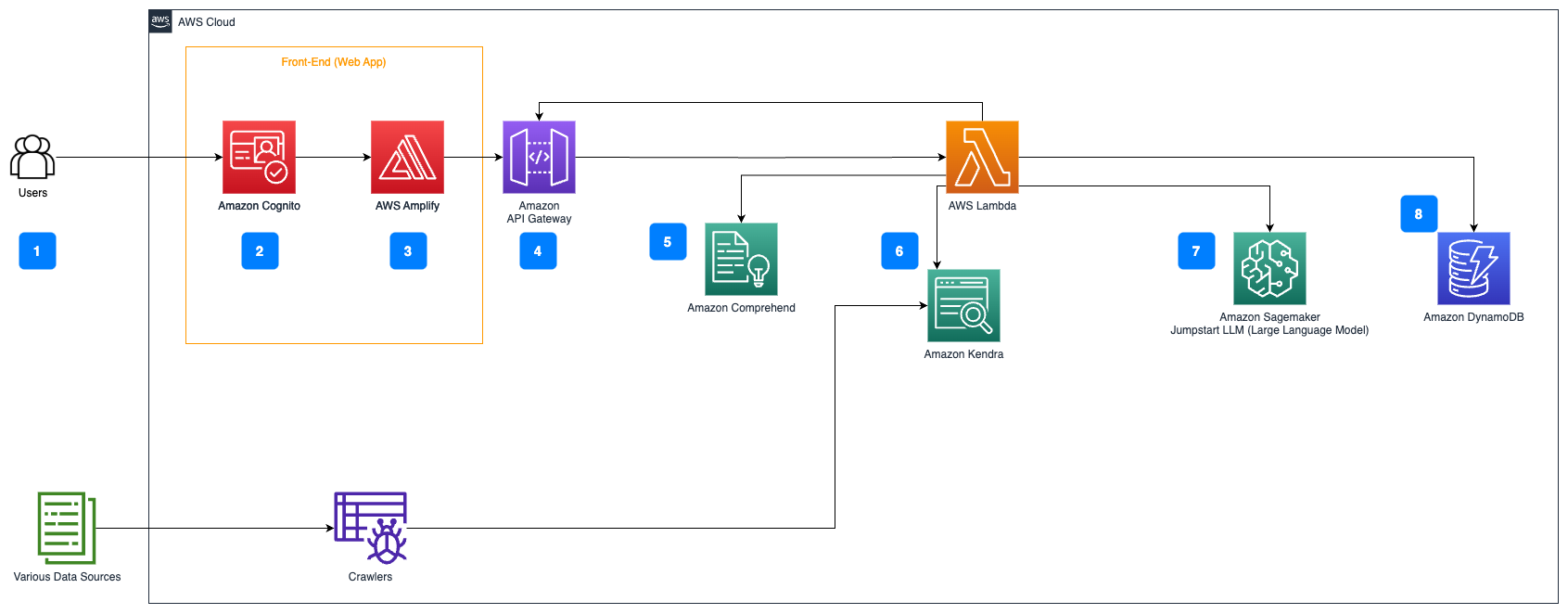

ขั้นตอนต่อไปนี้จะอธิบายเวิร์กโฟลว์ของการตอบคำถามผ่านโฟลว์เอกสาร:

- ผู้ใช้ส่งแบบสอบถามผ่านเว็บอินเตอร์เฟส

- Amazon Cognito Co ใช้สำหรับการรับรองความถูกต้องทำให้มั่นใจในการเข้าถึงเว็บแอปพลิเคชันอย่างปลอดภัย

- ส่วนหน้าของแอปพลิเคชันบนเว็บโฮสต์อยู่บน AWS ขยาย.

- Amazon API Gateway Amazon โฮสต์ REST API ด้วยตำแหน่งข้อมูลต่างๆ เพื่อจัดการคำขอของผู้ใช้ที่ได้รับการตรวจสอบสิทธิ์โดยใช้ Amazon Cognito

- การแก้ไข PII ด้วย เข้าใจ Amazon:

- การประมวลผลคำค้นหาของผู้ใช้: เมื่อผู้ใช้ส่งคำค้นหาหรืออินพุต คำค้นหานั้นจะถูกส่งผ่าน Amazon Comprehend ก่อน บริการวิเคราะห์ข้อความและระบุเอนทิตี PII ใดๆ ที่มีอยู่ในแบบสอบถาม

- การดึงข้อมูล PII: Amazon Comprehend จะแยกเอนทิตี PII ที่ตรวจพบออกจากคำค้นหาของผู้ใช้

- การสืบค้นข้อมูลที่เกี่ยวข้องด้วย อเมซอน เคนดรา:

- Amazon Kendra ใช้เพื่อจัดการดัชนีเอกสารที่มีข้อมูลที่ใช้ในการสร้างคำตอบสำหรับคำถามของผู้ใช้

- พื้นที่ การดึงข้อมูล LangChain QA โมดูลใช้เพื่อสร้างห่วงโซ่การสนทนาที่มีข้อมูลที่เกี่ยวข้องกับคำถามของผู้ใช้

- บูรณาการกับ Amazon SageMaker JumpStart:

- ฟังก์ชัน AWS Lambda ใช้ไลบรารี LangChain และเชื่อมต่อกับตำแหน่งข้อมูล Amazon SageMaker JumpStart ด้วยการสืบค้นแบบยัดบริบท ตำแหน่งข้อมูล Amazon SageMaker JumpStart ทำหน้าที่เป็นอินเทอร์เฟซของ LLM ที่ใช้สำหรับการอนุมาน

- การจัดเก็บคำตอบและส่งคืนให้กับผู้ใช้:

- การตอบสนองจาก LLM จะถูกเก็บไว้ใน อเมซอน ไดนาโมดีบี พร้อมด้วยข้อความค้นหาของผู้ใช้ การประทับเวลา ตัวระบุที่ไม่ซ้ำกัน และตัวระบุที่กำหนดเองอื่นๆ สำหรับรายการ เช่น หมวดหมู่คำถาม การจัดเก็บคำถามและคำตอบเป็นรายการแยกกันทำให้ฟังก์ชัน AWS Lambda สามารถสร้างประวัติการสนทนาของผู้ใช้ขึ้นใหม่ตามเวลาที่ถามคำถามได้อย่างง่ายดาย

- สุดท้าย การตอบสนองจะถูกส่งกลับไปยังผู้ใช้ผ่านคำขอ HTTP ผ่านการตอบกลับการรวม Amazon API Gateway REST API

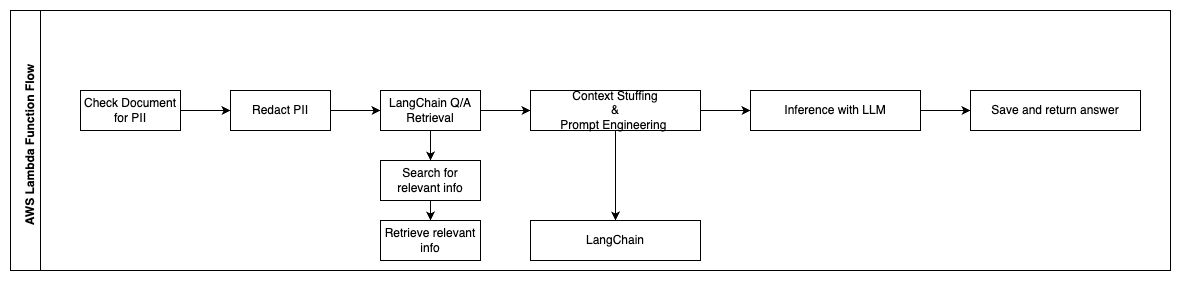

ขั้นตอนต่อไปนี้จะอธิบายฟังก์ชัน AWS Lambda และโฟลว์ของฟังก์ชันตลอดกระบวนการ:

- ตรวจสอบและแก้ไขข้อมูล PII / ข้อมูลที่ละเอียดอ่อน

- ห่วงโซ่การดึงข้อมูล QA ของ LangChain

- ค้นหาและดึงข้อมูลที่เกี่ยวข้อง

- การบรรจุบริบทและวิศวกรรมพร้อมท์

- การอนุมานกับ LLM

- ตอบกลับและบันทึก

ใช้กรณี

มีกรณีการใช้งานทางธุรกิจมากมายที่ลูกค้าสามารถใช้เวิร์กโฟลว์นี้ได้ ส่วนต่อไปนี้จะอธิบายวิธีการใช้เวิร์กโฟลว์ในอุตสาหกรรมและแนวดิ่งต่างๆ

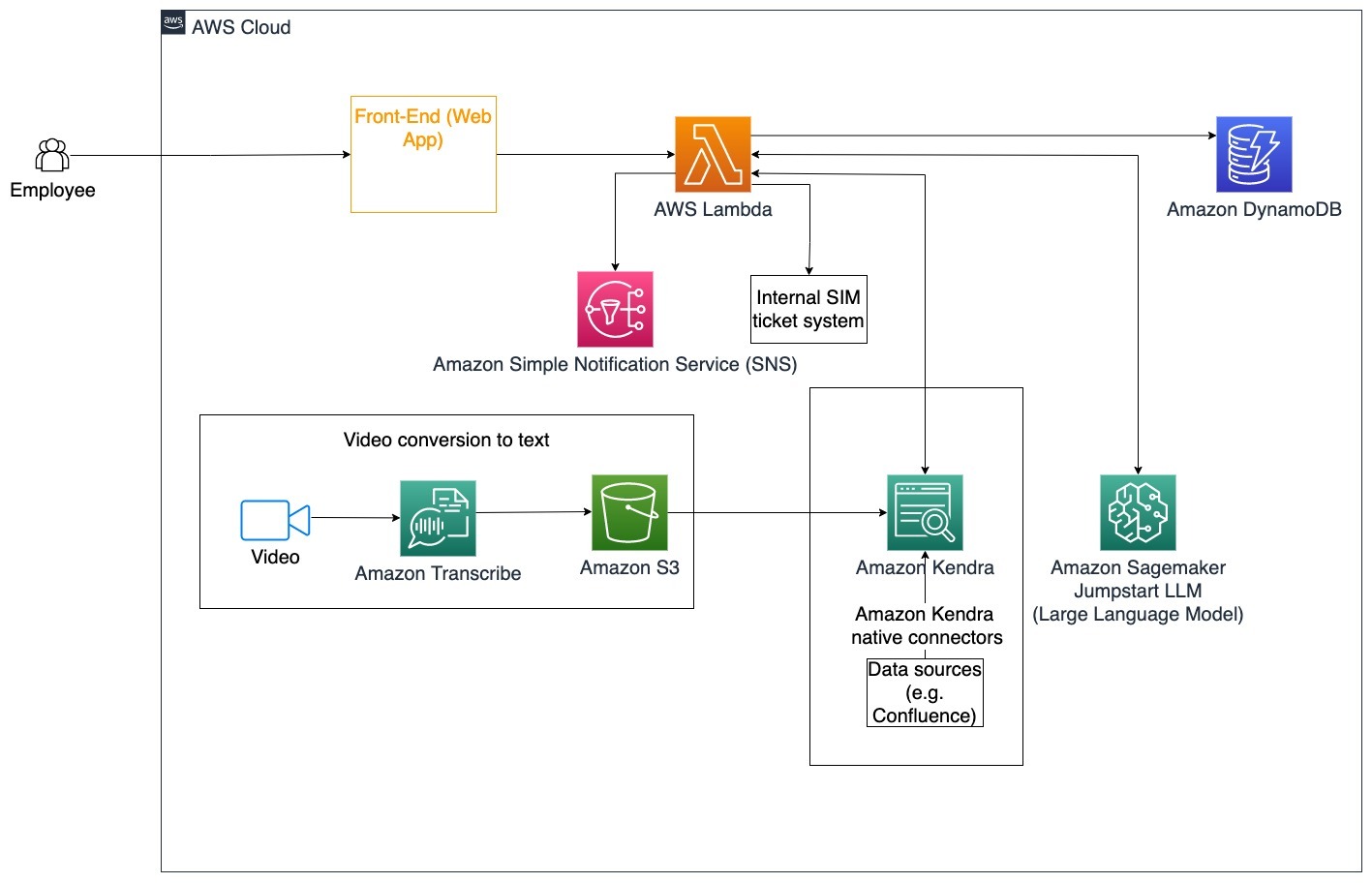

การช่วยเหลือพนักงาน

การฝึกอบรมระดับองค์กรที่ออกแบบมาอย่างดีสามารถปรับปรุงความพึงพอใจของพนักงานและลดเวลาที่ต้องใช้ในการเริ่มต้นพนักงานใหม่ เมื่อองค์กรเติบโตและความซับซ้อนเพิ่มขึ้น พนักงานพบว่าเป็นเรื่องยากที่จะเข้าใจแหล่งที่มาของเอกสารภายในจำนวนมาก เอกสารภายในในบริบทนี้ประกอบด้วยแนวปฏิบัติของบริษัท นโยบาย และขั้นตอนการปฏิบัติงานมาตรฐาน สำหรับสถานการณ์นี้ พนักงานมีคำถามเกี่ยวกับวิธีการดำเนินการและแก้ไขตั๋วการออกตั๋วภายใน พนักงานสามารถเข้าถึงและใช้บอทสนทนาอัจฉริยะประดิษฐ์ (AI) เพื่อถามและดำเนินการขั้นตอนถัดไปสำหรับตั๋วเฉพาะ

กรณีการใช้งานเฉพาะ: แก้ไขปัญหาโดยอัตโนมัติสำหรับพนักงานตามหลักเกณฑ์ขององค์กร

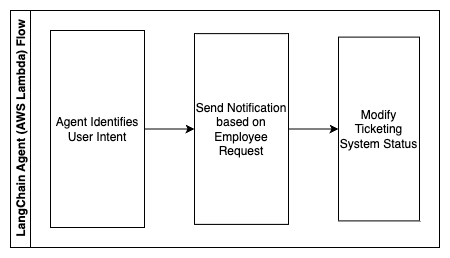

ขั้นตอนต่อไปนี้จะอธิบายฟังก์ชัน AWS Lambda และโฟลว์ของฟังก์ชันตลอดกระบวนการ:

- ตัวแทน LangChain เพื่อระบุเจตนา

- ส่งการแจ้งเตือนตามคำขอของพนักงาน

- แก้ไขสถานะตั๋ว

ในแผนภาพสถาปัตยกรรมนี้ คุณสามารถนำเข้าวิดีโอการฝึกอบรมขององค์กรได้ ถอดความจากอเมซอน เพื่อรวบรวมบันทึกสคริปต์วิดีโอเหล่านี้ นอกจากนี้ เนื้อหาการฝึกอบรมขององค์กรที่จัดเก็บไว้ในแหล่งต่างๆ (เช่น Confluence, Microsoft SharePoint, Google Drive, Jira ฯลฯ) สามารถใช้เพื่อสร้างดัชนีผ่านตัวเชื่อมต่อ Amazon Kendra อ่านบทความนี้เพื่อเรียนรู้เพิ่มเติมเกี่ยวกับคอลเล็กชันภาษาพื้นเมือง การเชื่อมต่อ คุณสามารถใช้ใน Amazon Kendra เป็นจุดต้นทางได้ จากนั้นโปรแกรมรวบรวมข้อมูลของ Amazon Kendra จะสามารถใช้ทั้งสคริปต์วิดีโอการฝึกอบรมขององค์กรและเอกสารที่จัดเก็บไว้ในแหล่งข้อมูลอื่นๆ เหล่านี้ เพื่อช่วยบอทสนทนาในการตอบคำถามเฉพาะเกี่ยวกับแนวทางการฝึกอบรมขององค์กรของบริษัท เอเจนต์ LangChain ตรวจสอบสิทธิ์ แก้ไขสถานะตั๋ว และแจ้งบุคคลที่ถูกต้องโดยใช้ Amazon Simple Notification Service (อเมซอน SNS).

ทีมสนับสนุนลูกค้า

การแก้ไขข้อซักถามของลูกค้าอย่างรวดเร็วช่วยปรับปรุงประสบการณ์ของลูกค้าและส่งเสริมความภักดีต่อแบรนด์ ฐานลูกค้าประจำช่วยกระตุ้นยอดขาย ซึ่งส่งผลต่อผลกำไรและเพิ่มการมีส่วนร่วมของลูกค้า ทีมสนับสนุนลูกค้าใช้พลังงานจำนวนมากในการอ้างอิงเอกสารภายในจำนวนมากและซอฟต์แวร์การจัดการลูกค้าสัมพันธ์เพื่อตอบคำถามของลูกค้าเกี่ยวกับผลิตภัณฑ์และบริการ เอกสารภายในในบริบทนี้อาจรวมถึงสคริปต์การโทรสนับสนุนลูกค้าทั่วไป คู่มือกลยุทธ์ แนวทางการยกระดับ และข้อมูลทางธุรกิจ บอทสนทนา AI เจนเนอเรชั่นช่วยในการเพิ่มประสิทธิภาพต้นทุน เนื่องจากจะจัดการคำถามในนามของทีมสนับสนุนลูกค้า

กรณีการใช้งานเฉพาะ: การจัดการคำขอเปลี่ยนถ่ายน้ำมันเครื่องตามประวัติการบริการและแผนการบริการลูกค้าที่ซื้อ

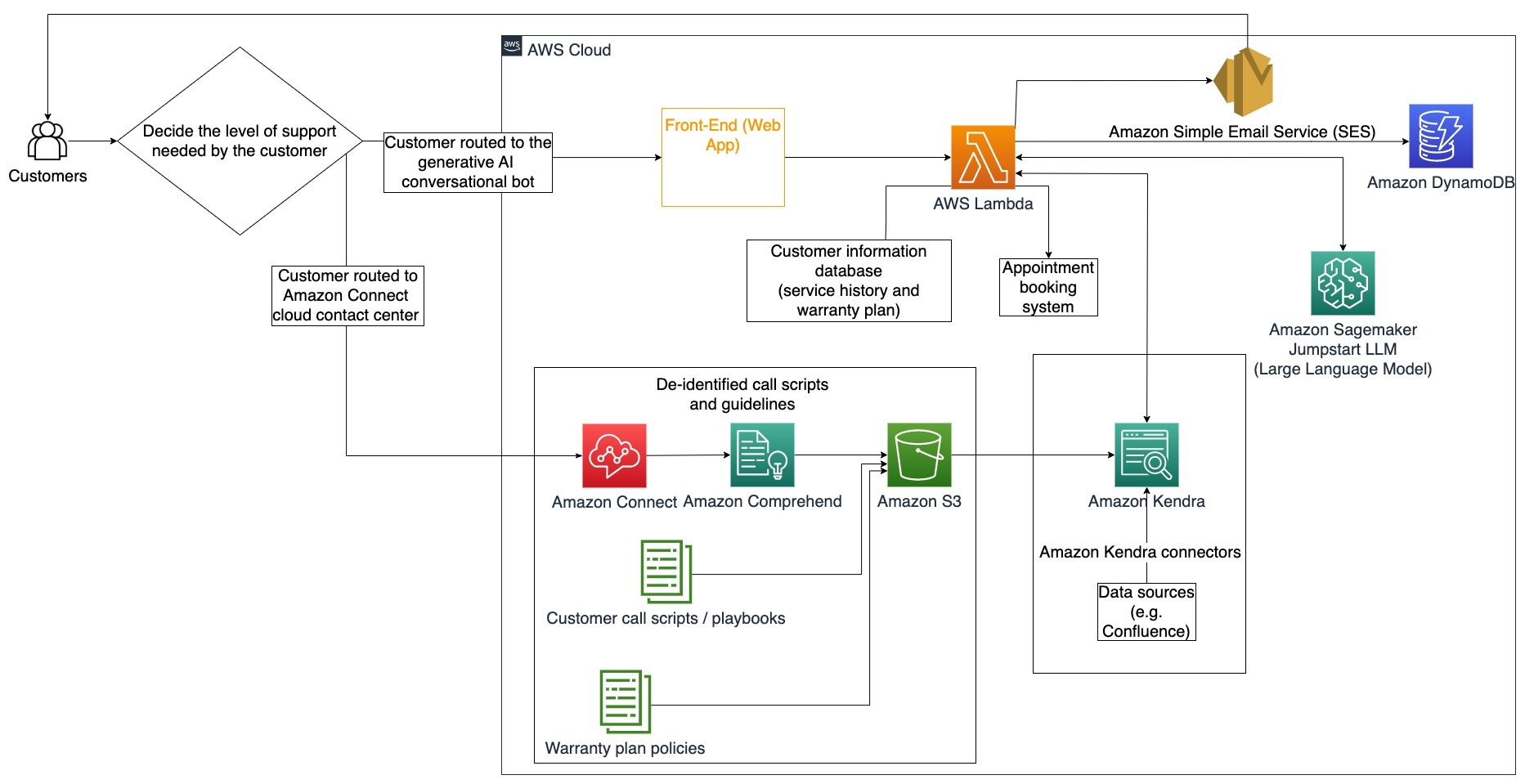

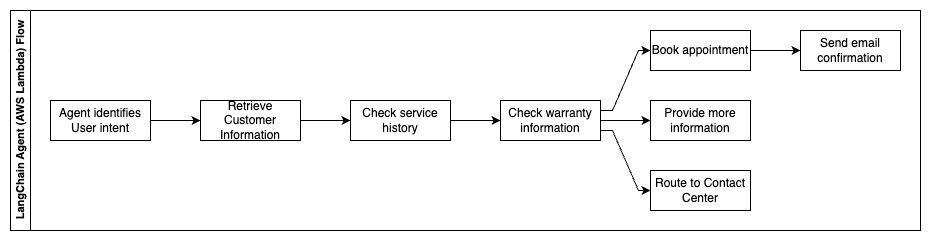

ในแผนภาพสถาปัตยกรรมนี้ ลูกค้าจะถูกส่งไปยังบอทสนทนา AI แบบสร้างหรือ อเมซอน คอนเนค ศูนย์ติดต่อ การตัดสินใจนี้อาจขึ้นอยู่กับระดับการสนับสนุนที่ต้องการหรือความพร้อมของตัวแทนฝ่ายสนับสนุนลูกค้า ตัวแทน LangChain ระบุความตั้งใจของลูกค้าและยืนยันตัวตน ตัวแทน LangChain ยังตรวจสอบประวัติการบริการและซื้อแผนการสนับสนุนอีกด้วย

ขั้นตอนต่อไปนี้จะอธิบายฟังก์ชัน AWS Lambda และโฟลว์ของฟังก์ชันตลอดกระบวนการ:

- ตัวแทน LangChain ระบุเจตนา

- ดึงข้อมูลลูกค้า

- ตรวจสอบประวัติการบริการลูกค้าและข้อมูลการรับประกัน

- จองนัดหมาย ให้ข้อมูลเพิ่มเติม หรือสอบถามเส้นทางไปยังศูนย์ติดต่อ

- ส่งอีเมลยืนยัน

Amazon Connect ใช้เพื่อรวบรวมบันทึกเสียงและการแชท และ Amazon Comprehend ใช้เพื่อลบข้อมูลส่วนบุคคล (PII) ออกจากบันทึกเหล่านี้ จากนั้นโปรแกรมรวบรวมข้อมูลของ Amazon Kendra จะสามารถใช้บันทึกเสียงสนทนาและการแชทที่แก้ไข สคริปต์การโทรของลูกค้า และนโยบายแผนสนับสนุนการบริการลูกค้าเพื่อสร้างดัชนี เมื่อตัดสินใจได้แล้ว บอทสนทนา AI ทั่วไปจะตัดสินใจว่าจะจองการนัดหมาย ให้ข้อมูลเพิ่มเติม หรือกำหนดเส้นทางลูกค้าไปยังศูนย์ติดต่อเพื่อขอความช่วยเหลือเพิ่มเติม สำหรับการเพิ่มประสิทธิภาพต้นทุน ตัวแทน LangChain ยังสามารถสร้างคำตอบโดยใช้โทเค็นน้อยลงและโมเดลภาษาขนาดใหญ่ที่มีราคาถูกกว่าสำหรับการสืบค้นของลูกค้าที่มีลำดับความสำคัญต่ำกว่า

บริการทางการเงิน

บริษัทผู้ให้บริการทางการเงินพึ่งพาการใช้ข้อมูลอย่างทันท่วงทีเพื่อรักษาความสามารถในการแข่งขันและปฏิบัติตามกฎระเบียบทางการเงิน การใช้บอทการสนทนาแบบ generative AI นักวิเคราะห์ทางการเงินและที่ปรึกษาสามารถโต้ตอบกับข้อมูลที่เป็นข้อความในลักษณะการสนทนา และลดเวลาและความพยายามในการตัดสินใจโดยมีข้อมูลดีขึ้น นอกเหนือจากการลงทุนและการวิจัยตลาด บอทสนทนาแบบ AI ทั่วไปยังสามารถเพิ่มขีดความสามารถของมนุษย์ด้วยการจัดการงานที่แต่เดิมต้องใช้ความพยายามและเวลาของมนุษย์มากขึ้น ตัวอย่างเช่น สถาบันการเงินที่เชี่ยวชาญด้านสินเชื่อส่วนบุคคลสามารถเพิ่มอัตราการประมวลผลสินเชื่อในขณะที่ให้ความโปร่งใสแก่ลูกค้าได้ดีขึ้น

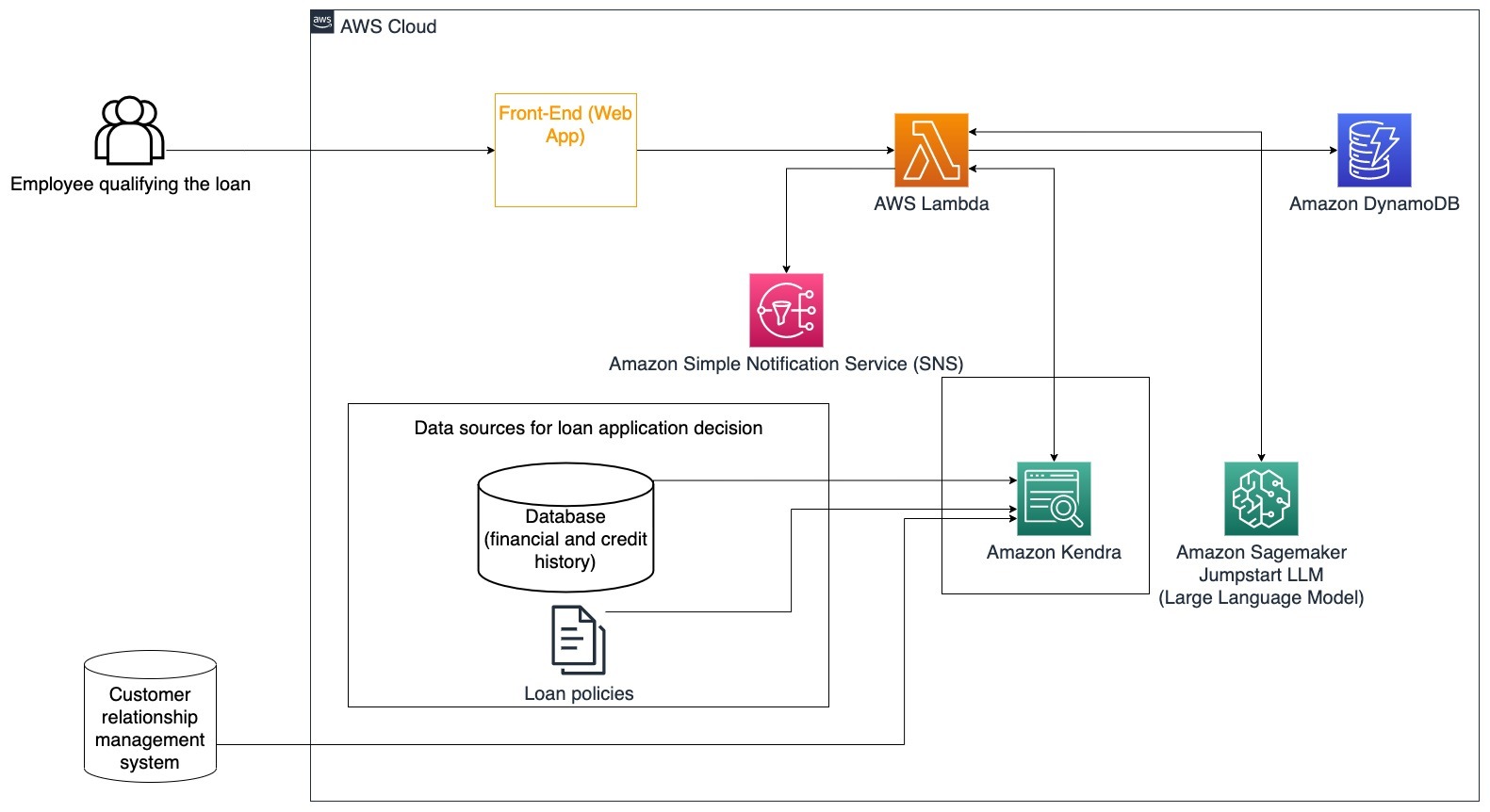

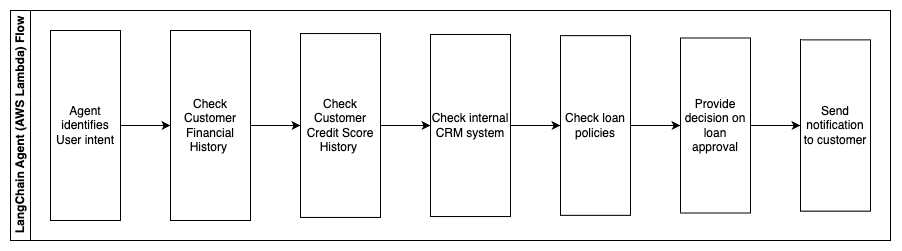

กรณีการใช้งานเฉพาะ: ใช้ประวัติทางการเงินของลูกค้าและการสมัครสินเชื่อก่อนหน้าเพื่อตัดสินใจและอธิบายการตัดสินใจสินเชื่อ

ขั้นตอนต่อไปนี้จะอธิบายฟังก์ชัน AWS Lambda และโฟลว์ของฟังก์ชันตลอดกระบวนการ:

- ตัวแทน LangChain เพื่อระบุเจตนา

- ตรวจสอบประวัติทางการเงินและคะแนนเครดิตของลูกค้า

- ตรวจสอบระบบการจัดการลูกค้าสัมพันธ์ภายใน

- ตรวจสอบนโยบายสินเชื่อมาตรฐานและเสนอแนะการตัดสินใจสำหรับพนักงานที่มีคุณสมบัติเหมาะสมในการกู้ยืม

- ส่งการแจ้งเตือนไปยังลูกค้า

สถาปัตยกรรมนี้รวมข้อมูลทางการเงินของลูกค้าที่จัดเก็บไว้ในฐานข้อมูลและข้อมูลที่จัดเก็บไว้ในเครื่องมือการจัดการลูกค้าสัมพันธ์ (CRM) จุดข้อมูลเหล่านี้ใช้เพื่อประกอบการตัดสินใจตามนโยบายสินเชื่อภายในของบริษัท ลูกค้าสามารถถามคำถามที่ชัดเจนเพื่อทำความเข้าใจว่าพวกเขามีสิทธิ์ได้รับสินเชื่อประเภทใดและเงื่อนไขของสินเชื่อที่พวกเขาสามารถรับได้ หากบอทการสนทนาแบบ generative AI ไม่สามารถอนุมัติการสมัครสินเชื่อได้ ผู้ใช้ยังสามารถถามคำถามเกี่ยวกับการปรับปรุงคะแนนเครดิตหรือตัวเลือกทางการเงินอื่น ๆ ได้

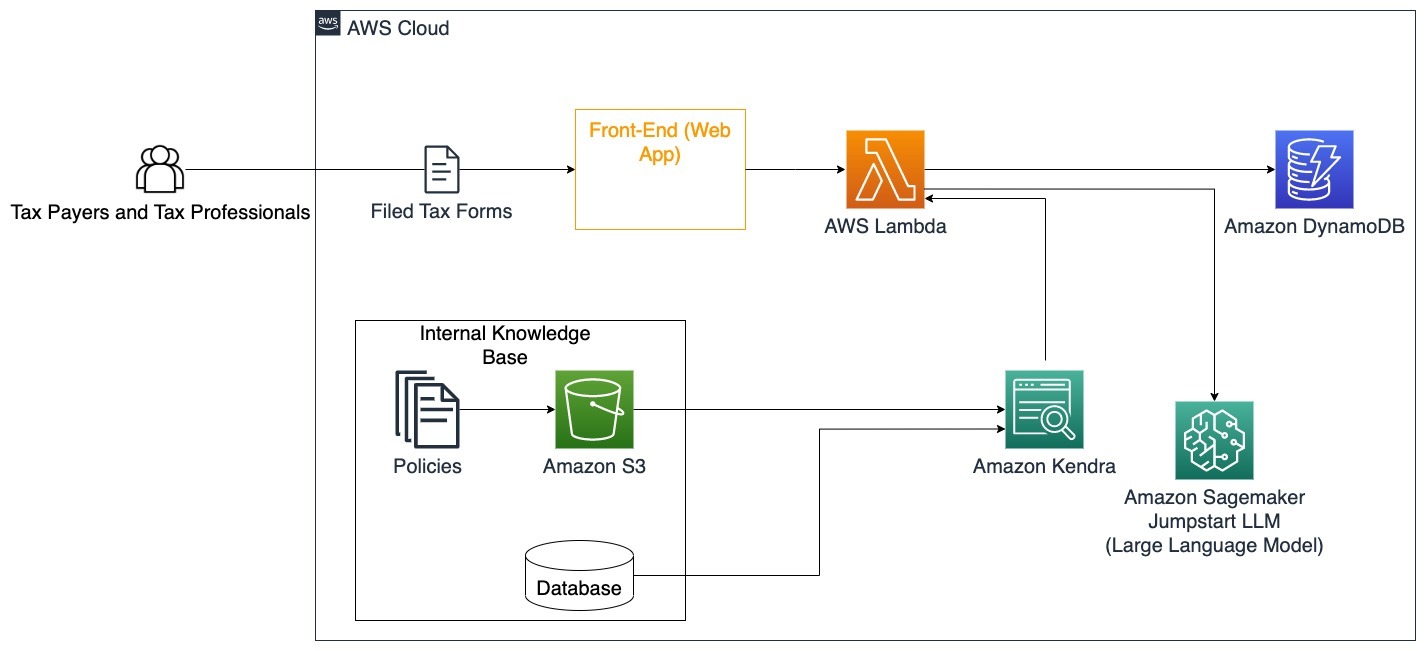

รัฐบาล

บอทสนทนา Generative AI สามารถให้ประโยชน์อย่างมากต่อสถาบันภาครัฐ โดยการเร่งกระบวนการสื่อสาร ประสิทธิภาพ และการตัดสินใจ บอทสนทนา Generative AI ยังให้การเข้าถึงฐานความรู้ภายในได้ทันที เพื่อช่วยให้พนักงานของรัฐดึงข้อมูล นโยบาย และขั้นตอนต่างๆ ได้อย่างรวดเร็ว (เช่น เกณฑ์คุณสมบัติ กระบวนการสมัคร และบริการและการสนับสนุนของพลเมือง) โซลูชันหนึ่งคือระบบโต้ตอบ ซึ่งช่วยให้ผู้เสียภาษีและผู้เชี่ยวชาญด้านภาษีสามารถค้นหารายละเอียดและสิทธิประโยชน์ที่เกี่ยวข้องกับภาษีได้อย่างง่ายดาย สามารถใช้เพื่อทำความเข้าใจคำถามของผู้ใช้ สรุปเอกสารภาษี และให้คำตอบที่ชัดเจนผ่านการสนทนาเชิงโต้ตอบ

ผู้ใช้สามารถถามคำถามเช่น:

- ภาษีมรดกทำงานอย่างไร และเกณฑ์ภาษีมีอะไรบ้าง?

- ช่วยอธิบายแนวคิดเรื่องภาษีเงินได้หน่อยได้ไหม?

- ผลกระทบทางภาษีเมื่อขายอสังหาริมทรัพย์แห่งที่สองมีอะไรบ้าง?

นอกจากนี้ผู้ใช้สามารถส่งแบบฟอร์มภาษีเข้าระบบได้สะดวกซึ่งสามารถช่วยตรวจสอบความถูกต้องของข้อมูลที่ให้ไว้ได้

สถาปัตยกรรมนี้แสดงให้เห็นว่าผู้ใช้สามารถอัปโหลดแบบฟอร์มภาษีที่กรอกเรียบร้อยแล้วไปยังโซลูชันได้อย่างไร และใช้สำหรับการตรวจสอบเชิงโต้ตอบและคำแนะนำเกี่ยวกับวิธีการกรอกข้อมูลที่จำเป็นอย่างถูกต้อง

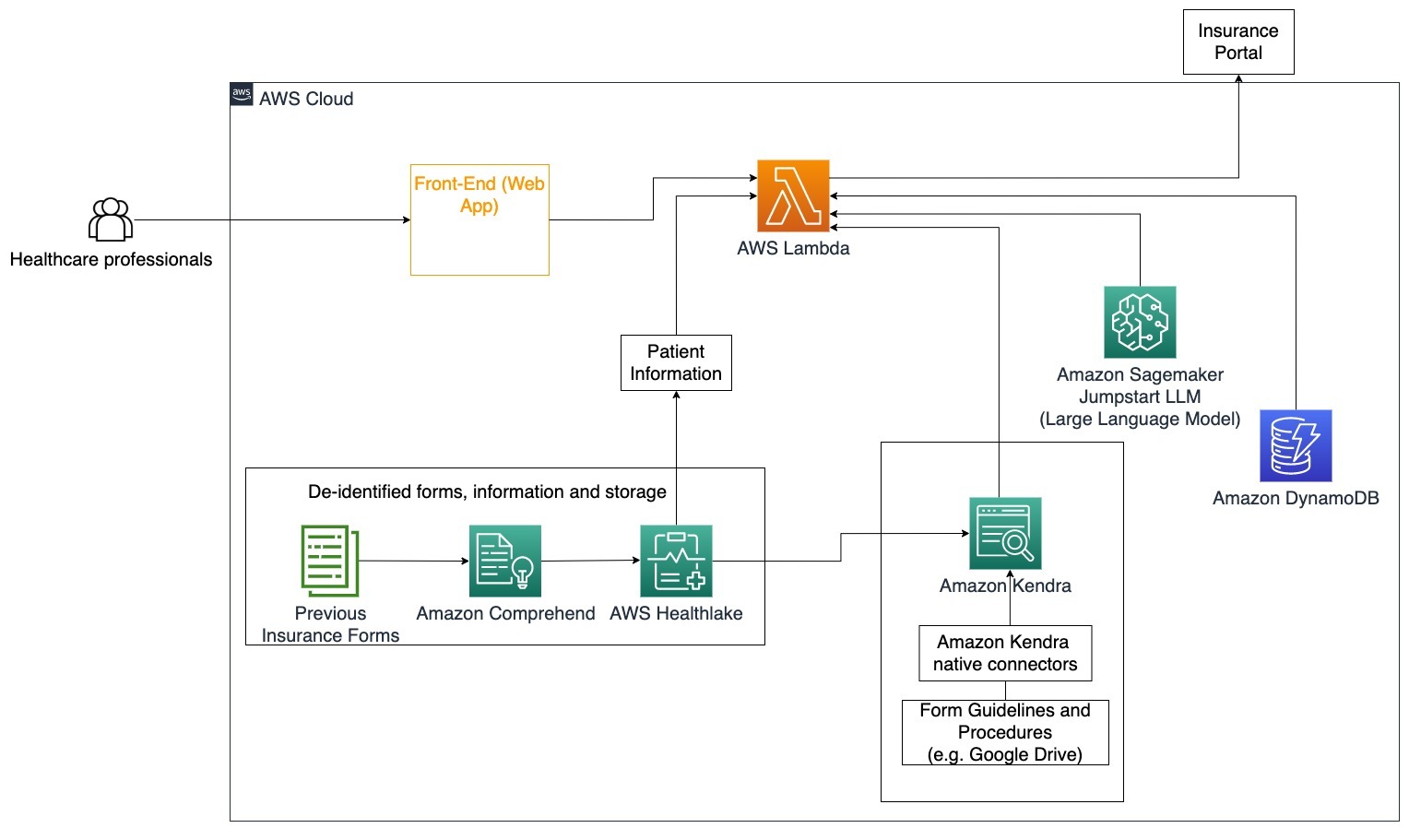

การดูแลสุขภาพ

ธุรกิจด้านการดูแลสุขภาพมีโอกาสที่จะทำให้การใช้ข้อมูลภายในของผู้ป่วยจำนวนมากเป็นไปโดยอัตโนมัติ ขณะเดียวกันก็ตอบคำถามทั่วไปเกี่ยวกับกรณีการใช้งาน เช่น ตัวเลือกการรักษา การเคลมประกัน การทดลองทางคลินิก และการวิจัยทางเภสัชกรรม การใช้บอทสนทนา AI เจนเนอเรชั่นช่วยให้สร้างคำตอบเกี่ยวกับข้อมูลด้านสุขภาพได้อย่างรวดเร็วและแม่นยำจากฐานความรู้ที่ให้มา ตัวอย่างเช่น ผู้เชี่ยวชาญด้านสุขภาพบางคนใช้เวลาส่วนใหญ่ในการกรอกแบบฟอร์มเพื่อยื่นเคลมประกัน

ในสภาวะที่คล้ายกัน ผู้บริหารการทดลองทางคลินิกและนักวิจัยจำเป็นต้องค้นหาข้อมูลเกี่ยวกับตัวเลือกการรักษา บอทสนทนา AI เจนเนอเรชั่นสามารถใช้ตัวเชื่อมต่อที่สร้างไว้ล่วงหน้าใน Amazon Kendra เพื่อดึงข้อมูลที่เกี่ยวข้องมากที่สุดจากเอกสารนับล้านที่เผยแพร่ผ่านการวิจัยที่กำลังดำเนินการโดยบริษัทยาและมหาวิทยาลัย

กรณีการใช้งานเฉพาะ: ลดข้อผิดพลาดและเวลาที่ต้องใช้ในการกรอกและส่งแบบฟอร์มประกันภัย

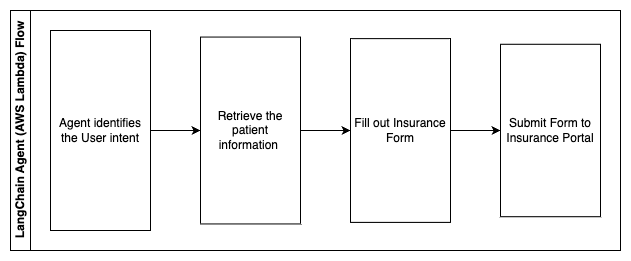

ในแผนภาพสถาปัตยกรรมนี้ ผู้เชี่ยวชาญด้านสุขภาพสามารถใช้บอทสนทนา AI เชิงสร้างสรรค์ เพื่อดูว่าต้องกรอกแบบฟอร์มใดบ้างสำหรับการประกัน จากนั้นตัวแทนของ LangChain จะสามารถดึงแบบฟอร์มที่ถูกต้องและเพิ่มข้อมูลที่จำเป็นสำหรับผู้ป่วย รวมทั้งให้คำตอบสำหรับส่วนที่เป็นคำอธิบายของแบบฟอร์มตามกรมธรรม์ประกันภัยและแบบฟอร์มก่อนหน้า ผู้เชี่ยวชาญด้านสุขภาพสามารถแก้ไขคำตอบที่ได้รับจาก LLM ก่อนที่จะอนุมัติและส่งแบบฟอร์มไปยังพอร์ทัลประกันภัย

ขั้นตอนต่อไปนี้จะอธิบายฟังก์ชัน AWS Lambda และโฟลว์ของฟังก์ชันตลอดกระบวนการ:

- ตัวแทน LangChain เพื่อระบุเจตนา

- ดึงข้อมูลผู้ป่วยที่จำเป็น

- กรอกแบบฟอร์มประกันภัยตามข้อมูลคนไข้และแนวปฏิบัติในแบบฟอร์ม

- ส่งแบบฟอร์มไปยังพอร์ทัลประกันภัยหลังจากได้รับการอนุมัติจากผู้ใช้

AWS HealthLake ใช้เพื่อจัดเก็บข้อมูลสุขภาพอย่างปลอดภัย รวมถึงแบบฟอร์มประกันก่อนหน้าและข้อมูลผู้ป่วย และ Amazon Comprehend ใช้เพื่อลบข้อมูลส่วนบุคคล (PII) ออกจากแบบฟอร์มประกันก่อนหน้า จากนั้นโปรแกรมรวบรวมข้อมูลของ Amazon Kendra จะสามารถใช้ชุดแบบฟอร์มการประกันและหลักเกณฑ์เพื่อสร้างดัชนีได้ เมื่อ Generative AI กรอกแบบฟอร์มแล้ว แบบฟอร์มที่ได้รับการตรวจสอบโดยผู้เชี่ยวชาญทางการแพทย์จะถูกส่งไปยังพอร์ทัลประกันภัย

ประมาณการค่าใช้จ่าย

ค่าใช้จ่ายในการปรับใช้โซลูชันพื้นฐานเป็นการพิสูจน์แนวคิดจะแสดงอยู่ในตารางต่อไปนี้ เนื่องจากโซลูชันพื้นฐานถือเป็นการพิสูจน์แนวคิด จึงใช้ Amazon Kendra Developer Edition เป็นตัวเลือกที่มีต้นทุนต่ำเนื่องจากปริมาณงานจะไม่อยู่ในการใช้งานจริง สมมติฐานของเราสำหรับ Amazon Kendra Developer Edition คือ 730 ชั่วโมงที่ใช้งานต่อเดือน

สำหรับ Amazon SageMaker เราได้สันนิษฐานว่าลูกค้าจะใช้อินสแตนซ์ ml.g4dn.2xlarge สำหรับการอนุมานแบบเรียลไทม์ โดยมีจุดสิ้นสุดการอนุมานจุดเดียวต่ออินสแตนซ์ คุณสามารถค้นหาข้อมูลเพิ่มเติมเกี่ยวกับราคา Amazon SageMaker และประเภทอินสแตนซ์การอนุมานที่มีอยู่ โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม.

| Service | ทรัพยากรที่ใช้ไป | ประมาณการค่าใช้จ่ายต่อเดือนในสกุลเงิน USD |

| AWS ขยาย | 150 นาทีในการสร้าง ให้บริการข้อมูล 1 GB 500,000 คำขอ |

15.71 |

| Amazon API Gateway Amazon | การเรียก API REST 1 ล้านครั้ง | 3.5 |

| AWS แลมบ์ดา | 1 ล้านคำขอ ระยะเวลา 5 วินาทีต่อคำขอ จัดสรรหน่วยความจำ 2 GB |

160.23 |

| อเมซอน ไดนาโมดีบี | 1 ล้านการอ่าน 1 ล้านเขียน พื้นที่จัดเก็บ 100 GB |

26.38 |

| อเมซอน Sagemaker | การอนุมานแบบเรียลไทม์ด้วย ml.g4dn.2xlarge | 676.8 |

| อเมซอน เคนดรา | Developer Edition พร้อม 730 ชั่วโมง/เดือน สแกนเอกสารได้ 10,000 ชุด 5,000 ข้อความค้นหา/วัน |

821.25 |

| . | . | ต้นทุนทั้งหมด: 1703.87 |

* Amazon Cognito มีผู้ใช้ที่ใช้งานอยู่รายเดือนจำนวน 50,000 รายที่ใช้กลุ่มผู้ใช้ Cognito หรือผู้ใช้ที่ใช้งานอยู่รายเดือนจำนวน 50 รายที่ใช้ผู้ให้บริการข้อมูลระบุตัวตน SAML 2.0

ทำความสะอาดขึ้น

เพื่อประหยัดค่าใช้จ่าย ให้ลบทรัพยากรทั้งหมดที่คุณปรับใช้โดยเป็นส่วนหนึ่งของบทช่วยสอน คุณสามารถลบตำแหน่งข้อมูล SageMaker ใดๆ ที่คุณอาจสร้างขึ้นผ่านคอนโซล SageMaker ได้ โปรดจำไว้ว่า การลบดัชนี Amazon Kendra จะไม่ลบเอกสารต้นฉบับออกจากพื้นที่จัดเก็บข้อมูลของคุณ

สรุป

ในโพสต์นี้ เราได้แสดงให้คุณเห็นถึงวิธีทำให้การเข้าถึงข้อมูลภายในง่ายขึ้นโดยการสรุปจากที่เก็บข้อมูลหลายแห่งแบบเรียลไทม์ หลังจากการพัฒนา LLM ที่มีจำหน่ายในท้องตลาดเมื่อเร็วๆ นี้ ความเป็นไปได้ของ generative AI ก็ชัดเจนมากขึ้น ในโพสต์นี้ เราได้จัดแสดงวิธีการใช้บริการของ AWS เพื่อสร้างแชทบอทแบบไร้เซิร์ฟเวอร์ที่ใช้ AI เชิงสร้างสรรค์ในการตอบคำถาม แนวทางนี้รวมชั้นการรับรองความถูกต้องและการตรวจจับ PII ของ Amazon Comprehend เพื่อกรองข้อมูลที่ละเอียดอ่อนใดๆ ที่ให้ไว้ในคำค้นหาของผู้ใช้ออก ไม่ว่าจะเป็นบุคคลที่อยู่ในแวดวงการดูแลสุขภาพที่เข้าใจความแตกต่างในการยื่นคำร้องประกัน หรือฝ่ายทรัพยากรบุคคลเข้าใจกฎระเบียบเฉพาะของบริษัท มีอุตสาหกรรมและแนวดิ่งมากมายที่สามารถได้รับประโยชน์จากแนวทางนี้ โมเดลพื้นฐาน Amazon SageMaker JumpStart คือกลไกเบื้องหลังแชทบอต ในขณะที่ใช้วิธีการบรรจุบริบทโดยใช้เทคนิค RAG เพื่อให้แน่ใจว่าการตอบสนองจะอ้างอิงเอกสารภายในได้แม่นยำยิ่งขึ้น

หากต้องการเรียนรู้เพิ่มเติมเกี่ยวกับการทำงานกับ Generative AI บน AWS โปรดดูที่ ประกาศเครื่องมือใหม่สำหรับการสร้างด้วย Generative AI บน AWS. สำหรับคำแนะนำเชิงลึกเพิ่มเติมเกี่ยวกับการใช้เทคนิค RAG กับบริการของ AWS โปรดดูที่ สร้างแอปพลิเคชัน Generative AI ที่มีความแม่นยำสูงอย่างรวดเร็วบนข้อมูลองค์กรโดยใช้ Amazon Kendra, LangChain และโมเดลภาษาขนาดใหญ่. เนื่องจากแนวทางในบล็อกนี้เป็นแบบไม่เชื่อเรื่องพระเจ้าแบบ LLM ดังนั้น LLM ใดๆ จึงสามารถนำไปใช้ในการอนุมานได้ ในโพสต์ถัดไป เราจะสรุปวิธีการปรับใช้โซลูชันนี้โดยใช้ Amazon Bedrock และ Amazon Titan LLM

เกี่ยวกับผู้เขียน

อภิเชค มาลิเกฮัลลี ชิวาลิงไกอาห์ เป็นสถาปนิกโซลูชันบริการ AI อาวุโสที่ AWS เขาหลงใหลในการสร้างแอปพลิเคชันโดยใช้ Generative AI, Amazon Kendra และ NLP เขามีประสบการณ์ประมาณ 10 ปีในการสร้างโซลูชันข้อมูลและ AI เพื่อสร้างมูลค่าให้กับลูกค้าและองค์กร เขาได้สร้างแชทบอท (ส่วนตัว) เพื่อความสนุกสนานในการตอบคำถามเกี่ยวกับอาชีพและเส้นทางอาชีพของเขา นอกเหนือจากงานแล้ว เขาชอบถ่ายภาพครอบครัวและเพื่อนๆ และชอบสร้างสรรค์ผลงานศิลปะ

อภิเชค มาลิเกฮัลลี ชิวาลิงไกอาห์ เป็นสถาปนิกโซลูชันบริการ AI อาวุโสที่ AWS เขาหลงใหลในการสร้างแอปพลิเคชันโดยใช้ Generative AI, Amazon Kendra และ NLP เขามีประสบการณ์ประมาณ 10 ปีในการสร้างโซลูชันข้อมูลและ AI เพื่อสร้างมูลค่าให้กับลูกค้าและองค์กร เขาได้สร้างแชทบอท (ส่วนตัว) เพื่อความสนุกสนานในการตอบคำถามเกี่ยวกับอาชีพและเส้นทางอาชีพของเขา นอกเหนือจากงานแล้ว เขาชอบถ่ายภาพครอบครัวและเพื่อนๆ และชอบสร้างสรรค์ผลงานศิลปะ

เมธา ไอยะห์ เป็น Associate Solutions Architect ที่ AWS ซึ่งตั้งอยู่ในเมืองออสติน รัฐเท็กซัส เธอเพิ่งสำเร็จการศึกษาจากมหาวิทยาลัยเท็กซัสที่ดัลลัสในเดือนธันวาคม 2022 ด้วยปริญญาโทสาขาวิทยาศาสตรมหาบัณฑิตสาขาวิทยาการคอมพิวเตอร์ที่มีความเชี่ยวชาญเฉพาะด้านระบบอัจฉริยะที่เน้นด้าน AI/ML เธอสนใจที่จะเรียนรู้เพิ่มเติมเกี่ยวกับ AI/ML และการใช้บริการของ AWS เพื่อค้นหาโซลูชันที่ลูกค้าจะได้รับประโยชน์

เมธา ไอยะห์ เป็น Associate Solutions Architect ที่ AWS ซึ่งตั้งอยู่ในเมืองออสติน รัฐเท็กซัส เธอเพิ่งสำเร็จการศึกษาจากมหาวิทยาลัยเท็กซัสที่ดัลลัสในเดือนธันวาคม 2022 ด้วยปริญญาโทสาขาวิทยาศาสตรมหาบัณฑิตสาขาวิทยาการคอมพิวเตอร์ที่มีความเชี่ยวชาญเฉพาะด้านระบบอัจฉริยะที่เน้นด้าน AI/ML เธอสนใจที่จะเรียนรู้เพิ่มเติมเกี่ยวกับ AI/ML และการใช้บริการของ AWS เพื่อค้นหาโซลูชันที่ลูกค้าจะได้รับประโยชน์

ฮิวโก้ เซ เป็น Associate Solutions Architect ที่ AWS ในเมืองซีแอตเทิล รัฐวอชิงตัน เขาสำเร็จการศึกษาระดับปริญญาโทสาขาเทคโนโลยีสารสนเทศจากมหาวิทยาลัยรัฐแอริโซนา และระดับปริญญาตรีสาขาเศรษฐศาสตร์จากมหาวิทยาลัยชิคาโก เขาเป็นสมาชิกของสมาคมการตรวจสอบและควบคุมระบบสารสนเทศ (ISACA) และสมาคมรับรองความปลอดภัยระบบสารสนเทศระหว่างประเทศ (ISC)2 เขาสนุกกับการช่วยให้ลูกค้าได้รับประโยชน์จากเทคโนโลยี

ฮิวโก้ เซ เป็น Associate Solutions Architect ที่ AWS ในเมืองซีแอตเทิล รัฐวอชิงตัน เขาสำเร็จการศึกษาระดับปริญญาโทสาขาเทคโนโลยีสารสนเทศจากมหาวิทยาลัยรัฐแอริโซนา และระดับปริญญาตรีสาขาเศรษฐศาสตร์จากมหาวิทยาลัยชิคาโก เขาเป็นสมาชิกของสมาคมการตรวจสอบและควบคุมระบบสารสนเทศ (ISACA) และสมาคมรับรองความปลอดภัยระบบสารสนเทศระหว่างประเทศ (ISC)2 เขาสนุกกับการช่วยให้ลูกค้าได้รับประโยชน์จากเทคโนโลยี

ไอมาน อิชิมเว เป็น Associate Solutions Architect ที่ AWS ในเมืองซีแอตเทิล รัฐวอชิงตัน เขาสำเร็จการศึกษาระดับปริญญาโทสาขาวิศวกรรมซอฟต์แวร์และไอทีจากมหาวิทยาลัยโอ๊คแลนด์ เขามีประสบการณ์มาก่อนในการพัฒนาซอฟต์แวร์ โดยเฉพาะในการสร้างไมโครเซอร์วิสสำหรับเว็บแอปพลิเคชันแบบกระจาย เขามีความกระตือรือร้นในการช่วยลูกค้าสร้างโซลูชันที่แข็งแกร่งและปรับขนาดได้บนบริการคลาวด์ของ AWS ตามแนวทางปฏิบัติที่ดีที่สุด

ไอมาน อิชิมเว เป็น Associate Solutions Architect ที่ AWS ในเมืองซีแอตเทิล รัฐวอชิงตัน เขาสำเร็จการศึกษาระดับปริญญาโทสาขาวิศวกรรมซอฟต์แวร์และไอทีจากมหาวิทยาลัยโอ๊คแลนด์ เขามีประสบการณ์มาก่อนในการพัฒนาซอฟต์แวร์ โดยเฉพาะในการสร้างไมโครเซอร์วิสสำหรับเว็บแอปพลิเคชันแบบกระจาย เขามีความกระตือรือร้นในการช่วยลูกค้าสร้างโซลูชันที่แข็งแกร่งและปรับขนาดได้บนบริการคลาวด์ของ AWS ตามแนวทางปฏิบัติที่ดีที่สุด

เชอร์วิน ซูเรช เป็น Associate Solutions Architect ที่ AWS ในเมืองออสติน รัฐเท็กซัส เขาสำเร็จการศึกษาระดับปริญญาโทสาขาวิศวกรรมซอฟต์แวร์ สาขาคอมพิวเตอร์คลาวด์และการจำลองเสมือน และปริญญาตรีสาขาวิศวกรรมคอมพิวเตอร์จากมหาวิทยาลัยซานโฮเซสเตต เขาหลงใหลในการใช้เทคโนโลยีเพื่อช่วยปรับปรุงชีวิตของผู้คนจากทุกภูมิหลัง

เชอร์วิน ซูเรช เป็น Associate Solutions Architect ที่ AWS ในเมืองออสติน รัฐเท็กซัส เขาสำเร็จการศึกษาระดับปริญญาโทสาขาวิศวกรรมซอฟต์แวร์ สาขาคอมพิวเตอร์คลาวด์และการจำลองเสมือน และปริญญาตรีสาขาวิศวกรรมคอมพิวเตอร์จากมหาวิทยาลัยซานโฮเซสเตต เขาหลงใหลในการใช้เทคโนโลยีเพื่อช่วยปรับปรุงชีวิตของผู้คนจากทุกภูมิหลัง

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. ยานยนต์ / EVs, คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ChartPrime. ยกระดับเกมการซื้อขายของคุณด้วย ChartPrime เข้าถึงได้ที่นี่.

- BlockOffsets การปรับปรุงการเป็นเจ้าของออฟเซ็ตด้านสิ่งแวดล้อมให้ทันสมัย เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- $ ขึ้น

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- สามารถ

- เกี่ยวกับเรา

- ยอมรับ

- เข้า

- การเข้าถึง

- บัญชี

- ถูกต้อง

- แม่นยำ

- การปฏิบัติ

- คล่องแคล่ว

- เพิ่ม

- นอกจากนี้

- ที่อยู่

- ที่อยู่

- ผู้ดูแลระบบ

- การนำ

- อาจารย์ที่ปรึกษา

- หลังจาก

- ตัวแทน

- ตัวแทน

- สรุป

- AI

- บริการ AI

- AI / ML

- ทั้งหมด

- ช่วยให้

- ตาม

- ด้วย

- ทางเลือก

- อเมซอน

- Amazon API Gateway Amazon

- Amazon Cognito Co

- เข้าใจ Amazon

- อเมซอน เคนดรา

- อเมซอน SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- จำนวน

- จำนวน

- an

- นักวิเคราะห์

- การวิเคราะห์

- และ

- คำตอบ

- คำตอบ

- ใด

- API

- เห็นได้ชัด

- การใช้งาน

- การใช้งาน

- การแต่งตั้ง

- เข้าใกล้

- อนุมัติ

- สถาปัตยกรรม

- เป็น

- เกิดขึ้น

- อาริโซน่า

- รอบ

- บทความ

- เทียม

- ปัญญาประดิษฐ์

- ปัญญาประดิษฐ์ (AI)

- งานศิลปะ

- AS

- ถาม

- ด้าน

- ประเมินผล

- ช่วยเหลือ

- ความช่วยเหลือ

- ภาคี

- ที่เกี่ยวข้อง

- สมาคม

- ข้อสมมติ

- At

- การตรวจสอบบัญชี

- เติม

- ออสติน

- รับรองความถูกต้อง

- การยืนยันตัวตน

- การอนุญาต

- โดยอัตโนมัติ

- อัตโนมัติ

- ความพร้อมใช้งาน

- ใช้ได้

- AWS

- AWS แลมบ์ดา

- กลับ

- ภูมิหลัง

- ฐาน

- ตาม

- BE

- หมี

- เพราะ

- กลายเป็น

- จะกลายเป็น

- รับ

- ก่อน

- ตัวแทน

- หลัง

- ประโยชน์

- ประโยชน์ที่ได้รับ

- ที่ดีที่สุด

- ปฏิบัติที่ดีที่สุด

- ดีกว่า

- บล็อก

- หนังสือ

- ธ ปท

- ทั้งสอง

- บอท

- ด้านล่าง

- ยี่ห้อ

- งบ

- สร้าง

- การก่อสร้าง

- สร้าง

- ธุรกิจ

- ธุรกิจ

- แต่

- by

- โทรศัพท์

- CAN

- ความสามารถในการ

- ความก้าวหน้า

- รอบคอบ

- กรณี

- กรณี

- หมวดหมู่

- ที่เกิดจาก

- ศูนย์

- ส่วนกลาง

- บาง

- ใบรับรอง มาตราฐาน

- โซ่

- ความท้าทาย

- เปลี่ยนแปลง

- การเรียกเก็บเงิน

- chatbot

- การตรวจสอบ

- การตรวจสอบ

- ชิคาโก

- การเรียกร้อง

- ชัดเจน

- คลินิก

- การทดลองทางคลินิก

- เมฆ

- คอมพิวเตอร์เมฆ

- บริการคลาวด์

- รวบรวม

- ชุด

- ในเชิงพาณิชย์

- ร่วมกัน

- การสื่อสาร

- บริษัท

- บริษัท

- บริษัท

- การแข่งขัน

- เสร็จ

- เสร็จสิ้น

- ซับซ้อน

- ความซับซ้อน

- ปฏิบัติตาม

- เข้าใจ

- คอมพิวเตอร์

- วิศวกรรมคอมพิวเตอร์

- วิทยาการคอมพิวเตอร์

- การคำนวณ

- สมาธิ

- แนวคิด

- กระชับ

- ดำเนินการ

- ที่บรรจบกัน

- เชื่อมต่อ

- เชื่อมต่อ

- การพิจารณา

- การพิจารณา

- ถือว่า

- คงเส้นคงวา

- ประกอบด้วย

- ปลอบใจ

- สมาคม

- บริโภค

- การบริโภค

- ติดต่อเรา

- contact center

- มี

- เนื้อหา

- สิ่งแวดล้อม

- อย่างต่อเนื่อง

- ก่อ

- ควบคุม

- การควบคุม

- ความสะดวกสบาย

- การสนทนา

- การสนทนา

- การสนทนา

- ไทม์ไลน์การ

- แก้ไข

- ราคา

- ค่าใช้จ่าย

- ไม้เลื้อย

- สร้าง

- สร้างมูลค่า

- ที่สร้างขึ้น

- การสร้าง

- เครดิต

- เกณฑ์

- วิกฤติ

- CRM

- สำคัญมาก

- curated

- ปัจจุบัน

- ขณะนี้

- ลูกค้า

- การมีส่วนร่วมของลูกค้า

- ประสบการณ์ของลูกค้า

- บริการลูกค้า

- Customer Support

- ลูกค้า

- ประจำวัน

- ดัลลัส

- ข้อมูล

- จุดข้อมูล

- ชุดข้อมูล

- ฐานข้อมูล

- วันที่

- ธันวาคม

- ตัดสินใจ

- การตัดสินใจ

- การตัดสินใจ

- การตัดสินใจ

- องศา

- ส่ง

- ทั้งนี้ขึ้นอยู่กับ

- นำไปใช้

- ปรับใช้

- บรรยาย

- ออกแบบ

- แม้จะมี

- รายละเอียด

- ตรวจพบ

- การตรวจพบ

- ผู้พัฒนา

- พัฒนาการ

- การพัฒนา

- ต่าง

- ยาก

- ค้นพบ

- กระจาย

- เอกสาร

- เอกสาร

- ทำ

- ไม่

- ขับรถ

- ระยะเวลา

- e

- ง่ายดาย

- อย่างง่ายดาย

- เศรษฐศาสตร์

- ระบบนิเวศ

- ฉบับ

- อย่างมีประสิทธิภาพ

- ความพยายาม

- ทั้ง

- เช็คคุณสมบัติที่นี่

- อีเมล

- อีเมล

- ลูกจ้าง

- พนักงาน

- ช่วยให้

- กระตุ้นให้เกิดการ

- ปลายทาง

- พลังงาน

- มีส่วนร่วม

- เครื่องยนต์

- ชั้นเยี่ยม

- เพิ่มคุณค่า

- ทำให้มั่นใจ

- เพื่อให้แน่ใจ

- การสร้างความมั่นใจ

- Enterprise

- ผู้ประกอบการ

- หน่วยงาน

- ข้อผิดพลาด

- การเพิ่ม

- ประมาณการ

- ฯลฯ

- แม้

- ตัวอย่าง

- ดำเนินการ

- ที่มีอยู่

- แพง

- ประสบการณ์

- อธิบาย

- อธิบาย

- การสกัด

- สารสกัดจาก

- ใบหน้า

- ครอบครัว

- ลักษณะ

- เฟด

- น้อยลง

- รูป

- เนื้อไม่มีมัน

- ใส่

- ที่เต็มไป

- การกรอก

- กรอง

- ทางการเงิน

- ข้อมูลทางการเงิน

- ประวัติทางการเงิน

- สถาบันการเงิน

- การจัดหาเงินทุน

- หา

- หา

- ชื่อจริง

- ความยืดหยุ่น

- ไหล

- โดยมุ่งเน้น

- ดังต่อไปนี้

- สำหรับ

- ฟอร์ม

- รูปแบบ

- ฟอรั่ม

- พบ

- รากฐาน

- กรอบ

- ฟรี

- เพื่อน

- ราคาเริ่มต้นที่

- สนุก

- ฟังก์ชัน

- ฟังก์ชั่น

- ต่อไป

- ได้รับ

- เกตเวย์

- สร้าง

- รุ่น

- กำเนิด

- กำเนิด AI

- ได้รับ

- กำหนด

- จะช่วยให้

- ให้

- รัฐบาล

- อย่างมาก

- ขึ้น

- การเจริญเติบโต

- เติบโต

- คำแนะนำ

- แนวทาง

- จัดการ

- จัดการ

- การจัดการ

- มี

- มี

- he

- สุขภาพ

- ข้อมูลสุขภาพ

- การดูแลสุขภาพ

- ช่วย

- การช่วยเหลือ

- จะช่วยให้

- เธอ

- จุดสูง

- อย่างสูง

- ของเขา

- ประวัติ

- ถือ

- เป็นเจ้าภาพ

- เจ้าภาพ

- ชั่วโมง

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- อย่างไรก็ตาม

- hr

- HTML

- HTTPS

- เป็นมนุษย์

- i

- ระบุ

- ตัวบ่งชี้

- ระบุ

- แยกแยะ

- ระบุ

- เอกลักษณ์

- if

- แสดงให้เห็นถึง

- การดำเนินการ

- การดำเนินการ

- ผลกระทบ

- ปรับปรุง

- ช่วยเพิ่ม

- การปรับปรุง

- in

- ลึกซึ้ง

- ไม่เที่ยง

- ประกอบด้วย

- รวมถึง

- รวมทั้ง

- เงินได้

- ภาษีเงินได้

- เพิ่ม

- เพิ่มขึ้น

- ดัชนี

- การจัดทำดัชนี

- ดัชนี

- บุคคล

- อุตสาหกรรม

- แจ้ง

- ข้อมูล

- ระบบสารสนเทศ

- เทคโนโลยีสารสนเทศ

- แจ้ง

- มรดก

- อินพุต

- ตัวอย่าง

- ด่วน

- แทน

- สถาบัน

- สถาบัน

- ประกัน

- แบบบูรณาการ

- รวม

- บูรณาการ

- Intelligence

- ฉลาด

- ความตั้งใจ

- โต้ตอบ

- การโต้ตอบ

- สนใจ

- อินเตอร์เฟซ

- ภายใน

- International

- เข้าไป

- การลงทุน

- ปัญหา

- IT

- รายการ

- การเดินทาง

- jpg

- เก็บ

- ความรู้

- ที่รู้จักกัน

- ภาษา

- ใหญ่

- ชั้น

- นำ

- เรียนรู้

- การเรียนรู้

- น้อยลง

- ชั้น

- การใช้ประโยชน์

- ห้องสมุด

- การ จำกัด

- ข้อ จำกัด

- Line

- ชีวิต

- LLM

- เงินกู้

- เงินให้กู้ยืม

- เข้าสู่ระบบ

- ตรรกะ

- นาน

- เวลานาน

- อีกต่อไป

- ดู

- Lot

- รัก

- ที่มีราคาต่ำ

- ลด

- ซื่อสัตย์

- ความจงรักภักดี

- เครื่อง

- เรียนรู้เครื่อง

- ทำ

- เก็บรักษา

- ทำ

- ทำให้

- การทำ

- จัดการ

- การจัดการ

- ลักษณะ

- คู่มือ

- ด้วยมือ

- หลาย

- ตลาด

- การวิจัยทางการตลาด

- ปริญญาโท

- อาจ..

- วิธี

- ทางการแพทย์

- สมาชิก

- หน่วยความจำ

- microservices

- ไมโครซอฟท์

- ล้าน

- ล้าน

- ใจ

- ML

- แบบ

- โมเดล

- โมดูล

- เดือน

- รายเดือน

- ข้อมูลเพิ่มเติม

- มากที่สุด

- หลาย

- พื้นเมือง

- จำเป็น

- จำเป็นต้อง

- จำเป็น

- ความต้องการ

- ใหม่

- ถัดไป

- NLP

- การประกาศ

- ตัวเลข

- โอ๊คแลนด์

- รับรอง

- of

- เสนอ

- มักจะ

- น้ำมัน

- on

- การดูแลพนักงานใหม่

- ครั้งเดียว

- ONE

- ต่อเนื่อง

- เพียง

- เปิด

- ทำงาน

- การดำเนินงาน

- การดำเนินงาน

- โอกาส

- การเพิ่มประสิทธิภาพ

- ตัวเลือกเสริม (Option)

- Options

- or

- ใบสั่ง

- องค์กร

- เป็นต้นฉบับ

- อื่นๆ

- ของเรา

- ออก

- เค้าโครง

- ด้านนอก

- เกิน

- ตัวอย่าง

- ส่วนหนึ่ง

- ส่วน

- ผ่าน

- หลงใหล

- ผู้ป่วย

- ชำระ

- คน

- ต่อ

- การปฏิบัติ

- สิทธิ์

- ส่วนบุคคล

- ข้อมูลส่วนบุคคล

- ส่วนตัว

- เภสัชกรรม

- เสา

- แผนการ

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- กรุณา

- จุด

- จุด

- นโยบาย

- สระว่ายน้ำ

- พอร์ทัล

- การถ่ายภาพบุคคล

- ความเป็นไปได้

- ความเป็นไปได้

- โพสต์

- ขับเคลื่อน

- การปฏิบัติ

- นำเสนอ

- ป้องกัน

- ก่อน

- ก่อนหน้านี้

- การตั้งราคา

- รูปแบบการกำหนดราคา

- ก่อน

- ลำดับความสำคัญ

- ความเป็นส่วนตัว

- ปัญหาที่เกิดขึ้น

- ขั้นตอน

- ดำเนิน

- กระบวนการ

- แปรรูปแล้ว

- กระบวนการ

- การประมวลผล

- การผลิต

- ผลผลิต

- ผลิตภัณฑ์

- มืออาชีพ

- มืออาชีพ

- คุณสมบัติ

- ให้

- ให้

- ผู้ให้บริการ

- การให้

- การตีพิมพ์

- ซื้อ

- Q & A

- แก้ไข

- ที่พรรณา

- คำสั่ง

- คำถาม

- คำถาม

- รวดเร็ว

- อย่างรวดเร็ว

- พิสัย

- คะแนน

- อ่าน

- การอ่าน

- เรียลไทม์

- เมื่อเร็ว ๆ นี้

- เมื่อเร็ว ๆ นี้

- ลด

- ลด

- อ้างอิง

- อ้างอิง

- เกี่ยวกับ

- สม่ำเสมอ

- กฎระเบียบ

- ความสัมพันธ์

- ความสัมพันธ์กัน

- ตรงประเด็น

- วางใจ

- ซากศพ

- จำ

- เอาออก

- ขอ

- การร้องขอ

- ต้องการ

- จำเป็นต้องใช้

- ความต้องการ

- การวิจัย

- นักวิจัย

- ความละเอียด

- การตัดสินใจ

- แหล่งข้อมูล

- คำตอบ

- การตอบสนอง

- ความรับผิดชอบ

- REST

- ผล

- การคืน

- สุดท้าย

- ขวา

- ความเสี่ยง

- แข็งแรง

- เส้นทาง

- วิ่ง

- s

- sagemaker

- ขาย

- ซาน

- ซานโฮเซ

- ความพอใจ

- ลด

- ที่ปรับขนาดได้

- ขนาด

- สถานการณ์

- วิทยาศาสตร์

- คะแนน

- สคริปต์

- ค้นหา

- ค้นหา

- ซีแอตเทิ

- ที่สอง

- วินาที

- Section

- ปลอดภัย

- อย่างปลอดภัย

- ความปลอดภัย

- Selling

- ส่ง

- ระดับอาวุโส

- มีความละเอียดอ่อน

- ส่ง

- serverless

- ให้บริการอาหาร

- บริการ

- บริการ

- ชุด

- ชุดอุปกรณ์

- การตั้งค่า

- หลาย

- เธอ

- เปลี่ยน

- ข้อบกพร่อง

- น่า

- จัดแสดง

- แสดงให้เห็นว่า

- แสดง

- ไซโล

- คล้ายคลึงกัน

- ง่าย

- ลดความซับซ้อน

- ตั้งแต่

- เดียว

- ขนาด

- มีขนาดเล็กกว่า

- So

- สังคม

- ซอฟต์แวร์

- การพัฒนาซอฟต์แวร์

- วิศวกรรมซอฟต์แวร์

- ทางออก

- โซลูชัน

- บาง

- แหล่ง

- แหล่งที่มา

- ความเชี่ยวชาญ

- โดยเฉพาะ

- เฉพาะ

- ใช้จ่าย

- การใช้จ่าย

- มาตรฐาน

- สถานะ

- Status

- เข้าพัก

- ขั้นตอน

- ขั้นตอน

- ยังคง

- การเก็บรักษา

- จัดเก็บ

- เก็บไว้

- การเก็บรักษา

- ความเครียด

- การบรรจุ

- เป็นกอบเป็นกำ

- อย่างเช่น

- แนะนำ

- สรุป

- สนับสนุน

- ระบบ

- ระบบ

- ตาราง

- ใช้เวลา

- งาน

- ภาษี

- ทีม

- ทีม

- เทคโนโลยี

- เงื่อนไขการใช้บริการ

- เท็กซัส

- ข้อความ

- เกี่ยวกับใจความ

- ที่

- พื้นที่

- ข้อมูล

- ของพวกเขา

- ตัวเอง

- แล้วก็

- ที่นั่น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- ของบุคคลที่สาม

- นี้

- ตลอด

- ตั๋ว

- จองตั๋ว

- ชั้น

- เวลา

- ต้องใช้เวลามาก

- ทันเวลา

- ครั้ง

- การประทับเวลา

- ยักษ์

- ไปยัง

- ในวันนี้

- ราชสกุล

- เครื่องมือ

- เครื่องมือ

- ตรวจสอบย้อนกลับ

- ตามธรรมเนียม

- ผ่านการฝึกอบรม

- การฝึกอบรม

- หม้อแปลงไฟฟ้า

- ความโปร่งใส

- การรักษา

- การทดลอง

- การทดลอง

- เกี่ยวกับการสอน

- ชนิด

- ไม่สามารถ

- เข้าใจ

- ความเข้าใจ

- เป็นเอกลักษณ์

- มหาวิทยาลัย

- มหาวิทยาลัย

- มหาวิทยาลัยชิคาโก

- ทันเหตุการณ์

- ให้กับคุณ

- การปรับปรุง

- ใช้

- ใช้กรณี

- มือสอง

- ผู้ใช้งาน

- ผู้ใช้

- ใช้

- การใช้

- นำไปใช้

- ใช้

- การใช้ประโยชน์

- ความคุ้มค่า

- ต่างๆ

- การตรวจสอบ

- ตรวจสอบ

- แนวดิ่ง

- ผ่านทาง

- วีดีโอ

- วิดีโอ

- เสียงพูด

- รอ

- ที่รอ

- คือ

- วอชิงตัน

- วิธี

- we

- เว็บ

- โปรแกรมประยุกต์บนเว็บ

- เว็บแอปพลิเคชัน

- บริการเว็บ

- ดี

- คือ

- อะไร

- เมื่อ

- ว่า

- ที่

- ในขณะที่

- WHO

- กว้าง

- ช่วงกว้าง

- กับ

- ภายใน

- งาน

- เวิร์กโฟลว์

- การทำงาน

- จะ

- เขียน

- ปี

- คุณ

- ของคุณ

- ลมทะเล