Açık kaynaklı büyük dil modelleri (LLM'ler) popüler hale geldi ve araştırmacıların, geliştiricilerin ve kuruluşların inovasyonu ve denemeyi teşvik etmek için bu modellere erişmesine izin verdi. Bu, LLM'lerin geliştirilmesine ve iyileştirilmesine katkıda bulunmak için açık kaynak topluluğunun işbirliğini teşvik eder. Açık kaynaklı LLM'ler, model mimarisine, eğitim sürecine ve eğitim verilerine şeffaflık sağlayarak araştırmacıların modelin nasıl çalıştığını anlamalarına, potansiyel önyargıları belirlemelerine ve etik kaygıları ele almalarına olanak tanır. Bu açık kaynaklı LLM'ler, görev açısından kritik iş uygulamaları oluşturmak için gelişmiş doğal dil işleme (NLP) teknolojisini geniş bir kullanıcı yelpazesine sunarak üretken yapay zekayı demokratikleştiriyor. GPT-NeoX, LLaMA, Alpaca, GPT4All, Vicuna, Dolly ve OpenAssistant, popüler açık kaynaklı LLM'lerden bazılarıdır.

OpenChatKit Together Computer tarafından Mart 2023'te Apache-2.0 lisansı altında piyasaya sürülen, genel amaçlı ve özel sohbet robotu uygulamaları oluşturmak için kullanılan açık kaynaklı bir LLM'dir. Bu model, geliştiricilerin sohbet robotunun davranışı üzerinde daha fazla kontrole sahip olmasına ve bunu kendi özel uygulamalarına göre uyarlamasına olanak tanır. OpenChatKit, tamamen özelleştirilmiş, güçlü sohbet robotları oluşturmak için bir dizi araç, temel bot ve yapı taşları sağlar. Anahtar bileşenler aşağıdaki gibidir:

- EleutherAI'nin GPT-NeoX-20B'sinden %43 karbon negatif hesaplamada 100 milyondan fazla talimatla sohbet için ince ayarlı, talimat ayarlı LLM. bu

GPT-NeoXT-Chat-Base-20Bmodel, EleutherAI'nin GPT-NeoX modeline dayalıdır ve diyalog tarzı etkileşimlere odaklanan verilerle ince ayar yapılmıştır. - Görevlerinizde yüksek doğruluk elde etmek için modelde ince ayar yapmak için özelleştirme tarifleri.

- Çıkarım zamanında bir belge havuzundan, API'den veya diğer canlı güncelleme bilgi kaynağından gelen bilgilerle bot yanıtlarını artırmanıza olanak tanıyan genişletilebilir bir alma sistemi.

- Botun yanıt verdiği soruları filtrelemek için tasarlanmış, GPT-JT-6B'den ince ayarı yapılmış bir moderasyon modeli.

Derin öğrenme modellerinin artan ölçeği ve boyutu, bu modelleri üretken yapay zeka uygulamalarında başarılı bir şekilde dağıtmanın önünde engeller oluşturuyor. Düşük gecikme süresi ve yüksek verim taleplerini karşılamak için, model paralelliği ve niceleme gibi karmaşık yöntemlerin kullanılması zorunlu hale gelir. Bu yöntemlerin uygulanmasında yeterliliğe sahip olmayan çok sayıda kullanıcı, üretken AI kullanım durumları için oldukça büyük modellerin barındırılmasını başlatmada zorluklarla karşılaşıyor.

Bu gönderide, OpenChatKit modellerinin nasıl konuşlandırılacağını gösteriyoruz (GPT-NeoXT-Chat-Base-20B and GPT-JT-Moderation-6B) modeller açık Amazon Adaçayı Yapıcı DJL Sunumunu ve DeepSpeed ve Hugging Face Accelerate gibi açık kaynaklı model paralel kitaplıkları kullanarak. Programlama dilinden bağımsız olan Deep Java Library (DJL) tarafından desteklenen yüksek performanslı bir evrensel model sunma çözümü olan DJL Serving'i kullanıyoruz. Hugging Face Accelerate kitaplığının büyük modellerin birden çok GPU'ya dağıtımını nasıl basitleştirdiğini ve böylece LLM'leri dağıtılmış bir şekilde çalıştırma yükünü nasıl azalttığını gösteriyoruz. Başlayalım!

Genişletilebilir alma sistemi

Genişletilebilir bir erişim sistemi, OpenChatKit'in temel bileşenlerinden biridir. Kapalı bir etki alanı bilgi tabanına dayalı olarak bot yanıtını özelleştirmenizi sağlar. LLM'ler, model parametrelerinde olgusal bilgileri tutabilmelerine ve ince ayar yapıldığında aşağı akış NLP görevlerinde dikkate değer performans elde edebilmelerine rağmen, kapalı alan bilgisine erişme ve doğru bir şekilde tahmin etme kapasiteleri sınırlı kalır. Bu nedenle, yoğun bilgi gerektiren görevler sunulduğunda, performansları göreve özgü mimarilerin performansından zarar görür. Wikipedia, belge havuzları, API'ler ve diğer bilgi kaynakları gibi harici bilgi kaynaklarından gelen yanıtlardaki bilgileri artırmak için OpenChatKit alma sistemini kullanabilirsiniz.

Geri alma sistemi, belirli bir sorguya yanıt olarak ilgili ayrıntıları elde ederek sohbet robotunun mevcut bilgilere erişmesini sağlar ve böylece modelin yanıtlar üretmesi için gerekli bağlamı sağlar. Bu alma sisteminin işlevselliğini göstermek için, Wikipedia makaleleri dizini için destek sağlıyoruz ve bilgi alma için bir web arama API'sinin nasıl çalıştırılacağını gösteren örnek kod sunuyoruz. Sağlanan belgeleri takip ederek, çıkarım işlemi sırasında alma sistemini herhangi bir veri kümesi veya API ile entegre ederek sohbet robotunun dinamik olarak güncellenen verileri yanıtlarına dahil etmesine olanak sağlayabilirsiniz.

moderasyon modeli

Moderasyon modelleri, chatbot uygulamalarında içerik filtreleme, kalite kontrol, kullanıcı güvenliği ve yasal ve uyumluluk nedenlerini uygulamak için önemlidir. Denetleme zor ve öznel bir görevdir ve büyük ölçüde chatbot uygulamasının etki alanına bağlıdır. OpenChatKit, sohbet robotu uygulamasını yönetmek ve herhangi bir uygunsuz içerik için giriş metni istemlerini izlemek için araçlar sağlar. Denetleme modeli, çeşitli ihtiyaçlara göre uyarlanabilen ve özelleştirilebilen iyi bir temel sağlar.

OpenChatKit'in 6 milyar parametreli bir moderasyon modeli vardır, GPT-JT-Moderation-6B, girişleri denetlenen konularla sınırlamak için sohbet robotunu denetleyebilir. Modelin kendisinde yerleşik bir denetim olsa da, TogetherComputer bir GPT-JT-Denetim-6B Ontocord.ai ile model OIG moderasyon veri kümesi. Bu model, hem kullanıcı girişinin hem de bottan gelen yanıtın uygunsuz sonuçlar içermediğini kontrol etmek için ana sohbet robotuyla birlikte çalışır. Bunu ayrıca, chatbot'a etki alanı dışındaki soruları algılamak ve soru chatbot'un etki alanının parçası olmadığında geçersiz kılmak için de kullanabilirsiniz.

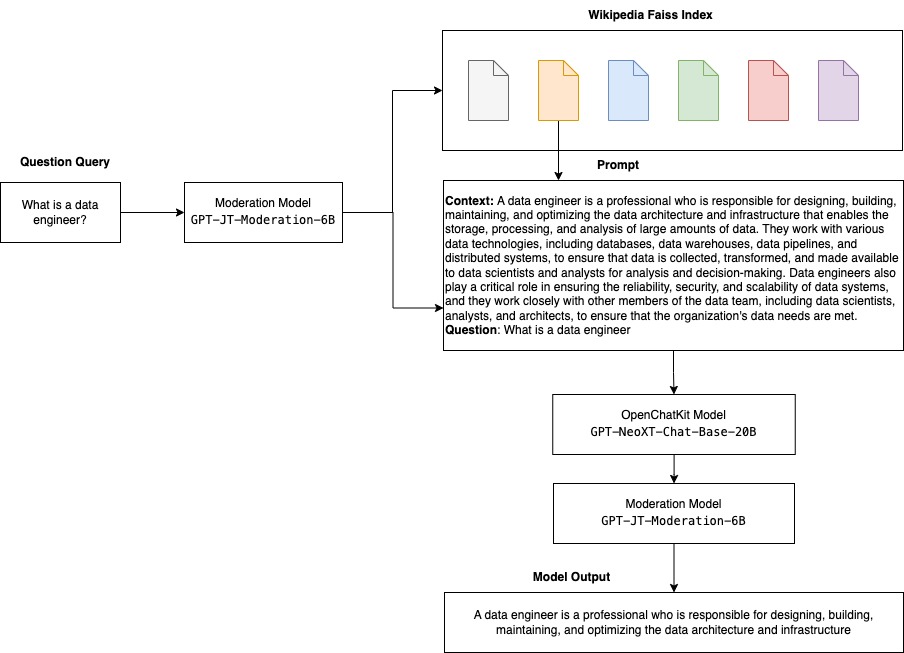

Aşağıdaki diyagram, OpenChatKit iş akışını göstermektedir.

Genişletilebilir alma sistemi kullanım durumları

Üretken AI uygulamaları oluşturmak için bu tekniği çeşitli endüstrilerde uygulayabilsek de, bu yazı için finans endüstrisindeki kullanım örneklerini tartışacağız. Alma artırılmış üretim, belirli şirketler, endüstriler veya finansal ürünler hakkında otomatik olarak araştırma raporları oluşturmak için finansal araştırmalarda kullanılabilir. Dahili bilgi tabanlarından, mali arşivlerden, haber makalelerinden ve araştırma makalelerinden ilgili bilgileri alarak, önemli içgörüleri, mali ölçütleri, pazar eğilimlerini ve yatırım tavsiyelerini özetleyen kapsamlı raporlar oluşturabilirsiniz. Finansal haberleri, piyasa duyarlılığını ve trendleri izlemek ve analiz etmek için bu çözümü kullanabilirsiniz.

Çözüme genel bakış

OpenChatKit modellerini kullanarak bir sohbet robotu oluşturmak ve bunları SageMaker'da dağıtmak için aşağıdaki adımlar yer alır:

- Sohbet tabanını indirin

GPT-NeoXT-Chat-Base-20Byüklenecek model eserlerini modelleyin ve paketleyin Amazon Basit Depolama Hizmeti (Amazon S3). - Bir SageMaker büyük model çıkarım (LMI) kabı kullanın, özellikleri yapılandırın ve bu modeli dağıtmak için özel çıkarım kodu ayarlayın.

- Model paralel tekniklerini yapılandırın ve DJL hizmet özelliklerinde çıkarım optimizasyonu kitaplıklarını kullanın. DJL sunumu için motor olarak Hugging Face Accelerate kullanacağız. Ek olarak, modeli bölümlemek için tensör paralel konfigürasyonları tanımlıyoruz.

- Bir SageMaker modeli ve uç nokta yapılandırması oluşturun ve SageMaker uç noktasını konuşlandırın.

Not defterini çalıştırarak takip edebilirsiniz. GitHub repo.

OpenChatKit modelini indirin

İlk olarak, OpenChatKit temel modelini indiriyoruz. Kullanırız huggingface_hub ve kullan snapshot_download belirli bir revizyonda tüm depoyu indiren modeli indirmek için. İşlemi hızlandırmak için indirmeler eş zamanlı olarak yapılır. Aşağıdaki koda bakın:

DJL Sunum özellikleri

Kendi çıkarım kodunuzu sağlamadan özel çıkarım koduyla büyük üretken yapay zeka modellerini barındırmak için SageMaker LMI kapsayıcılarını kullanabilirsiniz. Bu, girdi verilerinin özel ön işlemesi veya model tahminlerinin sonradan işlenmesi olmadığında son derece kullanışlıdır. Özel çıkarım kodunu kullanarak da bir model dağıtabilirsiniz. Bu gönderide, OpenChatKit modellerinin özel çıkarım koduyla nasıl dağıtılacağını gösteriyoruz.

SageMaker, model eserlerinin tar biçiminde olmasını bekler. Her OpenChatKit modelini aşağıdaki dosyalarla oluşturuyoruz: serving.properties ve model.py.

The serving.properties yapılandırma dosyası, DJL Serving'e hangi model paralelleştirme ve çıkarım optimizasyonu kitaplıklarını kullanmak istediğinizi belirtir. Bu yapılandırma dosyasında kullandığımız ayarların listesi aşağıdadır:

Bu, aşağıdaki parametreleri içerir:

- motor – DJL'nin kullanması için motor.

- seçenek.giriş Noktası – Giriş noktası Python dosyası veya modülü. Bu, kullanılan motorla uyumlu olmalıdır.

- seçenek.s3url – Bunu, modeli içeren S3 klasörünün URI'sine ayarlayın.

- seçenek.model kimliği – Modeli huggingface.com adresinden indirmek isterseniz ayarlayabilirsiniz.

option.modelidhuggingface.co'daki bir model havuzunda barındırılan önceden eğitilmiş bir modelin model kimliğine (https://huggingface.co/models). Kapsayıcı, huggingface.co'daki ilgili model havuzunu indirmek için bu model kimliğini kullanır. - seçenek.tensor_parallel_degree – Bunu, DeepSpeed'in modeli bölmek için ihtiyaç duyduğu GPU cihazlarının sayısına ayarlayın. Bu parametre aynı zamanda, DJL Sunumu çalıştığında başlatılacak model başına çalışan sayısını da kontrol eder. Örneğin, 8 GPU'lu bir makinemiz varsa ve sekiz bölüm oluşturuyorsak, istekleri yerine getirmek için model başına bir çalışanımız olacaktır. Belirli bir model mimarisi ve donanım platformu için paralellik derecesini ayarlamak ve en uygun değeri belirlemek gerekir. Biz buna yetenek diyoruz çıkarıma uyarlanmış paralellik.

Bakın Yapılandırmalar ve ayarlar Kapsamlı bir seçenek listesi için.

OpenChatKit modelleri

OpenChatKit temel model uygulaması aşağıdaki dört dosyaya sahiptir:

- model.py – Bu dosya, ana OpenChatKit GPT-NeoX modeli için işleme mantığını uygular. Çıkarım girdi talebini alır, modeli yükler, Wikipedia dizinini yükler ve yanıtı sunar. bakın

model.py(not defterinin oluşturulan parçası) ek ayrıntılar için.model.pyaşağıdaki anahtar sınıfları kullanır:- OpenChatKit Hizmeti – Bu, verilerin GPT-NeoX modeli, Faiss araması ve konuşma nesnesi arasında aktarılmasını yönetir.

WikipediaIndexveConversationnesneler başlatılır ve giriş sohbet konuşmaları, Wikipedia'dan ilgili içeriği aramak için dizine gönderilir. Bu aynı zamanda, bilgi istemlerini saklamak amacıyla sağlanmadığı takdirde, her çağrı için benzersiz bir kimlik oluşturur. Amazon DinamoDB. - Sohbet Modeli – Bu sınıf, modeli ve belirteç oluşturucuyu yükler ve yanıtı oluşturur. Kullanarak modeli birden fazla GPU arasında bölümlemeyi yönetir.

tensor_parallel_degreeve yapılandırırdtypesvedevice_map. İstemler, yanıtlar oluşturmak için modele iletilir. Durdurma kriteriStopWordsCriterianesil için yalnızca çıkarımda bot yanıtı üretecek şekilde yapılandırılmıştır. - DenetlemeModel – İki denetleme modeli kullanıyoruz

ModerationModelclass: Girdinin çıkarım sonucunu geçersiz kılmak için uygun olmadığını sohbet modeline belirtmek için girdi modeli ve çıkarım sonucunu geçersiz kılmak için çıktı modeli. Girdi istemini ve çıktı yanıtını aşağıdaki olası etiketlerle sınıflandırıyoruz:- gündelik

- dikkat gerekiyor

- müdahale gerekiyor (bu, model tarafından yönetilmek üzere işaretlendi)

- muhtemelen dikkat gerektiriyor

- muhtemelen dikkat gerekiyor

- OpenChatKit Hizmeti – Bu, verilerin GPT-NeoX modeli, Faiss araması ve konuşma nesnesi arasında aktarılmasını yönetir.

- wikipedia_prepare.py – Bu dosya, Wikipedia dizininin indirilmesini ve hazırlanmasını yönetir. Bu gönderide, Hugging Face veri kümelerinde sağlanan bir Wikipedia dizini kullanıyoruz. İlgili metni Wikipedia belgelerinde aramak için, başka bir yerde paketlenmediğinden dizinin Hugging Face'ten indirilmesi gerekir. bu

wikipedia_prepare.pyDosya içe aktarıldığında indirme işleminden sorumludur. Çıkarım için çalışan birden çok işlemde yalnızca tek bir işlem depoyu klonlayabilir. Geri kalanlar, dosyalar yerel dosya sisteminde bulunana kadar bekler. - wikipedia.py – Bu dosya, bağlamsal olarak ilgili belgeler için Wikipedia dizininde arama yapmak için kullanılır. Giriş sorgusu tokenize edilir ve yerleştirmeler kullanılarak oluşturulur.

mean_pooling. Bağlamsal olarak ilgili Wikipedia cümlelerini almak için sorgu gömme ile Wikipedia dizini arasındaki kosinüs benzerlik mesafesi ölçümlerini hesaplıyoruz. bakınwikipedia.pyuygulama detayları için.

- konuşma.py – Bu dosya, modele ve kullanıcıya iletmek üzere konuşma dizisini DynamoDB'de depolamak ve almak için kullanılır.

conversation.pyaçık kaynaklı OpenChatKit deposundan uyarlanmıştır. Bu dosya, insan ve model arasındaki konuşma dönüşlerini saklayan nesneyi tanımlamaktan sorumludur. Bununla model, konuşma için bir oturumu tutabilir ve kullanıcının önceki mesajlara bakmasına olanak tanır. SageMaker uç nokta çağrıları durum bilgisiz olduğundan, bu görüşmenin uç nokta örneklerinin dışında bir konumda saklanması gerekir. Başlatma sırasında örnek, yoksa bir DynamoDB tablosu oluşturur. Konuşmadaki tüm güncellemeler daha sonra DynamoDB'de depolanır.session_iduç nokta tarafından oluşturulan anahtar. Bir oturum kimliğine sahip herhangi bir çağrı, ilişkili konuşma dizesini alır ve gerektiği gibi günceller.

Özel bağımlılıklarla bir LMI çıkarım kapsayıcısı oluşturun

Dizin araması Facebook'un fay benzerlik araması yapmak için kütüphane. Bu, temel LMI görüntüsüne dahil edilmediğinden, kapsayıcının bu kitaplığı yüklemek için uyarlanması gerekir. Aşağıdaki kod, bot uç noktasının ihtiyaç duyduğu diğer kitaplıkların yanı sıra Faiss'i kaynaktan yükleyen bir Dockerfile tanımlar. biz kullanıyoruz sm-docker görüntüyü oluşturmak ve itmek için yardımcı program Amazon Elastik Konteyner Kayıt Defteri (Amazon ECR) Amazon SageMaker Stüdyosu. Bakın Studio dizüstü bilgisayarlarınızdan kapsayıcı görüntüleri oluşturmak için Amazon SageMaker Studio Image Build CLI'yi kullanma daha fazla ayrıntı için.

DJL kapsayıcısında Conda kurulu değildir, bu nedenle Faiss'in kaynaktan klonlanması ve derlenmesi gerekir. Faiss'i kurmak için, BLAS API'lerini kullanma bağımlılıkları ve Python desteği kurulmalıdır. Bu paketler kurulduktan sonra Faiss, kurulu Python uzantıları ile derlenmeden önce AVX2 ve CUDA kullanacak şekilde yapılandırılır.

pandas, fastparquet, boto3, ve git-lfs dizin dosyalarının indirilmesi ve okunması için gerekli olduğundan daha sonra kurulur.

Modeli oluşturun

Artık Amazon ECR'de Docker görüntüsüne sahip olduğumuza göre, OpenChatKit modelleri için SageMaker model nesnesini oluşturmaya devam edebiliriz. konuşlandırıyoruz GPT-NeoXT-Chat-Base-20B kullanarak giriş ve çıkış denetleme modelleri GPT-JT-Moderation-6B. Bakın model_oluştur daha fazla ayrıntı için.

Uç noktayı yapılandırın

Ardından, OpenChatKit modelleri için uç nokta yapılandırmalarını tanımlıyoruz. Modelleri ml.g5.12xlarge bulut sunucusu tipini kullanarak konuşlandırıyoruz. bakın create_endpoint_config daha fazla ayrıntı için.

Uç noktayı dağıtın

Son olarak, önceki adımlarda tanımladığımız model ve uç nokta konfigürasyonunu kullanarak bir uç nokta oluşturuyoruz:

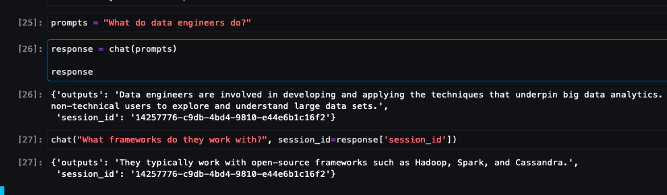

OpenChatKit modellerinden çıkarım çalıştırma

Şimdi modele çıkarım istekleri gönderme ve yanıtları alma zamanı. Giriş metni istemini ve aşağıdaki gibi model parametrelerini geçiyoruz temperature, top_k, ve max_new_tokens. Chatbot yanıtlarının kalitesi belirtilen parametrelere bağlıdır, bu nedenle kullanım durumunuz için en uygun ayarı bulmak üzere model performansını bu parametrelerle kıyaslamanız önerilir. Giriş istemi önce giriş moderasyon modeline gönderilir ve çıkış şuna gönderilir: ChatModel yanıtları oluşturmak için. Bu adım sırasında model, modelden alana özgü yanıtlar almak için bilgi istemi olarak modele bağlamsal olarak ilgili bölümleri almak için Wikipedia dizinini kullanır. Son olarak, model yanıtı, sınıflandırmayı kontrol etmek için çıktı denetleme modeline gönderilir ve ardından yanıtlar döndürülür. Aşağıdaki koda bakın:

Aşağıdaki örnek sohbet etkileşimlerine bakın.

Temizlemek

Gereksiz ücretlerden kaçınmak için bu gönderinin bir parçası olarak sağlanan kaynakları silmek için temizleme bölümündeki talimatları izleyin. bakın Amazon SageMaker Fiyatlandırması çıkarım örneklerinin maliyetiyle ilgili ayrıntılar için.

Sonuç

Bu gönderide, açık kaynaklı LLM'lerin önemini ve yeni nesil sohbet robotu uygulamaları oluşturmak için SageMaker'da bir OpenChatKit modelinin nasıl dağıtılacağını tartıştık. OpenChatKit modellerinin çeşitli bileşenlerini, moderasyon modellerini ve artırılmış nesil (RAG) alma iş akışları için Wikipedia gibi harici bir bilgi kaynağının nasıl kullanılacağını tartıştık. Adım adım talimatları şu adreste bulabilirsiniz: GitHub not defteri. Oluşturduğunuz harika sohbet robotu uygulamaları hakkında bize bilgi verin. Şerefe!

Yazarlar Hakkında

Dhaval Patel AWS'de Baş Makine Öğrenimi Mimarıdır. Dağıtılmış bilgi işlem ve Yapay Zeka ile ilgili sorunlar üzerinde büyük kuruluşlardan orta ölçekli girişimlere kadar çeşitli kuruluşlarla çalıştı. NLP ve Computer Vision alanları dahil olmak üzere Derin öğrenmeye odaklanmaktadır. Müşterilerin SageMaker'da yüksek performanslı model çıkarımı yapmasına yardımcı olur.

Dhaval Patel AWS'de Baş Makine Öğrenimi Mimarıdır. Dağıtılmış bilgi işlem ve Yapay Zeka ile ilgili sorunlar üzerinde büyük kuruluşlardan orta ölçekli girişimlere kadar çeşitli kuruluşlarla çalıştı. NLP ve Computer Vision alanları dahil olmak üzere Derin öğrenmeye odaklanmaktadır. Müşterilerin SageMaker'da yüksek performanslı model çıkarımı yapmasına yardımcı olur.

vikram elango Virginia, ABD merkezli AWS'de Kıdemli AIML Uzmanı Çözüm Mimarıdır. Şu anda üretken yapay zeka, LLM'ler, hızlı mühendislik, büyük model çıkarım optimizasyonu ve işletmeler genelinde makine öğrenimini ölçeklendirmeye odaklanmıştır. Vikram, finans ve sigorta sektörü müşterilerine, makine öğrenimi uygulamalarını geniş ölçekte oluşturmak ve dağıtmak için tasarım ve düşünce liderliği konusunda yardımcı olur. Boş zamanlarında ailesiyle birlikte seyahat etmeyi, yürüyüş yapmayı, yemek yapmayı ve kamp yapmayı seviyor.

vikram elango Virginia, ABD merkezli AWS'de Kıdemli AIML Uzmanı Çözüm Mimarıdır. Şu anda üretken yapay zeka, LLM'ler, hızlı mühendislik, büyük model çıkarım optimizasyonu ve işletmeler genelinde makine öğrenimini ölçeklendirmeye odaklanmıştır. Vikram, finans ve sigorta sektörü müşterilerine, makine öğrenimi uygulamalarını geniş ölçekte oluşturmak ve dağıtmak için tasarım ve düşünce liderliği konusunda yardımcı olur. Boş zamanlarında ailesiyle birlikte seyahat etmeyi, yürüyüş yapmayı, yemek yapmayı ve kamp yapmayı seviyor.

Andrew Smith Sidney, Avustralya merkezli AWS'de SageMaker, Vision & Other ekibinde Bulut Destek Mühendisidir. Amazon SageMaker ile çalışma konusundaki uzmanlığıyla AWS'de birçok AI/ML hizmetini kullanan müşterileri destekler. İş dışında arkadaşları ve ailesiyle vakit geçirmekten ve farklı teknolojiler hakkında bilgi edinmekten keyif alıyor.

Andrew Smith Sidney, Avustralya merkezli AWS'de SageMaker, Vision & Other ekibinde Bulut Destek Mühendisidir. Amazon SageMaker ile çalışma konusundaki uzmanlığıyla AWS'de birçok AI/ML hizmetini kullanan müşterileri destekler. İş dışında arkadaşları ve ailesiyle vakit geçirmekten ve farklı teknolojiler hakkında bilgi edinmekten keyif alıyor.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- EVM Finans. Merkezi Olmayan Finans için Birleşik Arayüz. Buradan Erişin.

- Kuantum Medya Grubu. IR/PR Güçlendirilmiş. Buradan Erişin.

- PlatoAiStream. Web3 Veri Zekası. Bilgi Genişletildi. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/build-custom-chatbot-applications-using-openchatkit-models-on-amazon-sagemaker/

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- 1

- 10

- 100

- 11

- 14

- %15

- 17

- 195

- 20

- 2023

- 30

- 40

- 7

- 8

- a

- kabiliyet

- Yapabilmek

- Hakkımızda

- hızlandırmak

- erişim

- doğruluk

- tam olarak

- Başarmak

- karşısında

- Ek

- Ayrıca

- adres

- ileri

- Sonra

- sonradan

- karşı

- AI

- AI kullanım durumları

- AI / ML

- AIML

- hizalamak

- Türkiye

- Izin

- veriyor

- boyunca

- yanında

- Ayrıca

- Rağmen

- şaşırtıcı

- Amazon

- Amazon Adaçayı Yapıcı

- Amazon SageMaker Stüdyosu

- Amazon Web Servisleri

- an

- çözümlemek

- ve

- cevap

- cevaplar

- herhangi

- api

- API'ler

- Uygulama

- uygulamaları

- Tamam

- APT

- mimari

- arşiv

- ARE

- mal

- yapay

- yapay zeka

- AS

- ilişkili

- At

- augmented

- Avustralya

- otomatik olarak

- mevcut

- önlemek

- AWS

- baz

- merkezli

- Temel

- BE

- Çünkü

- müşterimiz

- olur

- önce

- olmak

- altında

- kıyaslama

- arasında

- önyargıları

- BIN

- Blokları

- vücut

- Bot

- her ikisi de

- inşa etmek

- bina

- yapılı

- yük

- iş

- İş Uygulamaları

- by

- çağrı

- CAN

- Kapasite

- karbon

- dava

- durumlarda

- CD

- yükler

- chatbot

- chatbots

- Kontrol

- sınıf

- sınıflar

- sınıflandırma

- sınıflandırmak

- kapalı

- bulut

- CO

- kod

- işbirliği

- topluluk

- Şirketler

- uyma

- bileşenler

- kapsamlı

- hesaplamak

- bilgisayar

- Bilgisayar görüşü

- bilgisayar

- Endişeler

- yapılandırma

- yapılandırılmış

- içermek

- Konteyner

- Konteynerler

- içeren

- içerik

- bağlam

- katkıda bulunmak

- kontrol

- kontroller

- konuşma

- konuşmaları

- uyan

- Ücret

- yaratmak

- çevrimiçi kurslar düzenliyorlar.

- oluşturur

- Oluşturma

- kriterleri

- akım

- Şu anda

- görenek

- Müşteriler

- özelleştirmek

- özelleştirilmiş

- veri

- veri kümeleri

- derin

- derin öğrenme

- tanımlı

- tanımlar

- tanımlarken

- derece

- talepleri

- Demokratikleştirilmesi

- göstermek

- tasviridir

- bağlıdır

- dağıtmak

- açılma

- Dizayn

- tasarlanmış

- ayrıntılar

- geliştiriciler

- gelişmeler

- Cihaz

- farklı

- zor

- zorluklar

- tartışmak

- tartışılan

- mesafe

- dağıtıldı

- Dağıtılmış bilgi işlem

- do

- liman işçisi

- belge

- belgeleme

- evraklar

- yok

- Değil

- domain

- etki

- Dont

- indir

- indirme

- sırasında

- dinamik

- her

- başka

- başka yerde

- katıştırma

- istihdam

- sağlar

- etkinleştirme

- teşvik

- Son nokta

- uygulamak

- Motor

- mühendis

- Mühendislik

- işletmelerin

- Tüm

- giriş

- gerekli

- törel

- hİÇ

- örnek

- mevcut

- beklediğini

- Uzmanlık

- uzantıları

- dış

- son derece

- Yüz

- aile

- Moda

- fileto

- dosyalar

- filtre

- süzme

- Nihayet

- mali

- finans haberleri

- finansal ürünler

- bulmak

- Ad

- bayraklı

- odaklanmış

- odaklanır

- odaklanma

- takip et

- takip etme

- şu

- İçin

- biçim

- Beslemek

- dört

- arkadaşlar

- itibaren

- tamamen

- işlevsellik

- genel amaçlı

- oluşturmak

- oluşturulan

- üretir

- nesil

- üretken

- üretken yapay zeka

- almak

- Git

- verilmiş

- Tercih Etmenizin

- GPU

- GPU'lar

- Kolları

- kullanma

- donanım

- Var

- he

- yardımcı olur

- Yüksek

- yüksek performans

- onun

- ev sahibi

- ev sahipliği yaptı

- hosting

- Ne kadar

- Nasıl Yapılır

- HTML

- http

- HTTPS

- SarılmaYüz

- insan

- ID

- belirlemek

- if

- göstermektedir

- görüntü

- görüntüleri

- uygulama

- uygular

- ithalat

- önem

- önemli

- iyileşme

- in

- dahil

- Dahil olmak üzere

- birleştirmek

- artan

- indeks

- belirtmek

- gösterir

- Endüstri

- sanayi

- bilgi

- Yenilikçilik

- giriş

- girişler

- içeride

- anlayışlar

- kurmak

- yüklü

- örnek

- talimatlar

- sigorta

- entegre

- İstihbarat

- etkileşimleri

- iç

- müdahale

- içine

- yatırım

- yatırım tavsiyeleri

- ilgili

- IT

- ONUN

- kendisi

- Java

- jpg

- json

- anahtar

- Bilmek

- bilgi

- Etiketler

- dil

- büyük

- Büyük işletmeler

- Gecikme

- Liderlik

- öğrenme

- en az

- Yasal Şartlar

- izin

- Kaldıraç

- kütüphaneler

- Kütüphane

- Lisans

- sevmek

- LİMİT

- Liste

- lama

- Yüksek Lisans

- yükler

- yerel

- yer

- mantık

- Çok

- Düşük

- makine

- makine öğrenme

- yapılmış

- Ana

- yapmak

- Yapımı

- çok

- Mart

- pazar

- piyasa hassasiyeti

- Pazar eğilimleri

- maske

- uygun

- Neden

- mesajları

- yöntemleri

- Metrikleri

- milyon

- ML

- model

- modelleri

- ılımlılık

- modül

- izlemek

- Daha

- çoklu

- isim

- Doğal (Madenden)

- Doğal Dil İşleme

- gerekli

- gerek

- gerekli

- ihtiyaçlar

- negatif

- haber

- gelecek nesil

- nlp

- yok hayır

- defter

- numara

- sayısız

- nesne

- nesneler

- engeller

- edinme

- of

- teklif

- on

- ONE

- bir tek

- açık kaynak

- optimum

- optimizasyon

- seçenek

- Opsiyonlar

- or

- kuruluşlar

- organizasyonlar

- OS

- Diğer

- dışarı

- çıktı

- dışında

- tekrar

- geçersiz kılma

- kendi

- paket

- paketlenmiş

- paketler

- pandalar

- kâğıtlar

- Paralel

- parametre

- parametreler

- Bölüm

- geçmek

- geçti

- Geçen

- yol

- model

- performans

- icra

- platform

- Platon

- Plato Veri Zekası

- PlatoVeri

- Nokta

- Popüler

- mümkün

- Çivi

- potansiyel

- powered

- güçlü

- tahmin

- Tahminler

- hazırlanması

- mevcut

- sundu

- önceki

- Anapara

- sorunlar

- süreç

- işleme

- üretmek

- Ürünler

- Programlama

- özellikleri

- sağlamak

- sağlanan

- sağlar

- sağlama

- amaç

- Itmek

- Python

- pytorch

- kalite

- soru

- Sorular

- menzil

- değişen

- Okuma

- nedenleri

- alır

- tavsiyeler

- Tavsiye edilen

- azaltarak

- ilgili

- serbest

- uygun

- kalıntılar

- dikkat çekici

- Raporlar

- Depo

- talep

- isteklerinizi

- gereklidir

- araştırma

- Araştırmacılar

- Kaynaklar

- yanıt

- yanıtları

- sorumlu

- DİNLENME

- kısıtlı

- sonuç

- Sonuçlar

- tutmak

- dönüş

- koşmak

- koşu

- Güvenlik

- sagemaker

- ölçek

- ölçekleme

- Ara

- arama

- Bölüm

- bölümler

- görmek

- göndermek

- gönderdi

- cümle

- duygu

- hizmet vermek

- vermektedir

- Hizmetler

- servis

- Oturum

- set

- ayar

- ayarlar

- meli

- şov

- Basit

- beri

- tek

- oldukça büyük

- beden

- Enstantane fotoğraf

- So

- çözüm

- Çözümler

- biraz

- sofistike

- Kaynak

- kaynaklar

- uzman

- özel

- özel

- Belirtilen

- hız

- Harcama

- başladı

- başlangıç

- Startups

- adım

- Basamaklar

- durdurma

- hafızası

- saklı

- mağaza

- depolamak

- dizi

- stüdyo

- Başarılı olarak

- böyle

- Çekiyor

- özetlemek

- Verilen

- tedarik

- destek

- Destekler

- sydney

- sistem

- tablo

- Görev

- görevleri

- takım

- teknikleri

- Teknolojileri

- Teknoloji

- o

- The

- Kaynak

- ve bazı Asya

- Onları

- sonra

- Orada.

- böylece

- bu nedenle

- Bunlar

- Re-Tweet

- düşünce

- düşünce liderliği

- verim

- zaman

- için

- birlikte

- simgeleþtirilmiþ

- araçlar

- eğitilmiş

- Eğitim

- Şeffaflık

- Seyahat

- Trendler

- gerçek

- döner

- iki

- tip

- altında

- anlamak

- benzersiz

- Evrensel

- kadar

- Güncelleme

- güncellenmiş

- Güncellemeler

- Yüklenen

- us

- kullanım

- kullanım durumu

- Kullanılmış

- kullanıcı

- kullanıcılar

- kullanım

- kullanma

- yarar

- değer

- çeşitli

- VİKUNA

- Virjinya

- vizyonumuz

- beklemek

- istemek

- we

- ağ

- web hizmetleri

- İYİ

- Ne

- ne zaman

- hangi

- geniş

- Geniş ürün yelpazesi

- Vikipedi

- irade

- ile

- olmadan

- İş

- işlenmiş

- işçi

- işçiler

- iş akışı

- iş akışları

- çalışma

- çalışır

- olur

- X

- Sen

- zefirnet