Розмовляйте майже з ким завгодно — тобто з будь-якою людиною — і ваша розмова зустрінеться з чим Маліхе Аліхані називає «здоровими тертями», моменти, коли ваша мета в розмові стикається з метою вашого партнера, моменти, які вимагають роз’яснення, викликають плутанину або призводять до розбіжностей.

Не так з великими мовними моделями.

Аліхані, доцент Коледжу комп’ютерних наук Хурі при Північно-східному університеті, каже, що великі мовні моделі, такі як ChatGPT, мають серйозну проблему з певністю.

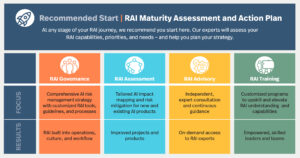

Новий проект Аліхані під назвою Friction for Accountability in Conversational Transactions (FACT) є результатом співпраці між Північно-східним університетом, Університетом Іллінойсу Урбана-Шампейн та Університетом Південної Каліфорнії.

Проект FACT, який фінансується за рахунок гранту на дослідження штучного інтелекту через Агентство перспективних оборонних досліджень, спрямований на розробку більш прозорих і справедливих інструментів штучного інтелекту.

«Одна з речей, яка робить людське спілкування плідним інструментом, — каже Аліхані, — це те, що ми виражаємо свою невпевненість у своїй промові, у своєму тоні. Ми передаємо це у свій вираз обличчя».

Здорові тертя, які виникають через невизначеність у спілкуванні між людьми, допомагають підтримувати різноманітність думок і точок зору, продовжує вона.

Але великі мовні моделі (або LLM) не зацікавлені у вираженні своєї невизначеності, що призводить до того, що Аліхані називає «підлабузницькою поведінкою». Великі мовні моделі «бажають максимізувати задоволення» своїх користувачів, каже вона, і «ніколи не створюють ніяких суперечок у розмові, незалежно від того, впевнена [модель]» у своїх твердженнях чи ні.

Додаткові проблеми виникають із великими моделями мови через їх схильність до галюцинацій. LLM «вигадують факти. Вони дуже добре вміють переконувати людей у вигаданих фактах».

Незважаючи на ці проблеми, Аліхані також каже, що люди схильні надмірно покладатися на «факти», створені цими моделями штучного інтелекту, які «можуть вигадати факти, щоб зробити вас щасливими».

Частково через те, що користувачі надмірно покладаються на LLM, є їхня «людська поведінка», каже вона. «Це буде маніпулювати нашим пізнанням».

Здається, що великі мовні моделі видають свої відповіді миттєво, що є ще одним фактором, який змушує користувачів вважати правильними. «Нам, вченим штучного інтелекту, важко сказати людям: «Так, це узгоджено. Так, це швидко. Так, це налаштовується на ваш стиль. Але це галюцинація», — каже Аліхані.

У рамках свого нового гранту Аліхані та її команда розроблять інструменти, які демонструватимуть рівні впевненості, які має LLM щодо своїх заяв, і впровадять здорові суперечки в розмову між людиною та ШІ.

«Як ми можемо передбачити та вербалізувати довіру системи?» — запитує Аліхані. Якщо модель штучного інтелекту «лише на 2% впевнена, вона повинна висвітлити це».

«Одна з головних цілей дослідження — змоделювати невизначеність, вивести невизначеність назовні» та навчити магістрів, як зобразити цю невизначеність у розмові між людиною та ШІ. Це може відображатися в інтерфейсі користувача як процентний бал достовірності моделі, або модель може відображати невизначеність у своїх відповідях більш схожим на людину способом.

Наприклад, Аліхані уявляє ситуацію, в якій пацієнт може задати великій мовній моделі запитання про своє здоров’я. Поточне покоління магістрів права намагатиметься дати відповідь, навіть якщо ця відповідь може виявитися небезпечною. Аліхані сподівається створити моделі, які зможуть сказати: «Я не знаю. Ви повинні покликати свою медсестру».

«Надійність є ключем до підзвітності в ШІ», — каже Аліхані. На даний момент LLM зазвичай відповідає однією відповіддю на запит під час запиту та зовсім іншою відповіддю через кілька хвилин.

Коли йдеться про розробку безпечного та підзвітного штучного інтелекту, попередні системи штучного інтелекту, які могли б допомогти у виконанні простих завдань, «не мали доступу до купи інших наборів даних, — каже Аліхані, — і вони не могли сказати речі, які могли б бути небезпечними. , оскільки цього не було в їхніх даних».

Саме те, що ці набори даних включають або виключають, є ключовим для подолання упереджень, які LLM демонструють щодо «гендерних, але також тонких упереджень, таких як протилежні сторонні групи та різні когнітивні упередження, які відображені в [великих мовних] моделях».

Тепер Аліхані сподівається розробити моделі, які обслуговуватимуть людей із «різними можливостями та вподобаннями», — каже вона.

«Ми не хочемо просто продовжувати будувати системи для населення, для якого маємо дані, але ми думаємо про те, кого ми залишаємо позаду, і як ми можемо зупинити цю величезну прірву нерівності, а не погіршувати її?» — запитує вона. «Мета моєї лабораторії — рухатися в цьому напрямку».

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://www.mtlc.co/large-language-models-can-lie-to-you-this-professor-wants-you-to-know-when-they-do/

- :є

- : ні

- :де

- $UP

- 2%

- a

- МЕНЮ

- доступ

- підзвітність

- підзвітний

- просунутий

- проти

- агентство

- AI

- Системи ШІ

- Цілі

- майже

- Також

- an

- та

- Інший

- відповідь

- будь-який

- будь

- з'являтися

- ЕСТЬ

- виникати

- штучний

- штучний інтелект

- AS

- запитати

- запитувач

- Помічник

- припустити

- At

- BE

- оскільки

- поведінки

- за

- між

- упередження

- обидва

- будувати

- Створюємо

- гроно

- але

- by

- Каліфорнія

- call

- званий

- Виклики

- CAN

- впевненість

- ChatGPT

- пізнання

- пізнавальний

- КОГЕРЕНТНИЙ

- співробітництво

- коледж

- приходить

- загальний

- Комунікація

- повністю

- комп'ютер

- довіра

- впевнений

- замішання

- триває

- сприяє

- Розмова

- діалоговий

- розмови

- Рада

- Поточний

- Небезпечний

- дані

- набори даних

- оборони

- демонструвати

- дизайн

- проектування

- розвивати

- різний

- напрям

- дисплей

- різноманітність

- do

- Не знаю

- зіткнення

- справедливим

- Навіть

- дослідження

- висловлюючи

- вираз

- лицьової

- факт

- фактор

- Факти

- ШВИДКО

- кілька

- для

- тертя

- від

- плідний

- розрив

- генерується

- покоління

- мета

- Цілі

- добре

- надавати

- щасливий

- Жорсткий

- Мати

- здоров'я

- здоровий

- допомога

- її

- тримає

- сподівається,

- Як

- How To

- HTTPS

- величезний

- людина

- Людей

- if

- Іллінойс

- уявляє

- in

- включати

- нерівність

- екземпляр

- миттєво

- замість

- Інтелект

- зацікавлений

- інтерфейс

- в

- вводити

- питання

- IT

- ЙОГО

- просто

- тримати

- ключ

- Знати

- lab

- мова

- великий

- пізніше

- вести

- Керівництво

- догляд

- рівні

- брехня

- як

- LLM

- made

- головний

- підтримувати

- зробити

- РОБОТИ

- Робить

- Маса

- Максимізувати

- може бути

- хвилин

- модель

- Моделі

- момент

- Моменти

- більше

- рухатися

- my

- Нові

- Північно-східний університет

- of

- on

- ONE

- Думки

- or

- Інше

- наші

- з

- над

- подолання

- пацієнт

- Люди

- plato

- Інформація про дані Платона

- PlatoData

- населення

- передбачати

- переваги

- попередній

- Проблема

- проблеми

- виробляти

- Професор

- проект

- забезпечувати

- put

- запит

- питання

- відображати

- відображено

- покладаючись

- представляти

- вимагати

- дослідження

- Реагувати

- відповіді

- в результаті

- сейф

- say

- говорить

- НАУКИ

- Вчені

- рахунок

- здається

- серйозний

- обслуговування

- вона

- Повинен

- простий

- ситуація

- So

- Південний

- мова

- Заява

- заяви

- Стоп

- стиль

- такі

- система

- Systems

- завдання

- команда

- технології

- сказати

- тенденція

- Що

- Команда

- їх

- Ці

- вони

- речі

- думати

- це

- ті

- через

- час

- до

- TONE

- інструмент

- інструменти

- до

- до

- Transactions

- прозорий

- намагатися

- настройка

- ПЕРЕГЛЯД

- Невизначеність

- університет

- us

- користувач

- користувачі

- Проти

- дуже

- точки зору

- хотіти

- хоче

- було

- шлях..

- we

- Що

- коли

- Чи

- який

- ВООЗ

- волі

- з

- в

- гірше

- так

- Ти

- вашу

- зефірнет