Моделі генеративної мови виявилися надзвичайно вправними у вирішенні завдань логічної та аналітичної обробки природної мови (NLP). Крім того, використання оперативне проектування можуть значно підвищити їх продуктивність. Наприклад, ланцюг думок (CoT), як відомо, покращує здатність моделі розв’язувати складні багатокрокові проблеми. Щоб додатково підвищити точність завдань, які включають міркування, a самоузгодженість Було запропоновано підхід підказки, який замінює жадібне на стохастичне декодування під час генерації мови.

Amazon Bedrock це повністю керований сервіс, який пропонує вибір високопродуктивних базових моделей від провідних компаній штучного інтелекту та Amazon через єдиний API, а також широкий набір можливостей для створення генеративний ШІ програми з безпекою, конфіденційністю та відповідальним ШІ. З пакетний висновок API, ви можете використовувати Amazon Bedrock, щоб виконувати висновки з базовими моделями в пакетах і отримувати відповіді більш ефективно. У цьому дописі показано, як реалізувати підказки самоузгодженості за допомогою пакетного висновку на Amazon Bedrock, щоб підвищити продуктивність моделі в арифметичних завданнях і завданнях із множинним вибором.

Огляд рішення

Підказка щодо самоузгодженості мовних моделей базується на генеруванні кількох відповідей, які об’єднуються в остаточну відповідь. На відміну від підходів одного покоління, таких як CoT, процедура самоузгодженості вибірки та маргіналізації створює низку доповнень моделі, що призводить до більш узгодженого рішення. Генерація різних відповідей на задану підказку можлива завдяки використанню стохастичної, а не жадібної стратегії декодування.

На наступному малюнку показано, чим самоузгодженість відрізняється від жадібного CoT тим, що вона генерує різноманітний набір шляхів міркування та агрегує їх для отримання остаточної відповіді.

Стратегії декодування для генерації тексту

Текст, створений мовними моделями лише для декодера, розгортається слово за словом, а наступний токен передбачається на основі попереднього контексту. Для заданого запиту модель обчислює розподіл ймовірностей, що вказує ймовірність того, що кожен маркер з’явиться наступним у послідовності. Декодування передбачає переклад цих розподілів ймовірностей у фактичний текст. Генерація тексту опосередковується набором параметри висновку які часто є гіперпараметрами самого методу декодування. Одним із прикладів є температура, який модулює розподіл ймовірностей наступного токена та впливає на випадковість виходу моделі.

Жадібне розшифровка це детермінована стратегія декодування, яка на кожному кроці вибирає маркер із найвищою ймовірністю. Незважаючи на те, що підхід є простим і ефективним, він ризикує впасти в повторювані шаблони, оскільки він не враховує ширший простір ймовірностей. Встановлення параметра температури на 0 під час висновку по суті прирівнюється до реалізації жадібного декодування.

Вибірка вводить стохастичність у процес декодування шляхом випадкового вибору кожного наступного токена на основі передбаченого розподілу ймовірностей. Ця випадковість призводить до більшої мінливості виходу. Стохастичне декодування виявляється більш вправним у захопленні різноманітності потенційних результатів і часто дає більш творчі відповіді. Вищі значення температури викликають більше коливань і підвищують креативність реакції моделі.

Методи підказки: CoT і самоузгодженість

Здатність міркувати мовних моделей можна розширити за допомогою оперативного проектування. Зокрема, було показано, що CoT викликати міркування в комплексних завданнях НЛП. Один із способів реалізації a нульовий постріл CoT – це швидке розширення з інструкцією «думати крок за кроком». Інший полягає в тому, щоб представити модель зразкам проміжних кроків міркування кілька пострілів підказки мода. Обидва сценарії зазвичай використовують жадібне декодування. CoT веде до значного підвищення продуктивності порівняно з простими інструкціями підказок для арифметичних, здорового глузду та символічних завдань.

Спонукання до самоузгодженості ґрунтується на припущенні, що введення різноманітності в процес міркування може бути корисним, щоб допомогти моделям сходитися до правильної відповіді. Методика використовує стохастичне декодування для досягнення цієї мети в три етапи:

- Підкажіть мовну модель за допомогою зразків CoT, щоб викликати міркування.

- Замініть жадібне декодування стратегією вибірки, щоб створити різноманітний набір шляхів міркування.

- Об’єднайте результати, щоб знайти найбільш послідовну відповідь у наборі відповідей.

Показано, що самоузгодженість перевершує підказки CoT на популярних тестах арифметики та здорового глузду. Обмеженням підходу є його більша обчислювальна вартість.

У цьому дописі показано, як підказки самоузгодженості покращують продуктивність генеративних мовних моделей у двох завданнях НЛП: розв’язування арифметичних задач і відповіді на предметно-специфічні питання з множинним вибором. Ми демонструємо підхід за допомогою пакетного висновку на Amazon Bedrock:

- Ми отримуємо доступ до Amazon Bedrock Python SDK у JupyterLab на Amazon SageMaker примірник ноутбука.

- Для арифметичних міркувань підказуємо Команда Cohere на набір даних GSM8K для завдань з математики початкової школи.

- Для міркування з вибором варіантів ми пропонуємо AI21 Labs Jurassic-2 Mid на невеликій вибірці запитань іспиту AWS Certified Solutions Architect – Associate.

Передумови

Це покрокове керівництво передбачає наступні передумови:

Орієнтовна вартість запуску коду, показаного в цій публікації, становить 100 доларів США, припускаючи, що ви запускаєте підказку самоузгодженості один раз із 30 шляхами міркування з використанням одного значення для вибірки на основі температури.

Набір даних для дослідження можливостей арифметичного міркування

GSM8K це набір даних математичних задач початкової школи, зібраних людиною, які відрізняються високою мовною різноманітністю. Розв’язування кожної задачі складається з 2–8 кроків і вимагає виконання послідовності елементарних обчислень з елементарними арифметичними діями. Ці дані зазвичай використовуються для порівняння можливостей багатокрокових арифметичних міркувань генеративних мовних моделей. The Комплект поїзда GSM8K містить 7,473 записи. Ось приклад:

{"question": "Natalia sold clips to 48 of her friends in April, and then she sold half as many clips in May. How many clips did Natalia sell altogether in April and May?", "answer": "Natalia sold 48/2 = <<48/2=24>>24 clips in May.nNatalia sold 48+24 = <<48+24=72>>72 clips altogether in April and May.n#### 72"}

Налаштуйте пакетний аналіз за допомогою Amazon Bedrock

Пакетний висновок дозволяє асинхронно запускати кілька викликів висновків до Amazon Bedrock і покращувати продуктивність моделювання на великих наборах даних. На момент написання цієї статті служба доступна лише через API. Відноситься до Запустити пакетний висновок для доступу до API пакетного висновку через користувацькі SDK.

Після того, як ви завантажили та розпакували архів Python SDK в екземплярі блокнота SageMaker ви можете встановити його, запустивши такий код у комірці блокнота Jupyter:

Відформатуйте та завантажте вхідні дані в Amazon S3

Вхідні дані для пакетного висновку потрібно підготувати у форматі JSONL recordId та modelInput ключі. Останнє має збігатися з полем тіла моделі, яка буде викликана на Amazon Bedrock. Зокрема, деякі підтримувані параметри виведення для Cohere Command він має temperature для випадковості, max_tokens для вихідної довжини, а num_generations для створення кількох відповідей, усі з яких передаються разом із prompt as modelInput:

Читати Параметри висновку для моделей основи для отримання додаткової інформації, включаючи інших постачальників моделей.

Наші експерименти з арифметичних міркувань виконуються за кілька етапів без налаштування чи тонкого налаштування Cohere Command. Ми використовуємо той самий набір із восьми невеликих прикладів із ланцюжка думок (Таблиця 20) та самоузгодженості (Таблиця 17) папери. Підказки створюються шляхом об’єднання зразків із кожним запитанням із набору поїздів GSM8K.

Ми ставимо max_tokens до 512 і num_generations до 5, максимум, дозволений командою Cohere. Для жадібного декодування встановлюємо temperature до 0 і для самоузгодженості ми проводимо три експерименти за температур 0.5, 0.7 та 1. Кожне налаштування дає різні вхідні дані відповідно до відповідних значень температури. Дані відформатовано як JSONL і зберігаються в Amazon S3.

Створюйте та запускайте завдання пакетного висновку в Amazon Bedrock

Для створення завдань пакетного висновку потрібен клієнт Amazon Bedrock. Ми визначаємо шляхи введення та виведення S3 і надаємо кожному завданню виклику унікальне ім’я:

Робота є створений передаючи роль IAM, ідентифікатор моделі, назву завдання та конфігурацію вводу/виводу як параметри до API Amazon Bedrock:

Listing, моніторинг та зупинка завдання пакетного висновку підтримуються відповідними викликами API. Під час створення робочі місця з’являються спочатку як Submitted, то як InProgress, і нарешті як Stopped, Failedабо Completed.

Якщо завдання успішно виконано, згенерований вміст можна буде отримати з Amazon S3, використовуючи його унікальне місце виведення.

[Out]: 'Natalia sold 48 * 1/2 = 24 clips less in May. This means she sold 48 + 24 = 72 clips in April and May. The answer is 72.'

Самоузгодженість підвищує точність моделі в арифметичних завданнях

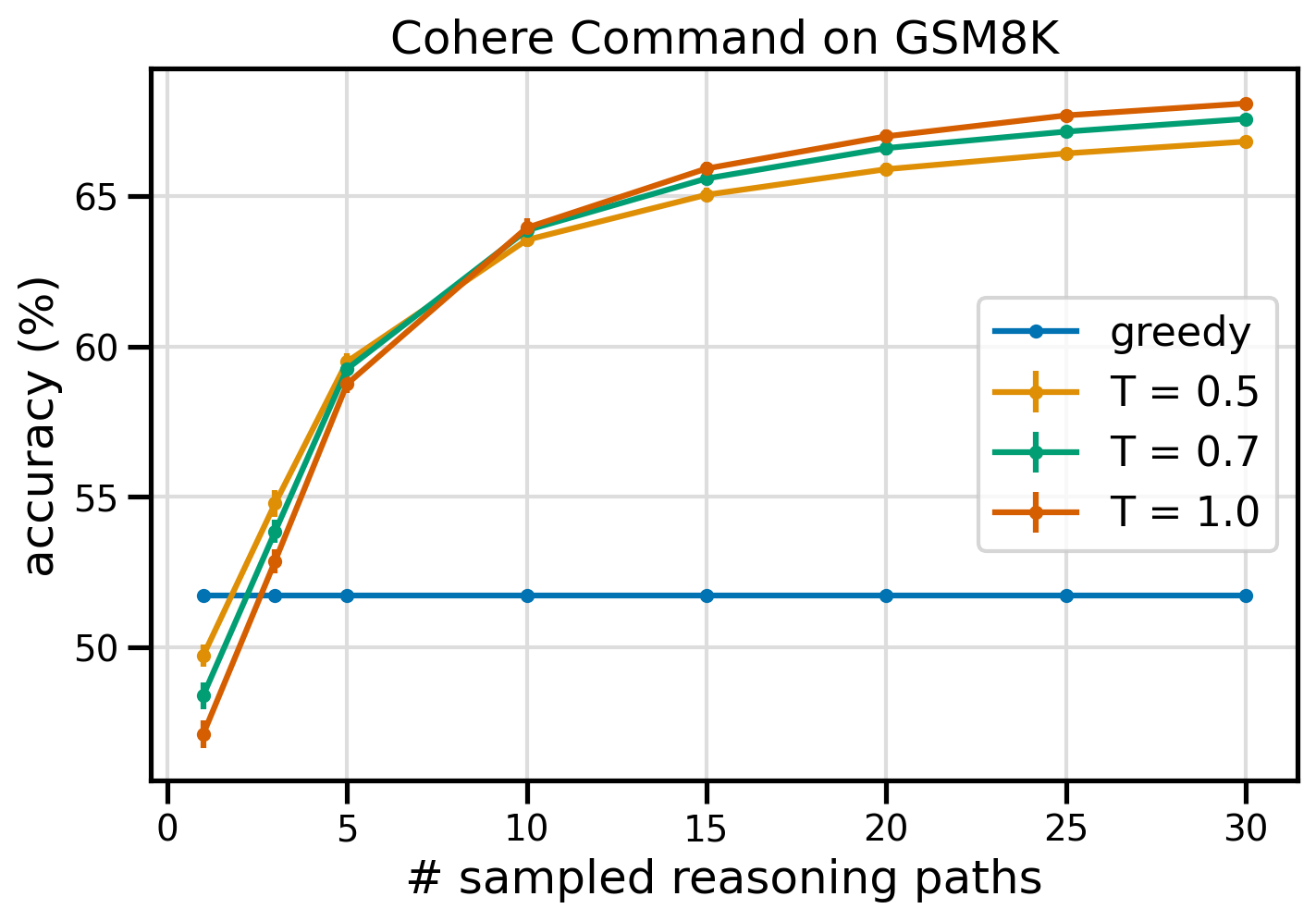

Підказка самоузгодженості Cohere Command перевершує жадібну базову лінію CoT з точки зору точності набору даних GSM8K. Для самоузгодженості ми вибираємо 30 незалежних шляхів міркування при трьох різних температурах, з topP та topK встановити їх значення за замовчуванням. Остаточні рішення агрегуються шляхом вибору найбільш узгодженого випадку шляхом голосування більшістю. У разі рівності ми випадковим чином обираємо одну з більшості відповідей. Ми обчислюємо значення точності та стандартного відхилення, усереднені за 100 прогонів.

На наступному малюнку показано точність набору даних GSM8K від Cohere Command із підказкою жадібного CoT (синій) і самоузгодженості при значеннях температури 0.5 (жовтий), 0.7 (зелений) і 1.0 (помаранчевий) як функцію кількості вибірок. шляхи міркування.

На попередньому малюнку показано, що самоузгодженість підвищує арифметичну точність порівняно з жадібним CoT, коли кількість вибіркових шляхів становить лише три. Ефективність зростає відповідно до подальших шляхів міркування, підтверджуючи важливість впровадження різноманітності в генерацію думок. Cohere Command розв’язує набір запитань GSM8K із точністю 51.7% за підказкою CoT проти 68% із 30 самоузгодженими шляхами міркування при T=1.0. Усі три досліджувані значення температури дають подібні результати, причому нижчі температури є порівняно ефективнішими на менш вибіркових шляхах.

Практичні міркування щодо ефективності та вартості

Самоузгодженість обмежена збільшеним часом відповіді та витратами, понесеними під час генерування кількох виходів на підказку. Як практична ілюстрація, пакетний висновок для жадібної генерації за допомогою Cohere Command на 7,473 записах GSM8K завершився менш ніж за 20 хвилин. Робота взяла 5.5 мільйонів токенів як вхідні дані та згенерувала 630,000 XNUMX вихідних токенів. При струмі Висновки про ціни Amazon Bedrock, загальна сума понесених витрат склала близько 9.50 доларів США.

Для самоузгодженості з командою Cohere ми використовуємо параметр висновку num_generations щоб створити декілька доповнень на підказку. На момент написання цієї статті Amazon Bedrock допускає максимум п’ять поколінь і три одночасних Submitted завдання пакетного висновку. Роботи переходити до InProgress статус послідовно, тому вибірка більше ніж п'яти шляхів потребує кількох викликів.

На наступному малюнку показано час виконання для Cohere Command на наборі даних GSM8K. Загальний час виконання відображається на осі x, а час виконання для вибіркового шляху міркування – на осі y. Жадібна генерація виконується за найкоротший час, але потребує вищих витрат часу на вибірковий шлях.

Greedy Generation завершується менш ніж за 20 хвилин для повного набору GSM8K і демонструє унікальний шлях міркування. Для самоузгодженості з п’ятьма зразками потрібно приблизно на 50% більше часу та коштує приблизно 14.50 доларів США, але за цей час створюється п’ять шляхів (понад 500%). Загальний час роботи та вартість поступово збільшуються з кожними додатковими п’ятьма вибірками. Аналіз витрат і вигод припускає, що 1–2 завдання пакетного висновку з 5–10 вибірковими шляхами є рекомендованим налаштуванням для практичної реалізації самоузгодженості. Завдяки цьому досягається покращена продуктивність моделі, утримуючи вартість і затримку.

Самоузгодженість покращує продуктивність моделі за межі арифметичного міркування

Вирішальне питання для доведення придатності підказки самоузгодженості полягає в тому, чи успішний метод у подальших завданнях НЛП і мовних моделях. Як розширення сценарію використання, пов’язаного з Amazon, ми виконуємо невеликий аналіз зразків запитань із Сертифікація асоційованого архітектора AWS Solutions. Це іспит із множинним варіантом відповіді з технологій і послуг AWS, який потребує знання предметної галузі та вміння міркувати та вибирати між кількома варіантами.

Ми готуємо набір даних з SAA-C01 та SAA-C03 зразки екзаменаційних питань. З 20 доступних запитань ми використовуємо перші 4 як кілька прикладів і пропонуємо моделі відповісти на решту 16. Цього разу ми запускаємо висновок за допомогою моделі AI21 Labs Jurassic-2 Mid і генеруємо максимум 10 шляхів міркування на температура 0.7. Результати показують, що самоузгодженість покращує продуктивність: хоча жадібний CoT дає 11 правильних відповідей, самоузгодженість вдається ще на 2.

У наведеній нижче таблиці показано результати точності для 5 і 10 вибіркових шляхів, усереднені за 100 прогонів.

| . | Жадібне розшифровка | T = 0.7 |

| # вибіркових шляхів: 5 | 68.6 | 74.1 0.7 ± |

| # вибіркових шляхів: 10 | 68.6 | 78.9 ± 0.3 |

У наведеній нижче таблиці ми представляємо два екзаменаційні запитання, на які жадібний CoT дає неправильні відповіді, хоча самоузгодженість досягає успіху, висвітлюючи в кожному випадку правильні (зеленим) або неправильні (червоним) міркування, які спонукали модель дати правильні чи неправильні відповіді. Хоча не кожен вибірковий шлях, згенерований самоузгодженістю, є правильним, більшість збігається з істинною відповіддю, оскільки кількість вибіркових шляхів збільшується. Ми спостерігаємо, що зазвичай достатньо 5–10 шляхів, щоб покращити жадібні результати зі зменшенням ефективності, що перевищує ці значення.

| Питання |

Веб-додаток дозволяє клієнтам завантажувати замовлення в сегмент S3. Отримані події Amazon S3 запускають функцію Lambda, яка вставляє повідомлення до черги SQS. Один екземпляр EC2 читає повідомлення з черги, обробляє їх і зберігає в таблиці DynamoDB, розділеної за унікальним ідентифікатором порядку. Очікується, що наступного місяця трафік зросте в 10 разів, і архітектор рішень переглядає архітектуру на предмет можливих проблем із масштабуванням. Який компонент НАЙБІЛЬШ вірогідно потребуватиме зміни архітектури, щоб мати можливість масштабуватись для розміщення нового трафіку? А. Лямбда-функція |

Програма, що працює на AWS, використовує для своєї бази даних розгортання кластера Amazon Aurora Multi-AZ DB. Оцінюючи показники продуктивності, архітектор рішень виявив, що зчитування бази даних спричиняє високий обсяг введення-виведення та додає затримку запитам на запис до бази даних. Що повинен зробити архітектор рішень, щоб відокремити запити на читання від запитів на запис? A. Увімкніть наскрізне кешування бази даних Aurora. |

| Правильна відповідь | C – Один екземпляр EC2 не буде масштабуватися і є єдиною точкою відмови в архітектурі. Набагато кращим рішенням було б, щоб екземпляри EC2 у групі автоматичного масштабування в 2 зонах доступності читали повідомлення з черги. Усі інші відповіді — це керовані служби, які можна налаштувати на масштабування або масштабуватимуться автоматично. | C – Репліки Aurora забезпечують спосіб розвантажити трафік читання. Репліки Aurora використовують те саме базове сховище, що й основна база даних, тому час затримки зазвичай дуже малий. Репліки Aurora мають власні кінцеві точки, тому програму потрібно буде налаштувати для спрямування трафіку читання на нові кінцеві точки. |

| Жадібне розшифровка | Безпосереднє масштабування екземпляра EC2 може бути неможливим, оскільки неможливо змінити розмір екземпляра. Масштабування лямбда-функції може бути недостатнім, оскільки функції Lambda мають ліміт виділення пам’яті 6 ГБ. Масштабування черги SQS може бути недостатнім, оскільки SQS має обмеження на 10,000 XNUMX повідомлень. Таблиці DynamoDB можна масштабувати шляхом надання більшої кількості одиниць ємності. Правильна відповідь Д. | Зміна програми для читання з резервного екземпляра Multi-AZ (варіант B) є найкращим підходом. Резервний екземпляр асинхронно реплікується з основного екземпляра, тому операції читання не заважатимуть операціям запису. Увімкнення наскрізного кешування (варіант A) або створення репліки Aurora (варіант C) не вирішить проблему конфлікту вводу/виводу. Створення другої бази даних Aurora та зв’язування її як репліки для читання (варіант D) також не вирішить проблему конфлікту вводу-виводу. Правильна відповідь Б. |

| Зразок шляху №1 | Масштабування екземпляра EC2 у 10 разів більше поточного розміру може бути неможливим з точки зору вартості чи продуктивності. Для цього знадобиться більший екземпляр, який може бути дорогим. Більш економічно ефективним підходом може бути використання групи менших екземплярів (наприклад, Auto Scaling Group) для розподілу навантаження. У цьому випадку примірник EC2, ймовірно, потребуватиме перебудови. Правильна відповідь C. | Модифікація програми для використання відповідних кінцевих точок не є практичним рішенням, оскільки це вимагатиме змін у коді програми. Правильна відповідь: C: Створіть копію Aurora та змініть програму для використання відповідних кінцевих точок. |

| Зразок шляху №2 | Масштабувати один екземпляр EC2 складніше й проблематичніше, ніж масштабувати інші компоненти служби. Amazon SQS, Lambda та DynamoDB можуть автоматично масштабуватися впоратися з підвищеним навантаженням. Правильна відповідь C. |

(С) Створіть репліку Aurora та змініть програму для використання відповідних кінцевих точок. Налаштувавши репліку Aurora, ви можете відокремити трафік читання від трафіку запису. Репліки Aurora використовують різні URL-адреси кінцевих точок, що дозволяє спрямувати трафік читання до репліки замість основної бази даних. Репліка може обробляти запити на читання паралельно із запитами на запис до основної бази даних, зменшуючи введення-виведення та затримку. |

Прибирати

За виконання пакетного аналізу в Amazon Bedrock стягується плата згідно з цінами Amazon Bedrock. Виконавши покрокове керівництво, видаліть свій екземпляр блокнота SageMaker і видаліть усі дані з сегментів S3, щоб уникнути стягнення плати в майбутньому.

Міркування

Незважаючи на те, що продемонстроване рішення показує покращену продуктивність мовних моделей, коли запитується з самоузгодженістю, важливо зазначити, що покрокове керівництво не готове до виробництва. Перед розгортанням у виробництві вам слід адаптувати це підтвердження концепції до власної реалізації, пам’ятаючи про такі вимоги:

- Обмеження доступу до API і баз даних для запобігання несанкціонованому використанню.

- Дотримання найкращих практик безпеки AWS щодо доступу до ролей IAM і груп безпеки.

- Перевірка та дезінфекція введених користувачем даних для запобігання атакам швидкого впровадження.

- Моніторинг і журналювання запущених процесів для тестування та аудиту.

Висновок

У цьому дописі показано, що підказки самоузгодженості покращують ефективність генеративних мовних моделей у складних завданнях НЛП, які вимагають арифметичних і логічних навичок із множинним вибором. Самоузгодженість використовує стохастичне декодування на основі температури для створення різних шляхів міркування. Це збільшує здатність моделі виявляти різноманітні та корисні думки для отримання правильних відповідей.

За допомогою пакетного висновку Amazon Bedrock мовна модель Cohere Command отримує запит на створення самоузгоджених відповідей на набір арифметичних задач. Точність покращується з 51.7% при жадібному декодуванні до 68% при самоузгодженій вибірці 30 шляхів міркування при T=1.0. Вибірка п’яти шляхів вже підвищує точність на 7.5 відсотка. Цей підхід можна перенести на інші мовні моделі та завдання на міркування, як продемонстрували результати моделі AI21 Labs Jurassic-2 Mid на сертифікаційному іспиті AWS. У невеликому наборі питань самоузгодженість із п’ятьма відібраними шляхами підвищує точність на 5 відсотків порівняно з жадібним CoT.

Ми заохочуємо вас реалізувати запит самоузгодженості для підвищення продуктивності у ваших власних програмах за допомогою генеративних мовних моделей. Дізнайтеся більше про Команда Cohere та AI21 Labs Юрський період моделі доступні на Amazon Bedrock. Щоб отримати додаткові відомості про пакетний висновок, див Запустити пакетний висновок.

Подяки

Автор дякує технічним рецензентам Аміну Таджгардуну та Патріку МакСвіні за корисні відгуки.

Про автора

Люсія Сантамарія є старшим прикладним науковцем в Університеті машинного навчання Amazon, де вона зосереджена на підвищенні рівня компетентності в галузі машинного навчання в компанії за допомогою практичного навчання. Лусія має ступінь доктора філософії з астрофізики та пристрасно прагне демократизувати доступ до технічних знань та інструментів.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/enhance-performance-of-generative-language-models-with-self-consistency-prompting-on-amazon-bedrock/

- : має

- :є

- : ні

- :де

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 15%

- 150

- 16

- 19

- 20

- 24

- 25

- 30

- 33

- 50

- 51

- 7

- 72

- 8

- a

- здатність

- Здатний

- МЕНЮ

- доступ

- розмістити

- За

- точність

- Achieve

- Досягає

- через

- фактичний

- пристосовувати

- додати

- Додатково

- adept

- проти

- агреговані

- агрегати

- AI

- ВСІ

- розподіл

- дозволено

- Дозволити

- дозволяє

- по

- вже

- хоча

- взагалі

- Amazon

- Amazon Web Services

- серед

- an

- аналіз

- Аналітичний

- та

- Інший

- відповідь

- відповідь

- Відповіді

- API

- Інтерфейси

- з'являтися

- додаток

- застосування

- прикладної

- підхід

- підходи

- відповідний

- квітня

- архітектура

- ЕСТЬ

- навколо

- AS

- Юрист

- передбачає

- припущення

- At

- нападки

- аудит

- збільшено

- Аврора

- автор

- автоматичний

- автоматично

- наявність

- доступний

- уникнути

- AWS

- Вісь

- заснований

- Базова лінія

- основний

- основа

- затока

- BE

- оскільки

- було

- перед тим

- буття

- еталонний тест

- тести

- корисний

- КРАЩЕ

- передового досвіду

- Краще

- між

- За

- синій

- тіло

- підвищення

- обидва

- широкий

- ширше

- будувати

- але

- by

- кешування

- розрахунки

- Виклики

- CAN

- можливості

- потужність

- захопивши

- випадок

- викликаючи

- осередок

- сертифікація

- Сертифікований

- Зміни

- вантажі

- вибір

- Вибирати

- Вибираючи

- клієнт

- кліпси

- кластер

- код

- зазвичай

- Компанії

- компанія

- порівняльно

- порівняний

- повний

- Завершує

- комплекс

- компонент

- Компоненти

- включає

- обчислювальна

- обчислення

- концепція

- одночасно

- конфігурація

- налаштувати

- конфігурування

- міркування

- послідовний

- послідовно

- зміст

- контекст

- контрастність

- сходяться

- виправити

- Коштувати

- рентабельним

- витрати

- створювати

- створений

- створює

- створення

- створення

- креативність

- вирішальне значення

- Поточний

- виготовлений на замовлення

- Клієнти

- дані

- Database

- базами даних

- набори даних

- вирішувати

- Декодування

- Демократизувати

- демонструвати

- продемонстрований

- розгортання

- розгортання

- деталі

- відхилення

- DID

- Відмінності

- різний

- важкий

- зменшується

- прямий

- безпосередньо

- відкритий

- розподіл

- Розподілу

- Різне

- різноманітність

- do

- домен

- Завантажений

- два

- під час

- e

- кожен

- Освіта

- ефективність

- ефективний

- продуктивно

- вісім

- або

- включіть

- дозволяє

- заохочувати

- Кінцева точка

- Машинобудування

- підвищувати

- підвищена

- Підсилює

- досить

- прирівнює

- по суті

- оцінка

- оцінки

- Події

- Кожен

- іспит

- приклад

- очікуваний

- дорогий

- Експерименти

- розширення

- додатково

- фактор

- Провал

- Падіння

- мода

- реально

- Показуючи

- зворотний зв'язок

- поле

- Рисунок

- філе

- остаточний

- в кінці кінців

- знайти

- Перший

- п'ять

- коливання

- увагу

- після

- для

- формат

- фонд

- друзі

- від

- Повний

- повністю

- функція

- Функції

- далі

- Крім того

- майбутнє

- прибуток

- в цілому

- породжувати

- генерується

- генерує

- породжує

- покоління

- покоління

- генеративний

- отримати

- GitHub

- Давати

- даний

- мета

- клас

- великий

- Жадібний

- зелений

- Group

- Групи

- Половина

- практичний

- Мати

- голова

- допомога

- корисний

- її

- Високий

- високопродуктивний

- вище

- найвищий

- виділивши

- Як

- How To

- HTML

- HTTPS

- ID

- здійснювати

- реалізація

- реалізації

- значення

- важливо

- удосконалювати

- поліпшений

- поліпшується

- in

- У тому числі

- неправильний

- невірно

- Augmenter

- збільшений

- Збільшує

- понесені

- незалежний

- вказуючи

- інформація

- вхід

- Вставки

- встановлювати

- екземпляр

- замість

- втручатися

- в

- вводити

- Вводить

- введення

- викликали

- залучати

- включає в себе

- питання

- IT

- ЙОГО

- сам

- робота

- Джобс

- json

- зберігання

- ключ

- ключі

- знання

- відомий

- Labs

- мова

- великий

- більше

- Затримка

- вести

- провідний

- Веде за собою

- УЧИТЬСЯ

- Led

- довжина

- менше

- рівень

- як

- ймовірність

- Ймовірно

- МЕЖА

- обмеження

- обмеженою

- ліній

- LINK

- Зв'язуючий

- загрузка

- розташування

- каротаж

- логічний

- довше

- низький

- знизити

- головний

- Більшість

- управляти

- вдалося

- багато

- матч

- математики

- максимальний

- Може..

- засоби

- пам'ять

- повідомлення

- повідомлення

- метод

- Метрика

- В середині

- може бути

- мільйона

- mind

- хвилин

- ML

- модель

- Моделі

- змінювати

- місяць

- більше

- найбільш

- багато

- множинний

- ім'я

- Природний

- Обробка природних мов

- Необхідність

- потреби

- Нові

- наступний

- nlp

- особливо

- увагу

- ноутбук

- номер

- спостерігати

- виникнення

- of

- Пропозиції

- часто

- on

- ONE

- тільки

- операції

- варіант

- Опції

- or

- помаранчевий

- порядок

- замовлень

- Інше

- з

- Вищі результати

- Переважає

- вихід

- виходи

- над

- власний

- пакети

- документи

- Паралельні

- параметр

- параметри

- приватність

- розділений

- Пройшов

- Проходження

- пристрасний

- Минуле

- шлях

- стежки

- Патрік

- моделі

- для

- відсотків

- Виконувати

- продуктивність

- виконується

- виконанні

- перспектива

- Вчений ступінь

- plato

- Інформація про дані Платона

- PlatoData

- точка

- точок

- популярний

- це можливо

- пошта

- потенціал

- Практичний

- практики

- попередній

- передвіщений

- Готувати

- підготовлений

- передумови

- представити

- запобігати

- попередній перегляд

- ціни без прихованих комісій

- первинний

- недоторканність приватного життя

- зонд

- Проблема

- вирішення проблем

- проблематичний

- проблеми

- процедура

- продовжити

- процес

- процеси

- обробка

- виробляти

- випускає

- Production

- підказок

- доказ

- доказ концепції

- Доведіть

- доведений

- доводить

- забезпечувати

- провайдери

- Python

- питання

- питань

- залучення

- випадковість

- діапазон

- швидше

- Читати

- причина

- рекомендований

- облік

- червоний

- зниження

- послатися

- про

- спирається

- решті

- видаляти

- повторювані

- відповідь

- тиражувати

- запитів

- вимагати

- Вимога

- Вимагається

- ті

- відповідь

- відповіді

- відповідальний

- обмеження

- в результаті

- результати

- Умови повернення

- рецензування

- ризики

- Роль

- ROW

- прогін

- біг

- пробіжки

- час виконання

- мудрець

- то ж

- зразок

- шкала

- масштабний

- Масштабування

- сценарії

- Школа

- вчений

- Sdk

- sdks

- другий

- безпеку

- вибирає

- продавати

- окремий

- Послідовність

- обслуговування

- Послуги

- Сесія

- комплект

- установка

- кілька

- Поділитись

- вона

- найкоротший

- Повинен

- Показувати

- показаний

- Шоу

- значний

- аналогічний

- простий

- один

- Розмір

- навички

- невеликий

- менше

- So

- проданий

- рішення

- Рішення

- ВИРІШИТИ

- Вирішує

- Розв’язування

- деякі

- Простір

- standard

- Статус

- Крок

- заходи

- зберігання

- зберігати

- зберігати

- магазинів

- просто

- стратегії

- Стратегія

- тема

- наступні

- Успішно

- Запропонує

- придатність

- Підтриманий

- опитаних

- рій

- символічний

- таблиця

- приймає

- завдання

- технології

- технічний

- техніка

- методи

- Технологія

- terms

- Тестування

- текст

- ніж

- Дякую

- Що

- Команда

- їх

- Їх

- потім

- отже

- Ці

- це

- ті

- думка

- три

- через

- TIE

- час

- times

- до

- разом

- знак

- Жетони

- прийняли

- інструменти

- Усього:

- трафік

- поїзд

- переносимо

- викликати

- спрацьовує

- правда

- два

- типово

- несанкціонований

- що лежить в основі

- створеного

- одиниць

- університет

- Оновити

- Використання

- використання

- використання випадку

- використовуваний

- корисний

- користувач

- використовує

- використання

- значення

- Цінності

- різний

- дуже

- через

- Голосування

- vs

- покрокове керівництво

- було

- шлях..

- we

- Web

- Веб-додаток

- веб-сервіси

- коли

- Чи

- який

- в той час як

- WHL

- волі

- з

- без

- слово

- б

- запис

- лист

- X

- вихід

- врожайність

- Ти

- вашу

- зефірнет

- Zip

- зони