Відколи ChatGPT вибухнув на технологічній сцені в листопаді минулого року, він допомагає людям писати всілякі матеріали, генерувати код і знаходити інформацію. Вона та інші великі мовні моделі (LLM) полегшили виконання завдань, починаючи від дзвінків у службу підтримки клієнтів і закінчуючи прийомом замовлень швидкого харчування. Враховуючи те, наскільки LLM були корисними для людей за короткий час їх існування, як ChatGPT для роботів може вплинути на їх здатність навчатися та робити нові речі? Дослідники Google DeepMind вирішили з’ясувати це та опублікували свої висновки в блог і документ, випущений минулого тижня.

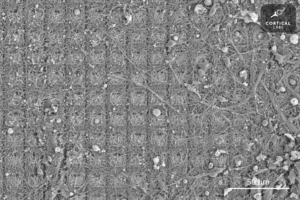

Вони називають свою систему RT-2. Це скорочення від robotics transformer 2 і є наступником робототехніка трансформер 1, яку компанія випустила наприкінці минулого року. RT-1 базувався на невеликій програмі мови та зору та був спеціально навчений виконувати багато завдань. Програмне забезпечення використовувалося в Alphabet X Повсякденні роботи, дозволяючи їм виконувати понад 700 різних завдань із 97-відсотковим показником успіху. Але коли їм було запропоновано виконати нові завдання, яким вони не були навчені, роботи, які використовували RT-1, були успішними лише в 32 відсотках випадків.

RT-2 майже вдвічі збільшує цей показник, успішно виконуючи нові завдання в 62 відсотках поставленого часу. Дослідники називають RT-2 моделлю бачення-мова-дія (VLA). Він використовує текст і зображення, які бачить в Інтернеті, щоб отримати нові навички. Це не так просто, як звучить; воно вимагає від програмного забезпечення спочатку «зрозуміти» концепцію, потім застосувати це розуміння до команди або набору інструкцій, а потім виконати дії, які задовольняють ці інструкції.

Одним із прикладів автори статті є утилізація сміття. У попередніх моделях програмне забезпечення робота потрібно було спочатку навчити ідентифікувати сміття. Наприклад, якщо на столі лежить очищений банан із шкіркою поруч, боту буде показано, що шкірка є сміттям, а банан – ні. Потім його навчать, як зібрати шкірку, перенести її в сміттєвий бак і залишити там.

Однак RT-2 працює трохи інакше. Оскільки модель тренувалася на величезній кількості інформації та даних з Інтернету, вона має загальне розуміння того, що таке сміття, і хоча вона не навчена викидати сміття, вона може скласти разом кроки для виконання цього завдання.

Дослідники використовували для навчання RT-2 магістра PaLI-X (модель бачення та мови з 55 мільярдами параметрів) і PaLM-E (те, що Google називає втіленою мультимодальною мовною моделлю, розробленою спеціально для роботів, із 12 мільярдами параметрів). «Параметр» стосується атрибута, який модель машинного навчання визначає на основі даних навчання. У випадку LLMs вони моделюють зв’язки між словами в реченні та зважують, наскільки ймовірно, що дане слово буде передувати або слідувати за іншим словом.

Шляхом пошуку зв’язків і шаблонів між словами у гігантському наборі даних моделі навчаються на власних висновках. Згодом вони можуть зрозуміти, як різні поняття співвідносяться між собою, і розрізнити контекст. У випадку RT-2 він перетворює ці знання в узагальнені інструкції для робототехнічних дій.

Ці дії представлені для робота у вигляді токенів, які зазвичай використовуються для представлення тексту природної мови у вигляді фрагментів слів. У цьому випадку маркери є частинами дії, і програмне забезпечення об’єднує декілька маркерів разом для виконання дії. Ця структура також дозволяє програмному забезпеченню виконувати ланцюжок думок, тобто воно може відповідати на запитання чи підказки, які потребують певної міри міркування.

Приклади, які наводить команда, включають вибір об’єкта для використання як молотка, коли молотка немає (робот вибирає камінь) і вибір найкращого напою для втомленої людини (робот вибирає енергетичний напій).

«RT-2 показує покращені можливості узагальнення та семантичне та візуальне розуміння за межами роботизованих даних, яким він піддавався», — написали дослідники в Google блог. «Це включає в себе інтерпретацію нових команд і реагування на команди користувача шляхом виконання елементарних міркувань, таких як міркування про категорії об’єктів або описи високого рівня».

Мрія про роботи загального призначення що може допомогти людям у будь-якому випадку — чи то вдома, чи на комерційному, чи промисловому — не буде досягнутим, доки роботи не зможуть навчатися на ходу. Те, що нам здається основним інстинктом, для роботів — це складна комбінація розуміння контексту, здатності міркувати через нього та вживати дій для вирішення проблем, які не передбачалося виникнути. Запрограмувати їх на відповідну реакцію на різноманітні незаплановані сценарії неможливо, тому вони повинні мати можливість узагальнювати та вчитися на досвіді, як і люди.

РТ-2 – крок у цьому напрямку. Проте дослідники визнають, що хоча RT-2 може узагальнювати семантичні та візуальні концепції, він ще не здатний навчатися новим діям самостійно. Натомість він застосовує дії, які вже знає, до нових сценаріїв. Можливо, RT-3 або 4 зможуть підняти ці навички на новий рівень. Тим часом, як робить висновок команда у своїх блог, «Хоча попереду ще величезна кількість роботи, щоб створити корисних роботів у середовищі, зосередженому на людині, RT-2 показує нам захоплююче майбутнє для робототехніки в межах досяжності».

Зображення Фото: Google DeepMind

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. Автомобільні / електромобілі, вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- BlockOffsets. Модернізація екологічної компенсаційної власності. Доступ тут.

- джерело: https://singularityhub.com/2023/08/02/deepminds-chatgpt-like-brain-for-robots-lets-them-learn-from-the-internet/

- : має

- :є

- : ні

- $UP

- 12

- 32

- 700

- a

- здатність

- Здатний

- МЕНЮ

- визнавати

- дію

- дії

- ВСІ

- Алфавіт

- вже

- Також

- кількість

- an

- та

- Інший

- Очікуваний

- Застосовувати

- відповідним чином

- ЕСТЬ

- навколо

- AS

- At

- authors

- доступний

- геть

- Банан

- заснований

- основний

- BE

- було

- буття

- КРАЩЕ

- між

- За

- Мільярд

- Бот

- Brain

- але

- by

- call

- Виклики

- CAN

- можливості

- нести

- випадок

- категорії

- ChatGPT

- Вибираючи

- код

- поєднання

- Приходити

- комерційний

- компанія

- повний

- комплекс

- концепція

- поняття

- контекст

- кредит

- клієнт

- Контакти

- дані

- вирішене

- Deepmind

- Визначає

- Ступінь

- депозит

- розвиненою

- різний

- напрям

- do

- зроблений

- Парний

- мрія

- напій

- кожен

- включіть

- дозволяє

- дозволяє

- кінець

- енергія

- середовищах

- врешті-решт

- приклад

- захоплюючий

- досвід

- піддаватися

- полегшений

- ШВИДКО

- Рисунок

- знайти

- виявлення

- результати

- Перший

- потім

- харчування

- для

- форма

- від

- майбутнє

- Загальне

- породжувати

- гігант

- Давати

- даний

- дає

- Go

- схопити

- забивати

- Мати

- допомога

- корисний

- допомогу

- на вищому рівні

- Головна

- Як

- How To

- HTML

- HTTPS

- Людей

- ідентифікувати

- if

- зображень

- Impact

- неможливе

- поліпшений

- in

- включати

- includes

- промислові

- інформація

- інструкції

- інтернет

- в

- IT

- ЙОГО

- JPG

- просто

- знання

- мова

- великий

- останній

- Минулого року

- УЧИТЬСЯ

- вивчення

- дозволяє

- рівень

- як

- Ймовірно

- трохи

- вантажі

- машина

- навчання за допомогою машини

- багато

- матеріал

- макс-ширина

- Може..

- сенс

- тим часом

- може бути

- модель

- Моделі

- найбільш

- рухатися

- множинний

- Природний

- Необхідність

- Нові

- наступний

- немає

- Листопад

- об'єкт

- of

- on

- онлайн

- тільки

- на

- or

- замовлень

- Інше

- з

- над

- власний

- Папір

- параметри

- частини

- моделі

- Люди

- відсотків

- Виконувати

- виконанні

- може бути

- людина

- вибирати

- частина

- plato

- Інформація про дані Платона

- PlatoData

- поп

- попередній

- проблеми

- програма

- Програмування

- опублікований

- питань

- ставка

- швидше

- Реагувати

- причина

- відноситься

- Відносини

- випущений

- представляти

- представлений

- вимагати

- Вимагається

- Дослідники

- Реагувати

- відповідаючи

- робот

- робототехніка

- роботи

- Rock

- s

- сценарії

- сцена

- Здається,

- бачить

- пропозиція

- обслуговування

- комплект

- установка

- Короткий

- показаний

- Шоу

- простий

- з

- навички

- невеликий

- So

- Софтвер

- ВИРІШИТИ

- деякі

- конкретно

- Крок

- заходи

- Як і раніше

- структура

- успіх

- успішний

- Успішно

- такі

- система

- таблиця

- Приймати

- взяття

- Завдання

- завдання

- навчав

- команда

- технології

- Що

- Команда

- їх

- Їх

- потім

- Там.

- Ці

- вони

- речі

- це

- ті

- хоча?

- через

- час

- втомлений

- до

- разом

- Жетони

- поїзд

- навчений

- Навчання

- трансформатор

- величезний

- розуміння

- до

- us

- використання

- використовуваний

- користувач

- використовує

- використання

- зазвичай

- різноманітність

- бачення

- було

- week

- важать

- були

- Що

- будь

- коли

- який

- в той час як

- волі

- з

- в

- слово

- слова

- Work

- працює

- б

- запис

- пише

- Х-х

- рік

- ще

- зефірнет