Вибір окремих об’єктів у візуальній сцені здається нам інтуїтивно зрозумілим, але машинам важко впоратися з цим завданням. Тепер нова модель ШІ від Meta розробила широке уявлення про те, що таке об’єкт, дозволяючи їй відокремлювати об’єкти, навіть якщо вони ніколи раніше їх не бачили.

Це може здатися досить прозаїчним завданням комп’ютерного зору, але вміння розібрати зображення та визначити, де закінчується один об’єкт і починається інший, є досить фундаментальним навиком, без якого безліч складніших завдань було б нерозв’язаним.

«Сегментація об’єктів» не є чимось новим; Дослідники ШІ працювали над цим роками. Але, як правило, створення цих моделей було трудомістким процесом, який вимагав великої кількості людських анотацій зображень і значних обчислювальних ресурсів. І зазвичай отримані моделі були вузькоспеціалізованими для конкретних випадків використання.

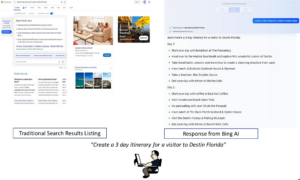

Однак тепер дослідники з Meta оприлюднили модель Segment Anything Model (SAM), яка здатна вирізати будь-який об’єкт у будь-якій сцені, незалежно від того, чи бачили щось подібне раніше. Модель також може робити це у відповідь на різноманітні підказки, від текстового опису до клацання мишею або навіть даних стеження за очима.

«SAM дізнався загальне поняття про об’єкти, і він може генерувати маски для будь-якого об’єкта на будь-якому зображенні чи будь-якому відео», – пишуть дослідники в блог після. «Ми вважаємо, що можливості широкі, і ми в захваті від багатьох потенційних випадків використання, про які ми ще навіть не уявляли».

Ключем до розробки моделі став масивний новий набір даних із 1.1 мільярда масок сегментації, які стосуються областей зображення, які були ізольовані та анотовані, щоб позначити, що вони містять певний об’єкт. Він був створений шляхом поєднання анотацій зображень вручну людиною та автоматизованих процесів, і на сьогоднішній день є найбільшою колекцією такого типу, зібраною на сьогодні.

Навчаючись на такому масивному наборі даних, дослідники Meta кажуть, що вони розробили загальну концепцію того, що таке об’єкт, що дозволяє сегментувати речі, які вони навіть не бачили раніше. Ця здатність до узагальнення спонукала дослідників назвати SAM «основною моделлю», a спірний термін використовується для опису інших масивних попередньо навчених моделей, таких як GPT OpenAI серії, чиї можливості нібито настільки загальні, що їх можна використовувати як основу для безлічі програм.

Сегментація зображення, безумовно, є ключовим компонентом широкого спектру завдань комп’ютерного зору. Якщо ви не можете відокремити різні компоненти сцени, важко зробити з нею щось складніше. У своєму блозі дослідники кажуть, що це може виявитися неоціненним у редагуванні відео та зображень або допомогти в аналізі наукових зображень.

Можливо, більш відповідним для амбіцій компанії щодо метавсесвіту є те, що вони надають демонстрацію того, як його можна використовувати в поєднанні з гарнітурою віртуальної реальності для вибору конкретних об’єктів на основі погляду користувача. Вони також кажуть, що його потенційно можна поєднати з великою мовною моделлю для створення мультимодальної системи, здатної розуміти як візуальний, так і текстовий вміст веб-сторінки.

Можливість працювати з широким діапазоном підказок робить систему особливо гнучкою. В веб-сторінка Демонструючи нову модель, компанія показує, що після аналізу зображення можна запропонувати відокремити конкретні об’єкти, просто клацнувши на них курсором миші, ввівши, що саме потрібно сегментувати, або просто розбивши все зображення на окремі об'єкти.

І що найважливіше, компанія надає відкрите джерело як моделі, так і набору даних для дослідницьких цілей, щоб інші могли використовувати їхню роботу. Це той самий підхід, який компанія застосувала до своєї широкомовної моделі LLaMA, що призвело до її швидкого просочився в Інтернеті і стимулювання a хвиля експериментів любителями та хакерами.

Чи станеться те саме з SAM, ще невідомо, але в будь-якому випадку це подарунок дослідницькому співтовариству штучного інтелекту, який міг би прискорити прогрес у розв’язанні багатьох важливих проблем комп’ютерного зору.

Зображення Фото: Мета ШІ

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- Платоблокчейн. Web3 Metaverse Intelligence. Розширені знання. Доступ тут.

- джерело: https://singularityhub.com/2023/04/10/metas-new-ai-can-identify-and-remove-objects-in-images/

- :є

- $UP

- 1

- a

- здатність

- Здатний

- прискорювати

- після

- AI

- ai дослідження

- Дозволити

- дозволяє

- амбіції

- аналіз

- Аналізуючи

- та

- Інший

- застосування

- підхід

- ЕСТЬ

- AS

- зібраний

- At

- Автоматизований

- заснований

- BE

- перед тим

- буття

- Вірити

- Мільярд

- Блог

- Розрив

- широкий

- будувати

- Створюємо

- by

- CAN

- можливості

- випадків

- збір

- поєднання

- співтовариство

- компанія

- Компанії

- складний

- Компоненти

- комп'ютер

- Комп'ютерне бачення

- обчислення

- концепція

- значний

- містити

- зміст

- може

- створювати

- створений

- кредит

- Вирізати

- дані

- Дата

- угода

- безумовно

- описувати

- description

- розвиненою

- розробка

- різний

- або

- закінчується

- Весь

- Навіть

- збуджений

- достатньо

- гнучкий

- для

- Підвалини

- від

- фундаментальний

- Загальне

- породжувати

- подарунок

- хакери

- траплятися

- Жорсткий

- Мати

- навушники

- допомога

- дуже

- господар

- Як

- HTTPS

- людина

- ідея

- зображення

- зображень

- важливо

- in

- інтуїтивний

- безцінний

- ізольований

- IT

- ЙОГО

- ключ

- мова

- великий

- найбільших

- вчений

- Led

- як

- Лама

- Машинки для перманенту

- РОБОТИ

- керівництво

- багато

- маски

- масивний

- Meta

- Метавеси

- може бути

- модель

- Моделі

- більше

- найбільш

- Нові

- поняття

- об'єкт

- об'єкти

- of

- on

- ONE

- Інше

- інші

- сторінка

- парний

- приватність

- особливо

- вибирати

- plato

- Інформація про дані Платона

- PlatoData

- можливостей

- потенціал

- потенційно

- досить

- проблеми

- процес

- процеси

- прогрес

- Доведіть

- забезпечувати

- цілей

- діапазон

- швидко

- Реальність

- відноситься

- Незалежно

- райони

- залишається

- дослідження

- Дослідники

- ресурси

- відповідь

- в результаті

- Сем

- то ж

- сцена

- науковий

- Здається,

- сегмент

- сегментація

- окремий

- Серія

- Шоу

- просто

- майстерність

- So

- спеціалізований

- конкретний

- боротьба

- такі

- система

- Завдання

- завдання

- Що

- Команда

- їх

- Їх

- Ці

- речі

- через

- трудомісткий

- до

- Навчання

- типово

- розуміти

- представила

- us

- використання

- різноманітність

- Відео

- Віртуальний

- Віртуальна реальність

- бачення

- шлях..

- Web

- Що

- Чи

- який

- широкий

- Широкий діапазон

- волі

- з

- без

- Work

- тренування

- працював

- б

- років

- Ти

- зефірнет