Дані змінюють кожну сферу та кожен бізнес. Однак, оскільки обсяг даних зростає швидше, ніж можуть відстежувати більшість компаній, збирати дані та отримувати від них користь – це складна справа. А сучасна стратегія даних може допомогти вам досягти кращих бізнес-результатів за допомогою даних. AWS надає найповніший набір послуг для наскрізна передача даних , Щоб допомогти вам розблокувати цінність ваших даних і перетворити це на розуміння.

Науковці даних можуть витрачати до 80% свого часу на підготовку даних для проектів машинного навчання (ML). Цей процес підготовки є здебільшого недиференційованою та виснажливою роботою, яка може включати численні API програмування та спеціальні бібліотеки. Amazon SageMaker Data Wrangler допомагає науковцям та інженерам даних спростити та прискорити підготовку табличних і часових рядів даних та розробку функцій за допомогою візуального інтерфейсу. Ви можете імпортувати дані з кількох джерел даних, наприклад Служба простого зберігання Amazon (Amazon S3), Амазонка Афіна, Амазонська червона змінаабо навіть рішення сторонніх розробників, як Сніжинка or DataBricks, а також обробляти ваші дані за допомогою понад 300 вбудованих перетворень даних і бібліотеки фрагментів коду, щоб ви могли швидко нормалізувати, трансформувати та комбінувати функції без написання коду. Ви також можете перенести власні трансформації в PySpark, SQL або Pandas.

Ця публікація демонструє, як можна запланувати автоматичне виконання завдань підготовки даних. Ми також досліджуємо нову можливість Data Wrangler параметризованих наборів даних, яка дозволяє вказувати файли, які слід включити в потік даних за допомогою параметризованих URI.

Огляд рішення

Data Wrangler тепер підтримує імпорт даних за допомогою параметризованого URI. Це забезпечує додаткову гнучкість, оскільки тепер ви можете імпортувати всі набори даних, які відповідають указаним параметрам, які можуть бути типу String, Number, Datetime та Pattern, в URI. Крім того, тепер ви можете запускати завдання трансформації Data Wrangler за розкладом.

У цій публікації ми створюємо зразок потоку з набором даних Titanic, щоб показати, як можна почати експериментувати з цими двома новими функціями Data Wrangler. Щоб завантажити набір даних, зверніться до Титанік – машинне навчання після катастрофи.

Передумови

Щоб отримати всі функції, описані в цій публікації, вам потрібно запустити останню версію ядра Data Wrangler. Для отримання додаткової інформації див Оновити Data Wrangler. Крім того, вам потрібно бігати Студія Amazon SageMaker JupyterLab 3. Щоб переглянути поточну версію та оновити її, зверніться до Версій JupyterLab.

Структура файлу

Для цієї демонстрації ми дотримуємося простої файлової структури, яку ви повинні відтворити, щоб відтворити кроки, описані в цій публікації.

- У студії, створити новий блокнот.

- Запустіть наведений нижче фрагмент коду, щоб створити структуру папок, яку ми використовуємо (переконайтеся, що ви перебуваєте в потрібній папці в дереві файлів):

- Скопіюйте

train.csvтаtest.csvфайли з оригінального набору даних Titanic до папокtitanic_dataset/trainтаtitanic_dataset/test, відповідно. - Запустіть наведений нижче фрагмент коду, щоб заповнити папки необхідними файлами:

Ми розділили train.csv файл набору даних "Титаніка" на дев'ять різних файлів з назвами part_x, де х – номер деталі. Частина 0 містить перші 100 записів, частина 1 — наступні 100 і так далі до частини 8. Кожна папка вузла дерева файлів містить копію дев’яти частин навчальних даних, за винятком train та test папки, які містять train.csv та test.csv.

Параметризовані набори даних

Користувачі Data Wrangler тепер можуть вказувати параметри для наборів даних, імпортованих із Amazon S3. Параметри набору даних указано в URI ресурсів, і його значення можна динамічно змінювати, що забезпечує більшу гнучкість вибору файлів, які ми хочемо імпортувати. Параметри можуть бути чотирьох типів даних:

- Номер – Може приймати значення будь-якого цілого числа

- рядок – Може приймати значення будь-якого текстового рядка

- Викрійки – Може приймати значення будь-якого регулярного виразу

- Дата, час – Може приймати значення будь-якого з підтримуваних форматів дати/часу

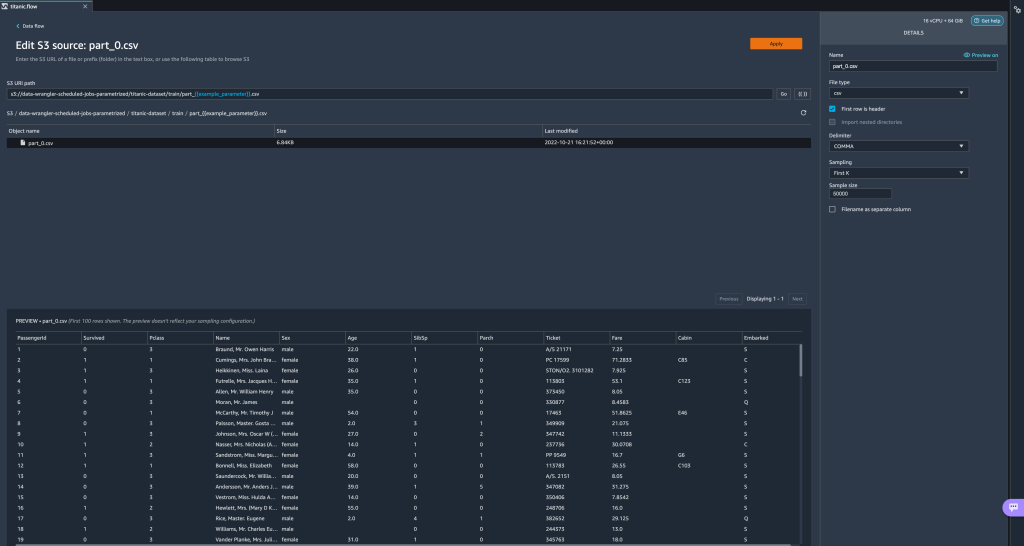

У цьому розділі ми пропонуємо покрокове керівництво цією новою функцією. Це доступно лише після імпорту набору даних у поточний потік і лише для наборів даних, імпортованих із Amazon S3.

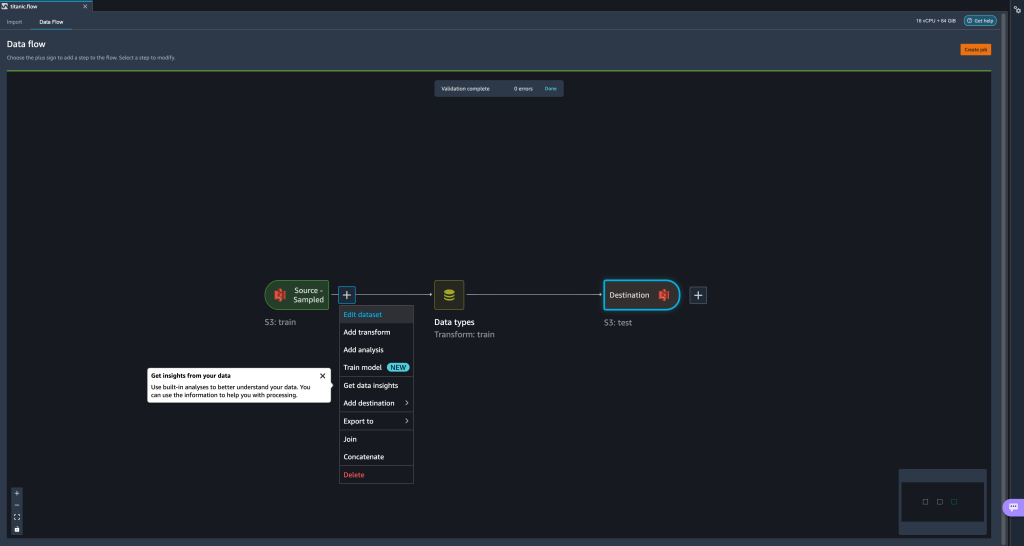

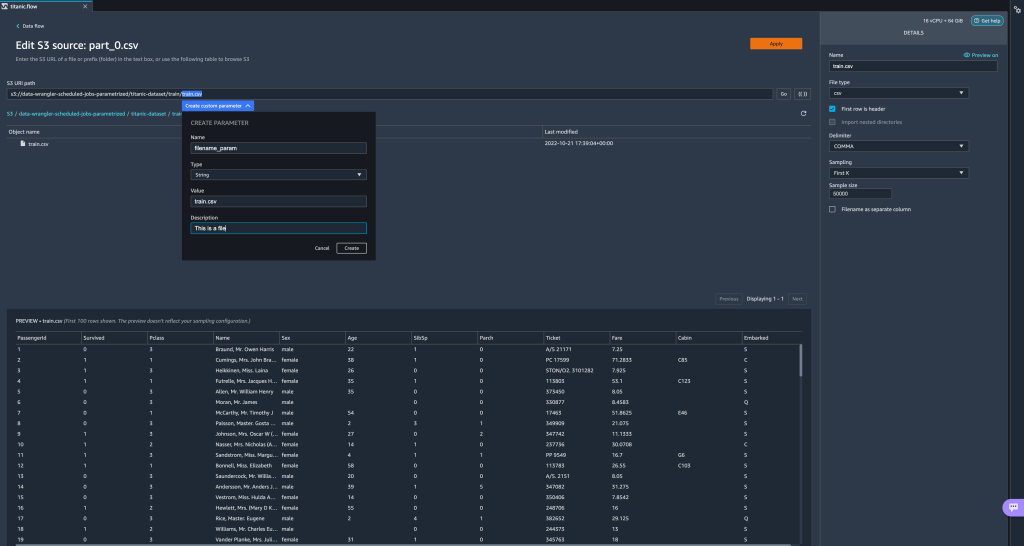

- У потоці даних виберіть знак плюс (+) поруч із кроком імпорту та виберіть Редагувати набір даних.

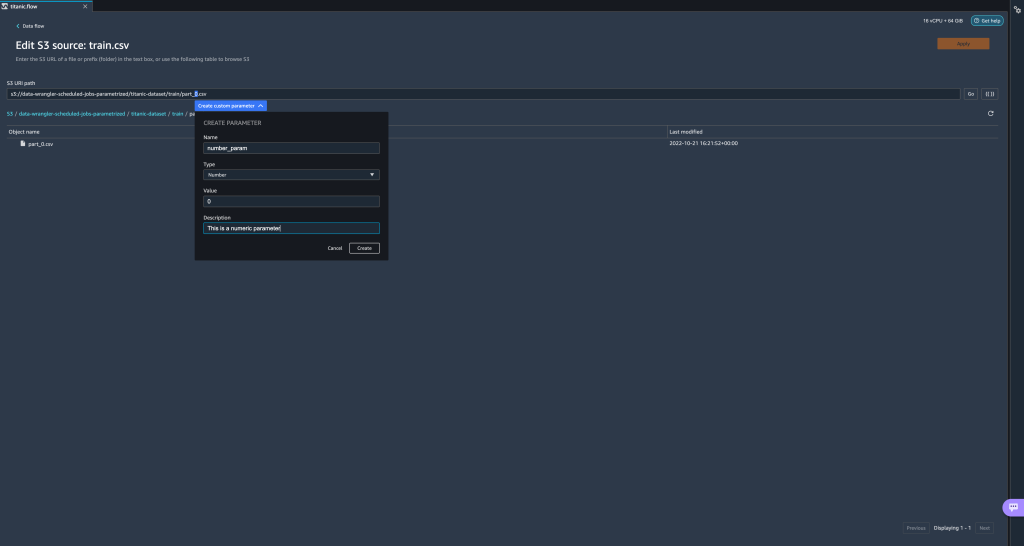

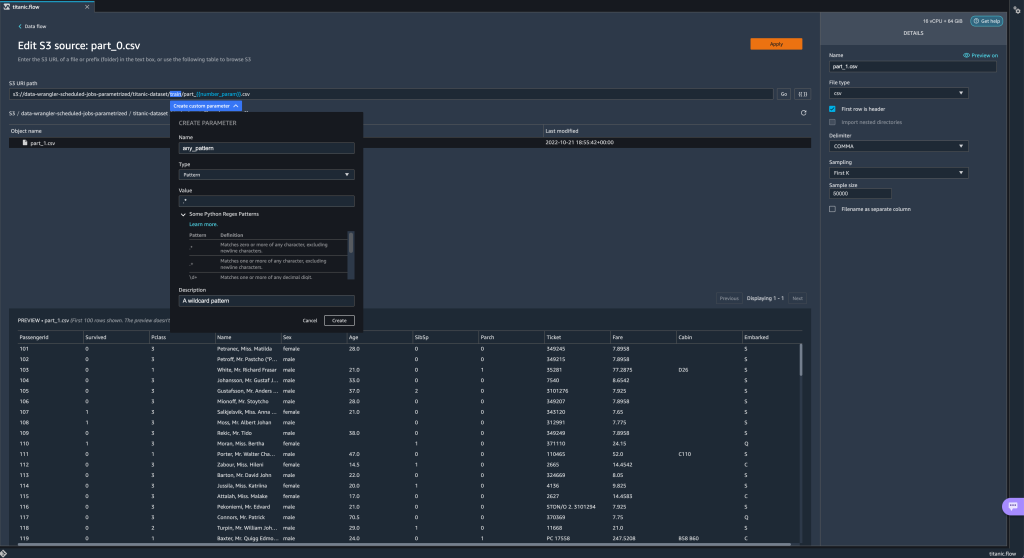

- Найкращий (і найпростіший) спосіб створення нових параметрів – це виділити розділ вашого URI та вибрати Створити власний параметр у спадному меню. Вам потрібно вказати чотири речі для кожного параметра, який ви хочете створити:

- ІМ'Я

- тип

- Значення за замовчуванням

- Опис

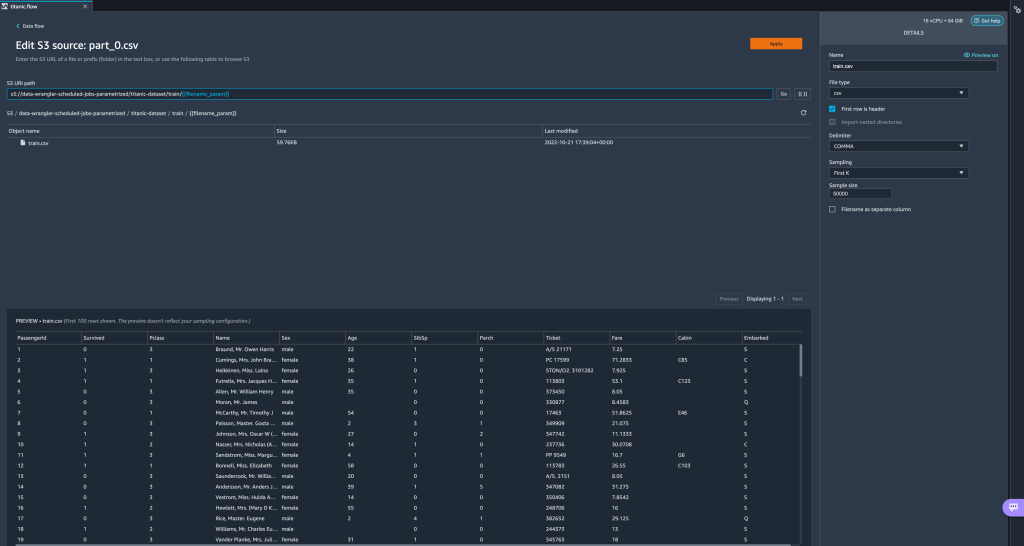

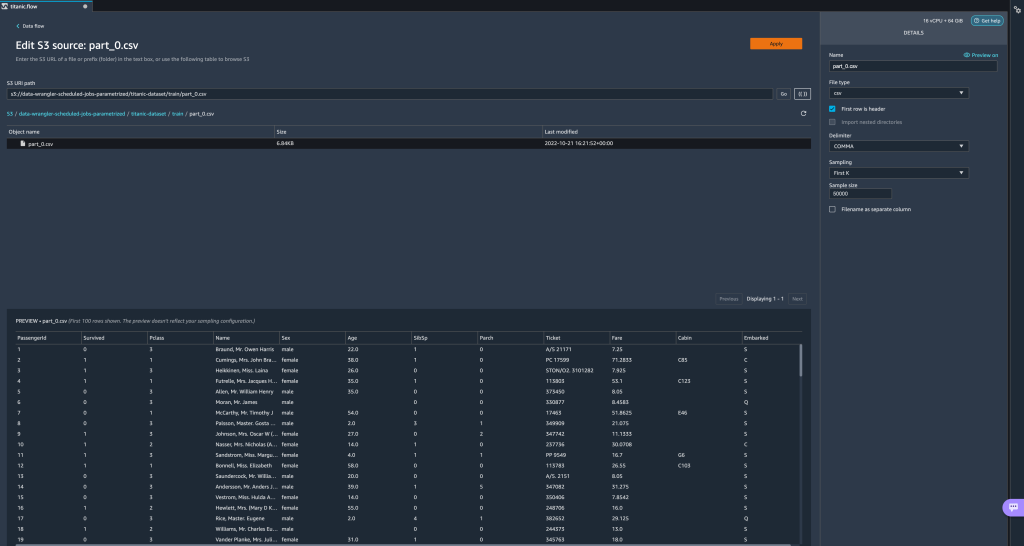

Тут ми створили параметр типу String під назвоюfilename_paramзі значенням за замовчуваннямtrain.csv. Тепер ви можете побачити назву параметра, укладену в подвійні дужки, замінюючи частину URI, яку ми раніше виділили. Оскільки визначене значення цього параметра булоtrain.csv, тепер ми бачимо файлtrain.csvперераховані в таблиці імпорту.

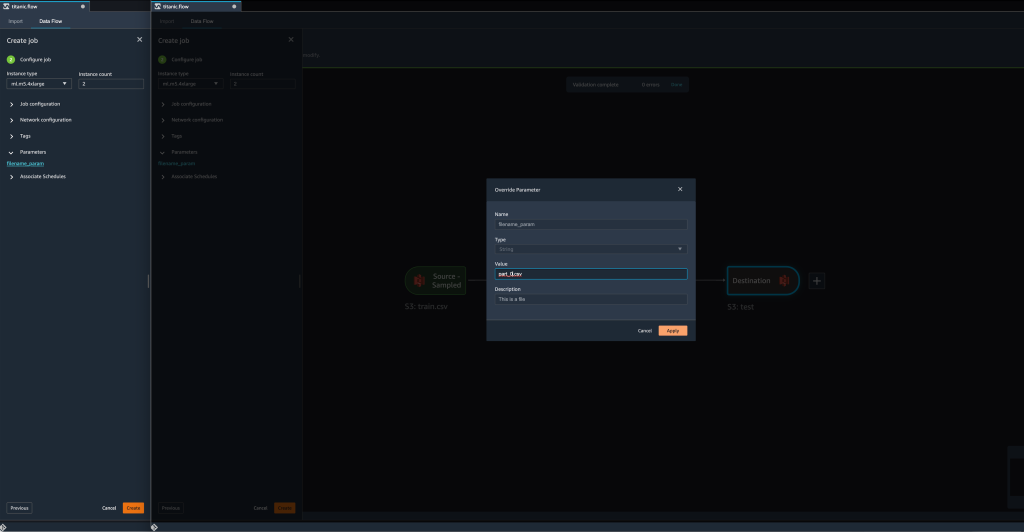

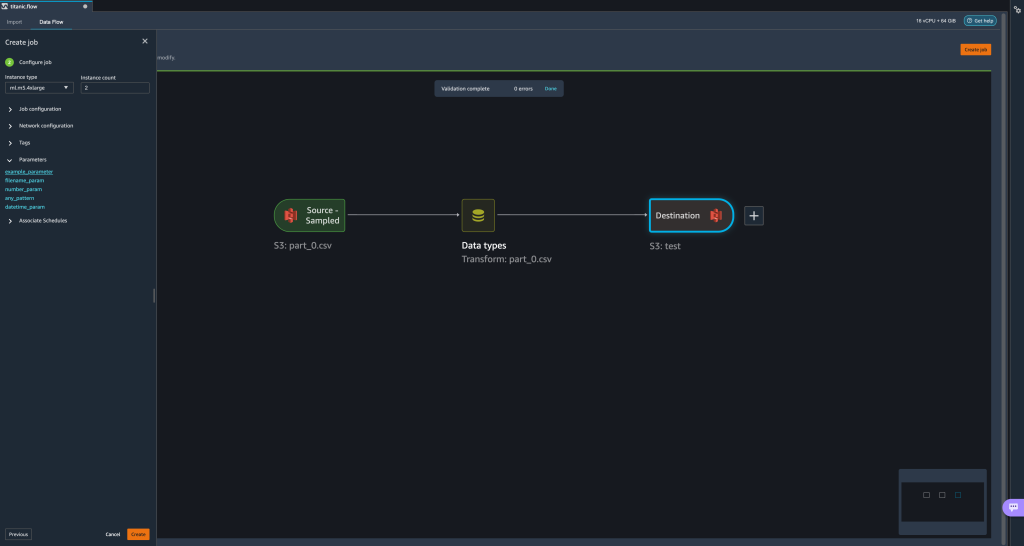

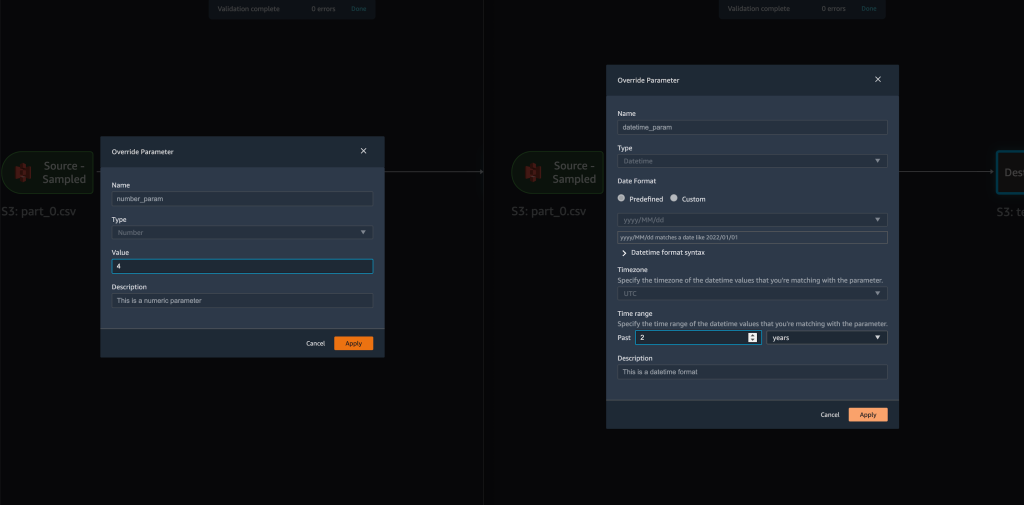

- Коли ми намагаємося створити завдання трансформації, на Налаштувати завдання крок, тепер ми бачимо a параметри розділ, де ми можемо побачити список усіх визначених нами параметрів.

- Вибір параметра дає нам можливість змінити значення параметра, у цьому випадку змінюючи вхідний набір даних, який буде перетворено відповідно до визначеного потоку.

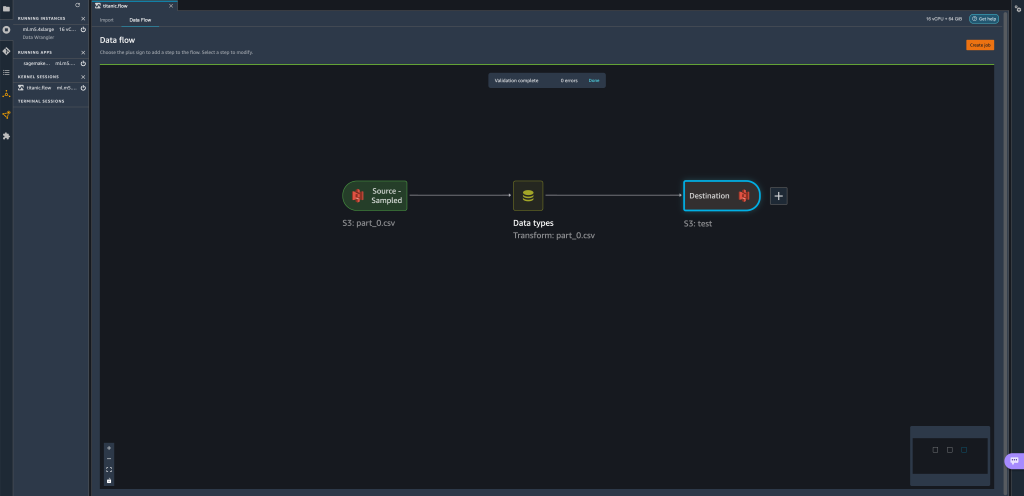

Припустимо, що ми змінимо значенняfilename_paramвідtrain.csvдоpart_0.csv, виконується робота з перетворенняpart_0.csv(за умови, що файл із назвоюpart_0.csvіснує в тій же папці), що й нові вхідні дані.

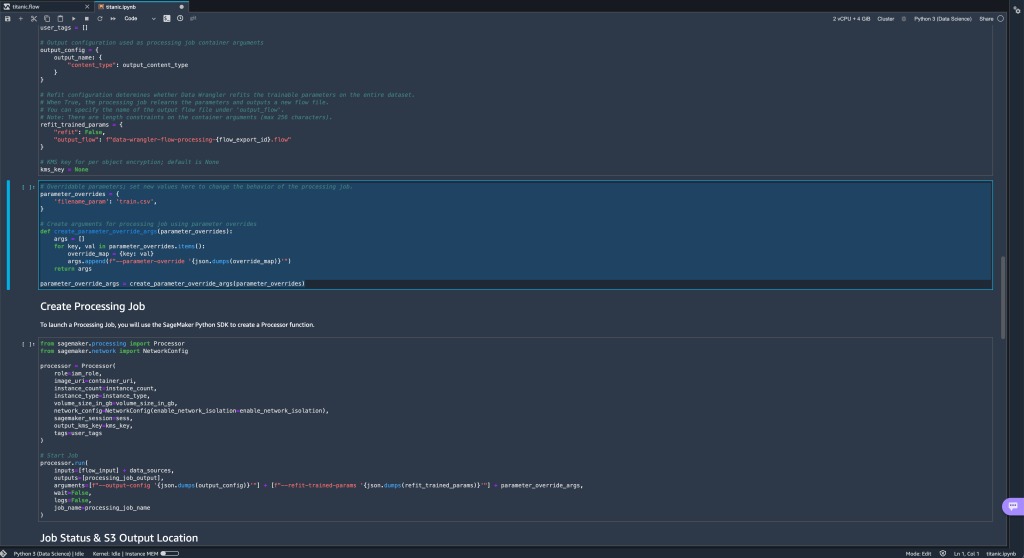

- Крім того, якщо ви спробуєте експортувати свій потік до пункту призначення Amazon S3 (через блокнот Jupyter), тепер ви побачите нову клітинку, що містить параметри, які ви визначили.

Зверніть увагу, що параметр приймає значення за замовчуванням, але ви можете змінити його, замінивши його значення вparameter_overridesсловник (при цьому ключі словника залишаються без змін).

Крім того, ви можете створити нові параметри з параметри UI. - Відкрийте його, вибравши піктограму параметрів ({{}}), розташований поруч із Go варіант; обидва вони розташовані поруч із значенням шляху URI.

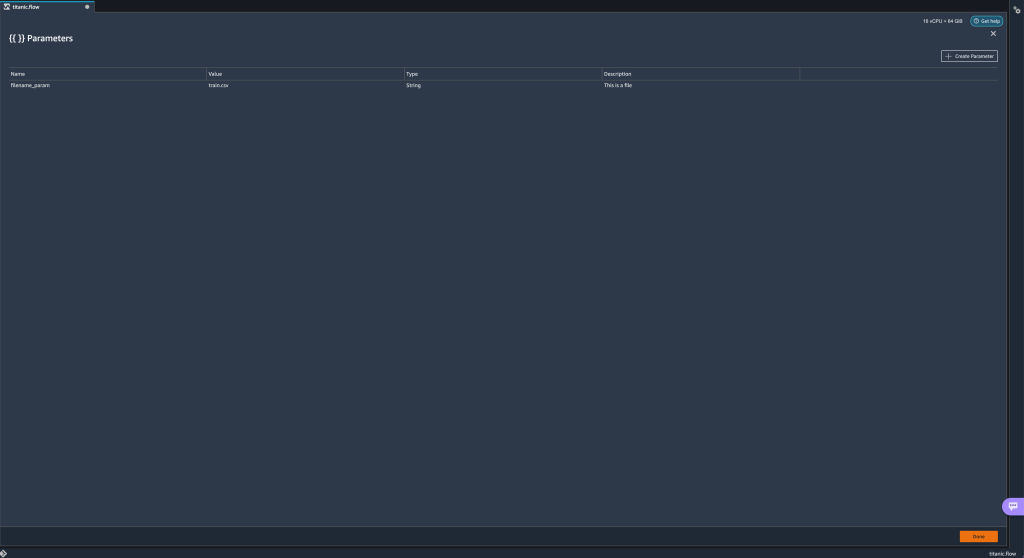

Відкриється таблиця з усіма параметрами, які наразі існують у вашому файлі потоку (

Відкриється таблиця з усіма параметрами, які наразі існують у вашому файлі потоку (filename_paramна даному етапі). - Ви можете створити нові параметри для свого потоку, вибравши Створити параметр.

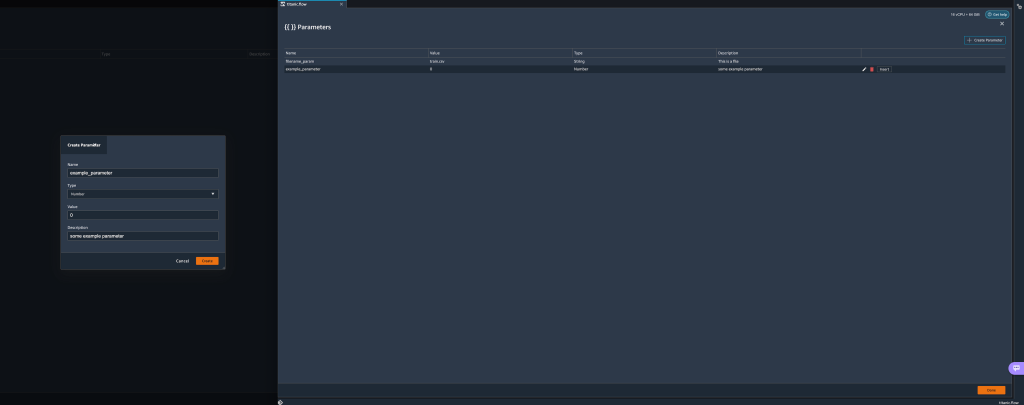

Відкриється спливаюче вікно, у якому можна створити новий спеціальний параметр. - Ось ми створили новий

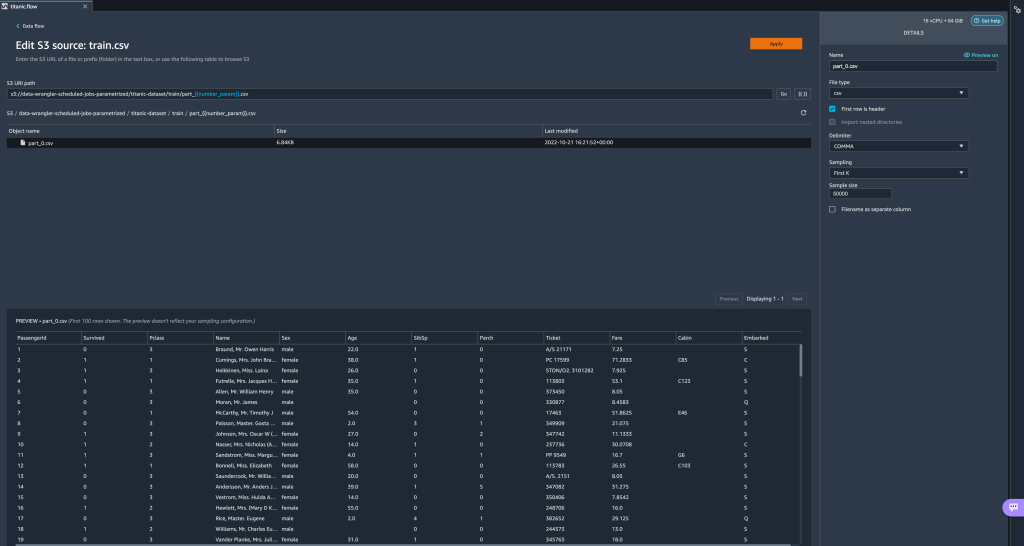

example_parameterяк тип числа зі значенням за замовчуванням 0. Цей щойно створений параметр тепер перераховано в параметри стіл. Наведення курсора на параметр відображає параметри Редагувати, видаляти та Insert.

- Зсередини параметри UI, ви можете вставити один із ваших параметрів до URI, вибравши потрібний параметр і вибравши Insert.

Це додає параметр у кінець вашого URI. Вам потрібно перемістити його до потрібного розділу вашого URI.

- Змініть значення параметра за замовчуванням, застосуйте зміни (з модального), виберіть Goі виберіть піктограму оновлення, щоб оновити список попереднього перегляду за допомогою вибраного набору даних на основі щойно визначеного значення параметра.

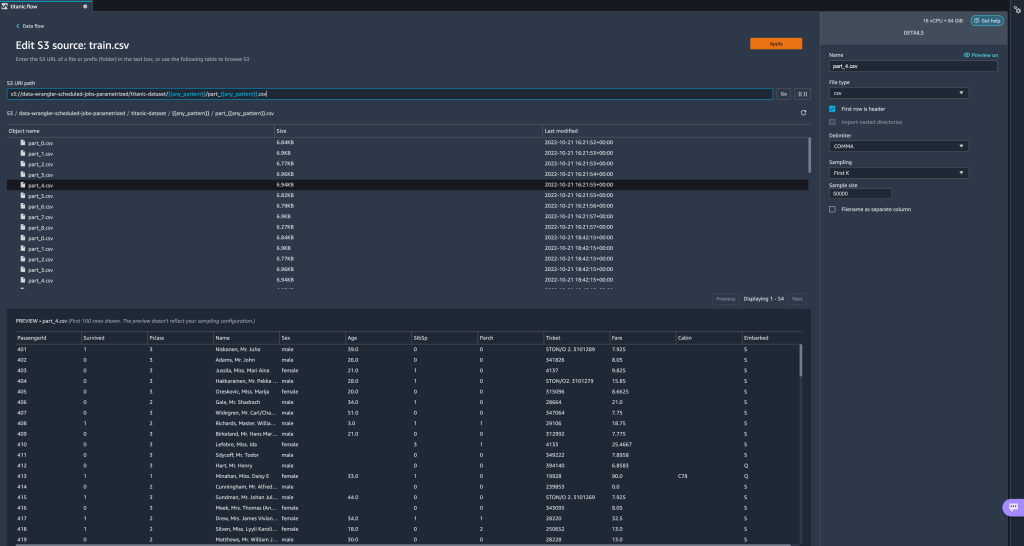

Давайте тепер розглянемо інші типи параметрів. Припустімо, що тепер у нас є набір даних, розділений на кілька частин, де кожен файл має номер частини.

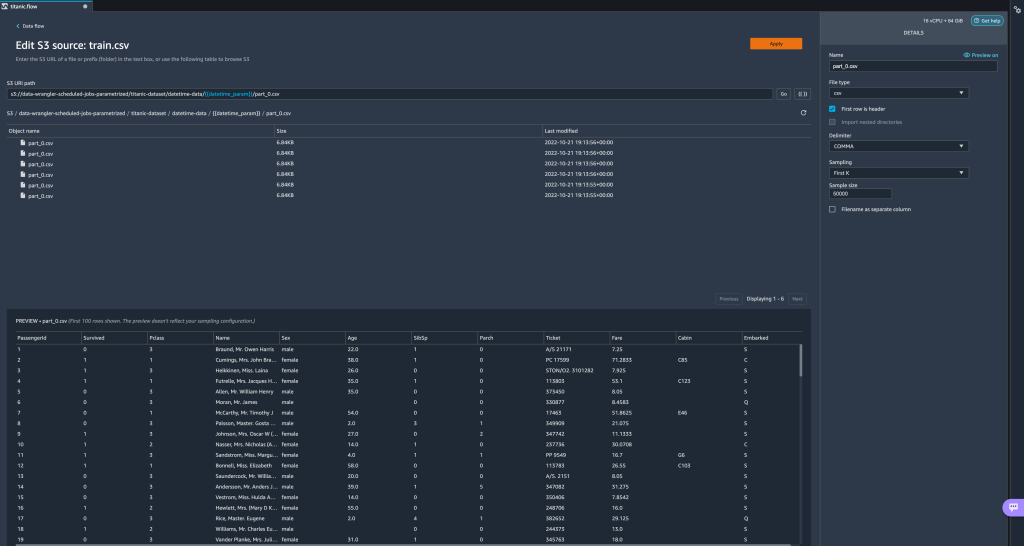

Давайте тепер розглянемо інші типи параметрів. Припустімо, що тепер у нас є набір даних, розділений на кілька частин, де кожен файл має номер частини. - Якщо ми хочемо динамічно змінювати номер файлу, ми можемо визначити параметр Number, як показано на наступному знімку екрана.

Зауважте, що вибраний файл відповідає номеру, указаному в параметрі.

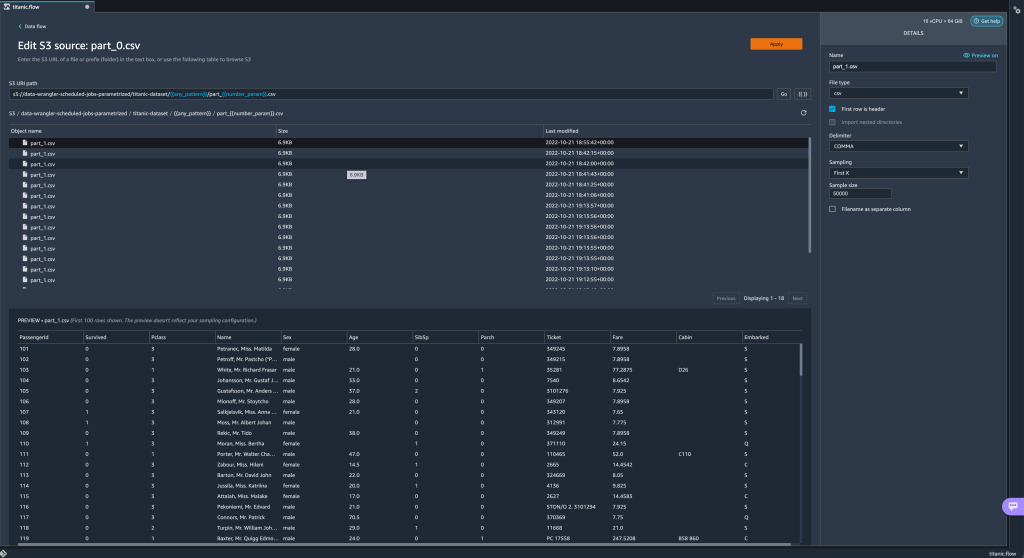

Зауважте, що вибраний файл відповідає номеру, указаному в параметрі. Тепер давайте продемонструємо, як використовувати параметр Pattern. Припустимо, ми хочемо імпортувати всі

Тепер давайте продемонструємо, як використовувати параметр Pattern. Припустимо, ми хочемо імпортувати всі part_1.csvфайли в усіх папках підtitanic-dataset/папку. Параметри шаблону можуть приймати будь-який дійсний регулярний вираз; як приклади наведено кілька шаблонів регулярних виразів. - Створіть параметр шаблону, який називається

any_patternщоб відповідати будь-якій папці чи файлу підtitanic-dataset/папка зі значенням за замовчуванням.*.Зверніть увагу, що символ підстановки — це не одна * (зірочка), а також крапка. - Виділіть

titanic-dataset/частину шляху та створіть спеціальний параметр. Цього разу ми вибираємо Викрійки тип Цей шаблон вибирає всі викликані файли

Цей шаблон вибирає всі викликані файли part-1.csvз будь-якої з папок нижчеtitanic-dataset/. Параметр можна використовувати кілька разів у шляху. У наступному прикладі ми використовуємо наш щойно створений параметр

Параметр можна використовувати кілька разів у шляху. У наступному прикладі ми використовуємо наш щойно створений параметр any_patternдвічі в нашому URI, щоб відповідати будь-якому з файлів частини в будь-якій папці підtitanic-dataset/. Нарешті, давайте створимо параметр Datetime. Параметри дати й часу корисні, коли ми маємо справу зі шляхами, розділеними за датою та часом, як ті, що генеруються Amazon Kinesis Data Firehose (Див. Динамічне розділення в Kinesis Data Firehose). Для цієї демонстрації ми використовуємо дані з папки datetime-data.

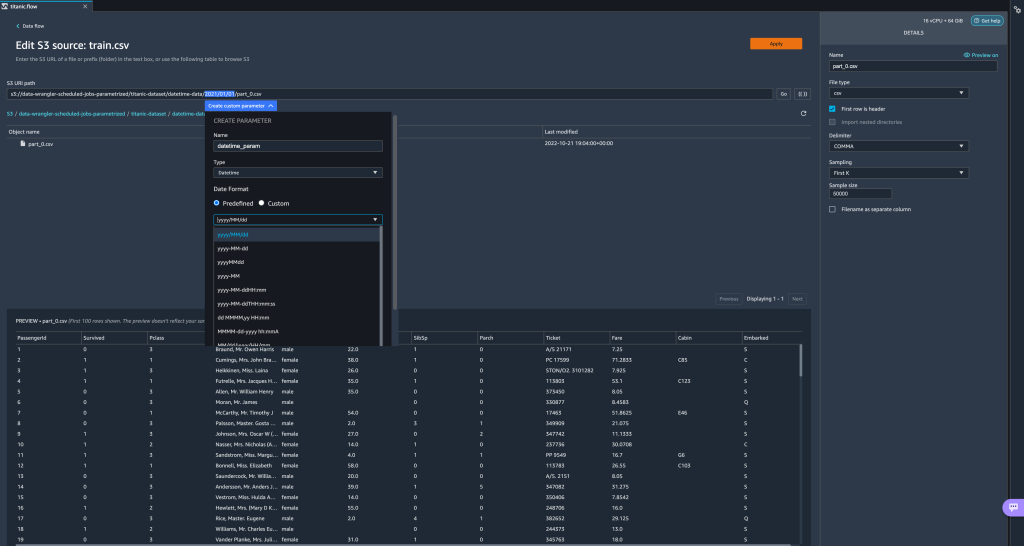

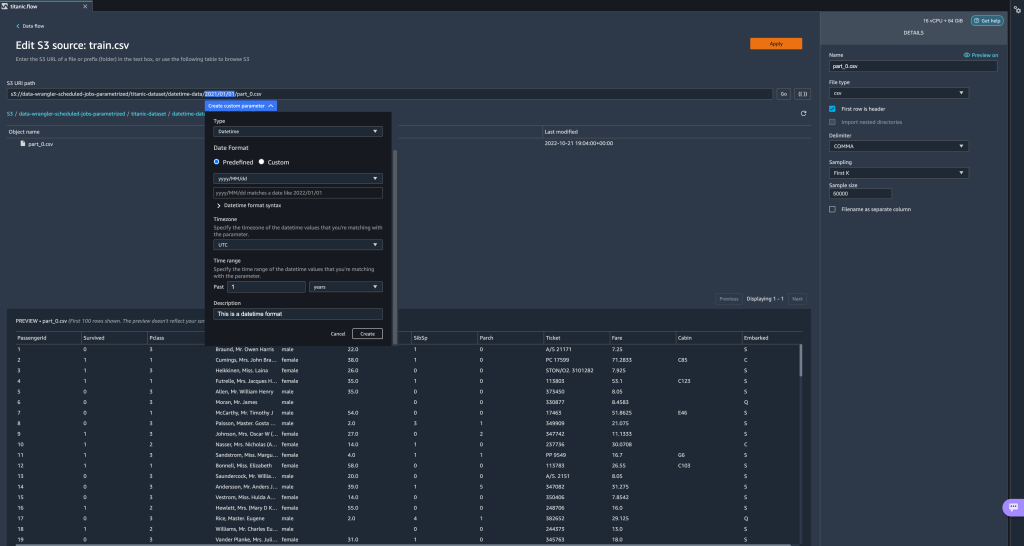

Нарешті, давайте створимо параметр Datetime. Параметри дати й часу корисні, коли ми маємо справу зі шляхами, розділеними за датою та часом, як ті, що генеруються Amazon Kinesis Data Firehose (Див. Динамічне розділення в Kinesis Data Firehose). Для цієї демонстрації ми використовуємо дані з папки datetime-data. - Виберіть частину шляху, яка є датою/часом, і створіть настроюваний параметр. Виберіть Дата, час тип параметра.

Вибираючи тип даних Datetime, потрібно вказати більше деталей. - Перш за все, ви повинні вказати формат дати. Ви можете вибрати будь-який із попередньо визначених форматів дати/часу або створити власний.

Для попередньо визначених форматів дати/часу легенда містить приклад дати, що відповідає вибраному формату. Для цієї демонстрації ми вибираємо формат рррр/ММ/дд.

- Далі вкажіть часовий пояс для значень дати й часу.

Наприклад, поточна дата може бути 1 січня 2022 року в одному часовому поясі, але може бути 2 січня 2022 року в іншому часовому поясі. - Нарешті, ви можете вибрати часовий діапазон, який дає змогу вибрати діапазон файлів, які ви хочете включити у свій потік даних.

Ви можете вказати часовий діапазон у годинах, днях, тижнях, місяцях або роках. Для цього прикладу ми хочемо отримати всі файли за останній рік. - Надайте опис параметра та виберіть Створювати.

Якщо ви використовуєте кілька наборів даних із різними часовими поясами, час не конвертується автоматично; вам потрібно попередньо обробити кожен файл або джерело, щоб конвертувати його в один часовий пояс. Вибрані файли — це всі файли в папках, що відповідають даним минулого року.

Вибрані файли — це всі файли в папках, що відповідають даним минулого року.

- Тепер, якщо ми створюємо завдання перетворення даних, ми можемо побачити список усіх визначених нами параметрів і можемо змінити їхні значення за замовчуванням, щоб наші завдання перетворення вибирали вказані файли.

Розклад робіт з обробки

Тепер ви можете планувати завдання обробки для автоматизації виконання завдань перетворення даних і експорту перетворених даних до Amazon S3 або Магазин функцій Amazon SageMaker. Ви можете запланувати роботу з часом і періодичністю, яка відповідає вашим потребам.

Використання завдань обробки за розкладом Amazon EventBridge Правила щоб запланувати виконання завдання. Тому, як передумова, ви повинні переконатися, що Управління ідентифікацією та доступом AWS (IAM), яку використовує Data Wrangler, а саме Amazon SageMaker виконавча роль екземпляра Studio має дозволи на створення правил EventBridge.

Налаштувати IAM

Продовжуйте з наступними оновленнями щодо ролі виконання IAM SageMaker, що відповідає екземпляру Studio, де запущено потік Data Wrangler:

- Прикріпіть AmazonEventBridgeFullAccess керована політика.

- Додайте політику для надання дозволу на створення завдання обробки:

- Надайте EventBridge дозвіл на виконання ролі, додавши таку політику довіри:

Крім того, якщо ви використовуєте іншу роль для виконання завдання обробки, застосуйте до цієї ролі політики, описані в кроках 2 і 3. Докладніше про конфігурацію IAM див Створіть розклад для автоматичної обробки нових даних.

Створіть розклад

Щоб створити розклад, відкрийте свій потік у редакторі потоку Data Wrangler.

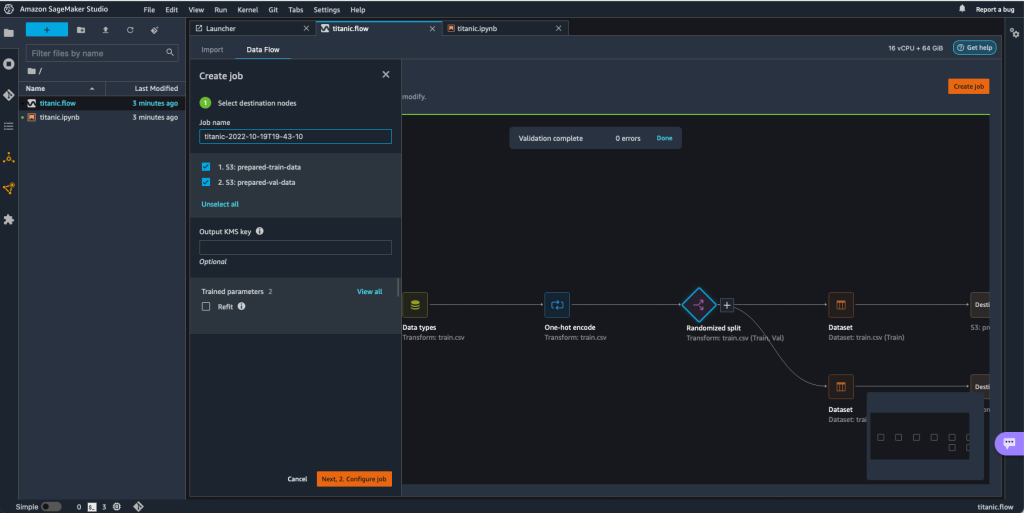

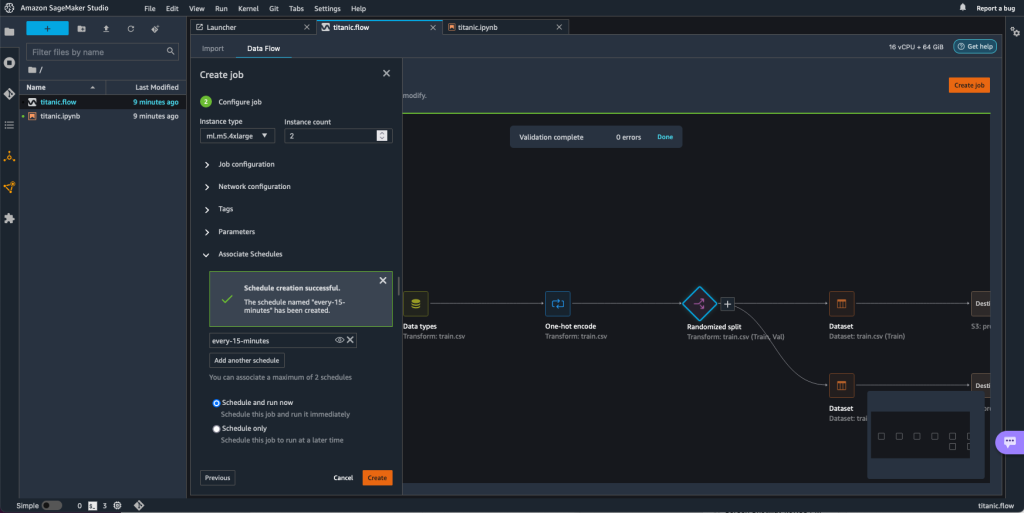

- на Потік даних вкладку, виберіть Створити роботу.

- Налаштуйте необхідні поля та виберіть Далі 2. Налаштувати завдання.

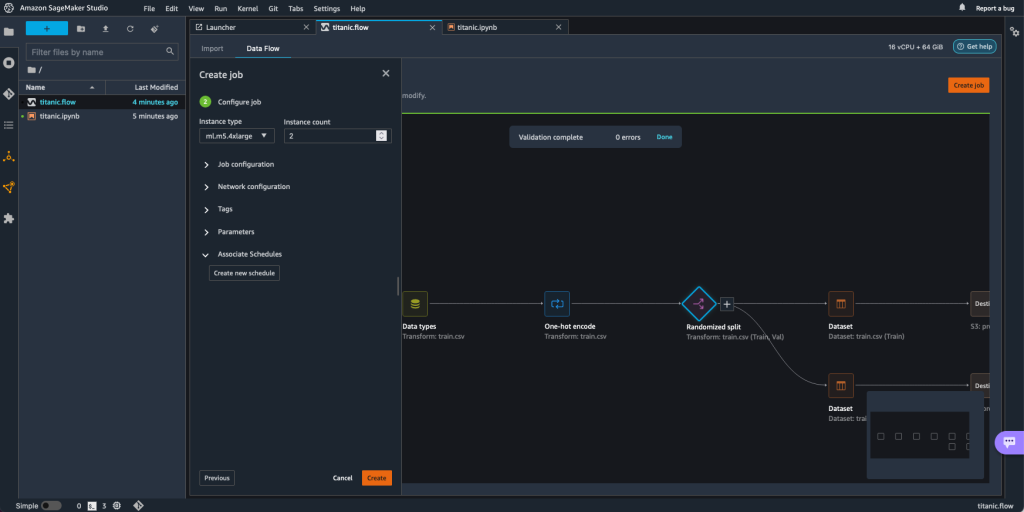

- Розширювати Асоційовані графіки.

- Вибирати Створіть новий розклад.

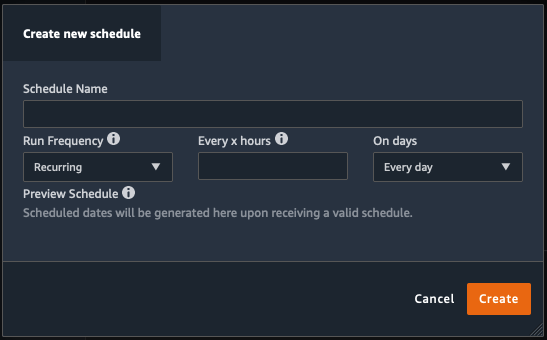

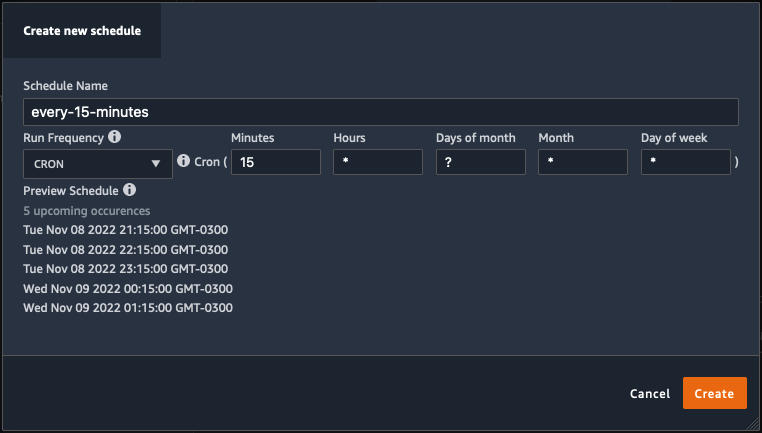

Команда Створіть новий розклад Відкриється діалогове вікно, де ви визначаєте деталі розкладу завдань обробки.

Діалогове вікно забезпечує велику гнучкість, щоб допомогти вам визначити розклад. Ви можете, наприклад, виконати завдання обробки в певний час або кожні X годин у певні дні тижня.

Періодичність може бути гранульованою до рівня хвилин.

- Визначте назву розкладу та періодичність, а потім виберіть Створювати щоб зберегти розклад.

- У вас є можливість розпочати завдання обробки відразу разом із плануванням, яке піклується про майбутні запуски, або залишити завдання виконуватися лише за розкладом.

- Ви також можете визначити додатковий розклад для того самого завдання обробки.

- Щоб завершити розклад завдання обробки, виберіть Створювати.

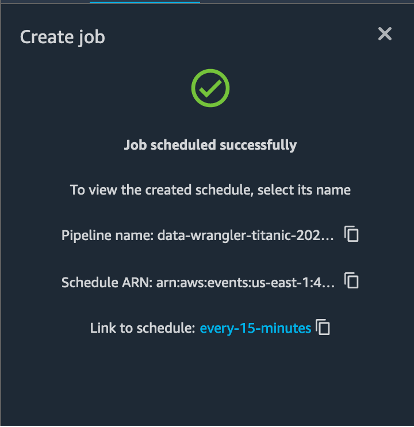

Ви бачите повідомлення «Завдання заплановано успішно». Крім того, якщо ви вирішили залишити завдання виконуватися лише за розкладом, ви побачите посилання на щойно створене правило EventBridge.

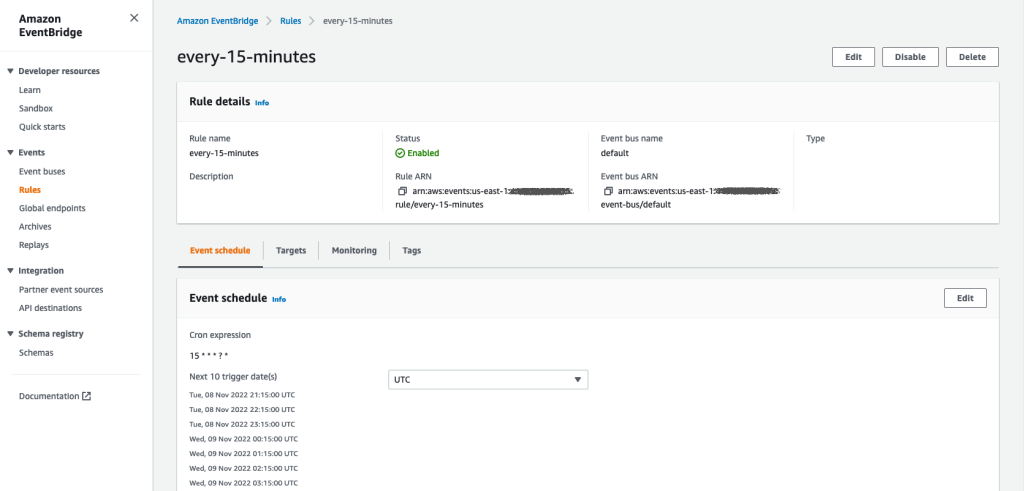

Якщо вибрати посилання розкладу, у браузері відкриється нова вкладка з правилом EventBridge. На цій сторінці ви можете вносити подальші зміни в правило та відстежувати історію його викликів. Щоб припинити виконання запланованого завдання обробки, видаліть правило події, яке містить назву розкладу.

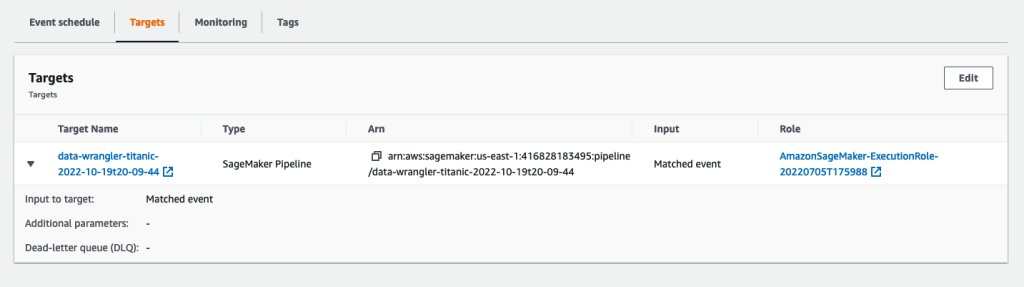

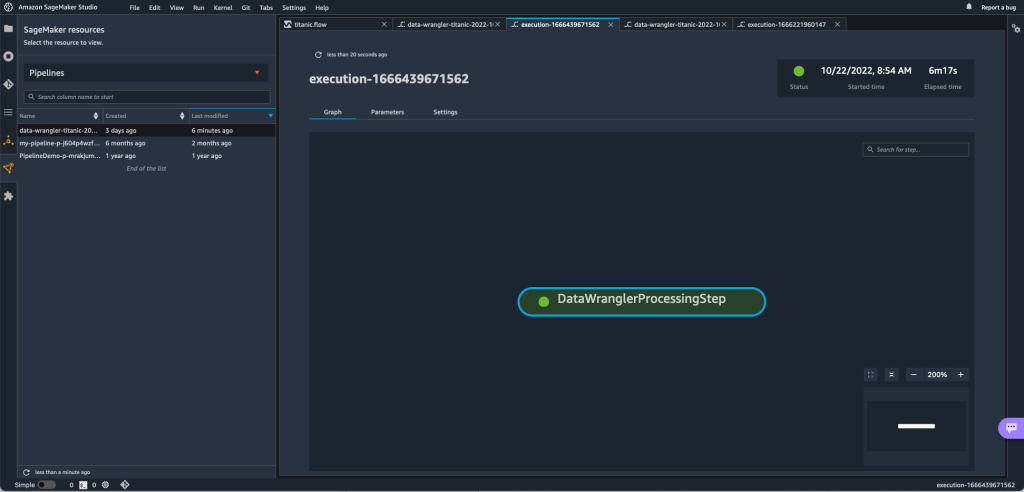

Правило EventBridge показує конвеєр SageMaker як ціль, який запускається відповідно до визначеного розкладу, а завдання обробки викликається як частина конвеєра.

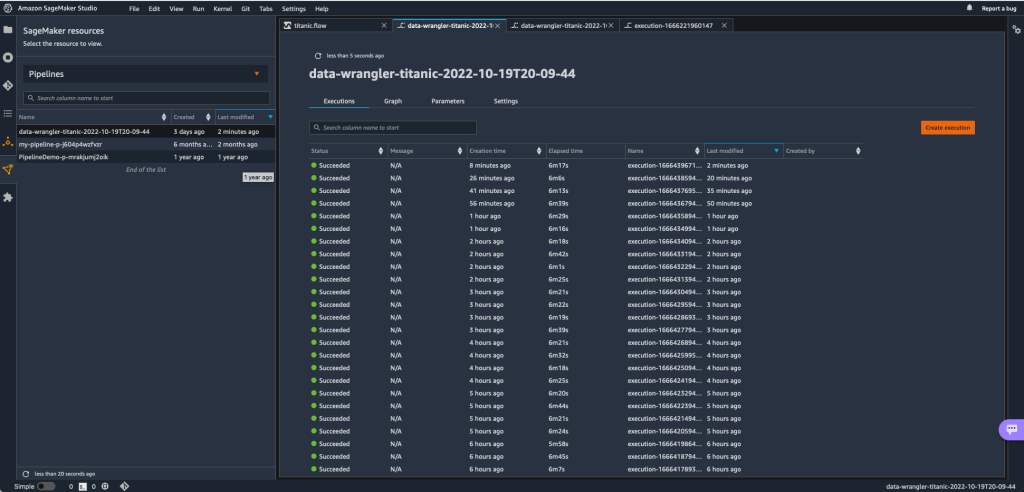

Щоб відстежувати запуски конвеєра SageMaker, ви можете повернутися до Studio, вибрати Ресурси SageMaker піктограму, виберіть Трубопроводиі виберіть назву конвеєра, який потрібно відстежувати. Тепер ви можете побачити таблицю з усіма поточними та минулими запусками та статусом цього конвеєра.

Ви можете побачити більше деталей, двічі клацнувши певний запис.

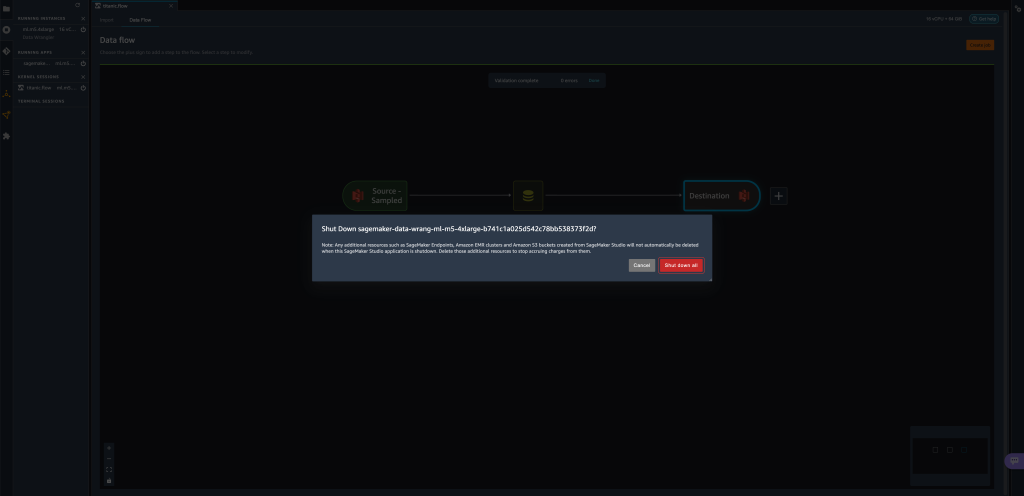

Прибирати

Якщо ви не використовуєте Data Wrangler, радимо вимкнути екземпляр, на якому він працює, щоб уникнути додаткових зборів.

Щоб уникнути втрати роботи, збережіть потік даних, перш ніж вимикати Data Wrangler.

- Щоб зберегти потік даних у Studio, виберіть філе, Потім виберіть Збереження потоку даних Wrangler. Data Wrangler автоматично зберігає ваш потік даних кожні 60 секунд.

- Щоб вимкнути екземпляр Data Wrangler, виберіть у Studio Запуск екземплярів та ядер.

- під ЗАПУЩЕНІ ПРОГРАМИвиберіть піктограму завершення роботи поруч із

sagemaker-data-wrangler-1.0додаток

- Вибирати Вимкнути все підтвердити.

Data Wrangler працює на примірнику ml.m5.4xlarge. Цей екземпляр зникає з ЗАПУСКАНІ ЕКЗЕМПЛЯРИ коли ви закриваєте програму Data Wrangler.

Після завершення роботи програми Data Wrangler її потрібно буде перезапустити, коли ви наступного разу відкриєте файл потоку Data Wrangler. Це може тривати кілька хвилин.

Висновок

У цій публікації ми продемонстрували, як можна використовувати параметри для імпорту наборів даних за допомогою потоків Data Wrangler і створення на них завдань перетворення даних. Параметризовані набори даних забезпечують більшу гнучкість наборів даних, які ви використовуєте, і дозволяють повторно використовувати свої потоки. Ми також продемонстрували, як ви можете налаштувати заплановані завдання для автоматизації перетворення даних і експорту в Amazon S3 або Feature Store у час і з періодичністю, які відповідають вашим потребам, безпосередньо з інтерфейсу користувача Data Wrangler.

Щоб дізнатися більше про використання потоків даних із Data Wrangler, див Створення та використання потоку даних Wrangler та Ціни на Amazon SageMaker. Щоб почати роботу з Data Wrangler, див Підготуйте дані ML за допомогою Amazon SageMaker Data Wrangler.

Про авторів

Девід Ларедо є архітектором прототипування команди прототипування та хмарної інженерії в Amazon Web Services, де він допоміг розробити кілька прототипів машинного навчання для клієнтів AWS. Протягом останніх 6 років він працював у сфері машинного навчання, тренував і налагоджував моделі машинного навчання та впроваджував наскрізні конвеєри для виробництва цих моделей. Сфери його інтересів – НЛП, додатки ML і наскрізне ML.

Девід Ларедо є архітектором прототипування команди прототипування та хмарної інженерії в Amazon Web Services, де він допоміг розробити кілька прототипів машинного навчання для клієнтів AWS. Протягом останніх 6 років він працював у сфері машинного навчання, тренував і налагоджував моделі машинного навчання та впроваджував наскрізні конвеєри для виробництва цих моделей. Сфери його інтересів – НЛП, додатки ML і наскрізне ML.

Гіванільдо Алвес є архітектором прототипування в групі прототипування та хмарної інженерії в Amazon Web Services, допомагаючи клієнтам впроваджувати інновації та прискорюватися, демонструючи мистецтво можливого на AWS, уже реалізувавши кілька прототипів на основі штучного інтелекту. Він має довгу кар’єру в розробці програмного забезпечення, а раніше працював інженером з розробки програмного забезпечення в Amazon.com.br.

Гіванільдо Алвес є архітектором прототипування в групі прототипування та хмарної інженерії в Amazon Web Services, допомагаючи клієнтам впроваджувати інновації та прискорюватися, демонструючи мистецтво можливого на AWS, уже реалізувавши кілька прототипів на основі штучного інтелекту. Він має довгу кар’єру в розробці програмного забезпечення, а раніше працював інженером з розробки програмного забезпечення в Amazon.com.br.

Адріан Фуентес є менеджером програм у групі прототипування та хмарної інженерії Amazon Web Services, впроваджуючи інновації для клієнтів у сфері машинного навчання, Інтернету речей та блокчейну. Він має понад 15 років досвіду управління та реалізації проектів і 1 рік роботи в AWS.

Адріан Фуентес є менеджером програм у групі прототипування та хмарної інженерії Amazon Web Services, впроваджуючи інновації для клієнтів у сфері машинного навчання, Інтернету речей та блокчейну. Він має понад 15 років досвіду управління та реалізації проектів і 1 рік роботи в AWS.

- AI

- ai мистецтво

- AI арт генератор

- ai робот

- Амазонське машинне навчання

- Amazon SageMaker Data Wrangler

- Сповіщення

- штучний інтелект

- сертифікація штучного інтелекту

- штучний інтелект у банківській справі

- робот зі штучним інтелектом

- роботи зі штучним інтелектом

- програмне забезпечення для штучного інтелекту

- AWS Машинне навчання

- blockchain

- блокчейн конференція AI

- coingenius

- розмовний штучний інтелект

- крипто конференція ai

- dall's

- обробка даних

- глибоке навчання

- у вас є гугл

- середній (200)

- навчання за допомогою машини

- Параметризовані набори даних

- plato

- платон ai

- Інформація про дані Платона

- Гра Платон

- PlatoData

- platogaming

- масштаб ai

- Планові роботи

- синтаксис

- Технічні інструкції

- зефірнет