Щоб порадувати клієнтів і мінімізувати відходи упаковки, Amazon має вибрати оптимальний тип упаковки для мільярдів пакунків, що відправляються щороку. Якщо для крихкого предмета, такого як чашка для кави, використовується надто низький рівень захисту, предмет надійде пошкодженим, і Amazon ризикує довірою своїх клієнтів. Використання занадто великої кількості захисту призведе до збільшення витрат і переповнених контейнерів для переробки. Оскільки доступні сотні мільйонів продуктів, необхідний масштабований механізм прийняття рішень, щоб постійно навчатися на основі тестування продуктів і відгуків клієнтів.

Щоб вирішити ці проблеми, команда Amazon Packaging Innovation розробила моделі машинного навчання (ML), які класифікують, чи підходять продукти для таких типів упаковки Amazon, як листівки, пакети чи коробки, чи можуть вони навіть відправлятися без додаткового пакування. Раніше команда розробила спеціальний конвеєр на основі Функції кроку AWS виконувати щотижневі тренінги та щоденні або щомісячні роботи з висновків. Однак з часом конвеєр не забезпечив достатньої гнучкості для запуску моделей з новою архітектурою. Розробка нових конвеєрів представляла накладні витрати та вимагала координації між науковцями та розробниками даних. Щоб подолати ці труднощі та підвищити швидкість розгортання нових моделей і архітектур, команда вирішила організовувати навчання моделей і висновки за допомогою Трубопроводи Amazon SageMaker.

У цій публікації ми обговорюємо попередню архітектуру оркестровки, засновану на покрокових функціях, описуємо архітектури навчання та логічного висновку з використанням конвеєрів, а також підкреслюємо гнучкість, якої досягла команда Amazon Packaging Innovation.

Проблеми колишнього конвеєра ML в Amazon Packaging Innovation

Щоб включити постійний зворотний зв’язок щодо ефективності пакетів, щотижня навчається нова модель із використанням зростаючої кількості міток. Висновок для всього асортименту продуктів виконується щомісяця, а щоденний висновок виконується для надання своєчасних прогнозів для щойно доданого запасу.

Щоб автоматизувати процес навчання кількох моделей і забезпечити прогнози, команда розробила спеціальний конвеєр на основі покрокових функцій для організації наступних кроків:

- Підготовка даних для завдань навчання та висновків і завантаження прогнозів до бази даних (Амазонська червона зміна) з Клей AWS.

- Модельне навчання та умовивід с Amazon SageMaker.

- Розрахунок показників ефективності моделі на перевірочному наборі з Пакет AWS.

- використання Amazon DynamoDB для зберігання конфігурацій моделі (наприклад, коефіцієнта розподілу даних для навчання та перевірки, розташування артефакту моделі, типу моделі та кількості екземплярів для навчання та висновку), показників продуктивності моделі та останньої успішно навченої версії моделі.

- Розрахунок відмінностей у показниках ефективності моделі, змін у розподілі навчальних міток і порівняння розміру вхідних даних між попередньою та новою версіями моделі з AWS Lambda функції.

- Враховуючи велику кількість кроків, трубопровід також вимагав надійної системи сигналізації на кожному етапі, щоб попередити зацікавлених сторін про будь-які проблеми. Це було досягнуто за допомогою комбінації Служба простої черги Amazon (Amazon SQS) та Служба простих сповіщень Amazon (Amazon SNS). Сигнали були створені, щоб сповістити зацікавлених сторін у бізнесі, спеціалістів з обробки даних і розробників про будь-які невдалі кроки та значні відхилення в моделі та показниках даних.

Після використання цього рішення протягом майже 2 років команда зрозуміла, що ця реалізація добре працювала лише для типового робочого процесу машинного навчання, де одна модель була навчена та оцінювалася за набором даних перевірки. Однак рішення не було достатньо гнучким для складних моделей і не було стійким до збоїв. Наприклад, архітектура не легко вміщала послідовне навчання моделі. Було важко додати або видалити крок, не дублюючи весь конвеєр і не змінюючи інфраструктуру. Навіть прості зміни в етапах обробки даних, такі як коригування співвідношення розподілу даних або вибір іншого набору функцій, вимагали координації як від спеціаліста з обробки даних, так і від розробника. Коли конвеєр вийшов з ладу на будь-якому етапі, його потрібно було перезапускати з самого початку, що призводило до повторних запусків і збільшення витрат. Щоб уникнути повторних запусків і необхідності перезапускати з невдалого кроку, команда створить нову копію скороченого кінцевого автомата. Це усунення несправностей призвело до поширення кінцевих автоматів, кожен з яких починався з кроків, які зазвичай виходять з ладу. Нарешті, якщо під час навчальної роботи виявлялося відхилення в розподілі міток, оцінці моделі або кількості міток, фахівець із обробки даних мав переглядати модель та її показники вручну. Потім фахівець із даних отримує доступ до таблиці DynamoDB із версіями моделі та оновлює таблицю, щоб переконатися, що правильна модель використовується для наступного завдання висновку.

Підтримка цієї архітектури вимагала принаймні одного виділеного ресурсу та додаткового штатного ресурсу для розробки. Враховуючи труднощі розширення конвеєра для адаптації до нових варіантів використання, дослідники даних почали розробляти власні робочі процеси, що, у свою чергу, призвело до зростання кодової бази, кількох таблиць даних із подібними схемами даних і децентралізованого моніторингу моделей. Накопичення цих проблем призвело до зниження продуктивності команди та збільшення накладних витрат.

Щоб вирішити ці проблеми, команда Amazon Packaging Innovation оцінила інші існуючі рішення для MLOps, зокрема SageMaker Pipelines (Оголошення про випуск у грудні 2020 року). Pipelines — це можливість SageMaker для створення, керування, автоматизації та масштабування наскрізних робочих процесів машинного навчання. Конвеєри дозволяють зменшити кількість кроків у всьому робочому процесі машинного навчання та є достатньо гнучкими, щоб дозволити дослідникам обробки даних визначати спеціальний робочий процес машинного навчання. Він піклується про моніторинг і реєстрацію кроків. Він також поставляється з реєстром моделей, який автоматично створює версії для нових моделей. Реєстр моделей має вбудовані робочі процеси затвердження для вибору моделей для висновків у виробництві. Конвеєри також дозволяють кешувати кроки, що викликаються з однаковими аргументами. Якщо знайдено попередній запуск, створюється кеш, який дозволяє легко перезапустити замість повторного обчислення успішно виконаних кроків.

У процесі оцінки Pipelines виділявся з-поміж інших рішень своєю гнучкістю та наявністю функцій для підтримки та розширення поточних і майбутніх робочих процесів. Перехід на Pipelines звільнив час розробників від обслуговування платформи та усунення несправностей і спрямував увагу на додавання нових функцій. У цій публікації ми представляємо дизайн робочих процесів навчання та висновків у команді Amazon Packaging Innovation за допомогою конвеєрів. Ми також обговорюємо переваги та скорочення витрат, які команда зрозуміла, перейшовши на Pipelines.

Навчальний конвеєр

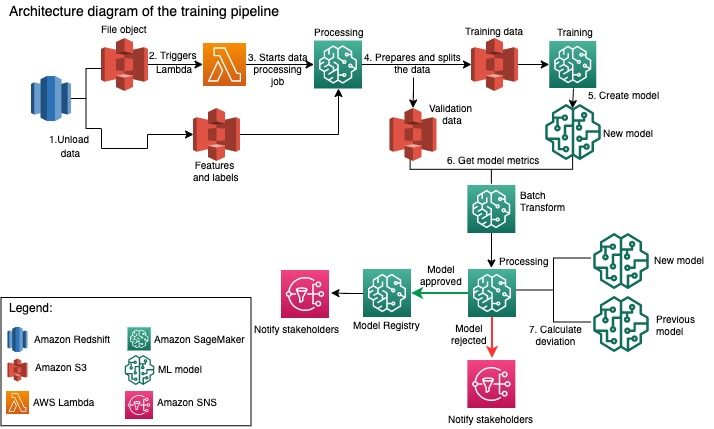

Команда Amazon Packaging Innovation тренує моделі для кожного типу упаковки, використовуючи зростаючу кількість етикеток. На наступній схемі показано весь процес.

Робочий процес починається з вилучення міток і функцій із бази даних Amazon Redshift і вивантаження даних Служба простого зберігання Amazon (Amazon S3) за допомогою запланованого завдання вилучення, перетворення та завантаження (ETL). Разом із вхідними даними у відро S3 поміщається файловий об’єкт із типом моделі та параметрами. Цей файл служить тригером конвеєра через функцію лямбда.

Подальші кроки можна повністю настроїти та повністю визначити спеціаліст із обробки даних за допомогою SageMaker Python SDK for Pipelines. У сценарії, який ми представляємо в цій публікації, вхідні дані розбиваються на набори для навчання та перевірки та зберігаються назад у відро S3 шляхом запуску завдання обробки SageMaker.

Коли дані готові в Amazon S3, починається навчальна робота SageMaker. Після успішного навчання та створення моделі виконується етап оцінки моделі для даних перевірки за допомогою завдання пакетного перетворення SageMaker. Потім показники моделі порівнюються з показниками моделі попереднього тижня за допомогою завдання обробки SageMaker. Команда визначила кілька спеціальних критеріїв для оцінки відхилень у продуктивності моделі. Модель або відхиляється, або схвалюється на основі цих критеріїв. Якщо модель відхилено, попередня схвалена модель використовується для наступних завдань висновку. Якщо модель схвалено, її версія реєструється, і ця модель використовується для завдань логічного висновку. Зацікавлені сторони отримують повідомлення про результат через Amazon CloudWatch сигналізації.

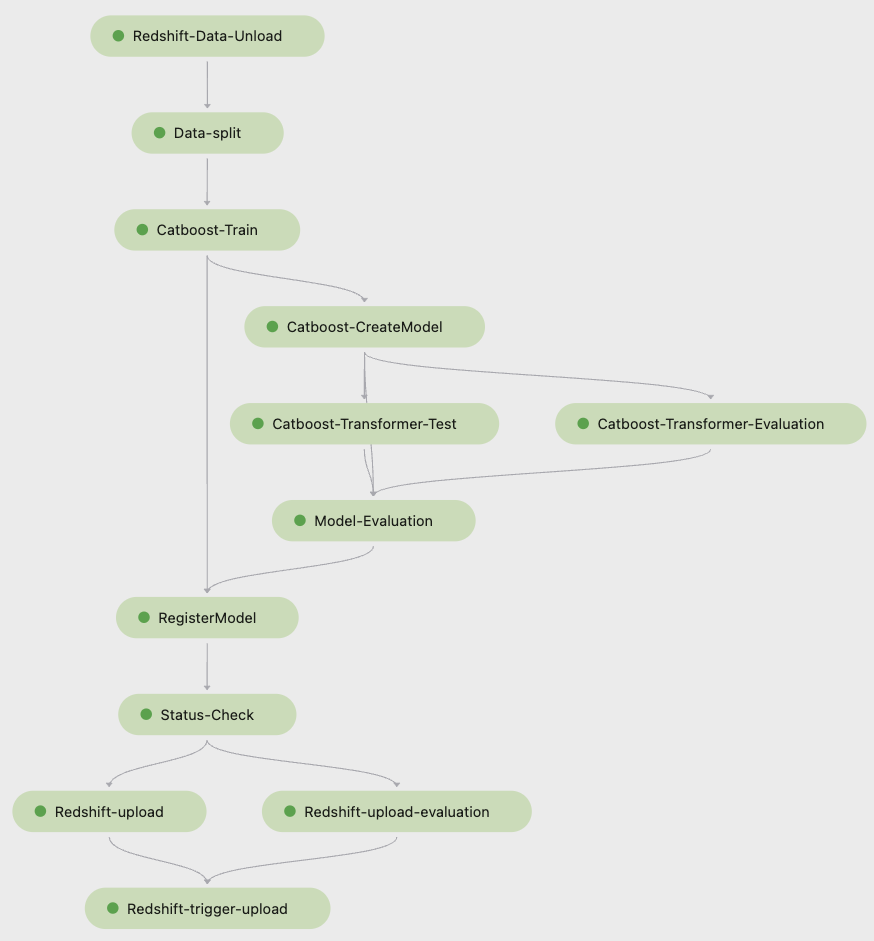

Наступний знімок екрана з Студія Amazon SageMaker показує кроки навчального конвеєра.

Pipelines відстежує кожен запуск конвеєра, який ви можете контролювати в Studio. Крім того, ви можете запитати хід виконання за допомогою Бото3 або Інтерфейс командного рядка AWS (AWS CLI). Ви можете візуалізувати показники моделі в Studio та порівняти різні версії моделі.

Конвеєр для висновків

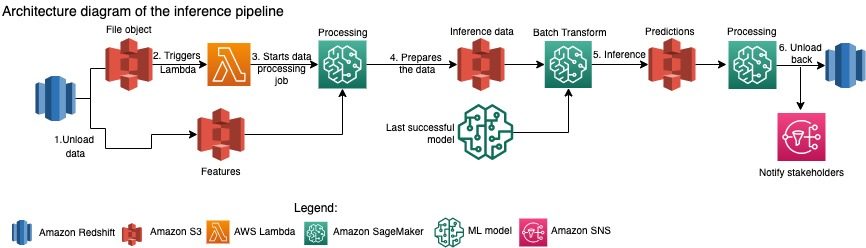

Команда Amazon Packaging Innovation щомісяця оновлює прогнози для всього асортименту продуктів. Щоденні прогнози генеруються, щоб надати своєчасні рекомендації щодо упаковки для щойно доданого інвентарю з використанням останньої навченої моделі. Це вимагає, щоб конвеєр висновків запускався щодня з різними обсягами даних. Наступна діаграма ілюструє цей робочий процес.

Подібно до конвеєра навчання, висновок починається з вивантаження даних із Amazon Redshift у сегмент S3. Файловий об’єкт, розміщений в Amazon S3, запускає функцію Lambda, яка ініціює конвеєр висновку. Функції готуються для висновку, а дані розбиваються на файли відповідного розміру за допомогою завдання обробки SageMaker. Далі конвеєр визначає останню затверджену модель для виконання прогнозів і завантаження їх у сегмент S3. Зрештою, прогнози завантажуються назад в Amazon Redshift за допомогою API даних boto3 у межах завдання обробки SageMaker.

На наступному знімку екрана зі Studio показано деталі конвеєра висновку.

Переваги вибору архітектури робочих процесів машинного навчання за допомогою SageMaker Pipelines

У цьому розділі ми обговорюємо переваги, яких досягла команда Amazon Packaging Innovation, перейшовши на конвеєри для навчання моделей і висновків.

Готові функції MLOps виробничого рівня

Порівнюючи різні внутрішні та зовнішні рішення для наступного конвеєрного рішення ML, один фахівець із обробки даних зміг створити прототип і розробити повну версію робочого процесу ML із Pipelines у середовищі Studio Jupyter менш ніж за 3 тижні. Навіть на етапі прототипування стало зрозуміло, що Pipelines забезпечує всі необхідні компоненти інфраструктури, необхідні для робочого процесу на виробничому рівні: версії моделі, кешування та сигнали тривоги. Негайна доступність цих функцій означала, що не витрачався додатковий час на їх розробку та налаштування. Це була чітка демонстрація цінності, яка переконала команду Amazon Packaging Innovation, що Pipelines — це правильне рішення.

Гнучкість у розробці моделей ML

Найбільшою перевагою для дослідників даних у команді стала можливість легко експериментувати та переглядати різні моделі. Незалежно від того, яку структуру вони віддали перевагу для своєї роботи з машинного навчання та кількість кроків і функцій, які вона включає, Pipelines задовольнила їхні потреби. Фахівці з обробки даних отримали можливість експериментувати, не чекаючи спринту розробки програмного забезпечення, щоб додати додаткову функцію чи крок.

Скорочені витрати

Можливість конвеєрів SageMaker є безкоштовно: ви платите лише за обчислювальні ресурси та пам’ять, пов’язану з навчанням і висновками. Однак, думаючи про вартість, вам потрібно враховувати не лише вартість використаних послуг, але й години розробника, необхідні для підтримки робочого процесу, налагодження та виправлення. Оркестрування за допомогою конвеєрів простіше, оскільки воно складається з меншої кількості частин і знайомої інфраструктури. Раніше для впровадження нової функції потрібно було принаймні двох людей (фахівця з обробки даних та інженера-програміста) з команди Amazon Packaging Innovation. З переробленим конвеєром зусилля інженерів тепер спрямовані на додаткову спеціальну інфраструктуру навколо конвеєра, таку як створення єдиного сховища для відстеження коду машинного навчання, спрощення розгортання моделі в облікових записах AWS, розробка інтегрованих завдань ETL і спільних багаторазові функції.

Здатність кешувати кроки з подібними вхідними даними також сприяла зниженню витрат, оскільки команди мали менше шансів повторно запустити весь конвеєр. Натомість вони могли легко розпочати це з точки невдачі.

Висновок

Команда Amazon Packaging Innovation щомісяця навчає моделі ML і регулярно оновлює прогнози щодо рекомендованих типів упаковки продуктів. Ці рекомендації допомогли їм досягти багатьох цілей для команди та всієї компанії, зменшивши відходи та радуючи клієнтів кожним замовленням. Конвеєри навчання та висновків повинні працювати надійно на регулярній основі, але дозволяти постійне вдосконалення моделей.

Перехід до Pipelines дозволив команді розгорнути чотири нові архітектури мультимодальної моделі для виробництва менш ніж за 2 місяці. Для розгортання нової моделі з використанням попередньої архітектури знадобилося б від 5 днів (з такою ж архітектурою моделі) до 1 місяця (з новою архітектурою моделі). Розгортання тієї самої моделі за допомогою конвеєрів дозволило команді скоротити час розробки до 4 годин із тією самою архітектурою моделі та до 5 днів із новою архітектурою моделі. Це означає економію майже 80% робочого часу.

Додаткові ресурси

Для отримання додаткової інформації див. такі ресурси:

Про авторів

Анкур Шукла є головним спеціалістом з обробки даних в AWS-ProServe, розташованому в Пало-Альто. Анкур має понад 15 років консультаційного досвіду, працюючи безпосередньо з клієнтами та допомагаючи їм вирішити бізнес-проблеми з технологіями. Він керує кількома глобальними ініціативами з прикладної науки та ML-Ops в AWS. У вільний час любить читати та проводити час із родиною.

Анкур Шукла є головним спеціалістом з обробки даних в AWS-ProServe, розташованому в Пало-Альто. Анкур має понад 15 років консультаційного досвіду, працюючи безпосередньо з клієнтами та допомагаючи їм вирішити бізнес-проблеми з технологіями. Він керує кількома глобальними ініціативами з прикладної науки та ML-Ops в AWS. У вільний час любить читати та проводити час із родиною.

Акаш Сінгла є старшим системним інженером у команді Amazon Packaging Innovation. Він має понад 17 років досвіду вирішення критичних бізнес-проблем за допомогою технологій для кількох бізнес-вертикалей. Зараз він зосереджується на модернізації інфраструктури NAWS для різноманітних додатків, орієнтованих на упаковку, щоб краще їх масштабувати.

Акаш Сінгла є старшим системним інженером у команді Amazon Packaging Innovation. Він має понад 17 років досвіду вирішення критичних бізнес-проблем за допомогою технологій для кількох бізнес-вертикалей. Зараз він зосереджується на модернізації інфраструктури NAWS для різноманітних додатків, орієнтованих на упаковку, щоб краще їх масштабувати.

Віталіна Комашко є спеціалістом із обробки даних у AWS Professional Services. Вона має ступінь доктора філософії з фармакології та токсикології, але перейшла до науки про дані з експериментальної роботи, оскільки хотіла «власноруч генерувати дані та інтерпретувати результати». На початку своєї кар’єри вона працювала з біотехнологічними та фармацевтичними компаніями. В AWS їй подобається вирішувати проблеми клієнтів з різних галузей і дізнаватися про їхні унікальні проблеми.

Віталіна Комашко є спеціалістом із обробки даних у AWS Professional Services. Вона має ступінь доктора філософії з фармакології та токсикології, але перейшла до науки про дані з експериментальної роботи, оскільки хотіла «власноруч генерувати дані та інтерпретувати результати». На початку своєї кар’єри вона працювала з біотехнологічними та фармацевтичними компаніями. В AWS їй подобається вирішувати проблеми клієнтів з різних галузей і дізнаватися про їхні унікальні проблеми.

Прасант Мейяппан є старшим науковим співробітником Amazon Packaging Innovation протягом 4+ років. Він має понад 6 років досвіду роботи в машинному навчанні та постачає продукти для покращення взаємодії з клієнтами в пошуку та покращення досвіду пакування клієнтів. Прасант захоплений питаннями сталого розвитку та має ступінь доктора філософії зі статистичного моделювання зміни клімату.

Прасант Мейяппан є старшим науковим співробітником Amazon Packaging Innovation протягом 4+ років. Він має понад 6 років досвіду роботи в машинному навчанні та постачає продукти для покращення взаємодії з клієнтами в пошуку та покращення досвіду пакування клієнтів. Прасант захоплений питаннями сталого розвитку та має ступінь доктора філософії зі статистичного моделювання зміни клімату.

Метью Бейлз є старшим науковим співробітником, який працює над оптимізацією вибору типу упаковки за допомогою відгуків клієнтів і машинного навчання. До роботи в Amazon Метт працював постдоктором, виконуючи моделювання фізики елементарних частинок у Німеччині, а в минулому житті був керівником виробництва радіоактивних медичних імплантатів у стартапі. Має ступінь доктора філософії. доктор фізики Мічиганського університету.

Метью Бейлз є старшим науковим співробітником, який працює над оптимізацією вибору типу упаковки за допомогою відгуків клієнтів і машинного навчання. До роботи в Amazon Метт працював постдоктором, виконуючи моделювання фізики елементарних частинок у Німеччині, а в минулому житті був керівником виробництва радіоактивних медичних імплантатів у стартапі. Має ступінь доктора філософії. доктор фізики Мічиганського університету.

- AI

- ai мистецтво

- AI арт генератор

- ai робот

- Amazon SageMaker

- штучний інтелект

- сертифікація штучного інтелекту

- штучний інтелект у банківській справі

- робот зі штучним інтелектом

- роботи зі штучним інтелектом

- програмне забезпечення для штучного інтелекту

- AWS Машинне навчання

- blockchain

- блокчейн конференція AI

- coingenius

- розмовний штучний інтелект

- крипто конференція ai

- Рішення для клієнтів

- dall's

- глибоке навчання

- у вас є гугл

- навчання за допомогою машини

- plato

- платон ai

- Інформація про дані Платона

- Гра Платон

- PlatoData

- platogaming

- масштаб ai

- Sustainability

- синтаксис

- зефірнет