1IRIF، CNRS - یونیورسٹی پیرس سٹی، فرانس

2کیو سی ویئر، پالو آلٹو، امریکہ اور پیرس، فرانس

3سکول آف انفارمیٹکس، یونیورسٹی آف ایڈنبرا، سکاٹ لینڈ، یوکے

4F. Hoffmann La Roche AG

اس کاغذ کو دلچسپ لگتا ہے یا اس پر بات کرنا چاہتے ہیں؟ SciRate پر تبصرہ کریں یا چھوڑیں۔.

خلاصہ

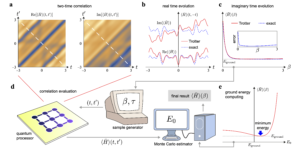

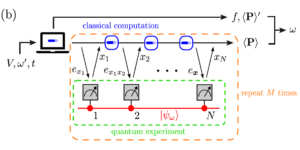

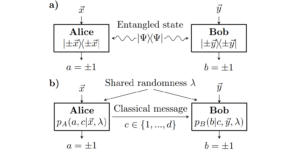

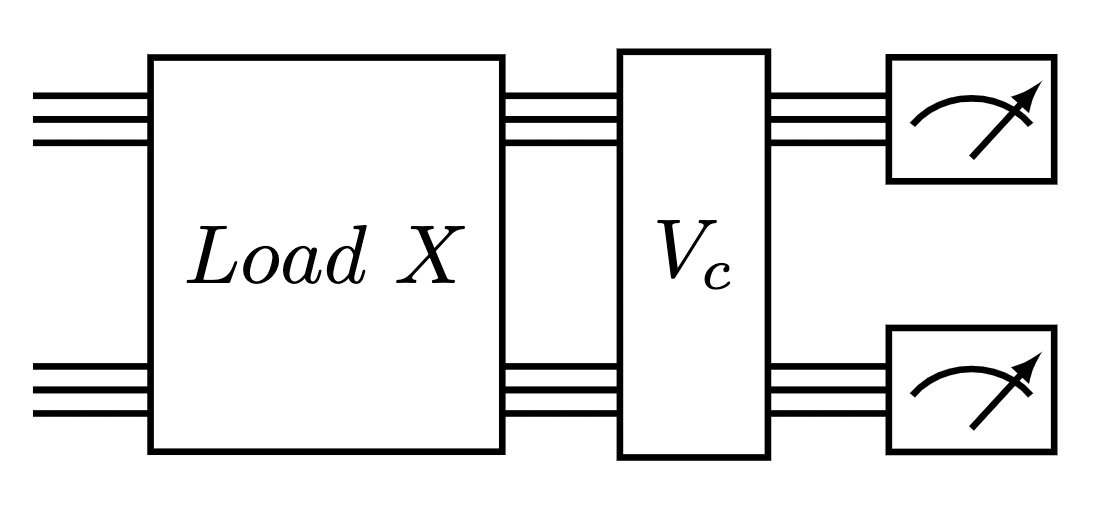

اس کام میں، کوانٹم ٹرانسفارمرز کو جدید ترین کلاسیکی ٹرانسفارمر نیورل نیٹ ورک آرکیٹیکچرز کو بڑھا کر تفصیل سے ڈیزائن اور تجزیہ کیا جاتا ہے جو قدرتی زبان کی پروسیسنگ اور تصویری تجزیہ میں بہت کارآمد ثابت ہوتے ہیں۔ پچھلے کام کی بنیاد پر، جو ڈیٹا لوڈنگ اور آرتھوگونل نیورل لیئرز کے لیے پیرامیٹرائزڈ کوانٹم سرکٹس کا استعمال کرتا ہے، ہم ٹریننگ اور انفرنس کے لیے تین قسم کے کوانٹم ٹرانسفارمرز متعارف کراتے ہیں، بشمول کمپاؤنڈ میٹرکس پر مبنی کوانٹم ٹرانسفارمر، جو کوانٹم توجہ کے طریقہ کار کے نظریاتی فائدہ کی ضمانت دیتا ہے۔ اسیمپٹوٹک رن ٹائم اور ماڈل پیرامیٹرز کی تعداد کے لحاظ سے ان کے کلاسیکی ہم منصب کے مقابلے میں۔ یہ کوانٹم آرکیٹیکچر اتلی کوانٹم سرکٹس کا استعمال کرتے ہوئے بنائے جا سکتے ہیں اور معیار کے لحاظ سے مختلف درجہ بندی کے ماڈل تیار کر سکتے ہیں۔ تین مجوزہ کوانٹم توجہ کی پرتیں کلاسیکی ٹرانسفارمرز کو قریب سے پیروی کرنے اور زیادہ کوانٹم خصوصیات کی نمائش کے درمیان سپیکٹرم پر مختلف ہوتی ہیں۔ کوانٹم ٹرانسفارمر کے بلڈنگ بلاکس کے طور پر، ہم میٹرکس کو کوانٹم سٹیٹس کے طور پر لوڈ کرنے کے لیے ایک نیا طریقہ تجویز کرتے ہیں اور ساتھ ہی دو نئی قابل تربیت کوانٹم آرتھوگونل پرتیں جو کنیکٹوٹی کی مختلف سطحوں اور کوانٹم کمپیوٹرز کے معیار کے لیے قابل اطلاق ہوں۔ ہم نے معیاری میڈیکل امیج ڈیٹاسیٹس پر کوانٹم ٹرانسفارمرز کی وسیع نقلی کارکردگی کا مظاہرہ کیا جو مسابقتی طور پر دکھائے گئے، اور بعض اوقات کلاسیکی بینچ مارکس کے مقابلے میں بہتر کارکردگی، بشمول بہترین کلاسیکل وژن ٹرانسفارمرز۔ ان چھوٹے پیمانے کے ڈیٹاسیٹس پر ہم نے جن کوانٹم ٹرانسفارمرز کو تربیت دی ہے ان کے لیے معیاری کلاسیکل بینچ مارکس کے مقابلے میں کم پیرامیٹرز درکار ہیں۔ آخر میں، ہم نے اپنے کوانٹم ٹرانسفارمرز کو سپر کنڈکٹنگ کوانٹم کمپیوٹرز پر لاگو کیا اور چھ کوبٹ تجربات کے حوصلہ افزا نتائج حاصل کیے۔

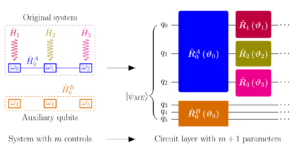

نمایاں تصویر: کوانٹم سرکٹ کمپاؤنڈ ٹرانسفارمر کی ایک توجہ کی تہہ پر عمل کرنے کے لیے۔ ایک میٹرکس ڈیٹا لوڈر جس کے بعد آرتھوگونل کوانٹم پرت ہوتی ہے۔

مقبول خلاصہ

► BibTeX ڈیٹا

► حوالہ جات

ہے [1] جیکب بیامونٹے، پیٹر وٹیک، نکولا پینکوٹی، پیٹرک ریبینٹروسٹ، ناتھن ویبی، اور سیٹھ لائیڈ۔ "کوانٹم مشین لرننگ"۔ فطرت 549، 195–202 (2017)۔

https://doi.org/10.1038/nature23474

ہے [2] Iris Cong، Soonwon Choi، اور Mikhail D Lukin. "کوانٹم کنولوشنل نیورل نیٹ ورکس"۔ نیچر فزکس 15، 1273–1278 (2019)۔

https://doi.org/10.1038/s41567-019-0648-8

ہے [3] کشور بھارتی، البا سرویرا لیرٹا، تھی ہا کیاو، ٹوبیاس ہاگ، سمنر الپرین لی، ابھینو آنند، میتھیاس ڈیگروٹ، ہرمننی ہیمونن، جیکب ایس کوٹ مین، ٹم مینکے، وغیرہ۔ "شور انٹرمیڈیٹ اسکیل کوانٹم الگورتھم"۔ جدید طبیعیات کے جائزے 94، 015004 (2022)۔

https:///doi.org/10.1103/RevModPhys.94.015004

ہے [4] Marco Cerezo، Andrew Arrasmith، Ryan Babbush، Simon C Benjamin، Suguru Endo، Keisuke Fujii، Jarrod R McClean، Kosuke Mitarai، Xiao Yuan، Lukasz Cincio، et al. "متغیر کوانٹم الگورتھم"۔ فطرت کا جائزہ طبیعیات 3، 625–644 (2021)۔

https://doi.org/10.1038/s42254-021-00348-9

ہے [5] Jonas Landman، Natansh Mathur، Yun Yvonna Li، Martin Strahm، Skander Kazdaghli، Anupam Prakash، اور Iordanis Kerenidis۔ "نیورل نیٹ ورکس کے لیے کوانٹم طریقے اور طبی امیج کی درجہ بندی کے لیے اطلاق"۔ کوانٹم 6، 881 (2022)۔

https://doi.org/10.22331/q-2022-12-22-881

ہے [6] بوبک کیانی، رینڈل بیلسٹریو، یان لیکون، اور سیٹھ لائیڈ۔ "پروجن: یونیٹری میٹرکس کے ساتھ گہرے نیٹ ورکس کی تربیت کا موثر طریقہ"۔ نیورل انفارمیشن پروسیسنگ سسٹمز میں پیشرفت 35، 14448–14463 (2022)۔

ہے [7] آشیش واسوانی، نوم شازیر، نکی پرمار، جیکب اسزکوریٹ، لیون جونز، ایڈن این گومز، لوکاز قیصر، اور الیا پولوسوخن۔ "توجہ صرف آپ کی ضرورت ہے"۔ نیورل انفارمیشن پروسیسنگ سسٹم میں پیشرفت 30 (2017)۔

ہے [8] جیکب ڈیولن، منگ وی چانگ، کینٹن لی، اور کرسٹینا ٹوٹانووا۔ "برٹ: زبان کی تفہیم کے لیے گہرے دو طرفہ ٹرانسفارمرز کی پری ٹریننگ" (2018)۔

ہے [9] Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mustafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit, and Neil Houlsby. "ایک تصویر کی قیمت 16×16 الفاظ ہے: پیمانے پر تصویر کی شناخت کے لیے ٹرانسفارمرز"۔ سیکھنے کی نمائندگی پر بین الاقوامی کانفرنس (2021)۔ url: openreview.net/forum?id=YicbFdNTTy۔

https://openreview.net/forum?id=YicbFdNTTy

ہے [10] یی طائی، مصطفی دہغنی، دارا بہری، اور ڈونلڈ میٹزلر۔ "موثر ٹرانسفارمرز: ایک سروے"۔ ACM کمپیوٹنگ سروے (CSUR) (2020)۔

https://doi.org/10.1145/3530811

ہے [11] Dzmitry Bahdanau، Kyunghyun Cho، اور Yoshua Bengio۔ "Neural Machine Translation by Jointly Learning to Align and Translate" (2016)۔ arXiv:1409.0473 [cs, stat]۔

آر ایکس سی: 1409.0473

ہے [12] J. Schmidhuber. "مکمل طور پر ریکرنٹ نیٹ میں سیکھنے کی پیچیدگی اور وقت کے مختلف ہونے والے متغیرات کی تعداد کے درمیان تناسب کو کم کرنا"۔ Stan Gielen اور Bert Kappen میں، ایڈیٹرز، ICANN '93۔ صفحات 460–463۔ لندن (1993)۔ اسپرنگر۔

https://doi.org/10.1007/978-1-4471-2063-6_110

ہے [13] یورگن شمڈوبر۔ "تیز وزن کی یادوں کو کنٹرول کرنا سیکھنا: متحرک ریکرنٹ نیٹ ورکس کا متبادل"۔ نیورل کمپیوٹیشن 4، 131–139 (1992)۔

https://doi.org/10.1162/neco.1992.4.1.131

ہے [14] پیٹر چا، پال گینسپارگ، فیلکس وو، جوآن کاراسکویلا، پیٹر ایل میک موہن، اور یون آہ کم۔ "توجہ پر مبنی کوانٹم ٹوموگرافی"۔ مشین لرننگ: سائنس اور ٹیکنالوجی 3, 01LT01 (2021)۔

https://doi.org/10.1088/2632-2153/ac362b

ہے [15] Riccardo Di Sipio، Jia-Hong Huang، Samuel Yen-chi Chen، Stefano Mangini، اور Marcel Worring۔ "کوانٹم نیچرل لینگویج پروسیسنگ کا آغاز"۔ ICASSP 2022-2022 میں IEEE انٹرنیشنل کانفرنس آن ایکوسٹکس، سپیچ اینڈ سگنل پروسیسنگ (ICASSP)۔ صفحات 8612–8616۔ IEEE (2022)۔

https://doi.org/10.1109/ICASSP43922.2022.9747675

ہے [16] گوانگسی لی، شوانکیانگ ژاؤ، اور ژن وانگ۔ "متن کی درجہ بندی کے لیے کوانٹم خود توجہ دینے والے نیورل نیٹ ورکس" (2022)۔

ہے [17] فیبیو سانچس، شان وینبرگ، تاکانوری آئیڈی، اور کازومتسو کامیا۔ "گاڑی کی روٹنگ کے مسئلے کے لیے کمک سیکھنے کی پالیسیوں میں شارٹ کوانٹم سرکٹس"۔ جسمانی جائزہ A 105, 062403 (2022)۔

https:///doi.org/10.1103/PhysRevA.105.062403

ہے [18] یوآن فو یانگ اور من سن۔ "ہائبرڈ کلاسیکل کوانٹم ڈیپ لرننگ کے ذریعے سیمی کنڈکٹر کی خرابی کا پتہ لگانا"۔ CVPRPages 2313–2322 (2022)۔

https:///doi.org/10.1109/CVPR52688.2022.00236

ہے [19] میکسویل ہینڈرسن، سمردھی شاکیا، ششیندرا پردھان، اور ٹرسٹن کک۔ "کوانوولوشنل نیورل نیٹ ورکس: کوانٹم سرکٹس کے ساتھ تصویری شناخت کو طاقت بخشنا"۔ کوانٹم مشین انٹیلی جنس 2، 1–9 (2020)۔

https://doi.org/10.1007/s42484-020-00012-y

ہے [20] ایڈورڈ فرہی اور ہارٹمٹ نیوین۔ "قریب مدتی پروسیسرز پر کوانٹم نیورل نیٹ ورکس کے ساتھ درجہ بندی" (2018)۔ url: doi.org/10.48550/arXiv.1802.06002۔

https://doi.org/10.48550/arXiv.1802.06002

ہے [21] Kosuke Mitarai، Makoto Negoro، Masahiro Kitagawa، اور Keisuke Fujii۔ "کوانٹم سرکٹ لرننگ"۔ جسمانی جائزہ A 98، 032309 (2018)۔

https:///doi.org/10.1103/PhysRevA.98.032309

ہے [22] کوی جیا، شوائی لی، یوکسین وین، ٹونگلیانگ لیو، اور داچینگ تاؤ۔ "آرتھوگونل ڈیپ نیورل نیٹ ورکس"۔ پیٹرن تجزیہ اور مشین انٹیلی جنس (2019) پر IEEE لین دین۔

https://doi.org/10.1109/TPAMI.2019.2948352

ہے [23] راجر اے ہارن اور چارلس آر جانسن۔ "میٹرکس تجزیہ"۔ کیمبرج یونیورسٹی پریس۔ (2012)۔

https://doi.org/10.1017/CBO9780511810817

ہے [24] Iordanis Kerenidis اور انوپم پرکاش۔ "سب اسپیس سٹیٹس کے ساتھ کوانٹم مشین لرننگ" (2022)۔

ہے [25] Brooks Foxen، Charles Neill، Andrew Dunsworth، Pedram Roushan، Ben Chiaro، Anthony Megrant، Julian Kelly، Zijun Chen، Kevin Satzinger، Rami Barends، et al. "قریب مدتی کوانٹم الگورتھم کے لیے دو کیوبٹ گیٹس کے مسلسل سیٹ کا مظاہرہ کرنا"۔ جسمانی جائزہ کے خطوط 125, 120504 (2020)۔

https:///doi.org/10.1103/PhysRevLett.125.120504

ہے [26] سونیکا جوہری، شانتنو دیبناتھ، اویناش موچرلا، الیگزینڈروس سنگک، انوپم پرکاش، جنگسانگ کم، اور ایوردانیس کیرینیڈس۔ "ایک پھنسے ہوئے آئن کوانٹم کمپیوٹر پر قریب ترین سینٹروڈ درجہ بندی"۔ npj کوانٹم معلومات 7, 122 (2021)۔

https://doi.org/10.1038/s41534-021-00456-5

ہے [27] جیمز ڈبلیو کولی اور جان ڈبلیو ٹوکی۔ "پیچیدہ فورئر سیریز کی مشین کیلکولیشن کے لیے الگورتھم"۔ حساب کی ریاضی 19، 297–301 (1965)۔

https://doi.org/10.1090/S0025-5718-1965-0178586-1

ہے [28] لی جینگ، یچن شین، ٹینا ڈبسیک، جان پیوریفائے، سکاٹ اے اسکرلو، یان لیکون، میکس ٹیگ مارک، اور مارین سولجیک۔ "ٹیون ایبل موثر یونٹری نیورل نیٹ ورکس (ایون) اور ان کا rnns پر اطلاق"۔ مشین لرننگ پر بین الاقوامی کانفرنس میں۔ (2016)۔ url: api.semanticscholar.org/CorpusID:5287947۔

https:///api.semanticscholar.org/CorpusID:5287947

ہے [29] Léo Monbroussou، Jonas Landman، Alex B. Grilo، Romain Kukla، اور Elham Kashefi۔ "مشین لرننگ کے لیے کوانٹم سرکٹس کو محفوظ رکھنے والے ہیمنگ ویٹ کی تربیت اور اظہاریت" (2023)۔ arXiv:2309.15547۔

آر ایکس سی: 2309.15547

ہے [30] اینریکو فونٹانا، ڈیلن ہرمن، شوانک چکربرتی، نیرج کمار، رومینا یالوویٹزکی، جیمی ہیریج، شری ہری سریش بابو، اور مارکو پسٹویا۔ "ملحقہ وہی ہے جس کی آپ کو ضرورت ہے: کوانٹم اینسیٹز میں بنجر سطح مرتفع کی خصوصیت" (2023)۔ arXiv:2309.07902۔

آر ایکس سی: 2309.07902

ہے [31] مائیکل راگون، بوجکو این باکالوف، فریڈرک ساویج، الیگزینڈر ایف کیمپر، کارلوس اورٹیز ماریرو، مارٹن لاروکا، اور ایم سیریزو۔ "گہری پیرامیٹرائزڈ کوانٹم سرکٹس کے لیے بنجر سطح مرتفع کا ایک متفقہ نظریہ" (2023)۔ arXiv:2309.09342۔

آر ایکس سی: 2309.09342

ہے [32] Xuchen You اور Xiaodi Wu. "کوانٹم نیورل نیٹ ورکس میں تیزی سے بہت سے مقامی منیما"۔ مشین لرننگ پر بین الاقوامی کانفرنس میں۔ صفحات 12144–12155۔ PMLR (2021)۔

ہے [33] ایرک آر اینشوئٹز اور بوبک توسی کیانی۔ "کوانٹم تغیراتی الگورتھم جال سے بھرے ہوئے ہیں"۔ نیچر کمیونیکیشنز 13 (2022)۔

https://doi.org/10.1038/s41467-022-35364-5

ہے [34] Ilya O. Tolstikhin, Neil Houlsby, Alexander Kolesnikov, Lucas Beyer, Xiaohua Zhai, Thomas Unterthiner, Jessica Yung, Daniel Keysers, Jakob Uszkoreit, Mario Lucic, and Alexey Dosovitskiy۔ "ایم ایل پی مکسر: وژن کے لیے ایک آل ایم ایل پی فن تعمیر"۔ نیور آئی پی ایس میں۔ (2021)۔

ہے [35] جیانچینگ یانگ، روئی شی، اور بنگ بنگ نی۔ "میڈمنسٹ کی درجہ بندی ڈیکاتھلون: طبی تصویر کے تجزیہ کے لیے ایک ہلکا پھلکا آٹومل بینچ مارک" (2020)۔

https://doi.org/10.1109/ISBI48211.2021.9434062

ہے [36] جیانچینگ یانگ، روئی شی، ڈونگلائی وی، زیکوان لیو، لن ژاؤ، بلیان کے، ہینسپیٹر فائسٹر، اور بنگ بنگ نی۔ "Medmnist v2-2d اور 3d بائیو میڈیکل امیج کی درجہ بندی کے لیے ایک بڑے پیمانے پر ہلکا پھلکا بینچ مارک"۔ سائنسی ڈیٹا 10، 41 (2023)۔

https://doi.org/10.1038/s41597-022-01721-8

ہے [37] اینجلوس کتھاروپولوس، اپورو ویاس، نیکولاس پاپاس، اور فرانکوئس فلوریٹ۔ "ٹرانسفارمرز آر این این ایس ہیں: لکیری توجہ کے ساتھ تیز آٹوریگریسو ٹرانسفارمرز"۔ مشین لرننگ پر بین الاقوامی کانفرنس میں۔ صفحات 5156–5165۔ PMLR (2020)۔

ہے [38] جیمز بریڈبری، رائے فروسٹیگ، پیٹر ہاکنز، میتھیو جیمز جانسن، کرس لیری، ڈوگل میکلورین، جارج نیکولا، ایڈم پاسزکے، جیک وانڈر پلاس، اسکائی وانڈرمین-ملنے، اور کیاو ژانگ۔ "JAX: Python + NumPy پروگراموں کی کمپوز ایبل تبدیلیاں"۔ گیتھب (2018)۔ url: http:///github.com/google/jax۔

http:///github.com/google/jax

ہے [39] ڈیڈرک پی کنگما اور جمی با۔ "آدم: اسٹاکسٹک آپٹیمائزیشن کا ایک طریقہ"۔ CoRR abs/1412.6980 (2015)۔

ہے [40] Hyeonwoo Noh، Tackgeun You، Jonghwan Mun، اور Bohyung Han۔ "شور کے ذریعہ گہرے اعصابی نیٹ ورکس کو باقاعدہ بنانا: اس کی تشریح اور اصلاح"۔ نیور آئی پی ایس (2017)۔

ہے [41] زیو ینگ۔ "اوور فٹنگ اور اس کے حل کا ایک جائزہ"۔ جرنل آف فزکس میں: کانفرنس سیریز۔ جلد 1168، صفحہ 022022۔ IOP پبلشنگ (2019)۔

https://doi.org/10.1088/1742-6596/1168/2/022022

کی طرف سے حوالہ دیا گیا

[1] David Peral García، Juan Cruz-Benito، اور Francisco José García-Peñalvo، "سسٹمیٹک لٹریچر ریویو: کوانٹم مشین لرننگ اور اس کی ایپلی کیشنز"، آر ایکس سی: 2201.04093, (2022).

[2] ایل امائن چیراٹ، اسنیہل راج، ایوردانیس کیرینیڈس، ابھیشیک شیکھر، بین ووڈ، جون ڈی، شووانک چکربرتی، رچرڈ چن، ڈیلن ہرمن، شاون ہو، پیئر منسن، رسلان شیڈولن، یو سن، رومینا یالوویٹزکی، اور مارکو اسٹوکیا۔ "کوانٹم ڈیپ ہیجنگ"، کوانٹم 7, 1191 (2023).

[3] Léo Monbroussou, Jonas Landman, Alex B. Grilo, Romain Kukla, and Elham Kashefi, "Trainability and expressivity of Hamming-weight preserving Quantum Circuits for Machine Learning", آر ایکس سی: 2309.15547, (2023).

[4] سوہم ٹھاکر، سکندر کازداغلی، نتنش ماتھر، آئرڈینس کیرینیڈس، آندرے جے فریرا-مارٹنز، اور سامورائی بریٹو، "کوانٹم مشین لرننگ کے ذریعے بہتر مالی پیشن گوئی"، آر ایکس سی: 2306.12965, (2023).

[5] جیسن آئیکونس اور سونیکا جوہری، "ٹینسر نیٹ ورک پر مبنی موثر کوانٹم ڈیٹا لوڈنگ آف امیجز"، آر ایکس سی: 2310.05897, (2023).

[6] نشانت جین، جوناس لینڈ مین، نتنش ماتھر، اور Iordanis Kerenidis، "پیرامیٹرک PDEs کو حل کرنے کے لیے کوانٹم فوئیر نیٹ ورکس"، آر ایکس سی: 2306.15415, (2023).

[7] ڈینیل ماستروپیٹرو، جارجیوس کورپاس، ویاچسلاو کنگورتسیف، اور جیکب ماریسیک، "فلیمنگ-وائیوٹ بنجر سطح مرتفع کی موجودگی میں تغیراتی کوانٹم الگورتھم کو تیز کرنے میں مدد کرتا ہے"، آر ایکس سی: 2311.18090, (2023).

[8] علیزا یو صدیقی، کیٹلن گیلی، اور کرس بیلنس، "اسٹریسنگ آؤٹ ماڈرن کوانٹم ہارڈ ویئر: پرفارمنس ایویلیوایشن اینڈ ایگزیکیوشن انسائٹس"، آر ایکس سی: 2401.13793, (2024).

مذکورہ بالا اقتباسات سے ہیں۔ SAO/NASA ADS (آخری بار کامیابی کے ساتھ 2024-02-22 13:37:43)۔ فہرست نامکمل ہو سکتی ہے کیونکہ تمام ناشرین مناسب اور مکمل حوالہ ڈیٹا فراہم نہیں کرتے ہیں۔

نہیں لا سکا کراس ریف کا حوالہ دیا گیا ڈیٹا آخری کوشش کے دوران 2024-02-22 13:37:41: Crossref سے 10.22331/q-2024-02-22-1265 کے لیے حوالہ کردہ ڈیٹا حاصل نہیں کیا جا سکا۔ یہ عام بات ہے اگر DOI حال ہی میں رجسٹر کیا گیا ہو۔

یہ مقالہ کوانٹم میں کے تحت شائع کیا گیا ہے۔ Creative Commons انتساب 4.0 انٹرنیشنل (CC BY 4.0) لائسنس کاپی رائٹ اصل کاپی رائٹ ہولڈرز جیسے مصنفین یا ان کے اداروں کے پاس رہتا ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://quantum-journal.org/papers/q-2024-02-22-1265/

- : ہے

- : نہیں

- ][p

- $UP

- 1

- 10

- 11

- 12

- 125

- 13

- 14

- 15٪

- 16

- 17

- 19

- 20

- 2012

- 2015

- 2016

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 2024

- 22

- 23

- 24

- 25

- 26٪

- 27

- 28

- 29

- 2D

- 30

- 31

- 32

- 33

- 35٪

- 36

- 39

- 3d

- 40

- 41

- 43

- 7

- 8

- 9

- 98

- a

- اوپر

- خلاصہ

- تک رسائی حاصل

- ACM

- آدم

- اس کے علاوہ

- ترقی

- فائدہ

- فوائد

- وابستگیاں

- AL

- یلیکس

- الیگزینڈر

- یلگورتم

- یلگوردمز

- سیدھ کریں

- تمام

- متبادل

- an

- تجزیہ

- اور

- اینڈریو

- انتھونی

- اے پی آئی

- درخواست

- ایپلی کیشنز

- فن تعمیر

- آرکیٹیکچرز

- کیا

- AS

- مفروضے

- At

- کرنے کی کوشش

- توجہ

- مصنف

- مصنفین

- آٹو ایم ایل

- بنجر

- کی بنیاد پر

- BE

- بین

- معیار

- معیارات

- بنیامین

- بہتر

- کے درمیان

- دو سمتی

- بایڈیکل

- بلاکس

- دونوں

- توڑ

- عمارت

- تعمیر

- by

- حساب سے

- کیمبرج

- کر سکتے ہیں

- صلاحیتوں

- کارلوس

- چا

- چانگ

- خصوصیات

- چارلس

- چن

- چو

- کرس

- درجہ بندی

- قریب سے

- تبصرہ

- عمومی

- کموینیکیشن

- مقابلے میں

- مقابلہ

- مکمل

- پیچیدہ

- پیچیدگی

- کمپوزایبل

- کمپاؤنڈ

- حساب

- کمپیوٹر

- کمپیوٹر

- کمپیوٹنگ

- کانفرنس

- رابطہ

- مسلسل

- کنٹرول

- کاپی رائٹ

- سکتا ہے

- کاؤنٹر پارٹ

- ہم منصبوں

- تخلیق

- ڈینیل

- اعداد و شمار

- ڈیٹاسیٹس

- ڈیوڈ

- گہری

- گہری سیکھنے

- مظاہرہ

- ڈیزائن

- تفصیل

- کھوج

- مختلف

- بات چیت

- ڈونالڈ

- کے دوران

- متحرک

- ای اینڈ ٹی

- ایڈیٹرز

- ایڈورڈ

- تاثیر

- ہنر

- el

- حوصلہ افزا

- بڑھانے کے

- ایرک

- تشخیص

- بھی

- عملدرآمد

- پھانسی

- نمائش کر رہا ہے

- تجربات

- تلاش

- توسیع

- وسیع

- فاسٹ

- فروری

- کم

- آخر

- مالی

- توجہ مرکوز

- پیچھے پیچھے

- کے بعد

- کے لئے

- فرانسسکو

- سے

- مکمل طور پر

- گیٹس

- جارج

- GitHub کے

- بم

- ضمانت دیتا ہے

- ہارڈ ویئر

- ہارورڈ

- باڑ لگانا

- مدد

- مدد کرتا ہے

- ہولڈرز

- HTTP

- HTTPS

- ہانگ

- ہائبرڈ

- IEEE

- if

- Illia

- تصویر

- تصویر کی درجہ بندی

- تصویری شناخت

- تصاویر

- عملدرآمد

- بہتر

- in

- سمیت

- معلومات

- بصیرت

- اداروں

- انٹیلی جنس

- دلچسپ

- بین الاقوامی سطح پر

- تشریح

- متعارف کرانے

- میں

- جیکب

- جیمز

- جیمی

- جاوا سکرپٹ

- جمی

- جان

- جانسن

- جان

- جونز

- جرنل

- جان

- کم

- جانا جاتا ہے

- کمر

- زبان

- بڑے پیمانے پر

- آخری

- پرت

- تہوں

- سیکھنے

- چھوڑ دو

- لی

- سطح

- لیورنگنگ

- Li

- لائسنس

- ہلکا پھلکا

- کی طرح

- لن

- لکیری

- لسٹ

- ادب

- بارک

- لوڈ کر رہا ہے

- مقامی

- لندن

- مشین

- مشین لرننگ

- بہت سے

- مارکو

- ماریو

- مارٹن

- ریاضی

- میٹرکس

- میٹھی

- میکس

- زیادہ سے زیادہ چوڑائی

- میکسیل

- مئی..

- mcclean

- میکانزم

- طبی

- یادیں

- طریقہ

- طریقوں

- مائیکل

- میخائل

- منٹ

- ماڈل

- ماڈل

- جدید

- مہینہ

- زیادہ

- قدرتی

- قدرتی زبان عملیات

- فطرت، قدرت

- قریب

- ضرورت ہے

- نیٹ

- نیٹ ورک

- نیٹ ورک

- عصبی

- عصبی نیٹ ورک

- نیند نیٹ ورک

- نئی

- شور

- عام

- ناول

- تعداد

- حاصل کی

- of

- on

- ایک

- کھول

- اصلاح کے

- or

- اصل

- ہمارے

- باہر

- پر

- مجموعی جائزہ

- صفحہ

- صفحات

- پالو آلٹو

- کاغذ.

- پیرامیٹرز

- پیرس

- پیٹرک

- پاٹرن

- پال

- کارکردگی

- کارکردگی

- پیٹر

- جسمانی

- طبعیات

- پتھر

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پالیسیاں

- polosukhin

- ممکنہ

- طاقتور

- پرکاش

- کی موجودگی

- حال (-)

- محفوظ کر رہا ہے

- پریس

- پچھلا

- مسئلہ

- پروسیسنگ

- پروسیسرز

- پیدا

- پروگرام

- وعدہ

- تجویز کریں

- مجوزہ

- فراہم

- شائع

- پبلیشر

- پبلشرز

- پبلشنگ

- معیار

- کوانٹم

- کوانٹم الگورتھم

- کوانٹم کمپیوٹر

- کوانٹم کمپیوٹرز

- کمانٹم کمپیوٹنگ

- کوانٹم معلومات

- کوانٹم مشین لرننگ

- کیوبیت

- R

- ریمآئ

- تناسب

- حال ہی میں

- تسلیم

- بار بار

- حوالہ جات

- رجسٹرڈ

- باقی

- کی ضرورت

- نتائج کی نمائش

- کا جائزہ لینے کے

- جائزہ

- رچرڈ

- روچ

- رومن

- روٹنگ

- رای

- رن

- رن ٹائم

- ریان

- s

- پیمانے

- سائنس

- سائنس اور ٹیکنالوجی

- سائنسی

- سکٹ

- شان

- سیریز

- مقرر

- ارے

- سے ظاہر ہوا

- اشارہ

- سائمن

- نقوش

- چھ

- حل

- حل کرنا۔

- کچھ

- سپیکٹرم

- تقریر

- تیزی

- معیار

- ریاستی آرٹ

- امریکہ

- مطالعہ

- کامیابی کے ساتھ

- اس طرح

- موزوں

- اتوار

- سپر کنڈکٹنگ

- سروے

- سسٹمز

- کاموں

- ہم جنس پرستوں

- ٹیکنالوجی

- اصطلاح

- شرائط

- متن

- متن کی درجہ بندی

- کہ

- ۔

- ان

- نظریاتی

- نظریہ

- یہ

- وہ

- اس

- تھامس

- تین

- ٹم

- وقت

- اوقات

- عنوان

- کرنے کے لئے

- تربیت یافتہ

- ٹریننگ

- معاملات

- تبدیلی

- ٹرانسفارمر

- ٹرانسفارمرز

- ترجمہ کریں

- ترجمہ

- پھنس گیا

- نیٹ ورک

- دو

- اقسام

- کے تحت

- افہام و تفہیم

- متحد

- منفرد

- یونیورسٹی

- اپ ڈیٹ

- صلی اللہ علیہ وسلم

- URL

- امریکا

- استعمال

- کا استعمال کرتے ہوئے

- مختلف

- مختلف

- گاڑی

- بہت

- کی طرف سے

- نقطہ نظر

- حجم

- W

- وانگ

- چاہتے ہیں

- تھا

- we

- اچھا ہے

- جس

- ساتھ

- لکڑی

- الفاظ

- کام

- قابل

- wu

- ژاؤ

- سال

- پیداوار

- ینگ

- تم

- یوآن

- زیفیرنیٹ

- زو