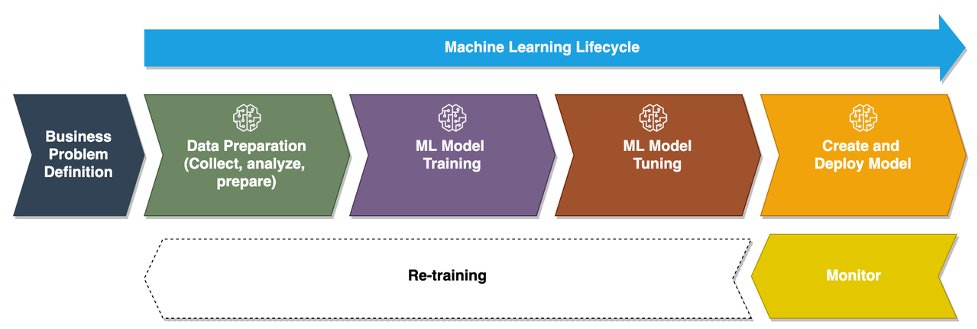

Khi các doanh nghiệp chuyển từ chạy các mô hình máy học (ML) đặc biệt sang sử dụng AI/ML để chuyển đổi hoạt động kinh doanh của họ trên quy mô lớn, việc áp dụng Hoạt động ML (MLOps) là điều không thể tránh khỏi. Như được hiển thị trong hình dưới đây, vòng đời ML bắt đầu bằng việc định hình một vấn đề kinh doanh dưới dạng trường hợp sử dụng ML, sau đó là một loạt các giai đoạn, bao gồm chuẩn bị dữ liệu, kỹ thuật tính năng, xây dựng mô hình, triển khai, giám sát liên tục và đào tạo lại. Đối với nhiều doanh nghiệp, nhiều bước trong số này vẫn còn thủ công và được tích hợp lỏng lẻo với nhau. Do đó, điều quan trọng là phải tự động hóa vòng đời ML từ đầu đến cuối, cho phép thử nghiệm thường xuyên để mang lại kết quả kinh doanh tốt hơn. Chuẩn bị dữ liệu là một trong những bước quan trọng trong vòng đời này, vì độ chính xác của mô hình ML phụ thuộc vào chất lượng của tập dữ liệu huấn luyện.

Các nhà khoa học dữ liệu và kỹ sư ML dành khoảng 70–80% thời gian để thu thập, phân tích, làm sạch và chuyển đổi dữ liệu cần thiết cho việc đào tạo mô hình. Trình sắp xếp dữ liệu Amazon SageMaker là khả năng được quản lý hoàn toàn của Amazon SageMaker điều đó giúp các nhà khoa học dữ liệu và kỹ sư ML phân tích và chuẩn bị dữ liệu cho các dự án ML của họ nhanh hơn mà không cần hoặc ít mã. Khi nói đến việc vận hành vòng đời ML từ đầu đến cuối, việc chuẩn bị dữ liệu hầu như luôn là bước đầu tiên trong quy trình. Vì có nhiều cách để xây dựng quy trình ML từ đầu đến cuối, nên trong bài đăng này, chúng tôi thảo luận về cách bạn có thể dễ dàng tích hợp Data Wrangler với một số công nghệ điều phối và tự động hóa quy trình làm việc nổi tiếng.

Tổng quan về giải pháp

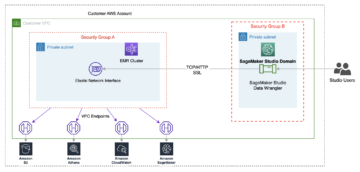

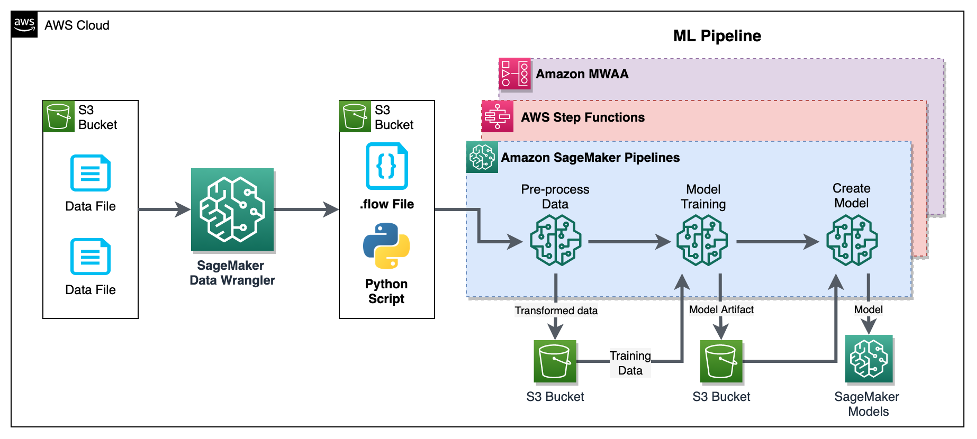

Trong bài đăng này, chúng tôi trình bày cách người dùng có thể tích hợp việc chuẩn bị dữ liệu bằng Data Wrangler với Đường ống Amazon SageMaker, Chức năng bước AWSvà Luồng khí Apache với Quy trình làm việc được quản lý của Amazon cho Luồng khí Apache (Amazon MWAA). Pipelines là một tính năng của SageMaker, là dịch vụ tích hợp liên tục và phân phối liên tục (CI/CD) có mục đích và dễ sử dụng dành cho ML. Step Functions là dịch vụ quy trình làm việc trực quan ít mã hóa, không có máy chủ, dùng để điều phối các dịch vụ AWS và tự động hóa quy trình kinh doanh. Amazon MWAA là dịch vụ điều phối được quản lý dành cho Apache Airflow, giúp vận hành quy trình ML và dữ liệu từ đầu đến cuối dễ dàng hơn.

Với mục đích trình diễn, chúng tôi xem xét một trường hợp sử dụng để chuẩn bị dữ liệu nhằm huấn luyện mô hình ML có tích hợp sẵn SageMaker Thuật toán XGBoost điều đó sẽ giúp chúng tôi xác định các yêu cầu bồi thường bảo hiểm xe gian lận. Chúng tôi đã sử dụng tập hợp dữ liệu mẫu được tạo tổng hợp để huấn luyện mô hình và tạo mô hình SageMaker bằng cách sử dụng các tạo phẩm mô hình từ quá trình huấn luyện. Mục tiêu của chúng tôi là vận hành quy trình này từ đầu đến cuối bằng cách thiết lập quy trình làm việc ML. Mặc dù quy trình làm việc ML có thể phức tạp hơn nhưng chúng tôi sử dụng quy trình làm việc tối thiểu cho mục đích trình diễn. Bước đầu tiên của quy trình làm việc là chuẩn bị dữ liệu với Data Wrangler, tiếp theo là bước đào tạo mô hình và cuối cùng là bước tạo mô hình. Sơ đồ sau đây minh họa quy trình làm việc của giải pháp của chúng tôi.

Trong các phần sau, chúng tôi sẽ hướng dẫn bạn cách thiết lập luồng Data Wrangler và tích hợp Data Wrangler với Pipelines, Step Functions và Apache Airflow.

Thiết lập luồng Trình sắp xếp dữ liệu

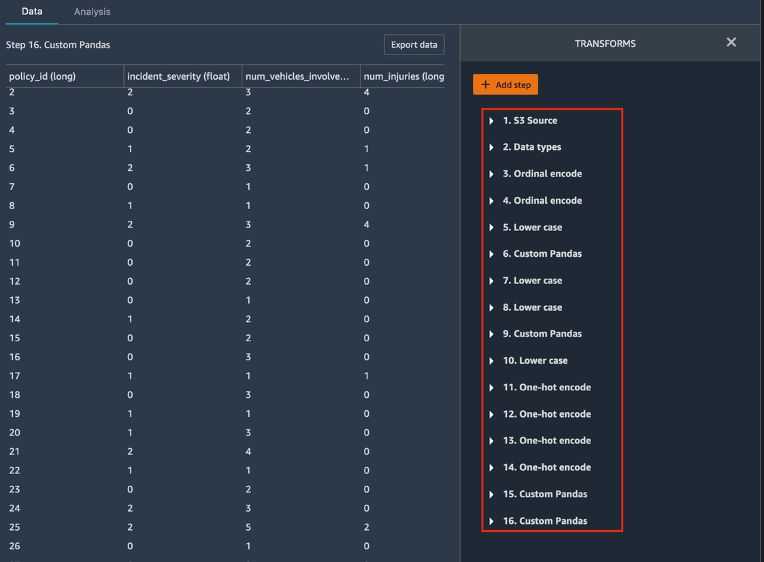

Chúng tôi bắt đầu bằng cách tạo luồng Data Wrangler, còn được gọi là luồng dòng dữ liệu, sử dụng giao diện luồng dữ liệu thông qua Xưởng sản xuất Amazon SageMaker IDE. Tập dữ liệu mẫu của chúng tôi bao gồm hai tệp dữ liệu: khiếu nại.csv và khách hàng.csv, được lưu trữ trong một Dịch vụ lưu trữ đơn giản của Amazon (Amazon S3) xô. Chúng tôi sử dụng giao diện người dùng luồng dữ liệu để áp dụng Data Wrangler's các phép biến đổi tích hợp mã hóa phân loại, định dạng chuỗi và gán cho các cột tính năng trong mỗi tệp này. Chúng tôi cũng áp dụng chuyển đổi tùy chỉnh đến một vài cột tính năng bằng cách sử dụng một vài dòng mã Python tùy chỉnh với Dữ liệu gấu trúc. Ảnh chụp màn hình sau đây hiển thị các biến đổi được áp dụng cho tệp Claims.csv trong giao diện người dùng luồng dữ liệu.

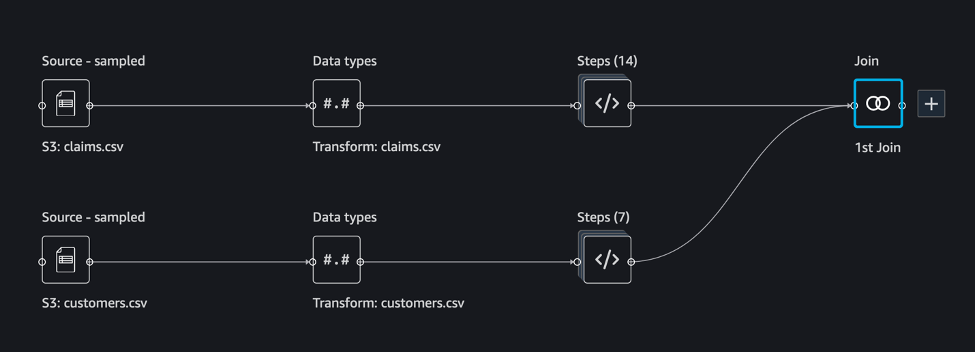

Cuối cùng, chúng tôi kết hợp các kết quả của các phép biến đổi được áp dụng của hai tệp dữ liệu để tạo ra một tập dữ liệu huấn luyện duy nhất cho việc huấn luyện mô hình của chúng tôi. Chúng tôi sử dụng tính năng tích hợp sẵn của Data Wrangler tham gia bộ dữ liệu khả năng cho phép chúng ta thực hiện các thao tác nối giống như SQL trên dữ liệu dạng bảng. Ảnh chụp màn hình sau đây hiển thị luồng dữ liệu trong giao diện người dùng luồng dữ liệu trong Studio. Để biết hướng dẫn từng bước cách tạo luồng dữ liệu bằng Data Wrangler, hãy tham khảo phần Kho GitHub.

Bây giờ bạn có thể sử dụng tệp luồng dữ liệu (.flow) để thực hiện chuyển đổi dữ liệu trên các tệp dữ liệu thô của chúng tôi. Giao diện người dùng luồng dữ liệu có thể tự động tạo sổ ghi chép Python để chúng tôi sử dụng và tích hợp trực tiếp với Pipelines bằng SDK SageMaker. Đối với Step Functions, chúng ta sử dụng AWS Step Functions Khoa học dữ liệu Python SDK để tích hợp quá trình xử lý Data Wrangler của chúng tôi với quy trình Step Functions. Đối với Amazon MWAA, chúng tôi sử dụng toán tử luồng khí tùy chỉnh và Nhà điều hành Airflow SageMaker. Chúng ta sẽ thảo luận chi tiết từng cách tiếp cận này trong các phần sau.

Tích hợp Data Wrangler với Pipeline

SageMaker Pipelines là một công cụ điều phối quy trình làm việc gốc để xây dựng các quy trình ML tận dụng khả năng tích hợp trực tiếp của SageMaker. Cùng với Đăng ký mô hình SageMaker, Pipelines cải thiện khả năng phục hồi hoạt động và khả năng tái tạo của quy trình công việc ML của bạn. Các thành phần tự động hóa quy trình làm việc này cho phép bạn dễ dàng mở rộng khả năng xây dựng, đào tạo, thử nghiệm và triển khai hàng trăm mô hình trong sản xuất; lặp lại nhanh hơn; giảm thiểu sai sót do điều phối thủ công; và xây dựng các cơ chế lặp lại. Mỗi bước trong quy trình có thể theo dõi dòng và các bước trung gian có thể được lưu vào bộ đệm để chạy lại quy trình một cách nhanh chóng. Bạn có thể tạo quy trình bằng SageMaker Python SDK.

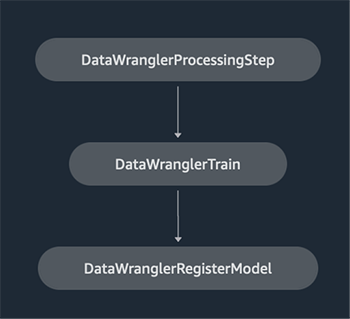

Quy trình làm việc được xây dựng bằng quy trình SageMaker bao gồm một chuỗi các bước tạo thành Đồ thị tuần hoàn có hướng (DAG). Trong ví dụ này, chúng ta bắt đầu với một bước xử lý, chạy một SageMaker Xử lý công việc dựa trên tệp luồng của Data Wrangler để tạo tập dữ liệu huấn luyện. Sau đó chúng tôi tiếp tục với một bước đào tạo, trong đó chúng tôi huấn luyện mô hình XGBoost bằng thuật toán XGBoost tích hợp của SageMaker và tập dữ liệu huấn luyện được tạo ở bước trước. Sau khi một mô hình đã được huấn luyện, chúng ta kết thúc quy trình công việc này bằng một Đăng ký bước mô hình để đăng ký mô hình đã đào tạo với sổ đăng ký mô hình SageMaker.

Cài đặt và hướng dẫn

Để chạy mẫu này, chúng tôi sử dụng sổ ghi chép Jupyter chạy Python3 trên hình ảnh hạt nhân Khoa học dữ liệu trong môi trường Studio. Bạn cũng có thể chạy nó trên phiên bản sổ ghi chép Jupyter cục bộ trên máy của mình bằng cách thiết lập thông tin xác thực để đảm nhận vai trò thực thi SageMaker. Sổ ghi chép này có trọng lượng nhẹ và có thể chạy trên phiên bản ml.t3.medium. Hướng dẫn chi tiết từng bước có thể được tìm thấy trong Kho GitHub.

Bạn có thể sử dụng tính năng xuất trong Data Wrangler để tạo mã Đường ống hoặc xây dựng tập lệnh của riêng mình từ đầu. Trong kho lưu trữ mẫu của chúng tôi, chúng tôi sử dụng kết hợp cả hai phương pháp để đơn giản hóa. Ở cấp độ cao, sau đây là các bước để xây dựng và chạy quy trình làm việc Đường ống:

- Tạo tệp luồng từ Data Wrangler hoặc sử dụng tập lệnh thiết lập để tạo tệp luồng từ mẫu được cấu hình sẵn.

- tạo một Dịch vụ lưu trữ đơn giản của Amazon (Amazon S3) và tải tệp luồng của bạn cũng như các tệp đầu vào vào nhóm. Trong sổ ghi chép mẫu của chúng tôi, chúng tôi sử dụng nhóm S3 mặc định của SageMaker.

- Làm theo hướng dẫn trong sổ ghi chép để tạo đối tượng Bộ xử lý dựa trên tệp luồng Data Wrangler và đối tượng Công cụ ước tính với các tham số của công việc đào tạo.

- Trong ví dụ của chúng tôi, vì chúng tôi chỉ sử dụng các tính năng của SageMaker và bộ chứa S3 mặc định nên chúng tôi có thể sử dụng vai trò thực thi mặc định của Studio. Giống nhau Quản lý truy cập và nhận dạng AWS (IAM) được đảm nhận bởi quá trình chạy quy trình, công việc xử lý và công việc đào tạo. Bạn có thể tùy chỉnh thêm vai trò thực thi theo đặc quyền tối thiểu.

- Tiếp tục với hướng dẫn để tạo quy trình với các bước tham chiếu đối tượng Bộ xử lý và Công cụ ước tính, sau đó chạy quy trình. Các công việc xử lý và đào tạo chạy trên môi trường do SageMaker quản lý và mất vài phút để hoàn thành.

- Trong Studio, bạn có thể xem chi tiết quy trình giám sát quá trình chạy quy trình. Bạn cũng có thể giám sát các công việc đào tạo và xử lý cơ bản từ bảng điều khiển SageMaker hoặc từ amazoncloudwatch.

Tích hợp Data Wrangler với Step Functions

Với Step Functions, bạn có thể thể hiện logic kinh doanh phức tạp dưới dạng quy trình làm việc theo sự kiện, ít mã hóa để kết nối các dịch vụ AWS khác nhau. Các SDK khoa học dữ liệu chức năng bước là một thư viện mã nguồn mở cho phép các nhà khoa học dữ liệu tạo ra các quy trình công việc có thể xử lý trước các tập dữ liệu cũng như xây dựng, triển khai và giám sát các mô hình ML bằng SageMaker và Step Functions. Step Functions dựa trên các máy và tác vụ trạng thái. Step Functions tạo quy trình làm việc gồm nhiều bước được gọi là tiểu bangvà thể hiện quy trình làm việc đó trong Ngôn ngữ Hoa Kỳ. Khi bạn tạo quy trình công việc bằng SDK khoa học dữ liệu Step Functions, nó sẽ tạo một máy trạng thái thể hiện quy trình công việc và các bước của bạn trong Step Functions.

Đối với trường hợp sử dụng này, chúng tôi đã xây dựng quy trình làm việc Step Functions dựa trên mẫu phổ biến được sử dụng trong bài đăng này bao gồm bước xử lý, bước đào tạo và RegisterModel bước chân. Trong trường hợp này, chúng tôi nhập các bước này từ SDK Python của Khoa học dữ liệu Step Functions. Chúng tôi xâu chuỗi các bước này theo cùng một thứ tự để tạo quy trình làm việc Step Functions. Luồng công việc sử dụng tệp luồng được tạo từ Data Wrangler, nhưng bạn cũng có thể sử dụng tệp luồng Data Wrangler của riêng mình. Chúng tôi sử dụng lại một số mã từ Data Wrangler tính năng xuất khẩu để đơn giản. Chúng tôi chạy logic tiền xử lý dữ liệu do tệp luồng Data Wrangler tạo ra để tạo tập dữ liệu huấn luyện, huấn luyện mô hình bằng thuật toán XGBoost và lưu thành phần lạ của mô hình đã huấn luyện dưới dạng mô hình SageMaker. Ngoài ra, trong kho lưu trữ GitHub, chúng tôi cũng chỉ ra cách Step Functions cho phép chúng tôi thử và phát hiện lỗi cũng như xử lý các lỗi và thử lại bằng FailStateStep và CatchStateStep.

Sơ đồ luồng kết quả, như minh họa trong ảnh chụp màn hình sau, có sẵn trên bảng điều khiển Step Functions sau khi dòng công việc đã bắt đầu. Điều này giúp các nhà khoa học và kỹ sư dữ liệu trực quan hóa toàn bộ quy trình làm việc và từng bước trong đó, đồng thời truy cập nhật ký CloudWatch được liên kết cho từng bước.

Cài đặt và hướng dẫn

Để chạy mẫu này, chúng tôi sử dụng sổ ghi chép Python chạy với nhân Khoa học dữ liệu trong môi trường Studio. Bạn cũng có thể chạy nó trên phiên bản sổ ghi chép Python cục bộ trên máy của mình bằng cách thiết lập thông tin xác thực để đảm nhận vai trò thực thi SageMaker. Ví dụ, máy tính xách tay này rất nhẹ và có thể chạy trên phiên bản trung bình t3. Hướng dẫn chi tiết từng bước có thể được tìm thấy trong Kho GitHub.

Bạn có thể sử dụng tính năng xuất trong Data Wrangler để tạo mã Đường ống và sửa đổi mã đó cho Step Functions hoặc xây dựng tập lệnh của riêng bạn từ đầu. Trong kho lưu trữ mẫu của chúng tôi, chúng tôi sử dụng kết hợp cả hai phương pháp để đơn giản hóa. Ở cấp độ cao, sau đây là các bước để xây dựng và chạy quy trình làm việc Step Functions:

- Tạo tệp luồng từ Data Wrangler hoặc sử dụng tập lệnh thiết lập để tạo tệp luồng từ mẫu được cấu hình sẵn.

- Tạo vùng lưu trữ S3 rồi tải tệp luồng và tệp đầu vào của bạn lên vùng lưu trữ.

- Định cấu hình vai trò thực thi SageMaker của bạn với các quyền cần thiết như đã đề cập trước đó. Tham khảo kho GitHub để biết hướng dẫn chi tiết.

- Làm theo hướng dẫn để chạy sổ ghi chép trong kho lưu trữ nhằm bắt đầu quy trình làm việc. Công việc xử lý chạy trên môi trường Spark do SageMaker quản lý và có thể mất vài phút để hoàn thành.

- Đi tới bảng điều khiển Step Functions và theo dõi quy trình làm việc một cách trực quan. Bạn cũng có thể điều hướng đến nhật ký CloudWatch được liên kết để gỡ lỗi.

Hãy xem lại một số phần quan trọng của mã ở đây. Để xác định quy trình làm việc, trước tiên chúng tôi xác định các bước trong quy trình làm việc cho máy trạng thái Step Function. Bước đầu tiên là data_wrangler_step để xử lý dữ liệu, sử dụng tệp luồng Data Wrangler làm đầu vào để chuyển đổi các tệp dữ liệu thô. Chúng tôi cũng xác định bước huấn luyện mô hình và bước tạo mô hình có tên training_step và model_step, tương ứng. Cuối cùng, chúng tôi tạo một quy trình làm việc bằng cách xâu chuỗi tất cả các bước mà chúng tôi đã tạo, như minh họa trong đoạn mã sau:

Trong ví dụ của chúng tôi, chúng tôi đã xây dựng quy trình làm việc để lấy tên công việc làm tham số vì chúng là duy nhất và cần được tạo ngẫu nhiên trong mỗi lần chạy quy trình. Chúng tôi chuyển những tên này khi dòng công việc chạy. Bạn cũng có thể lên lịch chạy quy trình làm việc Step Functions bằng CloudWatch (xem Lên lịch quy trình làm việc phi máy chủ với AWS Step Functions và Amazon CloudWatch), được gọi bằng cách sử dụng Sự kiện Amazon S3, hoặc được gọi từ Sự kiện Amazon (xem Tạo quy tắc EventBridge kích hoạt quy trình làm việc Step Functions). Với mục đích minh họa, chúng ta có thể gọi quy trình làm việc Step Functions từ giao diện người dùng bảng điều khiển Step Functions hoặc sử dụng mã sau đây từ sổ ghi chép.

Tích hợp Data Wrangler với Apache Airflow

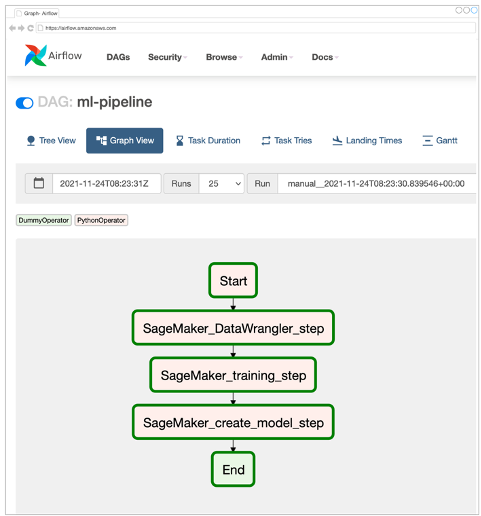

Một cách phổ biến khác để tạo quy trình công việc ML là sử dụng Apache Airflow. Apache Airflow là một nền tảng nguồn mở cho phép bạn soạn thảo, lên lịch và giám sát quy trình công việc theo chương trình. Amazon MWAA giúp dễ dàng thiết lập và vận hành quy trình ML toàn diện với Apache Airflow trên đám mây ở quy mô lớn. Đường ống luồng không khí bao gồm một chuỗi các nhiệm vụ, còn được gọi là quy trình làm việc. Luồng công việc được định nghĩa là một DAG gói gọn các nhiệm vụ và mối quan hệ phụ thuộc giữa chúng, xác định cách chúng sẽ chạy trong quy trình làm việc.

Chúng tôi đã tạo Airflow DAG trong môi trường Amazon MWAA để triển khai quy trình làm việc MLOps của mình. Mỗi tác vụ trong quy trình làm việc là một đơn vị thực thi, được viết bằng ngôn ngữ lập trình Python, thực hiện một số hành động. Một nhiệm vụ có thể là một nhà điều hành hoặc một cảm biến. Trong trường hợp của chúng tôi, chúng tôi sử dụng một Toán tử Python luồng khí cùng với SDK Python của SageMaker để chạy tập lệnh Data Wrangler Python và sử dụng tập lệnh được hỗ trợ nguyên bản của Airflow Toán tử SageMaker để huấn luyện thuật toán XGBoost tích hợp của SageMaker và tạo mô hình từ các tạo phẩm thu được. Chúng tôi cũng đã tạo một toán tử Data Wrangler tùy chỉnh hữu ích (SageMakerDataWranglerOperator) cho Apache Airflow mà bạn có thể sử dụng để xử lý các tệp luồng Data Wrangler nhằm xử lý dữ liệu mà không cần bất kỳ mã bổ sung nào.

Ảnh chụp màn hình sau đây hiển thị Airflow DAG với năm bước để triển khai quy trình làm việc MLOps của chúng tôi.

Bước Bắt đầu sử dụng toán tử Python để khởi tạo cấu hình cho các bước còn lại trong quy trình làm việc. SageMaker_DataWrangler_Step sử dụng SageMakerDataWranglerOperator và tệp luồng dữ liệu mà chúng tôi đã tạo trước đó. SageMaker_training_step và SageMaker_create_model_step sử dụng các toán tử SageMaker tích hợp sẵn để huấn luyện mô hình và tạo mô hình tương ứng. Môi trường Amazon MWAA của chúng tôi sử dụng loại phiên bản nhỏ nhất (mw1.small), vì phần lớn quá trình xử lý được thực hiện thông qua Công việc xử lý, sử dụng loại phiên bản riêng có thể được xác định làm tham số cấu hình trong quy trình làm việc.

Cài đặt và hướng dẫn

Bạn có thể tìm thấy hướng dẫn cài đặt chi tiết từng bước để triển khai giải pháp này trong Kho GitHub. Chúng tôi đã sử dụng sổ ghi chép Jupyter có các ô mã Python để thiết lập Airflow DAG. Giả sử bạn đã tạo tệp luồng dữ liệu, sau đây là tổng quan cấp cao về các bước cài đặt:

- Tạo một thùng S3 và các thư mục tiếp theo được Amazon MWAA yêu cầu.

- Tạo môi trường Amazon MWAA. Lưu ý rằng chúng tôi đã sử dụng Airflow phiên bản 2.0.2 cho giải pháp này.

- Tạo và tải lên một

requirements.txttệp chứa tất cả các phần phụ thuộc Python được yêu cầu bởi các tác vụ Airflow và tải nó lên/requirementsthư mục trong nhóm S3 chính của Amazon MWAA. Điều này được môi trường Airflow được quản lý sử dụng để cài đặt các phần phụ thuộc Python. - Tải lên

SMDataWranglerOperator.pynộp vào/dagsdanh mục. Tập lệnh Python này chứa mã cho toán tử Airflow tùy chỉnh cho Data Wrangler. Toán tử này có thể được sử dụng cho các tác vụ xử lý bất kỳ tệp .flow nào. - Tạo và tải lên

config.pykịch bản để/dagsdanh mục. Tập lệnh Python này được sử dụng cho bước đầu tiên trong DAG của chúng tôi để tạo các đối tượng cấu hình được yêu cầu bởi các bước còn lại của quy trình làm việc. - Cuối cùng, tạo và tải lên

ml_pipelines.pynộp vào/dagsdanh mục. Tập lệnh này chứa định nghĩa DAG cho quy trình làm việc của Airflow. Đây là nơi chúng tôi xác định từng nhiệm vụ và thiết lập các mối quan hệ phụ thuộc giữa chúng. Amazon MWAA thăm dò định kỳ/dagsthư mục để chạy tập lệnh này nhằm tạo DAG hoặc cập nhật tập lệnh hiện có với bất kỳ thay đổi mới nhất nào.

Sau đây là mã cho SageMaker_DataWrangler_step, sử dụng tùy chỉnh SageMakerDataWranglerOperator. Chỉ với một vài dòng mã trong tập lệnh Python định nghĩa DAG, bạn có thể trỏ SageMakerDataWranglerOperator đến vị trí tệp luồng Data Wrangler (là vị trí S3). Đằng sau hậu trường, toán tử này sử dụng SageMaker Xử lý công việc để xử lý tệp .flow nhằm áp dụng các phép biến đổi đã xác định cho các tệp dữ liệu thô của bạn. Bạn cũng có thể chỉ định loại trường hợp và số lượng phiên bản cần thiết cho công việc xử lý Data Wrangler.

Sản phẩm config tham số chấp nhận một từ điển (cặp khóa-giá trị) của các cấu hình bổ sung mà công việc xử lý yêu cầu, chẳng hạn như tiền tố đầu ra của tệp đầu ra cuối cùng, loại tệp đầu ra (CSV hoặc Parquet) và URI cho bộ chứa Data Wrangler tích hợp sẵn hình ảnh. Đoạn mã sau đây là những gì config từ điển cho SageMakerDataWranglerOperator giống như. Những cấu hình này là bắt buộc đối với quá trình xử lý SageMaker bộ vi xử lý. Để biết chi tiết về từng tham số cấu hình này, hãy tham khảo sagemaker.processing.Processor().

Làm sạch

Để tránh phát sinh phí trong tương lai, hãy xóa các tài nguyên đã tạo cho giải pháp bạn đã triển khai.

- Thực hiện theo hướng dẫn được cung cấp trong kho GitHub để dọn sạch các tài nguyên được tạo bởi giải pháp SageMaker Pipelines.

- Thực hiện theo hướng dẫn được cung cấp trong kho GitHub để dọn sạch các tài nguyên được tạo bởi giải pháp Step Functions.

- Thực hiện theo hướng dẫn được cung cấp trong kho GitHub để dọn sạch các tài nguyên được tạo bởi giải pháp Amazon MWAA.

Kết luận

Bài đăng này trình bày cách bạn có thể dễ dàng tích hợp Data Wrangler với một số công nghệ điều phối và tự động hóa quy trình làm việc nổi tiếng trong AWS. Trước tiên, chúng tôi đã xem xét trường hợp sử dụng mẫu và kiến trúc cho giải pháp sử dụng Data Wrangler để xử lý trước dữ liệu. Sau đó, chúng tôi đã trình bày cách bạn có thể tích hợp Data Wrangler với Pipelines, Step Functions và Amazon MWAA.

Bước tiếp theo, bạn có thể tìm và thử các mẫu mã và sổ ghi chép trong Kho GitHub bằng cách sử dụng hướng dẫn chi tiết cho từng giải pháp được thảo luận trong bài đăng này. Để tìm hiểu thêm về cách Data Wrangler có thể hỗ trợ khối lượng công việc ML của bạn, hãy truy cập Data Wrangler trang sản phẩm và Chuẩn bị dữ liệu ML với Amazon SageMaker Data Wrangler.

Giới thiệu về tác giả

Rodrigo Alarcón là Kiến trúc sư giải pháp chiến lược ML cấp cao của AWS có trụ sở tại Santiago, Chile. Trong vai trò của mình, Rodrigo giúp các công ty thuộc nhiều quy mô khác nhau tạo ra kết quả kinh doanh thông qua các giải pháp AI và ML dựa trên đám mây. Mối quan tâm của anh ấy bao gồm học máy và an ninh mạng.

Rodrigo Alarcón là Kiến trúc sư giải pháp chiến lược ML cấp cao của AWS có trụ sở tại Santiago, Chile. Trong vai trò của mình, Rodrigo giúp các công ty thuộc nhiều quy mô khác nhau tạo ra kết quả kinh doanh thông qua các giải pháp AI và ML dựa trên đám mây. Mối quan tâm của anh ấy bao gồm học máy và an ninh mạng.

Ganapathi Krishnamoorthi là Kiến trúc sư giải pháp ML cao cấp tại AWS. Ganapathi cung cấp hướng dẫn mang tính quy định cho khách hàng khởi nghiệp và doanh nghiệp, giúp họ thiết kế và triển khai các ứng dụng đám mây trên quy mô lớn. Anh ấy chuyên về học máy và tập trung vào việc giúp khách hàng tận dụng AI/ML để đạt được kết quả kinh doanh của họ. Khi không làm việc, anh ấy thích khám phá ngoài trời và nghe nhạc.

Ganapathi Krishnamoorthi là Kiến trúc sư giải pháp ML cao cấp tại AWS. Ganapathi cung cấp hướng dẫn mang tính quy định cho khách hàng khởi nghiệp và doanh nghiệp, giúp họ thiết kế và triển khai các ứng dụng đám mây trên quy mô lớn. Anh ấy chuyên về học máy và tập trung vào việc giúp khách hàng tận dụng AI/ML để đạt được kết quả kinh doanh của họ. Khi không làm việc, anh ấy thích khám phá ngoài trời và nghe nhạc.

Anjan Biswas là Kiến trúc sư giải pháp dịch vụ AI cấp cao tập trung vào AI / ML và Phân tích dữ liệu. Anjan là một phần của nhóm dịch vụ AI trên toàn thế giới và làm việc với khách hàng để giúp họ hiểu và phát triển các giải pháp cho các vấn đề kinh doanh với AI và ML. Anjan có hơn 14 năm kinh nghiệm làm việc với các tổ chức chuỗi cung ứng, sản xuất và bán lẻ toàn cầu và đang tích cực giúp khách hàng bắt đầu và mở rộng quy mô trên các dịch vụ AWS AI.

Anjan Biswas là Kiến trúc sư giải pháp dịch vụ AI cấp cao tập trung vào AI / ML và Phân tích dữ liệu. Anjan là một phần của nhóm dịch vụ AI trên toàn thế giới và làm việc với khách hàng để giúp họ hiểu và phát triển các giải pháp cho các vấn đề kinh doanh với AI và ML. Anjan có hơn 14 năm kinh nghiệm làm việc với các tổ chức chuỗi cung ứng, sản xuất và bán lẻ toàn cầu và đang tích cực giúp khách hàng bắt đầu và mở rộng quy mô trên các dịch vụ AWS AI.

- AI

- nghệ thuật ai

- máy phát điện nghệ thuật ai

- ai rô bốt

- Quy trình công việc được quản lý của Amazon dành cho Luồng khí Apache (Amazon MWAA)

- Amazon SageMaker

- Trình sắp xếp dữ liệu Amazon SageMaker

- trí tuệ nhân tạo

- chứng nhận trí tuệ nhân tạo

- trí tuệ nhân tạo trong ngân hàng

- robot trí tuệ nhân tạo

- robot trí tuệ nhân tạo

- phần mềm trí tuệ nhân tạo

- Học máy AWS

- Chức năng bước AWS

- blockchain

- hội nghị blockchain ai

- thiên tài

- trí tuệ nhân tạo đàm thoại

- hội nghị tiền điện tử ai

- dall's

- học kĩ càng

- google ai

- học máy

- plato

- Plato ai

- Thông tin dữ liệu Plato

- Trò chơi Plato

- PlatoDữ liệu

- Platogaming

- quy mô ai

- cú pháp

- zephyrnet