Hôm nay, chúng tôi vui mừng thông báo các bản cập nhật cho Thử nghiệm Amazon SageMaker khả năng của Amazon SageMaker cho phép bạn tổ chức, theo dõi, so sánh và đánh giá các thử nghiệm máy học (ML) và các phiên bản mô hình từ bất kỳ môi trường phát triển tích hợp (IDE) nào bằng SageMaker Python SDK hoặc boto3, bao gồm Sổ ghi chép Jupyter cục bộ.

Học máy (ML) là một quá trình lặp đi lặp lại. Khi giải quyết một trường hợp sử dụng mới, các nhà khoa học dữ liệu và kỹ sư ML lặp lại nhiều tham số khác nhau để tìm cấu hình mô hình tốt nhất (còn gọi là siêu tham số) có thể được sử dụng trong sản xuất để giải quyết thách thức kinh doanh đã xác định. Theo thời gian, sau khi thử nghiệm nhiều mô hình và siêu tham số, các nhóm ML sẽ khó quản lý hiệu quả các lần chạy mô hình để tìm ra mô hình tối ưu nếu không có công cụ theo dõi các thử nghiệm khác nhau. Các hệ thống theo dõi thử nghiệm hợp lý hóa các quy trình để so sánh các lần lặp lại khác nhau, đồng thời giúp đơn giản hóa hoạt động cộng tác và giao tiếp trong nhóm, từ đó tăng năng suất và tiết kiệm thời gian. Điều này đạt được bằng cách tổ chức và quản lý các thử nghiệm ML theo cách dễ dàng để rút ra kết luận từ chúng, chẳng hạn như tìm ra quá trình đào tạo với độ chính xác cao nhất.

Để giải quyết thách thức này, SageMaker cung cấp Thử nghiệm SageMaker, một khả năng SageMaker được tích hợp đầy đủ. Nó cung cấp sự linh hoạt để ghi lại các số liệu mô hình, tham số, tệp, tạo tác, biểu đồ cốt truyện từ các số liệu khác nhau, nắm bắt các siêu dữ liệu khác nhau, tìm kiếm thông qua chúng và hỗ trợ khả năng tái tạo mô hình. Các nhà khoa học dữ liệu có thể nhanh chóng so sánh hiệu suất và siêu tham số để đánh giá mô hình thông qua các biểu đồ và bảng trực quan. Họ cũng có thể sử dụng Thử nghiệm SageMaker để tải xuống các biểu đồ đã tạo và chia sẻ đánh giá mô hình với các bên liên quan của họ.

Với các bản cập nhật mới cho Thử nghiệm SageMaker, giờ đây nó là một phần của SDK SageMaker, giúp đơn giản hóa công việc của nhà khoa học dữ liệu và loại bỏ nhu cầu cài đặt thêm thư viện để quản lý nhiều lần thực thi mô hình. Chúng tôi đang giới thiệu các khái niệm cốt lõi mới sau đây:

- Thử nghiệm: Một tập hợp các lần chạy được nhóm lại với nhau. Một thử nghiệm bao gồm các lần chạy cho nhiều loại có thể được bắt đầu từ mọi nơi bằng cách sử dụng SageMaker Python SDK.

- chạy: Mỗi bước thực hiện của một quy trình huấn luyện mô hình. Một lần chạy bao gồm tất cả các đầu vào, tham số, cấu hình và kết quả cho một lần lặp đào tạo mô hình. Các thông số và chỉ số tùy chỉnh có thể được ghi lại bằng cách sử dụng

log_parameter,log_parametersvàlog_metricchức năng. Đầu vào và đầu ra tùy chỉnh có thể được ghi lại bằng cách sử dụnglog_filechức năng.

Các khái niệm được thực hiện như một phần của Run lớp được cung cấp từ bất kỳ IDE nào đã cài đặt SageMaker Python SDK. Dành cho đào tạo, xử lý và xử lý SageMaker

Chuyển đổi công việc, Lần chạy thử nghiệm SageMaker sẽ tự động được chuyển đến công việc nếu công việc được gọi trong ngữ cảnh chạy. Bạn có thể khôi phục đối tượng đang chạy bằng cách sử dụng load_run() từ công việc của bạn. Cuối cùng, với sự tích hợp của các chức năng mới, các nhà khoa học dữ liệu cũng có thể tự động ghi lại ma trận nhầm lẫn, đồ thị thu hồi và độ chính xác cũng như đường cong ROC để phân loại các trường hợp sử dụng bằng cách sử dụng run.log_confusion_matrix, run.log_precision_recallvà run.log_roc_curve các chức năng tương ứng.

Trong bài đăng trên blog này, chúng tôi sẽ cung cấp các ví dụ về cách sử dụng các chức năng Thử nghiệm SageMaker mới trong sổ ghi chép Jupyter thông qua SDK SageMaker. Chúng tôi sẽ chứng minh những khả năng này bằng cách sử dụng một Kim tự tháp ví dụ để đào tạo ví dụ phân loại chữ số viết tay MNIST. Thí nghiệm sẽ được tổ chức như sau:

- Tạo các lần chạy thử nghiệm và tham số ghi nhật ký: Trước tiên, chúng tôi sẽ tạo một thử nghiệm mới, bắt đầu một lần chạy mới cho thử nghiệm này và ghi lại các thông số cho thử nghiệm đó.

- Ghi nhật ký số liệu hiệu suất mô hình:Chúng tôi sẽ ghi lại số liệu hiệu suất mô hình và vẽ đồ thị số liệu.

- So sánh chạy mô hình:Chúng tôi sẽ so sánh các lần chạy mô hình khác nhau theo siêu tham số của mô hình. Chúng tôi sẽ thảo luận cách so sánh các lần chạy đó và cách sử dụng Thử nghiệm SageMaker để chọn mô hình tốt nhất.

- Chạy thử nghiệm từ công việc SageMaker: Chúng tôi cũng sẽ cung cấp ví dụ về cách tự động chia sẻ bối cảnh thử nghiệm của bạn với công việc xử lý, đào tạo hoặc chuyển đổi hàng loạt của SageMaker. Điều này cho phép bạn tự động khôi phục bối cảnh chạy của mình bằng

load_runchức năng bên trong công việc của bạn. - Tích hợp SageMaker Làm rõ báo cáo: Chúng tôi sẽ chứng minh làm thế nào bây giờ chúng tôi có thể tích hợp SageMaker Làm rõ báo cáo thiên vị và khả năng giải thích cho một chế độ xem với báo cáo mô hình được đào tạo của bạn.

Điều kiện tiên quyết

Đối với bài đăng trên blog này, chúng tôi sẽ sử dụng Xưởng sản xuất Amazon SageMaker để giới thiệu cách ghi nhật ký số liệu từ sổ ghi chép Studio bằng các chức năng Thử nghiệm SageMaker được cập nhật. Để thực thi các lệnh được trình bày trong ví dụ của chúng tôi, bạn cần có các điều kiện tiên quyết sau:

- Miền SageMaker Studio

- Hồ sơ người dùng SageMaker Studio với toàn quyền truy cập SageMaker

- Một sổ ghi chép SageMaker Studio có ít nhất một

ml.t3.mediumloại thể hiện

Nếu bạn không có sẵn Tên miền SageMaker và hồ sơ người dùng, bạn có thể tạo một cái bằng cái này hướng dẫn thiết lập nhanh.

Thông số ghi nhật ký

Đối với bài tập này, chúng ta sẽ sử dụng ngọn đuốc, một gói PyTorch cung cấp các bộ dữ liệu phổ biến, kiến trúc mô hình và các phép biến đổi hình ảnh phổ biến cho thị giác máy tính. SageMaker Studio cung cấp một bộ Docker hình ảnh cho các trường hợp sử dụng phổ biến về khoa học dữ liệu được cung cấp trong Amazon ECR. Đối với PyTorch, bạn có tùy chọn chọn hình ảnh được tối ưu hóa cho đào tạo CPU hoặc GPU. Đối với ví dụ này, chúng tôi sẽ chọn hình ảnh PyTorch 1.12 Python 3.8 CPU Optimized và Python 3 nhân. Các ví dụ được mô tả bên dưới sẽ tập trung vào các chức năng của Thử nghiệm SageMaker và chưa hoàn chỉnh về mã.

Hãy tải xuống dữ liệu với torchvision đóng gói và theo dõi số lượng mẫu dữ liệu cho tập dữ liệu thử nghiệm và đào tạo dưới dạng tham số với Thử nghiệm SageMaker. Đối với ví dụ này, giả sử train_set và test_set như đã được tải xuống torchvision bộ dữ liệu.

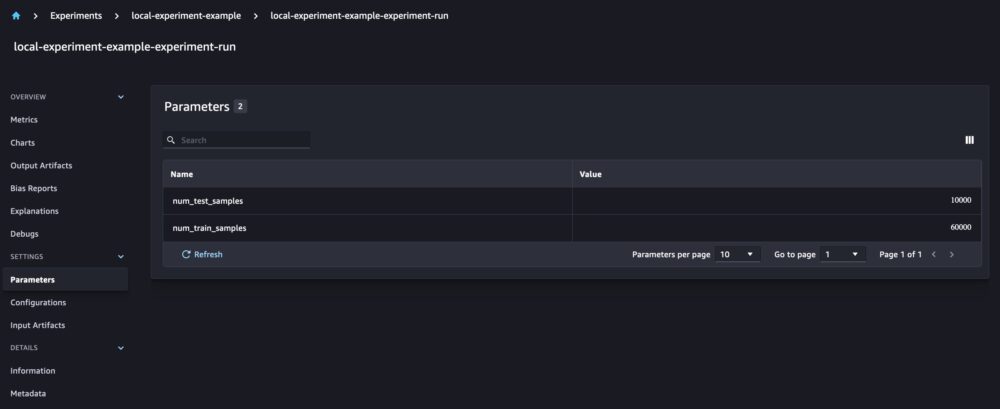

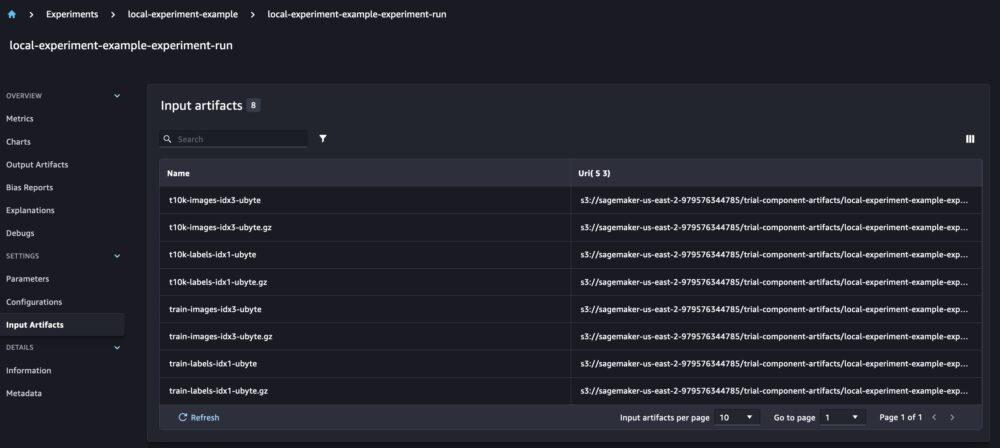

Trong ví dụ này, chúng tôi sử dụng run.log_parameters để ghi lại số lượng mẫu dữ liệu thử nghiệm và đào tạo và run.log_file để tải tập dữ liệu thô lên Amazon S3 và ghi nhật ký chúng làm đầu vào cho thử nghiệm của chúng tôi.

Đào tạo một mô hình và ghi lại các số liệu mô hình

Bây giờ chúng tôi đã tải xuống bộ dữ liệu MNIST của mình, hãy đào tạo một CNN mô hình để nhận biết các chữ số. Trong khi đào tạo mô hình, chúng tôi muốn tải lần chạy thử nghiệm hiện có của mình, ghi lại các tham số mới cho mô hình và theo dõi hiệu suất của mô hình bằng cách ghi lại các chỉ số của mô hình.

Chúng ta có thể sử dụng load_run chức năng tải lần chạy trước của chúng tôi và sử dụng nó để ghi nhật ký đào tạo mô hình của chúng tôi

Sau đó chúng ta có thể sử dụng run.log_parameter và run.log_parameters để ghi một hoặc nhiều tham số mô hình vào quá trình chạy của chúng tôi.

Và chúng ta có thể sử dụng run.log_metric để ghi số liệu hiệu suất vào thử nghiệm của chúng tôi.

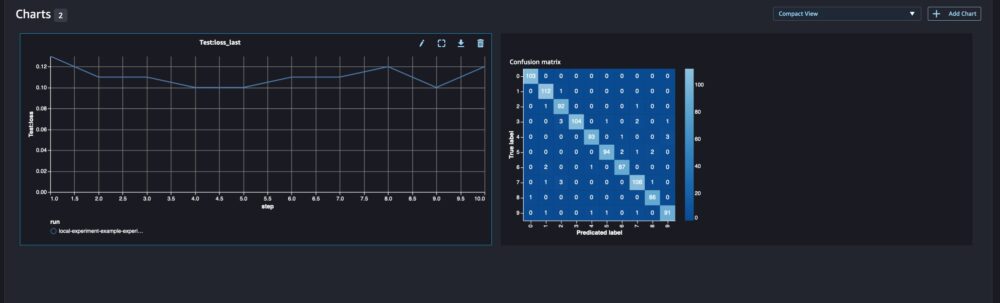

Đối với các mô hình phân loại, bạn cũng có thể sử dụng run.log_confusion_matrix, run.log_precision_recallvà run.log_roc_curve, để tự động vẽ đồ thị ma trận nhầm lẫn, biểu đồ thu hồi độ chính xác và đường cong ROC của mô hình của bạn. Vì mô hình của chúng ta giải quyết vấn đề phân loại nhiều lớp, nên hãy chỉ ghi lại ma trận nhầm lẫn cho nó.

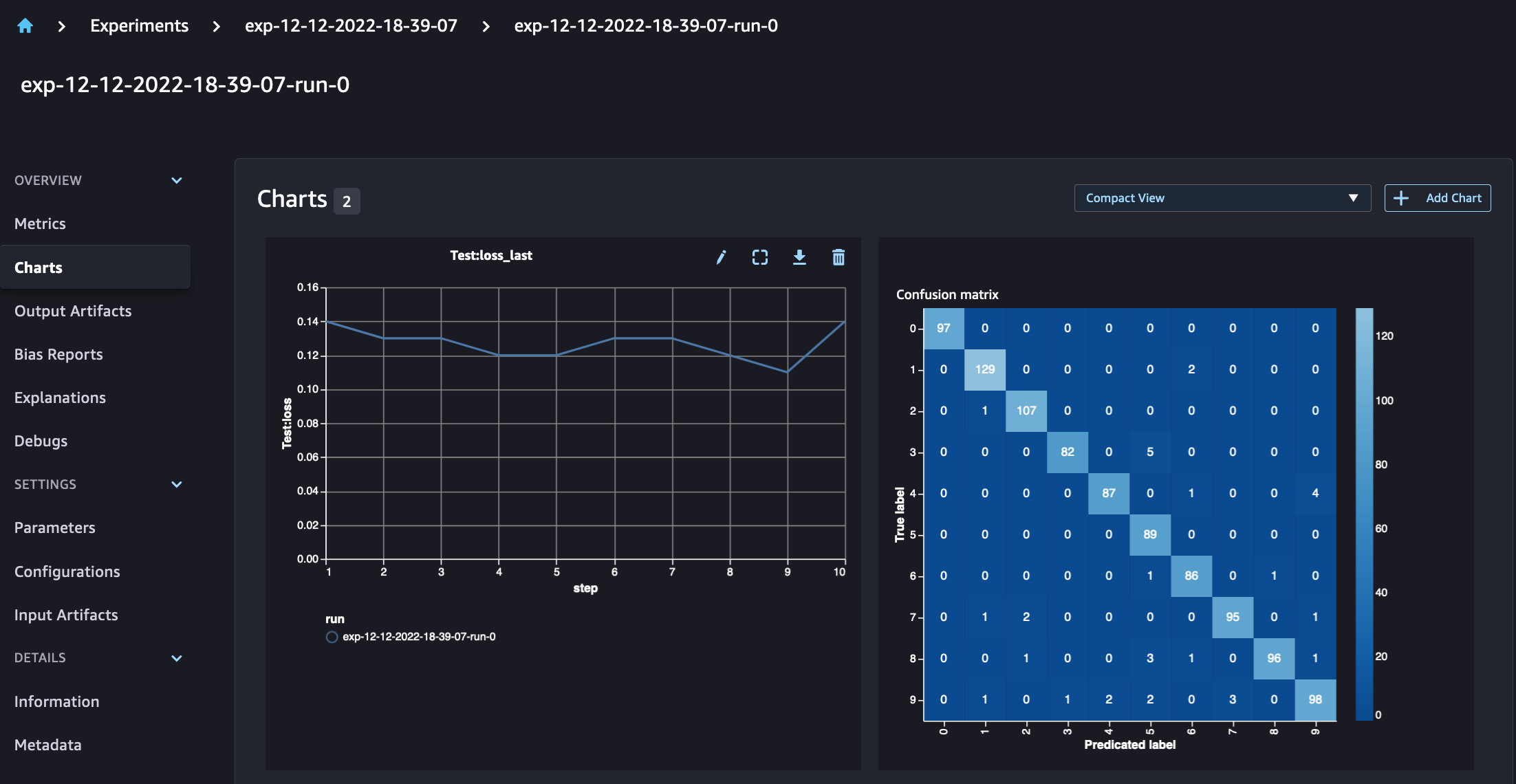

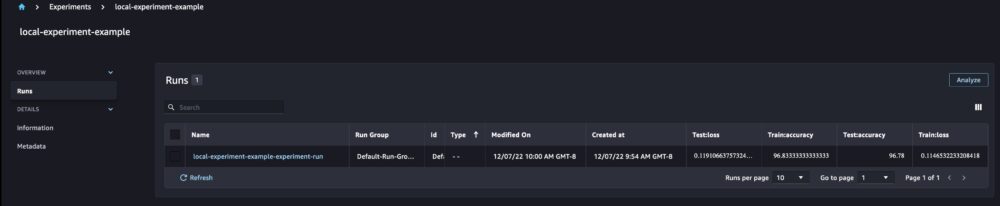

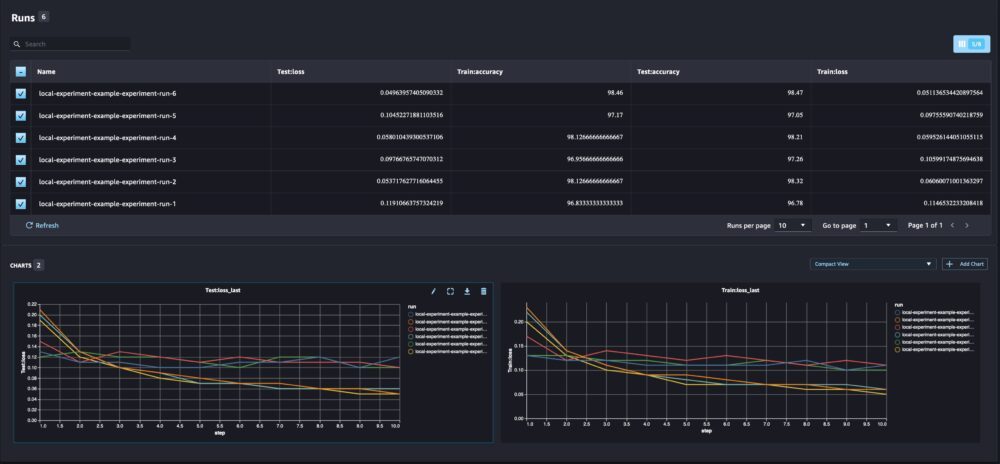

Khi xem chi tiết lần chạy của chúng tôi, giờ đây chúng tôi có thể thấy các số liệu được tạo như trong ảnh chụp màn hình bên dưới:

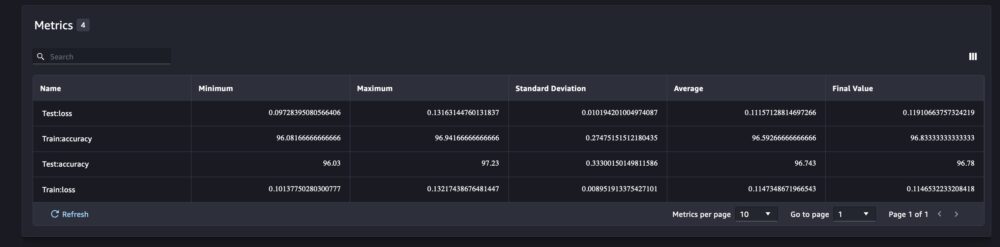

Trang chi tiết lần chạy cung cấp thêm thông tin về số liệu.

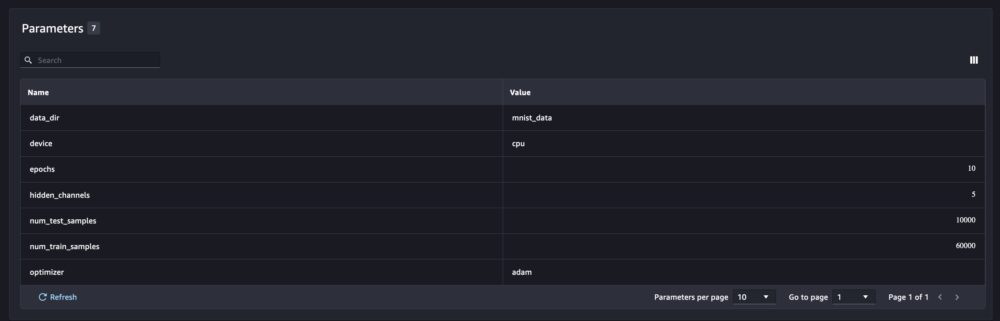

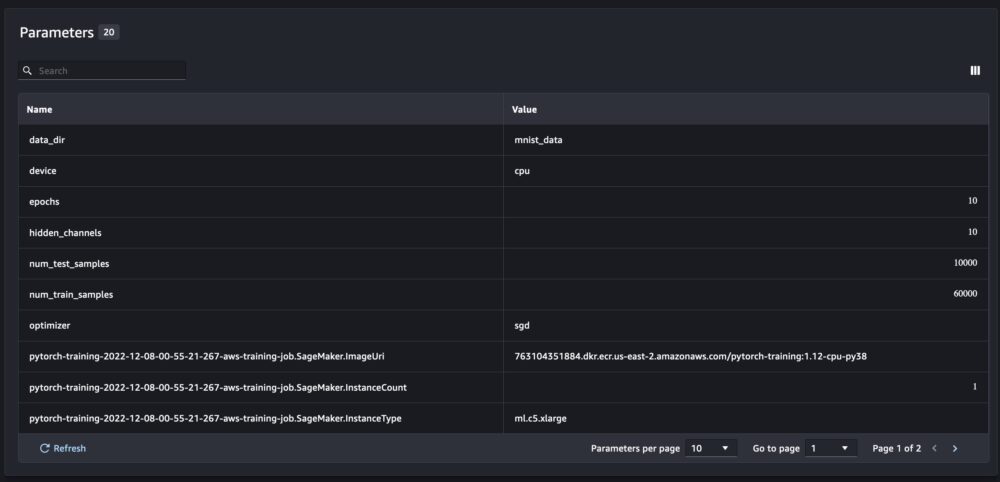

Và các thông số mô hình mới được theo dõi trên trang tổng quan về thông số.

Bạn cũng có thể phân tích hiệu suất mô hình của mình theo lớp bằng cách sử dụng ma trận nhầm lẫn được vẽ tự động, ma trận này cũng có thể được tải xuống và sử dụng cho các báo cáo khác nhau. Và bạn có thể vẽ các biểu đồ bổ sung để phân tích hiệu suất của mô hình dựa trên các số liệu đã ghi.

So sánh nhiều tham số mô hình

Là một nhà khoa học dữ liệu, bạn muốn tìm ra mô hình tốt nhất có thể. Điều đó bao gồm đào tạo một mô hình nhiều lần với các siêu đường kính khác nhau và so sánh hiệu suất của mô hình với các siêu đường kính đó. Để làm như vậy, Thử nghiệm SageMaker cho phép chúng tôi tạo nhiều lần chạy trong cùng một thử nghiệm. Hãy khám phá khái niệm này bằng cách huấn luyện mô hình của chúng ta với các num_hidden_channels và optimizers.

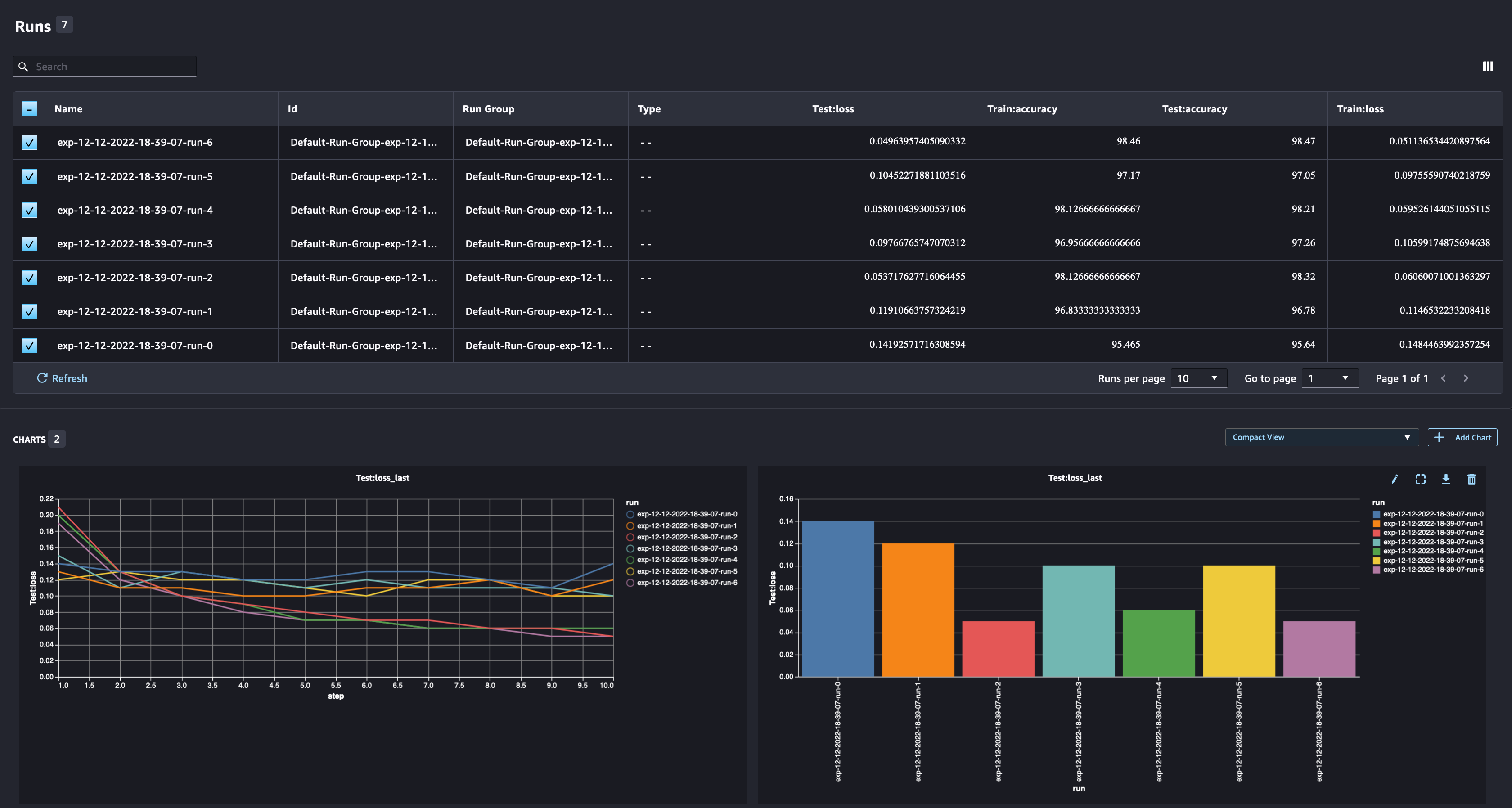

Chúng tôi hiện đang tạo sáu lần chạy mới cho thử nghiệm của mình. Mỗi cái sẽ ghi lại các tham số mô hình, số liệu và ma trận nhầm lẫn. Sau đó, chúng tôi có thể so sánh các lần chạy để chọn mô hình hoạt động tốt nhất cho sự cố. Khi phân tích các lần chạy, chúng ta có thể vẽ đồ thị số liệu cho các lần chạy khác nhau dưới dạng một biểu đồ duy nhất, so sánh hiệu suất của các lần chạy qua các bước đào tạo (hoặc các kỷ nguyên) khác nhau.

Sử dụng Thử nghiệm SageMaker với các công việc đào tạo, xử lý và chuyển đổi hàng loạt của SageMaker

Trong ví dụ trên, chúng tôi đã sử dụng Thử nghiệm SageMaker để ghi lại hiệu suất của mô hình từ sổ ghi chép SageMaker Studio nơi mô hình được đào tạo cục bộ trong sổ ghi chép. Chúng ta có thể làm tương tự để ghi lại hiệu suất mô hình từ các công việc xử lý, đào tạo và chuyển đổi hàng loạt của SageMaker. Với các khả năng chuyển ngữ cảnh tự động mới, chúng tôi không cần phải chia sẻ cụ thể cấu hình thử nghiệm với công việc SageMaker vì nó sẽ được ghi lại tự động.

Ví dụ bên dưới sẽ tập trung vào các chức năng của Thử nghiệm SageMaker và chưa hoàn tất mã.

Trong tệp tập lệnh mô hình của chúng tôi, chúng tôi có thể lấy bối cảnh chạy bằng cách sử dụng load_run(). Trong các công việc đào tạo và xử lý SageMaker, chúng tôi không cần cung cấp cấu hình thử nghiệm để tải cấu hình. Đối với công việc chuyển đổi hàng loạt, chúng tôi cần cung cấp experiment_name và run_name để tải cấu hình của thử nghiệm.

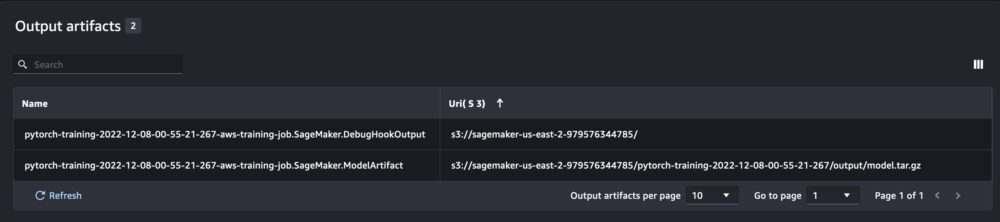

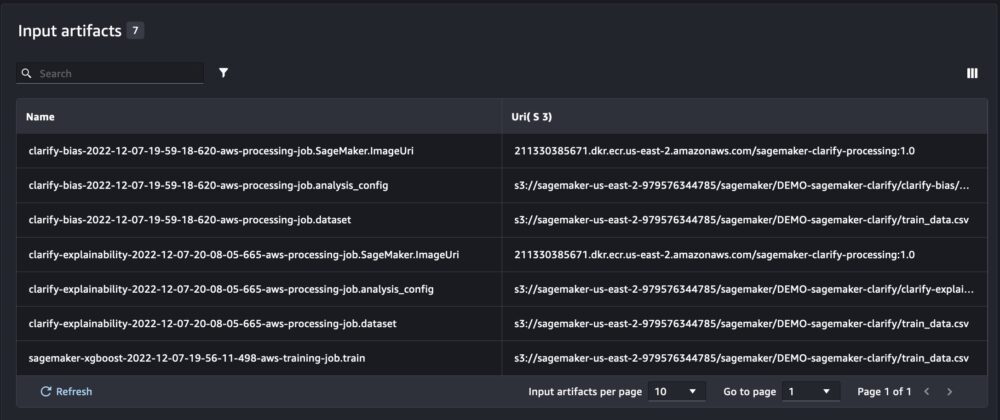

Ngoài thông tin chúng tôi nhận được khi chạy Thử nghiệm SageMaker từ tập lệnh sổ ghi chép, lần chạy từ công việc SageMaker sẽ tự động điền các thông số công việc và đầu ra.

SDK thử nghiệm SageMaker mới cũng đảm bảo khả năng tương thích ngược với phiên bản trước bằng cách sử dụng các khái niệm về bản dùng thử và thành phần dùng thử. Mọi thử nghiệm được kích hoạt bằng phiên bản Thử nghiệm SageMaker trước đó sẽ tự động có sẵn trong giao diện người dùng mới để phân tích thử nghiệm.

Tích hợp SageMaker Làm rõ và lập mô hình báo cáo đào tạo

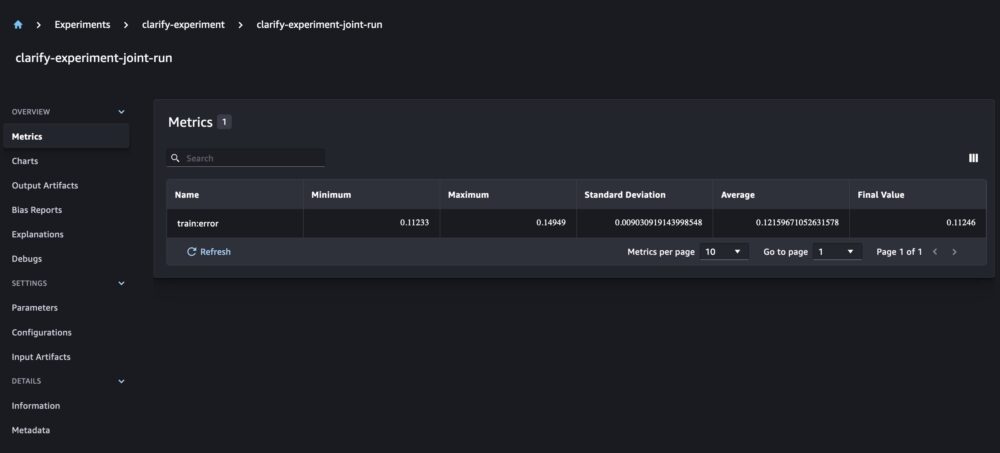

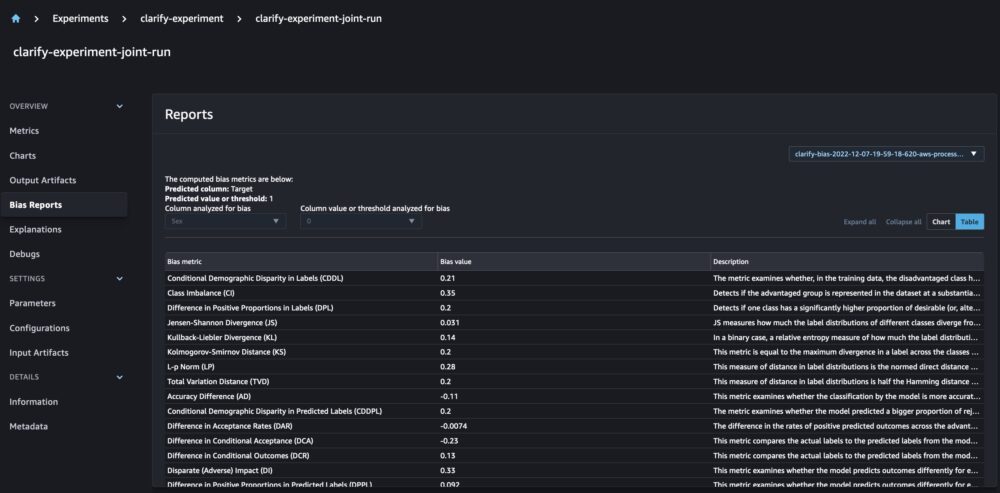

SageMaker Clarify giúp cải thiện các mô hình ML của chúng tôi bằng cách phát hiện thiên vị tiềm năng và giúp đỡ giải thích làm thế nào các mô hình này đưa ra dự đoán. Clarify cung cấp các bộ chứa dựng sẵn chạy dưới dạng công việc xử lý SageMaker sau khi mô hình của bạn đã được đào tạo, sử dụng thông tin về dữ liệu của bạn (cấu hình dữ liệu), mô hình (cấu hình mô hình) và các cột dữ liệu nhạy cảm mà chúng tôi muốn phân tích để tìm ra sai lệch có thể xảy ra (sai lệch cấu hình). Cho đến thời điểm hiện tại, Thử nghiệm SageMaker đã hiển thị các báo cáo về đào tạo mô hình và Làm rõ của chúng tôi dưới dạng các thành phần thử nghiệm riêng lẻ được kết nối thông qua một bản dùng thử.

Với Thử nghiệm SageMaker mới, chúng tôi cũng có thể tích hợp các báo cáo Làm rõ SageMaker với quá trình đào tạo mô hình của chúng tôi có một nguồn sự thật cho phép chúng tôi hiểu thêm về mô hình của mình. Đối với một báo cáo tích hợp, tất cả những gì chúng ta cần làm là có cùng tên chạy cho các công việc đào tạo và Làm rõ. Ví dụ sau minh họa cách chúng ta có thể tích hợp các báo cáo bằng cách sử dụng Mô hình XGBoost để dự đoán thu nhập của người trưởng thành trên khắp nước Mỹ. Mô hình sử dụng các Bộ dữ liệu UCI dành cho người lớn. Đối với bài tập này, chúng tôi giả định rằng mô hình đã được đào tạo và chúng tôi đã tính toán dữ liệu, mô hình và cấu hình sai lệch.

Với thiết lập này, chúng tôi có chế độ xem kết hợp bao gồm các chỉ số mô hình, đầu vào và đầu ra chung cũng như báo cáo Làm rõ về độ lệch thống kê và khả năng giải thích của mô hình.

Kết luận

Trong bài đăng này, chúng tôi đã khám phá thế hệ Thử nghiệm SageMaker mới, một phần tích hợp của SDK SageMaker. Chúng tôi đã trình bày cách ghi nhật ký quy trình công việc ML của bạn từ mọi nơi với lớp Run mới. Chúng tôi đã giới thiệu Giao diện người dùng thử nghiệm mới cho phép bạn theo dõi các thử nghiệm của mình và vẽ đồ thị cho một chỉ số lần chạy cũng như so sánh nhiều lần chạy với khả năng phân tích mới. Chúng tôi đã cung cấp các ví dụ về ghi nhật ký thử nghiệm từ sổ ghi chép SageMaker Studio và từ công việc đào tạo SageMaker Studio. Cuối cùng, chúng tôi đã chỉ ra cách tích hợp đào tạo mô hình và báo cáo SageMaker Clarify trong một chế độ xem thống nhất, cho phép bạn hiểu rõ hơn về mô hình của mình.

Chúng tôi khuyến khích bạn dùng thử các chức năng Thử nghiệm mới và kết nối với Cộng đồng Machine Learning & AI nếu bạn có bất kỳ câu hỏi hoặc phản hồi!

Về các tác giả

Maira Ladeira Tanke là Chuyên gia máy học tại AWS. Với nền tảng về Khoa học dữ liệu, cô ấy có 9 năm kinh nghiệm kiến trúc và xây dựng các ứng dụng ML với khách hàng trong các ngành. Với tư cách là trưởng nhóm kỹ thuật, cô ấy giúp khách hàng đẩy nhanh việc đạt được giá trị kinh doanh thông qua các công nghệ mới nổi và giải pháp sáng tạo. Khi rảnh rỗi, Maira thích đi du lịch và dành thời gian cho gia đình ở một nơi ấm áp.

Maira Ladeira Tanke là Chuyên gia máy học tại AWS. Với nền tảng về Khoa học dữ liệu, cô ấy có 9 năm kinh nghiệm kiến trúc và xây dựng các ứng dụng ML với khách hàng trong các ngành. Với tư cách là trưởng nhóm kỹ thuật, cô ấy giúp khách hàng đẩy nhanh việc đạt được giá trị kinh doanh thông qua các công nghệ mới nổi và giải pháp sáng tạo. Khi rảnh rỗi, Maira thích đi du lịch và dành thời gian cho gia đình ở một nơi ấm áp.

Mani Khanuja là Chuyên gia trí tuệ nhân tạo và máy học SA tại Amazon Web Services (AWS). Cô giúp khách hàng sử dụng công nghệ máy học giải quyết các thách thức kinh doanh của họ bằng AWS. Cô ấy dành phần lớn thời gian của mình để tìm hiểu sâu và hướng dẫn khách hàng về các dự án AI/ML liên quan đến thị giác máy tính, xử lý ngôn ngữ tự nhiên, dự báo, ML biên, v.v. Cô ấy rất đam mê ML, do đó, cô ấy đã tạo ra phòng thí nghiệm của riêng mình với bộ công cụ tự lái và dây chuyền sản xuất nguyên mẫu, nơi cô ấy dành nhiều thời gian rảnh rỗi.

Mani Khanuja là Chuyên gia trí tuệ nhân tạo và máy học SA tại Amazon Web Services (AWS). Cô giúp khách hàng sử dụng công nghệ máy học giải quyết các thách thức kinh doanh của họ bằng AWS. Cô ấy dành phần lớn thời gian của mình để tìm hiểu sâu và hướng dẫn khách hàng về các dự án AI/ML liên quan đến thị giác máy tính, xử lý ngôn ngữ tự nhiên, dự báo, ML biên, v.v. Cô ấy rất đam mê ML, do đó, cô ấy đã tạo ra phòng thí nghiệm của riêng mình với bộ công cụ tự lái và dây chuyền sản xuất nguyên mẫu, nơi cô ấy dành nhiều thời gian rảnh rỗi.

Đức Văn Kỳ là Kỹ sư phát triển phần mềm tại AWS. Cô hiện đang tham gia xây dựng bộ sưu tập các công cụ và dịch vụ nền tảng trong AWS SageMaker để giúp khách hàng thực hiện thành công các dự án ML của họ. Cô ấy cũng đam mê đưa khái niệm MLOps đến với nhiều đối tượng hơn. Ngoài công việc, Dewen thích tập Cello.

Đức Văn Kỳ là Kỹ sư phát triển phần mềm tại AWS. Cô hiện đang tham gia xây dựng bộ sưu tập các công cụ và dịch vụ nền tảng trong AWS SageMaker để giúp khách hàng thực hiện thành công các dự án ML của họ. Cô ấy cũng đam mê đưa khái niệm MLOps đến với nhiều đối tượng hơn. Ngoài công việc, Dewen thích tập Cello.

Abhishek Agarwal là Giám đốc sản phẩm cấp cao của Amazon SageMaker. Anh ấy đam mê làm việc với khách hàng và làm cho việc học máy trở nên dễ tiếp cận hơn. Khi rảnh rỗi, Abhishek thích vẽ tranh, đạp xe và tìm hiểu về các công nghệ tiên tiến.

Abhishek Agarwal là Giám đốc sản phẩm cấp cao của Amazon SageMaker. Anh ấy đam mê làm việc với khách hàng và làm cho việc học máy trở nên dễ tiếp cận hơn. Khi rảnh rỗi, Abhishek thích vẽ tranh, đạp xe và tìm hiểu về các công nghệ tiên tiến.

Dana Benson là một Kỹ sư phần mềm làm việc trong nhóm Thử nghiệm, Truyền thống và Tìm kiếm của Amazon SageMaker. Trước khi gia nhập AWS, Dana đã dành thời gian kích hoạt chức năng nhà thông minh trong Alexa và đặt hàng qua thiết bị di động tại Starbucks.

Dana Benson là một Kỹ sư phần mềm làm việc trong nhóm Thử nghiệm, Truyền thống và Tìm kiếm của Amazon SageMaker. Trước khi gia nhập AWS, Dana đã dành thời gian kích hoạt chức năng nhà thông minh trong Alexa và đặt hàng qua thiết bị di động tại Starbucks.

- AI

- nghệ thuật ai

- máy phát điện nghệ thuật ai

- ai rô bốt

- Amazon SageMaker

- trí tuệ nhân tạo

- chứng nhận trí tuệ nhân tạo

- trí tuệ nhân tạo trong ngân hàng

- robot trí tuệ nhân tạo

- robot trí tuệ nhân tạo

- phần mềm trí tuệ nhân tạo

- Học máy AWS

- blockchain

- hội nghị blockchain ai

- thiên tài

- trí tuệ nhân tạo đàm thoại

- hội nghị tiền điện tử ai

- dall's

- học kĩ càng

- google ai

- Trung cấp (200)

- học máy

- plato

- Plato ai

- Thông tin dữ liệu Plato

- Trò chơi Plato

- PlatoDữ liệu

- Platogaming

- quy mô ai

- cú pháp

- zephyrnet