介绍

偶尔,一个人可以采用一个对于正式研究来说似乎过于模糊的抽象概念,并提供一个优雅的正式定义。 克劳德香农做到了 信息, Andrey Kolmogorov 用 随机性. 在过去的几年里,研究人员一直在尝试对机器学习中的公平概念做同样的事情。 不幸的是,这更棘手。 不仅这个概念更难定义,而且单个定义也不可能满足所有理想的公平性指标。 Arvind Narayanan,普林斯顿大学的计算机科学家,在将不同的观点结合起来并帮助这个新领域建立起来方面发挥了重要作用。

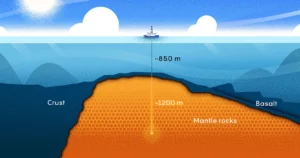

他的职业生涯跨越了从理论到政策的所有抽象层次,但最终导致他目前工作的旅程始于 2006 年。那一年,Netflix 赞助了一项竞赛,该竞赛将奖励 1 万美元给任何提高推荐系统准确性的人10%。 Netflix 提供了一个据称是匿名的用户数据集和他们的评级,并删除了个人身份信息。 但 Narayanan 表明,使用复杂的统计技术,你只需要几个数据点就可以揭示数据集中“匿名”用户的身份。

从那时起,纳拉亚南就专注于理论与实践相结合的其他领域。 通过 普林斯顿网络透明度和问责制项目,他的团队发现了网站跟踪用户和提取敏感数据的秘密方式。 他的团队发现,像国家安全局这样的组织可以使用网络浏览数据(特别是第三方放置的 cookie),不仅可以发现用户的真实身份,还可以重建他们 62% 到 73% 的浏览历史. 他们证明了——即兴演奏 著名 纽约客 动画片 — 在互联网上,网站现在知道你是一只狗。

近年来,Narayanan 专门转向 机器学习 — 人工智能的一种应用,使机器能够从数据中学习。 虽然他欢迎 AI 的进步,但他指出即使出于善意,此类系统也可能会失败,以及这些原本有用的技术如何成为为歧视辩护的工具。 从这个角度来看,定义纳拉亚南研究轨迹的看似互不关联的点形成了一种星座。

广达 与 Narayanan 谈到了他在去匿名化方面的工作、统计直觉的重要性以及人工智能系统的许多缺陷。 为清楚起见,对访谈进行了压缩和编辑。

介绍

你一直想做数学和科学研究吗?

我从小就对两者都很感兴趣,但主要是数学。 我擅长解谜,甚至在国际数学奥林匹克竞赛中取得了一些成绩。 但是我对解谜和研究数学之间的区别有很大的误解。

所以在很早的时候,我就把研究重点放在密码学上,尤其是理论密码学上,因为我仍然在我很擅长数学的错觉中苦苦挣扎。 然后在我余下的职业生涯中,我意识到这实际上根本不是我的强项。

这一定是您去匿名化工作的良好背景。

你说得对。 允许去匿名化研究的是我称之为统计直觉的技能。 它实际上不是正式的数学知识。 它能够在您的脑海中产生一种直觉,例如:“如果我采用这个复杂的数据集并对其应用这种转换,那么合理的结果是什么?”

直觉可能经常是错误的,这没关系。 但拥有直觉很重要,因为它可以引导您走向可能富有成果的道路。

介绍

统计直觉如何帮助您处理 Netflix 数据?

我一直在尝试为高维数据设计一种匿名化方案。 它完全失败了,但在失败的过程中,我形成了一种直觉,即高维数据无法有效匿名化。 当然,Netflix 和他们的竞争对手声称已经做到了这一点。

我天生对公司的营销声明持怀疑态度,所以我有动力去证明他们是错的。 我和我的导师 Vitaly Shmatikov 花了几个星期的时间来研究它。 一旦我们意识到这项工作确实产生了影响,我就开始做更多的事情。

总体影响如何? 你有没有收到 Netflix 和其他公司的回复,这些公司的数据并不是那么匿名?

好吧,一个积极的影响是它刺激了科学 差异隐私. 但就公司的反应而言,有一些不同的反应。 在许多情况下,原本会向公众发布数据集的公司现在不再这样做——他们将隐私作为武器来对抗透明度的努力。

Facebook 以这样做而闻名。 当研究人员去 Facebook 说,“我们需要访问其中的一些数据来研究信息如何在平台上传播时,”Facebook 现在可以说,“不,我们不能给你那个。 这将损害我们用户的隐私。”

你曾经写过一个 纸 认为“个人身份信息”一词可能具有误导性。 为何如此?

我认为,由于该术语的两种不同使用方式,政策制定者之间存在混淆。 一个是关于您的非常敏感的信息,例如您的社会安全号码。 另一个含义是可以索引到某些数据集中的信息,从而用于查找有关您的更多信息。

这两个有不同的含义。 从第一个意义上讲,我对 PII 的概念没有意见。 关于人的某些信息非常敏感,我们应该更加小心地对待它们。 但是,虽然您的电子邮件地址对大多数人来说不一定非常敏感,但它仍然是一个唯一标识符,可用于在其他数据集中找到您。 只要世界上任何其他人都可以获得关于一个人的属性组合,这就是去匿名化所需的全部。

介绍

你最终是如何开始研究公平的?

我在 2017 年教授了一门公平和机器学习课程。这让我对该领域的开放问题有了一个很好的了解。 与此同时,我发表了一个名为“21公平的定义及其政治” 我解释说,技术定义的激增不是因为技术原因,而是因为所有这一切的核心是真正的道德问题。 你不可能有一个单一的统计标准来捕捉所有规范的需求——你想要的所有东西。 演讲很受欢迎,所以这两个人一起说服我应该开始进入这个话题。

你也是 讲了 关于检测 AI 蛇油,同样受到好评。 这与机器学习中的公平性有何关系?

所以这样做的动机是人工智能中显然有很多真正的技术创新,比如文本到图像程序 达尔·E 2 或国际象棋程序 零度. 这种进步如此之快,真是令人惊叹。 许多创新值得庆祝。

当我们使用这个非常松散和宽泛的总称“AI”来表示类似的事情以及更令人担忧的应用程序时,例如用于犯罪风险预测的统计方法,问题就来了。 在这种情况下,所涉及的技术类型非常不同。 这是两种截然不同的应用,潜在的好处和危害也大不相同。 它们之间几乎没有任何联系,因此对两者使用相同的术语会让人非常困惑。

人们误以为他们在图像生成方面看到的所有这些进步实际上会转化为进步 用于预测犯罪风险或预测哪些孩子将辍学等社会任务。 但事实并非如此。 首先,在预测谁可能因犯罪被捕时,我们只能比随机概率稍好一些。 这种准确性是通过非常简单的分类器实现的。 随着时间的推移,它并没有变得更好,而且随着我们收集更多的数据集,它也没有变得更好。 因此,所有这些观察结果都与深度学习在图像生成方面的应用形成对比。

您如何区分不同类型的机器学习问题?

这不是一个详尽的列表,但共有三个常见类别。 第一类是感知,包括描述图像内容等任务。 第二类是我所说的“自动判断”,例如当 Facebook 想要使用算法来确定哪些言论毒性太大而不能留在平台上时。 第三个是预测人们未来的社会结果——是否有人会因犯罪而被捕,或者一个孩子是否会辍学。

在所有这三种情况下,可实现的准确性都大不相同,不准确的 AI 的潜在危险也大不相同,随之而来的伦理影响也大不相同。

例如人脸识别,在我的分类中,是一个感知问题。 很多人都说人脸识别不准确,但有时他们是对的。 但我不认为那是因为面部识别的准确性存在根本限制。 这项技术一直在改进,而且会变得更好。 这正是我们应该从道德角度关注它的原因——当你把它交到警察手中时,他们可能不负责任,或者国家对它的使用不透明。

介绍

是什么让社会预测问题比感知问题更难?

感知问题有几个特点。 第一,图像中是否有猫是没有歧义的。 所以你有基本事实。 其次,您实际上拥有无限的训练数据,因为您可以使用网络上的所有图像。 如果您是 Google 或 Facebook,您可以使用人们上传到您的应用程序的所有图像。 因此,这两个因素——没有歧义和数据可用性——让分类器表现得非常好。

这与没有这两个特征的预测问题不同。 我应该提到第三个区别,从某种意义上说,这是最重要的一个:将这些预测模型付诸行动的道德后果与在手机上使用语言翻译工具或图像标记工具有很大不同。

但这与用于确定某人是否应该被审前拘留的工具的严重性不同。 这些都会对人们的自由产生影响。 所以具有讽刺意味的是,人工智能最糟糕的领域,随着时间的推移并没有真正得到改善,而且未来也不太可能得到改善,而这些领域却产生了所有这些非常重要的后果。

您的大部分工作都需要与您所在领域以外的专家交谈。 像这样与他人合作是什么感觉?

跨学科合作一直是最愉快的合作之一。 我认为任何此类合作都会有令人沮丧的时刻,因为人们不会说同一种语言。

我的处方是:文化,然后是语言,然后是实质。 如果你不了解他们的文化——比如他们看重什么样的奖学金——那就真的很难了。 对一个人有价值的东西可能对另一个人似乎无关紧要。 因此,必须首先解决文化方面的问题。 然后你就可以开始建立共同语言和词汇,最后进入合作的实质。

您对我们能否安全、明智地采用新技术有多乐观?

部分问题是知识差距。 购买这些人工智能工具的决策者、政府机构、公司和其他人可能没有意识到预测准确性的严重限制。

但最终我认为这是一个政治问题。 有些人想削减成本,所以他们想要一个自动化工具,从而减少工作岗位。 因此,无论这些供应商对他们的预测工具所说的是什么,都有很大的压力要相信。

这是两个不同的问题。 像我这样的人也许可以帮助解决信息鸿沟。 但解决政治问题需要激进主义。 它要求我们利用民主进程。 很高兴看到有很多人这样做。 从长远来看,我认为我们可以抵制人工智能的有害和滥用应用。 我不认为它会立即改变,而是通过一个已经持续了十年或更长时间的长期、拖延、拖延的行动主义过程。 我相信它会持续很长时间。

- SEO 支持的内容和 PR 分发。 今天得到放大。

- 柏拉图区块链。 Web3 元宇宙智能。 知识放大。 访问这里。

- Sumber: https://www.quantamagazine.org/he-protects-privacy-and-ai-fairness-with-statistics-20230310/

- :是

- ][p

- 1 百万美元

- $UP

- 2017

- a

- 对,能力--

- Able

- 关于

- 关于它

- 摘要

- ACCESS

- 问责制

- 实现

- ACM

- 操作

- 激进

- 通

- 地址

- 解决

- 采用

- 进步

- 优点

- 驳

- 机构

- 机构

- AI

- 算法

- 所有类型

- 已经

- 时刻

- 惊人

- 歧义

- 其中

- 和

- 匿名

- 另一个

- 任何人

- 应用

- 应用领域

- 应用领域

- 使用

- 保健

- 国家 / 地区

- 地区

- 被捕

- 人造的

- 人工智能

- AS

- 方面

- At

- 属性

- 自动化

- 可用性

- 可使用

- 奖

- 背部

- 背景

- BE

- 因为

- 成为

- 牛肉

- 开始

- 作为

- 相信

- 好处

- 更好

- 之间

- 广阔

- 浏览

- 买房

- by

- 呼叫

- 被称为

- CAN

- 不能

- 捕获

- 寻找工作

- 小心

- 案件

- 例

- 喵星人

- 类别

- 产品类别

- 著名

- 一定

- 机会

- 更改

- 特点

- 棋

- 声称

- 明晰

- 分类

- 明确地

- 合作

- 合作

- 合作

- 收集

- 组合

- 如何

- 相当常见

- 公司

- 竞争

- 完全

- 复杂

- 妥协

- 一台

- 概念

- 关心

- 扑朔迷离

- 混乱

- 地都

- 后果

- 内容

- 上下文

- 继续

- 对比

- 曲奇饼

- 成本

- 可以

- 情侣

- 套餐

- 犯罪

- 刑事

- 加密技术

- 文化

- 文化塑造

- 电流

- 切

- 削减成本

- 危险

- data

- 数据点

- 数据集

- 数据集

- 十

- 决策者

- 深

- 深入学习

- 定义

- 民主的

- 值得

- 拘留

- 确定

- 发达

- 货币

- DID

- 差异

- 不同

- 不同的问题

- 通过各种方式找到

- 区分

- 狗

- 做

- 别

- 下降

- 早

- 只

- 工作的影响。

- 消除

- 邮箱地址

- 愉快的

- 特别

- 本质上

- 建立

- 建立

- 伦理

- 甚至

- 终于

- 究竟

- 专家

- 解释

- 提取

- 面部彩妆

- 人脸识别

- 因素

- 失败

- 失败

- 公平

- 公平

- 少数

- 部分

- 战斗

- 终于

- 找到最适合您的地方

- (名字)

- 重点

- 遵循

- 针对

- 申请

- 正式

- 发现

- Freedom

- 止

- 沮丧

- 根本

- 未来

- 差距

- 代

- 得到

- 越来越

- 给

- 给

- Go

- 去

- 非常好

- 谷歌

- 政府

- 陆运

- 团队

- 指南

- 手

- 事件

- 硬

- 有害

- 危害

- 有

- 有

- 头

- 听

- 胸襟

- 帮助

- 帮助

- 历史

- 创新中心

- HTTPS

- 巨大

- i

- 主意

- 识别码

- 身分

- 图片

- 图片

- 影响力故事

- 启示

- 重要性

- 重要

- 不可能

- 改善

- 改善

- 改善

- in

- 其他

- 不准确

- 包括

- 令人难以置信

- 信息

- 創新

- 例

- 即食类

- 仪器的

- 房源搜索

- 意图

- 有兴趣

- 国际

- 网络

- 专属采访

- 参与

- 问题

- IT

- 它的

- 本身

- 工作机会

- 旅程

- 小子

- 孩子们

- 类

- 知道

- 知识

- 已知

- 标签

- 缺乏

- 语言

- 学习用品

- 学习

- 导致

- 各级

- 光

- 喜欢

- 范围

- 清单

- 长

- 长时间

- 不再

- 占地

- 机

- 机器学习

- 机

- 制作

- 许多

- 营销

- 数学

- 数学的

- 意

- 会见

- 方法

- 指标

- 可能

- 百万

- 模型

- 美好瞬间

- 更多

- 最先进的

- 动机

- 动机

- National

- 国家安全

- 自然

- 一定

- 需求

- Netflix公司

- 全新

- 数

- of

- 提供

- 油

- on

- 一

- 打开

- 乐观的

- 其他名称

- 其它

- 除此以外

- 成果

- 学校以外

- 最划算

- 各方

- 过去

- 员工

- 人的

- 知觉

- 演出

- 也许

- 人

- 亲自

- 透视

- 电话

- 件

- 平台

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 似是而非

- 点

- Police

- 政策

- 政策制定者

- 政治

- 积极

- 潜力

- 在练习上

- 恰恰

- 预测

- 预测

- 处方

- 压力

- 主要

- 隐私

- 市场问题

- 问题

- 过程

- 曲目

- 进展

- 证明

- 提供

- 国家

- 推

- 推回

- 放

- 把

- 拼图

- 量子杂志

- 有疑问吗?

- 随机

- 快

- 评分

- 反应

- 真实的世界

- 实现

- 实现

- 原因

- 收到

- 最近

- 承认

- 承认

- 推荐

- 发布

- 留

- 去除

- 必须

- 需要

- 研究

- 研究员

- 研究人员

- REST的

- 揭示

- 风险

- 运行

- 安然

- 同

- 方案

- 学校

- 科学

- 科学家

- 其次

- 保安

- 看到

- 感

- 敏感

- 严重

- 集

- 套数

- 应该

- 简易

- 单

- 怀疑论

- 技能

- So

- 社会

- 解决

- 一些

- 有人

- 极致

- 说话

- 特别是

- 言语

- 赞助商

- 开始

- 开始

- 声明

- 州

- 统计

- 仍

- 实力

- 强烈

- 学习

- 留学

- 物质

- 成功

- 这样

- 系统

- 产品

- 采取

- 谈论

- 说

- 任务

- 团队

- 文案

- 技术

- 专业技术

- 条款

- 这

- 区域

- 未来

- 信息

- 世界

- 其

- 他们

- 理论

- 从而

- 博曼

- 事

- 思维

- 第三

- 第三者

- 透

- 三

- 通过

- 次

- 至

- 一起

- 也有

- 工具

- 工具

- 主题

- 对于

- 跟踪时

- 产品培训

- 轨道

- 转型

- 翻译

- 翻译

- 用户评论透明

- 透明

- 治疗

- 转身

- 类型

- 最终

- 伞

- 下

- 理解

- 独特

- 大学

- 无限

- 上传

- us

- 使用

- 用户

- 用户

- 有价值

- 折扣值

- 厂商

- 意见

- 方法..

- 方法

- 卷筒纸

- 网页

- 网站

- 周

- 欢迎光临

- 井

- 什么是

- 什么是

- 是否

- 这

- 而

- WHO

- 谁

- 维基百科上的数据

- 将

- 工作

- 工作

- 合作

- 世界

- 将

- 错误

- 年

- 年

- 完全

- 您一站式解决方案

- YouTube的

- 和风网